基于改进PRM的采摘机器人机械臂避障路径规划

- 格式:pdf

- 大小:328.32 KB

- 文档页数:5

机械手臂的路径规划与控制机械手臂是一种可编程、多关节的机械设备,能够在三维空间中进行精确运动和操作。

它广泛应用于工业生产线、医疗手术、物流仓储等领域。

而机械手臂的路径规划与控制是保证其高效运作的关键技术之一。

一、机械手臂的路径规划路径规划是指在给定的环境中,通过算法确定机械手臂的运动路径和关节角度,以实现所需的目标位置或动作。

在进行路径规划时,需要考虑到机械手臂的结构、工作空间限制、物体的位置和形状等多个因素。

1.几何路径规划几何路径规划是一种基于几何学的方法,通过计算机算法确定机械手臂的最优路径。

其中,最常用的算法包括线性插补、圆弧插补和样条插补等。

线性插补适用于直线运动,圆弧插补适用于弧线轨迹,而样条插补则可以实现更加灵活的曲线运动。

2.动力学路径规划与几何路径规划不同,动力学路径规划考虑了机械手臂的质量、惯性和运动约束,更加接近于实际应用情况。

常用的动力学路径规划算法包括逆运动学、优化算法和遗传算法等。

逆运动学方法通过已知目标位置,反推出机械手臂的关节角度,而优化算法和遗传算法则通过迭代寻找最优解。

二、机械手臂的控制机械手臂的控制是指通过控制器对机械手臂的电机、驱动器、传感器进行控制,实现路径规划和动作执行。

机械手臂的控制系统通常包括五个主要部分:传感器系统、执行器系统、控制算法、控制器和用户界面。

1.传感器系统传感器系统用于对机械手臂周围环境进行感知,从而获取物体位置、形态和力量等信息。

常见的传感器包括摄像头、激光测距仪、力传感器等。

传感器所获取的数据可以用于路径规划、动作控制和碰撞检测等。

2.执行器系统执行器系统包括电机、传动装置和关节,用于实现机械手臂的运动。

电机通过驱动器接受控制信号,驱动关节实现机械手臂的位移或转动。

在选择执行器系统时,需要考虑负载能力、精度和效率等因素。

3.控制算法控制算法是机械手臂控制系统的核心部分,根据传感器数据和用户指令,计算出适合的控制信号。

常见的控制算法包括PID控制、模糊控制和神经网络控制等。

第3期王寅等:基于深度强化学习与旋量法的机械臂路径规划517及其衍生算法、PRM(probabilistic road maps)[8]及其衍生算法、退火算法[9]等都是基于采样的,环境发生改变后需要重新采样才能得到可行路径,难以适用于多变的机械臂工作场景.因此,如何提高机械臂在复杂环境的泛化性能成为了机械臂路径规划中的一个难点.深度强化学习(deep reinforcement learning,DR-L)[10–11],将深度学习的感知能力和强化学习的决策能力相结合,近年来被广泛运用在包括机械臂路径规划的各领域中.文献[12]将深度强化学习与机器人逆运动学融合实现了无碰撞的路径规划;文献[13]提出了一种基于SAC(soft actor-critic)算法的多臂机器人周期运动障碍物路径规划算法;文献[14]采用了一种基于DRL的混合控制算法,并通过了真实机械臂进行的测试;文献[15]使用了一种无模型深度强化学习算法进行训练;文献[16]提出通过深度强化学习让机器人具有自主获取进行复杂装配的能力,证明了通过DRL 模型可以提高机器人的智能水平;文献[17]提出了一种面向果园复杂环境的基于深度强化学习的快速、鲁棒的无碰撞路径规划方法;文献[18]提出使用深度强化学习方法来学习机械臂的控制器,即通过机械臂的控制器的反馈数据进行训练,将机械臂引导到目标地点;文献[19]通过奖励函数的设计来解决面向路径规划的DRL算法在障碍物环境中性能差的现象;文献[20]提出一种基于六自由度机械臂运动规划的改进DRL算法,通过添加成功经验池和碰撞经验池、改进奖励函数、优先训练前三轴等方法提升了训练效率和模型性能.这些研究通过DRL进行机械臂的路径规划研究,并通过经验池改进、奖励函数改进等方法使DRL更适用于机械臂,但仍然存在明显的获取样本成本过高问题,且随着机械臂轴数增多、环境复杂程度增大,样本获取成本将成指数式增长.因而,提升样本利用率对于深度强化学习在机械臂领域的应用有着不可忽视的作用.利用学习过程中不断生成的自然轨迹作为实际示例来进行训练,是目前机械臂训练过程中获取样本的常见方法,但样本获取成本大,且常存在样本利用效率过低的问题.文献[21]提出经验回放方法,将与环境交互所得样本存储至重放缓冲区,使样本多次用于训练.深度学习中的数据增强方法,是在已有样本集的基础上进行样本的扩充,但由于强化学习的样本是在探索过程中即时得到,故对强化学习并不适用,但可以通过数据增强的思路对样本进行有效扩充.例如HER(hindsight experience replay)算法[22],此算法将采集所得智能体的状态作为该轨迹的新目标,以此生成有效人工轨迹.除此以外还有HER的衍生算法、对称等扩充样本的方法,但这些方法只通过改变智能体状态的方式进行样本扩充,提升样本利用率.本文基于数据增强的思想提出了一种面向机械臂领域的离线策略强化学习通用算法:DRL与旋量法的融合算法(screw method in DRL,SMIDRL).具体贡献如下:1)通过旋量法[23]对机械臂与环境交互得到的自然轨迹进行有效扩充,从而使得样本利用率得到了更高效的提升,总体流程如图1所示.因为SMIDRL需要将即时采集到的轨迹进行扩充再存入回放经验池,故只能局限于离线策略DRL算法;2)SMIDRL在扩充轨迹的同时还可以通过改变障碍物等物体姿态的方式对交互环境进行同步改变,从而提升智能体对动态复杂环境的应对能力;3)SMIDRL可以与HER算法这类样本扩充算法进行结合,这样可以使样本利用率和训练效率得到更显著提升.图1旋量法与离线策略DRL的融合算法Fig.1Fusion algorithm of screw method and off-policy DRL 本文的组织结构如下:第1部分介绍了DRL在机械臂路径规划领域的研究现状以及提升样本利用率的必要性;第2部分介绍了深度强化学习算法在机械臂路径规划中的应用;第3部分介绍了SMIDRL理论;第4部分在OpenAI Gym[24]的Mujoco平台下,通过Fe-tch机械臂[25]和UR5机械臂的仿真环境,使用DDPG (deep deterministic policy gradient)算法[26]进行实验分析,证明本算法不仅可以提高模型训练效率,还能提高机械臂在复杂动态环境的泛化能力;第5部分进行了总结.2DRL在机械臂路径规划中的应用2.1马尔可夫决策过程马尔可夫决策过程(Markov decision process,MD-P)[27]是强化学习的基础,用于系统状态具有马尔可夫性质的环境,模拟智能体可实现的随机性策略与回报.给定一个随机过程的当前状态和所有过去状态,如果未来状态的条件概率分布且仅与当前状态有关,则称该随机过程具有马尔可夫性质.本文考虑将连续状态和动作空间模拟为多目标马尔可夫决策过程,即{S,A,G,T,R,p,γ}.其中:S是连续的状态空间;A指的是一个连续的动作空间;G是一组目标;T:S×A×S→[0,1]代表描述环境动态的未知转换函数;R{s,a,s′,g}是当智能体目标为g∈G时,执行动作a∈A后从状态s∈S达到状态s′∈S 所得到的即时奖励;γ∈[0,1]是折扣因子.在该框架518控制理论与应用第40卷下的机械臂学习目的是获得一个策略π:S ×G ∈A ,使预期折扣奖励的总和对于任何给定的目标都能达到最大化.2.2DDPG 与机械臂路径规划基于DDPG 的机械臂路径规划方法如图2所示.行动者当前网络负责机械臂动作选择策略的更新,评判家当前网络负责对机械臂所执行动作评判策略的更新.两个目标网络则是借鉴了DDQN (double deep Q-learning)算法[28]的双网络框架模式,通过目标框架评判当前框架的方式解决单个网络框架收敛慢、算法不稳定的问题.经验回放将机械臂与环境交互所得转移样本(s,a,r,s ′)存放到经验池中,训练时再从经验池中随机采样,以此将采集样本碎片化存储,避免了样本之间的相关性,同时也提高了样本利用率.图2基于DDPG 的机械臂路径规划方法[26]Fig.2Path planning method of manipulator based on DDPG [26]3DRL 与旋量法的融合旋量法是一种基于李群的解决机械臂运动学的方法.SMIDRL 算法如图1所示,即通过旋量法将机械臂探索过程中收集到的自然轨迹进行复制、筛选,以此得到廉价的可行人工轨迹,在不进行额外探索的前提下得到更多的训练样本,达到提高样本利用率的目的.每次转换得到的人工轨迹必须通过自然轨迹生成,否则可能会使训练结果有很大偏差.3.1旋量法进行旋量运算需要参数ξ和θ,其中θ为旋转角度,ξ=[νω]T ∈se (3)⊂R 6为旋量系数,ν=−ω×q ,ω=[w 1w 2w 3]T ∈so (3)⊂R 3表示旋转轴(如z 轴为旋转轴时ω=[001]T ),q ∈R 3为旋转体到旋转轴的垂直向量.ξ和θ对应的旋量矩阵g (ξ,θ)表示为g (ξ,θ)=[e ˆωθ(I −e ˆωθ)(ω×ν)01]∈SE (3),(1)其中:ˆω=0−ω3ω2ω30−ω1−ω2ω10,(2)e ˆωθ=I +ˆωsin θ+ˆω2(1−cos θ)∈SO (3),(3)其中:SO (n )⊂R n ×n 为n 维的特殊正交群,SE (n )⊂R (n +1)×(n +1)为系统位形空间R n 与SO (n )的乘积空间,so (n ),se (n )为李群SO (n ),SE (n )的李代数.3.2机械臂参数本文所使用机械臂仿真环境参数如下:1)状态空间s =(s f ,s ob ,s ob2g ,s obs ),其中:s f 包含夹具位置(x f ,y f ,z f ),线速度(x ′f ,y ′f ,z ′f ),手指的相对距离d f 和相对速率d ′f ;s ob 包括可移动物体的位姿(x ob ,y ob ,z ob ,αob ,βob ,γob ),线速度和角速度(x ′ob ,y ′ob ,z ′ob ,α′ob ,β′ob ,γ′ob );s ob2g 表示可移动物体与目标的距离差(x ob2g ,y ob2g ,z ob2g );s obs 表示障碍物的位姿(x obs ,y obs ,z obs ,αobs ,βobs ,γobs ),若环境中无障碍物,则s obs 为空集;2)动作空间a =(x a ,y a ,z a ,d f ),其中:d f 为夹爪手指的相对距离,(x a ,y a ,z a )表示机械臂下一步将运动到的位置;3)目标g =(x g ,y g ,z g )表示目标位置;4)奖励函数R 如式(4)所示,未完成任务则给予惩第3期王寅等:基于深度强化学习与旋量法的机械臂路径规划519罚“−1”,反之反馈值为“0”.R =−1,d (ob ,g ) ϵ,0,d (ob ,g )>ϵ,(4)其中:d (ob ,g )为可移动物体与目标之间的距离标量;ϵ为距离阈值,d (ob ,g ) ϵ时判定任务完成.3.3自然轨迹与人工轨迹的映射假定一条长度为h 的轨迹τ={g,(s 0,a 1,r 1,s 1,a 2,r 2,s 2,···,s h )},g ∈G ,s 0∈S ,∀i =1,2,···,h ,s i ∈S ,a i ∈A ,r i =R (s i −1,a i ,s i ,g ).假定所有在真实存在的机械臂中的轨迹的长度不大于H ∈N (即每个操作长度有限),则所有轨迹集合为L =H ∪h =1G ×S ×(A ×R ×S )h .所有可行轨迹集合为L ⊆L .对于τ∈L ,都有T (s i −1,a i ,s i ),则判定τ∈L .对于τ∈L ,若满足条件R (τ)>R min 或r i >R min ,则判定τ为成功轨迹.其中:R (τ)=h ∑i =1γi −1R (s i −1,a i ,s i ,g ),R min 为阈值.本文中的成功条件为r i >R min ,阈值为R min =−1.成功轨迹集合为L +⊆L .定义可行轨迹L 的映射为f :L →L ,使得f (L ,θ)=L ,其中f (L ,θ)={τ∈L|∃τ′∈L ,f (τ′,−θ)=τ}(下文将f (L ,θ)简化为f (L )表示).对于任意轨迹τ∈L 进行映射f 时,其元素也存在映射f G :G →G ,f S :S →S ,f A :A →A .换言之,状态、动作和奖励都可进行单独映射,即对于任意τ∈L 都存在f (τ)=τ′∈L .定义自然轨迹为τ={g,(s 0,a 1,r 1,s 1,a 2,r 2,s 2,···,s h )},所得人工轨迹为τ′={g ′,(s ′0,a ′1,r ′1,s ′1,a ′2,r ′2,s ′2,···,s ′h )},则τ与τ′中的元素满足以下映射关系:g ′=f G (g ),s ′0=f S (s 0),∀i =1,2,···,h ,a ′i =f A (a i ),s ′i =f S (s i ),r ′i =R (f S (s i −1),f A (a i ),f S (s i ),f G ).在SMIDRL 算法中,对于任意τ∈L 通过映射f 得到的人工轨迹τ′∈L ,其内部元素之间的相对距离并未改变(例如机械臂末端相对于目标的距离并未改变,即d (ob ,g )=d (f S (ob),f G (g ))),因此自然轨迹τ映射得到人工轨迹τ′后奖励值不变,即r ′i =r i .所有成功轨迹L +⊆L 同样适用可行轨迹L 的映射关系.3.4SMIDRL 算法旋量法的本质是旋转,通过旋量法对轨迹映射(简称为旋量映射)后,可能会生成工作区外的无效轨迹,因此设置参数θmax 来提高生成轨迹的有效性.SMIDRL 算法将机械臂与环境交互得到的自然轨迹通过旋量法进行扩充得到人工轨迹,在加以筛选后,与自然轨迹共同放入到经验回放库中.需通过旋量法进行映射的轨迹元素包括第3.2节中介绍的状态、动作、目标,其中包括位置矢量、线速度矢量、欧拉角、角速度以及夹具相对距离和相对速度等元素.夹具相对距离和相对速度是刚体内的元素,在经过旋量映射以后并不会被改变,因此不对其进行映射.在仿真环境中,因为机械臂底座坐标系未与世界坐标系重合,故需将机械臂底座坐标系简单转换至世界坐标系,接下来的介绍将默认已进行转换.每条自然轨迹可同时进行多次映射,在此定义每条自然轨迹进行旋量映射次数的参数n tw ,具体如下所示:Θ={θj |θj ∼(0,θmax ],j =1,2,···,n tw },(5)其中Θ表示在(0,θmax ]采样n tw 次所得角度的集合.每次旋量映射除了旋量参数ξ和角度θ以外并无改变,接下来仅介绍单次旋量映射.为了方便介绍,下文所有位置和线速度皆以(x,y,z )表示,所有弧度和角速度皆以(α,β,γ)表示.首先,将对应的(x,y,z )和(α,β,γ)(如障碍物的位置和姿态、可移动物体的线速度和角速度定义为对应)转换为以下SE (3)矩阵形式:g 0=[R 0p 001],(6)其中:R 0=Eul(α,β,γ),p 0=[x y z ]T .再根据式(1)得到该轨迹参数ξ,θ对应的旋量矩阵g (ξ,θ),则可得(x ′,y ′,z ′)和(α′,β′,γ′)的SE (3)矩阵g =g (ξ,θ)g 0=[R ′p′01],(7)从而可得到映射后的(x ′,y ′,z ′)和(α′,β′,γ′):[x ′,y ′,z ′]=(p ′)T ,(8)[α′,β′,γ′]=Eul −1(R ′),(9)其中:Eul(·)为将欧拉角映射为旋转矩阵SO (3)的运算,Eul −1(·)为Eul(·)的逆运算.以上为单次旋量映射的过程,下文将由Sc 表示,如将状态s 映射为s ′,可用s ′←Sc (s )表示.旋量映射完成后,需通过生成轨迹是否在工作空间内等条件来判断该轨迹是否有效,如有效才可存放至经验池.SMIDRL 算法的伪代码见算法1所示.SMIDRL 算法将已得到的自然轨迹进行复制扩充,在不进行额外探索的情况下获得更多廉价的有效人工轨迹,从而提高样本利用率和学习效率;在复制轨迹的同时,对障碍物等环境元素进行同步改变,以此提升机械臂对随机环境的泛化性能.4实验与验证4.1实验环境实验环境如下:仿真环境为Mujoco 平台中具有双指平行夹具的模拟7自由度Fetch 机械臂和6自由度520控制理论与应用第40卷UR5机械臂;深度强化学习算法为DDPG 算法;神经网络框架为Pytorch;显卡为GeForce GTX 2080Ti;CPU 为Intel(R)Core(TM)i9-9900X CPU @3.50GHz;操作系统为Ubuntu16.04;GPU 为32G.算法1:DRL 与旋量法的融合算法(SMIDL)Input :离线策略DRL 算法D ,容量为N 的经验回放库R ,回合数(episode)M ,每回合步数T ,采样样本数m ,最大角度θmax ,旋量参数ξ,旋量映射次数n tw .1初始化离线策略DRL 算法D 和经验回放库R 2for episode =1,2,···,M do3获得目标g 和初始状态s 1.4for t =1,2,···,T do5通过算法D 获得动作a t 并执行;6到达下一状态s t +1,计算得奖励值r t ;7将转移样本(s t ,a t ,r t ,s t +1)存入R ;8end9for j =1,2,···,n tw do10采样获得角度θj ∼(0,θmax ];11根据θj 和ξ映射g 和s 1:12g ′←Sc (g ),s ′1←Sc (s 1);13for t =1,2,···,T do14根据θj 和ξ映射a t 和s t +1:a ′t ←Sc (a ′),s ′t +1←Sc (s t +1);15if 该人工轨迹为有效轨迹then16将(s ′i ,a ′i ,r i ,s ′t +1)存入R 17end18end19end20for t =1,2,···,T do21从R 进行随机采样m 个转移样本(s,a,r,s ′);22使用算法D 和采样转移样本进行优化23end 24end仿真环境包括如图3–5所示的Fetch 机械臂仿真环境以及如图6所示的UR5机械臂仿真环境.Fetch 机械臂仿真环境包括推动、滑动、拾取和放置任务,UR5机械臂仿真环境为拾取和放置任务.在所有任务中,每一回合都会使可移动物体和障碍物在桌上进行随机初始化.图3–6中可移动物体为黑色方块,预设目标为红色球体,障碍物为黄色方块.状态、动作及奖励函数等如第3.2节定义.1)推动:该任务通过机械臂末端将物体推动至桌上的预设位置.2)拾取和放置:该任务先使用机械臂末端的夹爪将物体拾取,再将物体放置到工作空间中的预设位置.3)滑动:该任务通过机械臂末端对物体施加一个力,使物体在存在摩擦力的前提下滑动到桌子上的预设位置(目标位置在机械臂的工作区之外).(a)无障碍物任务(b)有障碍物任务图3推动任务的环境Fig.3Environment of the pushingtask(a)无障碍物任务(b)有障碍物任务图4拾取与放置任务的环境Fig.4Environment of the pick-and-placement task第3期王寅等:基于深度强化学习与旋量法的机械臂路径规划521(a)无障碍物任务(b)有障碍物任务图5滑动任务的环境Fig.5Environment of slidingtask图6UR5机械臂的拾取与放置任务环境Fig.6Pick-and-placement task environment of UR5manipulator4.2神经网络超参数设置在本文实验所使用的算法中,其网络框架超参数设置如表1所示,除非有特殊说明,否则超参数值不做改变.4.3算法评判标准在强化学习中,一回合(epoch)由固定大小的连续步(episode)组成,因此可以通过计算每回合(即每迭代一次)中成功的步数来计算该回合的成功率.以此为基础,在本文实验中,算法每次更新完成后,都会通过当前的训练模型控制机械臂执行10次任务并求得其平均成功率,该平均成功率则为当前时刻的训练模型优劣性的评判标准.表1神经网络框架超参数Table 1Hyperparameter of neural networkframework超参数符号超参数名称具体数值α策略网络学习率0.001β评价网络学习率0.001τ目标网络软更新参数0.1γ衰减因子0.98m 小批量采样样本数128N 经验回放池容量1×106M 回合数200T每回合步数504.4实验与分析本文实验中,分别给推动、拾取和放置任务8倍加速,由于滑动任务更加困难,因此给它24倍加速.前文提到SMIDRL 与HER 算法融合后可使样本利用率提升更高,接下来将使用HER 算法中效果最好的“未来策略”进行验证,HER 算法的使用次数为4.为了更好介绍SMIDRL 算法的性能,本文将通过无障碍情况下有无HER 算法、不同次数的旋量映射、存在障碍物情况这3种情况进行实验对比并验证.同时为了证明SMIDRL 的通用性,本文通过solidworks 导出的UR5机械臂模型,保存UR5机械臂的物理参数,在存在障碍物环境下让该UR5机械臂进行“拾取与放置”实验.本实验中所展示数据图皆截取至Tensor-board,为方便对比已用Tensorboard 自带插件进行拟合,其中被虚化部分为原始数据,实体部分为拟合后数据.4.4.1无障碍情况下有无HER 算法的性能比较本实验将通过DRL,SMIDRL,DRL+HER 以及S-MIDRL+HER 这4种情况进行对比,来验证SMIDRL 算法提升性能的有效性,且与HER 算法融合后性能可使提升更高.其中推动任务、拾取与放置任务进行旋量映射的次数n tw =16,滑动任务进行旋量映射的次数n tw =24.实验结果如图7所示,实验分析如下:1)在推动任务中,DRL 算法的成功率呈微下降趋势;SMIDRL 算法的成功率在160回合开始上升,最高达到30%;HER+DRL 算法的成功率于60回合开始上升;HER+SMIDRL 算法在60回合时成功率就达到90%以上,并于80回合左右达到峰值且大致平稳;2)在拾取与放置任务中,DRL 算法的效果较差,成功率无上升趋势且均低于10%;SMIDRL 算法在100回合处成功率开始上升;HER+DRL 算法的成功率522控制理论与应用第40卷虽有增长,但相对缓慢,200回合时成功率都未高于90%;HER+SMIDRL 算法在120回合左右成功率就已达到峰值,并大致保持平稳;3)滑动任务相对其他两个任务更为困难,相对于HER+DRL 算法,HER+SMIDRL 算法仅得到微弱的提升;但在未融入HER 算法的情况下,SMIDRL 算法对比DRL 算法的优势较为明显:DRL 算法成功率无上升趋势,而SMIDRL 算法在130回合后成功率开始增高.(a)拾取与放置任务(b)滑动任务(c)推动任务图7无障碍任务下SMIDRL 算法的性能Fig.7Performance of SMIDRL without obstacle综上,在无障碍情况下,SMIDRL 算法的效率明显高于DRL 算法,且融入HER 算法后SMIDRL 算法提升更为显著.4.4.2不同次数旋量法对性能的影响本实验将通过进行不同次数旋量映射的实验,来比较在无障碍物的情况下不同次数旋量映射对算法性能的影响.在此次实验中,将在HER+SMIDRL 算法的基础上,通过0次、1次、8次、16次及32次旋量映射来进行比较.实验结果如图8所示,实验分析如下:1)在推动任务中,单次旋量映射的算法与未进行旋量映射的相比,训练效率得到大幅提升;而n tw =1到n tw =32的区别不大,在训练前期(60回合前)随着旋量映射次数增多成功率提升越快,在60回合左右达到最高值;2)拾取与放置任务与推动任务相似,n tw =1相对于n tw =0,其算法性能提升明显:n tw =0的成功率均低于90%,而n tw =1的成功率于140回合左右达到峰值;而n tw =1到n tw =32虽对算法的训练效率虽有提升,但提升幅度随着旋量映射次数的增加而减少;3)滑动任务相对更为复杂,随着旋量映射次数增多,训练效率虽能得到提升,但提升幅度降小.(a)拾取与放置任务(b)滑动任务(c)推动任务图8无障碍环境下进行不同次数旋量映射的比较Fig.8Comparison of screw-mapping with different times inbarrier-free environments在这3个任务中,在一定的旋量映射次数范围内,随着旋量映射的次数增加,成功率随之升高,但提升第3期王寅等:基于深度强化学习与旋量法的机械臂路径规划523效果逐渐降低.4.4.3存在障碍物情况的性能比较本实验将在仿真环境中加入障碍物,以此验证SMIDRL 算法在障碍物环境中也是可行有效的.为了方便对比,本实验将融入HER 算法,即通过HER+DRL 算法与HER+SMIDRL 算法进行对比分析.实验结果如图9所示,由于障碍物的加入使环境变得复杂,导致HER+DRL 的训练模型成功率均处于较低的状态.实验分析如下:1)在推动任务中,HER+DRL 算法成功率低于10%,但HER+SMIDRL 算法成功率逐步上升,在90回合开始成功率保持在90%以上;2)在拾取与放置任务中,HER+DRL 算法的成功率上升缓慢,在130回合处才开始有明显上升趋势;HER+SMIDRL 算法的成功率在40回合左右开始稳步上升,在120回合后保持在90%左右;3)由于滑动任务相对其他两个任务难度更大,故仅有小幅度的性能提升.(a)拾取与放置任务(b)滑动任务(c)推动任务图9存在障碍任务下SMIDRL 算法的性能Fig.9Performance of SMIDRL with obstacle综上,SMIDRL 算法在存在障碍物的非结构化下同样具备提升样本利用率和模型泛化性能的能力.4.4.4UR5机械臂的性能验证前3个实验已经验证SMIDRL 在Fetch 机械臂环境中的可行性,本实验将通过UR5机械臂在障碍物环境下进行拾取与放置实验,验证SMIDRL 的通用性以及在现实环境的可行性.在本实验中,旋量映射参数n tw 设置为16,为了方便对比观察,此实验都将融入HER 算法,即通过HER+DRL 与HER+SMIDRL 进行分析.实验结果如图10所示.由于UR5机械臂为六自由度,在障碍物环境中运动受限,因而成功率较低.HER+DRL 算法成功率低于10%,而HER+SMIDRL 算法在130回合左右将成功率稳定在42%左右.图10UR5机械臂下的SMIDRL 性能验证Fig.10SMIDRL performance verification in UR5manipulator5结论针对深度强化学习在机械臂路径规划的应用中仍面临的样本需求量大和获取成本高的问题,本文提出了SMIDRL 算法,并通过Fetch 机械臂和UR5机械臂在非结构化环境下的仿真实验进行了验证.SMIDRL 算法通过旋量法与DRL 算法的融合,在同样的探索次数下,能够复制更多的有效轨迹并投入训练,使训练效率得到提升;并且在进行轨迹扩充的同时,通过对目标、障碍物等环境元素进行同步复制的方式,对交互环境进行相应改变,从而提高了机械臂在复杂随机环境中的适应能力,提高训练模型的泛化性能.实验结果表明,在未融入HER 算法的情况下,旋量法对训练模型有质的提升;在与HER 算法结合后,加快了在推动、拾取与放置任务中的学习速度,大幅提高了机械臂的成功率.在滑动任务中也有一定的性能提升,且在有障碍物的复杂环境中,采用SMIDRL 算法的性能提升效率更为明显.参考文献:[1]YANG C,ZENG C,CONG Y ,et al.A learning framework of adap-tive manipulative skills from human to robot.IEEE Transactions on Industrial Informatics ,2018,15(2):1153–1161.524控制理论与应用第40卷[2]YANG C,WU H,LI Z,et al.Mind control of a robotic arm with vi-sual fusion technology.IEEE Transactions on Industrial Informatics, 2017,14(9):3822–3830.[3]NUBERT J,KOHLER J,BERENZ V,et al.Safe and fast tracking ona robot manipulator:Robust mpc and neural network control.IEEERobotics and Automation Letters,2020,5(2):3050–3057.[4]PIAZZI A,VISIOLI A.Global minimum-jerk trajectory planningof robot manipulators.IEEE Transactions on Industrial Electronics, 2000,47(1):140–194.[5]SARAMAGO S F P,JUNIOR V S.Optimal trajectory planning ofrobot manipulators in the presence of moving obstacles.Mechanism and Machine Theory,2000,35(8):1079–1094.[6]SARAMAGO S F P,STEFFEN JR V.Optimization of the trajectoryplanning of robot manipulators taking into account the dynamics of the system.Mechanism and Machine Theory,1998,33(37):883–894.[7]KARAMAN S,WALTER M R,PEREZ A,et al.Anytime motionplanning using the RRT.IEEE International Conference on Robotics and Automation.Shanghai:IEEE,2011:1478–1483.[8]CANNY J.The Complexity of Robot Motion Planning.Canbridge:MIT press,1988.[9]BARRAL D,PERRIN J P,DOMBRE E,et al.An evolutionary simu-lated annealing algorithm for optimizing robotic task point ordering.Proceedings of the IEEE International Symposium on Assembly and Task Planning(ISATP’99)(Cat.No.99TH8470).Porto:IEEE,1999: 157–162.[10]ZHAO Dongbin,SHAO Kun,ZHU Yuanheng,et al.Summary ofdeep reinforcement learning:Also on the development of computer go.Control Theory&Applications,2016,33(6):701–717.(赵冬斌,邵坤,朱圆恒,等.深度强化学习综述:兼论计算机围棋的发展.控制理论与应用,2016,33(6):701–717.)[11]TANG Zhentao,SHAO Kun,ZHAO Dongbin,et al.Progress in deepreinforcement learning:From Alphago to Alphago zero.Control The-ory&Applications,2017,34(12):1529–1546.(唐振韬,邵坤,赵冬斌,等.深度强化学习进展:从AlphaGo到AlphaGo Zero.控制理论与应用,2017,34(12):1529–1546.)[12]ZHONG J,WANG T,CHENG L.Collision-free path planning forwelding manipulator via hybrid algorithm of deep reinforcement learning and inverse plex&Intelligent Systems, 2022,8(3):1899–1912.[13]PRIANTO E,PARK J H,BAE J H,et al.Deep reinforcementlearning-based path planning for multi-arm manipulators with peri-odically moving obstacles.Applied Sciences,2021,11(6):2587.[14]SANGIOV ANNI B,INCREMONA G P,PIASTRA M,et al.Self-configuring robot path planning with obstacle avoidance via deep re-inforcement learning.IEEE Control Systems Letters,2020,5(2):397–402.[15]SANGIOV ANNI B,RENDINIELLO A,INCREMONA G P,etal.Deep reinforcement learning for collision avoidance of robotic manipulators.European Control Conference(ECC).Limassol, CYPRUS:IEEE,2018:2063–2068.[16]LI F,JIANG Q,ZHANG S,et al.Robot skill acquisition in assemblyprocess using deep reinforcement learning.Neurocomputing,2019, 345:92–102.[17]LIN G,ZHU L,LI J,et al.Collision-free path planning for a guava-harvesting robot based on recurrent deep reinforcement learning.Computers and Electronics in Agriculture,2021,188:106350.[18]IRIONDO A,LAZKANO E,SUSPERREGI L,et al.Pick and placeoperations in logistics using a mobile manipulator controlled with deep reinforcement learning.Applied Sciences,2019,9(2):348.[19]WEN S,CHEN J,WANG S,et al.Path planning of humanoid armbased on deep deterministic policy gradient.IEEE International Con-ference on Robotics and Biomimetics.Kuala Lumpur:IEEE,2018: 1755–1760.[20]LI Z,MA H,DING Y,et al.Motion planning of six-dof arm robotbased on improved DDPG algorithm.The39th Chinese Control Con-ference IEEE.Shenyang:IEEE,2020:3954–3959.[21]LIN L J.Self-improving reactive agents based on reinforcementlearning,planning and Teaching.Machine Learning,1992,8(3/4): 293–321.[22]ANDRYCHOWICZ M,WOLSKI F,RAY A,et al.Hindsight experi-ence replay.The31th Conference on Neural Information Processing Systems(NIPS2017),Long Beach,CA,USA:2017,30:5048–5058.[23]MURRAY,RICHARD M,ZEXIANG LI,et al.A Mathematical In-troduction to Robotic Manipulation.Boca Raton:CRC press,2017: 61–66.[24]BROCKMAN G,CHEUNG V,PETTERSSON L,et al.OpenAIGym.arXiv Preprint,2016:1606.0154OVI.[25]PLAPPERT M,ANDRYCHOWICZ M,RAY A,et al.Multi-goalreinforcement learning:Challenging robotics environments and request for research.ArXiv Preprint,2018:arXiv:1802.09464.[26]LILLICRAP T P,HUNT J J,PRITZEL A,et al.Continuous con-trol with deep reinforcement learning.International Conference on Learning Representations(Poster).Santiago:ICLR,2015.[27]SCHAUL T,HORGAN D,GREGOR K,et al.Universal value func-tion approximators.International Conference on Machine Learning.Lile:ICML,2015:1312–1320.[28]V AN HASSELT H,GUEZ A,SILVER D.Deep reinforcementlearning with double q-learning.Proceedings of the AAAI Conference on Artificial Intelligence.Texas:AAAI,2016,30(1):2094–2100.作者简介:王寅硕士研究生,目前研究方向为深度强化学习、串联机械臂、路径规划,E-mail:*********************;王永华副教授,博士,目前研究方向为信号处理、机器学习、智能测控,E-mail:********************.cn;尹泽中硕士研究生,目前研究方向为移动机械臂、深度强化学习、运动规划,E-mail:*********************;万频教授,博士,目前研究方向为智能测控技术、信号处理、物联网,E-mail:***************.第40卷第3期2023年3月控制理论与应用Control Theory&ApplicationsV ol.40No.3Mar.2023基于双边闭环函数的网络化采样控制系统稳定性分析曾红兵,颜俊杰,肖会芹†(湖南工业大学电气与信息工程学院,湖南株洲412007)摘要:考虑数据通信时延不确定环境下网络化采样控制系统的稳定性问题.首先基于输入时滞方法,建立包含采样周期信息的网络化采样控制系统的数学模型,在此基础上,采用双边闭环函数方法和自由矩阵积分不等式技术,得到网络传输时滞变化区间依赖稳定性新准则,并进一步讨论了网络化采样控制系统中网络时延与采样周期之间的关系.仿真结果表明减小采周期可以增强网络控制系统对网络通信时延的鲁棒性.关键词:网络控制系统;双边闭环函数;自由矩阵积分不等式;不确定数据传输时滞引用格式:曾红兵,颜俊杰,肖会芹.基于双边闭环函数的网络化采样控制系统稳定性分析.控制理论与应用, 2023,40(3):525–530DOI:10.7641/CTA.2022.11008Stability analysis of networked control system based ontwo-sided looped functionalsZENG Hong-bing,YAN Jun-jie,XIAO Hui-qin†(School of Electrical and Information Engineering,Hunan University of Technology,Zhuzhou Hunan412007,China) Abstract:The stability of a class of networked sampled-data control systems with data transmission delay is studied. Firstly,based on the input delay method,a model of networked control systems with periodic sampling is established.On this basis,a new stability criterion with uncertain transmission delay is obtained by using the two-sided looped function method and the free matrix integral inequality technique.Furthermore,the relationship of uncertain data transmission delay and the sampling period in networked sampled-data control system is investigated.Simulation results show that reducing the sampling period can improve the robustness of networked control system.Key words:networked control system;two-sided looped-functionals;free-matrix-based integral inequality;uncertain delayCitation:ZENG Hongbing,YAN Junjie,XIAO Huiqin.Stability analysis of networked control system based on two-sided looped functionals.Control Theory&Applications,2023,40(3):525–5301引言伴随着计算机和网络通讯技术的迅速发展,网络控制系统(networked control system,NCS)得到了广泛的关注[1].在网络控制系统中,采样作为信息处理的前端,在网络通讯、数据传输的过程中起着重要作用.增大采样周期可以降低信息的传输量,从而有效的节约网络通讯资源.此外,系统元件执行的速度和网络带宽是有限的,在信号的采集和传输中不可避免的会产生拥堵,从而导致数据传输时滞.因此,在具有数据传输时滞的网络环境下研究不确定时滞与保证系统稳定允许的最大采样周期之间的关系对实际网络控制系统的设计具有指导意义.目前,采样控制系统已经被学者们广泛研究并取得了许多重要成果[2–6].针对采样控制系统问题的稳定性问题,主要采用以下3种方法:1)离散时间系统方法[3],此方法主要应用于确定采样区间,它将采样系统构建为一个离散的时间系统模型,并基于离散时间系统理论进行分析;2)脉冲系统方法[4],此方法将采样系统建立成一个脉冲系统进行分析;3)输入时滞方法[5–6],此方法是将采样系统转化为具有输入时滞的连续时间系统,并基于连续时间系统理论进行分析.2012年,针对采样控制系统的稳定性问题,文献收稿日期:2021−10−21;录用日期:2022−07−27.†通信作者.E-mail:xiaohq***********;Tel.:+86731-22183270.本文责任编委:施阳.国家自然科学基金项目(62173136),湖南省自然科学基金项目(2020JJ2013,2021JJ50047)资助.Supported by the National Natural Science Foundation of China(62173136)and the National Natural Science Foundation of Hunan Province (2020JJ2013,2021JJ50047).。

机器人路径规划算法的研究与改进人工智能的发展已经使得机器人在各个领域发挥了重要的作用,而机器人路径规划算法就是其中的关键技术之一。

路径规划算法就是指机器人在给定环境中找到一条从起点到终点的最优路径的方法。

本文将就机器人路径规划算法的研究现状和改进方向进行探讨,以期能够提高机器人的运动效率和应用范围。

一、传统路径规划算法的研究现状目前,较为常用的传统路径规划算法有最短路径算法、A*算法、Dijkstra算法等。

最短路径算法主要基于图论中的最短路径问题,通过计算图中节点之间的距离和路径的权重来确定最优路径。

A*算法在搜索过程中综合考虑了节点间的距离和启发函数的值,能够在最短路径问题中更加高效地搜索。

Dijkstra算法则是通过不断更新节点的最小距离值来找到最优路径。

然而,这些传统路径规划算法在解决机器人路径规划问题时存在一些不足之处。

首先,传统算法大多假设机器人在平坦环境中运动,无法应对复杂的三维空间和障碍物。

其次,算法的计算效率有待提高,特别是在面对大规模地图和复杂环境时,往往需要很长时间才能得到结果。

因此,研究者们开始转向深度学习和强化学习等新的路径规划算法。

二、深度学习在路径规划中的应用深度学习是近年来兴起的一种机器学习方法,通过神经网络模型对特征进行学习和抽取。

在路径规划中,研究者们尝试将深度学习应用于机器人的感知、决策和控制等环节,以获得更加智能和高效的路径规划方案。

深度学习在路径规划中的应用主要有两个方面。

首先,研究者们利用深度学习模型对传感器数据进行处理和分析,提取环境中的障碍物信息,从而有效避免障碍物的干扰。

其次,深度学习模型可以通过学习大量的历史路径数据,对路径规划过程进行优化和预测。

这种基于数据驱动的路径规划方法不仅能够提高机器人的运动效率,还能够适应更加复杂的环境和任务。

然而,深度学习方法也存在一些挑战。

首先,深度学习模型需要大量的训练数据,但在机器人路径规划中获取这样的数据并不容易。

基于改进人工势场的苹果采摘机器人机械手避障方法 姬伟;程风仪;赵德安;陶云;丁世宏;吕继东 【期刊名称】《农业机械学报》 【年(卷),期】2013(44)11 【摘 要】针对非结构化环境下的采摘机器人机械手实时避障问题,提出一种改进人工势场法的避障路径规划方法.根据自行研制的5自由度苹果采摘机器人机械手具体结构和障碍物特征,进行机械手运动学分析和障碍物建模;在保留传统人工势场法易于实现、结构简单等优点的基础上,针对其存在的局部极小点、陷进区等问题,结合果树生长环境中障碍物的特点,通过引入虚拟目标点使搜索过程跳出局部最优的极小点,从而实现机械手避开障碍物到达目标的灵活避障;将该方法应用于机械手末端位置、障碍物位置和目标位置已知条件下的采摘机器人机械手实时避障任务中,仿真和实验研究结果表明此方法简单,实时性好,能够有效地避开障碍物,成功到达目标位置,适合自然生长状态下苹果的自动采摘.

【总页数】7页(P253-259) 【作 者】姬伟;程风仪;赵德安;陶云;丁世宏;吕继东 【作者单位】江苏大学电气信息工程学院,镇江212013;江苏大学电气信息工程学院,镇江212013;江苏大学电气信息工程学院,镇江212013;江苏大学电气信息工程学院,镇江212013;江苏大学电气信息工程学院,镇江212013;江苏大学电气信息工程学院,镇江212013

【正文语种】中 文 【中图分类】TP24 【相关文献】 1.基于改进人工势场法的机械手避障规划 [J], 胡小平;谢珂;左富勇 2.基于模糊改进人工势场法的机器人避障方法研究 [J], 游文洋;章政;黄卫华 3.基于改进人工势场法的机器人避障方法的研究 [J], 张红 4.基于改进人工势场法的搬运机器人避障算法研究 [J], 付泽民;吴力杰;乔涛涛;石博文;余奇 5.基于改进人工势场法的移动机器人避障研究 [J], 任工昌;郭维鹏;刘朋

因版权原因,仅展示原文概要,查看原文内容请购买

基于改进快速扩展随机树的机械臂路径规划张云峰;马振书;孙华刚;陆继山【摘要】针对机械臂路径规划问题,提出一种基于改进RRT算法的路径规划方法。

改进RRT结合了目标偏置策略和贪婪生长策略的优点,在随机采样时,以一定概率使采样点偏置为目标节点,降低随机采样的盲目性,在目标节点方向上采用贪婪式扩展策略,增加随机树局部方向上的生长速度。

RRT法规划路径结果并非最优,提出改进GPP法删除多余路径节点,优化机械臂运动路径。

通过与Biased-RRT和Greedy-RRT数值仿真结果对比,证明了改进RRT在计算时间、迭代次数、扩展节点数上均优于以上方法。

在机械臂两种典型工作环境中的仿真结果表明,使用该方法可以较好解决排爆机械臂避障路径规划问题。

%A certain improved rapidly-exploring random tree is proposed to solving the path planning problem of EOD manipulators. The improved RRT combines advantages of biased strategy and greedy strategy. By selecting goal node with some probability when sampling,improved RRT reduces the blindness of RRT. Greedy strategy is used for extending trees in the direction of goal node to enhance the extending rapid. The results by RRT are not optimal,an improved GPP technique is developed to prune the redundant nodes of planned paths,optimize the motion path of manipulators. By comparingthe numerical simulation results of Biased-RRT and Greedy-RRT,the high efficiency of improved RRT is proved in computation time,iterations and number of extended nodes. The simulation results in two typical environments show that the algorithm can achieved path planning tasks well in obstacle circumstances.【期刊名称】《火力与指挥控制》【年(卷),期】2016(041)005【总页数】6页(P25-30)【关键词】路径规划;快速扩展随机树;RRT;机械臂;最优路径【作者】张云峰;马振书;孙华刚;陆继山【作者单位】军械工程学院,石家庄 050003;军械技术研究所2室,石家庄050003;军械技术研究所2室,石家庄 050003;军械工程学院,石家庄 050003【正文语种】中文【中图分类】TP241.3机器人路径规划是机器人学的重要议题,它自20世纪70年代提出以来,逐渐成为人们的研究热点。

机械臂运动轨迹规划与优化研究引言:机械臂已广泛应用于工业生产、医疗手术、服务机器人等领域。

机械臂的运动轨迹规划与优化是提高机械臂运动效率、精确度和安全性的关键研究领域。

本文将围绕机械臂运动轨迹规划与优化展开讨论。

一、机械臂运动轨迹规划的重要性机械臂运动轨迹规划是机械臂运动控制的核心环节,合理的轨迹规划可以使机械臂在复杂环境下实现高效、安全的运动。

通过规划合理的运动轨迹,机械臂可以避开障碍物,减少能耗,提高运动速度和精确度。

二、机械臂运动轨迹规划的方法1. 笛卡尔空间规划笛卡尔空间规划是最简单直观的机械臂轨迹规划方法,通过规定机械臂末端的位置和姿态来确定机械臂的运动轨迹。

然而,笛卡尔空间规划无法保证机械臂避开障碍物,且运动路径不够灵活。

2. 关节空间规划关节空间规划是通过控制机械臂关节的转动角度来确定运动轨迹。

该方法具有较高的灵活性,但需要对机械臂关节的运动范围和约束条件进行精确建模。

3. 混合空间规划混合空间规划结合了笛卡尔空间和关节空间规划的优点,既考虑了机械臂末端的位置和姿态,又考虑了关节的运动约束。

该方法能够更好地规划机械臂的运动轨迹,提高运动效率和精确度。

三、机械臂运动轨迹优化的方法1. 最短路径规划最短路径规划是优化机械臂运动轨迹的常用方法之一。

该方法通过寻找距离最短的路径,使机械臂在有限时间内快速到达目标位置。

最短路径规划可以利用图论算法如Dijkstra算法和A*算法来求解。

2. 平滑轨迹生成平滑轨迹生成可以使机械臂运动过程更加连续平滑,避免不必要的抖动和震荡。

常用的平滑轨迹生成方法有三次样条插值和贝塞尔曲线拟合等。

3. 动力学优化动力学优化是针对机械臂运动中的力耗、振动等问题进行优化的方法。

通过建立动力学模型,可以优化机械臂的控制策略,减小能量消耗,提高运动稳定性。

四、机械臂运动轨迹规划与优化的挑战1. 复杂环境机械臂运动轨迹规划与优化在复杂环境下会面临更多的挑战,例如多个障碍物、不确定的环境变化等。

改进人工势场法的机械臂避障路径规划研究唐彪;何波【摘要】文章针对人工势场法可能会进入局部极小这一缺陷,通过添加虚拟目标点来改进人工势场法.该方法可以让机械臂逃离局部极小点,实现机械臂的避障路径规划.文章使用DH模型对机械臂进行正逆运动学分析,使用椭球包围盒进行机械臂碰撞检测,通过建立目标点,机械臂的引力场和障碍物对机械臂的斥力场,再搜索势函数的下降方向,实现机械臂的路径规划.最后仿真结果验证,使用虚拟目标点的人工势场法可以快速有效地进行避障规划路径.【期刊名称】《无线互联科技》【年(卷),期】2017(000)003【总页数】4页(P115-117,124)【关键词】机械臂路径规划;碰撞检测;人工势场法【作者】唐彪;何波【作者单位】中国海洋大学信息科学与工程学院,山东青岛 266100;中国海洋大学信息科学与工程学院,山东青岛 266100【正文语种】中文机械臂避障路径规划是指在有障碍的环境下,机械臂按照某种算法找到一条从起始点到目标点的无碰撞路径[1]。

人工势场法是路径规划的一种,具有运算速度快、实时性较高的优点。

人工势场法的基本原理是建立目标点对机械臂的引力场和障碍物对机械臂的斥力场,在引力场和斥力场作用下,引导机器人向目标点移动[2]。

人工势场法是一种局部最优的算法,容易进入局部极小点。

可以通过改变局部极小点的环境来让机械臂逃离局部极小点,本文使用虚拟目标点来解决局部极小的问题。

2.1 机械臂运动模型(DH模型)在对机械臂进行路径规划时,需要知道机械臂末端点和目标点的相对位置,以及机械臂和障碍物的相对位置,这种位置关系一般使用矩阵来表示。

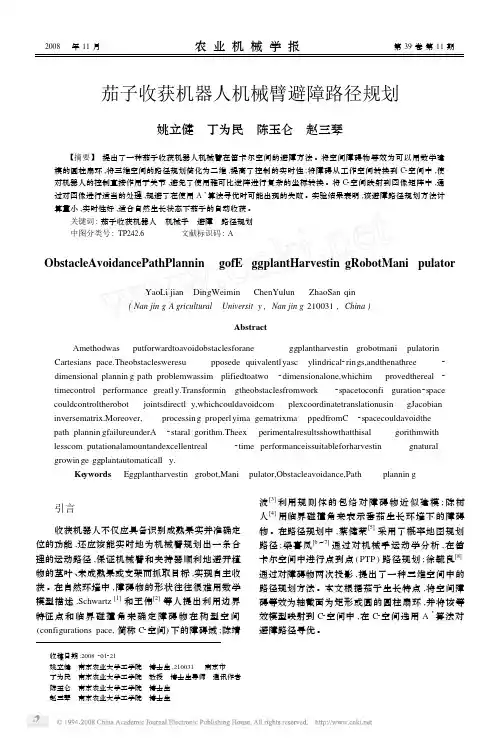

DH参数法是建立机械臂运动模型的一种有效的方法,机械臂的DH模型如图1所示。

在DH模型中,机械臂相连连杆之间的位置关系可由4个参数ai,ai,di及θi来确定。

其中,ai代表连杆长度,为常量;ai代表扭角,为常量,由连杆的属性决定。

di代表连杆偏置距离,在转动关节中di为常量;θi代表关节角,在移动关节中θi为常量[3]。

基于改进Informed-RRT^(*)的机械臂抓取运动规划第一篇范文基于改进Informed-RRT^(*)的机械臂抓取运动规划随着工业自动化技术的不断发展,机械臂作为自动化生产线上不可或缺的关键设备,其精准、高效的抓取运动规划成为研究的热点。

本文将探讨如何基于改进Informed-RRT^(*)算法实现机械臂的抓取运动规划。

1. Informed-RRT^(*)算法简介Informed-RRT^(*)算法是一种基于启发式搜索的规划算法,相较于传统RRT 算法,它在规划过程中引入了目标点的信息,以指导搜索方向的选取,从而提高了算法的搜索效率。

2. 改进Informed-RRT^(*)算法为了进一步提高Informed-RRT^(*)算法的性能,本文提出以下改进策略:1. 多目标点信息融合:在规划过程中,将多个目标点信息进行融合,以更准确地指导搜索方向的选取。

2. 自适应步长调整:根据当前搜索状态,动态调整步长大小,以平衡搜索效率和质量。

3. 节点邻域优化:对节点邻域进行优化,以减少无效搜索,提高算法的执行效率。

3. 机械臂抓取运动规划将改进Informed-RRT^(*)算法应用于机械臂抓取运动规划,主要包含以下几个步骤:1. 环境建模:对机械臂抓取环境进行建模,包括障碍物、目标点等。

2. 初始化:设置初始起点和目标点,启动改进Informed-RRT^(*)算法进行规划。

3. 优化:对规划得到的进行优化,以提高质量,减少抓取过程中的碰撞。

4. 执行控制:根据优化后的,生成机械臂的抓取控制指令,实现抓取任务。

4. 实验与分析为了验证改进Informed-RRT^(*)算法在机械臂抓取运动规划中的性能,我们在仿真环境中进行了实验。

实验结果表明,相较于传统Informed-RRT^(*)算法,改进后的算法在搜索效率和质量上都有了显著的提升。

5. 结论本文提出了一种基于改进Informed-RRT^(*)算法的机械臂抓取运动规划方法。

面向复杂环境的机器人路径规划与避障技术研究一、引言当前,机器人技术正在快速发展。

在工业自动化、家庭服务、医疗护理等领域,机器人逐渐替代人力完成精细、繁琐、危险或艰苦的工作。

但是,机器人在实际应用中面临的复杂环境下路径规划与避障问题仍然是一个重要的研究方向。

因为复杂环境中存在多种多样的不确定性因素,如地形、障碍物、新的物体等,这些都给机器人的路径规划和避障带来了特殊的挑战。

本文旨在探索面向复杂环境的机器人路径规划与避障技术研究的现状与发展方向。

二、机器人路径规划与避障技术的概述机器人路径规划与避障技术是指通过分析机器人目标与环境的信息,确定机器人运动轨迹以及如何避开障碍物的过程。

在复杂环境中,机器人的路径规划和避障需要综合考虑多种因素,如环境信息的获取、处理和建模、机器人运动规划算法的设计和优化、机器人感知系统的设计和优化,并需要解决多种对机器人规划和控制的技术难点,如路径的连续性、避障难度等。

全局路径规划和局部路径规划是机器人路径规划和避障的两个核心问题。

全局路径规划是指确定机器人从起点到终点的最优路径;局部路径规划是指在机器人行驶过程中,针对出现的障碍物重新规划路径。

在实现全局路径规划和局部路径规划过程中,障碍物的感知和定位、机器人状态估计精度和智能控制算法等技术是重要的关键因素。

三、当前机器人路径规划与避障技术的发展在复杂环境下机器人路径规划和避障的问题得到了广泛关注。

目前,相关技术分为基于几何模型的方法和基于人工神经网络或深度学习的方法两种。

1、基于几何模型的方法在基于几何模型的方法中,机器人路径规划和避障基于环境地图模型及碰撞检测算法。

这种方法的主要优点是准确性高,但由于依赖于较为准确的地图数据,因此适用范围受到限制。

2、基于人工神经网络或深度学习的方法在基于人工神经网络和深度学习的方法中,机器人无需预先得到环境地图,而是通过对多个场景的学习和识别,实现路径规划和避障。

这个方法可以处理复杂障碍物和不明确环境中的规划问题,但模型需要消耗较多的时间和计算资源。