第二十一讲广义特征值与极小极大原理

- 格式:pdf

- 大小:176.68 KB

- 文档页数:12

广义特征值分解广义特征值分解(Generalized Eigenvalue Decomposition, GED)是一种重要的矩阵分解方法,常常被应用在信号处理、机器学习等领域中。

它能够将两个矩阵同时对角化,得到它们的特征向量和特征值。

在本文中,我们将对广义特征值分解做一个详细的讲解。

步骤一:理解特征值与特征向量在矩阵计算中,特征向量是指在矩阵进行线性变换后仍然保留其方向的向量。

特征值是与特征向量相关的标量,描述了该特征向量在变换中的“伸缩”程度。

一般来说,我们可以通过解决以下方程式来找到一个矩阵的特征向量和特征值:(A−λI)v=0其中,A是一个方阵,λ是一个标量,I是单位矩阵,v是特征向量。

步骤二:理解广义特征值分解在广义特征值分解中,我们要找到两个矩阵A和B的特征向量和特征值。

也就是说,我们需要解决以下方程式:Av=λBv其中,v是特征向量,λ是特征值。

将其转化为标准形式:(A−λB)v=0这样,我们就可以将两个矩阵同时对角化,得到它们的特征向量和特征值。

步骤三:寻找广义特征值分解在实际应用中,我们可以使用数值计算方法来寻找广义特征值分解。

这包括基于迭代算法的方法,如幂法、反幂法和雅可比迭代法等。

其中,幂法是最常用的方法之一,可以用来寻找矩阵的最大特征值和对应的特征向量。

雅可比迭代法则是另一个最常见的方法,可以用来寻找所有特征值和对应的特征向量。

步骤四:应用广义特征值分解广义特征值分解在实际应用中有很多用途。

例如,它可以用来处理分析较大的数据集、图像、信号等。

在信号处理领域中,可以将电磁波分解为多个频率的成分,在图像处理领域中,可以寻找图像的相似性和模式。

在机器学习领域中,广义特征值分解可以被用来进行降维和特征提取。

总之,广义特征值分解是一种非常有用的矩阵分解方法,在很多领域中都被广泛应用。

理解广义特征值分解的原理和寻找方法,将有助于我们更好地应用这种方法来解决实际问题。

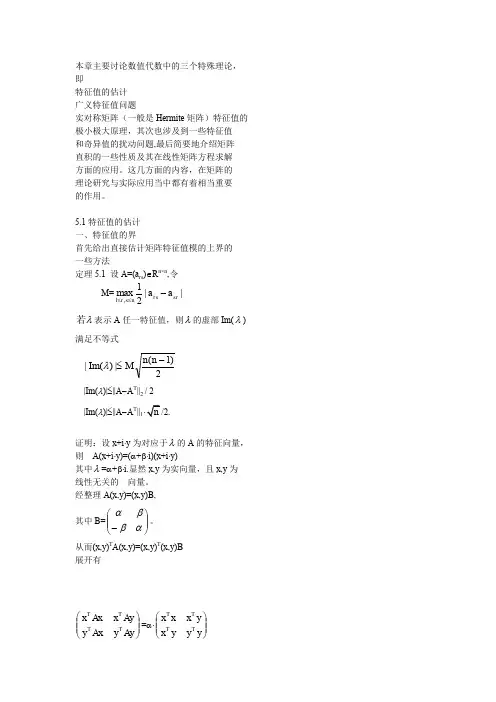

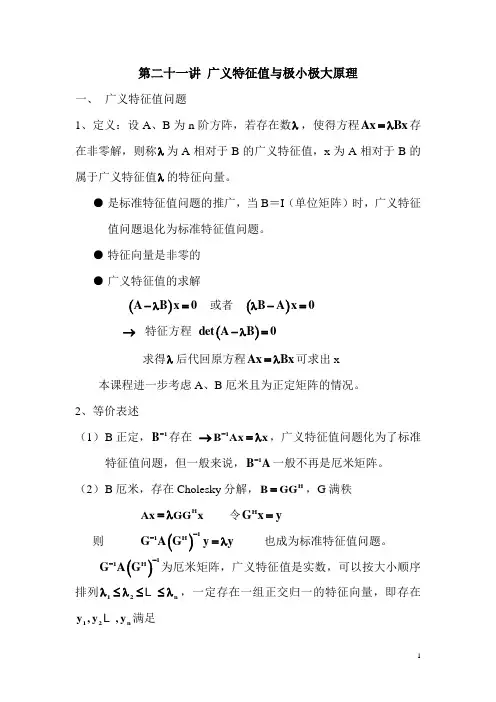

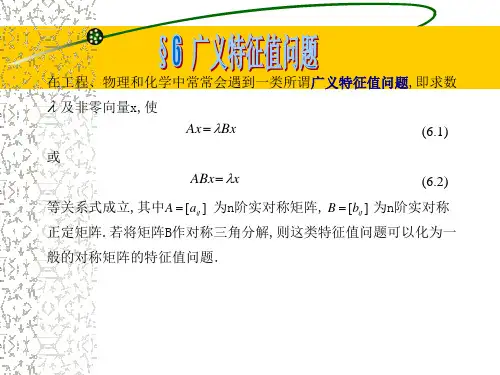

第二十一讲 广义特征值与极小极大原理一、 广义特征值问题1、定义:设A 、B 为n 阶方阵,若存在数λ,使得方程Ax Bx =λ存在非零解,则称λ为A 相对于B 的广义特征值,x 为A 相对于B 的属于广义特征值λ的特征向量。

● 是标准特征值问题的推广,当B =I (单位矩阵)时,广义特征值问题退化为标准特征值问题。

● 特征向量是非零的 ● 广义特征值的求解()A B x 0-λ= 或者 ()B A x 0λ-=→ 特征方程 ()det A B 0-λ=求得λ后代回原方程Ax Bx =λ可求出x本课程进一步考虑A 、B 厄米且为正定矩阵的情况。

2、等价表述(1) B 正定,1B -存在 →1B Ax x -=λ,广义特征值问题化为了标准特征值问题,但一般来说,1B A -一般不再是厄米矩阵。

(2) B 厄米,存在Cholesky 分解,H B GG =,G 满秩 H Ax GG x =λ 令H G x y = 则 ()11H G A Gy y --=λ 也成为标准特征值问题。

()11H G A G--为厄米矩阵,广义特征值是实数,可以按大小顺序排列12n λ≤λ≤≤λ ,一定存在一组正交归一的特征向量,即存在12n y ,y ,y 满足()11H i i G A Gy y --=λH i j ij1i jy y 0i j=⎧=δ=⎨≠⎩ 还原为()1Hi i x G y -= (i=1,2, ,n),则()()H H HH ij ij ij ij 1i jy y x G G x x Bx 0i j=⎧===δ=⎨≠⎩ (带权正交)二、 瑞利商A 、B 为n 阶厄米矩阵,且B 正定,称()()H H x AxR x x 0x Bx =≠为A相对于B 的瑞利商。

12n x ,x ,x 线性无关,所以,n x C ∀∈,存在12n a ,a ,a C ∈ ,使得 ni i i 1x a x ==∑Hnn n n2HHi i i j j j i j i i 1j 1i,j 1i 1x Bx a x B a x a a x Bx a ====⎛⎫⎛⎫=== ⎪ ⎪⎝⎭⎝⎭∑∑∑∑n n n2HHH i i j ij j ii j i i i,j 1i,j 1i 1x Ax a a x Ax a a x Bx a =====λ=λ∑∑∑∴ ()n2i ii 1n2ii 1a R x a ==λ=∑∑●()1x 0minR x ≠=λ ()n x 0maxR x ≠=λ证明:()()()()()HHHH kx A kx x Ax R x x Bx kx B kx == k 为非零常数 可取1k x=, kx 1=∴ ()H Hx 1x AxR x x Bx== (闭区域)当1x x =或()i a 0i 2,3,,n == 时,()1R x =λ i 1λ≥λ ()n2i i 111n2ii 1a R x a==≥λ=λ∑∑∴()1x 0minR x ≠=λ另一方面,i n λ≤λ ()n2i i 1n n n2ii 1a R x a==≤λ=λ∑∑∴ ()n x 0maxR x ≠=λ[证毕] 当B =I 时,标准特征值问题 A x x =λ (H A A =)12nHi j ijx x λ≤λ≤≤λ⎧⎨=δ⎩ 则 ()H 1H x 0x Ax min x x ≠=λ ()H n H x 0x Axmax x x≠=λ进一步分析可得()12x 0a 0minR x ≠==λ ()n n 1x 0a 0max R x -≠==λ()12k k 1x 0a a a 0minR x +≠=====λ ()n n 1n k n k 1x 0a a a 0max R x ----≠=====λ定理1.设{}r r 1s L span x ,x ,,x += ()r r 1s +λ≤λ≤≤λ ,则 ()r x 0x LminR x ≠∈=λ ()s x 0x Lmax R x ≠∈=λ这一结果不便于应用,希望对上述结果进行改造,改造成不依赖于i x 的一种表达方式。

极大极小原理:为什么让很多人都顿悟了作者:老喻在加来源:孤独大脑(ID:lonelybrain)1在“假设发生如下事情”之前,祝福我们此生永不发生这类事情。

假设你外出时,遭遇绑架,该怎么办?有一位(国外的)自卫专家,给出了三个应对原则:1、不要跟他去第二个地点。

如果你心怀侥幸,他可能将你带到偏僻的地方,为所欲为,甚至下毒手,然后掩藏他的罪恶痕迹。

2、记住,他在撒谎。

不管坏人说多好听,别相信。

这位专家的观点是:从一开始,每个谋杀犯,绑架犯,强奸犯,他们都会用同一句话:“照我说的做,我就不会伤害你。

”然而,一旦你照他们说的做,最后受伤最深的,还是你。

3、要在原地,用尽一切手段与之搏斗。

这一点似乎有点儿让人疑惑,万一受伤呢?被人用刀抵住,拼命挣扎要是不幸丢了命,岂非不识时务?然而,这位专家的洞见是:如果他们想在原地杀你,你早就已经死了。

所以:1.他们不想在原地杀你,他们希望带你去其他地方,或者先干点别的事。

2.通过打乱他们的计划,你会成为他们最恐怖的噩梦。

3.如果他们不想被抓,不想把事搞得太麻烦,他们可能就会直接逃跑了。

以上三点原则的所有原因,其实只有一个:如果你进了他的车,或者跟着他们去了某个地方,你死定了。

(以上经验仅供参考,不构成本文作者对遇到绑架的具体建议。

)2以上是一个生动的博弈场景。

由此引出我的一句“大脑碎片”:好的一手棋,是其令对手有不好的下一手,以及自己有好的下下一手棋。

我们姑且不讨论,在第1节里,专家应对绑架的三点原则的适用范围,以及如何根据情境调整策略。

本文的焦点是:极大极小原理。

绑架,是一场零和博弈。

就像下棋,一个人赢,一个人输,即使和棋,也只是暂时的平静。

双方没有合作的可能。

对于这类博弈,冯·诺依曼提出了“极小极大原理”。

《囚徒的困境》一书,用我们熟悉的分蛋糕来示例。

众所周知,公平的分法是:一个人切,一个人选。

假如两个孩子都不是孔融,并且都想吃更多蛋糕,这其实是一个典型的零和博弈。

姚极小极大原理

姚极小极大原理(Minimax Principle)是决策论中的一个重要概念,也常应用于博弈论等领域。

该原理基于两个核心观点:

1. 极小:在一个给定的决策问题中,假设每个决策者都会尽力使自己所能获得的最小利益最大化。

也就是说,每个决策者都会考虑对手可能的最优策略,并选择自己能够达到的最优结果。

2. 极大:相对地,每个决策者也会试图将对手所能获得的最大利益最小化。

每个决策者都会推断对手的可能策略,并努力避免对手获得最佳结果。

通过这种极小极大思想,决策者可以在不确定情况下进行决策,尽量减少风险和损失,同时争取最有利的结果。

在博弈论中,姚极小极大原理经常被应用于两个对手之间的零和游戏,例如象棋、围棋等。

每个选手都会根据对手的最佳策略来选择自己的行动,以期望在对手的最优情况下获得最大利益。

总之,姚极小极大原理是一种基于对手最优策略的决策思想,旨在通过预测对手行为来优化自身的决策,并最大程度地减少潜在损失。

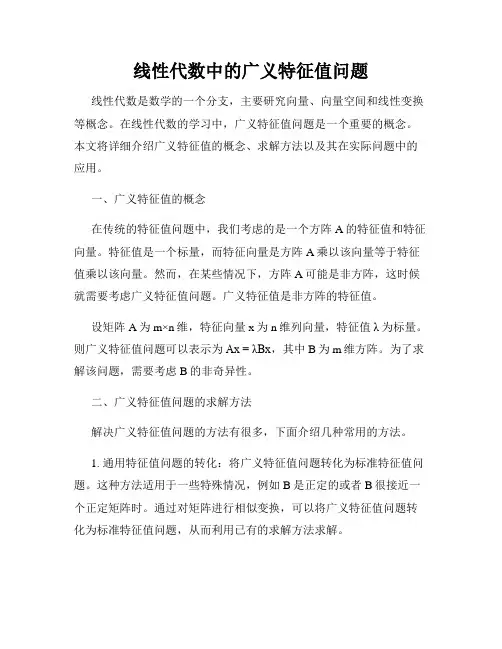

线性代数中的广义特征值问题线性代数是数学的一个分支,主要研究向量、向量空间和线性变换等概念。

在线性代数的学习中,广义特征值问题是一个重要的概念。

本文将详细介绍广义特征值的概念、求解方法以及其在实际问题中的应用。

一、广义特征值的概念在传统的特征值问题中,我们考虑的是一个方阵A的特征值和特征向量。

特征值是一个标量,而特征向量是方阵A乘以该向量等于特征值乘以该向量。

然而,在某些情况下,方阵A可能是非方阵,这时候就需要考虑广义特征值问题。

广义特征值是非方阵的特征值。

设矩阵A为m×n维,特征向量x为n维列向量,特征值λ为标量。

则广义特征值问题可以表示为Ax = λBx,其中B为m维方阵。

为了求解该问题,需要考虑B的非奇异性。

二、广义特征值问题的求解方法解决广义特征值问题的方法有很多,下面介绍几种常用的方法。

1. 通用特征值问题的转化:将广义特征值问题转化为标准特征值问题。

这种方法适用于一些特殊情况,例如B是正定的或者B很接近一个正定矩阵时。

通过对矩阵进行相似变换,可以将广义特征值问题转化为标准特征值问题,从而利用已有的求解方法求解。

2. 修正特征值问题的求解:对于一些特殊的B矩阵,例如对称正定的B矩阵,可以利用修正特征值问题进行求解。

通过将广义特征值问题转化为修正特征值问题,进一步求解得到广义特征值。

3. 广义特征值问题的迭代法:迭代法是一种常用的数值求解方法,对于广义特征值问题也有相应的迭代算法。

例如广义幂法,可以通过迭代的方式逐渐逼近广义特征值问题的解。

三、广义特征值问题的应用广义特征值问题在实际问题中具有广泛的应用。

以下列举一些常见的应用领域。

1. 物理学中的应用:广义特征值问题在量子力学中有很多的应用。

例如,通过广义特征值问题可以求解量子力学中的能量本征值和波函数等。

2. 工程中的应用:广义特征值问题在结构动力学和振动工程中有着重要的应用。

通过求解广义特征值问题,可以得到结构物的固有频率和振型等信息,从而评估结构物的稳定性和安全性。

极大极小原理

极大极小原理,也被称为最大最小原理或极值原理,是数学分析中经常使用的重要原理。

极大极小原理的核心思想是,如果一个函数在某个区间内取得了最大值或最小值,那么在该区间的边界上也必须取得最大值或最小值。

这个原理对于研究函数的性质和求解最优化问题非常有帮助。

举个例子来说明极大极小原理的应用。

考虑一个函数f(x),在

闭区间[a,b]上定义。

如果在区间内存在一个点x0,使得f(x0)

是f(x)在[a,b]上的最大值,那么可以得出结论:f(x)在区间的

边界上的值必须小于或等于f(x0),即f(x)<=f(x0),其中x属

于[a,b]。

同样地,如果f(x)在[a,b]上取得了最小值f(x0),则

f(x)>=f(x0)。

极大极小原理的应用非常广泛,可以用于证明函数的性质,如连续性、有界性等。

另外,它还可以用于解决一些最优化问题,比如求解函数的最大值或最小值的问题。

基于极大极小原理,可以通过在区间的边界上寻找函数的最大值或最小值,从而找到整个区间上的最大值或最小值。

总之,极大极小原理是数学分析中一项重要的基本原理,通过利用函数在区间内最大最小值的性质,可以帮助我们研究函数的性质和解决最优化问题。

广义特征值问题的数值求解算法广义特征值问题是数值线性代数中一个重要的问题,涉及到矩阵的特征值和特征向量的计算。

在实际应用中,广义特征值问题经常出现在工程、科学计算以及机器学习等领域。

本文将介绍一些常用的数值求解算法来解决广义特征值问题。

一、背景介绍广义特征值问题是求解形如Ax = λBx的问题,其中A和B是已知矩阵,x是特征向量,λ是特征值。

A和B可以是实对称矩阵、复对称矩阵、实正定矩阵、复正定矩阵等。

广义特征值问题的求解可以通过转化为普通特征值问题来实现。

二、常用求解算法1. 广义特征值问题的转化为了将广义特征值问题转化为普通特征值问题,可以使用Cholesky 分解、QR分解等方法。

其中,Cholesky分解适用于A和B都是实对称正定矩阵的情况,而QR分解适用于一般情况。

2. 广义特征值问题的迭代法Arnoldi迭代法和Lanczos迭代法是常用的广义特征值问题求解的迭代法。

这两种方法都是基于Krylov子空间的迭代,能够高效地求解大规模的广义特征值问题。

3. 广义特征值问题的直接法如果A和B的规模比较小,可以使用直接法求解广义特征值问题,例如LU分解、SVD分解等。

这种方法通常适用于规模不大的问题。

4. 广义特征值问题的特殊情况当A是实对称正定矩阵、B是单位矩阵时,广义特征值问题可以简化为普通特征值问题。

此时可以使用雅可比方法、幂迭代法等传统的特征值求解算法来解决。

三、算法性能评估为了评估广义特征值问题求解算法的性能,可以考虑以下指标:收敛速度、计算时间、内存消耗等。

实际应用中,需要根据具体的问题选择合适的算法,并根据需求进行性能评估和算法优化。

四、应用领域举例广义特征值问题的数值求解算法在各个领域都有广泛的应用。

例如,在结构力学中,用于求解振动频率和模态分析;在电力系统中,用于求解电力网络的特征频率;在机器学习中,用于求解矩阵的奇异值分解等。

这些应用都需要对广义特征值问题进行求解。

综上所述,广义特征值问题的数值求解算法是数值线性代数中的重要问题。

线性代数中的广义特征值问题与奇异值问题在线性代数学科中,广义特征值问题和奇异值问题都是重要的概念和研究领域。

它们在数学、物理学、工程学等众多领域都有广泛的应用。

本文将介绍广义特征值问题和奇异值问题的概念、性质以及应用,并探讨它们在实际问题中的重要性。

一、广义特征值问题广义特征值问题是指在给定线性变换下,寻找一个非零向量,使得该向量在变换后与原向量之间存在一个非零比例。

换句话说,我们要找到一个向量和一个数,满足一个齐次线性方程组的解。

广义特征值问题可以表示为Ax = λBx,其中A和B是已知的两个矩阵,x是未知的非零向量,λ是未知的数。

广义特征值问题在许多实际问题中有着重要的应用。

例如,在物理学中,广义特征值问题与量子力学的研究密切相关。

在工程学中,广义特征值问题用于分析结构的振动频率和振动模态等问题。

此外,广义特征值问题还在信号处理、图像处理等领域中被广泛应用。

二、奇异值问题奇异值问题是指矩阵分解的一种形式,它将一个任意形状的矩阵分解为三个矩阵的乘积:A = UΣV^T。

在这个分解中,U和V是正交矩阵,Σ是一个对角线上有奇异值的矩阵。

奇异值问题是线性代数中的核心问题之一,也是许多其他重要问题的基础。

奇异值问题在数据处理和模型分析中扮演着重要角色。

例如,在图像处理中,奇异值分解可以用于压缩图像和去噪图像。

在统计学中,奇异值问题可以用于主成分分析和线性回归等问题。

此外,奇异值问题还在机器学习、信号处理等领域中被广泛应用。

三、广义特征值问题与奇异值问题的关系广义特征值问题和奇异值问题在某种程度上是相关的。

事实上,当矩阵A和B都是对称矩阵时,广义特征值问题可以归结为奇异值问题。

此外,广义特征值问题和奇异值问题都可以通过特征分解和奇异值分解的方法来求解。

广义特征值问题和奇异值问题在理论和应用上都有深入的研究。

它们的解法和性质对于解决实际问题具有重要意义。

通过研究广义特征值问题和奇异值问题,我们可以深入了解和应用线性代数在科学和工程领域中的实际应用。

极大极小原理极大极小原理是数学中一个非常重要的概念,它在优化问题中有着广泛的应用。

极大极小原理是指对于一个函数而言,如果在某个点取得极大值或者极小值,那么这个点的导数为零。

极大极小原理是微积分中的基本定理之一,它可以帮助我们求解各种优化问题,包括最大值、最小值以及最优化问题。

首先,我们来看一下极大极小值点的定义。

对于一个函数f(x),如果在点x=a处,f'(a)=0,并且f''(a)>0,那么这个点就是函数f(x)的极小值点;如果在点x=b处,f'(b)=0,并且f''(b)<0,那么这个点就是函数f(x)的极大值点。

通过这个定义,我们可以很容易地找到函数的极大极小值点,从而解决各种优化问题。

在实际应用中,极大极小原理可以帮助我们解决各种实际问题。

比如在工程中,我们经常需要求解一些最优化问题,比如最小成本、最大收益等。

而这些问题往往可以转化为一个函数的极大极小值问题,通过极大极小原理,我们可以很快地找到最优解。

另外,在经济学、物理学、生物学等领域,极大极小原理也有着广泛的应用,可以帮助我们解决各种实际问题。

除了在求解最优化问题中的应用,极大极小原理在数学分析中也有着重要的地位。

通过极大极小原理,我们可以判断一个函数在某个区间内的极值点,从而对函数的性质有更深入的了解。

同时,极大极小原理也为我们提供了一种判断函数极值点的方法,通过这种方法,我们可以更快地找到函数的极值点,从而简化了计算过程。

总之,极大极小原理是数学中一个非常重要的概念,它在优化问题中有着广泛的应用。

通过极大极小原理,我们可以解决各种最优化问题,同时也可以对函数的性质有更深入的了解。

极大极小原理不仅在数学分析中有着重要的地位,同时也在工程、经济学、物理学、生物学等领域有着广泛的应用,可以帮助我们解决各种实际问题。

因此,对极大极小原理的深入理解和掌握,对于我们来说是非常重要的。

广义特征向量与广义特征值广义特征向量与广义特征值是线性代数中的重要概念,它们在矩阵理论与应用中扮演着重要角色。

本文将介绍广义特征向量与广义特征值的概念、性质以及应用,并探讨其在科学研究、数据分析等领域的重要性。

一、广义特征向量与广义特征值的定义在传统的特征向量与特征值的定义中,我们考虑的是方阵A乘以一个向量v所得到的结果与该向量v相等,即Av = λv,其中A是一个方阵,λ是一个数值特征值,v是对应的特征向量。

然而,在某些情况下,我们需要考虑非方阵情况的特征向量与特征值。

这就引出了广义特征向量与广义特征值的概念。

对于一个非方阵A,如果存在一个非零向量v和一个数值λ,使得(A-λI)v = 0,其中I是单位矩阵,则称v为矩阵A的广义特征向量,λ为其对应的广义特征值。

二、广义特征向量与广义特征值的性质1. 广义特征向量与广义特征值的定义是对特征向量与特征值的自然推广,它们包含了传统特征向量与特征值的概念,并适用于更广泛的矩阵类型。

2. 广义特征向量与广义特征值与方阵的特征向量与特征值的性质相似,包括线性无关性、相似矩阵具有相同的广义特征值等。

3. 广义特征向量与广义特征值满足广义特征方程det(A-λI) = 0,其中det表示行列式。

该方程与传统特征方程det(A-λI) = 0类似,但需要考虑到非方阵的情况。

三、广义特征向量与广义特征值的应用广义特征向量与广义特征值在科学研究、工程应用、数据分析等领域中具有广泛应用。

1. 在物理学中,广义特征向量与广义特征值被应用于描述物理系统的稳定性,例如描述电路中阻尼振动与电磁场中的模式分析。

2. 在工程学中,广义特征向量与广义特征值被应用于分析工程结构的振动特性、模态分析等。

通过求解广义特征方程,可以得到结构的固有频率与振动模态。

3. 在数据分析与机器学习中,广义特征向量与广义特征值被应用于矩阵分解、降维与特征提取等任务。

通过求解广义特征方程,可以得到数据集的共性特征与主成分。

《结构动力学》大作业结构大型特征值问题的求解0810020035 吴亮秦1振动系统的特征值问题1.1实特征值问题n 自由度无阻尼线性振动系统的运动微分方程可表示为:[]{}[]{}()M u K u F t += (1.1)其中,{}u 是位移向量,[]M 和[]K 分别是系统的质量矩阵和刚度矩阵,都是n 阶正定矩阵,()F t 是激励向量。

此系统的自由振动微分方程为[]{}[]{}0M u K u += (1.2)设其主振型为: {}{}sin()u v t ωϕ=+ (1.3) 其中,{}v 为振幅向量,ω为圆频率,ϕ为初相位。

将(1.3)代入自由振动微分方程(1.2), 得:[]{}[]{}K v M v λ= (1.4) 其中2λω=,(1.4)具有非零解的条件是()[][]det 0M K λ-= (1.5)式(1.4)称为系统的特征方程,由此可以确定方程的n 个正实根1{}n i i λ=,称为系统的特征值,1{}n i i ω=称为系统的固有频率,{}i v (i=1,2,…..n )为对应于特征值的特征向量或称为系统的振型或模态。

因为[]M 矩阵正定,则[]M 有Cholesky 分解:[][][]TM L L = (1.6)其中,[]L 是下三角矩阵。

引入向量{}x 满足:{}[]{}Tx L v =,则:1{}([]){}T v L x -= (1.7) 代入(1.4),得:([][]){}0I P x λ-= (1.8)其中,()11[][][][]TP L K L --=,式(1.8)称为标准实特征值问题。

1.2复特征值问题多自由度阻尼自由振动系统的运动方程为如下二阶常系数微分方程组:[]{()}[]{()}[]{()}0 M x t C x t K x t ++= (1.9) 其中 []M ,[]C ,[]K 分别是n 阶的质量、阻尼和刚度矩阵,{()}q t 是n 维可微向量函数。