收集-GPU并行计算与CUDA编程 第10课

- 格式:pptx

- 大小:698.91 KB

- 文档页数:13

作者简介张舒,电子科技大学信息与通信工程专业硕士,现任NvIDIA深圳有限公司系统设计验证工程师,CUDA技术顾问。

曾实现基于CUDA的神经网络、聚类分析、主分量分析等模式识别算法,以及信号仿真、密码破解、字符串匹配等应用。

编辑推荐精选典型实用例程,详解CUDA使用细节,重视理论结合实际,介绍并行程序设计方法,深入分析硬件架构,揭示模型与底层映射关系,精心总结优化经验,解析高性能编程技巧。

本书简介本书是全国第一本全面介绍CUDA软硬件体系架构的书籍。

全面介绍使用CUDA进行通用计算所需要的语法、硬件架构、程序优化技巧等知识,是进行GPU通用计算程序开发的入门教材和参考书。

本书共分5章。

第1章介绍GPU通用计算的发展历程,介绍并行计算的历史、现状以及面临的问题;第2章介绍CUDA的使用方法,帮助读者理解CUDA的编程模型、存储器模型和执行模型,掌握CUDA程序的编写方法;第3章探讨CUDA硬件架构,深入分析Tesla GPU架构与CUDA通用计算的相互作用:第4章总结CUDA的高级优化方法,对任务划分、存储器访问、指令流效率等课题进行探讨;第5章以丰富的实例展示如何使用CUDA的强大性能解决实际问题。

本书可作为CUDA的学习入门和编程参考书,主要面向从事高性能计算的程序员与工程师,使用GPU加速专业领域计算的科研人员,以及对GPU通用计算感兴趣的程序员。

开设相关课程的高等院校与科研机构也可选用本书作为教材。

目录前言第1章 GPU通用计算1.1 多核计算的发展1.1.1 CPU多核并行1.1.2 超级计算机、集群与分布式计算1.1.3 CPU+GPU异构并行1.2 GPU发展简介1.2.1 GPU渲染流水线1.2.2 着色器模型1.2.3 NVIDIA GPU发展简介1.3 从GPGPU到CUDA1.3.1 传统GPGPU开发1.3.2 CUDA开发第2章 CUDA基础2.1 CUDA编程模型2.1.1 主机与设备2.1.2 Kernel函数的定义与调用2.1.3 线程结构2.1.4 硬件映射2.1.5 deviceQuery示例2.1.6 matrixAssign示例2.2 CUDA软件体系2.2.1 CUDA C语言2.2.2 nvcc编译器2.2.3 运行时APl与驱动APl2.2.4 CUDA函数库2.3 CUDA存储器模型2.3.1 寄存器2.3.2 局部存储器2.3.3 共享存储器2.3.4 全局存储器2.3 5 主机端内存2.3.6 主机端页锁定内存2.3.7 常数存储器2.3.8 纹理存储器2.4 CUDA通信机制2.4.1 同步函数2.4.2 Volatile关键字2.4.3 ATOM操作2.4.4 VOTE操作2.5 异步并行执行2.5.1 流2.5.2 事件2.6 CUDA与图形学APl互操作2.6.1 CUDA与OpenGL的互操作2.6.2 CUDA与Direct3D互操作2.7 多设备与设备集群2.7.1 CUDA设备控制2.7.2 CUDA与openMP2.7.3 CUDA与集群第3章 CUDA硬件架构3.1 NVIDIA显卡构造简介3.1.1 图形显卡概览3.1.2 PCI—E总线3.1.3 显存3.1.4 GPU芯片3.2 Tesla图形与计算架构3.2.1 SPA—TPC—SM3.2.2 主流GPU架构3.3 Tesla通用计算模型3.3.1 数据与指令的加载3.3.2 warp指令的发射与执行3.3.3 纹理、渲染和存储器流水线第4章 CUDA程序的优化4.1 CUDA程序优化概述4.2 测量程序运行时间4.2.1 设备端测时4.2.2 主机端测时4.3 任务划分……第5章 综合应用附录A 安装、配置、编译及调试附录B 常见问题与解答附录C 技术规范附录D C扩展附录E 数学函数附录F 纹理拾取附录G 着色器模型下载后 点击此处查看更多内容。

CUDA并行架构及编程摘要CUDA是一种由NVIDIA推出的并行计算架构,非常适合大规模数据密集型计算。

CUDA使GPU的超高计算性能在数据处理和并行计算等通用计算领域发挥优势,本文讨论了CUDA的计算架构和基于GPU的CUDA C编程语言,CUDA使GPU流处理器阵列的性能得到充分发挥。

极大地提高了并行计算程序的效率。

关键词并行计算,GPU通用计算,CUDAAbstract CUDA is a parallel computing architecture introduced by NVIDIA , it mainly used for large scale data-intensive computing. CUDA makes GPU a high performance in parallel computing ,data processing and other general computing. this paper discusses the CUDA computing architecture and CUDA C programming language based on GPU, CUDA makes GPU stream processor arrays fully used and Greatly improved the efficiency of parallel computing program.Keywords parallel computing ,GPU general purpose computation,CUDA1 引言并行计算是指同时使用多种计算资源解决计算问题的过程。

并行计算科学中主要研究的是空间上的并行问题。

从程序和算法设计的角度来看,并行计算又可分为数据并行和任务并行。

一般来说,GPU更注重于数据并行计算,主要是将一个大任务化解成相同的各个子任务。

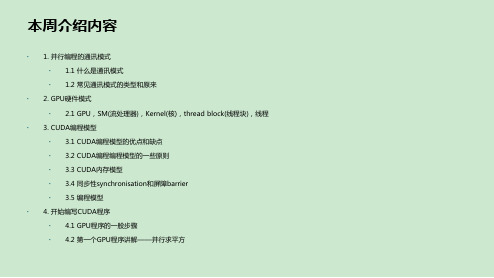

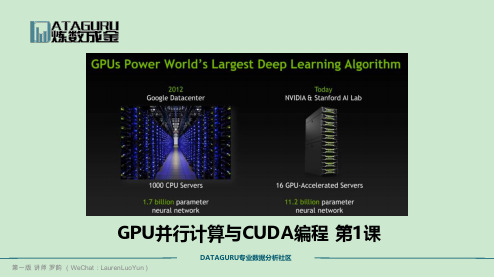

GPU并行计算与CUDA编程第1课本周介绍内容∙0. 课程参考资料∙ 1. GPU并行计算的原理与意义∙ 2. CUDA硬件环境,体系结构,常见的显卡型号与性能,显卡的选择与显存需求估计∙ 3. CUDA软件环境介绍,包括平台、架构、开发工具和热点技术∙ 4. 租用AWS云服务的环境搭建步骤∙ 5. 本地机器的环境搭建步骤0.课程参考资料1. GPU并行计算的原理与意义∙CPU和GPU的区别∙图片来自NVIDIA CUDA文档。

其中绿色的是计算单元,橙红色的是存储单元,橙黄色的是控制单元。

∙GPU采用了数量众多的计算单元和超长的流水线,但只有非常简单的控制逻辑并省去了Cache。

而CPU不仅被Cache 占据了大量空间,而且还有有复杂的控制逻辑和诸多优化电路,相比之下计算能力只是CPU很小的一部分CPU的发展:处理器越来越小,处理速度越来越快,处理核变多。

为什么CPU不可以一直沿着趋势发展下去?∙性能(低延时性Latency)与吞吐量(Throughput)∙Cache, local memory: CPU > GPU∙Threads(线程数): GPU > CPU∙Registers: GPU > CPU 多寄存器可以支持非常多的Thread,thread需要用到register,thread数目大,register也必须得跟着很大才行。

CPU:基于低延时性设计∙ALU:CPU有强大的ALU(算术运算单元),它可以在很少的时钟周期内完成算术计算。

∙当今的CPU可以达到64bit 双精度。

执行双精度浮点源算的加法和乘法只需要1~3个时钟周期。

∙CPU的时钟周期的频率是非常高的,达到1.532~3gigahertz(千兆HZ, 10的9次方).∙Cache:大的缓存也可以降低延时。

保存很多的数据放在缓存里面,当需要访问的这些数据,只要在之前访问过的,如今直接在缓存里面取即可。

∙Control:复杂的逻辑控制单元。

NVIDIACUDA编程指南一、CUDA的基本概念1. GPU(Graphics Processing Unit):GPU是一种专门用于图形处理的处理器,但随着计算需求的增加,GPU也被用于进行通用计算。

相比于CPU,GPU拥有更多的处理单元和更高的并行计算能力,能够在相同的时间内处理更多的数据。

2. CUDA核心(CUDA core):CUDA核心是GPU的计算单元,每个核心可以执行一个线程的计算任务。

不同型号的GPU会包含不同数量的CUDA核心,因此也会有不同的并行计算能力。

3. 线程(Thread):在CUDA编程中,线程是最基本的并行计算单元。

每个CUDA核心可以执行多个线程的计算任务,从而实现并行计算。

开发者可以使用CUDA编程语言控制线程的创建、销毁和同步。

4. 线程块(Thread Block):线程块是一组线程的集合,这些线程会被分配到同一个GPU的处理器上执行。

线程块中的线程可以共享数据,并且可以通过共享内存进行通信和同步。

5. 网格(Grid):网格是线程块的集合,由多个线程块组成。

网格提供了一种组织线程块的方式,可以更好地利用GPU的并行计算能力。

不同的线程块可以在不同的处理器上并行执行。

6.内存模型:在CUDA编程中,GPU内存被划分为全局内存、共享内存、寄存器和常量内存等几种类型。

全局内存是所有线程可访问的内存空间,而共享内存只能被同一个线程块的线程访问。

寄存器用于存储线程的局部变量,常量内存用于存储只读数据。

二、CUDA编程模型1.编程语言:CUDA编程语言是一种基于C语言的扩展,可在C/C++代码中嵌入CUDA核函数。

开发者可以使用CUDA编程语言定义并行计算任务、管理线程和内存、以及调度计算任务的执行。

2. 核函数(Kernel Function):核函数是在GPU上执行的并行计算任务,由开发者编写并在主机端调用。

核函数会被多个线程并行执行,每个线程会处理一部分数据,从而实现高效的并行计算。

GPU的并行运算与CUDA的简介一:GPU 编程技术的发展历程及现状1.冯诺依曼计算机架构的瓶颈曾经,几乎所有的处理器都是以冯诺依曼计算机架构为基础的。

该系统架构简单来说就是处理器从存储器中不断取指,解码,执行。

但如今这种系统架构遇到了瓶颈:内存的读写速度跟不上 CPU 时钟频率。

具有此特征的系统被称为内存受限型系统,目前的绝大多数计算机系统都属于此类型。

为了解决此问题,传统解决方案是使用缓存技术。

通过给 CPU 设立多级缓存,能大大地降低存储系统的压力:然而随着缓存容量的增大,使用更大缓存所带来的收益增速会迅速下降,这也就意味着我们要寻找新的办法了。

2.对 GPU 编程技术发展具有启发意义的几件事1. 70年代末期,克雷系列超级计算机研制成功(克雷1当年耗资800万美元)。

此类计算机采用若干内存条的共享内存结构,即这些内存条可以与多个处理器相连接,从而发展成今天的对称多处理器系统 (SMD)。

克雷2是向量机 - 一个操作处理多个操作数。

如今的 GPU 设备的核心也正是向量处理器。

2. 80年代初期,一家公司设计并研制了一种被称为连接机的计算机系统。

该系统具有16个 CPU 核,采用的是标准的单指令多数据 (SIMD) 并行处理。

连接机通过这种设计能够消除多余的访存操作,并将内存读写周期变为原来的 1/16 。

3. CELL 处理器的发明这类处理器很有意思,其架构大致如下图所示:在此结构中,一个 PPC 处理器作为监管处理器,与大量的 SPE流处理器相连通,组成了一个工作流水线。

对于一个图形处理过程来说,某个SPE 可负责提取数据,另一个SPE 负责变换,再另一个负责存回。

这样可构成一道完完整整的流水线,大大提高了处理速度。

顺便提一句,2010年超级计算机排名第三的计算机就是基于这种设计理念实现的,占地面积达560平方米,耗资 1.25 亿美元。

3.多点计算模型集群计算是指通过将多个性能一般的计算机组成一个运算网络,达到高性能计算的目的。

基于CUDA编程的GPU计算与并行处理技术研究一、引言在当今信息技术飞速发展的时代,计算机科学领域的GPU计算与并行处理技术备受关注。

GPU(Graphics Processing Unit)即图形处理器,最初被设计用于图形渲染,但随着其强大的并行计算能力逐渐被广泛应用于科学计算、深度学习、人工智能等领域。

CUDA(Compute Unified Device Architecture)是由NVIDIA推出的一种通用并行计算架构,为开发人员提供了利用GPU进行并行计算的能力。

本文将围绕基于CUDA编程的GPU计算与并行处理技术展开深入研究。

二、GPU计算原理GPU相对于CPU在并行计算方面具有明显优势,其核心原理在于拥有大量的处理单元和高带宽的内存访问能力。

GPU内部包含多个流处理器(Streaming Processor),每个流处理器包含多个CUDA核心,这些CUDA核心可以同时执行大量线程,实现高效的并行计算。

与之相对应的是CPU,虽然拥有较强的单线程性能,但在大规模并行计算任务上表现不如GPU。

三、CUDA编程模型CUDA编程模型是基于C/C++语言扩展而来,开发者可以使用CUDA C/C++语言编写程序,并通过调用CUDA API来实现对GPU的并行计算。

CUDA编程模型主要包括主机(Host)和设备(Device)两部分,主机负责控制整个程序流程,而设备则执行实际的并行计算任务。

开发者需要了解如何将数据从主机传输到设备,以及如何在设备上进行并行计算,并最终将结果传回主机。

四、GPU加速应用基于CUDA编程的GPU计算广泛应用于各个领域,例如科学计算、深度学习、密码学、图像处理等。

在科学计算领域,研究人员可以利用GPU加速求解复杂的数值模拟问题;在深度学习领域,研究人员可以通过GPU加速训练神经网络模型;在密码学领域,研究人员可以利用GPU加速破解密码等。

GPU加速应用大大提高了计算效率,缩短了任务执行时间。