深度学习相关知识

- 格式:docx

- 大小:89.27 KB

- 文档页数:5

第1篇摘要:随着教育改革的不断深入,教师的专业成长成为提升教育教学质量的关键。

本文以教研活动为切入点,探讨深度学习在教师专业成长中的应用,分析其重要性和实施策略,旨在为教师提供一种新的专业成长路径。

一、引言在新时代背景下,我国教育改革不断深化,对教师的专业素养提出了更高的要求。

教研活动作为教师专业成长的重要途径,其深度学习成为教师提升教育教学能力的关键。

本文将从以下几个方面展开论述:深度学习的内涵与特征、深度学习在教师专业成长中的重要性、深度学习的实施策略。

二、深度学习的内涵与特征1. 深度学习的内涵深度学习(Deeper Learning)是一种以学生为中心、注重知识建构和思维发展、强调学生自主探究的学习方式。

它要求学生在学习过程中,不仅掌握知识,还要学会运用知识解决问题,形成良好的学习习惯和品质。

2. 深度学习的特征(1)以学生为中心:深度学习强调学生的主体地位,关注学生的个性化需求,激发学生的学习兴趣和潜能。

(2)注重知识建构:深度学习强调知识的整合、拓展和迁移,使学生在掌握知识的基础上,形成自己的知识体系。

(3)思维发展:深度学习注重培养学生的批判性思维、创造性思维和逻辑思维,提高学生的思维品质。

(4)自主探究:深度学习鼓励学生主动探究、合作学习,培养学生的自主学习能力。

三、深度学习在教师专业成长中的重要性1. 提升教师教育教学能力深度学习使教师更加关注学生的个体差异,了解学生的学习需求,从而调整教学策略,提高教育教学效果。

2. 促进教师专业发展深度学习有助于教师拓宽知识视野,更新教育观念,提升教育教学能力,促进教师的专业成长。

3. 增强教师团队协作能力深度学习强调教师之间的合作与交流,有助于形成良好的团队氛围,提高教师团队的整体素质。

四、深度学习的实施策略1. 营造深度学习氛围(1)建立以学生为中心的教学理念,关注学生的个性化需求。

(2)开展丰富多样的教学活动,激发学生的学习兴趣。

(3)营造合作、互助、共赢的团队氛围,促进教师之间的交流与合作。

深度学习知识点总结深度学习是一种人工智能(AI)的子领域,它的目标是让计算机系统像人类一样具有分析、理解和解释数据的能力。

通过模拟人脑中神经元的工作原理,深度学习算法可以学习和理解数据中的复杂模式,并进行非常准确的分类和预测。

本文将系统地总结深度学习的基本概念和常见技术,帮助读者全面了解深度学习的核心知识点。

一、基本概念1. 神经网络神经网络是深度学习的基础,它模拟了人脑中神经元之间的连接关系。

一个神经网络由许多神经元组成,并通过神经元之间的连接来传递信息。

通常,神经网络被组织成多个层次,包括输入层、隐藏层和输出层。

每个神经元接收来自上一层神经元的输入,通过加权求和和激活函数的处理后产生输出。

神经网络可以通过训练来学习适应不同的数据模式和特征。

2. 深度学习深度学习是一种使用多层神经网络进行学习的机器学习技术。

与传统的浅层神经网络相比,深度学习能够更好地处理大规模高维度的数据,并学习到更加复杂的特征和模式。

深度学习已经广泛应用在图像识别、语音识别、自然语言处理等领域,取得了显著的成果。

3. 监督学习监督学习是一种常见的机器学习方法,它通过使用有标签的数据样本来训练模型。

在监督学习中,模型通过学习输入和输出之间的关系来进行预测。

常见的监督学习算法包括:神经网络、决策树、支持向量机等。

4. 无监督学习无监督学习是一种不使用标签数据的机器学习方法,它通过学习数据之间的内在结构和模式来进行数据分析和分类。

无监督学习常用的算法包括聚类、关联规则、降维等。

5. 强化学习强化学习是一种通过与环境交互来学习最优决策策略的机器学习方法。

在强化学习中,智能体通过观察环境的反馈和奖励来调整自身的行为,并不断优化决策策略。

强化学习在机器人控制、游戏AI等领域有着广泛应用。

6. 深度学习框架深度学习框架是一种方便开发者进行深度学习模型搭建和训练的软件工具。

常见的深度学习框架包括:TensorFlow、PyTorch、Keras、Caffe等。

深度学习教学大纲深度学习教学大纲深度学习作为人工智能领域的一个重要分支,已经在各个领域展现出了巨大的应用潜力。

为了培养更多的深度学习人才,许多高校和培训机构开始开设相关的课程。

本文将探讨一个完整的深度学习教学大纲,以帮助学习者系统地掌握这一领域的知识和技能。

第一部分:基础知识在深度学习的教学大纲中,首先需要介绍深度学习的基础知识。

这包括神经网络的基本概念和结构,以及常用的深度学习框架和工具。

学习者需要了解神经网络的基本组成部分,如神经元、层和权重,并且能够使用深度学习框架来构建和训练自己的神经网络模型。

第二部分:深度学习算法在深度学习教学大纲的第二部分,需要详细介绍深度学习的核心算法。

这包括卷积神经网络(CNN)、循环神经网络(RNN)和生成对抗网络(GAN)等。

学习者需要理解这些算法的原理和应用场景,并且能够使用相应的算法解决实际问题。

第三部分:深度学习应用深度学习的应用领域非常广泛,包括图像识别、语音识别、自然语言处理等。

在深度学习教学大纲的第三部分,需要介绍深度学习在不同领域的应用案例,并且引导学习者独立完成相关的实践项目。

通过实际应用的学习,学习者可以更好地理解深度学习的实际价值和应用方法。

第四部分:深度学习理论与研究深度学习作为一个不断发展的领域,其中的理论和研究也非常重要。

在深度学习教学大纲的第四部分,需要介绍深度学习的一些重要理论和研究方向,如梯度下降、优化算法和迁移学习等。

学习者需要了解这些理论的原理和应用,并且能够阅读和理解相关的研究论文。

第五部分:深度学习实践与项目在深度学习教学大纲的最后一部分,需要引导学习者进行深度学习的实践和项目。

学习者可以选择一个感兴趣的领域或问题,设计并实现一个深度学习模型来解决。

通过实践项目,学习者可以将前面学到的知识和技能应用到实际情境中,加深对深度学习的理解和掌握。

总结:深度学习教学大纲应该从基础知识开始,逐步深入,涵盖算法、应用、理论和实践等方面。

深度学习基础知识题库1. 什么是深度学习?深度学习是一种机器学习方法,通过使用多层神经网络来模拟人脑的工作原理,从而实现对数据进行学习和分析的能力。

深度学习模型通常由多层神经网络组成,每一层都对输入数据进行特征提取和转换,最终输出预测结果。

2. 深度学习与传统机器学习的区别是什么?深度学习与传统机器学习的主要区别在于特征提取的方式和模型的复杂度。

传统机器学习方法需要手工选择和设计特征,而深度学习可以自动从原始数据中学习最有用的特征。

此外,深度学习模型通常比传统机器学习模型更复杂,拥有更多的参数需要训练。

3. 请解释下面几个深度学习中常用的概念:神经网络、激活函数和损失函数。

•神经网络是深度学习的核心组成部分,它由多个神经元组成,并通过神经元之间的连接进行信息传递和处理。

每个神经元接收一组输入,并通过激活函数对输入进行非线性转换后输出结果。

•激活函数是神经网络中的一个重要组件,主要用于引入非线性。

常用的激活函数包括Sigmoid、ReLU和tanh,它们可以将神经网络的输出限制在一定的范围内,并增加模型的表达能力。

•损失函数用于衡量模型的预测结果与真实标签之间的差异。

常见的损失函数包括均方误差(MSE)、交叉熵(Cross-Entropy)等,模型的目标是通过优化损失函数的数值来提高预测的准确性。

4. 请解释一下反向传播算法在深度学习中的作用。

反向传播算法是深度学习中训练神经网络的关键算法之一。

它基于梯度下降的思想,通过计算当前预测值和真实标签之间的差异,并向后逐层更新神经网络中的参数,从而最小化误差。

具体地,反向传播算法沿着神经网络的前向传播路径,依次计算每一层的导数和误差。

然后使用链式法则将误差从输出层逐层向后传播,更新每个神经元的参数,直到最后一层。

反向传播算法的使用可以加速神经网络训练的过程,提高模型的准确性。

5. 请简要介绍一下卷积神经网络(CNN)以及它在计算机视觉任务中的应用。

卷积神经网络(Convolutional Neural Network,CNN)是一种深度学习模型,特别适用于处理网格状数据,如图像和语音。

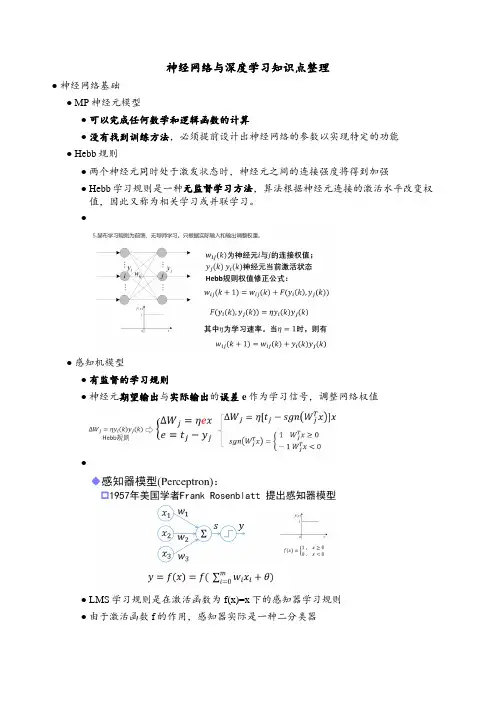

神经网络与深度学习知识点整理●神经网络基础●MP神经元模型●可以完成任何数学和逻辑函数的计算●没有找到训练方法,必须提前设计出神经网络的参数以实现特定的功能●Hebb规则●两个神经元同时处于激发状态时,神经元之间的连接强度将得到加强●Hebb学习规则是一种无监督学习方法,算法根据神经元连接的激活水平改变权值,因此又称为相关学习或并联学习。

●●感知机模型●有监督的学习规则●神经元期望输出与实际输出的误差e作为学习信号,调整网络权值●●LMS学习规则是在激活函数为f(x)=x下的感知器学习规则●由于激活函数f的作用,感知器实际是一种二分类器●感知器调整权值步骤●单层感知器不能解决异或问题●BP网络●特点:●同层神经网络无连接●不允许跨层连接●无反馈连接●BP学习算法由正向传播和反向传播组成●BP网络的激活函数必须处处可导——BP权值的调整采用 Gradient Descent 公式ΔW=-η(偏E/偏w),这个公式要求网络期望输出和单次训练差值(误差E)求导。

所以要求输出值处处可导。

s函数正好满足处处可导。

●运算实例(ppt)●Delta( δ )学习规则●误差纠正式学习——神经元的有监督δ学习规则,用于解决输入输出已知情况下神经元权值学习问题●δ学习规则又称误差修正规则,根据E/w负梯度方向调整神经元间的连接权值,能够使误差函数E达到最小值。

●δ学习规则通过输出与期望值的平方误差最小化,实现权值调整●●1●自动微分●BP神经网络原理:看书●超参数的确定,并没有理论方法指导,根据经验来选择●BP算法已提出,已可实现多隐含层的神经网络,但实际只使用单隐层节点的浅层模型●计算能力的限制●梯度弥散问题●自编码器●●自编码器(Auto-Encoder)作为一种无监督学习方法网络●将输入“编码”为一个中间代码●然后从中间表示“译码”出输入●通过重构误差和误差反传算法训练网络参数●编码器不关心输出(只复现输入),只关心中间层的编码————ℎ=σ(WX+b)●编码ℎ已经承载原始数据信息,但以一种不同的形式表达!●1●正则编码器——损失函数中加入正则项,常用的正则化有L1正则和L2正则●稀疏自编码器——在能量函数中增加对隐含神经元激活的稀疏性约束,以使大部分隐含神经元处于非激活状态●去噪自编码器——训练数据加入噪声,自动编码器学习去除噪声获得无噪声污染的输入,迫使编码器学习输入信号更加鲁棒的表达●堆叠自编码器●自编码器训练结束后,输出层即可去掉,网络关心的是x到ℎ的变换●将ℎ作为原始信息,训练新的自编码器,得到新的特征表达.●逐层贪婪预训练●1●深度神经网络初始化●●卷积神经网络●全连接不适合图像任务●参数数量太多●没有利用像素之间的位置信息●全连接很难传递超过三层●卷积神经网络是一种前馈神经网络,其输出神经元可以响应部分区域内的输入信息,适宜处理图像类信息●1●1●Zero Padding:在原始图像周围补0数量●卷积尺寸缩小,边缘像素点在卷积中被计算的次数少,边缘信息容易丢失●●卷积神经网络架构发展●1●深度发展●LeNet●具备卷积、激活、池化和全连接等基本组件●但GPU未出现,CPU的性能又极其低下●LetNet只使用在手写识别等简单场景,未得到重视●LeNet主要有2个卷积层(5*5)、2个下抽样层(池化层)、3个全连接层●通过sigmoid激活●全连接层输出:共有10个节点分别代表数字0到9,采用径向基函数作为分类器●AlexNet●第一次采用了ReLU,dropout,GPU加速等技巧●AlexNet网络共有:卷积层 5个(1111,55,3*3),池化层 3个,全连接层3个●首次采用了双GPU并行计算加速模式●第一卷积模块:96通道的特征图被分配到2个GPU中,每个GPU上48个特征图;2组48通道的特征图分别在对应的GPU中进行ReLU激活●第一层全连接:同时采用了概率为0.5的Dropout策略●VGG●通过反复堆叠3x3卷积和2x2的池化,得到了最大19层的深度●卷积-ReLU-池化的基本结构●串联多个小卷积,相当于一个大卷积的思想●使用两个串联的3x3卷积,达到5x5的效果,但参数量却只有之前的18/25●串联多个小卷积,增加ReLU非线性激活使用概率,从而增加模型的非线性特征●VGG16网络包含了13个卷积层,5个池化层和3个全连接层。

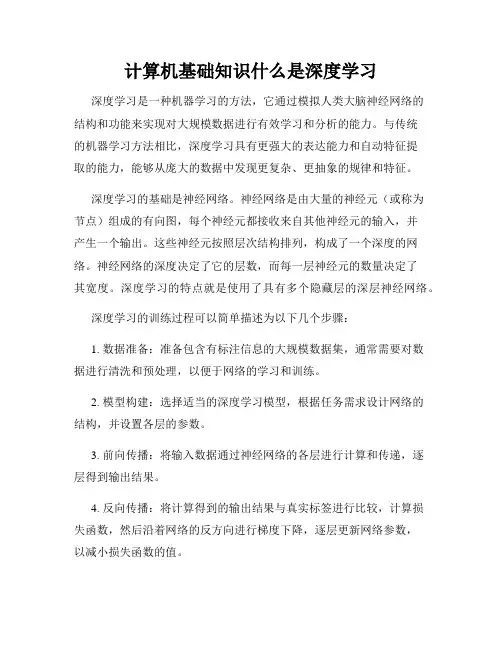

计算机基础知识什么是深度学习深度学习是一种机器学习的方法,它通过模拟人类大脑神经网络的结构和功能来实现对大规模数据进行有效学习和分析的能力。

与传统的机器学习方法相比,深度学习具有更强大的表达能力和自动特征提取的能力,能够从庞大的数据中发现更复杂、更抽象的规律和特征。

深度学习的基础是神经网络。

神经网络是由大量的神经元(或称为节点)组成的有向图,每个神经元都接收来自其他神经元的输入,并产生一个输出。

这些神经元按照层次结构排列,构成了一个深度的网络。

神经网络的深度决定了它的层数,而每一层神经元的数量决定了其宽度。

深度学习的特点就是使用了具有多个隐藏层的深层神经网络。

深度学习的训练过程可以简单描述为以下几个步骤:1. 数据准备:准备包含有标注信息的大规模数据集,通常需要对数据进行清洗和预处理,以便于网络的学习和训练。

2. 模型构建:选择适当的深度学习模型,根据任务需求设计网络的结构,并设置各层的参数。

3. 前向传播:将输入数据通过神经网络的各层进行计算和传递,逐层得到输出结果。

4. 反向传播:将计算得到的输出结果与真实标签进行比较,计算损失函数,然后沿着网络的反方向进行梯度下降,逐层更新网络参数,以减小损失函数的值。

5. 参数优化:通过反复迭代的训练过程,不断调整网络参数,使得模型的输出结果与真实标签更加接近,提高模型在新数据上的泛化能力。

6. 模型评估:使用验证集或测试集对训练好的模型进行评估性能,根据评估结果对模型进行调整和改进。

深度学习在各个领域都取得了显著的成果。

在计算机视觉领域,通过深度学习技术,可以实现图像分类、目标检测、人脸识别等任务。

在自然语言处理领域,可以通过深度学习技术实现语义理解、机器翻译、情感分析等任务。

此外,深度学习在推荐系统、语音识别、医学影像分析等领域也有广泛应用。

值得注意的是,深度学习需要大量的数据和计算资源来进行训练,特别是在大规模网络和复杂任务上。

同时,模型的设计和参数调整也需要经验和技巧。

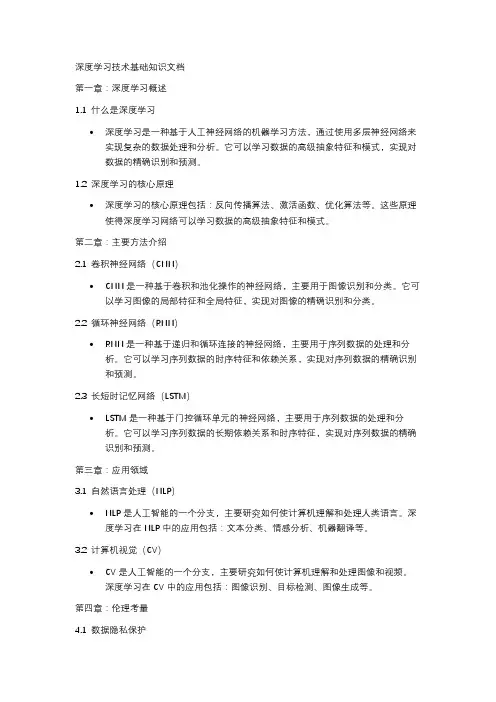

深度学习技术基础知识文档第一章:深度学习概述1.1 什么是深度学习•深度学习是一种基于人工神经网络的机器学习方法,通过使用多层神经网络来实现复杂的数据处理和分析。

它可以学习数据的高级抽象特征和模式,实现对数据的精确识别和预测。

1.2 深度学习的核心原理•深度学习的核心原理包括:反向传播算法、激活函数、优化算法等。

这些原理使得深度学习网络可以学习数据的高级抽象特征和模式。

第二章:主要方法介绍2.1 卷积神经网络(CNN)•CNN是一种基于卷积和池化操作的神经网络,主要用于图像识别和分类。

它可以学习图像的局部特征和全局特征,实现对图像的精确识别和分类。

2.2 循环神经网络(RNN)•RNN是一种基于递归和循环连接的神经网络,主要用于序列数据的处理和分析。

它可以学习序列数据的时序特征和依赖关系,实现对序列数据的精确识别和预测。

2.3 长短时记忆网络(LSTM)•LSTM是一种基于门控循环单元的神经网络,主要用于序列数据的处理和分析。

它可以学习序列数据的长期依赖关系和时序特征,实现对序列数据的精确识别和预测。

第三章:应用领域3.1 自然语言处理(NLP)•NLP是人工智能的一个分支,主要研究如何使计算机理解和处理人类语言。

深度学习在NLP中的应用包括:文本分类、情感分析、机器翻译等。

3.2 计算机视觉(CV)•CV是人工智能的一个分支,主要研究如何使计算机理解和处理图像和视频。

深度学习在CV中的应用包括:图像识别、目标检测、图像生成等。

第四章:伦理考量4.1 数据隐私保护•数据隐私保护是深度学习应用中的一个重要伦理问题。

我们需要确保数据的隐私和安全,避免数据的滥用和泄露。

4.2 AI偏见和公平性•AI偏见和公平性是深度学习应用中的一个重要伦理问题。

我们需要确保AI系统的公平性和无偏见,避免AI系统的歧视和偏见。

第五章:结论•深度学习是一种强大的机器学习方法,可以实现对数据的精确识别和预测。

通过了解深度学习的核心原理和主要方法,我们可以更好地应用深度学习技术来解决实际问题。

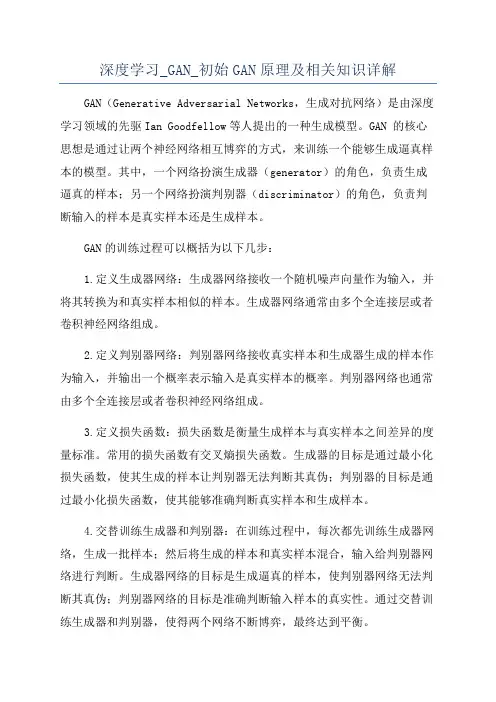

深度学习_GAN_初始GAN原理及相关知识详解GAN(Generative Adversarial Networks,生成对抗网络)是由深度学习领域的先驱Ian Goodfellow等人提出的一种生成模型。

GAN 的核心思想是通过让两个神经网络相互博弈的方式,来训练一个能够生成逼真样本的模型。

其中,一个网络扮演生成器(generator)的角色,负责生成逼真的样本;另一个网络扮演判别器(discriminator)的角色,负责判断输入的样本是真实样本还是生成样本。

GAN的训练过程可以概括为以下几步:1.定义生成器网络:生成器网络接收一个随机噪声向量作为输入,并将其转换为和真实样本相似的样本。

生成器网络通常由多个全连接层或者卷积神经网络组成。

2.定义判别器网络:判别器网络接收真实样本和生成器生成的样本作为输入,并输出一个概率表示输入是真实样本的概率。

判别器网络也通常由多个全连接层或者卷积神经网络组成。

3.定义损失函数:损失函数是衡量生成样本与真实样本之间差异的度量标准。

常用的损失函数有交叉熵损失函数。

生成器的目标是通过最小化损失函数,使其生成的样本让判别器无法判断其真伪;判别器的目标是通过最小化损失函数,使其能够准确判断真实样本和生成样本。

4.交替训练生成器和判别器:在训练过程中,每次都先训练生成器网络,生成一批样本;然后将生成的样本和真实样本混合,输入给判别器网络进行判断。

生成器网络的目标是生成逼真的样本,使判别器网络无法判断其真伪;判别器网络的目标是准确判断输入样本的真实性。

通过交替训练生成器和判别器,使得两个网络不断博弈,最终达到平衡。

GAN的训练过程中,生成器网络和判别器网络相互竞争,通过稳定的博弈过程,使得生成的样本逐渐接近真实样本,从而达到生成逼真样本的目的。

GAN的应用非常广泛,包括图像生成、图像修复、图像超分辨率、生成逼真的文本和语音等。

在图像生成方面,GAN能够生成逼真的图片,使得用户能够以更快速、低成本的方式进行图像合成或者增强。

深度学习基础知识解读第一章深度学习的背景和概念1.1 人工智能与机器学习的发展历程1.2 深度学习的定义和特点1.3 深度学习与传统机器学习的区别第二章神经网络及其基本原理2.1 人脑神经系统简介2.2 人工神经网络概述2.3 基本神经网络的结构和运行机制2.4 优化算法:梯度下降和反向传播第三章深度学习常用的网络结构3.1 卷积神经网络(CNN)3.1.1 卷积和池化层的原理3.1.2 LeNet-5网络结构解析3.1.3 AlexNet网络结构解析3.2 循环神经网络(RNN)3.2.1 循环单元(RNN unit)的原理3.2.2 长短时记忆网络(LSTM)的结构和应用 3.2.3 双向循环神经网络第四章深度学习的主要应用领域4.1 计算机视觉4.1.1 图像分类和目标检测4.1.2 图像分割和语义分割4.2 自然语言处理4.2.1 语言模型和文本生成4.2.2 机器翻译4.2.3 文本分类和情感分析4.3 语音识别和合成4.3.1 语音识别原理与技术4.3.2 语音合成原理与技术4.4 推荐系统4.4.1 基于内容的推荐4.4.2 协同过滤推荐4.4.3 深度学习在推荐系统中的应用第五章深度学习的训练和优化技巧5.1 数据预处理5.1.1 数据清洗和归一化处理5.1.2 数据增强技术5.2 正则化技术5.2.1 L1和L2正则化5.2.2 Dropout正则化5.2.3 批归一化(Batch Normalization) 5.3 学习率调整策略5.3.1 学习率衰减5.3.2 动量方法5.3.3 自适应学习算法(Adam)第六章深度学习的挑战和未来发展趋势6.1 深度学习存在的问题和挑战6.1.1 数据需求和标注困难6.1.2 模型的复杂性和计算资源要求6.2 深度学习的未来趋势6.2.1 模型压缩和轻量化网络6.2.2 自迁移学习和跨域学习6.2.3 强化学习和深度强化学习通过本文,我们深入解读了深度学习的基础知识。

深度学习知识:卷积神经网络与循环神经网络的比较深度学习(Deep Learning)是一种机器学习的方法,它旨在通过彼此之间有关的多层神经网络相互作用来解决复杂的模式识别问题。

在深度学习领域中,卷积神经网络(Convolutional Neural Network,CNN)和循环神经网络(Recurrent Neural Network,RNN)是两种最常用的神经网络架构。

它们分别适用于不同类型的任务,且各有优劣。

本文将对卷积神经网络和循环神经网络进行较为全面的比较。

我们将首先分别介绍这两种网络的基本原理和结构,然后从不同的角度对它们进行比较,包括适用领域、处理长期依赖性、参数共享、计算效率等方面。

1.卷积神经网络卷积神经网络是一种专门用于处理图像、语音识别、自然语言处理等高维数据的神经网络。

其核心思想是局部感知(local perception)和参数共享(parameter sharing)。

卷积层通过滤波器(filter)来提取数据的特征,池化层(pooling layer)通过降采样(down-sampling)来减少数据维度,全连接层(fully connected layer)则用于输出分类结果。

1.1卷积层:卷积层通过一系列的滤波器对输入数据进行卷积运算,从而提取数据的空间信息。

卷积运算的优势在于参数共享,使得网络对于输入的平移、旋转、尺度变化具有一定的不变性。

1.2池化层:池化层用于减少数据维度,提高模型的鲁棒性。

常用的池化操作包括最大池化(max pooling)、平均池化(average pooling)等。

1.3全连接层:全连接层将卷积层和池化层提取的特征映射到具体的分类结果上。

2.循环神经网络循环神经网络是一种适用于处理序列数据的神经网络结构。

其核心特点是具有循环连接(recurrent connection),能够在网络内部建立记忆,从而处理不定长的输入序列。

为了解决长期依赖性(long-term dependency)的问题,循环神经网络引入了门控机制,其中最典型的模型是长短期记忆网络(Long Short-Term Memory,LSTM)和门控循环单元(Gated Recurrent Unit,GRU)。

深度学习面试基本知识深度学习是机器学习的一个分支,它通过建立多层神经网络模型来模拟人类的神经系统,从而实现对数据的学习和分析。

在深度学习领域,掌握一些基本知识是进行面试的必备条件。

本文将介绍一些深度学习面试中常见的基本知识点。

1. 神经网络基础神经网络是深度学习的核心模型,它由多个神经元组成,每个神经元接收来自上一层神经元的输入,并将输入通过激活函数处理后传递给下一层神经元。

常见的神经网络结构包括前馈神经网络(Feedforward Neural Network)和循环神经网络(Recurrent Neural Network)等。

在面试中,你可能需要了解以下几个与神经网络相关的知识点:1.1 激活函数激活函数是神经网络中的一种非线性函数,它的作用是引入非线性因素,增加网络的表示能力。

常见的激活函数有Sigmoid函数、ReLU函数和Tanh函数等。

你需要理解这些激活函数的定义、特点以及适用场景。

1.2 损失函数损失函数用于衡量神经网络输出与真实值之间的差异,是深度学习中的一个重要概念。

常见的损失函数有均方误差(Mean Squared Error)和交叉熵(Cross Entropy)等。

你需要了解这些损失函数的定义、优缺点以及适用场景。

1.3 反向传播算法反向传播算法是训练神经网络的核心算法,它通过计算损失函数对网络参数的导数,从而根据梯度下降的原理进行参数更新。

你需要了解反向传播算法的基本原理,包括链式法则和梯度计算方法。

2. 卷积神经网络(CNN)卷积神经网络是深度学习中用于处理图像和语音等二维数据的重要模型。

它通过卷积、池化和全连接等操作来提取输入数据的特征,并进行分类或回归预测。

在面试中,你可能需要了解以下几个与卷积神经网络相关的知识点:2.1 卷积层卷积层是卷积神经网络的核心组件,它通过滑动窗口的方式对输入数据进行卷积操作,从而提取特征信息。

你需要了解卷积层的基本原理、参数设置以及卷积核的作用。

Python中的深度学习和强化学习随着科技的发展,机器学习成为了热门的领域之一。

深度学习和强化学习是机器学习中的两个重要方向,它们各自具有自己的特点和应用。

本文将重点介绍Python中的深度学习和强化学习的基础知识和应用。

一、深度学习深度学习是一种基于神经网络的机器学习方法,它可以通过多层次的神经网络自动学习抽象特征,并解决大规模的复杂问题。

Python 作为一种广泛使用的编程语言,具有许多强大的深度学习库,如TensorFlow、PyTorch等。

1. TensorflowTensorFlow是Google开发的开源机器学习框架,可以非常方便地构建和运行深度学习模型。

TensorFlow不仅支持机器学习,还可以用于数据科学和大数据应用。

TensorFlow提供了许多基于Python的API 接口,可以轻松地完成各种复杂神经网络的设计和实现。

2. PyTorchPyTorch是Facebook开发的另一种基于Python的开源机器学习框架,它与TensorFlow有着完全不同的结构。

PyTorch非常适合做研究和原型开发,可以非常快速地测试新的深度学习算法和模型。

3. KerasKeras是一个高级的深度学习API接口,它可以适用于TensorFlow、Theano和CNTK等不同的深度学习后端。

Keras使得构建和训练深度学习模型变得非常简单和易于使用。

以上三个深度学习框架各自有着自己的特点和优势,可根据具体需求进行选择和应用。

二、强化学习强化学习是一种采取试错策略的自动学习方法,通过与环境的交互来提高自己的能力。

强化学习在许多场景下都得到了应用,比如自动驾驶、游戏AI等。

Python也有着许多强大的强化学习库,如OpenAI gym、Tensorforce等。

1. OpenAI gymOpenAI gym是一个为了培养和比较强化学习算法而设计的平台。

它提供了一组标准接口,通过这些接口,开发者可以编写和训练强化学习智能体,并用不同的环境进行测试。

1. 深度学习中的“深度”通常指的是什么?A. 网络中隐藏层的数量B. 网络中节点的数量C. 网络中参数的数量D. 网络中输入层的数量2. 卷积神经网络(CNN)主要用于哪种类型的数据?A. 结构化数据B. 非结构化数据C. 图像数据D. 文本数据3. 在深度学习中,ReLU激活函数的优点是什么?A. 计算简单B. 防止梯度消失C. 输出范围无限D. 以上都是4. 以下哪种优化算法在深度学习中最常用?A. 梯度下降B. 随机梯度下降C. AdamD. 牛顿法5. 批量归一化(Batch Normalization)的主要作用是什么?A. 加速训练B. 防止过拟合C. 提高模型精度D. 以上都是6. 在深度学习中,过拟合通常是由于什么原因造成的?A. 模型太简单B. 数据太多C. 模型太复杂D. 数据太少7. 以下哪种技术可以用来防止过拟合?A. 数据增强B. 正则化C. DropoutD. 以上都是8. 在深度学习中,交叉熵损失函数通常用于哪种任务?A. 回归任务B. 分类任务C. 聚类任务D. 强化学习任务9. 以下哪种网络结构在自然语言处理中应用广泛?A. CNNB. RNNC. LSTMD. 以上都是10. 在深度学习中,注意力机制(Attention Mechanism)的主要作用是什么?A. 提高计算效率B. 增强模型对重要信息的聚焦C. 减少模型参数D. 防止过拟合11. 以下哪种技术可以用来处理序列数据?A. CNNB. RNNC. LSTMD. 以上都是12. 在深度学习中,迁移学习(Transfer Learning)的主要优势是什么?A. 减少训练时间B. 提高模型性能C. 减少数据需求D. 以上都是13. 以下哪种技术可以用来提高模型的泛化能力?A. 数据增强B. 正则化C. DropoutD. 以上都是14. 在深度学习中,生成对抗网络(GAN)的主要应用是什么?A. 图像生成B. 语音识别C. 自然语言处理D. 推荐系统15. 以下哪种技术可以用来生成新的数据样本?A. GANB. CNNC. RNND. LSTM16. 在深度学习中,强化学习(Reinforcement Learning)的主要特点是什么?A. 通过试错学习B. 需要大量标注数据C. 适用于静态环境D. 以上都不是17. 以下哪种技术可以用来处理无监督学习任务?A. 自编码器B. 聚类算法C. 生成模型D. 以上都是18. 在深度学习中,自编码器(Autoencoder)的主要作用是什么?A. 数据压缩B. 特征学习C. 数据生成D. 以上都是19. 以下哪种技术可以用来提高模型的鲁棒性?A. 数据增强B. 正则化C. DropoutD. 以上都是20. 在深度学习中,集成学习(Ensemble Learning)的主要优势是什么?A. 提高模型性能B. 减少训练时间C. 减少数据需求D. 以上都是21. 以下哪种技术可以用来提高模型的解释性?A. 可视化工具B. 特征选择C. 模型简化D. 以上都是22. 在深度学习中,元学习(Meta-Learning)的主要目标是什么?A. 快速适应新任务B. 提高模型性能C. 减少数据需求D. 以上都是23. 以下哪种技术可以用来处理多任务学习?A. 共享参数B. 任务特定的网络C. 多任务损失函数D. 以上都是24. 在深度学习中,知识蒸馏(Knowledge Distillation)的主要作用是什么?A. 模型压缩B. 提高模型性能C. 减少数据需求D. 以上都是25. 以下哪种技术可以用来提高模型的可扩展性?A. 分布式训练B. 模型并行C. 数据并行D. 以上都是26. 在深度学习中,半监督学习(Semi-Supervised Learning)的主要优势是什么?A. 减少标注数据需求B. 提高模型性能C. 加速训练D. 以上都是27. 以下哪种技术可以用来处理不平衡数据集?A. 重采样B. 代价敏感学习C. 集成方法D. 以上都是28. 在深度学习中,主动学习(Active Learning)的主要目标是什么?A. 减少标注数据需求B. 提高模型性能C. 加速训练D. 以上都是29. 以下哪种技术可以用来提高模型的可解释性?A. 可视化工具B. 特征选择C. 模型简化D. 以上都是30. 在深度学习中,对抗训练(Adversarial Training)的主要作用是什么?A. 提高模型鲁棒性B. 减少过拟合C. 加速训练D. 以上都是31. 以下哪种技术可以用来处理动态环境下的学习任务?A. 强化学习B. 迁移学习C. 元学习D. 以上都是32. 在深度学习中,多模态学习(Multi-Modal Learning)的主要目标是什么?A. 整合不同类型的数据B. 提高模型性能C. 减少数据需求D. 以上都是33. 以下哪种技术可以用来处理跨域学习任务?A. 迁移学习B. 元学习C. 多任务学习D. 以上都是34. 在深度学习中,增量学习(Incremental Learning)的主要优势是什么?A. 持续学习新知识B. 减少数据需求C. 提高模型性能D. 以上都是35. 以下哪种技术可以用来处理小样本学习任务?A. 元学习B. 迁移学习C. 数据增强D. 以上都是36. 在深度学习中,注意力机制(Attention Mechanism)的主要作用是什么?A. 提高计算效率B. 增强模型对重要信息的聚焦C. 减少模型参数D. 防止过拟合37. 以下哪种技术可以用来处理序列到序列的任务?A. RNNB. LSTMC. TransformerD. 以上都是38. 在深度学习中,Transformer模型的主要优势是什么?A. 并行计算B. 处理长序列C. 减少训练时间D. 以上都是39. 以下哪种技术可以用来提高模型的泛化能力?A. 数据增强B. 正则化C. DropoutD. 以上都是40. 在深度学习中,胶囊网络(Capsule Networks)的主要作用是什么?A. 提高模型性能B. 减少过拟合C. 提高对图像的理解能力D. 以上都是41. 以下哪种技术可以用来处理图像分割任务?A. CNNB. U-NetC. GAND. 以上都是42. 在深度学习中,U-Net模型的主要优势是什么?A. 处理小数据集B. 提高图像分割精度C. 减少训练时间D. 以上都是43. 以下哪种技术可以用来处理图像生成任务?A. GANB. CNNC. RNND. LSTM44. 在深度学习中,CycleGAN模型的主要作用是什么?A. 图像风格转换B. 图像生成C. 图像分割D. 以上都是45. 以下哪种技术可以用来处理图像超分辨率任务?A. GANB. CNNC. RNND. LSTM答案:1. A2. C3. D4. C5. D6. C7. D8. B9. D10. B11. D12. D13. D14. A15. A16. A17. D18. D19. D20. A21. D22. A23. D24. A25. D26. A27. D28. A29. D30. A31. A32. A33. A34. A35. A36. B37. D38. D39. D40. C41. B42. B43. A44. A45. A。

深度学习的基础知识深度学习(Deep Learning)是一种基于人工神经网络的机器学习方法,它模拟人类大脑的结构和功能,通过多层次的非线性处理单元对数据进行特征提取和建模,从而实现对复杂问题的学习和推断。

深度学习在语音识别、图像识别、自然语言处理和推荐系统等领域取得了广泛的应用和突破,成为了当今人工智能领域的热点之一。

本文将从深度学习的基本原理、常见模型和应用实例等方面介绍深度学习的基础知识,帮助读者深入了解深度学习的相关内容。

一、深度学习的基本原理深度学习模型的核心是人工神经网络(Artificial Neural Networks,ANNs),它由大量的神经元(Neurons)和连接它们的权重(Weights)组成,每个神经元接收来自前一层神经元的输入,并对其进行加权和非线性变换后输出给下一层神经元。

整个网络通过多层次的非线性处理单元逐层组合,形成了深度结构,从而能够学习到更加复杂的特征和模式。

1.神经元的工作原理神经元是人工神经网络的基本组成单元,它模拟了生物神经元的工作原理。

每个神经元接收来自前一层神经元的多个输入信号,通过加权和非线性变换后输出给下一层神经元。

具体来说,神经元的输入经过加权和求和后,再经过一个激活函数(Activation Function)进行非线性变换,最终输出给下一层神经元。

常用的激活函数包括Sigmoid函数、ReLU函数和tanh函数等。

2.神经网络的训练人工神经网络通过学习来调整连接权重,使得网络能够适应输入数据的特征和模式。

网络的训练通常采用梯度下降法(Gradient Descent)。

具体来说,网络先进行前向传播,将输入数据通过每层神经元的加权和非线性变换后输出给输出层,然后计算输出层的预测值与真实标签值的误差,最后通过反向传播算法将误差逐层传递回去,调整每个神经元的权重。

3.深度学习的优化深度学习模型通常会面临的问题包括梯度消失和梯度爆炸等。

为了解决这些问题,人们提出了许多优化方法,如Batch Normalization、Dropout和Residual Network等。

1、深度学习:“深度学习是基于原有知识能力之上的、以学习者主动参与为前提、重视知识结构的建立和认知策略的元认知过程,以知识迁移和认知策略迁移解决实际问题为最终目标”。

由此可见,深度学习意味着理解与批判、联系与构建、迁移与应用、学习的积极与主动,它通过对学习机制的探索,创造了新的学习方式,最大限度地提高学生的学习效能。

学生学习方式的变革是新一轮基础教育课程改革的显著特征。

过去,我们多侧重从教师教的角度研究变革教的方式;现在,新一轮课程改革则提出从学生的角度研究变革学的方式。

二、深度学习的特征深度学习与浅层学习在学习目标、知识呈现方式、学习者的学习状态和学习结果的迁移等方面都有明显的差异。

其特点主要表现在四个方面。

第一,深度学习注重知识学习的批判理解。

深度学习是一种基于理解的学习,强调学习者批判性地学习新知识和思想,要求学习者对任何学习材料保持一种批判或怀疑的态度,批判性地看待新知识并深入思考,并把它们纳入原有的认知结构中,在各种观点之间建立多元联接,要求学习者在理解事物的基础上善于质疑辨析,在质疑辨析中加深对深层知识和复杂概念的理解。

[6]第二,深度学习强调学习内容的有机整合。

学习内容的整合包括内容本身的整合和学习过程的整合。

其中内容本身的整合是指多种知识和信息间的联接,包括多学科知识融合及新旧知识联系。

深度学习提倡将新概念与已知概念和原理联系起来,整合到原有的认知结构中,从而引起对新的知识信息的理解、长期保持及迁移应用。

学习过程的整合是指形成内容整合的认知策略和元认知策略,使其存储在长时记忆中,如利用图表、概念图等方式利于梳理新旧知识之间的联系。

而浅层学习将知识看成是孤立的、无联系的单元来接受和记忆,不能促进对知识的理解和长期保持。

第三,深度学习着意学习过程的建构反思。

建构反思是指学习者在知识整合的基础上通过新、旧经验的双向相互作用实现知识的同化和顺应,调整原有认知结构,并对建构产生的结果进行审视、分析、调整的过程。

model-based deep learning 概述及解释说明1. 引言1.1 概述深度学习作为一种机器学习方法,已经在各个领域取得了显著的成就。

传统的深度学习方法主要依赖于大量标注的数据进行训练,从而提取出有效的特征表示。

然而,这些方法在面对缺乏标签或样本稀缺的问题时表现不佳。

因此,基于模型的深度学习方法应运而生。

1.2 文章结构本文首先介绍深度学习基础知识,包括神经网络和深度学习概述、模型训练与优化算法以及损失函数与评估指标。

之后,详细介绍Model-Based Deep Learning的定义、背景以及与传统深度学习方法的区别与联系。

接着,探讨Model-Based Deep Learning在不同领域中的应用和案例研究。

随后,重点解析Model-Based Reinforcement Learning,在强化学习中的模型建模方法及其应用案例分析,并探讨实际问题中可能遇到的挑战和解决方案。

之后是Model-Based Generative Adversarial Networks(GAN)综述,包括GAN 原理简介及其发展历程回顾、基于模型的GAN方法在视觉图像合成、图像处理等任务中的应用,以及Model-Based GAN的潜在应用和研究展望。

最后,通过总结主要观点,对Model-Based Deep Learning未来研究方向进行展望。

1.3 目的本文旨在全面介绍Model-Based Deep Learning,并解释其背景、优势和与传统深度学习方法的区别。

通过案例分析,探讨Model-Based Reinforcement Learning和Model-Based GAN在实际问题中的应用。

同时,本文还将探讨现有方法可能遇到的挑战,并提出解决方案。

最后,希望通过对未来研究方向的展望来推动Model-Based Deep Learning领域的发展。

(Translation)1. Introduction1.1 OverviewDeep learning, as a machine learning method, has achieved remarkable success in various fields. Traditional deep learning methods rely heavily on a large amount of annotated data for training to extract effective feature representations. However, these methods perform poorly when faced with problems that lack labels or have scarce samples. Hence, model-based deep learning approaches have emerged.1.2 Article StructureThis article begins by introducing the basics of deep learning, including an overview of neural networks and deep learning, model training andoptimization algorithms, as well as loss functions and evaluation metrics. It then provides a detailed explanation of Model-Based Deep Learning, including its definition, background, and the differences and connections with traditional deep learning methods. The article goes on to explore the applications and case studies of Model-Based Deep Learning in various domains. Next, it delves into the details of Model-Based Reinforcement Learning, covering the modeling methods and application case analysis in reinforcement learning and discussing challenges and solutions in real-world problems. Following that, a comprehensive review of Model-Based Generative Adversarial Networks (GAN) is presented. This includes an introduction to GAN principles, a retrospective on its development, the application of model-based GAN methods in tasks such as visual image synthesis and image processing, as well as the potential applications and future prospects of Model-Based GAN. Finally, the article concludes by summarizing the main points and providing insights into future research directions for Model-Based Deep Learning.1.3 ObjectivesThe objective of this article is to provide a comprehensive overview of Model-Based Deep Learning and explain its background, advantages, and differences from traditional deep learning methods. Through casestudies, it aims to explore the applications of Model-Based Reinforcement Learning and Model-Based GAN in practical problems. Additionally, this article will discuss the challenges faced by existing methods and propose potential solutions. Lastly, by offering insights into future research directions, it hopes to drive advancements in the field of Model-Based Deep Learning.2. 深度学习基础:2.1 神经网络和深度学习概述:深度学习是机器学习领域中的一个重要分支,它模仿人脑神经网络的工作方式,通过构建多层神经网络来实现对大规模数据的高效处理和学习。

神经网络的定义神经网络是一组大致模仿人类大脑构造设计的算法,用于识别模式。

神经网络通过机器感知系统解释传感器数据,对原始输入进行标记或聚类。

神经网络所能识别的模式是包含在向量中的数值形式,因此图像、声音、文本、时间序列等一切现实世界的数据必须转换为数值。

神经网络帮助我们进行聚类和分类。

可以将其理解为建立在你所存储和管理的数据之上的一个聚类与分类层。

对于未标记的数据,神经网络可以按照输入样例的相似之处将数据分组;若能用已标记的数据集定型,神经网络就可以对数据进行系统分类。

(更准确地说,神经网络提取特征,再输入其他算法进行聚类和分类;因此可以将深度神经网络视为更大的机器学习应用系统的一部分,这个系统中还包括强化学习、分类和回归分析的算法。

)神经网络的要素深度学习系统指一系列由多个层堆叠组成的特定神经网络。

每一层则由节点构成。

运算在节点中进行,节点的运作模式与人类的神经元大致相似,遇到足够的刺激信息时就会激活并释放信号。

节点将输入数据与一组系数(或称权重)结合,通过放大或抑制输入来指定其在算法学习任务中的重要性。

输入数据与权重的乘积之和将进入节点的激活函数,判定信号是否继续在网络中传递,以及传递的距离,从而决定信号如何影响网络的最终结果,例如分类动作。

节点层是一行类似神经元的开关,在输入数据通过网络时开启或关闭。

从最初接收数据的第一个输入层开始,每一层的输出同时也是下一层的输入。

我们将输入特征与可调整的权重匹配,由此指定这些特征的重要性,即它们对网络的输入分类和聚类方式有多大程度的影响。

深度神经网络的重要概念顾名思义,深度学习网络与更常见的单一隐藏层神经网络的区别在于深度,即数据在模式识别的多步流程中所经过的节点层数。

传统机器学习系统主要使用由一个输入层和一个输出层组成的浅层网络,至多在两层之间添加一个隐藏层。

三层以上(包括输入和输出层在内)的系统就可以称为“深度”学习。

所以,深度是一个有严格定义的术语,表示一个以上的隐藏层。

在深度学习网络中,每一个节点层在前一层输出的基础上学习识别一组特定的特征。

随着神经网络深度增加,节点所能识别的特征也就越来越复杂,因为每一层会整合并重组前一层的特征。

这被称为特征层次结构,复杂度与抽象度逐层递增。

这种结构让深度学习网络能处理大规模高维度数据集,进行数十亿个参数的非线性函数运算。

最重要的是,深度学习网络可以发现未标记、非结构化数据中的潜在结构,而现实世界中的数据绝大多数都属于这一类型。

非结构化数据的另一名称是原始媒体,即图片、文本、音视频文件等。

因此,深度神经网络最擅长解决的一类问题就是对现实中各类未标记的原始媒体进行处理和聚类,在未经人工整理成关系数据库的数据中,甚至是尚未命名的数据中识别出相似点和异常情况。

例如,深度学习网络可以处理一百万张图片,根据其相似之处进行聚类:一个角落是猫的图片,一个角落是破冰船的图片,还有一个角落都是你祖母的照片。

这就是所谓智能相册的基础。

同样的原理还可以应用于其他数据类型:深度学习可以对电子邮件或新闻报道等原始文本进行聚类。

通篇都是愤怒投诉的邮件可以聚集到向量空间的一个角落,而客户的满意评价或者垃圾邮件则可以聚集到别的角落。

这就是各类信息过滤器的基础,也可以用于客户关系管理(CRM)。

这对于语音消息同样适用。

如果使用时间序列,数据可以按正常/健康行为或异常/危险行为进行聚类。

由智能手机生成的时间序列数据可以用于洞悉用户的健康状况和生活习惯;而由汽车零部件产生的时间序列数据则可以用来预防严重故障。

与多数传统的机器学习算法不同,深度学习网络可以进行自动特征提取,而无需人类干预。

由于特征提取是需要许多数据科学家团队多年时间才能完成的任务,深度学习可以用于缓解专家人数不足造成的瓶颈。

较小的数据科学家团队原本难以实现规模化,而深度学习可以增强他们的力量。

用未标记数据定型时,深度神经网络的每一节点层会自动学习识别特征,方法是反复重构输入的样本,让网络猜测结果与输入数据自身几率分布之间的差异最小化。

例如,受限玻尔兹曼机就以这种方式进行所谓的重构。

深度神经网络通过这一过程学习识别具体相关特征和理想结果之间的关联-它们在特征信号与特征所代表的含义之间建立联系,可以是完全重构,也可以利用已标记的数据。

深度学习网络最终有一个输出层:一个逻辑或softmax分类器,用于指定某一种特定结果或标签的可能性。

我们称之为预测,但这是广义上的预测。

比方说,对一个深度学习网络输入图像形式的原始数据,网络可能会判定输入数据代表一个人的可能性是90%。

多元线性回归分析虽然人工神经网络这个名字来源于生物学,但其实质无非是数学运算和程序代码,就像其他机器学习算法一样。

事实上,只要理解线性回归这一统计学中的基本方法,就能理解神经网络的运作原理。

线性回归的最简表示方式是:其中Y_hat是估测的输出,X是输入,b是斜率,a是一条直线在二维图像平面纵轴上的截距。

(用更具体的例子说明:X可以是辐射照射量,Y可以是癌症风险;X可以是每天做俯卧撑的次数,Y是你能卧推的总重量;X可以是肥料的使用量,Y可以是农作物的大小。

)可以想象,每当X增加一个单位时,不论在X轴上的距离有多远,应变量Y都会按比例增加。

两个变量同步上下移动的简单关系是起点。

下一步是想象多元线性回归,它有多个输入变量,一个输出变量。

多元线性回归通常表示为以下形式:(借用前文农作物的例子,可以在肥料这一变量之外增加日照、降水量,所有三个变量都会影响Y_hat。

)这种形式的多元线性回归在神经网络的每个节点发生。

对于单个层内的每一节点,上一层内每个节点的输入都与所有其他节点的输入重新组合。

也就是说,输入按照各自的系数以不同比例混合,而系数在进入下一层的每个节点时会有所改变。

网络在减少误差的过程中用这种方式测试何种输入的组合具有意义。

节点输入在相加得到Y_hat之前,还会经过一个非线性函数。

其原因在于:如果每个节点都只进行多元线性回归运算,Y_hat将随X的增加而无限增大,这并不符合我们的目的。

每个节点所要实现的功能相当于一个开关(就像神经元一样……),其开关状态取决于是否应当让输入信号通过并对网络的最终判定结果产生影响。

每个开关也就是一个分类问题。

对于输入的信号,节点应当将其归为足够还是不够,开还是关?二元判定可以用1和0表示,使用逻辑回归这种非线性函数可以挤压输入,将其转换至0到1的区间内。

每个节点的非线性变换通常使用与逻辑回归相似的S型函数。

这类函数被称为sigmoid(希腊字母“S”的读音)、tanh、hard tanh等,用于调整每个节点的输出。

每个节点的输出均被挤压至0到1之间的s形空间内,随后作为输入传递至前馈神经网络的下一个层,如此不断推进,直至网络进行判定的最终层逻辑回归对于多层的深度神经网络,最后一个层有着独特的作用。

在处理已标记的输入时,输出层会对每个样例进行分类,添加最有可能与之匹配的标签。

输出层上的每个节点都代表一个标签,节点根据其从上一层输入和参数中接收到的信号强度来决定开关。

每个节点都有两种可能的结果,即二进制输出值0或1,因为输入变量要么与标签匹配,要么不匹配。

毕竟,世界上不存在“稍微有点怀孕”这种事。

处理已标记数据的神经网络生成的是二进制输出,然而网络接收的输入数据通常是连续的。

也就是说,网络接收到的输入信号通常会涵盖较大范围的值,包含许多种指标,具体取决于网络所要解决的问题。

例如,推荐引擎必须决定是否显示一个广告,这是一种二元判定。

但是引擎判定所依赖的输入可能包括客户上周在亚马逊网站上的消费金额,或者客户访问网站的频率等。

于是,输出层就必须将“花67.59美元购买尿布”、“访问网站15次”这样的信号压缩至0到1的区间内,亦即特定输入应当被标记的概率。

用于将连续信号转换为二进制输出的机制称为逻辑回归。

逻辑回归名不副实,因为它的用途是分类,而非大多数人所熟悉的线性回归分析。

逻辑回归用于计算一组输入与标签相匹配的概率。

我们看一看这个简单的公式。

连续输入如果要用概率的形式表示,就必须输出正的结果,因为不存在负概率。

正因为如此,输入在公式里是分母中e的指数-因为指数后的运算结果必定大于零。

接下来再看e的指数与分数1/1的关系。

我们知道,概率的最大值是一,如果超过一,则必然得出荒唐的结果。

(对此我们120%肯定。

)触发标签的输入x增加时,e的负x次幂会逐渐趋于零,函数的结果则趋向1/1,即100%,意味着我们越来越接近(但并不会达到)确定标签绝对匹配的状态。

与输出负相关的输入作为e的指数时会被负号转换成正数,所以随着负信号不断增加,e的负x次幂也会增大,使整个分数更趋向于零。

现在试想指数不再是x,而是所有权重与其对应输入的乘积的总和-在网络中传递的信号总和。

这就是输入神经网络分类器输出层的逻辑回归层的数据。

我们可以为这个层设置判定的标准,高于标准的样例标记为1,低于标准则不予标记。

你可以按照需要自行设定不同的标准-标准过低会增加取伪错误的数量,标准过高会增加弃真错误的数量-具体取决于你更能容忍哪一类的错误。

神经网络与人工智能在有些领域内,神经网络被视为“蛮力型”人工智能,因为这类系统最开始都是白纸一张,随后再一步一步打造出一个准确的模型。

神经网络很有效,但有些人认为这种建模方法效率低下,不能对输出与输入之间的函数依赖性进行假设。

话虽如此,梯度下降其实并不需要将每个权重都与其他所有权重重组才能发现最佳组合-梯度下降的寻路算法会压缩相关的权重空间,进而使所需的更新次数以及运算量减少许多个数量级。