matlab回归分析(1)

- 格式:doc

- 大小:146.50 KB

- 文档页数:11

使用Matlab技术进行回归分析的基本步骤回归分析是统计学中一种用于研究变量间关系的方法,可以用来预测和解释变量之间的相关性。

在实际应用中,使用计算工具进行回归分析可以提高分析效率和准确性。

本文将介绍使用Matlab技术进行回归分析的基本步骤,并探讨其中的一些关键概念和技巧。

一、数据准备在进行回归分析之前,首先需要收集和整理相关的数据。

这些数据通常包括自变量和因变量。

自变量是用来解释或预测因变量的变量,而因变量是需要解释或预测的变量。

在Matlab中,可以将数据保存为数据矩阵,其中每一列代表一个变量。

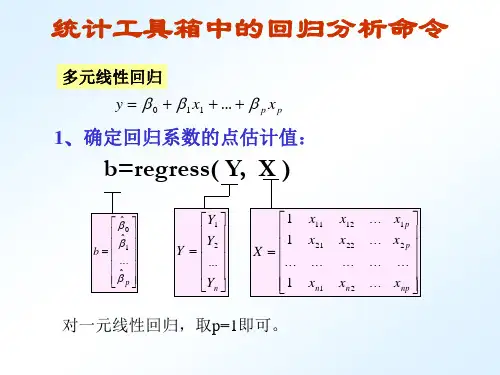

二、模型建立在回归分析中,需要建立一个数学模型来描述自变量和因变量之间的关系。

最简单的线性回归模型可以表示为:Y = βX + ε,其中Y是因变量,X是自变量,β是回归系数,ε是误差项。

在Matlab中,可以使用regress函数来进行线性回归分析。

三、模型拟合模型拟合是回归分析的核心步骤,它的目标是找到最佳的回归系数,使得预测值与实际观测值之间的差异最小。

在Matlab中,可以使用OLS(Ordinary Least Squares)方法来进行最小二乘法回归分析。

该方法通过最小化残差平方和来估计回归系数。

四、模型诊断模型诊断是回归分析中非常重要的一步,它可以帮助我们评估模型的合理性和有效性。

在Matlab中,可以使用多种诊断方法来检验回归模型是否满足统计假设,例如残差分析、方差分析和假设检验等。

这些诊断方法可以帮助我们检测模型是否存在多重共线性、异方差性和离群值等问题。

五、模型应用完成模型拟合和诊断之后,我们可以使用回归模型进行一些实际应用。

例如,可以使用模型进行因变量的预测,或者对自变量的影响进行解释和分析。

在Matlab中,可以使用该模型计算新的观测值和预测值,并进行相关性分析。

六、模型改进回归分析并不是一次性的过程,我们经常需要不断改进模型以提高预测的准确性和解释的可靠性。

在Matlab中,可以使用变量选择算法和模型改进技术来优化回归模型。

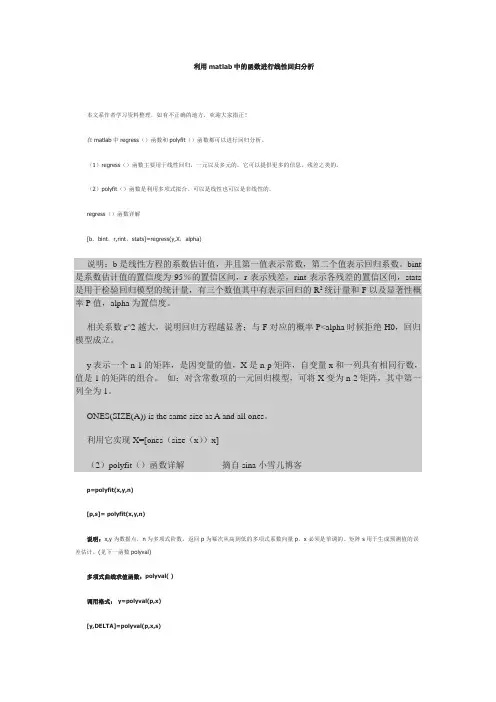

利用matlab中的函数进行线性回归分析本文系作者学习资料整理,如有不正确的地方,欢迎大家指正!在matlab中regress()函数和polyfit()函数都可以进行回归分析。

(1)regress()函数主要用于线性回归,一元以及多元的。

它可以提供更多的信息,残差之类的。

(2)polyfit()函数是利用多项式拟合。

可以是线性也可以是非线性的。

regress()函数详解[b,bint,r,rint,stats]=regress(y,X,alpha)说明:b是线性方程的系数估计值,并且第一值表示常数,第二个值表示回归系数。

bint 是系数估计值的置信度为95%的置信区间,r表示残差,rint表示各残差的置信区间,stats 是用于检验回归模型的统计量,有三个数值其中有表示回归的R2统计量和F以及显著性概率P值,alpha为置信度。

相关系数r^2越大,说明回归方程越显著;与F对应的概率P<alpha时候拒绝H0,回归模型成立。

y表示一个n-1的矩阵,是因变量的值,X是n-p矩阵,自变量x和一列具有相同行数,值是1的矩阵的组合。

如:对含常数项的一元回归模型,可将X变为n-2矩阵,其中第一列全为1。

ONES(SIZE(A)) is the same size as A and all ones。

利用它实现X=[ones(size(x))x](2)polyfit()函数详解-------------摘自sina小雪儿博客p=polyfit(x,y,n)[p,s]= polyfit(x,y,n)说明:x,y为数据点,n为多项式阶数,返回p为幂次从高到低的多项式系数向量p。

x必须是单调的。

矩阵s用于生成预测值的误差估计。

(见下一函数polyval)多项式曲线求值函数:polyval( )调用格式:y=polyval(p,x)[y,DELTA]=polyval(p,x,s)说明:y=polyval(p,x)为返回对应自变量x在给定系数P的多项式的值。

在MATLAB中进行分类和回归分析在科学和工程领域,分类和回归分析是常见的数据分析方法。

而MATLAB作为一种功能强大的数据分析软件,提供了丰富的工具和函数,使得分类和回归分析变得更加简单和高效。

本文将介绍在MATLAB中进行分类和回归分析的方法和技巧,帮助读者更好地理解和应用这些技术。

一、背景介绍分类和回归分析是基于已知数据的模式进行预测和分类的统计方法。

分类分析用于将数据分为不同的类别,而回归分析则试图通过已知数据的模式预测未知数据的数值。

这些方法在各个领域都有广泛的应用,如金融、医疗、市场营销等。

二、数据准备在进行分类和回归分析之前,需要准备好相应的数据。

一般来说,数据应当包含自变量(也称为特征或输入)和因变量(也称为标签或输出)。

自变量是用来作为预测或分类的输入变量,而因变量是要预测或分类的目标变量。

通常情况下,数据应当是数值型的,如果包含分类变量,需要进行相应的编码或处理。

三、分类分析在MATLAB中进行分类分析,有多种方法和技术可供选择。

其中最常见的方法包括K最近邻算法(K-nearest neighbors)和支持向量机(Support Vector Machines)等。

这些方法都有相应的函数,可以用于在MATLAB中实现分类分析。

K最近邻算法基于训练样本和测试样本之间的距离,将测试样本分类为与其最近的K个训练样本所属的类别。

而支持向量机则试图找到一个超平面,将不同类别的样本分开,并使得分类误差最小化。

在MATLAB中,我们可以使用fitcknn和fitcsvm函数来实现K最近邻算法和支持向量机。

除了上述方法,还有其他的分类算法可以在MATLAB中使用,如决策树、随机森林等。

根据数据的具体情况和需求,选择适合的分类算法非常重要。

四、回归分析在进行回归分析时,我们需要首先选择适当的回归模型。

常用的回归模型包括线性回归、多项式回归、岭回归等。

根据数据的分布和特点,选择合适的回归模型能够提高分析的准确性。

MATLAB回归分析回归分析是统计学中常用的一种方法,用于建立一个依赖于自变量(独立变量)的因变量(依赖变量)的关系模型。

在MATLAB环境下,回归分析可以实现简单线性回归、多元线性回归以及非线性回归等。

简单线性回归是一种最简单的回归分析方法,它假设自变量和因变量之间存在线性关系。

在MATLAB中,可以通过`polyfit`函数进行简单线性回归分析。

该函数可以拟合一元数据点集和一维多项式,返回回归系数和截距。

例如:```matlabx=[1,2,3,4,5];y=[2,3,4,5,6];p = polyfit(x, y, 1);slope = p(1);intercept = p(2);```上述代码中,`x`是自变量的数据点,`y`是因变量的数据点。

函数`polyfit`的第三个参数指定了回归的阶数,这里是1,即一次线性回归。

返回的`p(1)`和`p(2)`分别是回归系数和截距。

返回的`p`可以通过`polyval`函数进行预测。

例如:```matlabx_new = 6;y_pred = polyval(p, x_new);```多元线性回归是在有多个自变量的情况下进行的回归分析。

在MATLAB中,可以使用`fitlm`函数进行多元线性回归分析。

例如:```matlabx1=[1,2,3,4,5];x2=[2,4,6,8,10];y=[2,5,7,8,10];X=[x1',x2'];model = fitlm(X, y);coefficients = model.Coefficients.Estimate;```上述代码中,`x1`和`x2`是两个自变量的数据点,`y`是因变量的数据点。

通过将两个自变量放在`X`矩阵中,可以利用`fitlm`函数进行多元线性回归分析。

返回值`model`是回归模型对象,可以通过`model.Coefficients.Estimate`获得回归系数。

Matlab技术回归分析方法简介:回归分析是一种常用的数据分析方法,用于建立变量之间的关系模型。

Matlab是一种功能强大的数值计算软件,提供了丰富的函数和工具包,用于实现回归分析。

本文将介绍几种常见的Matlab技术回归分析方法,并探讨其应用场景和优缺点。

一、线性回归分析:线性回归分析是回归分析的经典方法之一,用于研究变量之间的线性关系。

在Matlab中,可以使用`fitlm`函数来实现线性回归分析。

该函数通过最小二乘法拟合出最优的线性模型,并提供了各种统计指标和图形展示功能。

线性回归分析的应用场景广泛,例如预测销售额、研究市场需求等。

然而,线性回归假设自变量和因变量之间存在线性关系,当数据呈现非线性关系时,线性回归会失效。

为了解决非线性关系的问题,Matlab提供了多种非线性回归分析方法,如多项式回归、指数回归等。

二、多项式回归分析:多项式回归分析是一种常见的非线性回归方法,用于建立多项式模型来描述变量之间的关系。

在Matlab中,可以使用`fitlm`函数中的`polyfit`选项来实现多项式回归分析。

多项式回归在处理非线性关系时具有很好的灵活性。

通过选择不同的多项式次数,可以适应不同程度的非线性关系。

然而,多项式回归容易过拟合,导致模型过于复杂,对新数据的拟合效果不佳。

为了解决过拟合问题,Matlab提供了正则化技术,如岭回归和Lasso回归,可以有效控制模型复杂度。

三、岭回归分析:岭回归是一种正则化技术,通过添加L2正则项来控制模型的复杂度。

在Matlab中,可以使用`fitlm`函数的`Regularization`选项来实现岭回归分析。

岭回归通过限制系数的大小,减少模型的方差,并改善模型的拟合效果。

然而,岭回归不能自动选择最优的正则化参数,需要通过交叉验证等方法进行调优。

四、Lasso回归分析:Lasso回归是另一种常用的正则化技术,通过添加L1正则项来控制模型的复杂度。

在Matlab中,可以使用`fitlm`函数的`Regularization`选项来实现Lasso回归分析。

如何在MATLAB中进行统计回归分析统计回归分析是一种被广泛应用于数据科学和统计学领域的技术。

它被用来分析变量之间的关系,并预测一个或多个自变量对因变量的影响。

在MATLAB中,有许多强大的工具和函数可以帮助我们进行统计回归分析。

本文将讨论如何在MATLAB中使用这些功能进行统计回归分析。

1. 数据导入与预处理在进行回归分析之前,首先需要将数据导入到MATLAB中。

MATLAB支持多种数据格式,如CSV、Excel、文本文件等。

可以使用readmatrix或readtable等函数读取数据,根据数据的特点选择合适的函数。

在导入数据之后,通常需要对数据进行预处理。

这包括处理缺失值、异常值以及数据的标准化。

MATLAB提供了一系列函数来处理这些问题,如isnan、isoutlier和zscore等。

2. 单变量回归分析单变量回归分析是最基本的回归分析方法。

它用于分析一个自变量对一个因变量的影响。

在MATLAB中,可以使用fitlm函数进行单变量回归分析。

fitlm函数需要输入自变量和因变量的数据,然后可以对回归模型进行拟合,并得到回归系数、残差等统计信息。

使用plot函数可以绘制回归模型的拟合曲线,以及残差的散点图。

通过观察残差的分布,可以评估拟合模型的合理性。

3. 多变量回归分析多变量回归分析是在一个或多个自变量对一个因变量的影响进行分析。

在MATLAB中,可以使用fitlm函数或者fitlmulti函数实现多变量回归分析。

fitlm函数可以处理多个自变量,但是需要手动选择自变量,并提供自变量和因变量的数据。

fitlmulti函数则可以自动选择最佳的自变量组合,并进行回归拟合。

它需要提供自变量和因变量的数据矩阵。

多变量回归分析的结果可以通过查看回归系数和残差来解释。

还可以使用plot函数绘制回归模型的拟合曲面或曲线,以便更好地理解自变量对因变量的影响。

4. 方差分析方差分析是一种常用的统计方法,用于比较两个或多个因素对因变量的影响。

如何使用MATLAB进行数据拟合与回归分析MATLAB是一种功能强大的数值计算和数据分析工具,可以用于数据拟合和回归分析。

下面将介绍如何使用MATLAB进行数据拟合和回归分析的步骤。

1. 导入数据:首先,将需要进行数据拟合和回归分析的数据导入到MATLAB中。

可以通过读取Excel文件、文本文件或直接将数据输入到MATLAB的工作空间中。

2. 数据预处理:在进行数据拟合和回归分析之前,通常需要对数据进行预处理。

这包括数据清洗、去除异常点、处理缺失值等。

MATLAB提供了许多数据预处理函数,如清除NaN值的函数“cleanData”和删除异常值的函数“outliers”。

3. 数据可视化:在进行数据拟合和回归分析之前,可以先对数据进行可视化,以便更好地了解数据的特征和分布。

MATLAB提供了丰富的绘图函数,可以绘制散点图、直方图、箱线图等。

例如,可以使用“scatter”函数绘制散点图,使用“histogram”函数绘制直方图。

4. 数据拟合:数据拟合是根据已有数据点,拟合出一个数学模型与函数,以揭示数据的内在规律。

在MATLAB中,可以使用“polyfit”函数进行多项式拟合,使用“fit”函数进行曲线拟合,也可以使用自定义函数进行拟合。

拟合过程可以使用最小二乘法等方法进行。

5. 回归分析:回归分析是通过对自变量和因变量之间的关系进行建模,预测因变量的值。

在MATLAB中,可以使用线性回归模型、多项式回归模型、逻辑回归模型等进行回归分析。

可以使用“fitlm”函数进行线性回归分析,使用“polyfit”函数进行多项式回归分析,使用“fitglm”函数进行逻辑回归分析。

6. 模型评估:在进行数据拟合和回归分析之后,需要对模型进行评估,以判断模型的合理性和预测能力。

在MATLAB中,可以使用均方误差(MSE)、决定系数(R-squared)、残差分析等方法对模型进行评价。

可以使用“mse”函数计算MSE,使用“rsquared”函数计算R-squared。

MATLAB回归分析回归分析是一种通过建立数学模型来研究变量之间的关系的统计方法。

在MATLAB中,我们可以使用回归分析工具箱来进行回归分析。

回归分析的目标是找到一个能够最好地描述自变量和因变量之间关系的数学模型。

在这篇文章中,我们将介绍回归分析的基本原理、MATLAB中的回归分析工具箱的使用以及如何解释回归分析的结果。

回归分析的基本原理回归分析建立在线性回归的基础上。

线性回归假设因变量与自变量之间存在一个线性关系。

回归分析通过找到最佳拟合线来描述这种关系。

最常用的回归方程是一元线性回归方程,它可以表示为:y=β0+β1x+ε,其中y是因变量,x是自变量,β0和β1是回归系数,ε是误差项。

- regress函数:用于计算多元线性回归模型,并返回回归系数、截距和残差。

例如,[B, BINT, R]=regress(y, X)用于计算因变量y和自变量矩阵X之间的回归模型。

- fitlm函数:用于拟合线性回归模型并返回拟合对象。

例如,mdl= fitlm(X, y)用于拟合因变量y和自变量矩阵X之间的线性回归模型,并返回mdl拟合对象。

- plot函数:用于绘制回归分析的结果。

例如,plot(mdl)用于绘制fitlm函数返回的拟合对象mdl的结果。

- coefCI函数:用于计算回归系数的置信区间。

例如,CI =coefCI(mdl)用于计算拟合对象mdl中回归系数的置信区间。

解释回归分析的结果回归分析的结果通常包括拟合曲线、回归系数以及模型的可靠性指标。

拟合曲线描述了自变量和因变量之间的关系。

回归系数可以用来解释自变量对因变量的影响。

模型的可靠性指标包括截距、回归系数的显著性检验以及相关系数等。

拟合曲线可以通过调用plot函数来绘制。

回归系数可以通过调用coef函数来获取。

对回归系数的显著性检验可以利用置信区间来判断,如果置信区间包含0,则说明回归系数不显著。

相关系数可以通过调用corrcoef函数来计算。

1、 考察温度x 对产量y 的影响,测得下列10组数据:

预测区间(置信度95%).

x=[20:5:65]'; Y=[ ]'; X=[ones(10,1) x]; plot(x,Y,'r*');

[b,bint,r,rint,stats]=regress(Y,X); b,bint,stats;

rcoplot(r,rint) %残差分析,作残差图

结果: b = bint = stats =

即01

ˆˆ9.1212,0.2230ββ==;0ˆβ的置信区间为[8.0211,10.2214]1ˆβ的置信区间为[0.1985,0.2476]; 2r = , F=, p= ,p<, 可知回归模型 y=+ 成立.

将x=42带入得到.

从残差图可以看出,所有数据的残差离零点均较近,且残差的置信区间均包含零点,这说明回归模型 y=+能较好的符合原始数据。

2

某零件上有一段曲线,为了在程序控制机床上加工这一零件,需要求这段曲线的解析表达式,在曲线横坐标xi处测得纵坐标yi共11对数据如下:

求这段曲线的纵坐标y关于横坐标x的二次多项式回归方程。

t=0:2:20;

s=[ ];

T=[ones(11,1) ,t',(t.^2)'];

[b,bint,r,rint,stats]=regress(s',T);

b,stats;

Y=polyconf(p,t,S)

plot(t,s,'k+',t,Y,'r') %预测及作图

b =

+04 *

2ˆ 1.01050.19710.1403s

t t =++ 图形为:

3

混凝土的抗压强度随养护时间的延长而增加,现将一批混凝土作成12个试块,记录了

试求ˆln y

a b x =+型回归方程。

function yhat=volum(beta,x); yhat=beta(1)+beta(2)*log(x);

%输入

x=[2 3 4 5 7 9 12 14 17 21 28 56]; y=[35 42 47 53 59 65 68 73 76 82 86 99]; beta0=[5 1]';

[beta,r,J]=nlinfit(x',y','volum',beta0); beta

结果: beta =

所得回归模型为:21.05819.5285ln y x =+ 画线:plot(x,y,'r-')

x=[2 3 4 5 7 9 12 14 17 21 28 56]'; u=log(x); u=[ones(12,1) u];

y=[35 42 47 53 59 65 68 73 76 82 86 99]';

[b,bint,r,rint,stats]=regress(y,u); b,bint,stats

结果为:

b =

bint =

stats =

+03 *

做残差图:rcoplot(r,rint)

预测及作图:

z=b(1)+b(2)*log(x); plot(x,y,'k+',x,z,'r')

1. 设有五个样品,每个只测量了一个指标,分别是1,2,6,8,11,试用最短距离法将它们分类。

(样品间采用绝对值距离。

)

clc clear

b=[1;2;6;8;11]; d=pdist(b,'cityblock'); D=squareform(d); z=linkage(d); H=dendrogram(z); T=cluster(z,2);

结果:

各样品之间的绝对距离为:[]1,5,7,10,4,6,9,2,5,3d =

距离矩阵01571010469=5

402576203109530D ⎡⎤

⎢⎥⎢

⎥

⎢⎥⎢⎥

⎢⎥⎢⎥⎣⎦

,样品间的最短距离为: 1 2 13 4 25 7 36 8 4z ⎡⎤

⎢⎥⎢

⎥=⎢⎥⎢⎥

⎣

⎦;

2.表1是1999 年中国省、自治区的城市规模结构特征的一些数据,试通过聚类分析将这些省、自治区进行分类。

(表1见下页)

a=[

259

146

];

d1=pdist(a); %欧氏距离:d1=pdist(a);,%b中每行之间距离

z1=linkage(d1) %作谱系聚类图:H= dendrogram(z1)

T=cluster(z1,3) %% 输出分类结果

结果为:

(1)z1 =

(2)输出分类结果:T =

1

3

3

3

3

3

2

3

3

3

3

3

3

3

3

3

3

3

3

3

3

3

3

3

3

3

3

表明,若分三类,3是一类,2是一类,其它的是一类。

(3)做谱系聚类图:

11。