特征选择

- 格式:ppt

- 大小:518.50 KB

- 文档页数:9

几种常用的特征选择方法特征选择是机器学习中非常重要的一个环节,通过选择合适的特征子集,可以提高模型的准确性、降低过拟合的风险,并减少计算成本。

以下是几种常用的特征选择方法:1. 过滤式特征选择(Filter feature selection):过滤式特征选择方法独立于机器学习算法,将特征子集选择作为单独的预处理步骤。

常见的过滤式方法有基于相关性的选择、方差选择和互信息选择等。

- 基于相关性的选择:计算每个特征与目标变量之间的相关性,选取相关性较高的特征。

例如,皮尔逊相关系数可以用于评估线性相关性,而Spearman相关系数可用于评估非线性相关性。

-方差选择:计算特征的方差,并选择方差较高的特征。

方差较高的特征在总体上具有更多的信息。

-互信息选择:计算每个特征与目标变量之间的互信息,选取互信息较高的特征。

互信息是度量两个变量之间相关性的一种方法。

2. 包裹式特征选择(Wrapper feature selection):包裹式方法将特征选择作为机器学习算法的一部分,通过评估模型的性能来选择特征。

常见的包裹式方法有递归特征消除(RFE)和遗传算法等。

-递归特征消除:通过反复训练模型并消除不重要的特征来选择特征。

该方法从所有特征开始,每次迭代都使用模型评估特征的重要性,并剔除最不重要的特征,直到选择指定数量的特征。

-遗传算法:通过模拟生物进化过程,使用交叉和变异操作来最佳的特征子集。

该方法可以通过评估特征子集的适应度来选择特征,适应度一般通过模型的性能进行度量。

3. 嵌入式特征选择(Embedded feature selection):嵌入式方法将特征选择与机器学习算法的训练过程相结合,通过优化算法自动选择特征。

常见的嵌入式方法有L1正则化(L1 regularization)和决策树算法等。

-L1正则化:L1正则化可以使得训练模型的系数稀疏化,从而实现特征选择。

L1正则化会增加模型的稀疏性,使得部分系数为0,从而对应的特征被选择。

特征选择的标准特征选择是机器学习中非常重要的一个步骤,它的目的是从原始数据中选出最具有代表性的特征,以便于构建模型和进行预测。

在特征选择过程中,需要遵循一些标准来评估和选择特征,这些标准主要包括以下内容:1. 相关性相关性是指特征与目标变量之间的关系程度。

在特征选择过程中,需要筛选出与目标变量高度相关的特征,并将其纳入模型中。

可以通过计算皮尔逊相关系数或斯皮尔曼等级相关系数来评估特征与目标变量之间的相关性。

2. 方差方差是指数据分布的离散程度。

在特征选择过程中,需要筛选出方差较大的特征,并将其纳入模型中。

可以通过计算方差来评估各个特征之间的差异性。

3. 互信息互信息是指两个随机变量之间的相互依赖程度。

在特征选择过程中,需要筛选出与目标变量具有较高互信息值的特征,并将其纳入模型中。

可以通过计算互信息来评估各个特征之间的相互依赖程度。

4. 偏差偏差是指模型对数据的拟合程度。

在特征选择过程中,需要筛选出对目标变量具有较小偏差的特征,并将其纳入模型中。

可以通过计算模型的均方误差或平均绝对误差来评估模型的拟合程度。

5. 多重共线性多重共线性是指特征之间存在强相关关系。

在特征选择过程中,需要筛选出与目标变量相关性高、但与其他特征无多重共线性的特征,并将其纳入模型中。

可以通过计算特征之间的相关系数矩阵来评估特征之间是否存在多重共线性。

总之,以上标准都是影响特征选择结果的重要因素。

在实际应用中,需要根据具体情况综合考虑这些标准,并结合领域知识和经验进行选择和调整,以达到最优的特征选择效果。

特征选择的一般过程特征选择是在机器学习和数据挖掘领域中一个非常重要的任务,它的目的是从原始数据中选择出对于目标变量具有较大预测能力的特征,以提高模型的性能和效果。

本文将介绍特征选择的一般过程,以帮助读者了解该领域的基本知识和方法。

一、特征选择的意义在实际的数据分析和建模任务中,我们常常面临大量的特征变量。

然而,并不是所有的特征都对于目标变量的预测有用,有些特征甚至可能对模型的性能产生负面影响。

因此,通过特征选择可以帮助我们从海量的特征中筛选出最为相关和有用的特征,提高模型的准确性和可解释性。

特征选择的一般过程可以分为以下几个步骤:1. 确定特征选择的目标和评价指标:在进行特征选择之前,我们首先需要确定特征选择的目标是什么,是为了提高模型的准确性,还是为了提高模型的解释性。

同时,我们还需要选择合适的评价指标来衡量特征的重要性,常见的评价指标包括信息增益、方差分析、相关系数等。

2. 收集和准备数据:在进行特征选择之前,我们需要收集和准备好用于特征选择的数据。

这包括了数据的清洗、预处理和标准化等步骤,以确保数据的质量和可用性。

3. 特征选择方法的选择:特征选择方法有很多种,包括过滤式方法、包裹式方法和嵌入式方法等。

在选择特征选择方法时,我们需要考虑到数据的特点和问题的需求,选择适合的方法进行特征选择。

4. 特征选择的实施:在进行特征选择时,我们可以采用不同的方法和策略,如单变量特征选择、递归特征消除、基于模型的特征选择等。

具体的实施方法可以根据数据的特点和问题的需求来选择。

5. 特征选择的评估和优化:在进行特征选择之后,我们需要对所选择的特征进行评估和优化。

这包括了对模型的性能进行评估和比较,判断所选择的特征是否能够提高模型的准确性和解释性。

三、特征选择方法的介绍1. 过滤式方法:过滤式方法是一种独立于模型的特征选择方法,它通过对特征和目标变量之间的相关性进行度量,来选择最相关的特征。

常见的过滤式方法包括相关系数、方差分析、卡方检验等。

特征选择与特征抽取的区别与联系在机器学习和数据挖掘领域,特征选择和特征抽取是两个重要的概念。

它们都是为了从原始数据中提取出最有用的特征,以便用于模型训练和预测。

虽然它们有相似之处,但也存在着一些明显的区别和联系。

首先,我们来看一下特征选择。

特征选择是指从原始数据中选择出最具有代表性和相关性的特征,以便用于模型的训练和预测。

在特征选择过程中,我们通常会使用一些评估指标,如信息增益、方差分析等,来衡量每个特征对于目标变量的重要性。

通过评估指标,我们可以排除那些对模型预测没有帮助的特征,从而减少特征空间的维度,提高模型的效果和效率。

与特征选择相比,特征抽取是一种更加综合和高级的特征处理方法。

特征抽取是指将原始数据转换为更具有表达能力和可解释性的特征表示。

在特征抽取过程中,我们通常会使用一些数学和统计方法,如主成分分析(PCA)、线性判别分析(LDA)等,来对原始数据进行降维和变换。

通过特征抽取,我们可以将高维的原始数据转换为低维的特征表示,从而减少数据的冗余和噪声,提高模型的泛化能力和鲁棒性。

特征选择和特征抽取之间存在着一定的联系。

首先,它们都是为了从原始数据中提取出最有用的特征,以便用于模型的训练和预测。

无论是选择还是抽取,都是为了减少特征空间的维度,提高模型的效果和效率。

其次,它们都需要依赖一些评估指标和数学方法来进行特征的筛选和变换。

无论是选择还是抽取,都需要根据具体的问题和数据特点来选择适合的评估指标和方法。

然而,特征选择和特征抽取也存在着一些明显的区别。

首先,特征选择是在原始数据的基础上进行的,而特征抽取是对原始数据进行变换和降维后得到的。

特征选择更加直观和可解释,可以通过分析每个特征与目标变量之间的关系来选择最有用的特征。

特征抽取更加综合和高级,可以通过数学和统计方法来发现数据中的潜在结构和规律。

其次,特征选择通常是针对某个具体的问题和数据集进行的,而特征抽取更加通用和普适,可以适用于各种类型的数据和问题。

常见特征选择方法特征选择是机器学习中非常重要的一步,它能够帮助我们从原始数据中选择出最具有代表性和有用的特征,以提高模型的性能和效果。

在实际应用中,常见的特征选择方法有以下几种:1. Filter方法Filter方法是一种基于特征本身的统计量来进行特征选择的方法。

它通过计算各个特征与目标变量之间的相关性或者相关系数,然后按照一定的规则来选择出具有显著相关性的特征。

常见的统计量包括皮尔逊相关系数、卡方检验、互信息等。

这种方法的优点是计算简单、效率高,但是忽略了特征与特征之间的关系。

2. Wrapper方法Wrapper方法是一种基于模型性能来进行特征选择的方法。

它通过构建不同的特征子集,然后利用机器学习算法训练模型,并评估模型的性能,从而选择出最佳的特征子集。

常见的Wrapper方法有递归特征消除(Recursive Feature Elimination, RFE)、遗传算法等。

这种方法的优点是考虑了特征与特征之间的关系,但是计算复杂度较高,耗时较长。

3. Embedded方法Embedded方法是一种将特征选择与模型训练合并在一起的方法。

它通过在模型训练过程中自动选择特征,从而得到最佳的特征子集。

常见的Embedded方法有L1正则化(L1 Regularization)、决策树算法等。

这种方法的优点是计算简单、效率高,但是需要选择合适的模型和参数。

4. 主成分分析(Principal Component Analysis, PCA)主成分分析是一种常用的无监督学习方法,它通过线性变换将原始特征空间映射到新的低维特征空间,从而达到降维的目的。

在主成分分析中,我们选择的新特征是原始特征的线性组合,使得新特征之间的相关性最小。

通过保留较高的主成分,我们可以保留原始数据中的大部分信息,同时减少特征的维度。

5. 基于信息增益的特征选择信息增益是一种用于衡量特征对分类任务的贡献程度的指标。

它通过计算特征对目标变量的不确定性减少程度来评估特征的重要性。

特征提取和特征选择是机器学习和数据挖掘领域中常用的两个概念。

虽然它们都是为了从原始数据中提取出有用的特征以便进行进一步的分析和建模,但是它们之间有着明显的区别和联系。

首先我们来看看特征提取,特征提取是指从原始数据中提取出一些能够代表数据特征的特征。

这些特征可以是原始数据中的某些属性,也可以是对原始数据进行某种变换得到的新的特征。

特征提取的目的是将原始数据转化为更容易被机器学习算法处理的形式,同时保持数据的最重要的特征。

特征提取的方法有很多种,比如说主成分分析(PCA)、线性判别分析(LDA)、小波变换等。

这些方法可以将高维度的数据降维到低维度,从而减小了数据的复杂度,提高了机器学习的效率。

特征提取的过程可以看成是对数据的一种抽象和概括,它的目的是提取出对于目标任务最有用的信息。

而特征选择则是在特征提取的基础上进行的一个步骤。

特征选择是指从已有的特征中选择出对目标任务最有用的特征。

在特征提取的过程中,可能会产生大量的特征,有些特征可能对于目标任务没有太大的作用,甚至会影响到机器学习算法的性能。

因此需要进行特征选择,选择出对目标任务最有用的特征,去除那些冗余或者无关的特征。

特征选择的方法也有很多种,比如说过滤式特征选择、包裹式特征选择、嵌入式特征选择等。

过滤式特征选择是指通过对特征进行评估,选择出对目标任务最有用的特征,比如说使用相关系数或者信息增益进行特征评估。

包裹式特征选择是指在特征子集上训练出一个机器学习模型,通过模型的性能来评估特征的重要性。

嵌入式特征选择则是指在模型训练的过程中自动选择出对目标任务最有用的特征,比如说使用正则化方法。

特征提取和特征选择在实际应用中经常会同时进行,它们之间有着很大的联系。

特征提取会产生大量的特征,在特征选择的过程中,有时候也需要对特征进行一些变换和组合。

比如说,在包裹式特征选择的过程中,需要对特征子集进行训练,可能需要将特征进行某种组合,而这个过程有点类似于特征提取。

特征选择的常用方法特征选择是机器学习和数据挖掘领域中的一个重要步骤,其目的是从各种特征中选择出对目标变量有最大预测能力的特征子集。

特征选择的主要作用是降低维度、减少计算复杂度、提高模型的解释性和泛化能力。

本文将介绍一些常用的特征选择方法。

一、过滤式方法过滤式方法是特征选择中最简单和最常用的方法之一。

它独立于任何具体的学习算法,通过计算各个特征与目标变量之间的关联度来选择特征。

常用的过滤式方法包括皮尔逊相关系数、互信息和卡方检验等。

1. 皮尔逊相关系数皮尔逊相关系数是衡量两个变量之间线性相关程度的统计量,取值范围为[-1,1]。

当相关系数接近于1时,表示两个变量呈正相关;当相关系数接近于-1时,表示两个变量呈负相关;当相关系数接近于0时,表示两个变量之间没有线性相关关系。

在特征选择中,可以计算每个特征与目标变量之间的相关系数,选取相关系数较大的特征作为最终的特征子集。

2. 互信息互信息是衡量两个随机变量之间信息传递量的统计量,可以用来度量特征与目标变量之间的相关性。

互信息的取值范围为[0,+∞],互信息越大表示两个变量之间的相关性越强。

在特征选择中,可以计算每个特征与目标变量之间的互信息,选取互信息较大的特征作为最终的特征子集。

3. 卡方检验卡方检验是一种统计方法,可以用来检验两个变量之间是否存在显著的关联性。

在特征选择中,可以将特征和目标变量之间的关系建模成一个列联表,然后计算卡方值。

卡方值越大表示特征和目标变量之间的关联性越强,选取卡方值较大的特征作为最终的特征子集。

二、包裹式方法包裹式方法是一种更加复杂和计算量较大的特征选择方法,它直接使用具体的学习算法来评估特征的贡献。

包裹式方法通过搜索特征子集的所有可能组合,并使用具体的学习算法对每个特征子集进行评估和比较。

常用的包裹式方法包括递归特征消除、遗传算法和模拟退火算法等。

1. 递归特征消除递归特征消除是一种基于模型的特征选择方法。

它通过反复训练模型,并在每次训练后消除对模型贡献较小的特征,直到达到指定的特征数目。

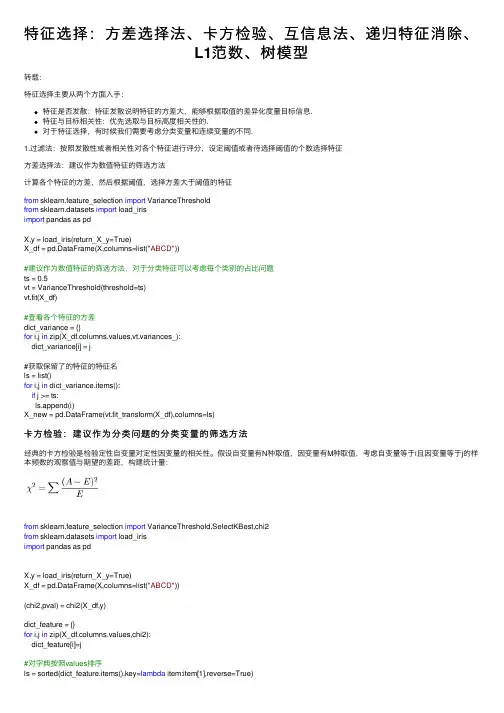

特征选择:⽅差选择法、卡⽅检验、互信息法、递归特征消除、L1范数、树模型转载:特征选择主要从两个⽅⾯⼊⼿:特征是否发散:特征发散说明特征的⽅差⼤,能够根据取值的差异化度量⽬标信息.特征与⽬标相关性:优先选取与⽬标⾼度相关性的.对于特征选择,有时候我们需要考虑分类变量和连续变量的不同.1.过滤法:按照发散性或者相关性对各个特征进⾏评分,设定阈值或者待选择阈值的个数选择特征⽅差选择法:建议作为数值特征的筛选⽅法计算各个特征的⽅差,然后根据阈值,选择⽅差⼤于阈值的特征from sklearn.feature_selection import VarianceThresholdfrom sklearn.datasets import load_irisimport pandas as pdX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))#建议作为数值特征的筛选⽅法,对于分类特征可以考虑每个类别的占⽐问题ts = 0.5vt = VarianceThreshold(threshold=ts)vt.fit(X_df)#查看各个特征的⽅差dict_variance = {}for i,j in zip(X_df.columns.values,vt.variances_):dict_variance[i] = j#获取保留了的特征的特征名ls = list()for i,j in dict_variance.items():if j >= ts:ls.append(i)X_new = pd.DataFrame(vt.fit_transform(X_df),columns=ls)卡⽅检验:建议作为分类问题的分类变量的筛选⽅法经典的卡⽅检验是检验定性⾃变量对定性因变量的相关性。

假设⾃变量有N种取值,因变量有M种取值,考虑⾃变量等于i且因变量等于j的样本频数的观察值与期望的差距,构建统计量:from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))(chi2,pval) = chi2(X_df,y)dict_feature = {}for i,j in zip(X_df.columns.values,chi2):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]互信息法:建议作为分类问题的分类变量的筛选⽅法经典的互信息也是评价定性⾃变量对定性因变量的相关性的,为了处理定量数据,最⼤信息系数法被提出,互信息计算公式如下:from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import mutual_info_classif#⽤于度量特征和离散⽬标的互信息X,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))feature_cat = ["A","D"]discrete_features = []feature = X_df.columns.values.tolist()for k in feature_cat:if k in feature:discrete_features.append(feature.index(k))mu = mutual_info_classif(X_df,y,discrete_features=discrete_features,n_neighbors=3, copy=True, random_state=None)dict_feature = {}for i,j in zip(X_df.columns.values,mu):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import mutual_info_classif,mutual_info_regression#⽤于度量特征和连续⽬标的互信息X,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))feature_cat = ["A","D"]discrete_features = []feature = X_df.columns.values.tolist()for k in feature_cat:if k in feature:discrete_features.append(feature.index(k))mu = mutual_info_regression(X_df,y,discrete_features=discrete_features,n_neighbors=3, copy=True, random_state=None)dict_feature = {}for i,j in zip(X_df.columns.values,mu):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]2.包装法递归特征消除法:⽤⼀个基模型来进⾏多轮训练,每轮训练后,消除若⼲权值系数的特征,再基于新的特征集进⾏下⼀轮训练from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import RFE,RFECVfrom sklearn.ensemble import RandomForestClassifierX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))refCV = RFECV(estimator=RandomForestClassifier(),step=0.5,cv =5,scoring=None,n_jobs=-1)refCV.fit(X_df,y)#保留特征的数量refCV.n_features_#保留特征的False、True标记refCV.support_feature_new = X_df.columns.values[refCV.support_]#交叉验证分数refCV.grid_scores_3.嵌⼊的⽅法基于L1范数:使⽤带惩罚项的基模型,除了筛选出特征外,同时也进⾏了降维from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import SelectFromModelfrom sklearn.linear_model import LogisticRegressionX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))sf = SelectFromModel(estimator=LogisticRegression(penalty="l1", C=0.1),threshold=None,prefit=False,norm_order=1)sf.fit(X_df,y)X_new = X_df[X_df.columns.values[sf.get_support()]]基于树模型的特征选择法:树模型中GBDT也可⽤来作为基模型进⾏特征选择,使⽤feature_selection库的SelectFromModel类结合GBDT模型from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import SelectFromModelfrom sklearn.ensemble import GradientBoostingClassifierX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))sf = SelectFromModel(estimator=GradientBoostingClassifier(),threshold=None,prefit=False,norm_order=1)sf.fit(X_df,y)X_new = X_df[X_df.columns.values[sf.get_support()]]。

数据挖掘中的特征选择和聚类分析数据挖掘是一种利用计算机技术对大量数据进行深入分析和处理的方法。

数据挖掘可以帮助我们从大量数据中发现规律、模式和趋势等信息。

其中,特征选择和聚类分析是数据挖掘中的两个重要步骤。

本文将深入探讨这两个步骤的相关概念、方法和应用。

一、特征选择特征选择是数据挖掘中的一项重要技术。

其目的是从原始数据中选择出最具有代表性和有效性的特征子集,以提高数据挖掘的准确性和效率。

特征选择可以帮助我们减少数据的维度,减少数据处理的时间和成本,还可以帮助我们发现数据中的规律和模式。

下面将介绍特征选择的方法和应用。

1.方法(1)过滤式特征选择:过滤式特征选择是在特征提取之前对所有特征进行筛选,选出与分类或回归任务相关性最高的特征。

常用的方法有相关系数法、卡方检验法、互信息法等。

(2)包裹式特征选择:包裹式特征选择是将特征选择嵌入到分类或回归模型中,通过评估分类或回归结果的精度来选择最佳特征子集。

常用的方法有遗传算法、模拟退火算法、梯度下降法等。

(3)嵌入式特征选择:嵌入式特征选择是将特征选择嵌入到分类或回归算法中,通过自动学习特征的权重和重要性来选择最佳特征子集。

常用的方法有决策树、支持向量机、神经网络等。

2.应用特征选择可以在许多领域中得到广泛应用,例如医学诊断、金融风险管理、文本分类等。

在医学诊断中,可以使用特征选择方法选择最具有代表性和有效性的生物标志物,以提高疾病的诊断准确性和治疗效果。

在金融风险管理中,可以使用特征选择方法选择最具有代表性和有效性的财务指标,以预测市场波动和风险。

在文本分类中,可以使用特征选择方法选择最具有代表性和有效性的单词或短语,以自动判断文本的主题和情感。

二、聚类分析聚类分析是数据挖掘中的一项常用技术。

其目的是将相似的数据点划分到同一类别中,以发现数据的内在结构和特征。

聚类分析可以帮助我们识别数据中的模式、群组和异常值等信息,还可以帮助我们预测未来的趋势和变化。

特征选择方法特征选择是机器学习和数据挖掘中的重要环节,其目的是从原始特征中选择出对目标变量有重要影响的特征,以提高模型的预测性能和降低计算成本。

在实际应用中,特征选择方法的选择对最终模型的性能有着重要的影响。

本文将介绍几种常见的特征选择方法,以帮助读者更好地理解和应用特征选择技术。

1. 过滤式特征选择。

过滤式特征选择是在训练模型之前对特征进行选择,其主要思想是根据特征与目标变量之间的相关性来进行选择。

常用的过滤式特征选择方法包括相关系数、信息增益、卡方检验等。

这些方法通过对特征进行评估,筛选出与目标变量相关性较高的特征,从而达到降低特征维度、提高模型性能的目的。

2. 包裹式特征选择。

包裹式特征选择是在模型训练过程中进行特征选择,其主要思想是将特征选择过程嵌入到模型训练中。

常用的包裹式特征选择方法包括递归特征消除、基于模型的特征选择等。

这些方法通过反复训练模型并调整特征集合,最终选择出对模型性能影响最大的特征组合。

3. 嵌入式特征选择。

嵌入式特征选择是在模型训练过程中自动地进行特征选择,其主要思想是将特征选择过程融入到模型参数的学习过程中。

常用的嵌入式特征选择方法包括L1正则化、决策树剪枝等。

这些方法通过在模型训练过程中对特征进行惩罚或剪枝,从而实现特征选择的目的。

4. 混合式特征选择。

混合式特征选择是将多种特征选择方法进行组合,以充分利用各种方法的优势。

常用的混合式特征选择方法包括特征重要性评估、特征组合搜索等。

这些方法通过综合考虑不同特征选择方法的结果,选择出对模型性能影响最大的特征集合。

在实际应用中,特征选择方法的选择应根据具体问题的特点和数据的特征来进行。

需要注意的是,特征选择过程应该是一个迭代的过程,需要不断地尝试不同的方法和参数,以找到最优的特征集合。

另外,特征选择方法的选择也需要考虑到模型的类型和性能指标,以确保选择出的特征集合能够在实际应用中发挥最大的作用。

总之,特征选择是机器学习和数据挖掘中至关重要的一环,其选择方法的合理性和有效性直接影响着最终模型的性能。

特征选择的常用方法特征选择是机器学习和数据挖掘中的一个重要步骤,它的目的是从原始数据中选择出最具有代表性和相关性的特征,以提高模型的性能和效果。

特征选择方法有很多种,本文将介绍其中一些常用的方法。

一、过滤式方法过滤式方法是指在特征选择和模型训练之前就进行特征选择的方法。

它通过计算特征与目标变量之间的相关性或其他统计指标,来评估特征的重要性,并选择出相关性较高的特征。

常用的过滤式方法有相关系数法、卡方检验法、互信息法等。

1. 相关系数法相关系数法是通过计算特征与目标变量之间的相关系数来评估特征的重要性。

相关系数的取值范围在-1到1之间,绝对值越接近1表示相关性越强。

可以根据相关系数的大小来选择相关性较高的特征。

2. 卡方检验法卡方检验法是一种统计方法,用于检验两个变量之间的独立性。

在特征选择中,可以将特征与目标变量之间的独立性作为评估指标,计算卡方值来选择特征。

卡方值越大表示特征与目标变量之间的独立性越低,特征的重要性越高。

3. 互信息法互信息法是一种衡量两个随机变量之间的相关性的方法。

在特征选择中,可以将特征与目标变量之间的互信息作为评估指标,来选择特征。

互信息的取值范围在0到正无穷之间,取值越大表示特征与目标变量之间的相关性越高,特征的重要性越高。

二、包裹式方法包裹式方法是指将特征选择作为一个子问题嵌入到模型训练过程中的方法。

它通过构建不同的特征子集,并评估模型在不同特征子集上的性能,来选择出最佳的特征子集。

常用的包裹式方法有递归特征消除法、遗传算法等。

1. 递归特征消除法递归特征消除法是一种自底向上的特征选择方法。

它通过不断地构建模型并剔除权重较小的特征,来选择出最佳的特征子集。

递归特征消除法可以根据模型的性能评估来选择特征,如准确率、均方误差等。

2. 遗传算法遗传算法是一种模拟自然选择和遗传机制的优化算法。

在特征选择中,可以将特征子集看作个体,通过遗传算法的选择、交叉和变异等操作,来搜索最佳的特征子集。

特征选择方法特征选择是机器学习和数据挖掘中非常重要的一步,它可以帮助我们从大量的特征中选择出对于问题解决有用的特征,从而提高模型的性能和效率。

在实际应用中,特征选择方法有很多种,包括过滤式、包裹式和嵌入式等。

本文将介绍几种常用的特征选择方法,帮助大家更好地理解和应用特征选择。

1. 过滤式特征选择。

过滤式特征选择是在特征选择和学习器训练之前进行的,它通过对特征进行评估和排序,然后选择出排名靠前的特征作为最终的特征集合。

常用的评估指标包括信息增益、方差分析、相关系数等。

过滤式特征选择的优点是计算简单,速度快,但缺点是没有考虑到学习器的性能,可能会选择出对学习任务无用的特征。

2. 包裹式特征选择。

包裹式特征选择是将特征选择过程嵌入到学习器的训练过程中,它直接使用学习器的性能作为特征选择的评价标准,从而能够更准确地选择出对学习任务有用的特征。

常用的方法包括递归特征消除、基于模型的特征选择等。

包裹式特征选择的优点是能够充分考虑学习器的性能,但缺点是计算复杂,速度较慢。

3. 嵌入式特征选择。

嵌入式特征选择是将特征选择过程嵌入到学习器的训练过程中,它通过正则化方法或者模型参数的学习来选择出对学习任务有用的特征。

常用的方法包括L1正则化、决策树剪枝等。

嵌入式特征选择的优点是能够充分考虑学习器的性能,计算相对较快,但缺点是可能会受到学习器类型的限制。

在实际应用中,选择合适的特征选择方法非常重要,需要根据具体的问题和数据集来进行选择。

有时候也可以结合多种特征选择方法来进行特征选择,以达到更好的效果。

另外,特征选择并不是一劳永逸的过程,随着数据的变化和问题的演化,特征选择也需要不断地进行调整和优化。

总结而言,特征选择是机器学习和数据挖掘中非常重要的一步,它可以帮助我们提高模型的性能和效率。

常用的特征选择方法包括过滤式、包裹式和嵌入式特征选择,每种方法都有其优点和局限性,需要根据具体情况进行选择和调整。

希望本文介绍的内容能够帮助大家更好地理解和应用特征选择方法,提高数据分析和建模的能力。

数据分析中的特征选择方法在数据分析领域,特征选择是一项重要的任务,它帮助我们从大量的特征中选择出最相关和最具有预测能力的特征,以提高模型的性能和解释能力。

特征选择方法可以帮助我们减少特征空间的维度,降低模型的复杂性,并且提高模型的泛化能力。

本文将介绍几种常见的特征选择方法。

一、过滤法过滤法是一种基于统计量的特征选择方法,它通过计算特征与目标变量之间的相关性来评估特征的重要性。

常见的过滤法包括相关系数法、卡方检验法和互信息法。

相关系数法是通过计算特征与目标变量之间的相关系数来评估特征的相关性。

相关系数的取值范围为[-1,1],绝对值越大表示相关性越强。

一般来说,相关系数大于0.5或小于-0.5的特征可以认为与目标变量具有较强的相关性。

卡方检验法适用于特征与目标变量都是离散型变量的情况。

它通过计算特征与目标变量之间的卡方统计量来评估特征的相关性。

卡方统计量的取值范围为[0,正无穷),值越大表示特征与目标变量之间的相关性越强。

互信息法适用于特征与目标变量都是离散型变量或者特征是连续型变量而目标变量是离散型变量的情况。

它通过计算特征与目标变量之间的互信息来评估特征的相关性。

互信息的取值范围为[0,正无穷),值越大表示特征与目标变量之间的相关性越强。

二、包裹法包裹法是一种基于搜索算法的特征选择方法,它将特征选择问题转化为一个优化问题,通过搜索算法来寻找最优的特征子集。

常见的包裹法包括递归特征消除法和遗传算法。

递归特征消除法是一种自底向上的特征选择方法,它从所有特征开始,每次迭代去掉一个最不重要的特征,直到达到指定的特征数目或者模型性能不再提升为止。

递归特征消除法可以基于模型的系数、特征的重要性或者模型的预测误差等进行特征选择。

遗传算法是一种模拟自然界进化过程的优化算法,它通过选择、交叉和变异等操作来搜索最优的特征子集。

遗传算法可以在大规模特征空间中寻找最优的特征组合,但是计算复杂度较高。

三、嵌入法嵌入法是一种将特征选择与模型训练过程结合起来的特征选择方法,它通过在模型训练过程中评估特征的重要性来选择特征。

特征选择方法特征选择在机器学习和数据挖掘中起着至关重要的作用。

它是指从所有特征中选择出最相关和最有代表性的特征,以提高模型的性能和减少计算成本。

在实际应用中,特征选择方法的选择对模型的性能和效果有着直接的影响。

本文将介绍几种常见的特征选择方法,并对它们进行简要的比较和分析。

1. 过滤式特征选择方法。

过滤式特征选择方法是在训练模型之前就对特征进行选择的方法。

它的主要思想是通过对特征进行评估和排序,然后选择出排名靠前的特征作为最终的特征集合。

常见的过滤式特征选择方法包括方差选择法、相关系数法和互信息法等。

这些方法的优点是简单高效,计算成本低,但缺点是忽略了特征之间的关联性,可能选择出冗余特征。

2. 包裹式特征选择方法。

包裹式特征选择方法是直接以模型性能为评价标准进行特征选择的方法。

它的主要思想是通过构建不同的特征子集,然后使用模型评估每个子集的性能,选择出性能最好的特征子集作为最终的特征集合。

常见的包裹式特征选择方法包括递归特征消除法、基于模型的特征选择法和遗传算法等。

这些方法的优点是考虑了特征之间的关联性,但缺点是计算成本高,需要大量的计算资源。

3. 嵌入式特征选择方法。

嵌入式特征选择方法是将特征选择过程与模型训练过程相结合的方法。

它的主要思想是通过在模型训练过程中对特征进行选择,以提高模型的性能。

常见的嵌入式特征选择方法包括L1正则化、决策树特征选择和基于树的特征选择法等。

这些方法的优点是能够充分利用模型的性能指标进行特征选择,但缺点是对模型的要求较高,可能导致模型性能不稳定。

综上所述,特征选择是机器学习和数据挖掘中不可或缺的一部分。

不同的特征选择方法有着各自的优缺点,需要根据具体的应用场景和需求进行选择。

在实际应用中,可以根据数据的特点和模型的要求,选择合适的特征选择方法,以提高模型的性能和效果。

希望本文介绍的内容能够对读者有所帮助,谢谢阅读!。

特征选择常用算法综述一.什么是特征选择(Featureselection )特征选择也叫特征子集选择 ( FSS , Feature SubsetSelection ) 。

是指从已有的M个特征(Feature)中选择N个特征使得系统的特定指标最优化。

需要区分特征选择与特征提取。

特征提取 ( Feature extraction )是指利用已有的特征计算出一个抽象程度更高的特征集,也指计算得到某个特征的算法。

特征提取与特征选择都能降低特征集的维度。

评价函数 ( Objective Function ),用于评价一个特征子集的好坏的指标。

这里用符号J ( Y )来表示评价函数,其中Y是一个特征集,J( Y )越大表示特征集Y 越好。

评价函数根据其实现原理又分为2类,所谓的Filter和Wrapper 。

Filter(筛选器):通过分析特征子集内部的信息来衡量特征子集的好坏,比如特征间相互依赖的程度等。

Filter实质上属于一种无导师学习算法。

Wrapper(封装器):这类评价函数是一个分类器,采用特定特征子集对样本集进行分类,根据分类的结果来衡量该特征子集的好坏。

Wrapper实质上是一种有导师学习算法。

二.为什么要进行特征选择?获取某些特征所需的计算量可能很大,因此倾向于选择较小的特征集特征间的相关性,比如特征A完全依赖于特征B,如果我们已经将特征B选入特征集,那么特征A 是否还有必要选入特征集?我认为是不必的。

特征集越大,分类器就越复杂,其后果就是推广能力(generalization capability)下降。

选择较小的特征集会降低复杂度,可能会提高系统的推广能力。

Less is More !三.特征选择算法分类精确的解决特征子集选择问题是一个指数级的问题。

常见特征选择算法可以归为下面3类:第一类:指数算法 ( Exponential algorithms )这类算法对特征空间进行穷举搜索(当然也会采用剪枝等优化),搜索出来的特征集对于样本集是最优的。

几种常用的特征选择方法特征选择在机器学习和数据挖掘领域中起着至关重要的作用,它用于从原始特征集中选择最具有预测能力和解释性的特征子集,以提高模型的性能和可解释性。

以下是几种常用的特征选择方法:1. 过滤法(Filter Method):过滤法通过计算特征与输出变量之间的相关性来进行特征选择。

常用的过滤法包括:-方差选择:选择方差较大的特征,即那些在输入变量间有较大变化的特征。

这种方法对于连续特征更为常见。

-互信息:衡量特征与输出变量之间的统计依赖关系。

该方法适用于连续和离散特征。

-相关系数:计算特征与输出变量之间的线性相关性。

较高的相关性意味着该特征对于预测输出变量很重要。

2. 包装法(Wrapper Method):包装法通过特定的机器学习算法来评估特征子集的性能。

常用的包装法有:- 递归特征消除(Recursive Feature Elimination, RFE):根据模型的权重或系数评估每个特征的重要性,并逐步消除最不重要的特征。

-基于遗传算法的特征选择:利用遗传算法最优的特征子集,其中每个特征子集被看作候选解,并通过适应度函数评估性能。

3. 嵌入法(Embedded Method):嵌入法将特征选择过程融入到机器学习的训练过程中,即特征选择和模型训练同时进行。

常见的嵌入法有:- 正则化方法:如L1正则化(Lasso)和L2正则化(Ridge)等,它们对模型的权重进行限制,从而过滤掉一些对输出变量没有贡献的特征。

-决策树:根据决策树的分裂规则和信息增益,选择最佳的划分特征。

这种方法可以从特征空间中选择相对较优的子集。

4. 混合方法(Hybrid Method):混合方法将多种特征选择方法结合起来,以达到更好的特征子集选择效果。

常见的混合方法有:-机器学习算法嵌入特征选择:在训练机器学习模型时,同时使用特征选择算法来选择特征子集。

-基于遗传算法的特征选择和过滤法的结合:使用遗传算法特征子集,并通过过滤法进行进一步筛选。