情感语音识别论文:情感语音识别谱能量特征人耳听觉特性支持向量机Teager能量算子

- 格式:doc

- 大小:111.50 KB

- 文档页数:7

《情感语音识别与合成的研究》篇一一、引言随着人工智能技术的发展,情感语音识别与合成逐渐成为人们关注的焦点。

情感语音识别与合成是自然语言处理(NLP)的重要领域,通过这些技术可以使得计算机和机器人更自然地理解和表达人类情感。

本文旨在探讨情感语音识别与合成的研究现状、应用领域以及未来发展趋势。

二、情感语音识别的研究情感语音识别是指通过计算机和机器学习技术分析语音中的情感信息,将声音转换为情感的标记和标签,实现识别人类情绪的目标。

这项技术的关键在于理解人的情绪特征以及如何从声音中提取这些特征。

2.1 情感语音识别的基本原理情感语音识别的基本原理是通过音频信号处理和机器学习算法对语音进行情感分析。

在音频信号处理阶段,提取出声音中的各种特征,如语调、音量、节奏等;在机器学习算法阶段,使用各种算法对这些特征进行训练,识别出不同情绪的特征和规律。

2.2 情感语音识别的研究进展近年来,随着深度学习技术的兴起,情感语音识别的准确率得到了显著提高。

例如,利用卷积神经网络(CNN)和循环神经网络(RNN)等技术对音频信号进行深度学习和特征提取,可以更准确地识别出不同情绪的语音。

此外,多模态情感识别技术也得到了广泛关注,通过融合声音、文字、表情等多种信息进行综合分析,提高情绪识别的准确率。

三、情感语音合成的研究情感语音合成是使计算机能够根据特定情感或语境生成自然语言语音的技术。

该技术可以实现与用户更自然地交流,提升人机交互的体验。

3.1 情感语音合成的基本原理情感语音合成的基本原理是将预定义的情感特征作为参考信号,生成相应情感的语调、音调、节奏等,从而实现模拟人类的情绪表达。

通常需要建立情绪参数的数学模型,然后将这些参数映射到特定的声波生成器中。

3.2 情感语音合成的技术进展近年来,深度学习和声学模型等技术在情感语音合成中得到了广泛应用。

例如,利用深度神经网络(DNN)和生成对抗网络(GAN)等技术,可以实现更加自然和逼真的声音表达。

the Application of Computer Technology •计算机技术应用Electronic Technology & Software Engineering 电子技术与软件工程• 135●基金项目:2017年甘肃省高等学校科研项目,编号:2017A-165。

【关键词】人工智能 支持向量机 语音情感 语音识别1 前言语音是人类进行高效复杂信息交换的最重要通道,语音情感识别是人工智能技术的核心领域之一。

情感语音当中可以提取多种声学特征,用以反映说话人的心理情感特征行为等特点。

然而在过去几十年里,如何高效地从语音信号中的识别情感特征已成为研究热点话题。

语音信号中的情感信息处理因为涉及到不同语种之间的差异,发展也不尽相同。

英语、德语等语种的语音情感分析处理都有较多的研究,而汉语语音的情感分析处理研究起步较晚。

情感信息有一个重要的心理特点就是文化依赖性,各国各民族各地区文化习惯不同,表达信息的方式也会不同。

所以,本文笔者在前人研究的基础上,利用MATLAB 编程,开展了模拟仿真训练识别语音情感信息的研究,将对在日常教学中提高学生实践能力起到一定的推动作用。

2 支持向量机应用于语音情感识别支持向量机是由Vapnik 等人提出的一种机器学习的算法,它是建立在统计学习理论和结构风险最小化的基础之上。

大量研究表明,支持向量机算法是一种非常有效的学习方法,它能够在高维特征空间得到优化的泛化界的超平面,能够使用核动技术从而避免局部最小,通过间隔和限制支持向量的个数控制容量来防止过拟合。

支持向量机在语音情感识别中存在天然的工作优势,适合于小样本数据的训练。

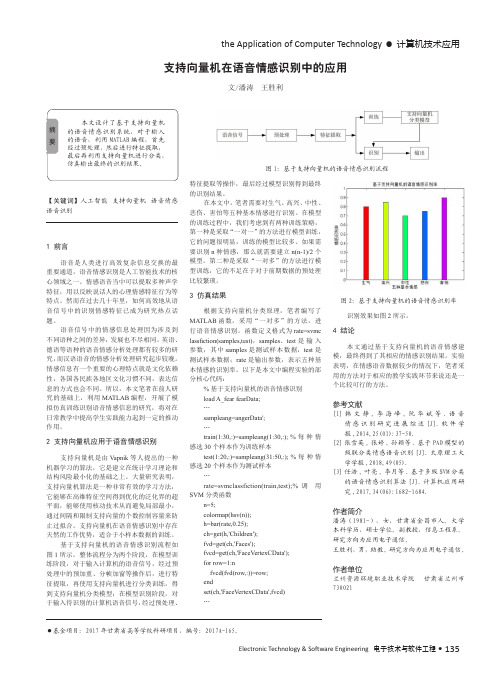

基于支持向量机的语音情感识别流程如图1所示。

整体流程分为两个阶段,在模型训练阶段,对于输入计算机的语音信号,经过预处理中的预加重、分帧加窗等操作后,进行特征提取,再使用支持向量机进行分类训练,得到支持向量机分类模型;在模型识别阶段,对于输入待识别的计算机语音信号,经过预处理、支持向量机在语音情感识别中的应用文/潘涛 王胜利本文设计了基于支持向量机的语音情感识别系统,对于输入的语音,利用MATLAB 编程,首先经过预处理,然后进行特征提取,最后再利用支持向量机进行分类,仿真输出最终的识别结果。

基于深度学习的语音情感识别研究基于深度学习的语音情感识别研究摘要语音情感识别是一个重要的研究领域,可以在人机交互、心理健康评估等领域发挥重要作用。

近年来,深度学习在语音情感识别中取得了显著的成果。

本论文通过对深度学习在语音情感识别中的应用研究进行综述,并从数据预处理、特征提取、模型构建等方面分析了相关技术的优势和不足。

在研究中,我们还探讨了未来深度学习在语音情感识别领域的发展方向,并对现有技术的挑战和改进提出了建议。

关键词:深度学习、语音情感识别、数据预处理、特征提取、模型构建引言随着人工智能技术的快速发展,人机交互的需求逐渐增加。

语音情感识别作为一种重要的人机交互方式,可以帮助机器了解人类的情感状态,进而提供更加个性化、适应性的服务。

从识别语音中的情感状态,可以推测人们的情绪、心理状态,并据此作出智能决策。

因此,语音情感识别在社交、心理健康评估、情感状态监控等领域具有广阔的应用前景。

传统的语音情感识别方法主要基于机器学习的算法,如支持向量机(SVM)、高斯混合模型(GMM)等。

这些传统方法在一定程度上能够实现有效的情感识别,但其对语音特征的提取和建模能力有一定局限性。

近年来,深度学习作为一种强大的机器学习方法,已经取得了在语音情感识别中的显著成果。

深度学习通过构建多层神经网络,能够更好地模拟人脑的工作机制,从而提高语音情感识别的准确率和稳定性。

本文将综述深度学习在语音情感识别中的研究进展,并分析现有技术在数据预处理、特征提取、模型构建等方面的优势和不足。

在综述的基础上,我们还将讨论未来深度学习在语音情感识别领域的发展方向,并提出改进和挑战的建议。

一、数据预处理语音情感识别的数据预处理是建立准确模型的关键步骤。

在实际应用中,语音数据可能存在噪音、失真、背景干扰等问题,这些问题会影响到情感识别的性能。

因此,在进行深度学习之前,需要对语音数据进行预处理,以提取有效的特征信息。

数据预处理的主要方法包括去噪、特征提取和数据增强。

基于机器学习的语音情感识别技术研究与实现在过去的几年中,语音情感识别技术通过使用机器学习方法取得了显著的进展。

该技术可以识别和分析人类语音中的情感状态,从而使计算机系统能够更好地理解和与人类进行交流。

语音情感识别技术在许多领域中具有广泛的应用前景,例如智能客服、情感分析、健康监测等。

在这些应用中,了解用户的情感状态对于提供更好的用户体验和满足用户需求至关重要。

为了实现基于机器学习的语音情感识别技术,我们需要采取以下步骤:第一步是数据采集。

为了训练和评估机器学习模型,我们需要收集具有不同情感状态的语音样本。

这些样本可以来自于各种来源,例如自然语音、电话录音、演讲等。

我们需要确保样本集具有多样性和代表性,以便更好地捕捉各种情感状态。

第二步是特征提取。

在语音情感识别中,我们需要从语音样本中提取有用的特征来描述情感状态。

常用的特征包括声音的频率、能量、音调等。

此外,还可以使用机器学习技术来提取更高级的特征,例如使用深度神经网络提取语音的潜在表示。

特征提取是非常关键的步骤,它直接影响后续模型的训练和识别性能。

第三步是模型训练。

在这一步中,我们使用已经标记情感状态的语音样本来训练机器学习模型。

常用的机器学习算法包括支持向量机、决策树、随机森林等。

此外,由于语音数据具有时间序列的特点,循环神经网络(RNN)和卷积神经网络(CNN)也被广泛应用于语音情感识别中。

通过不断调整和优化模型参数,我们可以提高模型的性能和准确度。

第四步是模型评估。

为了判断模型的性能和鲁棒性,我们需要对其进行评估。

通常用于评估模型的指标包括准确度、召回率、精确度等。

此外,对模型进行交叉验证和测试集验证也是一种常见的评估方法。

通过评估模型的性能,我们可以对其进行进一步的改进和调优。

基于机器学习的语音情感识别技术在实际应用中取得了良好的效果。

例如,通过分析电话录音中的情感状态,可以提供更好的客户服务和市场调研。

通过监测特定人群的语音情感状态,可以提早发现和处理心理健康问题。

基于MFCC和ZCPA的语音情感识别摘要随着计算机技术的不断发展,人们对计算机的要求越来越高,逐渐要求计算机具有人工智能,而语音情感识别是人工智能领域的研究热点。

语音情感识别包括语音信号预处理、语音情感特征提取和语音情感识别分类器等。

本文使用太原理工大学录制的情感语音库,该数据库包含高兴、生气和中性三种情感,本文采用的情感语音库中的600句情感语音,文中对情感语音进行了预处理,包括抗混叠滤波、预加重、加窗以及端点检测等,并对高兴、生气和中性三种语音情感提取MFCC和ZCPA特征,使用支持向量机对语音的三种情感进行识别,实验结果表明,MFCC和ZCPA特征均取得了较好的识别效果。

关键字:语音情感识别,MFCC,ZCPA,支持向量机Speech Emotion Recognition Based on MFCC and ZCPAABSTRACTWith the development of computer technology, people’s requirements of computer are higher and higher, and artificial intelligence is gradually important for computers. Speech emotion recognition is one of the hotspots in the field of artificial intelligence. The speech emotion recognition consists of speech signal pretreatment, feature extraction and speech emotion recognition classifier, etc. This paper used the emotional speech database recorded by the Taiyuan University of Technology, which contains happiness, anger and neutra. In this paper, we use 600 emotion sentences from emotional speech database. Firstly, this paper pretreated emotion sentences, including aliasing filter, the pre-emphasis, adding window and endpoint detection, etc. This paper extracted MFCC and ZCPA features from three emotions, and recognized by support vector machine (SVM), the experimental results show that MFCC and ZCPA features can get better recognition rate.Key words:speech emotion recognition; MFCC; ZCPA; SVM;目录摘要 (i)ABSTRACT (ii)第一章绪论 (5)1.1语音情感识别概述 (5)1.1.1引言 (5)1.1.2语音识别的发展过程及其现状 (5)1.1.3语音情感识别中面临的问题和困难 (7)1.2.论文研究的主要内容以及章节安排 (7)第二章语音情感识别原理和技术 (8)2.1综述 (8)2.2.预处理 (8)2.2.1语音情感信号的预加重处理 (8)2.2.2语音情感信号的加窗处理 (10)2.2.3短时平均能量 (12)2.2.4短时平均过零率 (13)2.2.5语音情感信号的端点检测 (15)2.3语音情感特征的提取 (16)2.3.1美尔频率倒谱系数(MFCC) (16)2.3.2过零率与峰值幅度(ZCPA) (18)2.4 本章小结 (19)第三章语音情感及语音情感库 (20)3.1语音情感 (20)3.1.1语音情感的分类 (20)3.1.2情感语句的选择 (21)3.1.3国际情感数据库 (21)3.2语音情感数据库 (22)3.3本章小结 (23)第四章语音情感识别分类器 (24)4.1语音情感识别技术基本原理 (24)4.2语音情感识别的方法 (24)4.3支持向量机 (25)4.3.1支持向量机发展历史 (25)4.3.2支持向量机的理论基础 (25)4.3.3最大间隔分类超平面 (26)4.3.4支持向量机的原理 (27)4.3.5支持向量机的核函数 (29)4.4 两种特征参数的语音情感识别实验 (30)4.4.1 情感语句的两种特征参数识别实验 (30)4.4.2 实验分析和结论 (31)4.5 本章小结 (32)参考文献 (33)致谢 (35)附录一:外文翻译 (36)附录二:外文文献翻译 (45)附录三:程序 (52)第一章绪论1.1语音情感识别概述1.1.1引言随着信息技术的高速发展以及人类对计算机的依赖性不断加强,人机交互(HCI)的深度和能力受到了越来越多研究者的青睐,计算机与人类的交流的语言有各种各样,其中包括各类的低级语言和高级语言。

《情感语音识别与合成的研究》篇一一、引言情感语音识别与合成技术是人工智能领域中一个重要的研究方向,其应用场景广泛,包括智能语音助手、智能家居、医疗保健、自动驾驶等领域。

情感语音识别与合成技术的研究对于提高人机交互的自然性和智能性具有重要意义。

本文旨在探讨情感语音识别与合成的研究现状、方法及未来发展趋势。

二、情感语音识别的研究1. 研究现状情感语音识别是指通过对语音信号的处理和分析,识别出说话人的情感状态。

目前,情感语音识别的研究已经取得了一定的进展,但是仍然存在许多挑战。

例如,情感的多样性和复杂性、语音信号的噪声干扰、不同语言和文化背景的差异等问题。

2. 研究方法情感语音识别的研究方法主要包括基于规则的方法、基于统计的方法和基于深度学习的方法。

基于规则的方法是通过制定一定的规则和模板来识别情感,但是其准确性和鲁棒性有待提高。

基于统计的方法则是利用统计学原理来提取语音信号中的特征,然后利用分类器进行情感分类。

基于深度学习的方法则是利用神经网络等算法对语音信号进行深度学习和特征提取,从而实现情感识别。

三、情感语音合成的研究1. 研究现状情感语音合成是指根据说话人的情感状态合成出具有相应情感的语音信号。

随着人工智能技术的发展,情感语音合成技术已经得到了广泛的应用。

目前,情感语音合成技术主要应用于智能语音助手、虚拟人物等领域。

2. 研究方法情感语音合成的研究方法主要包括基于规则的方法和基于深度学习的方法。

基于规则的方法是通过制定一定的规则和模板来生成具有特定情感的语音信号。

基于深度学习的方法则是利用神经网络等算法对情感特征进行学习和建模,然后生成具有相应情感的语音信号。

其中,基于端到端的深度学习模型已经成为当前研究的热点。

四、情感语音识别与合成的应用场景情感语音识别与合成技术的应用场景非常广泛,包括智能语音助手、智能家居、医疗保健、自动驾驶等领域。

在智能语音助手中,情感语音识别可以更好地理解用户的情感状态,从而提供更加智能化的服务;在智能家居中,情感语音合成技术可以用于智能家居系统的交互式对话中;在医疗保健中,通过分析患者的情感状态,可以帮助医生更好地了解患者的病情和需求;在自动驾驶中,情感语音识别与合成技术可以用于车辆与驾驶员之间的交互,提高驾驶的安全性和舒适性。

基于支持向量机的语音情感分类算法研究语音情感分类算法是人工智能技术应用最为广泛的领域之一,是自然语言处理技术的重要应用。

其中的支持向量机算法是一种在非线性数据集中表现优越的机器学习方法,已经在语音情感识别中有重要的应用。

语音情感分类的目的是根据说话者在语音中表现出的情感特征将语音分类为不同的情感类别,例如愉快、悲伤、愤怒等。

基于支持向量机的语音情感分类算法可以根据语音的声母、韵母、音调、语速、语音长度等特征进行分类,达到高精准度的识别效果。

支持向量机算法是一种非常适合处理高维度数据的机器学习方法,它可以有效地将高维数据映射到低维度的空间中进行分类。

在语音情感分类中,支持向量机算法可以通过训练样本对声音的频谱进行分析,形成一种基于频率和幅度的特征向量,再将该特征向量输入到支持向量机分类器中,最终得到情感分类结果。

在进行语音情感分类时,数据预处理是非常重要的一步。

由于语音信号的特点,需要预处理和标准化语音数据,将信号转换为数字表示,降低噪声的干扰,并且进行数据归一化等操作,以便支持向量机算法更好地处理语音信号。

同时,要准确地识别出语音的情感类别,需要大量的训练样本以及准确的情感分类标签,从而保证分类器的可靠性。

除了数据预处理外,选择合适的特征向量也是一项关键工作,常见的特征向量有MFCC(Mel频率倒谱系数)和LPCC(线性预测倒谱系数)等。

MFCC特征是一种常用的语音特征提取方法,其主要思想是通过模拟人耳的感受,将语音信号从时域转换到频域,并对所得到的频谱进行离散余弦变换,从而提取出最重要的语音特征。

而LPCC特征则是一种基于线性预测模型的特征提取方法,主要通过对语音信号的自回归分解,提取出语音信号的谐波频率及其振幅和相位。

总之,基于支持向量机的语音情感分类算法是一种非常值得研究的方法,可以有效地从语音信号中提取情感信息,实现情感分类的自动化处理。

在未来的应用中,该算法有望在人机交互、语音识别等领域得到更加广泛的应用,从而进一步推动人工智能技术的发展。

《情感语音识别与合成的研究》篇一一、引言随着人工智能技术的发展,情感语音识别与合成已成为近年来的研究热点。

情感语音识别能够分析出语音中蕴含的情感信息,而情感语音合成则能够生成具有情感色彩的语音。

这两项技术广泛应用于智能机器人、智能家居、虚拟助手、游戏、影视制作等领域。

本文将针对情感语音识别与合成技术的研究进行详细的阐述,为读者呈现当前研究的发展状况、相关方法和技术进展,并探讨未来的发展方向和潜在的应用场景。

二、情感语音识别的研究1. 研究现状情感语音识别主要利用计算机算法来分析和提取语音中的情感信息。

在近几年的研究中,国内外学者通过深度学习、机器学习等技术手段,取得了显著的成果。

其中,基于神经网络的情感语音识别方法已经成为主流。

这种方法通过大量数据训练模型,使得模型能够从语音中提取出丰富的情感特征,并准确判断出语音所表达的情感。

2. 关键技术与方法情感语音识别的关键在于提取语音中的情感特征。

在特征提取过程中,主要使用的方法包括频谱分析、音素分析和声学特征等。

其中,基于神经网络的特征提取方法尤为常用。

该方法可以通过大量的训练数据学习到有效的情感特征,提高识别的准确性。

此外,对于复杂情感的识别,往往需要结合多种特征提取方法,以提高识别的准确性和鲁棒性。

三、情感语音合成的研究1. 研究现状情感语音合成是指生成具有特定情感的语音。

近年来,随着深度学习和声学模型的发展,情感语音合成技术取得了显著的进步。

通过训练大量的数据,使得生成的语音更加自然、逼真,具有更强的感染力。

2. 关键技术与方法情感语音合成的关键在于生成具有情感的声波信号。

目前主要的方法包括基于规则的合成方法和基于深度学习的合成方法。

其中,基于深度学习的合成方法通过训练大量的数据来学习人类的发音规律和语音特征,从而生成具有情感的语音。

此外,为了使生成的语音更加逼真,还需要结合声学模型和语音信号处理技术。

四、技术进展与挑战随着研究的深入,情感语音识别与合成技术取得了显著的进展。

摘要情感语音识别是人机交流的重要组成部分,人的语音不仅仅包含内容信息,还包含情感信息,情感语音识别是当前人工智能的重点研究方向,人的情感识别具有非常重要的现实意义。

当前,在情感语音识别研究中,存在数据库获取难,模型结构、情感语音特征标准不统一,识别算法还不够精准四个问题,本文通过研究情感语音特征提取,特征学习,特征分类算法,利用深度神经网络与多级分类算法进行了深入的情感语音识别实验,主要研究工作内容:1.搭建了情感语音数据库,预处理然后提取了情感语音数据的特征。

情感语音预处理包括端点检测,分帧,加窗,预加重。

本文提取了情感语音的韵律特征,声音音质特征和频谱特征,包括能量,过零率,12阶MFCC,基频,谐波噪声比,并提取了其12个统计特征,包括最大值,均值,线性斜率等,总共提取了384维统计特征,并研究对比了不同情感特征分类能力的不同。

2.提出了基于深度神经网络的情感语音(DBN-DNN Feature,DDF)特征学习的改进算法。

通过SVM证明了改进的DDF特征学习算法的有效性。

对常用4种情感语音特征提取与分类算法进行了实验研究与仿真分析,包括支持向量机(SVM),人工神经网络(ANN),主成分分析(PCA),深度置信网络(DBN)。

研究了DBN与PCA在特征降维上的优劣。

考虑到DBN是一种无监督训练,本文通过结合DBN与softmax分类器,引入标签信息进行有监督的训练,进一步提炼出情感语音特征,实验表明,DDF在情感语音识别上有优异的性能。

3.提出了基于深度神经网络的多级分类算法。

首先研究传统分类算法的不足,然后通过引入困惑度,构建多级分类器,对每一级分类器调优,得到了比传统一次分类更好的识别率。

实验对比了PCA-SVM多级分类器与PCA-SVM一次分类,DDF-SVM多级分类与DDF-SVM一次分类,分类效果均得到提升,且基于DDF-SVM的多级分类算法比基于PCA-SVM的多级分类算法的识别率也有提升,证明了DDF-SVM多级分类的优异性能。

EMD结合Teager能量用于语音情感识别张卫;张雪英;孙颖【摘要】在语音情感识别系统中,语音情感特征的提取尤为重要.在前期已有对EMD分解研究的基础上,将EMD分解与Teager能量算子相结合,用于语音情感识别.首先利用EMD分解得到一组IMF分量,再对各阶IMF分量提取Teager能量;然后通过对不同语种的不同情感语音的Teager能量在Mel频率的分析,提出了一种新的情感特征.基于EMD分解的Me1频率的Teager能量谱系数(ETMC),最后利用SVM分类方法对不同语种的不同情感进行识别.实验结果表明,该方法有很好的识别结果.%In speech emotion recognition system,the extraction of speech emotion feature is especially important,on the basis of studies of EMD,combining the EMD decomposition with Teager energy operator for speech emotion recognition.First,the EMD decomposition are used to get a set of IMF component,and for each IMF component extraction Teager energy,then through to the different emotions of different languages Teager energy in Mel frequency analysis,a new emotional characteristic is proposed:based on the EMD decomposition Teager energy coefficient (ETMC),finally using the SVM classification method to identify different emotions of different languages,experimental results show that this method has a good recognition results.【期刊名称】《科学技术与工程》【年(卷),期】2013(013)024【总页数】4页(P7240-7243)【关键词】EMD分解;Teager能量;Mel滤波器组;语音情感识别【作者】张卫;张雪英;孙颖【作者单位】太原理工大学信息工程学院,太原030024;太原理工大学信息工程学院,太原030024;太原理工大学信息工程学院,太原030024【正文语种】中文【中图分类】TP391.42人类的语言中包含丰富的信息,而且人的情感也是直接反映在语言中[1,2]。

【关键词】情感语音识别谱能量特征人耳听觉特性支持向量机 Teager能量算子【英文关键词】emotional speech recognition spectral energy features humanauditory perception support vector machine TEO情感语音识别论文:基于人耳听觉特性的谱能量特征及其在情感语音识别中的应用【中文摘要】情感语音识别作为语音信号处理领域的一个重要的研究分支,在继承传统的语音信号处理技术的特点的同时,也与人类心理学、语音学、声学等多个学科相互渗透、交叉而形成语音处理领域中的一个热门的研究点。

所谓情感语音识别就是赋予计算机一定的智能,使其能够正确地判断出所输入语音的情感状态。

目前,随着计算机科学技术以及通信技术的快速发展,情感语音识别在人机智能交互方面也有着重要的理论意义和应用前景。

本文研究的主要内容是提取基于人耳听觉特性的谱能量特征,并在此基础上进行了几种优化性改进。

论文中采用的数据库为TYUT情感语音库和EMO-DB情感语音库,其中TYUT情感语音库包含中文和英文两种语种,EMO-DB情感语音库只包含德语语种。

后续识别模型采用支持向量机。

本文首先介绍并分析比较了LPCC、MFCC和ZCPA等几种经典的特征参数,然后分别就汉语、英语和德语三种语种设计了情感识别实验,并将实验结果作为后续所研究特征的参照。

接着研究了基本的谱能量特征:AUSEES特征和AUSEEG特征,由于AUSEES特征和AUSEEG特征采用线性平均频带划分方法,不符合人耳听觉特性,所以本文采用模拟人耳听觉特性的Bark尺度和ERB尺度两种频带划分方法对基本的AUSEES、 AUSEEG特征进行了改进,得到基于人耳听觉特性的两类四种谱能量特征:AUSEES-Bark、AUSEEG-Bark和AUSEES-ERB、AUSEEG-ERB。

将改进后的谱能量特征应用到情感语音识别中,实验结果表明,改进后的新特征的情感识别率明显提高,其中采用Bark尺度频带划分的谱能量特征的情感识别率相对最高,对不同语种的识别性能最稳定性。

然后,本文后续工作以AUSEES-Bark、AUSEEG-Bark两种特征为主要研究对象提出了两种改进方法。

首先利用LPCC参数主要反映声道响应的优点对AUSEEG-Bark特征进行了补偿改进,然后运用Teager能量算子对能量在不同频段上的搬移作用对AUSEES-Bark、AUSEEG-Bark特征进行了优化改进。

实验结果表明这两种改进方法都是有效可行的,改进后的新的谱能量特征也都具有更好的情感分类效果,其情感识别率都有明显提高,其中,基于Teager能量算子的谱能量特征具有相对最为满意的情感分类效果。

【英文摘要】Emotional speech recognition, as an important branch of signal processing technology, it inherits the characteristics of the traditional speech signal processingtechnology, and also formed a new research hotspot crossing with human psychology, phonetics, acoustics and many other disciplines. The so-called emotional speech recognition is to enable the computer to be able to correctly identify the emotional state of the voice input. With the rapid development of computer science and communication technology, the emotional speech recognition in human-computer intelligent interaction has important theoretical significance and application prospects.The main content of this study is to extract the spectral energy features based on human auditory perception, and on this basis, several optimization improvements are conducted. In the experiments, TYUT emotional speech database and the Berlin emotional speech database EMO-DB are used. These two databases include three emotional states (Happiness, Anger, Neutral) and three languages (Chinese, English, German). Support vector machine is used as the recognition model. The classical features such as LPC, LPCC, MFCC and ZCPA are firstly introduced, and their characteristics are compared. Then the emotional recognition experiments are designed. All the experiment results are preserved as references for the followed research. Next the basic spectralenergy features are researched:AUSEES feature and AUSEEG feature. The AUSEES feature and AUSEEG feature divided the entire spectral range with a linear scale, but this kind of method does not conform to the human auditory perception. So Bark scale and ERB scale based on the human auditory perception are introduced for dividing spectral sub-bands. These two methods are used to improve the original AUSEES, AUSEEG features. The improved features are named AUSEES-Bark, AUSEEG-Bark and AUSEES-ERB, AUSEEG-ERB, and they are used in emotional speech recognition experiments. The experiment results showed that the recognition rate of the improved features is significantly higher than the original features. The new features can represent the characteristic of different emotional states effectively. Especially the new features based on Bark scale frequency band division have got the highest recognition rate and the best stability.Then the follow-up research work make AUSEES-Bark and AUSEEG-Bark as the main objects to propose two new kind of improved methods. Firstly, use LPCC parameter’s advantage which is mainly reflecting the channel response to optimize AUSEEG-Bark feature; Then use the Teager Energy Operator on the role of moving energy in differentfrequency bands to improve AUSEES-Bark、 AUSEEG-Bark features. The experiment results show that these two improvements are feasible and efficiently, the new improved features have got better emotional classification results. Especially the spectral energy features based on Teager Energy Operator got the more satisfactory emotional recognition effect.【目录】基于人耳听觉特性的谱能量特征及其在情感语音识别中的应用摘要3-5ABSTRACT5-7第一章绪论11-17 1.1 课题研究背景与意义11-12 1.2 国内外研究现状及存在的问题12-14 1.3 论文的研究内容及章节安排14-17第二章情感语音识别概述17-29 2.1 情感的分类17-18 2.2 情感语音数据库18-21 2.2.1 国内外情感语音库介绍19-20 2.2.2 本文采用的情感语音库20-21 2.3 情感语音识别系统介绍21-22 2.4 情感语音识别分类器22-28 2.5 本章小结28-29第三章语音信号分析及其情感特征参数提取29-43 3.1 语音信号的产生机理29-31 3.2 语音信号产生的物理模型31-33 3.2.1 激励源—滤波器模型31-32 3.2.2 非线性模型32-33 3.3 语音信号的前端处理33-35 3.4 情感语音特征介绍35-39 3.4.1 线性预测系数(LPC)35-36 3.4.2 线性预测倒谱系数(LPCC)36-37 3.4.3 美尔频率倒谱系数(MFCC)37-38 3.4.4 过零峰值幅度特征参数(ZCPA)38-39 3.5 几种经典特征参数的情感识别实验39-40 3.6 本章小结40-43第四章基于人耳听觉特性的谱能量特征及其在情感语音识别中的应用43-57 4.1 引言43-44 4.2 基本的谱能量特征介绍44-45 4.2.1 AUSEES特征44 4.2.2 AUSEEG特征44-45 4.3 人耳听觉特性45-48 4.3.1 听觉系统介绍45-46 4.3.2 掩蔽效应46 4.3.3 临界带与频率群46-48 4.4 基于Bark尺度频带划分的谱能量特征48-52 4.4.1 Bark尺度频带划分48 4.4.2 AUSEES-Bark/AUSEEG-Bark特征提取48-49 4.4.3 情感识别实验49-52 4.5 基于ERB尺度频带划分的谱能量特征52-55 4.5.1 ERB尺度频带划分52-53 4.5.2 AUSEES-ERB/AUSEEG-ERB特征提取53 4.5.3 情感识别实验53-55 4.6 本章小结55-57第五章对基于人耳听觉特性的谱能量特征的优化改进57-69 5.1 声道响应对谱能量特征的补偿算法57-59 5.1.1 AUSEEG-Bark-LPCC特征57 5.1.2 情感识别实验57-59 5.2 基于TEO的谱能量特征59-61 5.2.1 Teager能量算子59 5.2.2AUSEES-Bark-TEO/AUSEEG-Bark-TEO特征提取59-60 5.2.3 情感识别实验60-61 5.3 多种特征的情感识别率对比61-68 5.3.1 多种特征对汉语的情感识别率对比61-64 5.3.2 多种特征对英语的情感识别率对比64-65 5.3.3 多种特征对德语的情感识别率对比65-67 5.3.4 分析与结论67-68 5.4 本章小结68-69第六章总结与展望69-71 6.1 工作总结69-70 6.2 下一步工作展望70-71参考文献71-75致谢75-77攻读硕士学位期间发表的学术论文77。