最小二乘法线性详细详细说明

- 格式:ppt

- 大小:882.50 KB

- 文档页数:45

最小二乘拟合的概念-概述说明以及解释1.引言1.1 概述最小二乘拟合是一种常用的数据分析方法,通过最小化观测值与拟合值之间的残差平方和来求取最优拟合曲线或平面,从而描述数据的模式和趋势。

该方法被广泛应用于统计建模、机器学习、信号处理、金融分析等领域。

最小二乘法的核心思想是寻找一条曲线或平面,使得该曲线或平面与数据点的残差之和最小。

通过最小二乘法,我们可以得到最佳拟合曲线或平面,从而对数据进行更准确的描述和预测。

因此,最小二乘拟合在数据分析中具有重要的意义。

本文将详细介绍最小二乘拟合的定义、原理和应用,从而帮助读者更好地理解和运用这一重要的数据分析方法。

1.2 文章结构文章结构部分的内容如下:文章结构部分将介绍整篇文章的组织结构和主要内容安排,以便读者对文章的整体框架有一个清晰的认识。

在本文中,主要分为引言、正文和结论三个部分。

- 引言部分包括对最小二乘拟合的概念进行简要介绍,阐述本文撰写的目的和重要性。

- 正文部分将详细讨论最小二乘拟合的定义、原理和应用,以便读者全面了解这一重要的数据分析方法。

- 结论部分将对最小二乘拟合的重要性进行总结,探讨最小二乘法在数据分析中的价值,并展望最小二乘拟合在未来的发展趋势。

通过这样的结构安排,读者可以清晰地了解本文的主要内容和章节布局,有助于他们更好地理解和掌握最小二乘拟合的相关知识。

1.3 目的本文的主要目的是介绍最小二乘拟合这一重要的数学方法。

通过对最小二乘拟合的定义、原理和应用进行详细讨论,希望读者能够深入了解这一方法在数据分析和模型拟合中的重要性。

此外,本文还将探讨最小二乘法在实际问题中的应用,以及展望未来最小二乘拟合在数据分析领域的发展趋势。

通过阐述这些内容,旨在让读者更加深入地理解和应用最小二乘拟合方法,为其在数据分析和模型拟合中提供有效的工具和思路。

2.正文2.1 最小二乘拟合的定义最小二乘拟合是一种常用的数学方法,用于通过调整参数来拟合一个数学模型以最小化观测数据和模型之间的残差平方和。

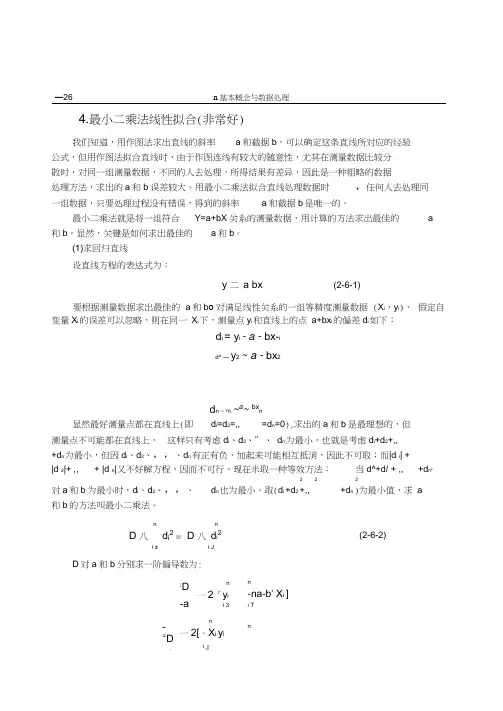

—26 n 基本概念与数据处理4.最小二乘法线性拟合(非常好)我们知道,用作图法求出直线的斜率a 和截据b ,可以确定这条直线所对应的经验公式,但用作图法拟合直线时,由于作图连线有较大的随意性,尤其在测量数据比较分 散时,对同一组测量数据,不同的人去处理,所得结果有差异,因此是一种粗略的数据 处理方法,求出的a 和b 误差较大。

用最小二乘法拟合直线处理数据时 ,任何人去处理同一组数据,只要处理过程没有错误,得到的斜率a 和截据b 是唯一的。

最小二乘法就是将一组符合 Y=a+bX 关系的测量数据,用计算的方法求出最佳的a和b 。

显然,关键是如何求出最佳的a 和b 。

(1)求回归直线设直线方程的表达式为: y 二 a bx(2-6-1)要根据测量数据求出最佳的 a 和b o 对满足线性关系的一组等精度测量数据 (X i ,y i ), 假定自变量X i 的误差可以忽略,则在同一 X i 下,测量点y i 和直线上的点 a+bx i 的偏差d i 如下:d i = y i - a - bx-id^ — y 2~ a - bx 2d n = yn ~a ~ bx n显然最好测量点都在直线上(即 d i =d 2=,, =d n =0),求出的a 和b 是最理想的,但测量点不可能都在直线上, 这样只有考虑d i 、d 2、”、 d n 为最小,也就是考虑d i +d 2+,, +d n 为最小,但因d i 、d 2、,,、d n 有正有负,加起来可能相互抵消,因此不可取;而|d i | + |d 2|+ ,,+ |d n |又不好解方程,因而不可行。

现在米取一种等效方法:当d^+d/ + ,,+d n 2222对a 和b 为最小时,d i 、d 2、,,、 d n 也为最小。

取(d i +d 2 +,, +d n )为最小值,求 a和b 的方法叫最小二乘法。

nD 八 d i 2i JD 对a 和b 分别求一阶偏导数为:n-na -b ' X i ]i T nnD 八 d i 2 = i ±(2-6-2)-=D-=b:D-a n 一2「y ii 3 n一2[、X i y i i 』n基本概念与数据处理—27 - -b' X j2]i d—28 - n 基本概念与数据处理2 ' x -x将a 、b 值带入线性方程y = a bx ,即得到回归直线方程。

标准最小二乘法标准最小二乘法(Ordinary Least Squares, OLS)是一种常用于回归分析的方法,旨在通过拟合数据来找到最合适的模型。

在本文中,将详细介绍标准最小二乘法的原理、应用和计算步骤。

标准最小二乘法的原理十分简单直观,它通过寻找使得拟合模型与观测数据之间误差的平方和最小的参数估计值。

在回归分析中,我们通常会假设一个线性模型来描述自变量和因变量之间的关系。

标准最小二乘法通过最小化残差的平方和来找到最佳拟合的模型。

残差即观测值与拟合值之间的差异。

在应用标准最小二乘法进行回归分析时,需要先确定一个合适的模型。

通常,我们会选择一个线性模型来描述因变量和自变量之间的关系,然后通过参数估计找到最佳的拟合模型。

这一过程可以通过最小化残差平方和的方法来实现。

在计算步骤上,标准最小二乘法可以分为以下几个关键步骤。

首先,需要确定线性模型的形式,并根据实际情况选择自变量。

其次,通过收集样本数据,计算出相关的变量值。

然后,利用计算出的变量值进行模型参数的估计。

最后,通过计算残差平方和,确定最佳的拟合模型。

标准最小二乘法在实际应用中具有广泛的意义和应用价值。

例如,在经济学中,可以利用标准最小二乘法来估计供求关系和弹性系数。

在工程领域,可以通过标准最小二乘法来建立物理模型并进行预测。

在社会科学中,也可以利用标准最小二乘法来研究变量之间的关系。

总结而言,标准最小二乘法是一种常用的回归分析方法,通过最小化残差平方和来找到最佳的拟合模型。

它的计算步骤简单清晰,适用于各个领域的数据分析和预测。

通过合理应用标准最小二乘法,可以有效地研究自变量和因变量之间的关系,为实际问题提供有力的解决方案。

综上所述,标准最小二乘法是一种重要的分析工具,具有广泛的应用前景。

它不仅可以帮助我们理解数据,还可以通过拟合模型来进行预测和分析。

在实际应用中,我们应当遵循标准最小二乘法的原理和计算步骤,以确保分析结果的准确性和可靠性。

通过深入学习和理解标准最小二乘法,我们能够更好地利用这一工具解决实际问题。

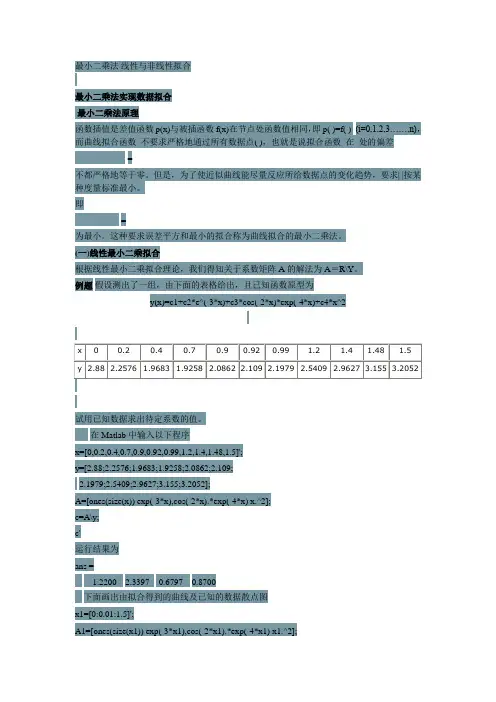

最小二乘法线性与非线性拟合最小二乘法实现数据拟合最小二乘法原理函数插值是差值函数p(x)与被插函数f(x)在节点处函数值相同,即p( )=f( ) (i=0,1,2,3……,n),而曲线拟合函数不要求严格地通过所有数据点( ),也就是说拟合函数在处的偏差=不都严格地等于零。

但是,为了使近似曲线能尽量反应所给数据点的变化趋势,要求| |按某种度量标准最小。

即=为最小。

这种要求误差平方和最小的拟合称为曲线拟合的最小二乘法。

(一)线性最小二乘拟合根据线性最小二乘拟合理论,我们得知关于系数矩阵A的解法为A=R\Y。

例题假设测出了一组,由下面的表格给出,且已知函数原型为y(x)=c1+c2*e^(-3*x)+c3*cos(-2*x)*exp(-4*x)+c4*x^2试用已知数据求出待定系数的值。

在Matlab中输入以下程序x=[0,0.2,0.4,0.7,0.9,0.92,0.99,1.2,1.4,1.48,1.5]';y=[2.88;2.2576;1.9683;1.9258;2.0862;2.109;2.1979;2.5409;2.9627;3.155;3.2052];A=[ones(size(x)) exp(-3*x),cos(-2*x).*exp(-4*x) x.^2];c=A\y;c'运行结果为ans =1.22002.3397 -0.6797 0.8700下面画出由拟合得到的曲线及已知的数据散点图x1=[0:0.01:1.5]';A1=[ones(size(x1)) exp(-3*x1),cos(-2*x1).*exp(-4*x1) x1.^2];y1=A1*c;plot(x1,y1,x,y,'o')事实上,上面给出的数据就是由已知曲线y(x)= 0.8700-0.6797*e^(-3*x)+ 2.3397*cos(-2*x)*exp(-4*x)+ 1.2200*x^2产生的,由上图可见拟合效果较好。

最小二乘法与高斯马尔科夫定理在统计学和数学建模领域都有着重要的作用,下面我们将从这两个方面分别介绍它们的概念、原理和应用。

一、最小二乘法最小二乘法是一种数学优化方法,用于拟合函数和估计参数。

在统计学中,最小二乘法常常用于线性回归分析,通过最小化观测值与理论值的残差平方和,来找到最优的拟合直线或曲线。

其原理可以用简单的数学公式表示:对于样本数据$(x_i, y_i)$,我们希望找到一个函数$f(x)$,使得实际观测值$y_i$与理论值$f(x_i)$的残差$e_i = y_i -f(x_i)$的平方和最小化,即:$$\sum_{i=1}^{n}e_i^2 =\sum_{i=1}^{n}(y_i - f(x_i))^2$$最小二乘法的应用十分广泛,不仅可以用于拟合曲线、解决回归分析问题,还可以应用于信号处理、滤波器设计等领域,是许多经济学、工程学和科学研究中不可或缺的数学工具。

二、高斯马尔科夫定理高斯马尔科夫定理是统计学中的一项重要定理,它主要阐述了上线性回归分析中,最小二乘估计是参数估计的最优线性无偏估计。

具体来说,高斯马尔科夫定理包含以下几个关键要点:1. 线性性:高斯马尔科夫定理要求模型是线性的,即因变量和自变量之间的关系是线性的。

2. 无偏性:最小二乘估计是参数估计的无偏估计,即估计值的数学期望等于真实参数值。

3. 最小方差:在所有无偏估计中,最小二乘估计具有最小的方差,即是最有效的估计方法。

高斯马尔科夫定理的证明相对复杂,涉及到线性代数、数理统计等多个学科的知识。

但它的应用在统计学和经济学中却是非常广泛的,例如在计量经济学中,通过最小二乘估计来估计经济模型的参数,就是基于高斯马尔科夫定理的。

三、最小二乘法与高斯马尔科夫定理的关系最小二乘法和高斯马尔科夫定理之间存在着密切的关系。

上线性回归分析中,最小二乘法的应用正是建立在高斯马尔科夫定理的基础之上的。

具体来说,最小二乘法不仅能够得到参数的无偏估计,而且还能够保证估计值的方差最小,这正是高斯马尔科夫定理所强调的。

题最小二乘法线性分类器设计目讲课老师:学生姓名:所属院系:专业: 学号:最小二乘法线性分类器设计1描述1.1最小二乘法原理的概述最小二乘法原理是指测量结果的最可信赖值应在残余误差平方和为最小的条件下求出。

从几何意义上讲,就是寻求与给定点(X j,yj (i=0,1,…,m)的距离平方和为最小的曲线y = p(x)。

函数p(x)称为拟合函数或最小二乘解,求拟合函数p(x)的方法称为曲线拟合的最小二乘法。

1.2最小二乘法的基本原理最小二乘法又称曲线拟合,所谓“拟合”即不要求所作的曲线完全通过所有的数据点,只要求所得的曲线能反映数据的基本趋势。

曲线拟合的几何解释:求一条曲线,使数据点均在离此曲线的上方或下方不远处。

从整体上考虑近似函数p(x)同所给数据点(X i, y i) (i=0,1, III,m)误差n = p(xj - y i (i =0,1,||( ,m)的大小,常用的方法有以下三种:一是误差r j=p(x)—y i (i=0,1」|(,m)绝对值的最大值max斤,即误差向量1g①mr =(r o,rj||,r m)T的范数;二是误差绝对值的和送斤|,即误差向量r的1—范数;三i=0m是误差平方和v『的算术平方根,即误差向量r的2—范数;前两种方法简单、自然,但i =0不便于微分运算,后一种方法相当于考虑2—范数的平方,因此在曲线拟合中常采用误差m平方和〔二『来度量误差r i(i=0 , 1,…,m)的整体大小。

i =0数据拟合的具体作法是:对给定数据(x,yJ (i=0,1,…,m),在取定的函数类①中,求p(x)・:•:」,使误差斤=p(X i)- y i (i=0,1,…,m)的平方和最小,即m m2'『八[p(xj -yj 二mini =0 i =0从几何意义上讲,就是寻求与给定点(X i,yj (i=0,1,…,m)的距离平方和为最小的曲线y = p(x)(图1)。

函数p(x)称为拟合函数或最小二乘解,求拟合函数p(x)的方法称为曲线拟合的最小二乘法。

最小二乘法和theil-sen趋势估计方法概述说明以及解释1. 引言1.1 概述引言部分将总体介绍本篇文章的研究主题和方法。

本文将探讨最小二乘法和Theil-Sen趋势估计方法,这两种方法旨在通过拟合数据来寻找变量间的关系,并用于预测和估计未来的趋势。

最小二乘法是一种常见且广泛应用的回归分析方法,而Theil-Sen趋势估计方法是一种鲁棒性更强的非参数统计方法。

1.2 文章结构引言部分还需要简要描述整篇文章的结构以供读者参考。

本文包含以下几个主要部分:引言、最小二乘法、Theil-Sen趋势估计方法、对比与对比分析、结论与展望。

每个部分将详细说明相关概念、原理及其在实际应用中的特点。

1.3 目的引言部分还需明确指出本文的目的。

本文旨在比较和对比最小二乘法和Theil-Sen趋势估计方法,评估它们在不同场景下的优缺点,并为读者提供选择适当方法进行数据拟合和趋势预测的依据。

此外,我们也会展望未来这两种方法的改进和应用领域扩展的可能性。

以上为“1. 引言”部分的详细清晰撰写内容。

2. 最小二乘法:2.1 原理介绍:最小二乘法是一种常用的回归分析方法,用于寻找一个函数(通常是线性函数)来逼近已知数据点的集合。

其基本原理是通过最小化实际观测值与模型预测值之间的残差平方和,寻找到使得残差最小化的系数,并将其作为估计值。

利用最小二乘法可以得到拟合直线、曲线或者更复杂的函数来描述数据点之间的关系。

2.2 应用场景:最小二乘法广泛应用于各种领域和行业,包括经济学、社会科学、物理学等。

例如,在经济学中,最小二乘法可以用于研究变量之间的关系以及预测未来趋势。

在工程领域,它可以用于建立模型并进行参数估计。

2.3 优缺点分析:最小二乘法具有以下优点:- 算法简单易行:只需要对数据进行简单处理即可求解出最佳拟合曲线。

- 表示能力强:可以适应不同类型函数的拟合。

- 结果一致性较好:针对相同数据集,得到的结果通常是一致的。

然而,最小二乘法也存在一些缺点:- 对异常值敏感:在数据集中存在离群值时,会对拟合曲线产生较大影响。

第3章 线性动态模型参数辨识-最小二乘法3.1 辨识方法分类根据不同的辨识原理,参数模型辨识方法可归纳成三类: ① 最小二乘类参数辨识方法,其基本思想是通过极小化如下准则函数来估计模型参数:min )()ˆ(ˆ==∑=θθLk k J 12ε 其中)(k ε代表模型输出与系统输出的偏差。

典型的方法有最小二乘法、增广最小二乘法、辅助变量法、广义最小二乘法等。

② 梯度校正参数辨识方法,其基本思想是沿着准则函数负梯度方向逐步修正模型参数,使准则函数达到最小,如随机逼近法。

③ 概率密度逼近参数辨识方法,其基本思想是使输出z 的条件概率密度)|(θz p 最大限度地逼近条件0θ下的概率密度)|(0θz p ,即)|()ˆ|(0m a x θθz p z p −−→−。

典型的方法是极大似然法。

3.2 最小二乘法的基本概念● 两种算法形式 ① 批处理算法:利用一批观测数据,一次计算或经反复迭代,以获得模型参数的估计值。

② 递推算法:在上次模型参数估计值)(ˆ1-k θ的基础上,根据当前获得的数据提出修正,进而获得本次模型参数估计值)(ˆk θ,广泛采用的递推算法形式为() ()()()~()θθk k k k d z k =-+-1K h其中)(ˆk θ表示k 时刻的模型参数估计值,K (k )为算法的增益,h (k -d ) 是由观测数据组成的输入数据向量,d 为整数,)(~k z 表示新息。

● 最小二乘原理定义:设一个随机序列)},,,(),({L k k z 21∈的均值是参数θ 的线性函数E{()}()T z k k θ=h其中h (k )是可测的数据向量,那么利用随机序列的一个实现,使准则函数21()[()()]LT k J z k k θθ==-∑h达到极小的参数估计值θˆ称作θ的最小二乘估计。

● 最小二乘原理表明,未知参数估计问题,就是求参数估计值θˆ,使序列的估计值尽可能地接近实际序列,两者的接近程度用实际序列与序列估计值之差的平方和来度量。

基于最小二乘法的多元线性回归研究多元线性回归是一种广泛应用于统计学和机器学习中的方法,它可用来分析两个或更多个自变量与一个或多个因变量之间的关系。

因其建模方式简单而有效,多元线性回归被广泛应用于社会科学、医学、环境科学和经济学等领域。

本文将介绍如何使用最小二乘法来理解和推导多元线性回归模型,并提供一个简单的例子来说明该方法在实践中的应用。

1. 什么是多元线性回归?在统计学中,回归是指研究因变量和一个或多个自变量之间关系的方法。

多元线性回归是指分析一个因变量和两个或更多个自变量之间的关系的统计方法。

其中,标准的多元线性回归模型可以用以下方程表示:Y = b0 + b1X1 + b2X2 + … + bkXk + ε其中,Y表示因变量,X1、X2 … Xk表示自变量,b0、b1、b2 … bk表示回归系数,ε表示误差。

2. 最小二乘法最小二乘法是一种通用的参数估计方法,将数据的误差平方和作为优化目标,通过最小化该误差来计算回归系数。

在多元线性回归中,建立模型的主要目的是找到最小二乘回归线,其方程为:Y^ = b0 + b1X1 + b2X2 + … + bkXk其中,Y^表示估计值,即预测值。

而求解回归系数的过程即是最小化以下式子:∑ (Y - Y^)2其中,∑表示求和符号,Y表示实际值,Y^表示估计值。

由于目标函数是一个非负函数,所以最小化目标函数即可得到最佳回归系数。

3. 最小二乘法的计算过程最小二乘法的计算过程包括以下步骤:3.1 导入数据首先,我们需要从外部数据源导入数据,这些数据可以是标准格式的数据集,如CSV或Excel文件,也可以通过API等方式从数据库或者Web服务获取。

3.2 理解数据了解数据是建立回归模型的必要步骤之一。

应该确定因变量和自变量之间的关系,并检查数据是否符合假设的分布模型。

3.3 建立模型建立回归模型是估计系数的过程,需要认真选择变量,并确定它们与因变量的关系。

3.4 评估模型确定了模型后,要对其进行评估。

最小二乘法矩阵表示及求解详细推导最小二乘法是将未知参数和误差数据组合为一个整体实现拟合,其运算公式也非常简单,一般可以用线性代数方程式来表示。

假定有一组实验数据 $\{(x_1, y_1), (x_2, y_2), …, (x_n, y_n)\}$,表示y与x的关系,它是满足 $y=f(x,\theta)$ 的任意函数的经验表达式,其中$x$是试验变量,而未知参数$\theta$是由最小二乘法估计出来的;设最小二乘估计参数为 $\theta^{*}$,则$\theta^{*}$就是使误差函数值 $\sum_{i=1}^{n}[y_i-f(x_i,\theta)]^2$最小的参数值。

最小二乘法矩阵表示就是把实验数据用矩阵表示,以简化求解问题,把最小二乘法问题写成矩阵形式,设有$m$z个参数:$$\left\{\begin{array}{l}A\theta =B \\\text {差值函数:}\\E=\left[y_{1}-f\left(x_{1}, \theta\right), y_{2}-f\left(x_{2}, \theta\right), \cdots, y_{n}-f\left(x_{n}, \theta\right)\right]\end{array}\right.$$其中,系数矩阵$A=[A_{1}, A_{2}, \cdots, A_{n}]$,$A_{i}$ 为实验点$(x_i, y_i)$的函数求导,其式子为:$$A_{i} =\left[\frac{\partial f\left(x_{i},\theta\right)}{\partial \theta_{1}}, \frac{\partialf\left(x_{i}, \theta\right)}{\partial \theta_{2}}, \cdots, \frac{\partial f\left(x_{i}, \theta\right)}{\partial\theta_{m}}\right]^T$$其中,常数矩阵$B=[B_1,B_2,\cdots,B_n]^T$,其中$B_i$表示实验点$(x_i,y_i)$的符号为:$$B_{i}=f\left(x_{i}, \theta\right)$$由上面几个式子可以得到$A\theta=B$,解出$\theta$即得到最优参数,即$\theta=A^{-1}B$。

最小二乘法求解线性回归问题最小二乘法是回归分析中常用的一种模型估计方法。

它通过最小化样本数据与模型预测值之间的误差平方和来拟合出一个线性模型,解决了线性回归中的参数估计问题。

在本文中,我将详细介绍最小二乘法在线性回归问题中的应用。

一、线性回归模型在介绍最小二乘法之前,先了解一下线性回归模型的基本形式。

假设我们有一个包含$n$个观测值的数据集$(x_1,y_1),(x_2,y_2),\dots,(x_n,y_n)$,其中$x_i$表示自变量,$y_i$表示因变量。

线性回归模型的一般形式如下:$$y=\beta_0+\beta_1 x_1+\beta_2 x_2+\dots+\beta_px_p+\epsilon$$其中,$\beta_0$表示截距,$\beta_1,\beta_2,\dots,\beta_p$表示自变量$x_1,x_2,\dots,x_p$的系数,$\epsilon$表示误差项。

我们希望通过数据集中的观测值拟合出一个线性模型,即确定$\beta_0,\beta_1,\dots,\beta_p$这些未知参数的值,使得模型对未知数据的预测误差最小化。

二、最小二乘法的思想最小二乘法是一种模型拟合的优化方法,其基本思想是通过最小化优化问题的目标函数来确定模型参数的值。

在线性回归问题中,我们通常采用最小化残差平方和的方式来拟合出一个符合数据集的线性模型。

残差代表观测值与模型估计值之间的差异。

假设我们有一个数据集$(x_1,y_1),(x_2,y_2),\dots,(x_n,y_n)$,并且已经选定了线性模型$y=\beta_0+\beta_1 x_1+\beta_2 x_2+\dots+\beta_p x_p$。

我们希望选择一组系数$\beta_0,\beta_1,\dots,\beta_p$,使得模型对数据集中的观测值的预测误差最小,即最小化残差平方和(RSS):$$RSS=\sum_{i=1}^n(y_i-\hat{y}_i)^2$$其中,$y_i$表示第$i$个观测值的实际值,$\hat{y}_i$表示该观测值在当前模型下的预测值。

一文让你彻底搞懂最小二乘法(超详细推导)要解决的问题在工程应用中,我们经常会用一组观测数据去估计模型的参数,模型是我们根据先验知识定下的。

比如我们有一组观测数据 ( x i , y i ) (x_i,y_i) (xi,yi)(一维),通过一些数据分析我们猜测 y y y和 x x x之间存在线性关系,那么我们的模型就可以定为: f ( x ) = k x + b f(x)=kx+bf(x)=kx+b这个模型只有两个参数,所以理论上,我们只需要观测两组数据建立两个方程,即可解出两个未知数。

类似的,假如模型有n n n个参数,我们只需要观测 n n n组数据就可求出参数,换句话说,在这种情况下,模型的参数是唯一确定解。

但是在实际应用中,由于我们的观测会存在误差(偶然误差、系统误差等),所以我们总会做多余观测。

比如在上述例子中,尽管只有两个参数,但是我们可能会观测 n n n组数据( x 1 , y 1 ) . . , ( x n , y n ) (x_1, y_1)..,(x_n, y_n) (x1,y1)..,(xn,yn),这会导致我们无法找到一条直线经过所有的点,也就是说,方程无确定解。

于是这就是我们要解决的问题:虽然没有确定解,但是我们能不能求出近似解,使得模型能在各个观测点上达到“最佳“拟合。

那么“最佳”的准则是什么?可以是所有观测点到直线的距离和最小,也可以是所有观测点到直线的误差(真实值-理论值)绝对值和最小,也可以是其它,如果是你面临这个问题你会怎么做?早在19世纪,勒让德就认为让“误差的平方和最小”估计出来的模型是最接近真实情形的。

为什么是误差平方而不是另一个?就连欧拉和拉普拉斯都没能成功回答这个问题。

后来高斯建立了一套误差分析理论,从而证明了系统在误差平方和最小的条件下是最优的。

证明这个理论并不难。

我写了另一篇关于最小二乘法原理理解的博客。

相信你了解后会对最小二乘法有更深的理解。