概率张量分解综述

- 格式:pdf

- 大小:932.20 KB

- 文档页数:10

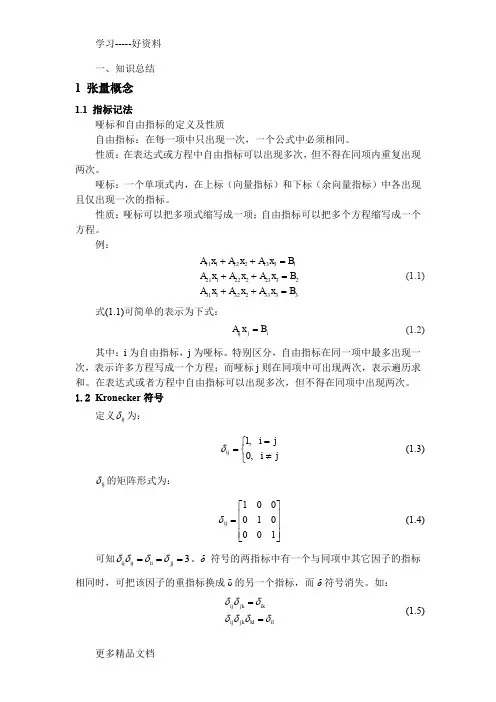

一、知识总结1 张量概念1.1 指标记法哑标和自由指标的定义及性质自由指标:在每一项中只出现一次,一个公式中必须相同。

性质:在表达式或方程中自由指标可以出现多次,但不得在同项内重复出现两次。

哑标:一个单项式内,在上标(向量指标)和下标(余向量指标)中各出现且仅出现一次的指标。

性质:哑标可以把多项式缩写成一项;自由指标可以把多个方程缩写成一个方程。

例:333323213123232221211313212111B x A x A x A B x A x A x A B x A x A x A =++=++=++ (1.1)式(1.1)可简单的表示为下式:i j ij B x A =(1.2)其中:i 为自由指标,j 为哑标。

特别区分,自由指标在同一项中最多出现一次,表示许多方程写成一个方程;而哑标j 则在同项中可出现两次,表示遍历求和。

在表达式或者方程中自由指标可以出现多次,但不得在同项中出现两次。

1.2 Kronecker 符号定义ij δ为:⎩⎨⎧≠==j i ji ij ,0,1δ(1.3)ij δ的矩阵形式为:⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=100010001ij δ (1.4)可知3ij ij ii jj δδδδ===。

δ符号的两指标中有一个与同项中其它因子的指标相同时,可把该因子的重指标换成δ的另一个指标,而δ符号消失。

如:ij jk ikij jk kl ilδδδδδδδ==(1.5)ij δ的作用:更换指标、选择求和。

1.3 Ricci 符号为了运算的方便,定义Ricci 符号或称置换符号:⎪⎩⎪⎨⎧-=其余情况为奇排列为偶排列,0,,,1,,,1k j i k j i l ijk(1.6)图1.1 i,j,k 排列图ijk l 的值中,有3个为1,3个为-1,其余为0。

Ricci 符号(置换符号)是与任何坐标系都无关的一个符号,它不是张量。

1.4 坐标转换图1.2 坐标转换如上图所示,设旧坐标系的基矢为i e ,新坐标系的基矢为'i e 。

多模态知识图谱表示学习综述多模态知识图谱表示学习综述摘要:随着大数据时代的到来,知识图谱成为了对现实世界进行建模和分析的重要工具。

然而,传统的知识图谱主要基于文本信息进行构建和表示,忽略了其他多模态数据的丰富信息。

针对这个问题,多模态知识图谱表示学习应运而生。

本文将对多模态知识图谱表示学习的研究现状、方法和应用进行综述,以期为相关领域的研究者提供参考和启发。

一、引言知识图谱是一种以图的形式表达的知识库,其中知识以实体、关系和属性的形式存储。

传统的知识图谱以基于文本的方式进行构建和表示,通过对文本进行实体抽取、关系抽取等技术来获得知识。

然而,文本信息属于单模态数据,仅能够提供有限的知识表达能力。

随着多模态数据的快速增长,如图像、音频和视频等,如何将多模态数据融入知识图谱表示学习成为当前研究的热点和挑战。

二、多模态知识图谱表示学习的研究现状多模态知识图谱表示学习旨在利用多模态数据增强知识图谱的表达能力。

已有的研究主要可以分为两类:基于图的方法和基于张量的方法。

基于图的方法使用图神经网络(GNN)来建模并融合多模态数据,利用节点和边的信息进行知识表示学习。

基于张量的方法则将多模态数据表示为高阶张量,通过张量分解等技术进行知识表示学习。

三、多模态知识图谱表示学习的方法多模态知识图谱表示学习的方法多种多样,以下是其中几种常见的方法:1. 卷积神经网络(CNN)和循环神经网络(RNN):这两种方法广泛用于图像和文本数据的表示学习,可以将其应用于多模态知识图谱表示学习中,从而提高知识图谱的表达能力。

2. 图卷积神经网络(GCN):GCN是一种特殊的卷积神经网络,它通过聚合周围节点的信息来更新当前节点的表示,已被广泛应用于多模态知识表示学习中。

3. 张量分解:张量分解可以将多维张量分解为若干低维张量,从而实现对多模态数据的表示学习。

常用的张量分解方法包括SVD、CP分解等。

四、多模态知识图谱表示学习的应用多模态知识图谱表示学习在许多领域中具有广泛的应用前景,以下是其中几个常见的应用:1. 音乐推荐:通过将音乐数据和用户数据融入知识图谱表示学习,可以提高音乐推荐系统的精确度和个性化程度。

文章标题:深度探讨张量分解稀疏张量wthres阈值处理的方法和应用引言在信息科学领域,张量分解是一项重要的技术,用于处理高维数据,特别是稀疏张量。

其中,wthres阈值处理是一种常见的方法,能够帮助我们更好地理解数据的结构和特征。

本文将深入探讨张量分解稀疏张量wthres阈值处理的方法和应用,帮助读者更好地理解和运用这一技术。

一、张量分解的基本概念1. 张量的概念张量是信息科学中一个重要的概念,它是一种多维数组或矩阵的扩展。

在现实世界中,许多数据可以被表示为张量,例如图像数据、视频数据和传感器数据等。

2. 张量分解的意义张量分解是将高维的张量数据进行分解,以便更好地理解数据的内在结构和特征。

通过张量分解,我们可以把复杂的高维数据转化为更简洁、更易于理解的形式,有助于数据的降维和特征提取。

二、稀疏张量的特点1. 稀疏张量的定义稀疏张量是指大部分元素为0的张量,这种数据在实际应用中非常常见。

在社交网络数据中,用户与用户之间的互动关系可以被表示为稀疏张量。

2. 稀疏张量的挑战稀疏张量的处理具有一定的挑战性,因为大部分元素都是0,所以需要特殊的方法来有效地分解和处理这种数据,同时保留数据的有用信息。

三、wthres阈值处理的方法1. wthres阈值处理的原理wthres阈值处理是一种常见的方法,用于处理稀疏张量。

它的基本思想是对张量的元素进行阈值处理,将小于阈值的元素置0,从而消除噪声和无用信息。

2. wthres阈值处理的应用wthres阈值处理可以应用于多个领域,如图像处理、信号处理和网络分析等。

在实际应用中,可以根据具体的情况选择合适的阈值和处理方法,以达到最佳的效果。

四、张量分解稀疏张量的技术挑战与解决方法1. 技术挑战张量分解稀疏张量在实际应用中也面临一些挑战,比如计算复杂度高、噪声干扰等问题。

如何有效地解决这些问题,是当前研究的热点之一。

2. 解决方法针对张量分解稀疏张量的技术挑战,有许多解决方法,如采用高效的分解算法、优化数据结构和引入先进的噪声处理技术等。

稀疏张量分解

摘要:

一、稀疏张量分解的背景与意义

1.张量概述

2.稀疏张量的特点

3.稀疏张量分解的必要性

二、稀疏张量分解的方法与技术

1.传统张量分解方法

2.针对稀疏张量的改进方法

3.现有方法的局限性与挑战

三、稀疏张量分解的应用领域

1.信号处理与通信

2.机器学习与深度学习

3.图像处理与计算机视觉

4.其他应用场景

四、我国在稀疏张量分解领域的研究进展

1.我国研究团队的成果与贡献

2.与国际水平的差距与优势

3.未来发展方向与前景

正文:

一、稀疏张量分解的背景与意义

随着大数据时代的到来,人们对于数据的处理与分析需求日益增长。

概率矩阵分解 python概率矩阵分解(PMF)是一种用于推荐系统的技术,它是一种基于概率的机器学习方法,可以用来预测用户对物品的喜好程度。

编程语言 Python 是一种非常流行的编程语言,广泛应用于人工智能、数据科学和机器学习等领域。

在本文中,我们将介绍如何使用 Python 实现概率矩阵分解。

1. PMF 的基本原理在推荐系统中,我们通常会有一个用户-物品矩阵,其中每行代表一个用户,每列代表一个物品。

用户-物品矩阵中的每个元素表示该用户对该物品的喜好程度。

我们可以使用概率矩阵分解是来预测用户对物品的喜好。

具体地说,我们将用户-物品矩阵拆分为两个低维度的矩阵,一个是用户矩阵 U,另一个是物品矩阵 V。

则可以根据矩阵乘法计算出预测的评分矩阵 R_hat:R_hat = U x V其中,矩阵 U 的维度是用户数 x K,矩阵 V 的维度是 K x 物品数,K 是低维度的隐藏因子。

这样,我们就可以得到预测的评分矩阵,其中每个元素代表用户对物品的喜好。

2. PMF 的 Python 实现在 Python 中实现 PMF,我们首先需要安装 NumPy 和SciPy 这两个库。

这两个库是 Python 中非常流行的科学计算库,可以在计算机科学和机器学习等领域广泛应用。

import numpy as np from scipy.sparse.linalgimport svdsdef pmf(train_data, test_data, K,learning_rate, reg_param, epochs): num_users,num_items = train_data.shape # 初始化用户和物品矩阵 U = np.random.normal(scale=1/K,size=(num_users, K)) V =np.random.normal(scale=1/K, size=(num_items, K))# 训练过程 for epoch in range(epochs):# 随机梯度下降法 for u in range(num_users): for i in range(num_items): iftrain_data[u, i] > 0: error =train_data[u, i] - np.dot(U[u, :], V[i, :].T) U[u, :] += learning_rate * (error * V[i, :] -reg_param * U[u, :]) V[i, :] +=learning_rate * (error * U[u, :] - reg_param *V[i, :]) # 计算 RMSE rmse = 0num_test = 0 for u in range(num_users):for i in range(num_items): iftest_data[u, i] > 0: error =test_data[u, i] - np.dot(U[u, :], V[i, :].T) rmse += error ** 2 num_test +=1 rmse = np.sqrt(rmse / num_test)print("Epoch: %d, RMSE: %f" % (epoch+1, rmse))return U, V在上述代码中,train_data 和 test_data 分别是训练集和测试集,K 是隐藏因子的维度,learning_rate 是学习率,reg_param 是正则化参数,epochs 是训练迭代次数。

两个基于不同张量乘法的四阶张量分解徐娇娇;杨志霞【期刊名称】《运筹学学报》【年(卷),期】2018(22)2【摘要】提出了两个基于不同张量乘法的四阶张量分解.首先,在矩阵乘法的基础上,定义第一种四阶张量乘法(F-乘),基于F-乘提出了第一种四阶张量分解(F-TD).其次,基于三阶张量t-product给出了第二种四阶张量乘法(B-乘)和分解(FT-SVD).同时,利用两种分解方法,分别给出两个张量逼近定理.最后,三个数值算例阐明提出的两种分解方法的准确性和可行性.%In this paper,two factorizations for fourth-order tensors based on different multiplications of the fourth-order tensors are investigated.One is,called as F-TD,based on the fourth-order tensor multiplication (F-product).Another is,the fourth-order tensor multiplication and decomposition are defined,called as B-product and FT-SVD,based on the t-product of the third-order tensor multiplication.Meanwhile,two tensor approximation theorems are present using two decomposition methods.Finally,three numerical examples are given to demonstrate the accuracy and the feasibility of our proposed methods.【总页数】14页(P41-54)【作者】徐娇娇;杨志霞【作者单位】新疆大学数学与系统科学学院,乌鲁木齐830046;新疆大学数学与系统科学学院,乌鲁木齐830046【正文语种】中文【中图分类】O151.24【相关文献】1.基于模板张量分解和双向LS TM的司法案件罪名认定 [J], 李大鹏;陈剑;王晨;闻英友;赵大哲2.基于随机网格张量分解的多用户毫米波大规模MIMO系统信道估计 [J], 张景;周小平;王培培;李莉3.基于张量分解的噪声抑制算法研究 [J], 宋毅梁4.不同意识状态对音乐感知的差异性:基于音乐特征与脑电张量分解的研究 [J], 梅戬;王小宇;刘杨;李景琦;刘克洪;杨勇;丛丰裕5.基于类别转移加权张量分解模型的兴趣点分区推荐 [J], 李胜;刘桂云;何熊熊因版权原因,仅展示原文概要,查看原文内容请购买。

张量分解及其在推荐系统中的应用代 翔(中国西南电子技术研究所,四川 成都 610036)摘 要:在异构信息网络下往往会产生纷繁复杂的数据,这些数据常用一种被称为张量的新的形式来表示。

但是由于这些数据中缺失值较多,存在一定的稀疏性,因此需要对张量进行分解,恢复缺失值,找出多元数据之间潜在的关系。

张量分解是推荐系统中一种重要的方法,在推荐系统中应用张量分解,可以挖掘出潜在关系,给用户带来更好的推荐体验。

笔者以数据挖掘为引,研究了张量分解及其在推荐系统中的应用,并根据当下的研究热点问题提出了未来张量分解在推荐领域的应用方向和发展趋势。

关键词:数据挖掘;异构信息网络;张量分解;矩阵分解;推荐系统中图分类号:TP391 文献标识码:A 文章编号:1003-9767(2016)22-034-041 引言在这个信息网络高度发达的时代,各个领域时刻都会产生大量的、纷繁复杂的数据,而这些数据之间往往呈现一些潜在的联系,数据挖掘领域就是为了挖掘这些数据之间的联系。

数据是伴随许多对象而产生的,把这些不同的对象抽象为图上一个个节点,对象之间用线连接起来,则构成了相互连接的网络。

网络下产生的数据用张量来表示,由于数据往往是稀疏的,为了解释数据之间联系,需要对张量进行分解。

张量分解最常用的分解方法是CP分解和Tucker分解,当然还有很多其他分解的方法,如INDSCAL[1]、PARAFAC2[2]、CANDELINC[3]、DEDICOM[4]和PARATUCK2[5-6]等。

张量分解后会产生一些潜在的因子,通过分析这些潜在的因子,就可以得出分解前数据之间的关联程度,即找出数据间内在的联系。

推荐系统就是针对蕴含着多源异构信息的复杂网络来向用户推荐所需物品的一个研究领域。

推荐系统是“利用电子商务网站向客户提供商品信息和建议,帮助用户决定应该购买什么产品,模拟销售人员帮助客户完成购买过程”[7]。

可以理解为推荐系统就是向用户推荐商品、电影、饮食、旅游地点等一些生活信息的系统,这些推荐信息可能是用户潜在感兴趣的,或者是用户可能需要的。

概率矩阵分解概率矩阵分解:从数据中挖掘隐藏的概率关系概率矩阵分解是一种数据分析方法,通过将数据转化为概率矩阵的形式,进而挖掘数据中隐藏的概率关系。

这种方法被广泛应用于推荐系统、自然语言处理、图像处理等领域,为我们提供了深入理解数据的可能性。

一、概率矩阵分解的基本原理概率矩阵分解的基本原理是将一个大的概率矩阵分解为两个或多个较小的矩阵的乘积,从而得到更加简洁和高效的表示。

这种分解不仅可以减小数据的维度,还可以揭示数据中的潜在关系,为进一步的分析和应用提供基础。

推荐系统是概率矩阵分解的一个重要应用领域。

通过将用户-物品评分矩阵分解为用户特征矩阵和物品特征矩阵,可以得到用户和物品的隐含特征表示。

这种表示可以用于预测用户对未观测物品的喜好程度,从而实现个性化推荐。

三、概率矩阵分解在自然语言处理中的应用自然语言处理是另一个重要的应用领域,概率矩阵分解在其中发挥着重要作用。

例如,通过将文本数据转化为词-文档矩阵,并对其进行分解,可以得到词的隐含语义表示和文档的隐含主题表示。

这种表示可以用于文本分类、情感分析等任务。

四、概率矩阵分解在图像处理中的应用除了推荐系统和自然语言处理,概率矩阵分解还被广泛应用于图像处理领域。

通过将图像数据转化为像素-特征矩阵,并对其进行分解,可以得到图像的隐含特征表示。

这种表示可以用于图像分类、目标检测等任务。

五、概率矩阵分解的局限性和改进方向概率矩阵分解虽然在很多领域取得了显著的成果,但仍然存在一些局限性。

例如,当数据稀疏性较高时,分解结果可能不准确。

此外,概率矩阵分解对于数据的先验知识要求较高,对于没有先验知识的数据可能效果不佳。

为了克服这些局限性,研究者们提出了许多改进的方法。

例如,可以引入正则化项来约束分解结果,提高模型的泛化能力。

另外,可以结合其他机器学习方法,如深度学习,来进一步提升概率矩阵分解的性能。

六、总结概率矩阵分解是一种重要的数据分析方法,通过将数据转化为概率矩阵的形式来挖掘数据中的概率关系。

张量分解算法研究与应用综述熊李艳;何雄;黄晓辉;黄卫春【摘要】张量分解是处理大规模数据的一种方法,它能有效的对数据进行降阶,由于高阶张量具有唯一性、对噪声更鲁棒、不破坏原数据的空间结构和内部潜在信息等优点,被广泛应用于神经科学、信号处理、图像分析、计算机视觉等领域.论文首先对传统的降维方法进行了介绍,指出这些方法存在的问题和不足.其次对张量分解的三种经典算法:CP分解、Tucker分解以及非负张量分解从算法的求解、基本思想、算法框架以及算法应用等方面进行概括分析,对CP分解算法和Tucker分解算法从多角度进行对比分析.最后对张量分解的现状以及实际应用进行了归纳和总结,并对未来的研究发展趋势进行了分析和展望.%Tensor decomposition is a significant method to deal with large-scale data, which can reduce the data effectively.The high-order tensor is widely used in neuroscience,signal processing,image analysis,computer vi-sion and other fields as it has such advantages as uniqueness, robustness to noises and zero impact on the origi-nal data of the spatial structure and internal potential information. In this paper, the traditional dimensionality reduction methods were introduced firstly, and their problems and shortcomings were also discussed. Secondly, general analysis of three classical algorithms of tensor decomposition was carried out from the aspects of algo-rithm, basic ideas, algorithm framework and algorithm applications of CP decomposition, Tucker decomposition and non-negative tensor decomposition. Then, The CP decomposition algorithm and the Tucker decomposition algorithm were compared and analyzed from different angles. Finally, the presentsituation, practical application and future research trends of tensor decomposition were summarized and analyzed.【期刊名称】《华东交通大学学报》【年(卷),期】2018(035)002【总页数】9页(P120-128)【关键词】张量;CP分解;Tucker分解;非负张量分解【作者】熊李艳;何雄;黄晓辉;黄卫春【作者单位】华东交通大学信息工程学院,江西南昌330013;华东交通大学信息工程学院,江西南昌330013;华东交通大学信息工程学院,江西南昌330013;华东交通大学软件学院,江西南昌330013【正文语种】中文【中图分类】TP301.61 数据降维及张量概述随着互联网时代的不断发展,数据规模越来越大,数据的结构往往具有高维特性,对高维数据进行处理,人们可以挖掘出有价值的信息。

张量回归模型及其应用研究综述近年来,随着大数据技术和复杂网络的发展,多维数据的解析(如影像,视频,文本和结构数据)的传统机器学习方法都失去了它们应用于这些数据的能力,这导致了新的学习理论和方法的出现。

张量回归模型是在最近几年出现的一种机器学习模型,它是为了替代传统机器学习模型解决多维数据解析带来的挑战而设计的。

本文将针对张量回归模型在近年来的研究发展,介绍张量回归模型的理论基础,及其在图像和结构数据处理中的应用,以及未来的研究方向,以期对多维数据的解析提供更好的理解和指导。

一、张量回归模型简介张量回归模型(Tensor Regression Model,TRM)是一种新型计算模型,它是由张量统计学习提出的,用于替代传统机器学习模型解决多维数据解析问题。

通常情况下,机器学习模型(如逻辑回归模型,支持向量机模型等)只能处理单变量的数据,多变量的数据往往无法有效地处理,而TRM则改善了这一点,它允许算法同时利用多种类型的特征,比如图像,视频,文本,结构数据等,更好地进行多维数据解析。

TRM主要是通过张量统计学习算法来处理多维数据,其算法模型定义为:$$ f(X)=sum_{i=1}^Nprod_{j=1}^{M} g_{ij}(x^{ij}) $$ 在张量统计学习算法中,N表示样本数量,M表示特征的种类,使得$x^{ij}$表示第i个样本的第j个特征,$g_{ij}$表示相应的模型函数。

最终,通过最小化损失函数来优化模型参数,从而使得总体模型更加精确。

二、张量回归模型在图像和结构数据处理中的应用张量回归模型已经被广泛应用于图像和结构数据处理。

对于图像数据,TRM可以利用其多方面的特征来更好地适应复杂图像,它提供了一种强大的框架,用于多维图像数据的分析和处理;对于结构数据,TRM可以构建一个更加强大的模型,从而用于结构数据的聚类、分类以及其他任务。

此外,由于TRM的对称性,使得其在解决复杂的多维问题时更有效。

张量分析在机器学习中的应用在近年来的机器学习领域中,张量分析作为一种强大的工具,被广泛应用于各种复杂的数据模型和算法中。

本文将探讨张量分析在机器学习中的应用,并分析其在不同领域中的优势和局限。

通过了解张量分析的基本概念和常见应用案例,我们可以更好地理解其在机器学习中的作用和价值。

一、张量分析的基本概念张量是一种多维数组,可以包含标量、向量、矩阵等数据类型。

在张量分析中,我们通常使用高阶张量来表示复杂的数据结构。

张量具有多个属性,如阶数、维度和元素等,这些属性可以为机器学习提供丰富的信息。

张量分析的基本概念包括张量的表示、运算和变换等,这些概念为机器学习提供了一种灵活和高效的数据处理方式。

二、1. 张量分解张量分解是一种重要的张量分析技术,可以将高阶张量分解为较低阶的张量,从而降低数据的复杂度。

在机器学习中,张量分解可以用于特征提取、降维和模型简化等任务。

通过张量分解,我们可以从高维数据中提取出有用的特征,减少冗余信息,提高学习算法的效果和效率。

2. 张量网络张量网络是一种基于张量分析的模型,可以用于处理复杂的数据结构和关系。

通过构建张量网络,我们可以将多个张量连接起来形成一个高效的数据流图,从而实现对复杂数据的处理和学习。

在机器学习中,张量网络可以用于图像识别、自然语言处理和推荐系统等任务,取得了很好的效果。

3. 张量分析算法张量分析算法是一种基于张量分析的算法思想,可以解决一些特定的机器学习问题。

例如,张量奇异值分解可以用于处理异常检测和异常值处理,张量回归可以用于处理多任务学习和关系建模等。

这些算法利用了张量分析的特性,将其应用于实际问题中,取得了一定的研究进展和应用效果。

三、张量分析在机器学习中的优势和局限1. 优势张量分析在机器学习中具有以下优势:(1) 多维数据处理:张量可以表示多维数据,可以更好地处理复杂的数据结构和关系。

(2) 特征提取和降维:张量分解可以从高维数据中提取有用的特征,减少数据的冗余信息。

张量链式分解引言张量链式分解(Tensor Chain Decomposition)是一种用于对多维数据进行降维和特征提取的技术。

它广泛应用于各个领域,包括图像处理、语音识别、推荐系统等。

本文将介绍张量链式分解的基本概念、原理、方法和应用,并探讨其优缺点以及未来的发展方向。

张量基础知识在深入讲解张量链式分解之前,我们先来了解一些张量的基础知识。

1. 张量的定义首先,我们需要明确张量(Tensor)的概念。

在数学和物理学中,张量是一种多维数组或矩阵的推广。

例如,0阶张量是标量(Scalar),1阶张量是向量(Vector),2阶张量是矩阵(Matrix),以此类推。

2. 张量的表示张量可以用多种方式进行表示,包括矩阵、数组和张量的分块表示等。

其中,张量的分块表示可以简化数据的处理和计算。

3. 张量的运算和矩阵类似,张量也支持多种运算,包括加法、减法、乘法、求逆等。

这些运算可以用于数据的变换和处理。

张量链式分解的基本概念接下来,我们将介绍张量链式分解的基本概念。

1. 张量链的定义张量链(Tensor Chain)是指由多个张量组成的序列。

每个张量可以有不同的维度和大小,但它们的维度必须满足一定的连续性条件。

2. 张量链的分解张量链的分解是将复杂的张量链表示为一系列低阶张量的乘积的过程。

分解后的低阶张量包含了原始张量链的信息,并可以用于降维和特征提取。

3. 张量链式分解的原理张量链式分解的原理是基于张量的秩的概念。

张量的秩是指表示张量的低阶张量的个数。

通过适当的张量链分解,可以降低张量的秩,从而实现降维和数据压缩。

张量链式分解的方法张量链式分解有多种方法和算法,下面介绍其中几种常见的方法。

1. CP分解(CANDECOMP/PARAFAC)CP分解是一种基于多线性代数的张量分解方法。

它将一个高阶张量表示为多个低阶张量的和。

CP分解具有数学上的优良性质和可解释性,被广泛应用于数据分析和模型简化。

2. Tucker分解Tucker分解是一种将一个高阶张量分解为一系列核张量与模态矩阵的乘积的方法。

2018年8月第34卷第4期陕西理工大学学报(自然科学版)Journal of Shaanxi University of Technology (Natural Science Edition)Aug.2018Vol.34 No.4[文章编号]2096 -3998(2018)04 -0070 -10概率张量分解综述史加荣#’2",张安银1(1.西安建筑科技大学理学院,陕西西安710055;2.西安建筑科技大学建筑学院,陕西西安710055)[摘要]在获取高维多线性数据的过程中,元素通常丢失,而概率张量分解能够在不破坏 数据结构的前提下有效地补全丢失值。

综述了近几年出现的主要概率张量分解模型。

首先,讨论了经典的张量分解模型;其次,将概率张量分解模型分为平行因子分解和塔克分解两大 类,并给出了求解方法及优缺点。

在模型求解过程中,分析了两种最常用的方法:变分贝叶斯 推断和吉布斯采样。

最后,指出了有待进一步研究的问题。

[关键词]张量分解;概率张量分解;低秩;变分贝叶斯推断;吉布斯采样[中图分类号]T P301.6 [文献标识码]A作为一类数据分析工具,低秩矩阵分解已被广泛地应用在机器学习、计算机视觉、数据挖掘和信号 与图像处理等诸多研究领域。

低秩矩阵分解主要包括主成分分析[1]、奇异值分解[2]和非负矩阵分解[3]等模型,它们需要完整的输入数据。

在数据获取时若出现数据丢失或者较大的噪声腐蚀,前述的传统低 秩分解方法往往不能给出理想的结果,而概率矩阵分解在一定程度上能克服这些缺陷[49]。

与矩阵分解 相比,概率矩阵分解要求低秩成分是随机的,这不但可以增加模型的鲁棒性,而且有利于研究数据的生 成方式。

随着信息技术的快速发展,数据规模急剧扩大,使得高维数据结构更加复杂。

传统的机器学习方法 用向量或矩阵形式来表示数据,因而不能很好地刻画数据的多线性结构。

作为向量和矩阵的高阶推广,张量表示在一定程度上能够避免上述问题。

因此,基于张量的机器学习方法已经受到广泛关注,成为当 今机器学习与数据挖掘领域的一个新的研究方向。

平行因子分解(C a n d e c o m p/P a r a f a c,C P)和塔克分解 (T u c k e r)是张量分解的两类最重要的代表模型,它们分别是主成分分析与奇异值分解的高阶推广[10],已成功地应用到计算机视觉[11—14]、人脸识别[15—17]、交通网络分析[18]、社会网络分析[19]和国际关系分 析[20]等领域中。

在获取高维数据的过程中,部分元素可能丢失或者不准确。

低秩张量恢复是解决上述问题的一类 方法,它根据待研究数据张量的近似低秩结构来恢复出低秩成分与噪声[2126]。

Q u等[2718]认为低秩张 量恢复充分利用了数据所有维度的信息,能有效恢复或预测丢失数据。

但现有的低秩张量恢复方法也 有一定的弊端,如:确定张量的秩是多项式非确定性(N o n-d e te r m in istic P o ly n o m ia1,N P)问题,低秩成分是 确定的而不是随机的。

这些问题可能会导致过拟合,不利于低秩模型的生成。

概率张量分解能够很好 地避免上述问题,已成为处理高维数据的一类重要方法。

本文对主要的概率张量模型进行综述。

收稿日期#2017-10-25 修回日期#2018-01-02基金项目:国家自然科学基金资助项目(61403298);中国博士后科学基金资助项目(2017M613087)"通信作者:史加荣(1979—),男,山东省聊城市人,西安建筑科技大学教授,博士,主要研究方向为机器学习、模式识别。

• 70 •第+期史加荣,张安银 概率张量分解综述1 基本知识1.1 C P 分解张量C P 分解是将一张量分解成一组秩1张量的线性组合。

令7 * R /1X/!X3X-是一个C P 秩为2的 #阶张量,其C P 分解形式为•,#T )],⑴CR b 2«1«2a R 7 )["⑴ 〇 "⑵-•••〇 "J T ) . [#D ,#⑵,r = 1其中A ⑷=(W 'a ”,…,为因子矩阵,E = 1,!,…,T 。

图1给出了 3阶张量的C P 分解示意图。

/对于某个固定的E ,假设因子矩阵#(E )未知而其余T - 1个因子矩阵已知,则可通过求解如下的最优化问题来得到最优的#(E)*G (i n ||7_ [#( 1),#(2),令$(E ) U #⑷〇…O # — 1)/#^-1)/…〇#(1),则最优化问题(2)等价于g 6"%(e ) _#㈦$(E )T ||(, ⑶其中%(E )是张量7的E -模式矩阵。

使用最小二乘法,得到#(E )的最优解,然后,通过交替迭代方法,可求出J 的较优的C P 分解形式。

1.2 Tucker 分解T 阶张量7 * R /1X /!X …^的Tucker 分解是将它分解为一 个核心张量与T 个矩阵的模式积,即图1 3阶张量的C P 分解•,#(T )]I I (。

⑵j ) C X }&⑴ x 2&(2_t &( T ).[C $&⑴,&⑵,…,&(T)], (4)其中C *R /1X 2X 3X /T 为核心张量,&⑷*r -x /e 为因子矩阵,e = 1,2,…,T 。

3阶张量的Tucker 分解示意图如图2所示。

为得到最优的Tucker 张量分解,可求解下列最优化问题:图2 3阶张量的Tucker分解c ,&(1),&?2)1:…,&( t J I 7_[ C $&( 1),&(2),…,&(T )]l l 2&(e )t &(e )(5)”n , E = 1,2,…,T ,其中'为人阶单位矩阵。

当所有因子矩阵给定时,根据其正交性,可得C 的最小二乘解。

此时,最优 化问题(5)的目标函数变为|| 7 || (- || C || (,此问题可转化为&⑴,,•,&(>_1&⑴=X 2&(2)TX 3...X t &(寧||(,&(n )T&(n )(6)1,2,…,T ,使用高阶奇异值分解(Higher-Order Singular Value Decomposition ,H O S V D ),可近似求出问题(5)的最优解[3〇]。

如果Tucker 分解中的核心张量C 是超对角的,且人=人=…=八,则Tucker 分解就退化成C P 分 解。

换言之,C P 分解是Tucker 分解的一种特殊情况。

本文采用了 Acar 等人[29]的张量符号,关于张量 分解的更多知识可参考文献[9-10 ]和[31 ]。

2概率张量C P 分解在进行C P 分解之前,需要事先确定张量的C P 秩。

计算张量的C P 秩是N P 难的,这无疑增加了模 型的复杂性,而概率张量C P 分解在一定程度上避免了上述不足。

下面对概率分解模型做简要综述。

+ 71 +陕西理工大学学报(自然科学版)第34卷2.1贝叶斯张量C P 分解对于给定的含噪声的不完全〜阶张量;S #将其分解为一个潜在的低秩张量;3与一个噪声张量!之和,6P y =x + (7)假设噪声张量!的元素相互独立且服从高斯分布,即1 T (0,4# )。

用2表示被观测数据的指标C2…C 集,被观测数据表示为!。

低秩张量;3的C P 分解模型为尤=$"⑴—⑵。

…—⑵.[义⑴,#'…,#""], ($)r = 1于是被观测数据的似然函数为]!i m (e )i :=i ,4 = n t (,w ..c | …c ,1)。

(9)(C ,C ,…,C " *2 r = 1为了能自动确定CP 秩和有效避免过拟合,用连续型参数控制潜在空间的每一维变量。

为此,假设因子矩阵#(E )的各行相互独立且分别服从均值为0、精度矩阵(协方差矩阵的逆)为"的高斯分布,即-]#(E ) |A ) = 1T ("C |0,"+), (10)C = 1 E 其中"CE )是#(E )的第C 行,# = (,1,A !,…,,2) =," =Aia (#)。

令参数#的先验分布为伽马(G a m m a )分 布]#) = n G a m (A j |4,';)),l 9,';)|f =1 为超参数集合。

J =1为了使用全贝叶斯框架,进一步假设噪声!的精度4也服从伽马分布,即P (4)= Ga m (4 =〇,> )。

记# = 0#⑴,#(2),…,#(T )1,(= |#,#,4,则观测数据的联合分布为N p (7fl ,()= p (y 21#,4> 1 p (#(E ) I a )p (a )p (t), (11)E = 1易知I !) 2p !,(),使用变分贝叶斯方法对参数(进行估计[3!]。

基于均值场理论[33],从而对丢失 的数据进行预测:p ,c ..c l !) = '(!c ..c l ()p (l !)d (=3(,112…T 1#,49(#)9(#)9(4^#(14 (12)这种算法能够根据A 自动确定CP 秩,避免了传统方法的弊端,但其缺点是计算复杂度较高。

2.2贝叶斯鲁棒CP 分解在贝叶斯张量C P 分解的基础上,再考虑数据张量还受到稀疏噪声的腐蚀。

于是,数据张量7的鲁棒C P 分解形式为y = x 7 ^ 7 !, (13)其中s 为稀疏噪声张量,!为噪声张量。

低秩张量;3的CP分解仍为公式(8)。

基于此,被观测数据!的 似然函数为p !i |#(")1:=1,",4 = n T (,c c ..c | + l c ..c ,41), (14)(C ,C ,…,C ) *2 r = 1当(C C ,…,C ) 4 2,则张量"对应的分量为0。

仍假设因子矩阵#(E )服从高斯分布,其分布密度参见公式(10)。

为简化问题,假设参数#的分布 密度函数为p #) = 1 G a m (A r 丨9,'0), (1V)r =1其中9,'0为超参数。

+ 72 +第4期史加荣,张安银概率张量分解综述对于稀疏噪声",同样使用分层框架:尸("|$) = n I〇,&+!.,),I(c,c,…,1T*2(16)1]$) = n G0n(&C r..c I=&,>",(C,C,…,C"*2其中$为与同型的张量。