张量分解学习

- 格式:pptx

- 大小:619.61 KB

- 文档页数:47

多模态知识图谱表示学习综述多模态知识图谱表示学习综述摘要:随着大数据时代的到来,知识图谱成为了对现实世界进行建模和分析的重要工具。

然而,传统的知识图谱主要基于文本信息进行构建和表示,忽略了其他多模态数据的丰富信息。

针对这个问题,多模态知识图谱表示学习应运而生。

本文将对多模态知识图谱表示学习的研究现状、方法和应用进行综述,以期为相关领域的研究者提供参考和启发。

一、引言知识图谱是一种以图的形式表达的知识库,其中知识以实体、关系和属性的形式存储。

传统的知识图谱以基于文本的方式进行构建和表示,通过对文本进行实体抽取、关系抽取等技术来获得知识。

然而,文本信息属于单模态数据,仅能够提供有限的知识表达能力。

随着多模态数据的快速增长,如图像、音频和视频等,如何将多模态数据融入知识图谱表示学习成为当前研究的热点和挑战。

二、多模态知识图谱表示学习的研究现状多模态知识图谱表示学习旨在利用多模态数据增强知识图谱的表达能力。

已有的研究主要可以分为两类:基于图的方法和基于张量的方法。

基于图的方法使用图神经网络(GNN)来建模并融合多模态数据,利用节点和边的信息进行知识表示学习。

基于张量的方法则将多模态数据表示为高阶张量,通过张量分解等技术进行知识表示学习。

三、多模态知识图谱表示学习的方法多模态知识图谱表示学习的方法多种多样,以下是其中几种常见的方法:1. 卷积神经网络(CNN)和循环神经网络(RNN):这两种方法广泛用于图像和文本数据的表示学习,可以将其应用于多模态知识图谱表示学习中,从而提高知识图谱的表达能力。

2. 图卷积神经网络(GCN):GCN是一种特殊的卷积神经网络,它通过聚合周围节点的信息来更新当前节点的表示,已被广泛应用于多模态知识表示学习中。

3. 张量分解:张量分解可以将多维张量分解为若干低维张量,从而实现对多模态数据的表示学习。

常用的张量分解方法包括SVD、CP分解等。

四、多模态知识图谱表示学习的应用多模态知识图谱表示学习在许多领域中具有广泛的应用前景,以下是其中几个常见的应用:1. 音乐推荐:通过将音乐数据和用户数据融入知识图谱表示学习,可以提高音乐推荐系统的精确度和个性化程度。

稀疏张量分解

摘要:

一、稀疏张量分解的背景与意义

1.张量概述

2.稀疏张量的特点

3.稀疏张量分解的必要性

二、稀疏张量分解的方法与技术

1.传统张量分解方法

2.针对稀疏张量的改进方法

3.现有方法的局限性与挑战

三、稀疏张量分解的应用领域

1.信号处理与通信

2.机器学习与深度学习

3.图像处理与计算机视觉

4.其他应用场景

四、我国在稀疏张量分解领域的研究进展

1.我国研究团队的成果与贡献

2.与国际水平的差距与优势

3.未来发展方向与前景

正文:

一、稀疏张量分解的背景与意义

随着大数据时代的到来,人们对于数据的处理与分析需求日益增长。

数学物理中的降维算法研究随着科技的迅速发展,各个领域都在不断涌现出大量的数据,这些数据不仅数量庞大,而且维度高,导致很多场景下的数据处理和分析变得非常困难。

降维算法便应运而生,成为了解决高维数据处理难题的一种重要方式。

数学物理中的降维算法,作为降维算法中的重要一部分,正在被广泛研究和应用。

一、降维算法的基本知识1. 降维算法的思想降维算法是一种将高维数据映射到低维空间的算法,具体而言就是将高维数据集转化为低维数据集,以此来简化处理和分析的难度。

其思想基于数据的预处理和特征提取,旨在减少数据冗余,最大程度地保留数据的特征,从而使数据在低维空间中表现出良好的性质和结构。

2. 降维算法的分类根据降维算法的处理对象不同,可以将其分为两类,即线性降维和非线性降维。

其中线性降维包括PCA(主成分分析)和LDA (线性判别分析)等方法,它们可以通过一系列的线性转换将高维数据映射到低维空间。

而非线性降维则使用一些非线性映射方法,如Isomap、LLE(局部线性嵌入)等,它们可以更好地处理高度非线性的数据集。

二、数学物理中的降维算法1. 张量分解张量分解是一种将高维数据张量分解成若干低维张量的方法。

在物理学中,张量分解被用于分析矩阵物理、量子力学中的张量等领域。

张量分解可以处理多个变量之间的关系,而且可以在提取特征的同时保留数据的原始形态,因此在实际应用中有着广泛的应用。

2. 流形学习流形学习是一种非线性降维算法,它基于流形学说,旨在发现数据在低维空间中的潜在流形结构。

流形结构指的是数据在高维空间中的低维规律和分布,通过流形学习可以在保留数据结构和信息的前提下,对高维数据集进行降维。

流形学习可以分为局部流形学习和全局流形学习两种,局部流形学习包括LLE、LE(局部线性嵌入)、LTSA(局部切空间对准)等方法,全局流形学习包括Isomap、Laplace特征映射等。

3. 独立成分分析独立成分分析是一种多元统计学的方法,用于对多元信号的源信号进行分离。

一种基于张量分解的多源异构数据特征融合

方法

多源异构数据特征融合是在当今大数据环境下的一个重要任务。

针对这个任务,一种基于张量分解的特征融合方法被提出。

在多源异构数据中,不同数据源之间可能具有不同的特征表示方式和数据分布。

为了充分利用这些数据源,并获得更准确的融合特征,我们可以使用张量分解技术。

首先,我们将异构数据转化为一个张量,将不同的特征维度作为张量的维度。

然后,利用张量分解算法对张量进行分解,将其分解为多个低秩子张量。

这样做的目的是捕捉到数据源之间的共享特征和异态特征。

接下来,在每个低秩子张量中,我们可以根据具体任务的需要进行特征选择或

特征加权。

这可以通过一些经典的特征选择算法(如卡方检验、互信息等)或特征加权方法(如TF-IDF、标准化等)来实现。

最后,我们将经过特征选择或特征加权后的低秩子张量进行重组,得到最终的

融合特征表示。

这些融合特征既可以直接用于后续的任务,如分类、聚类等,也可以作为新的特征输入到深度学习模型中。

通过基于张量分解的多源异构数据特征融合方法,我们能够更好地利用异构数

据之间的特征信息,提高数据挖掘任务的性能。

这种方法不仅可以应用于文本数据、图像数据等传统的异构数据,还可以扩展到其他领域,如社交网络数据、传感器网络数据等。

总之,基于张量分解的多源异构数据特征融合方法是一种有效的数据融合策略,可以提高数据挖掘任务的准确性和可靠性。

它为多源异构数据的应用提供了有力的支持,并在实际应用中具有广泛的应用前景。

2023年度数学领域热门词汇随着科技的不断进步和社会的快速发展,数学作为一门重要的学科在各个领域都起着举足轻重的作用。

2023年,数学领域涌现出了许多热门词汇,这些词汇代表了数学界最新的研究成果和前沿方向。

以下是2023年度数学领域的热门词汇:1. 量子计算(Quantum Computing):量子计算作为一项前沿的计算方法,引起了广泛的关注。

它基于量子力学原理,利用量子比特进行计算,具有高效性和并行性的特点。

2023年,量子计算在解决一些复杂的数学问题、优化算法和密码学方面取得了突破性进展。

2. 组合优化(Combinatorial Optimization):组合优化是一种研究如何在离散的情况下对优化问题进行求解的方法。

在2023年,组合优化在网络设计、交通规划、生产调度等诸多实际问题中发挥了重要作用。

它的研究对象包括排列、组合、图论等,通过寻找最优化的组合方式来解决实际难题。

3. 拓扑数据分析(Topological Data Analysis):拓扑数据分析是一种将拓扑学应用于数据科学的新兴领域。

它通过构建数据的拓扑结构,研究数据中的空间关系和形状特征,并借助拓扑学的工具来进行分析。

2023年,拓扑数据分析在图像处理、生物信息学和金融风险管理等领域具有广泛的应用前景。

4. 深度学习(Deep Learning):深度学习是一种基于人工神经网络的机器学习算法,它通过多层次的神经网络结构进行复杂的模式识别和数据分析。

在2023年,深度学习在图像识别、语音识别、自然语言处理等领域取得了显著的成果,并引领了人工智能技术的发展方向。

5. 张量分解(Tensor Decomposition):张量分解是一种对高维数据进行降维和表示的技术方法。

它将多维数据表示为更低维度的张量分量,以便进行数据分析和模型建立。

在2023年,张量分解在社交网络分析、推荐系统和信号处理等领域中表现出了广泛的应用前景。

6. 加密货币(Cryptocurrency):加密货币是一种基于密码学技术实现的数字货币,具备去中心化和匿名性的特点。

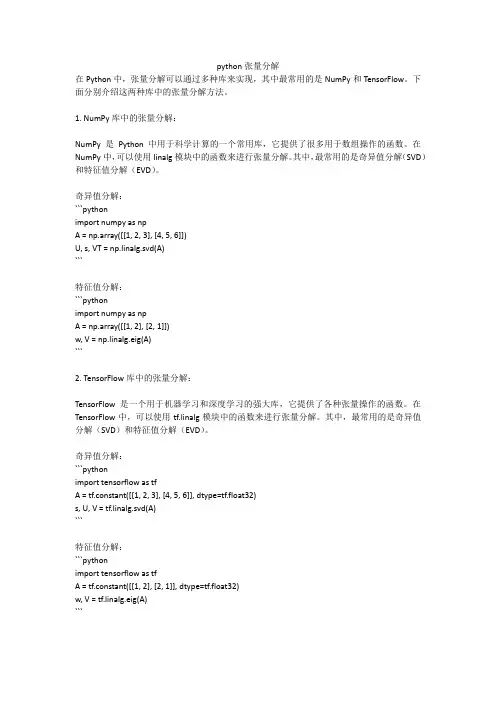

python张量分解在Python中,张量分解可以通过多种库来实现,其中最常用的是NumPy和TensorFlow。

下面分别介绍这两种库中的张量分解方法。

1. NumPy库中的张量分解:NumPy是Python中用于科学计算的一个常用库,它提供了很多用于数组操作的函数。

在NumPy中,可以使用linalg模块中的函数来进行张量分解。

其中,最常用的是奇异值分解(SVD)和特征值分解(EVD)。

奇异值分解:```pythonimport numpy as npA = np.array([[1, 2, 3], [4, 5, 6]])U, s, VT = np.linalg.svd(A)```特征值分解:```pythonimport numpy as npA = np.array([[1, 2], [2, 1]])w, V = np.linalg.eig(A)```2. TensorFlow库中的张量分解:TensorFlow是一个用于机器学习和深度学习的强大库,它提供了各种张量操作的函数。

在TensorFlow中,可以使用tf.linalg模块中的函数来进行张量分解。

其中,最常用的是奇异值分解(SVD)和特征值分解(EVD)。

奇异值分解:```pythonimport tensorflow as tfA = tf.constant([[1, 2, 3], [4, 5, 6]], dtype=tf.float32)s, U, V = tf.linalg.svd(A)```特征值分解:```pythonimport tensorflow as tfA = tf.constant([[1, 2], [2, 1]], dtype=tf.float32)w, V = tf.linalg.eig(A)```以上是使用NumPy和TensorFlow库进行张量分解的简单示例。

在实际应用中,还可以使用其他专门用于张量分解的库,如scikit-tensor、PyTorch等。

小变形张量的分解小变形张量是张量分析中的重要概念之一,它在多个学科领域中都有广泛的应用。

本文将从小变形张量的定义、分解以及在实际应用中的应用等方面进行介绍。

一、小变形张量的定义小变形张量是描述物体在受力下发生形变的数学工具,它用来描述物体各个点的微小形变程度和方向。

在三维空间中,小变形张量可以表示为一个3×3的矩阵,其中每个元素表示物体在三个坐标轴方向上的形变。

小变形张量既可以表示物体的线性变形,也可以表示物体的切变变形。

在张量分析中,小变形张量可以通过分解得到不同的分量,常见的分解有正交分解和主应变分解。

1. 正交分解:正交分解将小变形张量分解为一个对称的部分和一个反对称的部分。

对称部分描述了物体的拉伸和压缩变形,反对称部分描述了物体的切变变形。

正交分解的物理意义是将形变分解为体积变化和形状变化两个方面。

2. 主应变分解:主应变分解是指将小变形张量分解为三个主应变方向和对应的主应变值。

主应变方向是指物体在该方向上形变最大或最小的方向,主应变值表示该方向上的形变程度。

主应变分解可以用来分析物体在不同方向上的形变情况,有利于研究物体的力学性质。

三、小变形张量的应用小变形张量在物理学、工程学等领域中有广泛的应用。

以下将介绍其中几个常见的应用:1. 固体力学:小变形张量在固体力学中被广泛应用于弹性力学、塑性力学等领域。

通过分析小变形张量的分解,可以研究物体在受力下的形变情况,进而得到物体的应力分布和应变分布等力学性质。

2. 地质学:小变形张量在地质学中被用于研究地壳运动、地震活动等现象。

通过分析地壳的形变情况,可以预测地震的发生概率和地震破坏的范围,对地震风险评估和地震灾害防治具有重要意义。

3. 医学工程:小变形张量在医学工程中被用于分析组织和器官的形变情况。

例如,通过分析心脏的形变情况可以评估心脏的功能状态,对心脏病的诊断和治疗具有指导意义。

4. 机器人学:小变形张量在机器人学中被用于控制机器人的运动和形变。

4种张量分解方法用于人脸识别的效果对比和分析胡小平【摘要】张量的分解是主成分分析(PCA)在高阶上的扩展,目前几种张量分解方法各有优缺点,难以满足PCA的所有性质.基于4种经典的张量分解方法并没有在人脸识别中进行比较分析,利用ORL人脸数据库比较了4种经典的张量分解方法.实验结果表明,张量方法在压缩率大的情况下,其性能有显著的提高.不同的张量分解方法显示理论上分析Higher-Order Orthogonal Iteration(HOOI)的拟和度最好,但这4种方法用到实际人脸数据上并没有多大差别.考虑到Higher-Order Singular Value Decomposition(HO-SVD)方法相对比较简单,人脸识别研究时可选用此方法.【期刊名称】《湖南城市学院学报(自然科学版)》【年(卷),期】2017(026)001【总页数】6页(P67-72)【关键词】人脸识别;张量分解;主成分分析;张量【作者】胡小平【作者单位】安庆师范大学计算机与信息学院,安徽安庆 246133【正文语种】中文【中图分类】TP391.4随着特征提取技术的发展,越来越多的特征可以采用张量的统一表示形式.传统的向量表示方法以及处理方法对于这样的特征常显得力不从心,于是研究张量的性质及运算获得广泛的关注.张量化的数据处理面临的最大问题是如何选用合适的数学工具来对它进行分析.N-mode SVD( tensor SVD)是PCA(matrix SVD)在高阶上的扩展,最早是由Tucker等[1]提出,接着不少人对它进行了扩展,但张量的分解并不能简单地看作是PCA在高阶上的简单扩展,目前还不存在一种tensor SVD能满足matrix SVD 的所有性质.并存着多种方法分解张量,这些方法都各有自己的优缺点.Lathauwer等[2]总结了使用最广泛的一种张量分解方法 HOSVD,并分析了它的相关性质及其与SVD之间的联系,接着Turney[3]总结并比较分析了当前比较流行的4种张量分解方法,分别是Higher-Order Singular Value Decomposition (HO-SVD)[2],Higher-Order Orthogonal Iteration (HOOI)[4],Slice Projection (SP)[5]和 Multislice Projection(MP)[3].因人脸是一种高维、复杂的模式,其特征呈现出张量的模式.随着张量技术的发展,张量逐渐应用到人脸领域,Vasilescu等[6-7]将多线性分析引入到人脸识别中,使用张量代数对人脸进行分析,提出了张量的多线性投影方法和Tensorfaces方法.不少研究者[8-11]也在此基础上改进了张量方法,如Cao等[12]将张量代数用于人脸聚类.不同张量分解方法对人脸识别效果的影响是不一样的,HO-SVD, HOOI, SP都曾用于人脸识别,但MP还未用于人脸识别,这几种方法都没有在人脸识别中进行比较分析.周春光等[13]在多线性主成分分析的基础上提出了基于稀疏张量的人脸图像特征提取方法.本文在ORL人脸库中结合3D-PCA[14]对这4种张量分解方法对人脸识别效果进行比较分析,并总结出可用于人脸识别研究用的较好的方法.一般把张量视为多维数组,是0维标量、1维向量和2维矩阵的n维推广,可以用来表达多线性概念的某种确定类型.在张量的概念里,把张量的维数称为阶数,如标量是0阶张量,向量是1阶张量,矩阵是2阶张量.一般情况下,维数有2个概念,一个指的是一个向量的自由度,即一个向量的分量个数;另一个跟阶数是一个意思,如2维矩阵,3维矩阵等.为了不造成概念混乱,后面用维数表示一个向量的自由度,而用阶表示维数.通过展开张量A和Z,可以得到“N-mode SVD”的矩阵表示如公式(1)所示.给定一个秩为n的矩阵,最小方误差意义上最逼近它的秩为r的矩阵,是通过SVD分解去掉较小的奇异值得到的,但这种情况并不适用于阶数 N> 2的张量,去掉较小的奇异值往往不是最好的近似,但结果一般也还可以.为了找到好的近似,Lathauwer,Turney 和Wang[2-5]等提出了不同的张量分解方法.假设是张量A的近似,那么对A的拟合度用来度量.若该值越接近1,表明拟合的越好.1.1 Higher-Order Singular Value Decomposition(HO-SVD)方法对N阶张量A的分解,HO-SVD的算法过程如下所示.输入:张量中心张量Z的维数:展开A得到计算的前个较大的特征值对应的特征向量,将这些特征向量 nJ组成的矩阵赋给 ()nU .end for.(2)计算并将其赋给Z.从该算法过程,可以看到HO-SVD分解并没有尽力去优化拟合度即没有得出一个秩为的对A较好的近似,因为只是把每阶单独优化,没考虑到各阶的相互作用.1.2 Higher-Order Orthogonal Iteration方法(4)将赋给.HOOI用HO-SVD来初始化矩阵,它从张量整体和其他的矩阵来计算每个矩阵,并尽力优化拟合度计算量较大.1.3 Slice Projection (SP)方法SP介于HO-SVD和HOOI之间,它从张量和另一个矩阵来计算每个矩阵,并尽力优化拟合度,计算量小于HOOI.1.4 Multislice Projection(MP)方法对4阶张量A的分解,MP算法过程如下所示.从上面的算法过程我们可以看到MP的基本结构来自于SP,可是MP用了所有的矩阵去计算每一个矩阵,而不是只用一个矩阵,计算量略大于SP,但拟合效果较好.Turney[3]总结了这 4种方法并做了实验,总体上来说,相比HO-SVD和HOOI需要较大的内存,SP和MP能处理大张量,速度也较好,拟合度最好的是 HOOI,接着是 MP, SP, 最差的是HO-SVD.接下来我们将这4种方法应用到人脸识别的研究中,以分析其对人脸识别的影响.为了验证算法的有效性,在ORL人脸库上进行了实验,见图 1.ORL人脸库[15]是剑桥大学AT&T 实验室在1992-1994年间收集,它包括40个不同的人,每个人有 10幅不同的图像,总共400张,均是 256级的大小为92×112的灰度图像.该数据库包含了光照、人脸表情(眼睛睁开或闭上,微笑或不微笑)和面部饰物(戴眼镜或者不戴)的轻微变化.在ORL人脸库中用10-fold交叉验证方法,即轮流将每个人的9张图片作为训练集,剩下的一张作为测试集,这样进行10次,10次结果的均值作为人脸识别率.将训练图象按图2组成3阶张量,用D表示(D是一个92×112×360的张量),接着用HO-SVD, HOOI, SP或MP分解D.D=Z×1U1×2U2×3U3.最后运用3D-PCA识别人脸.3D-PCA算法步骤如下所示.训练过程:输入:训练人脸数据D.输出:投影特征矩阵ProjectedImages,投影矩阵U1和U2,样本均值m.(2)按照之前描述的方法用HO-SVD, HOOI, SP或MP分解张量D得到U1和U2;(3)计算赋给矩阵ProjectedImages.测试过程:输入:未知类别的人脸图像矩阵I和投影特征矩阵ProjectedImages,投影矩阵U1和U2,样本均值m.输出:该人脸所属类别.(1)中心化I:I = I-m;(2)将I向U1和U2投影赋给矩阵T;(3)计算T和ProjectedImages (:,:,i), (i=1,…,N)的欧式距离,最小距离对应的那张图像就是该未知图像所属的人脸.这里我们通过识别率随压缩率的变化来比较这4种张量分解方法和PCA方法,压缩率的计算方式如下.假设训练图象大小为m×n,图象个数为N,张量分解方法中图象压缩为m1×n1,PCA方法中图象压缩为m2.则张量分解方法压缩率r1=(N×n1×n2)/(N×m1×n1+m×n1+m1×n),PCA方法压缩率r2=(N×n1×n2)/(N×m2+m×n×n2).如图3所示,从实验结果中我们可以看到,4种张量分解方法明显优于PCA方法,而这4种张量方法从图中看不出差别.我们用表格的形式来仔细比较这4种张量分解方法的结果,如表1所示,可以看到4种张量分解方法在相同的压缩率下的识别率基本相同,即使有不同也差别不大,难以看出明显规律.文献[3]中指出拟合度最好的是HOOI,接着是MP,SP,最差的是HO-SVD.这样效果最好的应该是HOOI,接着是MP,SP,最差的是HO-SVD,这跟表1的实验结果并不相符.文献[3]中用来做实验的数据最小是250×250×250,在张量较小的情况下HO-SVD的拟合度也不错,因此效果不是很明显,而我们用到的人脸数据是92×112×360,这是与实验结果不相符的原因之一,另外影响人脸识别的因素较多,不一定拟合度越高,识别率越高.考虑到用来做实验的人脸图象较小,所对应的张量都不是大张量,而HO-SVD比较简单,而且文献[2]指出尽管HO-SVD计算过程中并不验证拟合度,但它分解出来的拟合度一般都还不错.于是,基于张量框架的人脸识别实验涉及的张量分解方法可以采用HO-SVD方法.本文分析了几种张量分解方法,并在 ORL人脸数据库上分析了4种经典的张量分解方法和PCA方法对人脸识别研究的影响.结果表明,相比PCA方法,张量方法在压缩率大的情况下性能有着显著的提高.另外,对比不同的张量分解方法,我们发现,尽管理论上分析HOOI拟和度最好,但用到实际人脸数据上这4种方法并没有多大差别,这主要是由于人脸图象较小,不涉及大张量.鉴于HO-SVD方法比较简单,对于人脸识别涉及的小张量,分解出来的拟合度都能满足需求,因此可选用HO-SVD方法用于人脸识别研究.[1]Tucker L R. Some mathematical notes on three mode factor analysis[J]. Psychometrika, 1966. 31(3): 279–311.[2] Lathauwer L D, Moor B E, Vandewalle J. A multilinear singular value decomposition[J]. SIAM Journal on Matrix Analysis and Applications, 2000, 21(4): 1253-1278.[3]Turney P D. Empirical evaluation of four tensor decomposition algorithms[Z]. Departmental Technical Report, 2007.[4]Lathauwer L D, Moor B E, Vandewalle J. On the best rank-1 and rank-(R1, R2, …, RN) approximation of higher-order tensors[J]. SIAM Journal onMatrix Analysis and Applications, 2000, 21(4): 1324–1342.[5]Wang H, Ahuja N. Rank-R approximation of tensors: Using image-as-matrix representation[A]//Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition[C]. San Diego: Canifornia, 2005.[6]Vasilescu M A O, Terzopoulos D. Multilinear projection for appearance-based recognition in the tensor framework [A]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition[C]. USA: Minneapois, 2007.[7] Vasilescu M A O. Multilinear projection for face recognition via canonical decomposition[A]//Proceedings 2011 IEEE International Conference on Automatic Face & Gesture Recognition[C]. USA: Santa Barbara, 2011.[8] Hao N, Kilmer M E, Braman K,et al. Facial recognition using Tensor-Tensor Decompositions[J]. Society for Industrial and Applied Mathematics. 2013, 6(1): 437-463.[9]Zhang F, Qi L, Chen E Q. Face Recognition via Multi linear Principal Component Analysis and Two-Dimensional Extreme Learning Machine[J]. Journal of Computational and Theoretical Nanoscience, 2015, 12(7): 1138-1146.[10]Zhang F, Wang X, Sun K. A report on multilinear PCA plus GTDA to deal with Face Image [J]. Cybernetics and Information Technologies, 2016, 16(1): 146-157.[11]Lita L, Pelican E. A low-rank tensor-based algorithm for facerecognition[J]. Applied Mathematical Modelling, 2014, 39(3-4): 1266-1274.[12]Cao X, Wei X, Han Y,et al. Robust face clustering via tensor decomposition[J]. IEEE Transactions on Cybernetics, 2015, 45(11): 2546-2557.[13]周春光, 孙明芳, 王甦菁, 等. 基于稀疏张量的人脸图像特征提取[J]. 吉林大学学报, 2012, 42(6): 1521-1526.[14]胡小平. 基于张量的多线性思想对主成份分析方法的改进[J].安庆师范学院学报, 2012,18(4): 38-43.[15]Chen W S, Zhao Y, Pan B B,et al. Supervised kernel nonnegative matrix factorization for face recognition[J]. Neurocomputing, 2016, 205: 165-181.。

概括张量奇异值分解-概述说明以及解释1.引言1.1 概述概述部分的内容可以描述张量奇异值分解的基本概念和重要性。

张量奇异值分解是将一个张量表示为多个部分的乘积的方法,类似于矩阵的奇异值分解。

通过这种分解,我们可以更好地理解张量的内在结构,并利用奇异值分解的性质进行数据降维、特征提取和信息压缩等操作。

张量奇异值分解在多领域中有着广泛的应用,包括图像处理、语音识别、推荐系统等,因此对于深入理解和应用张量奇异值分解具有重要的意义。

本文将对张量奇异值分解的原理和应用进行详细介绍,旨在帮助读者更好地理解和应用这一重要的数学工具。

1.2 文章结构文章结构部分的内容:本文共分为三个部分,分别是引言、正文和结论。

在引言部分,将会对张量奇异值分解进行概述,介绍文章的结构和目的。

在正文部分,将会详细讨论张量的基本概念、奇异值分解的原理以及张量奇异值分解的应用。

最后在结论部分,将会总结张量奇异值分解的重要性,展望未来的研究方向,并得出结论。

整篇文章将会全面深入地介绍张量奇异值分解的相关知识和应用。

1.3 目的文章旨在通过对张量奇异值分解的深入研究,探讨其在数据分析和机器学习领域的重要性和应用。

通过对张量和奇异值分解的基本概念和原理进行讲解,希望能够帮助读者更好地理解张量奇异值分解的内在机制和操作方法。

同时,通过介绍张量奇异值分解在实际问题中的应用,展示其在解决高维数据分析、图像处理、推荐系统和其他领域中的重要作用。

最终,本文旨在激发读者的兴趣,进一步深入研究张量奇异值分解,并展望未来在该领域的研究方向和应用前景。

2.正文2.1 张量的基本概念在数学和物理学中,张量是一个多重线性映射的代数对象,它可以表示在向量、标量和其他张量上的线性函数。

张量可以用来描述物体在各个方向上的应力和变形,也可以用来表示物理场的强度和方向。

在工程、物理、计算机科学和机器学习等领域中,张量都有广泛的应用。

张量的概念最早是由黎曼引入的,张量的定义要依靠对线性映射的理解。

张量链式分解引言张量链式分解(Tensor Chain Decomposition)是一种用于对多维数据进行降维和特征提取的技术。

它广泛应用于各个领域,包括图像处理、语音识别、推荐系统等。

本文将介绍张量链式分解的基本概念、原理、方法和应用,并探讨其优缺点以及未来的发展方向。

张量基础知识在深入讲解张量链式分解之前,我们先来了解一些张量的基础知识。

1. 张量的定义首先,我们需要明确张量(Tensor)的概念。

在数学和物理学中,张量是一种多维数组或矩阵的推广。

例如,0阶张量是标量(Scalar),1阶张量是向量(Vector),2阶张量是矩阵(Matrix),以此类推。

2. 张量的表示张量可以用多种方式进行表示,包括矩阵、数组和张量的分块表示等。

其中,张量的分块表示可以简化数据的处理和计算。

3. 张量的运算和矩阵类似,张量也支持多种运算,包括加法、减法、乘法、求逆等。

这些运算可以用于数据的变换和处理。

张量链式分解的基本概念接下来,我们将介绍张量链式分解的基本概念。

1. 张量链的定义张量链(Tensor Chain)是指由多个张量组成的序列。

每个张量可以有不同的维度和大小,但它们的维度必须满足一定的连续性条件。

2. 张量链的分解张量链的分解是将复杂的张量链表示为一系列低阶张量的乘积的过程。

分解后的低阶张量包含了原始张量链的信息,并可以用于降维和特征提取。

3. 张量链式分解的原理张量链式分解的原理是基于张量的秩的概念。

张量的秩是指表示张量的低阶张量的个数。

通过适当的张量链分解,可以降低张量的秩,从而实现降维和数据压缩。

张量链式分解的方法张量链式分解有多种方法和算法,下面介绍其中几种常见的方法。

1. CP分解(CANDECOMP/PARAFAC)CP分解是一种基于多线性代数的张量分解方法。

它将一个高阶张量表示为多个低阶张量的和。

CP分解具有数学上的优良性质和可解释性,被广泛应用于数据分析和模型简化。

2. Tucker分解Tucker分解是一种将一个高阶张量分解为一系列核张量与模态矩阵的乘积的方法。