最小距离分类法

- 格式:ppt

- 大小:90.50 KB

- 文档页数:5

最短距离法最短距离法是最近年来在分类学习和数据挖掘领域中较为流行的一种机器学习方法。

它的目的是从训练数据集中学习,并形成一种可以从新观察中推断出未知数据的判断方法。

本文介绍了最短距离法的基本概念、原理及其应用,结合例子进一步剖析了这种机器学习方法的核心思想。

一、什么是最短距离法最短距离法(k-nearest neighbors algorithm, k-NN)是一种基本分类算法,它通过测量不同特征值之间的距离来确定实例标签(类别)。

它的工作思路是:先从训练集中找出与当前实例(测试数据)最相似的k个实例,然后统计这k个实例中属于每一类别的实例数目,最后把当前实例分类到实例数目最多的类别中。

最短距离法的计算过程可以概括为:给定一个由N个特征表示的实例X,首先求出它到训练集中每个实例的距离,然后取出距离最小的k个实例,统计这k个实例中各类别的实例数,把X分类到实例数最多的类别中。

二、最短距离法的原理最短距离法的思想是,给定一个实例X,将它与训练集中的实例进行对比,利用距离的大小(越小越相似,越大越不相似)来判断X 的类别。

即:“物以类聚,人以群分”的思想。

最短距离法主要有两种距离计算方式:欧几里得距离(Euclidean Distance)和曼哈顿距离(Manhattan Distance),两者的计算方式不同,欧几里得距离适用于连续型变量,曼哈顿距离适用于离散型变量。

三、最短距离法的应用最短距离法的应用是模式分析的一个重要的挖掘工具,其主要用于分类任务。

它可以用于赛车、机器人、运动视觉系统等多种应用中。

由于最短距离法的简单性和高效的计算,它也被广泛应用于对用户行为分析、文档分类、图像分类、文字处理、计算生物学研究和金融研究等领域。

四、例子分析下面以一个简单的例子来说明最短距离法实例分类的过程:假设我们有一组三维数据,其中存在两类,[A类:[10,20,30], [20,30,40], [30,40,50]],[B类:[50,60,70], [60,70,80], [70,80,90]],现有一个需要分类的新实例:[40,50,60],我们使用最短距离法来确定其类别。

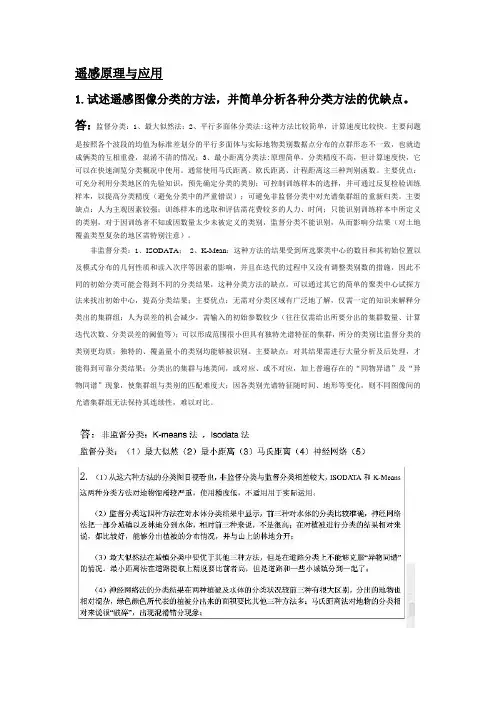

遥感原理与应用1.试述遥感图像分类的方法,并简单分析各种分类方法的优缺点。

答:监督分类:1、最大似然法;2、平行多面体分类法:这种方法比较简单,计算速度比较快。

主要问题是按照各个波段的均值为标准差划分的平行多面体与实际地物类别数据点分布的点群形态不一致,也就造成俩类的互相重叠,混淆不清的情况;3、最小距离分类法:原理简单,分类精度不高,但计算速度快,它可以在快速浏览分类概况中使用。

通常使用马氏距离、欧氏距离、计程距离这三种判别函数。

主要优点:可充分利用分类地区的先验知识,预先确定分类的类别;可控制训练样本的选择,并可通过反复检验训练样本,以提高分类精度(避免分类中的严重错误);可避免非监督分类中对光谱集群组的重新归类。

主要缺点:人为主观因素较强;训练样本的选取和评估需花费较多的人力、时间;只能识别训练样本中所定义的类别,对于因训练者不知或因数量太少未被定义的类别,监督分类不能识别,从而影响分结果(对土地覆盖类型复杂的地区需特别注意)。

非监督分类:1、ISODATA; 2、K-Mean:这种方法的结果受到所选聚类中心的数目和其初始位置以及模式分布的几何性质和读入次序等因素的影响,并且在迭代的过程中又没有调整类别数的措施,因此不同的初始分类可能会得到不同的分类结果,这种分类方法的缺点。

可以通过其它的简单的聚类中心试探方法来找出初始中心,提高分类结果;主要优点:无需对分类区域有广泛地了解,仅需一定的知识来解释分类出的集群组;人为误差的机会减少,需输入的初始参数较少(往往仅需给出所要分出的集群数量、计算迭代次数、分类误差的阈值等);可以形成范围很小但具有独特光谱特征的集群,所分的类别比监督分类的类别更均质;独特的、覆盖量小的类别均能够被识别。

主要缺点:对其结果需进行大量分析及后处理,才能得到可靠分类结果;分类出的集群与地类间,或对应、或不对应,加上普遍存在的“同物异谱”及“异物同谱”现象,使集群组与类别的匹配难度大;因各类别光谱特征随时间、地形等变化,则不同图像间的光谱集群组无法保持其连续性,难以对比。

最大似然法和最小距离法分类边界示例文章篇一:哎呀,我不太懂什么是最大似然法和最小距离法分类边界呢,这听起来好复杂呀!老师在课堂上讲这些的时候,我感觉脑袋都要晕啦!就好像我在森林里迷路,找不到出去的方向。

我看看啊,最大似然法,这是不是就像我们在一堆水果里猜哪种水果最多?比如说有一堆苹果、香蕉和橙子,我们要根据看到的一部分水果来猜哪种水果是这一堆里数量最多的。

那最小距离法呢,是不是有点像我们找自己的小伙伴,谁离我们最近,我们就先找谁玩?我同桌小明就说:“这最大似然法不就是凭感觉猜嘛!”我赶紧反驳他:“才不是呢,这是有根据的推测!” 可他还不服气,哼!老师说最大似然法是通过一些数据来计算哪种可能性最大。

这就好比我们猜考试谁能考最高分,不能随便瞎猜,得看看平时谁学习最认真,作业完成得最好。

而最小距离法呢,老师举了个例子,就好像我们把不同的动物分类,看哪种动物跟哪种动物长得最像,距离最近,就归为一类。

我跟后桌的小红讨论,我说:“这也太难理解啦,怎么才能分得清楚呀?”小红说:“多想想,多做做题目就懂啦。

”我还是有点迷糊,这两种方法到底有啥用呀?难道只是为了让我们头疼吗?后来我发现,其实在生活中也能用到呢。

比如说我们选衣服,要选适合自己的风格,这是不是也有点像在分类?还有选朋友,跟自己兴趣爱好差不多,性格合得来的,不也是一种分类嘛。

我觉得呀,这最大似然法和最小距离法分类边界虽然一开始让人摸不着头脑,但是仔细想想,还是挺有意思的,能帮我们解决好多问题呢!示例文章篇二:哎呀,这“最大似然法”和“最小距离法”分类边界可真是让人头疼!对于我这个还在上学的小朋友来说,一开始听到这两个词,简直就像掉进了一个充满奇怪符号和公式的迷宫里。

咱先来说说这个最大似然法吧。

就好像我们在玩猜谜语的游戏,要从好多好多的可能性里,找出最有可能的那个答案。

比如说,我们要猜一个盒子里有几个红球几个白球,我们通过一次次地从盒子里拿球,然后根据拿出来球的情况去猜盒子里球的分布,这是不是就有点像最大似然法呀?我们就是要找到那个最有可能的情况。

以各类平均值为类中心的最小距离法原理csdn1.引言1.1 概述引言部分是文章的开篇,它主要介绍文章的背景和目的。

对于本篇文章来说,概述部分应该包括以下内容:概述部分旨在介绍以各类平均值为类中心的最小距离法的原理及其在实际应用中的重要性。

在数据分析和模式识别领域,聚类分析是一种常用的数据分析方法。

它通过将相似的数据点划分为不同的簇,从而揭示数据中的隐藏模式和结构。

而各类平均值为类中心的最小距离法作为聚类算法的一种,其原理是基于样本点与类中心之间的距离来划分数据簇。

其中,类中心是指数据簇的中心点,而各类平均值指的是各个数据簇中样本点的平均值。

这种聚类方法有着广泛的应用场景,例如在数据聚类中,可以帮助我们将大量的数据点划分为不同的簇,从而理解和发现数据的内在结构。

此外,在模式识别中,该方法也可以帮助我们识别和分类不同的模式。

通过本文,我们将深入探讨各类平均值为类中心的最小距离法的原理和计算方法,并针对其在数据聚类和模式识别中的应用进行案例分析。

最后,我们将总结该方法的优势和局限性,并探讨其未来的发展方向。

总之,以各类平均值为类中心的最小距离法是一种重要的聚类算法,它在数据分析和模式识别中具有广泛的应用前景。

通过本文的介绍和分析,相信读者能够更深入地理解和应用该方法。

1.2文章结构文章结构部分的内容可以如下所示:1.2 文章结构本文将分为三个主要部分来介绍以各类平均值为类中心的最小距离法的原理和应用。

首先,在引言部分我们将对该方法进行概述,并阐明文章的目的。

接着,在正文部分,我们将详细介绍各类平均值为类中心的最小距离法的原理,包括类中心的定义和作用,以及各类平均值的计算方法。

然后,我们将探讨该方法在数据聚类和模式识别中的应用场景和案例。

最后,在结论部分,我们将总结各类平均值为类中心的最小距离法的优势和局限性,并提出未来的发展方向。

通过这样的文章结构,读者将能够全面了解该方法的基本原理和应用领域,以及对其进行深入思考和讨论。

遥感原理与应用第8章遥感作业遥感原理与应用第8章遥感作业第八章遥感图像自动识别分类名词解释:遥感技术图像自动分类光谱特征向量特征空间特征转换特征选择kl转换哈达玛转换kt转换判别函数辨别规则错分概率最小似然法分类最轻距离法分类监督分类非监督分类k均值聚类混为一谈矩阵用户精度制图精度1、遥感图像自动分类:采用决策理论或统计方法,按照决策理论方法,需要从被识别的模式中提取一组反映模式属性的量测值,称之为特征,并把模式特征定义在一个特征空间中,进而利用决策的原理对特征空间进行划分。

2、光谱特征向量:同名地物点在不同波段图像中亮度的观测量构成一个多维的随机向量x,称为光谱特征向量。

3、特征空间:传感器接收器输入的就是一组n个测量值,这一组几个测量值可以看作就是n维空间,称作特征空间。

4、特征变换:是将原有的m个测量值集合并通过某种变换,产生n个(n<=m)新的特征,这种方法称为特征变换。

5、特征选择:从旧有的m个测量值子集中,按某一准则挑选出来n个特征。

6、kl转换:就是一种线性变换,就是就均方误差最轻来说的最佳正交变换。

能将原来多个波段中的有价值信息尽量分散至数目尽可能少的特征图像组中去,达至数据压缩的目的,同时也能够并使代莱特征图像之间互不有关,并使代莱特征图像涵盖的信息内容不重合减少类别的可分性。

7、哈达玛变换:利用哈达玛矩阵作为变换矩阵新实施的遥感多光谱域变换。

8、kt变换:又称穗帽变换,是一种线性特征变换。

将mss影像通过k-t变换得到不同地物类别的分量值,形成的图形像一个穗帽。

9、判别函数:各个类别的辨别区域确认后,某个特征矢量属哪个类别可以用一些函数去则表示和辨别,这些函数就称作判别函数。

10、判别规则:当计算完某个矢量在不同类别判别函数中的值后,我们要确定该矢量属某类就必须得出一个推论的依据。

如若获得函数值最小则该矢量属最大值对应的类别,这种推论的依据我们称作辨别规则。

11、错分概率:是类别判别分界两侧做出不正确判别的概率之和。

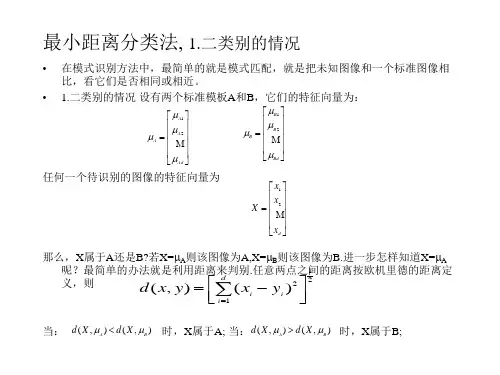

最小距离判别法

最小距离判别法是一种分类分析的技术,它也被称为最近邻分类法或最近邻判别法。

最小距离判别法是一种基于距离(特征值)的分类算法,用于分类数据集中的对象。

它将输入对象与训练样本中的每个对象进行比较,以计算输入对象与训练样本中每个对象之间的距离。

然后,将训练样本中的最近的邻居分配给输入对象,以决定其类别。

最小距离判别法的基本原理是将新的对象放入训练样本中,并将它与训练样本中的每个对象进行比较,以计算它们之间的距离。

当计算完所有输入对象与训练样本中每个对象之间的距离后,最小距离法将训练样本中最近的邻居分配给输入对象,以决定其类别。

最小距离判别法的优点包括:它是一种简单的分类算法,不需要任何训练;它能够处理数据集中的缺失值;它可以在高维空间中搜索;它可以处理多类别分类问题;它可以处理变量不平衡的数据集;它具有极高的计算效率,可以在短时间内处理大量的数据;它具有高度可扩展性,可以添加新的样本数据。

最小距离判别法是一种经典的分类算法,它具有计算效率高、易于实现等优点,因此广泛应用于数据挖掘、机器研究等领域。

它可以有效地处理数据集中缺失值、变量不平衡和多类别分类等问题,但也存在一些缺点,例如:容易出现过拟合现象,受到距离度量方法的影响等。

因此,在使用最小距离判别

法时,需要结合自身情况,选择合适的距离度量方法,尽量避免过拟合现象的出现。

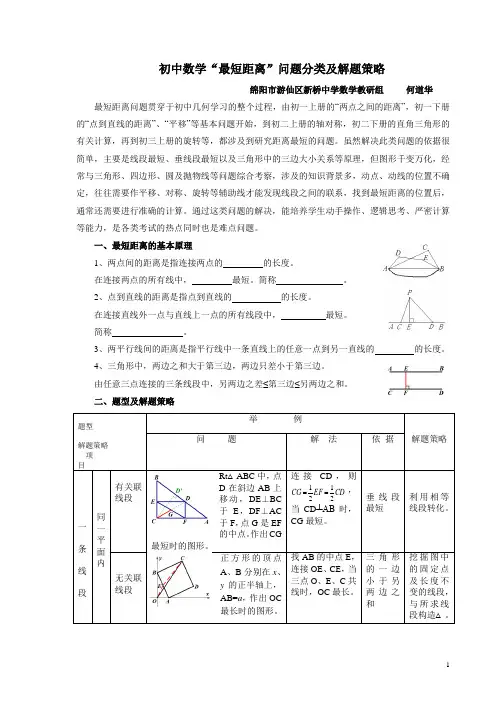

初中数学“最短距离”问题分类及解题策略绵阳市游仙区新桥中学数学教研组何道华最短距离问题贯穿于初中几何学习的整个过程,由初一上册的“两点之间的距离”,初一下册的“点到直线的距离”、“平移”等基本问题开始,到初二上册的轴对称,初二下册的直角三角形的有关计算,再到初三上册的旋转等,都涉及到研究距离最短的问题。

虽然解决此类问题的依据很简单,主要是线段最短、垂线段最短以及三角形中的三边大小关系等原理,但图形千变万化,经常与三角形、四边形、圆及抛物线等问题综合考察,涉及的知识背景多,动点、动线的位置不确定,往往需要作平移、对称、旋转等辅助线才能发现线段之间的联系,找到最短距离的位置后,通常还需要进行准确的计算。

通过这类问题的解决,能培养学生动手操作、逻辑思考、严密计算等能力,是各类考试的热点同时也是难点问题。

一、最短距离的基本原理1、两点间的距离是指连接两点的的长度。

在连接两点的所有线中,最短。

简称。

2、点到直线的距离是指点到直线的的长度。

在连接直线外一点与直线上一点的所有线段中,最短。

简称。

3、两平行线间的距离是指平行线中一条直线上的任意一点到另一直线的的长度。

4、三角形中,两边之和大于第三边,两边只差小于第三边。

由任意三点连接的三条线段中,另两边之差≤第三边≤另两边之和。

二、题型及解题策略题型解题策略项目举例解题策略问题解法依据一条线段同一平面内有关联线段Rt△ABC中,点D在斜边AB上移动,DE⊥BC于E,DF⊥AC于F,点G是EF的中点。

作出CG最短时的图形。

连接CD,则CDEFCG2121==,当CD┴AB时,CG最短。

垂线段最短利用相等线段转化。

无关联线段正方形的顶点A、B分别在x、y的正半轴上,AB=a,作出OC最长时的图形。

找AB的中点E,连接OE、CE,当三点O、E、C共线时,OC最长。

三角形的一边小于另两边之和挖掘图中的固定点及长度不变的线段,与所求线段构造△。

空间距离求一只蚂蚁从点A沿正方体表面爬到点G的最短距离。

最小ecm法则和fisher判别法的区别摘要:一、引言二、最小ECM法则简介1.定义及原理2.算法步骤3.优点与不足三、Fisher判别法简介1.定义及原理2.算法步骤3.优点与不足四、最小ECM法则与Fisher判别法的区别1.目标函数不同2.应用场景不同3.性能比较五、实例分析六、结论与展望正文:一、引言在机器学习领域,分类算法众多,最小ECM法则和Fisher判别法是其中两种常用的基于距离的分类方法。

本文将详细介绍这两种方法的区别,以帮助读者更好地理解它们的原理和应用。

二、最小ECM法则简介1.定义及原理最小ECM法则(Minimum Euclidean Distance Classification Rule),又称为最小距离分类法,是一种基于欧氏距离的分类方法。

它要求在训练样本中找到一个使得各类别中心到样本点的欧氏距离之和最小的分类。

2.算法步骤(1)计算每个类别的中心;(2)计算每个样本点到各个类别中心的距离;(3)找到距离之和最小的类别作为样本点的类别。

3.优点与不足优点:算法简单,易于实现。

不足:对于多维数据,计算量较大;对噪声敏感;对于类间距相近的情况,分类效果较差。

三、Fisher判别法简介1.定义及原理Fisher判别法(Fisher Discriminant Analysis),又称为Fisher 分类法,是一种基于线性判别函数的分类方法。

它通过构建一个线性判别函数,使得不同类别的样本在特征空间中的分布尽量分开。

2.算法步骤(1)计算各类别中心;(2)计算各类别中心之间的距离;(3)求解线性判别函数的系数;(4)对样本点进行分类。

3.优点与不足优点:分类效果较好,对噪声具有较好的抗干扰能力;计算量相对较小。

不足:对类间距较小的类别区分效果较差;对非线性分类问题解决能力有限。

四、最小ECM法则与Fisher判别法的区别1.目标函数不同最小ECM法则关注的是各类别中心到样本点的欧氏距离之和,目标是最小化这个距离之和。

最小距离法

最小距离法是一种最常见的模式识别技术,它的主要思想是最小化

平方误差。

它的特点是受空间分布的影响小,可以用于不严格的线性

关系拟合。

它也可以用于非结构化数据测量中的相关系数和正确率。

1、原理

最小距离法是一种统计分析方法,它原理是用来多变量数据分类或识

别方面。

它基于变量之间距离的统计度量,利用最大匹配原理或最小

化误差平方和原理来实现样本点的正确分类,是以两个事件的距离大

小来判断是否是同一类或相关的。

2、方法

(1)最近邻法:最近邻法是最主要的最小距离法,它把样本点分配给

最近的目标分类,尽可能的最小化分类误差,但会存在一定的误差。

(2)最小二乘法:这种方法有一个先验假设:样本数据不具有噪声,

只有少量的误差,实际上,它主要是多变量数据的线性拟合应用。

(3)加权最小二乘法:该方法可以首先把不存在线性关系的样本点的

权值设置的较小,以此减少在线性关系数据上的影响。

(4)第三类版本:它是最小距离法的一种特殊类型,其核心思想是通

过给定目标实例分类给不同分数,然后实现分数值最接近的样本分类。

3、应用

最小距离法主要应用于特征提取、数据划分、识别分类等,在机器学习、数据挖掘、人工智能等方面具有重要意义。

常用于图像分割、图

像聚类、文本分类、推荐系统等,基于它能够根据数据的密度差异,

发现数据的潜在关联。

另外,最小距离法不仅仅可以作为分类器应用,还可以用于在不带有结构的数据上进行测量,例如计算两个变量的相

关系数或正确率。

微型计算机系统(简称微机系统)与传统的计算机系统一样,也是由硬件系统和软件系统两大部分组成。

计算机硬件系统由控制器、运算器、存储器、输入设备、输出设备五大基本部件构成。

软件系统由系统软件和应用软件两大部分组成。

系统软件包括操作系统、语言处理程序、数据库管理系统、网络通信管理程序等部分。

应用软件包括的面非常广,它包括用户利用系统软件提供的系统功能、工具软件和其它实用软件开发的各种应用软件。

当前使用比较多的操作系统有UNIX、Linux,MS-DOS 和Windows操作系统。

内存又称为主存,分为随机存储RAM和只读存储器ROM两种,速度比外存快由于CPU比内存速度快,目前,在计算机中还普遍采用了一种比主存储器存取速度更快的超高速缓冲存储器,即Cache,置于CPU 与主存之间,以满足CPU 对内存高速访问的要求。

有了CaChe 以后,CPU 每次读操作都先查找CaChe,如果找到,可以直接从Cache中高速读出;如果不在CaChe中再由主存中读出在微型计算机中,常用的外存有磁盘、光盘和磁带,磁盘又可以分为硬盘和软盘。

基数是指该进制中允许选用的基本数码的个数。

每一种进制都有固定数目的计数符号。

十进制:基数为10,10个记数符号,0、1、2、……9。

每一个数码符号根据它在这个数中所在的位置(数位),按“逢十进一”来决定其实际数值。

二进制:基数为2,2 个记数符号,0 和1。

每个数码符号根据它在这个数中的数位,按“逢二进一”来决定其实际数值。

八进制:基数为8,8个记数符号,0、1、2、……7。

每个数码符号根据它在这个数中的数位,按“逢八进一”来决定其实际的数值。

十六进制:基数为16,16个记数符号,0-9,A,B,C,D,E,F。

其中A~F对应十进制的10~15。

每个数码符号根据它在这个数中的数位,按“逢十六进一”决定其实际的数值。

字节简写为B,人们采用8位为1个字节。

1个字节由8个二进制数位组成。

字节是计算机中用来表示存储空间大小的基本容量单位。

监督分类中常用的具体分类方法包括:最小距离分类法(minimum distance classifier):最小距离分类法是用特征空间中的距离作为像元分类依据的。

最小距离分类包括最小距离判别法和最近邻域分类法。

最小距离判别法要求对遥感图像中每一个类别选一个具有代表意义的统计特征量(均值),首先计算待分象元与已知类别之间的距离,然后将其归属于距离最小的一类。

最近邻域分类法是上述方法在多波段遥感图像分类的推广。

在多波段遥感图像分类中,每一类别具有多个统计特征量。

最近邻域分类法首先计算待分象元到每一类中每一个统计特征量间的距离,这样,该象元到每一类都有几个距离值,取其中最小的一个距离作为该象元到该类别的距离,最后比较该待分象元到所有类别间的距离,将其归属于距离最小的一类。

最小距离分类法原理简单,分类精度不高,但计算速度快,它可以在快速浏览分类概况中使用。

多级切割分类法(multi-level slice classifier):是根据设定在各轴上值域分割多维特征空间的分类方法。

通过分割得到的多维长方体对应各分类类别。

经过反复对定义的这些长方体的值域进行内外判断而完成各象元的分类。

这种方法要求通过选取训练区详细了解分类类别(总体)的特征,并以较高的精度设定每个分类类别的光谱特征上限值和下限值,以便构成特征子空间。

多级切割分类法要求训练区样本选择必须覆盖所有的类型,在分类过程中,需要利用待分类像元光谱特征值与各个类别特征子空间在每一维上的值域进行内外判断,检查其落入哪个类别特征子空间中,直到完成各像元的分类。

多级分割法分类便于直观理解如何分割特征空间,以及待分类像元如何与分类类别相对应。

由于分类中不需要复杂的计算,与其它监督分类方法比较,具有速度快的特点。

但多级分割法要求分割面总是与各特征轴正交,如果各类别在特征空间中呈现倾斜分布,就会产生分类误差。

因此运用多级分割法分类前,需要先进行主成分分析,或采用其它方法对各轴进行相互独立的正交变换,然后进行多级分割。

envi5.6最小距离法分类随着数字影像技术的不断发展和应用,遥感影像数据在地质勘探、环境监测、城市规划等领域得到了广泛的应用。

在遥感影像分类中,最小距离法是一种简单而有效的分类方法。

本文将对envi5.6最小距离法分类进行介绍和分析。

一、最小距离法概述最小距离法是一种基于样本点的分类方法,其基本思想是将待分类像元与已知类别的样本点进行比较,按照某种度量标准计算它们之间的相似度,然后将像元归入与其距离最近的样本点所对应的类别中。

最小距离法的主要优点是计算简单,易于理解和实现。

它不仅适用于单波段影像数据,也可以在多波段或高维数据上进行分类,因此得到了广泛的应用。

二、envi5.6最小距离法分类的基本原理envi5.6是一款常用的遥感影像处理软件,其最小距离法分类工具是其自带的影像分类功能之一。

在envi5.6中,最小距离法分类的基本原理是利用待分类像元与已知类别的样本点之间的欧氏距离来判断待分类像元所属的类别。

欧氏距离的计算公式为:D=sqrt[(x1-y1)^2+(x2-y2)^2+...+(xn-yn)^2]其中D表示欧氏距离,x1、x2、...、xn表示待分类像元的特征值,y1、y2、...、yn表示已知类别的样本点的特征值。

根据欧氏距离的计算结果,将待分类像元划分给与其距离最近的样本点所对应的类别。

三、envi5.6最小距禁法分类的操作步骤在envi5.6中进行最小距离法分类的操作步骤如下:1. 打开envi5.6软件,加载需要分类的遥感影像数据;2. 确定影像数据的类别数量,并在影像上选择代表每个类别的样本点;3. 确定分类所需的波段组合或特征值,并进行相应的数据预处理和特征提取;4. 在envi5.6中调用最小距离法分类工具,设置分类参数和样本点,运行分类算法;5. 完成分类后,对分类结果进行验证和调整,得到最终的分类图像。

四、envi5.6最小距离法分类的优缺点分析envi5.6最小距禁法分类作为一种简单而有效的分类方法,具有以下优点:1. 计算简单、易于理解和实现;2. 不受数据维度和波段数量的限制,适用于多种不同类型的遥感影像数据;3. 可以结合其他遥感数据处理和分析方法,提高分类的精度和稳定性。

遥感与数字图像处理基础知识一、名词解释:数字影像:数字图像指用计算机存储和处理的图像,是一种空间坐标和灰度均不连续、以离散数学原理表达的图像。

空间域图像:由图像像元组成的空间频率域图像:以空间频率(即波数)为自变量描述图像的特征图像采样:将空间上连续的图像变换成离散点的操作称为采样灰度量化:将像素灰度值转换为整数灰度级的过程像素:数字图像最基本的单位是像素,像素是A/D转换中的取样点,是计算机图像处理的最小单元,每个像素具有特定的空间位置和属性特征二、填空题:1、光学图像是一个_____二维的连续的光密度______ 函数。

2、数字图像是一个_____二维的离散的光密度______ 函数。

3、光学图像转换成数字影像的过程包括________采样和量化_______ 等步骤。

4、一般来说,采样间距越大,图像数据量___越少_____,质量_____越差_____;反之亦然。

5、遥感分类中按遥感平台可分为__航天遥感__、__航空遥感__和__地面遥感__。

按传感器的探测波段可分为:__可见光遥感___、__红外遥感___和__微波遥感__。

按工作方式可分为:__主动遥感___和__被动遥感__。

6、遥感机理是通过利用__传感器__主动或被动地接受地面目标__太阳辐射的反射__或__自身反射__的__电磁波__,通过__非接触传感器__所传递的信息来识别目标,从而达到__遥测目标地物的几何与物理特性__的目的。

7、黑体的性质是吸收率为_1__,反射率为_0__。

8、水体的反射主要集中在__蓝绿__波段,其它波段吸收都很强,近红外吸收更强。

9、常见的遥感平台有__地面平台__、__航天平台__、__航空平台__、_____和__宇航平台__等。

10、通常把电磁波通过大气层时较少被反射、吸收或散射的,通过率较高的波段称为_大气窗口__。

11、ETM的全称是__(Enhanced Thematic Mapper)增强型专题制图仪__。