一种基于无人机位姿信息的航拍图像拼接方法

- 格式:pdf

- 大小:4.23 MB

- 文档页数:8

无人机图像拼接算法的研究及实现随着近年来无人机技术的飞速发展,无人机图像拼接技术也得到了广泛的应用。

该技术可以将无人机拍摄得到的相邻区域的图像进行拼接,生成高分辨率的全景图像,提供了一种高效的地图制作和空中监测的手段。

本文将从无人机图像拼接的原理入手,分析其算法的研究,介绍常见的图像拼接算法以及其应用场景,并在最后给出一个无人机图像拼接的实现实例。

一、无人机图像拼接原理无人机的航拍图像拼接是借助现代数字图像处理技术来实现的。

该技术需要处理大量的数据,并结合图像的特征进行定位,将相邻图像进行拼接,生成全景图像。

以下是无人机图像拼接的原理图:如图所示,相机通过对地面连续拍摄,得到多幅重叠区域较多的图像。

在无人机图像拼接中,首先需要对相机进行标定,得到相机的内外参数。

然后,根据每张拍摄的图像的特征,例如SIFT特征,计算出每幅图像的特征点。

接着,通过匹配不同图像之间的特征点,建立不同图像之间的关系。

最后,运用优化算法对关系进行优化,完成图像拼接,生成全景图像。

二、无人机图像拼接的算法研究目前,无人机图像拼接的算法主要有以下几种:1. 基于特征点匹配的无人机图像拼接算法这种算法主要的思路是在多副图像上提取一些稀有的、具有代表性的特征点。

然后根据特征点的相似程度进行匹配,得到匹配点对。

匹配点对的质量好坏非常重要,其正确率和准确度直接决定了拼接后的图像质量。

这种算法的核心是对特征点的提取和匹配两个部分的处理。

由于SIFT, SURF和ORB等算子在特征提取和匹配上有着良好的效果,因此应用广泛。

2. 基于区域分割的无人机图像拼接算法该算法主要是先将输入的拍摄图像进行区域分割,将该图像分为多个区域,然后根据区域之间的相似度,通过一系列的变换操作,将这些不同区域的图像配准后合并起来生成全景图像。

这种算法具有很好的兼容性和可扩展性,能够处理不同场景和不同光照下的图像拼接。

但是该算法也存在着一些缺陷,例如耗费计算时间比较长而导致对计算机处理性能的要求比较高。

![一种基于无人机的图像拼接方法及装置[发明专利]](https://img.taocdn.com/s1/m/467b20f16bd97f192379e958.png)

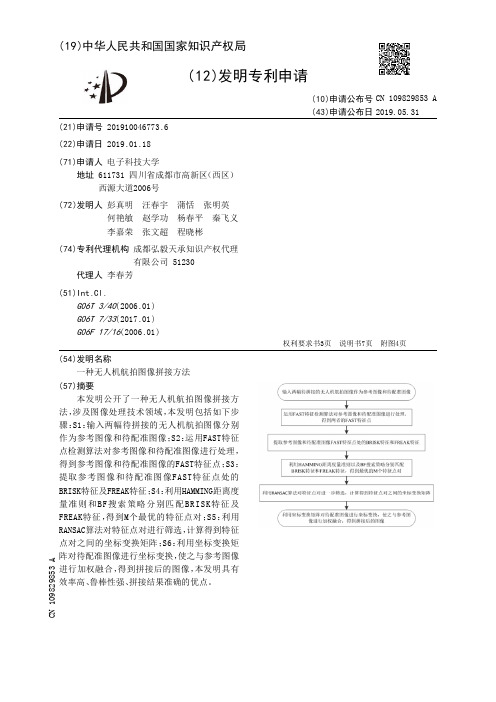

专利名称:一种基于无人机的图像拼接方法及装置专利类型:发明专利

发明人:不公告发明人

申请号:CN201810556862.0

申请日:20180531

公开号:CN108921776A

公开日:

20181130

专利内容由知识产权出版社提供

摘要:本发明涉及无人机技术领域,公开了一种基于无人机的图像拼接方法及装置,该方法包括:获取待拼接的图像,所述待拼接的图像包括第一图像和第二图像;提取所述待拼接的图像的特征点;对所述第一图像和第二图像的特征点对进行粗匹配;采用边缘检测算法进行边缘检测;去除误匹配的特征点对;采用渐入渐出的融合机制拼接所述第一图像和第二图像;通过提取的图像特征进行匹配,估算出图像间的变换矩阵,然后利用变换矩阵对齐图像,有效地消除了图像的“鬼影”现象,提高了匹配速度和拼接速度,提高了拼接准确率,硬件需求较低。

申请人:深圳市易飞方达科技有限公司

地址:518000 广东省深圳市宝安区西乡街道宝田一路臣田工业区第37栋5楼右侧

国籍:CN

代理机构:广东广和律师事务所

代理人:陈巍巍

更多信息请下载全文后查看。

无人机航拍影像拼接算法研究及应用无人机技术的发展和普及,使得无人机航拍成为了热门的领域。

随着无人机航拍的应用越来越广泛,无人机航拍影像的拼接算法研究及应用变得尤为重要。

本文将重点探索无人机航拍影像拼接算法的研究现状和应用,分析其中的挑战和发展空间。

一、无人机航拍影像拼接算法研究的现状无人机航拍影像拼接算法是指将多幅无人机拍摄的影像进行拼接,形成一幅完整的影像。

目前,已经涌现出了多种无人机航拍影像拼接算法。

其中,基于特征点匹配的算法是最常见和成熟的一种。

该算法通过提取影像中的特征点,并对这些特征点进行匹配,从而实现影像拼接。

此外,还有基于图像配准、光束法平差和多视图几何模型等算法。

在算法的研究中,需要考虑以下几个关键点:特征提取、特征匹配、坐标转换和影像融合。

特征提取主要通过图像处理技术,如边缘检测、角点检测等,从影像中提取关键的特征点。

特征匹配是通过比较两个或多个影像中的特征点,找到它们之间的对应关系。

坐标转换是将不同影像的坐标系统进行统一,以便进行影像配准和融合。

影像融合是将多张影像拼接为一幅完整的影像,需要考虑色彩一致性和无缝衔接。

二、无人机航拍影像拼接算法应用无人机航拍影像拼接算法的应用十分广泛,以下是几个典型的应用场景:1. 地理测绘与地形建模:利用无人机航拍影像,通过拼接算法可以生成高精度的地图和地形模型,用于土地规划、环境监测、灾害评估等领域。

2. 建筑工程与城市规划:通过无人机航拍影像的拼接,可以实现建筑物的三维模型重建、朝向分析和遥感检测,为建筑工程和城市规划提供重要数据支持。

3. 农业监测与精准农业:利用无人机航拍影像的拼接,可以实现农田的植被指数监测、农作物的生长情况分析和病虫害的检测,为农业生产提供精确的决策依据。

4. 环境保护与生态监测:通过无人机航拍影像的拼接,可以实现自然保护区的植被分布图、生态系统的动态变化等监测,为环境保护和生态研究提供数据支持。

三、无人机航拍影像拼接算法的挑战和发展空间尽管无人机航拍影像拼接算法在不同领域已经有了广泛的应用,但是仍然存在一些挑战和发展空间。

基于机器视觉的无人机图像拼接技术研究无人机技术在近年来的发展中扮演着越来越重要的角色,广泛应用于农业、测绘、安防等领域。

其中,无人机图像拼接技术是无人机技术中的一个重要组成部分。

基于机器视觉的无人机图像拼接技术通过对无人机采集到的图像进行处理和分析,实现多张图像的拼接,从而生成更大范围、高分辨率的图像。

一、无人机图像拼接的原理无人机图像拼接技术依赖于机器视觉的图像处理和分析能力。

其基本原理包括以下几个步骤:1. 图像采集:通过无人机搭载的摄像头进行图像采集。

无人机通过飞行控制系统和导航系统,精确控制摄像头的拍摄角度和位置,保证每张图像的拍摄精度和一致性。

2. 图像预处理:无人机采集的图像通常包含噪声、畸变等问题,需要进行预处理。

预处理包括图像去噪、图像校正、图像对齐等步骤,以获得更加清晰、准确的图像。

3. 特征提取:在拼接过程中,需要提取图像中的特征点,以确定图像之间的对应关系。

常用的特征点提取算法包括SIFT、SURF、ORB等,通过计算特征点的描述子,可以得到图像的特征描述信息。

4. 图像匹配:利用特征点的描述子,对图像进行匹配。

匹配算法通常采用最近邻算法或者最近邻搜索树算法,通过对比特征点之间的相似度,找到图像中匹配的对应点。

5. 图像拼接:根据图像匹配的结果,进行图像的拼接。

拼接算法包括基于特征的拼接算法、基于投影变换的拼接算法等。

其中,基于特征的拼接算法通过对匹配的特征点进行三角坐标计算,得到图像的平移、旋转和缩放矩阵,从而实现图像的拼接。

二、基于机器视觉的无人机图像拼接技术的应用1. 地质勘探:无人机图像拼接技术可以应用于地质勘探中的地貌分析和地质构造分析。

通过利用无人机搭载的摄像头,采集大面积的地表图像,利用图像拼接技术将这些图像拼接成一幅高分辨率的地貌图,从而实现对地质特征的精细分析和研究。

2. 农业遥感:无人机图像拼接技术在农业遥感中具有重要应用价值。

通过对农田进行无人机图像拍摄并拼接,可以获得农田的高清晰度图像,通过对图像进行分析,可以实现对农田土壤质量、作物生长状态等信息的提取和监测,有助于农民提高农田管理水平和农作物产量。

基于机器视觉的无人机照片拼接算法研究近年来,随着无人机技术的不断完善,越来越多的机器视觉技术被应用于无人机影像处理中。

其中一项重要的应用是无人机照片拼接,即将多张无人机照片拼接成一张完整的高清航拍图像,以便对地形、道路、建筑物等进行监测、识别和测量等操作。

本文将探讨基于机器视觉的无人机照片拼接算法的研究,从图像预处理、特征提取、图像匹配、重建和矫正等方面进行分析。

一、图像预处理在进行图像拼接前,需要对无人机拍摄的照片进行一系列预处理,以确保每张照片的色彩、亮度、尺寸等参数一致。

同时,为了减小图像拼接时的误差,需要对照片进行几何校正、畸变纠正等操作。

图像预处理的具体步骤包括:颜色校正、亮度调整、噪声去除、图像平滑、图像增强、图像缩放、几何校正、畸变纠正等。

其中,几何校正和畸变纠正是图像预处理的重要环节,需要通过计算机视觉算法来实现。

二、特征提取在进行无人机照片拼接前,需要对每张照片提取出具有代表性的特征点,以便进行图像匹配。

特征点提取需要考虑几个因素,包括特征点的唯一性、对称性、稳定性和可重复性等。

常用的特征点提取算法包括:SIFT(尺度不变特征变换)、SURF(加速稳健特征)、ORB(FAST和BRIEF的混合算法)、AKAZE(高速自适应关键点提取器)等。

利用这些算法提取出的特征点能够描述出图像的局部特征,以便进一步进行图像匹配。

三、图像匹配特征点提取后,需要进行图像匹配,以找到各个照片之间的联系,从而实现拼接。

图像匹配是一个基于相似性度量的问题,常用的相似性度量方法包括欧氏距离、余弦相似度、SAD(sum of absolute differences)、SSD(sum of squared differences)等。

在图像匹配中,常用的算法是基于特征匹配的方法。

通过对两张图片提取的特征点进行匹配,计算两张图片之间的相似性,从而确定它们之间的位置关系。

目前最常用的特征匹配算法是基于RANSAC(随机采样一致性)的方法或其变体。

无人机航拍中的图像拼接算法分析近年来,随着无人机技术的快速发展,无人机航拍成为了越来越受欢迎的方式来获取地面高分辨率的图像数据。

在实际应用中,无人机航拍通常会产生大量的图像数据,如何高效地对这些图像进行拼接成为了一个重要的问题。

本文将对无人机航拍中常用的图像拼接算法进行分析和讨论。

首先,图像拼接的目标是将多个部分重叠的图像拼接成一张无缝的全景图。

为了实现这个目标,需要解决以下几个主要问题:特征提取、特征匹配和图像融合。

特征提取是图像拼接算法的第一步,其目的是从每一张图像中提取出一些具有代表性的特征点。

这些特征点应该具备一些重要的性质,如在图像中具有较高的对比度,对图像变形具有较高的鲁棒性等。

在无人机航拍中,由于拍摄角度和光照条件的变化,图像中的特征点分布并不均匀。

因此,选择合适的特征提取算法对于图像拼接的成功至关重要。

常用的特征提取算法包括SIFT(尺度不变特征转换)和SURF(速度ed 特征转换)等。

特征匹配是图像拼接算法的关键一环,其目的是找到多个图像之间相对应的关键点。

在特征匹配过程中,需要解决的问题是如何确定两幅图像中的特征点是否匹配,即如何衡量两个特征点之间的相似度。

这一问题的解决方法有很多,其中一种常用的方法是计算特征点之间的距离并设定一个合适的阈值来进行匹配。

此外,还可以使用一些几何约束条件,如基础矩阵或单应矩阵等,来进一步筛选匹配点对。

特征匹配的准确性和鲁棒性对于图像拼接的质量有着重要影响。

图像融合是图像拼接的最后一步,其目的是将匹配好的图像进行平滑过渡和拼接,使得最终得到的全景图具有较高的视觉效果。

在图像融合过程中,需要解决的问题是如何将多幅图像进行平滑过渡,使得拼接处的边界不明显。

常用的图像融合算法包括基于像素值混合的线性融合算法和基于图像加权平均的多重分辨率融合算法等。

这些算法通过对图像进行处理,使拼接处的过渡更加自然,同时减少拼接引起的不连续现象。

除了上述的三个基本步骤,还有一些其他的技术可以用于提升图像拼接算法的效果。

文献引用格式:张梦颖ꎬ李立ꎬ龙凡ꎬ等.一种无人机航拍高清影像快速拼接方法[J].电视技术ꎬ2018ꎬ42(2):68-75.ZHANGMYꎬLILꎬLONGFꎬetal.AfaststitchingmethodofUAVaerialHDimage[J].Videoengineeringꎬ2018ꎬ42(2):68-75.中图分类号:TN919.8㊀㊀㊀㊀文献标志码:A㊀㊀㊀㊀DOI:10.16280/j.videoe.2018.02.013一种无人机航拍高清影像快速拼接方法张梦颖ꎬ李㊀立ꎬ龙㊀凡ꎬ余㊀翠ꎬ张㊀原(武汉大学电子信息学院ꎬ湖北武汉430072)摘要:该文研究了一种无人机航拍高清影像快速拼接方法ꎬ主要包括路线规划㊁视频特定帧抽取㊁帧图像拼接三步ꎮ其中ꎬ为得到较精确的对地分辨率ꎬ对实验场景进行路线规划ꎻ为解决无人机影像冗余帧信息量大的问题ꎬ提出了一种基于目标场景和无人机飞行状态参数的抽取算法ꎻ为解决配准阶段的耗时问题ꎬ用SURF算子仅在重叠区域内进行图像配准ꎬ减少配准用时ꎮ实验表明ꎬ该方法基本达到实时性要求ꎬ且拼接图像的视觉效果较好ꎮ关键词:快速拼接ꎻ路线规划ꎻ重叠度ꎻ抽取ꎻ分辨率AfaststitchingmethodofUAVaerialHDimageZHANGMengyingꎬLILiꎬLONGFanꎬYUCuiꎬZHANGYuan(SchoolofElectronicInformationꎬWuhanUniversityꎬWuhan430072ꎬChina)Abstract:Thispaperdevelopedamosaicmethodforunmannedaerialvehicle(UAV)photographvideowithhighdefinition(HD)ꎬitmainlyincludesthreesteps:routeplanningꎬaspecificframeextractionofvideoandimagemosaic.FirstꎬinordertogetmoreaccuratetotheresolutionꎬthesceneofrouteshouldbeplannedꎻSecondꎬinordertosolvetheproblemoflargeamountofre ̄dundantframesofUAVimageꎬanewalgorithmbasedonthetargetsceneandtheflightstateparametersofUAVꎻThirdꎬtheSURFoperatorisusedtomaketheimageregistrationintheoverlappingareaꎬthenthetimeconsumingforregistrationisreduced.FinallyꎬthesimulationresultsshowthatthemethodbasicallyreachedUAVaerialimagemosaicreal-timerequirementsꎬandthevisualeffectofmosaicimageisfine.Keywords:FaststitchingꎻRouteplanningꎻOverlapdegreeꎻExtractꎻResolvingpower㊀㊀利用无人机航拍采集数据可用于交通事故现场模拟㊁森林火灾检测㊁灾害的应急保障[1]等ꎮ虽然无人机航拍影像有对地分辨率高㊁实时性强㊁成本较低的优点ꎬ但在获得高清图像的要求下ꎬ单张无人机图像往往无法覆盖整个兴趣区域ꎬ可利用图像拼接技术将高清㊁小视角图像拼接成全景图像来克服此缺点ꎮ1㊀引言图像拼接主要包含图像配准和图像融合两步ꎬ而图像拼接的耗时主要集中在图像配准阶段ꎮ自2006年SURF算法被提出[2]ꎬ相较于经典的SIFT算法已经提高了其配准效率ꎮSURF算法采用积分图像进行特征提取ꎬ用64位浮点描述子其匹配复杂度仍比较高ꎮ2009年陈裕ꎬ刘庆元将马氏距离测度用于SIFT匹配中ꎬ这使算法得到改进ꎬ匹配精度提高[3]ꎮ2010年宋丽华将距离筛选方法应用于SURF匹配中[4]ꎬ优化了算法ꎮ2014年一种鲁棒的基于图像对比度的局部特征描述法被提出[5]ꎬ实现了比SURF更高的速度ꎮ2016年ꎬ文献[6]结合SURF算法与LDB描述算法分别用于特征提取和特征匹配ꎬ也稍稍提高了图像配准的效率ꎮ为适应无人机航拍影像拼接系统实时性的需求ꎬ本文利用经典的SURF算法配准较快的优点ꎬ在其基础上提出一种基于飞行状态参数的局部配准算法ꎬ利用无人机飞行状态参数来确定无人机帧之间的重叠区域ꎬ仅在重叠区域内进行图像配准ꎬ将减少特征提取的个数和时间ꎮ为方便计算重叠区域ꎬ结合飞行参数设计出影像帧抽取算法ꎬ使相邻帧间有固定重叠度ꎮ为满足图像高清度的要求ꎬ由于摄像头参数一定ꎬ图像目标对地分辨率大小即决定飞行高度ꎬ结合目标区域需进行路线规划ꎮ图1㊀高清影像快速拼接方法流程图2㊀路线规划为使无人机航拍时拍到全部目标场景并且达到拼接后图像对地分辨率要求ꎬ需对实验场景进行路线规划ꎮ2.1㊀飞行高度和对地分辨率的关系在实验器材一定的情况下ꎬ图像的对地分辨率和飞行高度成反比ꎮ无人机在空中飞行实验的前后应该满足以下几个条件:(1)飞行前ꎬ须知道无人机摄像头的横向视角θꎬ阅读无人机参数可知ꎮ(2)飞行前ꎬ须知道实验场景的尺寸ꎬ可利用GoogleEarth地图ꎬ对实验场景尺寸进行标定和测量ꎬ精度较高ꎮ(3)飞行中ꎬ无人机保持对地高度和飞行速度的一致ꎬ自动航行模式能较好的实现此功能ꎮ(4)飞行后ꎬ保证视频拍摄到实验场景的每一处ꎬ即做好路线规划ꎮ如图2为模拟摄像头对地高度和所取场景宽度大小关系ꎮ无人机摄像头的横向视角øEPF=θꎬ无人机飞行高度PO=H米ꎬ一幅图片对应的实际场景视野宽度为EOF=WL米ꎮ其中无人机摄像头方向垂直于地面即POʅEFꎮ根据条件一ꎬ已知摄像头横向视角为θꎬ设一幅图像宽度上对应的视野长为WL米ꎬ飞行高度为H米ꎬ它们的关系应该满足三角公式:WL/2H=tan(θ/2)(1)图2㊀模拟摄像头对地高度所取场景宽度大小对地图像分辨率通常指在影像上能够分辨地面最小影物的大小ꎬ单位为米/像素ꎮ设:设备录像模式画面尺寸aˑbꎬ即图像宽度上有a个像素ꎬ而宽度实长为WL米ꎬ飞行高度H米ꎬ对地分辨率为RESOLUTIONꎮ所以像素个数和场景实长的关系为:RESOLUTION=WLa(米/像素)(2)结合公式(1)WL=Hˑ2ˑtan(θ/2)ꎬ得到对地分辨率和飞行高度的关系:RESOLUTION=Hˑ2ˑtan(θ/2)a(米/像素)(3)由公式(3)可知:飞行高度越低ꎬ每像素对应的实际场景长度越短ꎬ即图像越高清ꎮ飞行高度和图像高清度成反比ꎮ2.2㊀路线规划路线规划不仅保证较精确的对地分辨率而且保证拍摄到目标场景的每一处ꎮ由公式(3)得已知对地分辨率对应的飞行高度为:H=RESOLUTIONˑa2ˑtan(θ/2)(4)由公式(2)得已知对地分辨率对应的一幅图像宽度视野长为:WL=RESOLUTIONˑa(5)设:目标场景的实际宽度为W米ꎮ根据其和一幅图像宽度上对应的视野长WL的关系来决定其路线规划的形状ꎬ以满足拍摄到全部目标场景ꎮ若WL>Wꎬ那么规划一个 I 型路线ꎻ若W/2<WL<Wꎬ那么规划一个 U 型路线ꎻ若W/8<WL<W/2ꎬ那么规划一个 III 型路线ꎻ若W/4<WL<W/8ꎬ依此类推......图3㊀路线规划3㊀无人机航拍序列影像抽取算法为解决无人机影像冗余帧信息较多的问题ꎬ基于目标场景尺寸和无人机飞行状态参数的影像抽取算法ꎬ使之抽取出相邻两帧间具有固定重叠度特点的关键帧用于图像拼接ꎮ3.1㊀基于目标场景和无人机飞行状态参数的抽取算序列影像抽取算法基于目标场景尺寸和无人机飞行状态参数ꎬ需知3点先验知识:(1)无人机的飞行高度Hꎬ(2)实验场景的实际视野范围的长度Lꎬ(3)无人机开启录像模式时ꎬ画面中宽长尺寸比ρꎮ图4㊀模拟某相邻帧画面内容在整个实验场景中情况因此ꎬ场景实长L㊁场景长度方向上抽取的帧数m和重叠度α的关系为:wˑm-wˑαˑ(m-1)=L(6)由公式(2)可知帧画面长l和飞行高度H的关系为公式(7)ꎻ录像模式画面长宽尺寸比为公式(8)ꎻ将公式(7)和(8)代入到公式(6)中求出抽取张数和重叠度的关系公式(9)ꎮl=Hˑ2ˑtan(θ/2)(7)w/l=ρ(8)Hˑ2ˑtan(θ/2)ˑρˑ[m-αˑ(m-1)]=L(9)公式(9)为基于目标场景和无人机飞行状态参数抽取算法的基础公式ꎬ在已知飞行高度Hꎬ摄像头横向视角θ和录像模式画面的宽长尺寸比ρ这三个基础参数条件下ꎬ求出视频所抽取的张数m和相邻每帧重叠度α的关系ꎮ3.2㊀无人机影像抽取目标和原理抽取条件:无人机匀速飞行ꎬ启用自动航行模式能较精准实现ꎮ抽取目标:相邻每帧都有固定的重叠度ꎮ视频的的帧率FPS时长TIMEꎬ总帧数TOTALFRAMES满足关系:TOTALFRAMES=FPSˑTIME(10)抽取原理:因为无人机飞行匀速ꎬ所以设置一个抽取帧周期(PERIOD)ꎬ将一段视频看成固定帧总数的图片的集合ꎬ在其中每隔固定帧数取一帧ꎬ那么抽取出的相邻每帧具有固定重叠度ꎮ其中ꎬ抽取帧周期PERIOD和抽取出的帧数m满足关系式:PERIOD=TOTALFRAMES/m(11)综上所述:此无人机航拍序列抽取算法具有通用性和普适性ꎬ不同无人机配置参数不同ꎬ但将实际参数代入即可达到无人机影像抽取的目标ꎬ为后续仅在重叠区域内寻找特征点㊁提高拼接效率作重要铺垫ꎮ4㊀基于SURF局部配准的帧图像拼接SURF算子是一种快速特征检测算法ꎬ用近似Hessian矩阵检测特征点ꎬ并用积分图像进行卷积运算ꎬ实现相对较快的特征提取速度[2]ꎮ4.1㊀基于飞行状态参数的局部配准经典SURF算法是基于特征的全图区域配准ꎬ但配准在全图区域进行ꎬ会产生大量冗余计算ꎬ因此利用抽取阶段抽取出的具有固定重叠度的帧图像进行仅在重叠区域内的图像配准ꎬ能减少图像配准的时间ꎮ由于图像拼接的耗时主要集中在配准阶段ꎬ所以此步骤会相应减少图像拼接的耗时ꎮ4.1.1㊀特征提取的改进改进思想:改进前在整幅图像中寻找特征点ꎻ改进后只在重叠区域寻找特征点ꎮ图5㊀基于飞行状态参数的局部配准的改进原理此改进需知道相邻每帧间的固定重叠度ꎬ利用无人机航拍序列影像抽取算法即可得到ꎮ4.1.2㊀特征匹配以欧式距离为匹配测度ꎻ利用较高效的BBF搜索策略[2]ꎬ在构成特征描述符时对每个特征点会添加亮度对比标识ꎬ有标识时ꎬ可限定同类型特征点相匹配ꎬ对于不一致点可跳过ꎮ最后用RANSAC算法[7]将误匹配点去除ꎬ即在一个样本集中先随机选择两点确定一条直线ꎻ然后根据某个阈值判断内外点ꎬ在阈值范围内的为内点ꎬ在阈值范围外的为外点ꎻ最后随机选择重复上述操作的次数ꎬ内点数量最多的估计即为样本点集的拟合ꎬ并剔除外点ꎮ4.2㊀图像融合线性加权融合算法ꎬ计算重叠区域像素值时分别对像素值赋权值后再取平均值[8]ꎮ设w1和w2分别表示两幅图像各自在重叠域内施加的权值ꎬ满足w1+w2=1ꎬ0<w1ꎬw2<1ꎮ㊀㊀f(xꎬy)=f1(xꎬy)ꎬ(xꎬy)ɪf1w1(xꎬy)f1(xꎬy)+w2(xꎬy)㊀f2(xꎬy)ꎬ(xꎬy)ɪ(f1ɘf2)f2(xꎬy)ꎬ(xꎬy)ɪf2ìîíïïïïï(12)此方法可以有效地消除拼接缝隙ꎬ实现图像拼接处的平滑过渡ꎮ5㊀实验分析5.1㊀实验数据和环境实验数据用大疆精灵3航拍采集得到ꎬ实验平台为Intel(R)Core(TM)i5-3230M处理器ꎬ64位Windows7操作系统ꎬ开发软件利用OpenCV2.4.9搭载在VisualStudio2010平台上C++编程实现ꎮ5.2㊀路线规划和对地分辨率实验已知摄像头横向视角θ=75ʎꎬ其录像模式的尺寸为2704ˑ1520ꎬ即a=2704ꎮ实验场景1:广场ꎬ设:目标分辨率5厘米/像素ꎬ利用公式(4)计算飞行高度约为88.14米ꎬ因此设整数飞行高度H=90米进行实验ꎬ根据公式(3)可得精确的对地分辨率:90ˑ2ˑtan(37.5ʎ)2704ʈ0.0511(米/像素)ʈ5.11(厘米/像素)(13)而根据公式(1)可知一幅图像对应实际场景的宽度WL:WL=Hˑ2ˑtan(θ/2)=90ˑ2ˑtan(37.5ʎ)=138.06(米)(14)目标场景实宽W由GoogleEarth地图标定得来W=136.97米ꎬ根据路线规划策略ꎬ136.97米<138.06米ꎬ满足条件W<WLꎬ因此广场路线规划为I 型ꎮ实验场景2:停车场ꎬ设:目标分辨率为1厘米/像素ꎬ利用公式(4)可得飞行高度约为17.62米ꎬ因此设整数飞行高度H=20米进行实验ꎬ根据公式(3)可得精确的对地分辨率:20ˑ2ˑtan(37.5ʎ)2704ʈ0.0113(米/像素)ʈ1.13(厘米/像素)(15)而根据公式(1)可得出一幅图像对应实际场景的宽度WL:WL=Hˑ2ˑtan(θ/2)=20ˑ2ˑtan(37.5ʎ)=30.68米(16)目标场景实宽W由GoogleEarth地图标定得来W=42.86mꎬ那么根据路线规划策略ꎬ21.43m<30.68m<42.86mꎬ满足条件W/2<WL<Wꎬ停车场路线规划为 U 型ꎮ5.3㊀无人机航拍序列影像抽取实验利用无人机航拍序列影像抽取算法ꎬ以停车场实验视频1为例ꎬ编程实现自动抽取并求出相邻帧间固定重叠度ꎮ表1㊀一段视频抽取的张数和相邻帧间固定重叠度的关系㊀㊀受实时环境风力的影响ꎬ无人机飞行并不完全匀速ꎬ以及实际计算手段上的误差等原因ꎬ导致实际重叠度大小有些波动ꎮ不过实验能保证相邻帧间重叠度大致相似ꎬ因此设置一个阈值Tꎬ满足T>FactMAX其中FactMAX为实际重叠度最大值ꎬ即可确定重叠区域的范围ꎮ5.4㊀改进前后图像配准效率分析图6和图7选取实际重叠度最大值为0.56的图片进行实验ꎬ设定阈值为T=0.6ꎬ即60%重叠度范围内寻找特征点ꎮ且实验所用图像无压缩1520ˑ2704ꎬ比较全图配准和仅在重叠区域配准结果ꎮ(a)DJI_0238_1和DJI_0238_2配准㊀(b)DJI_0238_2和DJI_0238_3配准图6㊀传统全图配准结果(a)DJI_0238_1和DJI_0238_2重叠域㊀(b)DJI_0238_2和DJI_0238_3重叠域图7㊀仅在重叠区域内图像配准结果表2㊀传统全图配准算法与本文局部配准算法的效率分析㊀㊀由表2可知ꎬ待拼接影像数量越多ꎬ相邻帧间的重叠度越大ꎬ总体的配准耗时越长ꎬ但其加速比越小ꎮ所以在不考虑配准正确率的情况下ꎬ使相邻两帧间重叠度越小ꎬ耗时不仅越短而且加速比越大ꎬ局部配准和全图配准效率的提高越明显ꎮ效率的提高对配准的正确率有何影响?由于将N张图像两两相邻进行配准ꎬ需配准N-1次ꎬ所以:平均每次错误点数=错误点数和/(影像数量-1)ꎮ表3㊀传统全图配准和本文重叠区域配准误匹配率比较㊀㊀结合表2㊁表3和图8综合分析可知:(1)影像数量越多ꎬ相邻两帧重叠区域越大ꎬ误匹配率越低ꎮ(2)随着影像数量的增加ꎬ误匹配率的降低越来越慢ꎮ(3)随着重叠区域的减小ꎬ误匹配点个数增加越快ꎮ(4)重叠度在0.5以下时ꎬ虽然改进方法比传统方法加速比很大ꎬ减少误匹配点个数也有明显的提高ꎬ但是误匹配点的基数仍很大ꎮ(5)重叠度大于0.6左右时ꎬ全图区域配准和仅在重叠区域配准的误匹配率相近ꎬ即此时全图配准和局部配准在耗时上有差别但其配准的精确度相近ꎬ因此基于SURF的局部配准方法可以实现在保持配准精度不变的条件下ꎬ提高拼接效率ꎮa广场配准性能比较㊀㊀㊀㊀㊀㊀㊀b停车场配准性能比较图8㊀传统全图配准和本文重叠区域配准误匹配率比较㊀㊀综上所述:为实现大致保证配准精度但提高拼接效率的目标ꎬ取重叠度在0.6左右时ꎬ能在保证配准精度较高的情况下ꎬ耗时最短ꎮ其中ꎬ实验场地为广场:抽取6张图片ꎬ重叠度为0.515ꎬ设定阈值T=0.6ꎬ传统方法耗时105.047sꎬ本文方法耗时54.679sꎬ提速比47.9%ꎻ实验场地为停车场:抽取8张图片ꎬ重叠度0.538ꎬ设定阈值T=0.6ꎬ传统方法耗时128.291sꎬ本文方法耗时69.665sꎬ提速比45.7%ꎮ表4㊀相邻两幅图像配准性能比较(T=0.6ꎬ配准原始图像尺寸1520ˑ2704)㊀㊀统计分析相邻两幅图像配准性能ꎬ如表4所示ꎮ改进方法在60%重叠区域进行图像配准提取的特征点数和配准用时都约为传统方法的一半ꎮ改进后的算法在提高实验效率上有明显的效果ꎬ其机制是减少提取的特征点数ꎬ从而减少拼接时间ꎮ5.5㊀拼接结果选取了两个场景进行验证ꎬ计算出的对地分辨率达到了厘米每像素ꎬ相对于GoogleEarth地图中米每像素指标而言ꎬ实验获得了较高的对地分辨率的拼接结果ꎮ广场I型拼接:由抽取出的7幅原始图片1520ˑ2704拼接而成ꎬ重叠度约为0.66ꎬ飞行高度90mꎬ分辨率5.11厘米/像素ꎬ全景图像的尺寸为4981ˑ2875ꎬ如图9所示ꎮ图9㊀广场全景拼接结果(4981ˑ2875)㊀㊀停车场U型拼接:待拼接图像无压缩尺寸为1520ˑ2704ꎬ相邻每帧间重叠度约为0.54ꎬ飞行高度20米ꎬ分辨率1.13厘米/像素ꎮ图10a为视频1抽取出的8张图片拼接而成ꎬ尺寸为3132ˑ6702ꎻ图10b为视频2抽取出的8张图片拼接而成ꎬ尺寸为2846ˑ5976ꎻ图10c全景图像尺寸4312ˑ6194ꎮ利用此方法在保证高清和高效的拼接中ꎬ其图像的视觉效果也较好ꎮ6㊀结束语本文提出了一种基于无人机飞行状态参数和姿a视频1拼接(3132ˑ6702)㊀b视频2拼接(2846ˑ5976)㊀c停车场全景拼接结果(4312ˑ6194)图10㊀场景拼接的步骤和结果态角的航拍高清影像快速拼接的方法ꎮ根据路线规划和无人机飞行状态参数能计算出较精确的对地分辨率ꎬ得出了高清度的定量指标ꎮ基于目标场景尺寸和无人机飞行状态参数的影像抽取算法ꎬ解决了影像冗余帧多的问题ꎬ抽取出的相邻帧之间有固定重叠度的特点ꎬ这为改进的图像配准做了铺垫ꎬ并且此抽取算法具有普适性ꎮ利用SURF算法仅在重叠区域内进行局部图像配准ꎬ减少特征点的提取数量也相应减少了图像拼接的时间ꎮ本文方法在保证配准精确度的情况下ꎬ较高效地得到视觉效果较好的拼接图像ꎬ且能得到全景图像较精确的对地分辨率ꎮ参考文献:[1]EVERAERTSJ.TheuseofUnmannedAerialVehicles(UAV)forremotesensingandmapping[J].TheInterna ̄tionalArchivesofthePhotogrammetryꎬRemoteSensingandSpatialInformationScienceꎬ2008ꎬ11(37):1187-1192. [2]BAYHꎬTUYTELAARSTꎬVANGL.SURF:Speededuprobustfeatures[J].InternationalJournalofComputerVi ̄sion.2006ꎬ1(6):404-417.[3]陈裕ꎬ刘庆元.基于SIFT算法和马氏距离的无人机遥感图像配准[J].测绘信息与空间地理信息ꎬ2009ꎬ23(6):50-53.[4]宋丽华.基于无人机飞行器序列影像的定位技术研究[D].郑州:解放军信息工程大学ꎬ2010. [5]颜雪军ꎬ赵春霞ꎬ袁霞.一种鲁棒的基于图像对比度的局部特征描述方法[J].电子与信息学报ꎬ2014ꎬ36(4):882-887.[6]余淮ꎬ杨文.一种无人机航拍影像快速特征提取与匹配算法[J].电子与信息学报ꎬ2016ꎬ38(3):509-516. [7]沈秋ꎬ李小凡ꎬ孔繁锵ꎬ等.基于仿射模型的无人机视频实时压缩算法[J].电子与信息学报.2014ꎬ36(12):2855-2860.[8]高超ꎬ张鑫ꎬ王云丽ꎬ等.一种基于SIFT特征的航拍图像序列自动拼接方法[J].计算机应用ꎬ2007ꎬ27(11):2789-2792.作者简介:张梦颖(1994 )ꎬ硕士生ꎬ主研数字图像处理与智能系统ꎻ李㊀立(1971 )ꎬ副教授ꎬ主要研究方向图像处理与模式识别㊁传感器网络等ꎻ龙㊀凡(1994 )ꎬ硕士生ꎬ主研方向图像处理与模式识别ꎻ余㊀翠(1994 )ꎬ硕士生ꎬ主研方向数字图像处理与智能系统ꎻ张㊀原(1994 )ꎬ硕士生ꎬ主研方向传感器网络ꎮ责任编辑:胡鑫收稿日期:2017-07-21。

一种新的无人机航拍图像快速拼接算法

李玉峰;任静波

【期刊名称】《计算机仿真》

【年(卷),期】2022(39)5

【摘要】针对无人机航拍图像拼接算法存在拼接速度慢、拼接结果不精准等问题,提出了一种新的无人机航拍图像快速拼接算法。

采用A-KAZE算法构建非线性尺度空间并寻找局部极值点,利用改进的二进制特征描述子FREAK进行采样,采用主成分分析法对特征描述子进行精简降维。

对最近邻比率策略设定搜索阈值,提高特征点配准效率,再利用随机样本一致性算法对特征点进一步提纯,使用加权平均融合算法对待拼接图像进行融合。

实验结果表明,所提算法的特征点提取速度和特征点匹配速度较快,同时提高了特征点匹配正确率及拼接精度,拼接后的图像没有明显的拼接缝,整体颜色亮度保持一致,能够有效提高拼接图像速度和质量。

【总页数】7页(P201-207)

【作者】李玉峰;任静波

【作者单位】沈阳航空航天大学电子信息工程学院

【正文语种】中文

【中图分类】TP391.41

【相关文献】

1.一种新的无人机航拍序列图像快速拼接方法

2.一种快速的基于SIFT算法的无人机航拍序列图像自动拼接方法

3.海事监管中无人机航拍图像快速拼接算法

4.基于

SIFT的无人机航拍图像快速拼接技术研究5.基于无人机航拍图像快速拼接方法的研究

因版权原因,仅展示原文概要,查看原文内容请购买。