实时数据库系统解决方案-Read

- 格式:ppt

- 大小:3.16 MB

- 文档页数:48

db2解决死锁的方法DB2是一种常见的关系型数据库管理系统,它被广泛应用于企业级应用程序中。

然而,随着应用程序的复杂性增加和并发访问的增加,死锁问题也变得越来越常见。

在本文中,我们将探讨一些使用DB2解决死锁问题的方法。

1. 死锁的定义和原因死锁是指两个或多个事务彼此等待对方持有的资源,从而导致所有事务无法继续执行的状态。

死锁通常发生在并发访问数据库时,其中一个事务正在使用某个资源,而另一个事务需要访问相同的资源。

死锁的发生原因可以归结为四个条件:互斥(资源只能被一个事务使用)、持有并等待(一个事务持有资源并等待另一个事务的资源)、不可剥夺(资源不能被其他事务抢占)、循环等待(多个事务形成循环等待资源)。

2. 使用锁机制避免死锁在DB2中,可以使用锁机制来避免死锁的发生。

锁是一种机制,用于协调并发事务对共享资源的访问。

DB2提供了两种类型的锁:共享锁和排他锁。

共享锁允许多个事务同时读取资源,但不允许写入资源;排他锁只允许一个事务同时读取或写入资源。

为了避免死锁,可以采取以下策略:- 在事务开始时,尽量将锁的范围缩小到最小,只锁定必要的资源。

- 在事务执行期间,尽量减少锁的持有时间,执行完操作后尽快释放锁。

- 避免循环等待,即事务在请求资源时按照统一的顺序进行,避免形成死锁的循环等待。

3. 设置适当的隔离级别DB2提供了多种隔离级别,用于控制事务之间的相互影响。

不同的隔离级别对并发访问的控制程度不同。

在选择隔离级别时,需要权衡事务的一致性和性能。

在避免死锁的角度考虑,可以选择较低的隔离级别,如读取已提交(Read Committed)。

较低的隔离级别可以减少锁的竞争,从而降低死锁的风险。

但同时,较低的隔离级别也可能导致数据不一致的问题,需要根据具体业务需求进行权衡。

4. 监控和诊断死锁DB2提供了一些工具和功能,用于监控和诊断死锁问题。

可以通过以下方式来实现:- 使用DB2的系统监控工具,如db2pd命令和db2top工具,可以实时查看数据库的锁和死锁情况。

主题:db file scattered read 消耗分析一、db file scattered read概述1.1 db file scattered read是Oracle数据库中的一种I/O操作,用于读取数据块到内存中。

1.2 db file scattered read操作会在访问表或索引时发生,通常是由于全表扫描或索引扫描导致。

1.3 db file scattered read操作的消耗对系统性能和数据库响应时间有着重要影响。

二、db file scattered read消耗的原因分析2.1 大量的I/O操作:当数据库需要执行大量的db file scattered read操作时,会增加I/O负载,导致系统性能下降。

2.2 大量的全表扫描:如果数据库中存在大量的全表扫描操作,可能会导致大量的db file scattered read操作,进而影响数据库性能。

2.3 磁盘读取速度慢:当磁盘读取速度较慢时,会导致db file scattered read操作消耗增加。

三、优化db file scattered read消耗的方法3.1 增加内存缓存:通过增加内存缓存,可以减少db file scattered read操作对磁盘的依赖,提高数据库性能。

3.2 优化SQL查询:尽量避免全表扫描,使用合适的索引和优化SQL查询语句,减少db file scattered read操作的消耗。

3.3 磁盘性能优化:优化磁盘的读取速度,使用高速磁盘或者采用磁盘阵列等技术来提高磁盘读取速度,减少db file scattered read操作的消耗。

四、db file scattered read消耗影响的解决方案4.1 增加数据库服务器的内存:通过增加数据库服务器的内存,可以提升内存缓存效果,减少db file scattered read操作的消耗对磁盘的依赖。

4.2 使用SSD硬盘:采用SSD硬盘可以显著提高磁盘的读取速度,减少db file scattered read操作的消耗,并提高数据库性能。

数据库连接池内存泄漏问题的分析和解决⽅案⼀、问题描述上周五晚上主营出现部分设备掉线,经过查看⽇志发现是由于缓存系统出现长时间gc导致的。

这⾥的gc⽇志的特点是:1.gc时间都在2s以上,部分节点甚⾄出现12s超长时间gc。

2.同⼀个节点距离上次gc时间间隔为普遍为13~15天。

然后紧急把剩余未gc的⼀个节点内存dump下来,使⽤mat⼯具打开发现,com.mysql.jdbc.NonRegisteringDriver 对象占了堆内存的⼤部分空间。

查看对象数量,发现com.mysql.jdbc.NonRegisteringDriver$ConnectionPhantomReference 这个对象堆积了10140 个。

初步判断长时间gc的问题应该是由于 com.mysql.jdbc.NonRegisteringDriver$ConnectionPhantomReference 这个对象⼤量堆积引起的。

⼆、问题分析⽬前正式环境使⽤数据库相关依赖如下:依赖版本mysql 5.1.47hikari 2.7.9Sharding-jdbc3.1.0根据以上描述,提出以下问题:1、com.mysql.jdbc.NonRegisteringDriver$ConnectionPhantomReference 到底是个什么对象呢?2、这种对象为什么会⼤量堆积,JVM回收不过来了?NonRegisteringDriver$ConnectionPhantomReference 到底是个什么对象呢?简单来说,NonRegisteringDriver类有个虚引⽤集合connectionPhantomRefs⽤于存储所有的数据库连接,NonRegisteringDriver.trackConnection⽅法负责把新创建的连接放⼊connectionPhantomRefs集合。

源码如下:1.public class NonRegisteringDriver implements java.sql.Driver {2. protected static final ConcurrentHashMap<ConnectionPhantomReference, ConnectionPhantomReference> connectionPhantomRefs = new ConcurrentHashMap<ConnectionPhantomReference,3. protected static final ReferenceQueue<ConnectionImpl> refQueue = new ReferenceQueue<ConnectionImpl>();4.5. ....6.7. protected static void trackConnection(Connection newConn) {8.9. ConnectionPhantomReference phantomRef = new ConnectionPhantomReference((ConnectionImpl) newConn, refQueue);10. connectionPhantomRefs.put(phantomRef, phantomRef);11. }12. ....13. }我们追踪创建数据库连接的过程源码,发现其中会调到com.mysql.jdbc.ConnectionImpl的构造函数,该⽅法会调⽤createNewIO⽅法创建⼀个新的数据库连接MysqlIO对象,然后调⽤我们上⾯提到的NonRegisteringDriver.trackConnection⽅法,把该对象放⼊NonRegisteringDriver.connectionPhantomRefs集合。

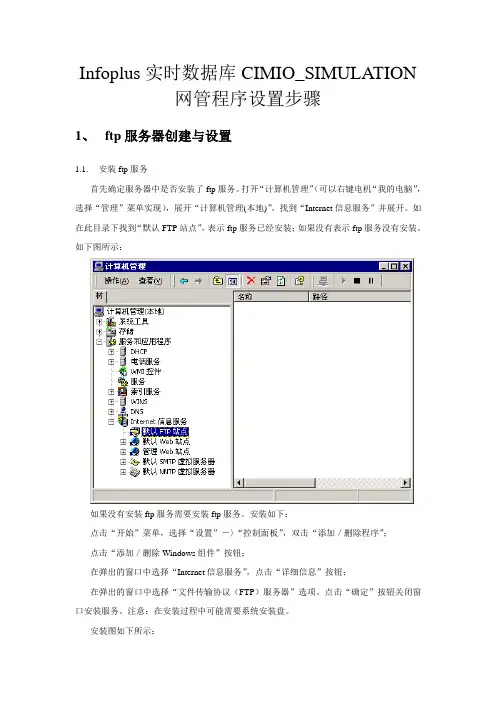

Infoplus实时数据库CIMIO_SIMULATION网管程序设置步骤1、ftp服务器创建与设置1.1.安装ftp服务首先确定服务器中是否安装了ftp服务。

打开“计算机管理”(可以右键电机“我的电脑”,选择“管理”菜单实现),展开“计算机管理(本地)”,找到“Internet信息服务”并展开。

如在此目录下找到“默认FTP站点”,表示ftp服务已经安装;如果没有表示ftp服务没有安装。

如下图所示:如果没有安装ftp服务需要安装ftp服务。

安装如下:点击“开始”菜单,选择“设置”-〉“控制面板”,双击“添加/删除程序”;点击“添加/删除Windows组件”按钮;在弹出的窗口中选择“Internet信息服务”,点击“详细信息”按钮;在弹出的窗口中选择“文件传输协议(FTP)服务器”选项。

点击“确定”按钮关闭窗口安装服务。

注意:在安装过程中可能需要系统安装盘。

安装图如下所示:1.2.ftp服务器的设置新建一个用户“eastxy”,用户密码为“eastxy1234”。

打开“计算机管理”(可以右键电机“我的电脑”,选择“管理”菜单实现),展开“计算机管理(本地)”,找到“Internet信息服务”并展开,右键点击“默认FTP站点”,选择“帐号安全”页签,勾选“允许匿名连接”,用户选择“eastxy”,密码“eastxy1234”。

如下图所示:然后再资源管理器中找到“C:\Inetpub\ftproot\”目录,然后再改目录下建一个新的的“CIM_IO”目录。

2、逻辑设备创建2.1.复制程序解压cimio_SIMULATION.rar文件,拷贝其中的文件到“C:\WINNT\system32”(Windows2000系统)或者“C:\windows\system32”(WindowsXP系统)目录下。

2.2.设置服务打开“C:\WINNT\system32\drivers\etc”(Windows2000系统)或者“C:\windows \system32\drivers\etc”(WindowsXP系统)目录。

RESSET高频数据库系统简介及使用说明(RESSET/HF)北京聚源锐思数据科技有限公司Beijing Gildata Resset DataTech Co.LtdRESSET高频数据库系统提供上海与深圳两个交易所上市交易工具的高频数据。

相关工具包括股票、指数、债券、基金、权证、回购等。

如交易的时间、成交价格、成交量、5个卖价与卖量、5个买价与买量等,及相应的市场买卖指标。

锐思数据基于量化投资时代背景下市场各类参与者对于高频数据深度、广度、质量、时效性以及应用领域专业化等方面的迫切需求而推出的高频数据系列产品以及基于高频数据的访问与应用的一整套解决方案。

高频数据的引入将为金融模型的构建、验证等环节,以及算法交易策略研究提供强大的支持。

数据库内容RESSET高频数据数据词典一、RESSET高频数据_分笔RESSET分笔高频数据记录每笔交易数据或每次买卖量价的变化。

按照交易工具代码进行归类,提供SAS格式的数据集。

调用模式:1.本机调用SAS系统;2.远程调用SAS系统;3.数据定制(用户定制)。

RESSET高频数据_分笔数据词典特殊计量单位说明:1. 沪市债券债券高频数据,沪市按手算,1手等于10只,即,沪市债券高频数据的"数量"都要再乘以10.2. 回购回购高频数据,相关价格都要除以100才是小数,现在是用%表示。

3. 沪市权证沪市权证高频数据,从'3mar2006'开始,所有"数量"都要乘以100。

2006年3月3日以前,上海证券交易所实时行情中权证产品总成交量以份为单位。

2006年3月2日,因上市的招行认沽权证成交量巨大,导致其行情显示时总成交量字段溢出,致使其总成交量显示异常。

因此海证券交易所在2006年3月2日发了一个《关于实时行情中权证产品总成交量显示单位变更的通知》,决定自2006年3月3日起,上海证券交易所对外发布的实时行情中,所有权证产品的各总成交数量显示(即show2003.dbf文件的S11字段),由原以份为单位改为以百份为单位,余量四舍五入。

⾯向ad-hoc查询的实时SQL分析系统Impala/Hive现状分析与前景展望Impala和Hive野史提到Impala就不得不提Google的Dremel,处理PB级数据规模的基于SQL的交互式、实时数据分析系统。

Dremel是Googl e推出的PaaS数据分析服务BigQuery的后台。

Google已经有了MapReduce,为什么还要开发Dremel呢?Dremel/Impala 类系统和MapReduce有什么区别呢?Hadoop现在已经成为BigData应⽤系统的标配,那么基于Hadoop平台做⼤数据分析⽆⾮⼏种使⽤⽅式:优点缺点典型案例⾃⼰写MapReduce任务性能⽐Hive和Pig要⾼点开发难度⼤1)搜索引擎⽹页处理,PageRank计算(Google)2)典型的ETL(全盘扫描)3)机器学习/聚类,分类,推荐等(百度Ecomm)使⽤Hive做基于SQL的分析对于数据分析师来说SQL太熟悉了有些场景下性能不如MR1)⽤户访问⽇志处理/互联⽹⼴告(Yahoo, Facebook,hulu, Amazon)2)电⼦商务(淘宝的云梯)使⽤Pig做数据分析Pig的语法不是很普及有些场景下性能不如MR统计和机器学习(Yahoo, twitter)基于HBase开发的系统基本可以达到准实时统计分析功能⽬前没有开源实现,开发成本⾼⼤多是⾃有系统,例如Google的Percolator,淘宝的prom关于twitter使⽤Pig做机器学习⽅⾯的内容请参考SIGMOD2012的论⽂Large-Scale Machine Learning at Twitter。

我们都知道MapReduce是由Google发明的,Google发明这个当然⾸先是满⾜⾃⼰的应⽤需求。

它们的主要需求就是对互联⽹⽹页的处理:⽹页有效信息提取,转化,PageRank的计算。

这种应⽤模式决定了这是⼀个批处理的系统。

后来Face book为了了解⽤户对其平台上⼴告点击的反馈,同时给不会MR编程只会使⽤SQL的数据分析师开发了Hive这个东西,使得Hive在FB内部应⽤⾮常⼴泛。

redis常见的⾯试题及答案1、什么是Redis?2、Redis相⽐memcached有哪些优势?3、Redis⽀持哪⼏种数据类型?4、Redis主要消耗什么物理资源?5、Redis的全称是什么?6、Redis有哪⼏种数据淘汰策略?7、Redis官⽅为什么不提供Windows版本?8、⼀个字符串类型的值能存储最⼤容量是多少?9、为什么Redis需要把所有数据放到内存中?10、Redis集群⽅案应该怎么做?都有哪些⽅案?11、Redis集群⽅案什么情况下会导致整个集群不可⽤?12、MySQL⾥有2000w数据,redis中只存20w的数据,如何保证redis中的数据都是热点数据?13、Redis有哪些适合的场景?14、Redis⽀持的Java客户端都有哪些?官⽅推荐⽤哪个?15、Redis和Redisson有什么关系?16、Jedis与Redisson对⽐有什么优缺点?17、Redis如何设置密码及验证密码?18、说说Redis哈希槽的概念?19、Redis集群的主从复制模型是怎样的?20、Redis集群会有写操作丢失吗?为什么?21、Redis集群之间是如何复制的?22、Redis集群最⼤节点个数是多少?23、Redis集群如何选择数据库?24、怎么测试Redis的连通性?25、Redis中的管道有什么⽤?26、怎么理解Redis事务?27、Redis事务相关的命令有哪⼏个?28、Redis key的过期时间和永久有效分别怎么设置?29、Redis如何做内存优化?30、Redis回收进程如何⼯作的?31、Redis回收使⽤的是什么算法?32、Redis如何做⼤量数据插⼊?33、为什么要做Redis分区?34、你知道有哪些Redis分区实现⽅案?35、Redis分区有什么缺点?36、Redis持久化数据和缓存怎么做扩容?37、分布式Redis是前期做还是后期规模上来了再做好?为什么?38、Twemproxy是什么?39、⽀持⼀致性哈希的客户端有哪些?40、Redis与其他key-value存储有什么不同?41、Redis的内存占⽤情况怎么样?42、都有哪些办法可以降低Redis的内存使⽤情况呢?43、查看Redis使⽤情况及状态信息⽤什么命令?44、Redis的内存⽤完了会发⽣什么?45、Redis是单线程的,如何提⾼多核CPU的利⽤率?46、⼀个Redis实例最多能存放多少的keys?List、Set、Sorted Set他们最多能存放多少元素?47、Redis常见性能问题和解决⽅案?48、Redis提供了哪⼏种持久化⽅式?49、如何选择合适的持久化⽅式?50、修改配置不重启Redis会实时⽣效吗?1、什么是Redis?Redis本质上是⼀个Key-Value类型的内存数据库,很像memcached,整个数据库统统加载在内存当中进⾏操作,定期通过异步操作把数据库数据flush到硬盘上进⾏保存。

考虑到企业数据仓库的重要战略意义(EDWs)和每年投入的巨额维护和扩展费用,如何容易地访问这些大量信息资产是非常迫切的需求。

然而,许多EDWs成为自己成功的受害者。

随着时间的推移,用户获取新问题答案的需要导致EDWs包含的数据量和复杂数据类型发生迅速增长,同时也带来更多的并发和复杂分析的压力。

如果企业级数据仓库变得无法应付这种变化,或者服务水平协议(SLA)不能满足用户的要求,企业则往往不得不进行昂贵的数据库重新设计或硬件平台迁移扩容项目,这往往需要持续好多个月以及带来大量成本损失。

即使如此新的架构也往往由于数据量增加得太快(目前已经有大量的客户从TB向PB级别扩展),而导致系统不得不进行更多的优化,这些优化需要占用大量的磁盘存储,带来了存储浪费和I/O瓶颈的问题。

因此如何解决在以往EDWs架构保持不变的状况下来满足新的实时性分析应用的需要成为技术创新的重要领域。

Vertica正是这一领域的积极创新先锋。

Vertica 创建于2005年,Vertica 成立于2005年,总部位于美国麻萨诸塞州的Billerica,在亚太和欧洲都设有Office。

2011年3月被HP公司收购。

它的合作创始人是数据库之父Michael Stonebraker,他曾开发了Ingres 和Postgres数据库,是公认的数据库权威大师。

Vertica是Stonebraker 基于MIT开发的C-Store 架构的商业实现,致力于解决当前数据分析平台日益增长的“大数据”和实时分析要求所带来的挑战,可以以传统解决方案30%的成本,实现50倍-1000倍的性能提高。

从技术角度来看,目前数据分析技术主要面临以下四个挑战:1. 数据量和数据复杂程度的增长。

非结构化数据,如web数据,设备采样数据,图形数据等被纳入数据分析的视野,数据量也随之成倍甚至数十倍的增长。

2. 处理数据的时间窗口越来越短。

以往存在往往一整个晚上进行批处理而无需考虑提供查询服务,现在则逐渐缩短到需要分钟级延迟的分析,即越来越多的准实时分析带来用户更强大的竞争能力、3. 混合负载和大并发成为常态。

嵌入式Linux组态软件实时数据库的设计1 引言实时数据库(real-time database, RTDB)作为组态软件设计与实现的核心内容解决了其所应对的现代工业生产现场环境中生产数据与控制数据类型复杂多样,数据处理与事件调度时间约束严格等难题[1]。

目前,国内外已经有多种基于Windows 操作系统平台的实时数据库产品在自动化过程控制领域中得到应用[2],随着Linux 操作系统的出现,这种开发平台单一的局面有望得到改观。

Linux 操作系统具有很多优秀的特性适于组态软件实时数据库系统的开发,特别是其完善的进程线程管理,进程间通信机制与并发控制,可靠的内存管理系统[3],更是为时间约束严格的实时数据库的开发提供了有力的支持。

因此,本文结合Linux 系统实时多任务方面的特性,采取能够满足数据实时响应要求的多级存储结构,研究并提出了一种基于嵌入式Linux 系统平台并可应用于监控组态软件的实时数据库实现方案。

2 实时数据库存储结构的分析与设计实时数据库是监控组态软件数据处理,事务调度,各应用程序间通信的中心。

图 1 即示出了组态软件实时数据库的数据处理流程。

2.1 实时数据库的数据流分析组态软件运行环境分为实时数据库管理系统(RTDBMS)和实时监控界面程序(real-time supervisory control interface, RTSCI)。

实时数据库管理系统需要把工业现场中复杂多样的过程和控制数据抽象为合理高效的数据结构,实时监控界面程序则利用实时过程数据为现场监控人员提供一个反映实际生产过程的可视化图形界面,在实际运行中二者构成客户端/服务器计算模式。

RTDBMS 作为数据服务的提供者,需要满足RTSCI 种类多样的数据需求。

为了形象的描绘工业现场的实际生产过程,RTSCI 由多种图形对象构成,根据不同的数据类型需求可分为实时显示,实时趋势,历史趋势,实时报警等。

而应用于现代工业生产现场环境的实时数据库还需要满足严格的数据存取与事件响应的定时限制。

施耐德readvar指令详解摘要:1.施耐德readvar 指令概述2.readvar 指令的功能3.readvar 指令的结构和参数4.readvar 指令的应用实例5.施耐德readvar 指令的优势和局限性正文:施耐德readvar 指令详解1.施耐德readvar 指令概述施耐德电气是一家全球领先的工业制造公司,其产品广泛应用于各种工业自动化领域。

在施耐德电气的自动化控制系统中,readvar 指令是一种重要的功能指令,用于实现对模拟输入信号的连续监测。

通过readvar 指令,可以实时获取模拟输入信号的当前值,并将其保存到指定的变量中,从而为后续的控制和调节提供数据支持。

2.readvar 指令的功能readvar 指令的主要功能是实时读取模拟输入信号的值,并将其保存到指定的变量中。

在施耐德电气的自动化控制系统中,模拟输入信号通常来自于各种传感器和检测设备,如温度传感器、压力传感器等。

通过readvar 指令,可以实时监测这些信号的变化,并在控制系统中进行相应的处理和调节。

3.readvar 指令的结构和参数readvar 指令的结构相对简单,其主要由以下几个部分组成:- 指令名称:readvar- 功能代码:用于指定指令的具体功能,例如,读取模拟输入信号的值- 存储位置:指定读取到的模拟输入信号值应保存到的变量地址- 输入信号:指定要读取的模拟输入信号的通道号4.readvar 指令的应用实例以下是一个简单的施耐德readvar 指令应用实例:假设有一个温度控制系统,其中包含一个温度传感器和一个控制器。

温度传感器的信号通道号为AI1,控制器的模拟输入通道号为AI1。

我们可以使用readvar 指令实时读取温度传感器的信号值,并将其保存到控制器的变量V100 中。

具体的指令如下:```readvar AI1 to V100```这样,控制器就可以根据实时读取到的温度信号值,对系统进行相应的温度控制和调节。

CSM-300EA远动软件 使 用 说 明 书CSM-300EA远动软件使用说明书编制:赵龙江校核:胡波涛标准化审查:郑蔚审定:王凤山出版号:V3.00文件代号:0SF.462.001.2出版日期:2005-12-31版权所有:北京四方继保自动化股份有限公司注:本公司保留对此说明书修改的权利。

如果产品与说明书有不符之处,请您及时与我公司联系,我们将为您提供相应的服务。

技术支持 电话:010-******** 传真:010-********重 要 提 示感谢您使用北京四方继保自动化股份有限公司的产品。

为了安全、正确、高效地使用本装置,请您务必注意以下重要提示:1)本说明书仅适用于CSM-300E系列远动产品。

2)请仔细阅读本说明书,并按照说明书的规定调整、测试和操作。

如有随机资料,请以随机资料为准。

3)为防止装置损坏,严禁带电插拔装置各插件、触摸印制电路板上的芯片和器件。

4)请使用合格的测试仪器和设备对装置进行试验和检测。

5)装置如出现异常或需维修,请及时与本公司服务热线联系。

6)本装置的操作密码是:8888。

目录1概述 (1)2基本软件的安装 (1)2.1 基本安装方式 (1)2.2 软件下载 (1)3 CSM-300EA远动软件的使用 (5)3.1 配置CSM-300EA (5)3.2 密钥的获取 (33)3.3 运行、简单调试RTU程序 (34)3.4 GPS对时处理 (39)3.5 双机切换的实现 (40)3.6 双通道切换的实现 (44)4典型工程配置步骤 (46)4.1 建立远动功能启动需要的软、硬件环境 (46)4.2 写配置文件 (46)4.3 调试 (51)4.4 对点 (52)4.5 写批处理文件 (52)5 CSM-310E装置上液晶和小键盘的使用 (53)5.1 循环显示 (53)5.2 普通菜单 (53)5.2.1 普通菜单-本机设置 (55)5.2.2 普通菜单-通道信息 (57)5.2.3 普通菜单-通信状态 (59)5.2.4 普通菜单-故障信息 (59)5.3 操作菜单 (60)5.3.1 操作菜单-本机设置 (62)5.3.2 操作菜单-通道信息 (64)5.3.3 操作菜单-进程信息 (66)附录A 虚拟点对应表 (68)附录B CSM-2调制解调器MODEM的设置 (72)附录C KHCS型系列装置使用说明 (73)1概述CSM-300EA远动软件是运行于CSM-300E系列装置上的一个重要的应用软件。

浅谈Excel如何通过OPC读取PHD实时数据作者:李刚任利民来源:《数字化用户》2013年第25期【摘要】简要说明程序如何通过OPC 服务器接口读取PHD实时数据,并实现Excel读取实时数据库数据,具有行业应用价值。

关键词:PHD 实时数据库 OPC服务器 Excel VBA一、前言生产控制系统都存在大量的实时数据,这些数据都使用实时数据库存储和管理。

查询都只能依靠厂家系统界面查询,如果需要对其数据导出并再综合应用,现有厂家系统与工具都无法实现。

为此,研究实现Office Excel通过OPC接口读取PHD实时数据库数据。

二、正文(一)OPC Server 配置PHD OPC服务器是基于微软的DCOM技术来实现,使用OPC Server之前,需要进行相关的DCOM配置。

注意:修改DCOM的相关设置之后,需要重新启动计算机方可生效。

配置步骤详见《Uniformance PHD OPC Server User Guide》“View/Modi fy DCOM Configuration of PHD OPC Server”章节。

(二)OPC Client 连接测试使用opcuser用户登陆本机,运行进入opc quick client应用程序,测试能否连接OPC Server成功:1.菜单Edit: New Server Connection... --> 选OPC Data Access Servers Version2.0 --> 选OPC.PHDServerDA.1 --> 输入:HL-MESOPC --> ok2.选OPC.PHDServerDA.1 右键 --> 选New Group... --> Name处随便输入可分组信息3.选中新建的组名:右键 --> 选New Item... --> Item ID 处输入点位号信息 --> 点一下右边勾 --> ok如果连接测试成功,就可以进行VBA程序开发了。

<Insert Picture Here>TimesTen内存数据库 内存数据库TimesTen内存数据库的背景 内存数据库的背景• 1992 --在HP美国总部, 第一个对于内存数据库的实验室, 主要研究内 存数据库技术在电信网络中的应用 • 1996 – TimesTen从HP实验室分离出来, 成立了一家独立的内存数据 库公司• 公司中的核心成员都从HP实验室来 • 同时发布了第一个内存数据库的商用版本(TimesTen 2.0)• 1999 – Timesten 在欧洲开业, 设在伦敦 • 2001 – Cache Connect capability released • 2005 – Oracle 收购了Timesten• 推出主要的商用版本 (TimesTen 6.0) • 过去三年每年有30%以上的增长率 • 庞大的客户, 超过1500 企业级的用户• 2007 – Timesten 新版本 7.0 正式推出TimesTen 高性能技术针对物理内存而特别设计优化的数据库• 所有数据存于物理内存• 针对物理内存而特别设计优化的数据 存储结构与算法NetworkApplication• 采用关系型数据模型 • 标准 APIs (ODBC, JDBC, SQL92)TimesTen libraries...ApplicationTimesTen librariesClientServerIn-Memory Database(s)Transaction Logs Checkpoint filesApplication-Tier Platform闪电般的响应速度TimesTen In-Memory Database 6.0, 4-CPU, 3 GHz x86 Xeon, 32-bit RHLinux30microseconds2028 millionths of a second1025 millionths of a second 9 millionths0 update mixed70% select; 20% update; 10% insertselect极高的处理能力Oracle TimesTen 6.0, 4-CPU, 3 GHz x86 Xeon, 32-bit RHLinuxTransactions per second300,000250,550250,000 200,000 150,000 100,000 50,000 032,6631 CPU 2 CPUs 4 CPUs121,70598,56870,11154,303updatemixed70% select; 20% update; 10% insertselect响应时间及吞吐量的比较内存数据库与磁盘数据库的比较数据库特性 目标应用 数据模型 优化 典型部署方式 架构 响应时间 数据容量 可扩展性 Oracle 10g 关键业务应用 关系型 - SQL Database Oracle TimesTen In-Memory Database 关键业务应用 关系型 - SQL磁盘为中心 数据库层 客户机/服务器 毫秒到秒级TB到PB级 Cluster (RAC) & SMP内存为中心 应用层 嵌入式(直接数据访问) 嵌入式(直接数据访问) 微秒到毫秒级GB级 SMPOracle TimesTen支持 实时世界 支持“实时世界 支持 实时世界”全球有超过1500家企业客户采用Oracle TimesTen内存数据库解决方案In NetworksIn TelecomOn Wall StreetIn the Enterprise呼叫处理 呈现业务 定位服务 软交换 一键通话( 一键通话(PTT) )实时计费 欠费分析 认证鉴权 网络/QoS管理 管理 网络 自服务门户订单匹配 智能订单路由 成交撮合 实时分析呼叫中心 用户个性化在线 实时订座 实时物流 BI / BAM SOATimesTen 无数据丢失技术日志与数据持久性Memory-resident Data Store• Transaction log manager 来协调 大量事务吞吐 • 内存缓冲区交易日志与同步交易 日志 • 交易日志与检查点文件保存在磁 盘之上 • 交易日志与检查点文件保障数据 可恢复ApplicationsUpdatesCommitted TransactionsTransaction Log Memory BufferBackground Log flusher persists transaction data to diskPeriodic snapshot of data store to checkpoint files1 Transaction Log files2Checkpoint files与Oracle数据库的无缝连接 数据库的无缝连接 Cache 选件Cache Connect to Oracle• 缓存Oracle数据库的数据 • 只读或可更新的缓存 • 双向更新 • 在一个Oracle数据库上可以 建立多个缓存实例NetworkApplication Program Application ProgramTimesTenTimesTenIn-Memory DatabaseIn-Memory DatabaseCache Connect to OracleOracleCache Group 定义需要被缓存到 TimesTen data store里 Cache Group 的Oracle数据库的数据集合,称之为缓 存组(Cache Group)。

Redis简介redis是一个key-value存储系统。

和Memcached类似,它支持存储的value类型相对更多,包括string(字符串)、list(链表)、set(集合)、zset(sortedset --有序集合)和hash(哈希类型)。

这些数据类型都支持push/pop、add/remove及取交集并集和差集及更丰富的操作,而且这些操作都是原子性的。

在此基础上,redis支持各种不同方式的排序。

与memcached一样,为了保证效率,数据都是缓存在内存中。

区别的是redis会周期性的把更新的数据写入磁盘或者把修改操作写入追加的记录文件,并且在此基础上实现了master-slave(主从)同步。

安装:安装Redis官方网站:http://redis.io/官方下载:http://redis.io/download 可以根据需要下载不同版本windows版:https:///ServiceStack/redis-windows下载安装包:解压启动Redis解压redis64-2.8.17版本后,找到redis.windows.conf,修改配置文件内容,内容如下。

支持数据结构redis提供五种数据类型:String,hash,list,set及zset(sortedset)。

Redis配置文件主要参数配置1、指定Redis监听端口,默认端口为6379。

port 63792、绑定的主机地址bind 127.0.0.13、当客户端闲置多长时间后关闭连接,如果指定为0,表示关闭该功能timeout 3004、指定日志记录级别,Redis总共支持四个级别:debug、verbose、notice、warning,默认为verbose。

loglevel verbose5、日志记录方式,默认为标准输出,如果配置Redis为守护进程方式运行,而这里又配置为日志记录方式为标准输出,则日志将会发送给/dev/null。

摘要本组课题是对液体自动混合装置的模拟控制,实现液体混合装置的自动添加液体、自动混合等自动控制功能。

在本设计的梯形图设计中是大量运用计时器和顺序控制继电器指令来完成的。

在PLC程序设计的基础上结合有关的外围设备形成一个易于工业控制的系统整体,在易于扩展其功能的原则而设计。

本监控系统采用PLC为控制核心,具备自动混合两种液体的功能, 由传感器检测储藏罐中的液面高度,按顺序加入A和B两种液体,搅拌40s后放出混合液体。

过程监控上,我们采用的是MCGS组态软件,这是我国自主研发的组态软件,适用于各品牌的PLC。

在课程设计中主要进行的是设备的基本机构图,混合装置控制的模拟实验面板图,PLC的选型,外部硬件接线图,以及绘制所要实现的功能图,进而在GX_Developer与GX.Simulator 中仿真调试,输出对应的指令表;在MCGS中设计监控的人机界面,对于储藏罐以及传感器和电磁阀和流动块的属性设置,同时绘制历史报表,最后将PLC中的程序同步到MCGS中,进行仿真调试,实现界面的实时监控,以及历史数据和曲线的实时监测。

关键词: 液体自动混合,可编程控制器PLC,MCGS组态软件AbstractThis topic is for liquid automatically mixing device simulation control,the fulfilling liquid mixing device automatically add liquid,automatic mixing automatic control function.In this design ladder diagram design is application of a timer and sequence control relay instructions to finish。

On the basis of the PLC program design combined with related peripheral devices formed an easy to industrial control of the whole system,easy to expand its function in the principle of design. The monitor system adopts PLC as control core, with automatic mixing two liquids function by the tanks sensor test highly liquid surface,in order to join A and B two liquids,stirring 3min after release mixture liquid. Process monitoring, we use is MCGS software,this is our country self—developed configuration software,applicable to the brand of PLC.In the course design of main equipment of the basic organization chart is mixing device control simulation experiments of panel figure,PLC selection,external hardware hookup and mapping to achieve the functional diagram,and in the GX_Developer GX. With weathering steel during commissioning,output of simulation corresponding instruction form;In the MCGS in design human—machine interface,for monitoring and tanks sensor and solenoid and flow pieces of attribute to set,while drawing history statements and will last a program in a PLC synchronization to MCGS,debugging realize simulation,real-timemonitoring of the interface and the history data and curve of real—time monitoring。

数据库事务处理的艺术1. 事务的定义与特性数据库事务是指一组与数据库操作相关的逻辑单元,这些操作要么全部成功执行,要么全部失败回滚。

事务必须具备ACID特性,即原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)和持久性(Durability)。

2. 事务的隔离级别数据库系统提供多个事务的隔离级别,包括未提交读(Read Uncommitted)、提交读(Read Committed)、可重复读(Repeatable Read)和串行化(Serializable)。

选择合适的隔离级别可以保证数据的一致性和并发性的平衡。

3. 事务的开始和结束事务的开始通过BEGIN TRANSACTION或START TRANSACTION语句来标识。

事务的结束有两种方式,一种是COMMIT用于成功提交事务,另一种是ROLLBACK用于回滚事务。

事务的结束需要根据业务需求和异常情况来决定。

4. 事务的并发控制并发控制对于多个并发事务的执行是必要的。

数据库系统使用锁、时间戳和多版本控制等机制来保证事务的隔离性和一致性。

在设计数据库应用时,需要考虑锁的粒度、锁的类型和事务的并发度等因素。

5. 事务的异常处理在事务处理中,可能发生各种异常情况,如数据库故障、网络中断、并发冲突等。

对于这些异常情况,需要合理地进行处理,要么回滚事务并重试,要么进行适当的异常处理,以保证数据的完整性和一致性。

6. 事务的性能优化事务处理的性能对于数据库系统的高效运行至关重要。

通过合理地设计数据库表结构、索引策略和查询优化等手段,可以提高事务处理的效率和并发性,从而提升整个系统的性能。

7. 事务的监控与日志对于大规模的数据库应用,事务的监控和日志是必不可少的。

通过记录事务的执行过程和状态变化,可以实时监控事务的运行情况,并进行故障排查和性能调优。

8. 事务的分布式处理随着分布式系统的兴起,分布式数据库事务成为一个重要的研究领域。