4.5特征建模

- 格式:ppt

- 大小:180.00 KB

- 文档页数:28

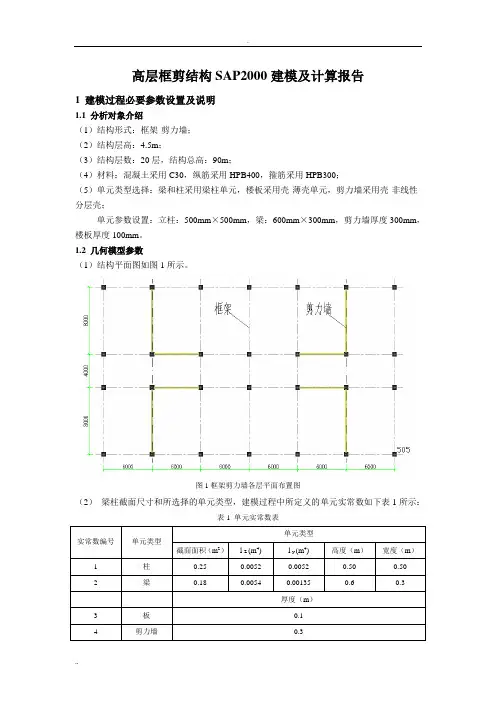

.高层框剪结构SAP2000建模及计算报告1 建模过程必要参数设置及说明1.1 分析对象介绍(1)结构形式:框架-剪力墙;(2)结构层高:4.5m;(3)结构层数:20层,结构总高:90m;(4)材料:混凝土采用C30,纵筋采用HPB400,箍筋采用HPB300;(5)单元类型选择:梁和柱采用梁柱单元,楼板采用壳-薄壳单元,剪力墙采用壳-非线性分层壳;单元参数设置:立柱:500mm×500mm,梁:600mm×300mm,剪力墙厚度300mm,楼板厚度100mm。

1.2 几何模型参数(1)结构平面图如图1所示。

图1框架剪力墙各层平面布置图(2)梁柱截面尺寸和所选择的单元类型,建模过程中所定义的单元实常数如下表1所示:表1 单元实常数表单元类型实常数编号单元类型截面面积(m2)l Z (m4)l y (m4) 高度(m)宽度(m)1 柱0.25 0.0052 0.0052 0.50 0.502 梁0.18 0.0054 0.00135 0.6 0.3厚度(m)3 板0.14 剪力墙0.31.3 SAP建模图2 X-Y平面@Z=4500mm图3 3维模型2 结果分析2.1 模态分析2.1.1求模型的前六阶自振频率和周期。

表2 模型的前六阶自振频率和周期类型分析类型分析阶数周期频率角频率特征值单位s s-1 rad/s rad2/s2模态Mode 1 1.892431 0.52842 3.3202 11.024 Mode 2 1.561719 0.64032 4.0232 16.187 Mode 3 1.508159 0.66306 4.1661 17.357 Mode 4 0.46633 2.1444 13.474 181.54 Mode 5 0.38717 2.5828 16.228 263.36 Mode 6 0.353476 2.829 17.775 315.972.1.2求模型的前六阶振型。

特征工程模型特征工程是机器学习中非常重要的一步,它的作用是将原始数据转化为适合机器学习算法使用的特征。

特征工程模型是指在特征工程过程中使用的各种方法和技术,用于对数据进行处理、转换和选择,以提取出能够最好地表达数据特点的特征。

特征工程模型的主要目标是提高机器学习算法的性能,使其能够更好地理解数据。

在特征工程模型中,我们通常需要考虑以下几个方面:1. 数据清洗:数据清洗是特征工程中的重要一步,它包括去除重复值、处理缺失值、处理异常值等。

通过数据清洗,我们可以保证数据的质量,避免因为脏数据对模型的影响。

2. 特征选择:特征选择是指从原始数据中选择出最重要的特征。

通过特征选择,我们可以减少特征的维度,提高模型的训练速度,并避免过拟合的问题。

3. 特征变换:特征变换是指对原始数据进行变换,使其更适合机器学习算法的使用。

常见的特征变换方法包括标准化、归一化、对数变换等。

4. 特征构建:特征构建是指从原始数据中构建新的特征。

通过特征构建,我们可以利用领域知识和经验,将原始数据转化为更能够表达数据特点的特征。

5. 特征组合:特征组合是指将多个特征进行组合,构建新的特征。

通过特征组合,我们可以发现特征之间的相互关系,并提取出更有信息量的特征。

在特征工程模型中,选择合适的特征工程方法是非常重要的。

不同的数据集和问题可能需要不同的特征工程方法。

以下是一些常用的特征工程方法:1. 独热编码:将离散型特征转化为二进制编码,用于处理分类问题。

2. 标签编码:将离散型特征转化为整数编码,用于处理分类问题。

3. 缺失值处理:根据缺失值的情况,选择填充、删除或者插值等方法进行处理。

4. 特征选择方法:包括过滤法、包装法和嵌入法等,用于选择最重要的特征。

5. 主成分分析:通过线性变换将原始特征转化为新的特征,用于降低维度。

6. 多项式特征:将原始特征的幂次方进行组合,用于发现特征之间的非线性关系。

7. 时间特征:从时间序列数据中提取出年份、季节、月份等时间特征,用于处理时间序列问题。

特征建模的名词解释特征建模是一种用于描述和捕捉事物特征的方法,它在许多领域中得到广泛应用,包括计算机科学、机器学习、统计学和生物学等。

特征建模的目标是将原始数据转化为更具信息量的特征向量,以便更好地表示和理解数据。

在特征建模中,特征是对数据的某种属性或特性的描述。

这些特征可以是定量的或定性的,可以是连续的或离散的,也可以是结构化的或非结构化的。

特征可以来自于数据本身,也可以通过预处理和特征提取的方式得到。

在构建特征模型时,我们需要选择哪些特征对我们的问题最有意义,并且需要选择适当的表示方法和特征提取技术。

特征建模的一个重要步骤是特征选择,即从原始数据中选择最有代表性和区分度的特征。

特征选择可以帮助降低数据维度,去除冗余或噪声特征,并提高建模的效果和效率。

常见的特征选择方法包括过滤式、包裹式和嵌入式方法。

过滤式方法通过对特征进行评估和排序,并根据某种准则选择最好的特征。

包裹式方法则根据最终的学习任务来选择特征,通过评估每个特征子集的性能来搜索最佳特征组合。

嵌入式方法则将特征选择与模型训练过程结合起来,通过正则化或其他手段来约束特征的选择。

另一个重要的步骤是特征提取,即从原始数据中提取出更有信息量和表示能力的特征。

特征提取可以通过各种方式实现,包括统计特征、频域特征、小波变换等。

这些方法根据数据的特点和问题的需求选择不同的特征提取方式。

例如,在图像处理中,我们可以使用颜色直方图、梯度方向直方图等统计特征来表示图像的颜色和纹理信息。

在文本挖掘中,我们可以使用词频、TF-IDF(词频-逆文档频率)等特征来表示文档的内容和关键词。

特征建模的一个重要应用领域是机器学习。

在机器学习中,特征建模是构建分类器或回归器的关键步骤之一。

通过选择和提取合适的特征,可以改善机器学习模型的性能和泛化能力。

许多经典的机器学习算法,如支持向量机(SVM)、决策树和神经网络等,都依赖于有效的特征建模。

特征建模在实际应用中具有广泛的应用价值。

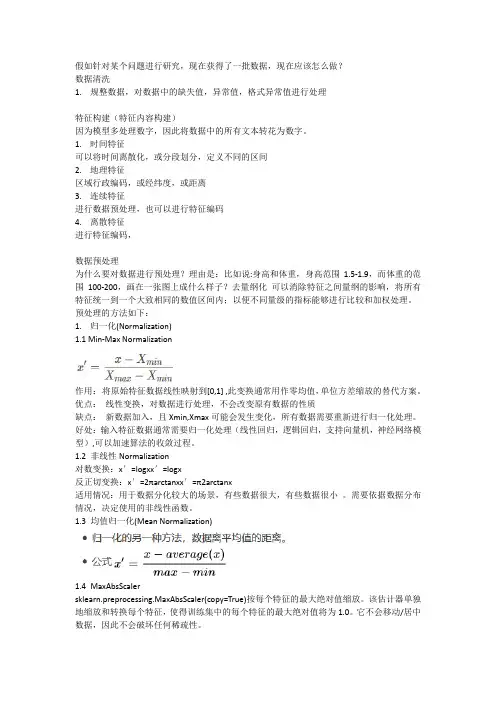

假如针对某个问题进行研究,现在获得了一批数据,现在应该怎么做?数据清洗1.规整数据,对数据中的缺失值,异常值,格式异常值进行处理特征构建(特征内容构建)因为模型多处理数字,因此将数据中的所有文本转花为数字。

1.时间特征可以将时间离散化,或分段划分,定义不同的区间2.地理特征区域行政编码,或经纬度,或距离3.连续特征进行数据预处理,也可以进行特征编码4.离散特征进行特征编码,数据预处理为什么要对数据进行预处理?理由是:比如说:身高和体重,身高范围1.5-1.9,而体重的范围100-200,画在一张图上成什么样子?去量纲化可以消除特征之间量纲的影响,将所有特征统一到一个大致相同的数值区间内;以便不同量级的指标能够进行比较和加权处理。

预处理的方法如下:1.归一化(Normalization)1.1 Min-Max Normalization作用:将原始特征数据线性映射到[0,1] ,此变换通常用作零均值,单位方差缩放的替代方案。

优点:线性变换,对数据进行处理,不会改变原有数据的性质缺点:新数据加入,且Xmin,Xmax可能会发生变化,所有数据需要重新进行归一化处理。

好处:输入特征数据通常需要归一化处理(线性回归,逻辑回归,支持向量机,神经网络模型),可以加速算法的收敛过程。

1.2非线性Normalization对数变换:x′=logxx′=logx反正切变换:x′=2πarctanxx′=π2arctanx适用情况:用于数据分化较大的场景,有些数据很大,有些数据很小。

需要依据数据分布情况,决定使用的非线性函数。

1.3均值归一化(Mean Normalization)1.4MaxAbsScalersklearn.preprocessing.MaxAbsScaler(copy=True)按每个特征的最大绝对值缩放。

该估计器单独地缩放和转换每个特征,使得训练集中的每个特征的最大绝对值将为1.0。

它不会移动/居中数据,因此不会破坏任何稀疏性。

c4.5算法例题一、算法简介C4.5算法是一种决策树生成算法,它是在C4算法的基础上进行改进得到的,具有更高的生成效率和准确性。

C4.5算法通过选择最佳特征、构建决策树、剪枝优化等步骤,生成可用于分类和预测的决策树模型。

二、算法步骤1. 特征选择:从输入数据中选择出与目标变量相关性最强、信息增益最大的特征作为最佳特征。

2. 构建决策树:根据最佳特征建立决策树的各个节点,每个节点包含一个属性值和一个分支,指向满足该属性值的样本集合。

3. 剪枝优化:通过剪枝算法对决策树进行优化,减少决策树的复杂度,提高模型的准确性和稳定性。

三、例题说明假设我们有一组葡萄酒品质的数据,数据集包括多个特征,如酒精度、酸度、甜度等,目标变量为葡萄酒的品质评分。

我们希望使用C4.5算法构建一个决策树模型,对新的葡萄酒进行品质预测。

1. 准备数据:将数据集导入到数据分析软件中,确保数据格式正确,特征和目标变量分离。

2. 特征选择:使用C4.5算法的特征选择步骤,从多个特征中选择出与品质评分相关性最强、信息增益最大的特征,如酒精度、酸度等。

3. 构建决策树:根据选定的特征,使用C4.5算法构建决策树。

首先,选择酒精度作为最佳特征,建立第一个节点。

根据酒精度的不同值,将样本分为两个子集。

然后,在每个子集中继续选择最佳特征建立分支,不断重复这个过程,直到达到决策树的终止条件(如叶节点)。

4. 剪枝优化:对决策树进行剪枝优化,减少其复杂度。

可以通过设置剪枝阈值、限制树的最大深度等方式进行优化。

5. 模型评估:使用测试数据集对优化后的决策树模型进行评估,评估指标包括准确率、召回率、AUC值等。

四、代码实现由于C4.5算法的实现较为复杂,需要一定的编程知识和技能。

这里以Python语言为例,展示使用Scikit-learn库实现C4.5算法的基本步骤。

假设已经将数据集加载到一个Pandas数据框中,命名为df。

```pythonfrom sklearn.model_selection import train_test_splitfrom sklearn.tree import C4_5, export_graphvizimport graphviz# 划分训练集和测试集X_train, X_test, y_train, y_test =train_test_split(df.drop('quality', axis=1), df['quality'],random_state=42)# 创建C4.5模型对象clf = C4_5()# 训练模型clf.fit(X_train, y_train)# 预测测试集结果y_pred = clf.predict(X_test)# 模型评估accuracy = clf.score(X_test, y_test)print('Accuracy:', accuracy)```五、总结通过以上步骤,我们可以使用C4.5算法构建一个用于葡萄酒品质预测的决策树模型。

第四章 指数函数与对数函数 4.5 函数的应用(二) 4.5.3 函数模型的应用教学设计一、教学目标1.会通过具体的函数模型分析实际问题,达到数学建模和数学运算核心素养学业质量水平一的层次.2.能够对问题进行分析,建立合适的数学模型,并对不同数学模型的契合度进行比较,择优选择,达到数学建模核心素养学业质量水平二的层次. 二、教学重难点 1.教学重点根据图、表信息建立函数模型,解决实际问题. 2.教学难点将实际问题抽象为数学问题,完成从文字语言、图表语言向符号语言的转化,并建立函数模型.三、教学过程 (一)新课导入人口问题是当今世界各国普遍关注的问题.认识人口数量的变化规律,可以为制定一系列相关政策提供依据,早在1798年,英国经济学家马尔萨斯(T.R.Malthus ,1766-1834)就提出了自然状态下的人口增长模型:0rty y e =,其中t 表示经过的时间,0y 表示t =0时的人口数,r表示人口的年平均增长率.(1)根据国家统计局网站公布的数据,我国1950年末、1959年末的人口总数分别为55 196万和67 207万,根据这些数据,用马尔萨斯人口增长模型建立我国在1950~1959年期间的具体人口增长模型.(2)利用(1)中的模型计算1951~1958年各年末的人口总数.查阅国家统计局网站公布的我国在1951~1958年间各年末的实际人口总数,检验所得模型与实际人口数据是否相符. (3)以(1)中的模型作预测,大约在什么时候我国人口总数达到13亿? (二)探究:数学建模的主要步骤教师:形如cxy ba =的函数为指数型函数,生产生活中以此函数建构模型的实例很多(如“新课导入”中的题目).教师引导学生审题、建模、求解、检验,尝试完成此问题. 教师和学生合作总结答题思路和题型特征.解:(1)由题意知0y = 55 196,设1950 -1959年期间我国人口的年平均增长率为r ,根据马尔萨斯人口增长模型,有 67 207=55 1969re ,由计算工具得r ≈0.021 876.因此,我国在1950 -1959年期间的人口增长模型为[]0.021********,0,9t y e t =∈.(2)分别取t =1,2,….,8,由0.021********ty e=可得我国在1951~1958年间的各年末人口总数;查阅国家统计局网站,得到我国1951~1958年各年末的实际人口总数,如下表所示:年份 1951 1952 1953 1954 1955 1956 1957 1958 计算所得人口数/万 5641757665589406024361576629386433065753实际人口总数/万5630057482587966026661465628286456365994根据1950~1959年我国人口总数的实际数据画出散点图,并画出函数[]0.021********,0,9t y e t =∈的图象(如下图).由表和图可以看出,所得模型与1950~1959年的实际人口数据基本吻合.(3)将y=130 000代入0.021********ty e=,由计算工具得t ≈39.15.所以,如果人口按照(1)中的模型增长,那么大约在1950年后的第40年(即1990年),我国的人口就已占到13亿.例1. 假设你有一笔资金用于投资,现有三种投资方案供你选择,这三种方案的回报如下:方案一:每天回报40元;方案二:第一天回报10元,以后每天比前一天多回报10元;方案三:第一天回报0.4元,以后每天回报比前一天翻一番.请问,你会选择哪种投资方案? 教师引导学生思考分析.我们可以先建立三种投资方案所对应的函数模型,再通过比较它们的增长情况,为选择投资方案提供依据.解:设第x 天所得回报是y 元,则方案一可以用函数y =40(x ∈N*)进行描述;方案二可以用函数y =10x (x ∈N*)进行描述;方案三可以用函数10.42(*)x y x N -=⨯∈进行描述,三种方案所得回报的增长情况的见教材第151页表4.5-5.再画出三个函数的图象(见教材第151页图4.5-7).由表和图可知,从每天所得回报看,在第1~3天,方案一最多;在第4天,方案一和方案二一样多,方案三最少;在第5~8天,方案二最多;第9天开始,方案三比其他两个方案所得回报多得多,到第30天所得回报已超过2亿元,下面再看累计的回报数,通过信息技术列表(见教材第152页表4.5-6).因此,投资1~6天,应选择方案一;投资7天,应选择方案一或方案二;投资8~10天,应选择方案二;投资11天(含11天)以上,则应选择方案三.学生通过对例题的思考和必要的交流,分析归纳例题的解题过程,简述建模的主要步骤: (1)理解问题:阅读理解,读懂文字叙述,认真审题,理解实际背景,弄清楚问题的实际背景和意义,设法用数学语言来描述问题.(2)简化假设:理解所给的实际问题之后,领悟背景中反映的实质,需要对问题作必要的简化,有时要给出一些恰当的假设,精选问题中关键或主要的变量.(3)数学建模:把握新信息,勇于探索,善于联想,灵活化归,根据题意建立变量或参数间的数学关系,实现实际问题数学化,引进数学符号,构建数学模型,常用的函数模型有一次函数、二次函数、指数函数、对数函数等.(4)求解模型:以所学的数学性质为工具对建立的数学模型进行求解.(5)检验模型:将所求的结果代回模型之中检验,对模拟的结果与实际情形比较,以确定模型的有效性:如果不满意,要考虑重新建模.(6)评价与应用:如果模型与实际情形比较吻合,要对计算的结果做出解释并给出其实际意义,最后对所建立的模型给出运用范围:如果模型与实际问题有较大出人,则要对模型改进并重复上述步展, (三)课堂练习例 1.某公司在甲、乙两地销售一种品牌车,利润(单位:万元)分别为21 5.060.15L x x =-和22L x =,其中x 为销售量(单位:辆).若该公司在这两地共销售15辆车,则能获得的最大利润为( ) A.45.606B.45.6C.45.56D.45.51解:设甲地销售x 辆,则乙地销售()15x -辆,从而总利润为()()()225.060.152150.15 3.06300015S x x x x x x x x =-+-=-++≥≤≤∈,,N ,显然,当10x =时,S 取得最大值45.6S =.故选B.例2.某工厂引进先进生产技术,产品产量从2011年1月到2012年8月的20个月间翻了两番,设月平均增长率为x ,则有( ) A.19()14x +=B.20()13x +=C.20()12x +=D.20()14x +=解:由平均增长率的定义可知,()2014x +=.故选D.3.某种计算机病毒是通过电子邮件进行传播的,下表是某公司前5天监测到的数据:则下列函数模型中,能较好地反映计算机在第x 天被感染的数量y 与x 之间的关系的是( ) A.10y x = B.25510y x x =-+ C.210log 10y x =+D.52x y =⨯解:对于A 选项,当1,2,3,4,5x =时,对应的y 值分别为10,20,30,40,50;对于B 选项,当1,2,3,4,5x =时,对应的y 值分别为10,20,40,70,110;对于C 选项,当1,2,3,4,5x =时,对应的y 值分别为2210,20,1010log 3,30,1010log 5++;对于D 选项,当1,2,3,4,5x =时,对应的y 值分别为10,20,40,80,160.而表中所给的数据当1,2,3,4,5x =时,对应的y 值分别为10,20,39,81,160,通过y=⨯能较好地反映y与x之间的关系,故选D. 比较,即可发现选项D中y的值误差最小,即52x(四)小结作业小结:本节课我们主要学习了哪些内容?数学建模的主要步骤:(1)理解问题(2)简化假设(3)数学建模(4)求解模型(5)检验模型(6)评价与应用四、板书设计1.问题导入:例题2.数学建模的主要步骤:(1)理解问题(2)简化假设(3)数学建模(4)求解模型(5)检验模型(6)评价与应用。

c4.5算法的基本原理-回复什么是C4.5算法?C4.5算法是机器学习领域中的一种决策树算法,是ID3算法的改进版本。

它由Ross Quinlan于1993年提出,是一种用于分类问题的监督学习算法。

C4.5算法的基本原理是通过对数据集进行划分来构建决策树,以实现对新样本进行分类。

下面将详细介绍C4.5算法的基本原理和步骤。

C4.5算法的基本原理是基于信息增益来选择最优特征进行划分。

在构建决策树的过程中,C4.5算法通过计算每个特征的信息增益比来选择最优特征,从而实现对数据集的划分。

信息增益是指在得知某个特征的取值后,对分类结果的不确定性减少的程度。

C4.5算法的步骤如下:1. 选择最优特征:计算每个特征的信息增益比,选择具有最大信息增益比的特征作为当前节点的划分特征。

2. 划分数据集:根据划分特征将数据集划分为多个子数据集,每个子数据集包含具有相同特征值的样本。

3. 递归构建子树:对每个子数据集递归地应用步骤1和步骤2,构建子树。

4. 停止划分:当数据集的所有属性都已经被使用或者数据集中的样本都属于同一类别时,停止划分,将当前节点标记为叶节点,并将叶节点标记为数据集中样本数最多的类别。

5. 构建决策树:将步骤3中得到的子树连接到当前节点,构成完整的决策树。

具体来说,C4.5算法的核心步骤是选择最优特征和划分数据集。

在选择最优特征时,C4.5算法通过计算每个特征的信息增益比来选择最优特征。

信息增益比是信息增益除以划分数据集的熵,熵是度量数据集的纯度的指标。

信息增益比能够避免特征取值较多而导致的信息增益偏大的问题,从而更加准确地选择最优特征。

划分数据集是将数据集根据划分特征的取值划分为多个子数据集,每个子数据集包含具有相同特征值的样本。

划分后的子数据集可以分别作为子树的训练数据,递归地构建子树。

每个子树的构建过程都是通过选择最优特征和划分数据集来实现的。

当数据集的所有属性都已经被使用或者数据集中的样本都属于同一类别时,停止划分,将当前节点标记为叶节点,并将叶节点标记为数据集中样本数最多的类别。

特征建模法

特征建模法是一种数据分析方法,旨在通过对数据中的特征进行分析和建模来预测某些特定的结果。

这种方法通常用于大量数据的分析,例如在商业、医疗和科学领域。

特征建模法的过程包括准备数据集、选择合适的特征、特征提取、特征选择和最终模型的构建。

在准备数据集阶段,需要收集大量的数据,并对数据进行初步清洗和筛选,以确保数据的准确性和完整性。

在选择合适的特征阶段,需要根据问题的性质和背景知识选出与问题相关的特征。

特征提取是将原始数据转换为特征的过程,这些特征通常是数字或类别特征。

特征选择是根据某些准则选出最具有预测能力的特征。

最终模型的构建通常是通过机器学习算法实现的。

其中常用的算法有决策树、神经网络、支持向量机和朴素贝叶斯等。

构建好的模型可以应用于新数据的预测和分类。

在特征建模法中,特征的选择和提取是非常重要的环节,可以显著影响模型的预测能力。

因此,该方法需要对数据领域有一定的专业知识,并且需要不断调整和改进,以达到更好的预测效果。

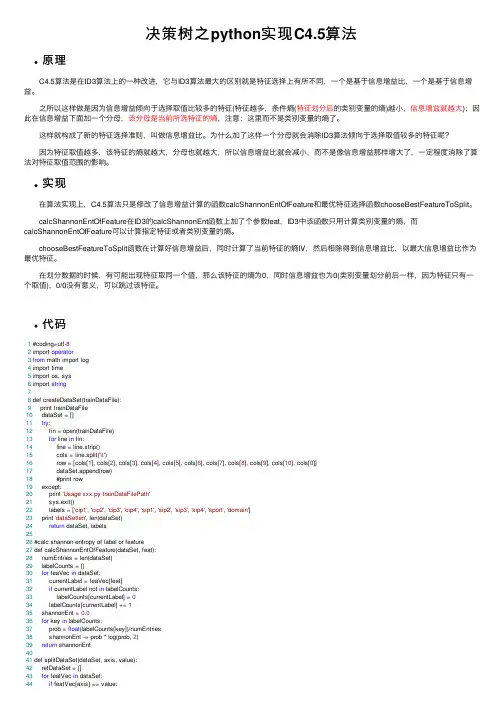

决策树之python实现C4.5算法原理 C4.5算法是在ID3算法上的⼀种改进,它与ID3算法最⼤的区别就是特征选择上有所不同,⼀个是基于信息增益⽐,⼀个是基于信息增益。

之所以这样做是因为信息增益倾向于选择取值⽐较多的特征(特征越多,条件熵(特征划分后的类别变量的熵)越⼩,信息增益就越⼤);因此在信息增益下⾯加⼀个分母,该分母是当前所选特征的熵,注意:这⾥⽽不是类别变量的熵了。

这样就构成了新的特征选择准则,叫做信息增益⽐。

为什么加了这样⼀个分母就会消除ID3算法倾向于选择取值较多的特征呢? 因为特征取值越多,该特征的熵就越⼤,分母也就越⼤,所以信息增益⽐就会减⼩,⽽不是像信息增益那样增⼤了,⼀定程度消除了算法对特征取值范围的影响。

实现 在算法实现上,C4.5算法只是修改了信息增益计算的函数calcShannonEntOfFeature和最优特征选择函数chooseBestFeatureToSplit。

calcShannonEntOfFeature在ID3的calcShannonEnt函数上加了个参数feat,ID3中该函数只⽤计算类别变量的熵,⽽calcShannonEntOfFeature可以计算指定特征或者类别变量的熵。

chooseBestFeatureToSplit函数在计算好信息增益后,同时计算了当前特征的熵IV,然后相除得到信息增益⽐,以最⼤信息增益⽐作为最优特征。

在划分数据的时候,有可能出现特征取同⼀个值,那么该特征的熵为0,同时信息增益也为0(类别变量划分前后⼀样,因为特征只有⼀个取值),0/0没有意义,可以跳过该特征。

代码1 #coding=utf-82 import operator3from math import log4 import time5 import os, sys6 import string78 def createDataSet(trainDataFile):9 print trainDataFile10 dataSet = []11try:12 fin = open(trainDataFile)13for line in fin:14 line = line.strip()15 cols = line.split('\t')16 row = [cols[1], cols[2], cols[3], cols[4], cols[5], cols[6], cols[7], cols[8], cols[9], cols[10], cols[0]]17 dataSet.append(row)18 #print row19 except:20 print 'Usage xxx.py trainDataFilePath'21 sys.exit()22 labels = ['cip1', 'cip2', 'cip3', 'cip4', 'sip1', 'sip2', 'sip3', 'sip4', 'sport', 'domain']23 print 'dataSetlen', len(dataSet)24return dataSet, labels2526 #calc shannon entropy of label or feature27 def calcShannonEntOfFeature(dataSet, feat):28 numEntries = len(dataSet)29 labelCounts = {}30for feaVec in dataSet:31 currentLabel = feaVec[feat]32if currentLabel not in labelCounts:33 labelCounts[currentLabel] = 034 labelCounts[currentLabel] += 135 shannonEnt = 0.036for key in labelCounts:37 prob = float(labelCounts[key])/numEntries38 shannonEnt -= prob * log(prob, 2)39return shannonEnt4041 def splitDataSet(dataSet, axis, value):42 retDataSet = []43for featVec in dataSet:44if featVec[axis] == value:45 reducedFeatVec = featVec[:axis]46 reducedFeatVec.extend(featVec[axis+1:])47 retDataSet.append(reducedFeatVec)48return retDataSet4950 def chooseBestFeatureToSplit(dataSet):51 numFeatures = len(dataSet[0]) - 1 #last col is label52 baseEntropy = calcShannonEntOfFeature(dataSet, -1)53 bestInfoGainRate = 0.054 bestFeature = -155for i in range(numFeatures):56 featList = [example[i] for example in dataSet]57 uniqueVals = set(featList)58 newEntropy = 0.059for value in uniqueVals:60 subDataSet = splitDataSet(dataSet, i, value)61 prob = len(subDataSet) / float(len(dataSet))62 newEntropy += prob *calcShannonEntOfFeature(subDataSet, -1) #calc conditional entropy63 infoGain = baseEntropy - newEntropy64 iv = calcShannonEntOfFeature(dataSet, i)65if(iv == 0): #value of the feature is all same,infoGain and iv all equal 0, skip the feature66continue67 infoGainRate = infoGain / iv68if infoGainRate > bestInfoGainRate:69 bestInfoGainRate = infoGainRate70 bestFeature = i71return bestFeature7273 #feature is exhaustive, reture what you want label74 def majorityCnt(classList):75 classCount = {}76for vote in classList:77if vote not in classCount.keys():78 classCount[vote] = 079 classCount[vote] += 180return max(classCount)8182 def createTree(dataSet, labels):83 classList = [example[-1] for example in dataSet]84if classList.count(classList[0]) ==len(classList): #all data is the same label85return classList[0]86if len(dataSet[0]) == 1: #all feature is exhaustive87return majorityCnt(classList)88 bestFeat = chooseBestFeatureToSplit(dataSet)89 bestFeatLabel = labels[bestFeat]90if(bestFeat == -1): #特征⼀样,但类别不⼀样,即类别与特征不相关,随机选第⼀个类别做分类结果 91return classList[0]92 myTree = {bestFeatLabel:{}}93 del(labels[bestFeat])94 featValues = [example[bestFeat] for example in dataSet]95 uniqueVals = set(featValues)96for value in uniqueVals:97 subLabels = labels[:]98 myTree[bestFeatLabel][value] = createTree(splitDataSet(dataSet, bestFeat, value),subLabels)99return myTree100101 def main():102if(len(sys.argv) < 3):103 print 'Usage xxx.py trainSet outputTreeFile'104 sys.exit()105 data,label = createDataSet(sys.argv[1])106 t1 = time.clock()107 myTree = createTree(data,label)108 t2 = time.clock()109 fout = open(sys.argv[2], 'w')110 fout.write(str(myTree))111 fout.close()112 print 'execute for ',t2-t1113if __name__=='__main__':114 main()本⽂来⾃于:谢谢博主。

特征建模方法特征建模方法是指在数据挖掘和机器学习领域中,将原始数据转换成有用的特征与特征集合的技术过程。

具体来说,它是一种将原始数据转换成特征的过程,这些特征可以用于训练和构建分类器或其他算法。

该方法旨在提高分类器或最终算法的准确性和性能。

下面将介绍一些特征建模方法。

1. 特征选择特征选择是从原始数据中选择最相关的特征,这些特征可以提高训练和构建分类器或其他算法的性能。

这种方法可以通过过滤或包装的方式实现。

过滤方法利用特征之间的相关性或重要性来选择特征。

包装方法则通过构建多个模型并评估其性能来选择特征。

2. 主成分分析主成分分析(PCA)是一种用于降维的技术,它可以将高维数据转换成低维数据,并保留大部分的信息和方差。

该方法通过将数据投影到新的轴上来实现降维。

这些新轴将保留原始数据的最大方差。

这种方法可以用于降低特征集的维数,从而提高分类器或算法的性能。

3. 独热编码独热编码(One-Hot Encoding)是一种将分类变量转换成数字变量的方法。

该方法为每个分类变量创建一个二进制变量,并将它们设置为1或0,表示该变量是否出现。

这种方法可以将分类数据用于分类器或算法的训练和构建,从而提高其性能。

4. 交叉特征交叉特征是指将两个或多个特征结合在一起创建一个新变量的方法。

这种方法可以捕捉特征之间的交互作用,并将其用于训练和构建分类器或其他算法。

例如,将两个特征合并为一个新特征,可以使分类器更好地识别某些模式和关联性。

5. Word2VecWord2Vec是一种基于向量的方法,用于捕捉单词之间的语义和上下文关系。

该方法将每个单词表示为一个向量,并使用单词在上下文中的相对位置来捕捉其含义。

这种方法可以用于将自然语言文本转换成数值特征,并将其用于分类器或算法的训练和构建。