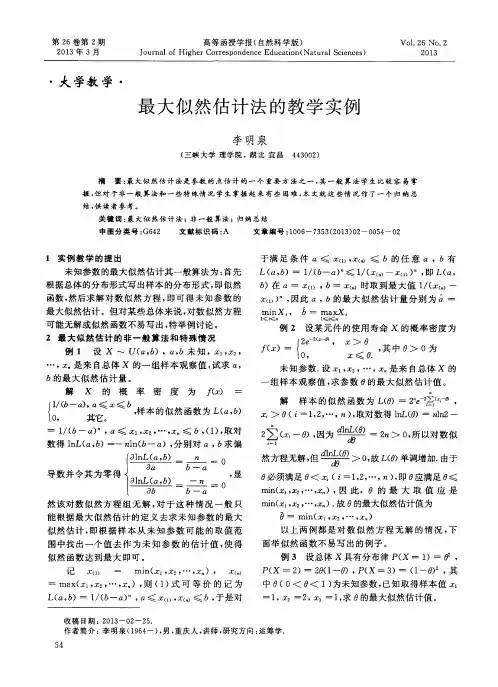

最大似然估计法

- 格式:ppt

- 大小:444.50 KB

- 文档页数:32

最大似然估计值例题详解最大似然估计(Maximum Likelihood Estimation, 简称MLE)是一种常用的参数估计方法,用于找到最符合观测数据的统计模型参数值。

在统计学和机器学习中,我们经常需要根据观测到的数据来估计模型的未知参数。

最大似然估计是一种基于统计学原理的方法,它通过最大化观测数据的似然函数来求得参数的估计值。

下面我们以一个例题来详细介绍最大似然估计的原理和步骤。

假设有一组观测数据X = {x1, x2, ..., xn},我们希望通过这些数据来估计某个未知参数θ。

我们假设这组观测数据服从某个已知的概率分布,同时假设每个观测值都是独立同分布的。

我们的目标是找到使得这组观测数据的概率最大的参数值。

首先,我们需要给出观测数据的概率分布函数。

假设观测数据服从正态分布N(μ, σ^2),其中μ和σ^2是未知参数。

我们可以写出似然函数L(θ):L(θ) = P(X | θ) = ∏[i=1, n] P(xi | θ)其中,P(xi | θ)是观测数据xi的概率密度函数。

根据正态分布的概率密度函数公式,我们可以得到:P(xi | θ) = (1 / (√(2π)σ)) * exp(-(xi - μ)^2 /(2σ^2))接下来,我们需要求解使得似然函数最大化的参数估计值。

常用的方法是对似然函数取对数,得到对数似然函数:ln(L(θ)) = ln(∏[i=1, n] P(xi | θ)) = ∑[i=1, n] ln(P(xi | θ))由于对数函数是单调递增的,对数似然函数的最大值与似然函数的最大值出现在相同的参数值上。

因此,我们可以通过最大化对数似然函数来得到参数的估计值。

接下来,我们需要使用优化算法来求解最大化对数似然函数的问题。

常用的方法包括梯度下降法和牛顿法等。

在这个例题中,我们可以通过计算偏导数来得到对数似然函数的最大值。

对数似然函数的偏导数是一个关于参数的方程,我们可以使用数值优化方法来求解这个方程,找到对数似然函数的最大值所对应的参数估计值。

最大似然估计的原理及应用1. 原理概述最大似然估计(Maximum Likelihood Estimation,简称MLE)是统计学中一种常见的参数估计方法,通过寻找使观测数据发生的概率最大化的参数值,来估计未知参数的方法。

其基本原理是在给定观测数据的条件下,选择参数值使得似然函数(或对数似然函数)最大。

2. 最大似然估计的步骤最大似然估计的步骤可以总结为以下几点:1.建立概率模型:根据观测数据的特点,选择合适的概率分布模型,如高斯分布、泊松分布等。

2.构建似然函数:将观测数据与参数构成的概率模型相结合,得到关于参数的似然函数。

3.对似然函数取对数:通常对似然函数取对数,方便计算和推导。

4.求导并解方程:对似然函数取导数,并解方程找到使似然函数最大化的参数值。

5.参数估计:得到使似然函数最大化的参数值,作为对未知参数的估计。

3. 最大似然估计的优点最大似然估计具有以下几个优点:•简单易用:只需要建立合适的概率模型,并求解似然函数的最大值,无需额外的假设或先验知识。

•有效性:在样本量充足的情况下,最大似然估计能够产生高质量的参数估计结果。

•渐进无偏性:在样本量趋于无穷的情况下,最大似然估计的结果具有无偏性。

4. 最大似然估计的应用4.1. 二项分布的参数估计二项分布是一种常见的离散概率分布,用于描述n次独立的二元试验中成功次数的概率分布。

最大似然估计可以用来估计二项分布的参数。

假设我们观测到了一系列成功次数的数据,我们可以建立一个二项分布模型,并使用最大似然估计来确定二项分布的参数,如成功概率p。

4.2. 正态分布的参数估计正态分布是一种常见的连续概率分布,具有对称性和钟形曲线特点。

最大似然估计可以用来估计正态分布的参数,包括均值和方差。

假设我们观测到一组服从正态分布的数据,我们可以建立正态分布模型,并使用最大似然估计来确定正态分布的参数,如均值和方差。

4.3. 泊松分布的参数估计泊松分布是一种常见的离散概率分布,用于描述单位时间内独立事件发生次数的概率分布。

最大似然估计计算公式

最大似然估计是一种统计方法,用于估计一个模型中的未知参数值。

它基于观察到的数据,通过找到使得观察数据出现的概率最大的参数值来进行估计。

最大似然估计的计算公式如下:

假设我们有一个总体数据集,其中包含n个观测值。

我们希望估计一个参数θ,使得在给定这些观测值的情况下,出现这些观测值的概率最大。

我们可以利用似然函数L(θ)来表示这个概率。

似然函数L(θ)可以定义为观测值的联合概率密度函数(如果观测值是连续的)或联合概率质量函数(如果观测值是离散的)。

假设每个观测值都是独立同分布的,那么似然函数可以写作L(θ) = f(x₁;θ) * f(x ₂;θ) * ... * f(xₙ;θ),其中f(x;θ)表示观测值x在给定参数θ下的概率密度函数或概率质量函数。

为了找到最大似然估计,我们需要最大化似然函数L(θ)关于参数θ的值。

通常是通过对似然函数取对数,将乘法转化为加法,从而简化计算。

我们得到对数似然函数logL(θ) = log(f(x₁;θ)) + log(f(x₂;θ)) + ... + log(f(xₙ;θ))。

最大似然估计的计算公式可以写作:

θ^ = argmax(logL(θ))

即找到使得logL(θ)取得最大值的参数θ^。

一般情况下,我们使用数值优化方法(如梯度下降法或牛顿方法)来求解这个最优化问题,找到使得logL(θ)最大化的参数值θ^。

最终,θ^就是对未知参数θ的最大似然估计值。

通过最大似然估计,我们可以使用观测数据来估计模型中的未知参数,从而使得模型能更好地拟合观测数据,并进行各种统计推断和预测。

参数估计公式最大似然估计贝叶斯估计矩估计参数估计是统计学中的一个重要问题,它的目标是通过已经观测到的样本数据来估计未知参数的值。

在参数估计中,最大似然估计、贝叶斯估计和矩估计是常用的方法。

下面将分别介绍这三种估计方法及其公式。

一、最大似然估计最大似然估计是一种常用的参数估计方法,它基于样本数据的观测结果,通过寻找参数值使得观测样本出现的概率最大化来估计未知参数的值。

最大似然估计的公式如下所示:$$\hat{\theta}_{MLE} = \arg \max_{\theta} P(X|\theta)$$其中,$\hat{\theta}_{MLE}$表示最大似然估计得到的参数值,$P(X|\theta)$表示给定参数$\theta$下观测样本$X$出现的概率。

二、贝叶斯估计贝叶斯估计是另一种常用的参数估计方法,它基于贝叶斯定理,通过在先验分布和观测数据的基础上更新参数的后验分布来进行参数估计。

贝叶斯估计的公式如下所示:$$P(\theta|X) = \frac{P(X|\theta)P(\theta)}{P(X)}$$其中,$P(\theta|X)$表示给定观测样本$X$后,参数$\theta$的后验分布;$P(X|\theta)$表示给定参数$\theta$下观测样本$X$出现的概率;$P(\theta)$表示参数$\theta$的先验分布;$P(X)$表示观测样本$X$的边缘概率。

三、矩估计矩估计是一种基于样本矩的无偏估计方法,它通过样本矩与理论矩之间的差异来估计未知参数的值。

矩估计的公式如下所示:$$\hat{\theta}_{MME} = g(\overline{X}_n)$$其中,$\hat{\theta}_{MME}$表示矩估计得到的参数值,$g(\cdot)$表示由样本矩计算得到参数的函数,$\overline{X}_n$表示样本的均值。

在实际应用中,最大似然估计常用于样本量较大、参数唯一可估情况下的参数估计;贝叶斯估计常用于样本量较小、先验分布已知情况下的参数估计;矩估计常用于样本量较大、参数个数较多时的参数估计。

均匀函数的最大似然估计均匀分布是统计学中常见的一种概率分布,它具有简单直观的特点。

在实际应用中,我们经常需要根据已知的样本数据来估计均匀分布的参数。

最大似然估计是一种常用的参数估计方法,它可以用来估计均匀分布的参数。

我们来了解一下均匀分布。

均匀分布是指在一定的取值范围内,各个取值的概率是相等的。

在一维情况下,均匀分布可以用一个区间[a, b]来表示,其中a为下界,b为上界。

在二维情况下,均匀分布可以用一个矩形区域[a, b]x[c, d]来表示。

对于一维均匀分布,我们可以通过最大似然估计来估计参数a和b。

假设我们有一个样本数据集X={x1, x2, ..., xn},我们需要找到最合适的参数a和b,使得样本数据在[a, b]范围内出现的概率最大。

最大似然估计的思想是,选择参数的值,使得观测到当前样本的概率最大。

对于均匀分布来说,每个样本数据在[a, b]范围内出现的概率都是1/(b-a),因此整个样本数据集的概率可以表示为(1/(b-a))^n。

我们的目标是找到使得概率最大的参数值。

为了简化计算,我们可以对概率取对数,即ln((1/(b-a))^n)=-nln(b-a)。

因为对数函数是单调递增的,所以概率最大化的参数值与对数概率最大化的参数值是一致的。

因此,我们可以通过最大化对数概率来估计参数。

为了找到最大化对数概率的参数值,我们需要对参数进行约束。

在一维均匀分布中,参数a和b的取值范围是有限的,即a<=x<=b。

这意味着参数a和b之间的关系是:b>=a。

接下来,我们来推导最大似然估计的具体步骤。

首先,我们需要求解对数概率的导数,并令导数等于0,以找到极值点。

对ln((1/(b-a))^n)=-nln(b-a)求导,得到-ln(b-a)=-n/(b-a)。

然后,解方程-ln(b-a)=-n/(b-a),得到b-a=√(n),即b=a+√(n)。

因此,最大似然估计给出的参数值为a和b分别为样本数据的最小值和最大值。

最大对数似然估计是一种常用的参数估计方法,用于估计统计模型的参数值。

在凸优化中,可以使用最大对数似然估计来求解一些凸优化问题。

假设我们有一个关于参数向量θ的对数似然函数L(θ),我们的目标是找到能最大化该函数的参数值,即找到θ* = argmax L(θ)。

在凸优化中,我们希望求解的问题是凸问题,即有一个凸目标函数和一些凸约束。

虽然最大对数似然估计本身可能不是凸问题,但很多常见的模型满足凸性质,使得最大对数似然估计可以转化为凸优化问题。

通常,我们将对数似然函数取负值,得到负对数似然函数,即f(θ) = -L(θ)。

然后,我们可以根据具体的模型和约束条件,将最大对数似然估计问题转化为具有凸目标函数和凸约束的优化问题。

常见的凸优化算法,如梯度下降法、共轭梯度法、牛顿法或拟牛顿法等,可以用于求解这个凸优化问题,以找到最大对数似然估计对应的参数值。

总结起来,在凸优化中,可以使用最大对数似然估计来求解一些满足凸性质的统计模型的参数估计问题。

通过将对数似然函数取负值,并将最大对数似然估计问题转化为凸优化问题,应用常见的凸优化算法可以找到最大对数似然估计的参数值。

伯努利分布的最大似然估计法公式

伯努利分布的最大似然估计法公式是指,在伯努利分布中,根据已知参数和样本数据,通过最大化似然函数,得到使得样本出现概率最大的未知参数的估计方法。

具体地,对于一组二元随机变量X,X取值为0或1,且概率为p,1-p。

如果我们观测到n次独立的X取值,其中有m次为1,那么伯努利分布的最大似然估计法公式为:p=m/n。

该公式可用于估计一个未知的二元随机变量X的概率分布参数p,从而可以进一步用于预测或分类等应用。

- 1 -。

幂律分布最大似然估计法你知道吗?生活中有一种神奇的现象,叫做“幂律分布”,听上去是不是挺酷的?其实它就像一个神秘的规律,像是自然界的秘密武器,隐藏在我们周围的各种事物里。

我们会发现,有些东西的分布看起来非常不寻常:就拿网络上的名气来说吧。

一个人可能在网上突然就火了,而大多数人却始终默默无闻。

你会发现,少数人拥有绝大部分的资源或者关注,而大多数人都只有一点点。

嗯,你想知道这种现象怎么量化吗?这就是幂律分布的厉害之处。

可能你就好奇了:幂律分布是啥玩意儿?怎么就能这么神奇?其实呢,幂律分布就是指某些事物的数量和它们的大小之间存在某种“倒数”的关系。

举个例子吧:有些城市的居民数量可能比其他城市多几百倍,然而这些“超级城市”的数量却远远少于小城市。

就像是一个“头部效应”一样,最火的几个就占据了大部分的流量或资源,其余的则像是小星星,微不足道。

哎,人生就是这样吧,大部分人都在默默无闻地努力,只有少数几个“大佬”能站在聚光灯下。

而要搞明白幂律分布的秘密,我们就得用到一个非常有用的工具:最大似然估计法。

这个名字听上去就像是数学考试中的一个大难题,但其实它不那么复杂。

说白了,最大似然估计就是一种通过已知数据来推测某个分布最可能的参数值的方法。

比如说,你拿到了一堆数据,想知道这个数据到底是遵循什么样的规律,最大似然估计就能帮你找出最合适的规律,也就是找出“最佳的”幂律指数。

来,咱们把话题再拉回来。

假设你有一堆数字,可能是某个网站的访问量,可能是某些城市的面积,也可能是股票市场的涨跌幅。

你想知道,这些数字是不是符合幂律分布。

嗯,简单地说,你可以通过最大似然估计法来算出一个最合适的“指数”,也就是幂律分布的参数。

说到这里,大家可能都觉得这个方法有点像侦探破案的过程——数据就是线索,最大似然估计就是侦探,找到答案的那一刻,你会恍若大悟,哦,原来如此!最大似然估计法就像是一个“量体裁衣”的过程。

你拿到的原始数据有很多种可能的“样子”,但是你希望能找到最贴合这些数据的模型。

最大似然估计公式了解最大似然估计的计算公式最大似然估计(Maximum Likelihood Estimation, MLE)是概率统计学中常用的一种参数估计方法,旨在通过大量观测数据,根据最有可能(最大似然)导致观测结果发生的参数值,来估计未知参数的值。

在概率模型中,假设数据服从某一分布,而最大似然估计能够找出使得观测数据出现概率最大的参数值。

一、最大似然估计的基本概念最大似然估计的基本思想是通过选择合适的参数值,使得观测数据出现的概率最大化。

在给定观测数据和参数模型的前提下,我们可以通过最大化似然函数来获得最可信的参数估计。

似然函数(Likelihood Function)是指在给定某个参数值的条件下,观测数据出现的可能性。

似然函数的计算公式如下:L(θ|x) = f(x|θ)其中,L代表似然函数,θ代表参数值,x代表观测数据。

f(x|θ)表示基于参数θ的概率密度函数或概率质量函数。

似然函数的求解就是寻找使得给定观测数据出现概率最大的参数值。

二、最大似然估计的计算公式在进行最大似然估计时,我们通常需要计算似然函数的极大值点。

为了简化计算,我们常使用对数似然函数(Log-Likelihood Function)来替代似然函数。

对数似然函数的计算公式如下:ln L(θ|x) = Σ ln f(xi|θ)其中,ln表示自然对数,Σ表示求和运算。

ln L(θ|x)表示对数似然函数,xi表示第i个观测数据。

利用对数似然函数,最大似然估计的目标就是寻找使得对数似然函数最大的参数估计值。

为了找到使对数似然函数最大的参数值,我们需要采用数值优化的方法,例如梯度下降法或牛顿法等。

三、最大似然估计的应用最大似然估计广泛应用于各个领域的数据建模和参数估计中。

以下是最大似然估计在常见概率模型中的应用实例:1. 二项分布:最大似然估计可以用于估计二项分布的参数p,即成功的概率。

在伯努利试验或二项试验中,成功与失败的结果按独立的概率p和1-p发生。

稳健最大似然(mlr)估计方法The robust maximum likelihood estimation method (mlr) is a statistical technique used to estimate the parameters of a model while accounting for outliers or extreme values in the data. This method is particularly useful in situations where traditional maximum likelihood estimation may be prone to bias or inefficiency due to the presence of outliers. By incorporating robust estimators, such as the Huber or Tukey biweight functions, mlr helps to reduce the impact of outliers on parameter estimates, resulting in more reliable and accurate model fitting.稳健最大似然估计方法(mlr)是一种统计技术,用于在考虑数据中的异常值或极端值的情况下估计模型的参数。

这种方法特别适用于传统最大似然估计可能因为异常值存在而产生偏差或低效的情况。

通过结合稳健估计器,如Huber或Tukey双加权函数,mlr有助于减少异常值对参数估计的影响,从而实现更可靠和准确的模型拟合。

One of the key advantages of the robust maximum likelihood estimation method is its ability to provide consistent estimates even in the presence of outliers. Traditional maximum likelihoodestimation methods are sensitive to outliers, which can greatly impact the accuracy of parameter estimates and the overall fit of the model. By using robust estimators, mlr is able to downweight the influence of outliers while still maintaining the consistency of parameter estimates, resulting in more robust and reliable inference.稳健最大似然估计方法的关键优势之一是它能够在存在异常值的情况下提供一致的估计。

最大似然估计的原理及其应用摘要:了解最大似然估计的原理,并通过其原理来解决生活中的某些概率与统计的问题。

引言:似然函数 是θ的函数,表示由参数θ产生样本值 的“可能性”大小.将样本观察看成“结果",θ是产生结果的“原因”,则是度量产生该结果的各种 “原因"的机会。

因此,θ的一个合理的估计应使这种机会(即)达到最大的那个值。

关键词:似然函数,最大似然估计,最大似然估计值。

(1)似然函数 设描述总体的随机变量X的概率密度函数为,其中k θθθ,,,21⋯都是总体的未知参数(若X是离散型的,则约定表示概率分布,总体的样本X1,X2,…,Xn 的测量值为n x x x ,,,21⋯,也可以理解为是n维独立随机向量(X1,X2,…, Xn)的一个测量值.即是说,对一维随机变量进行n次测量得到的n个测量值可以看成是对n维独立的随机向量进行一次测量得到的n个测量值。

由于n维随机向量的联合概率密度为∏=⋯n i k i x f 121),,;(θθθ显然,对于样本的一个测量值,它是k θθθ,,,21⋯的函数,记为并称它为似然函数,简记为L。

对于离散型随机变量。

应该注意,似然函数与参数k θθθ,,,21⋯有关,对于给定的样本值,它是这些参数的函数.(2) 最大似然估计值设总体含未知参数k θθθ,,,21⋯,对于给定的样本值如有 ∏∏==⋯>⋯ni k i n i k i x f x f 121121)'',';()ˆ,,ˆ,ˆ;(θθθθθθ 其中k θθθˆ,,ˆ,ˆ21⋯为未知参数k θθθ,,,21⋯可能取的某一组值,而k '','21θθθ⋯为k θθθ⋯21,的一切其他可能取值,此时,我们可认为k θθθˆ,,ˆ,ˆ21⋯,比k '','21θθθ⋯作为k θθθ,,,21⋯的估值要好些。

这是因为不等式说明,k θθθ,,,21⋯取k θθθˆ,,ˆ,ˆ21⋯时得到样本值n x x x ,,,21⋯的可能性最大,这样的估计值就是k θθθ,,,21⋯的最大似然估计值。

最大似然估计法是由英国统计学家R.A.Fisher 于1912年提出来的,随后经过进一步的发展,成了一种普遍采用的估计方法。

与矩估计法不同的是,它使用了总体的概率分布,从而很好的利用了总体分布提供的有关θ的信息,所以具有许多优良的性质。

前提:总体分布已知 1. 准备工作定义1 设总体的密度函数(或分布列)为),(θx f ,其中T k),,,(21θθθθ =为待估参数。

若T nX X X ),,,(21 是来自总体的样本,则样本的联合密度函数(或联合分布列)为∏=ni ix f 1),(θ。

一旦抽样结束,取定n x x x ,,,21 后,我们可以把它看作待估参数Tk),,,(21θθθθ =的函数,记为)(θL ,即∏==n i i x f L 1),()(θθ我们称这里的函数)(θL 为似然函数。

从定义1不难看出,样本的联合概率分布和似然函数其实是同一个事物从不同侧面看得到的两个概念。

前者度量的是固定参数θ后,试验出现各种样本值的概率;而后者度量的是样本值n x x x ,,,21 出现后,样本空间Θ中的各个可能参数θ导致这个样本值出现的概率。

综上所述,最大似然估计的思想是:在试验的结果出现的情况下,应该寻求使这个结果出现的可能性最大的那个θ值作为θ的估计。

定义2 若对任意给定的样本值n x x x ,,,21 ,存在),,,(ˆˆ21n x x x θθ=,使)(max )ˆ(θθθL L Θ∈= 则称),,,(ˆˆ21n x x x θθ=为θ的最大似然估计值,称相应的统计量),,,(ˆˆ21n X X X θθ=为θ的最大似然估计量,两者统称为最大似然估计。

2.步骤通过以上定义不难看出,最大似然估计本质上就是似然函数的最大值点,所以我们就可以利用高等数学中求最大值点的方法求之。

具体步骤如下:⑴ 写出似然函数∏==ni i x f L 1),()(θθ; ⑵ 令∑==n i i x f L 1),(ln )(ln θθ,称)(ln θL 为对数似然函数。

最大似然法、邻接法、贝叶斯法建树原理以最大似然法、邻接法、贝叶斯法建树原理为标题最大似然法(Maximum Likelihood Estimation,简称MLE)是一种常用的参数估计方法,通过寻找最大化观测数据的似然函数来确定参数的值。

在建树原理中,最大似然法常被用于构建概率模型,包括决策树、隐马尔可夫模型等。

最大似然法的核心思想是选择能使观测数据出现概率最大的参数值。

在决策树构建中,我们希望通过最大似然法来选择最优的划分变量和划分点,从而构建出具有最高预测能力的决策树模型。

邻接法(Nearest Neighbor Algorithm)是一种常用的非参数建树方法,它基于样本之间的相似性来构建树结构。

邻接法通过计算样本间的距离或相似度,然后根据一定的规则将相似度高的样本连接在一起,形成一个树结构。

邻接法的主要思想是将相似的样本聚集在一起,从而形成一个样本集合的层次结构。

在建树过程中,邻接法根据不同的相似度度量方法和连接规则,可以构建不同类型的树,如近邻树、平均链树等。

贝叶斯法(Bayesian Method)是一种基于贝叶斯定理的建树方法,通过考虑先验知识和观测数据的条件概率来进行建树。

贝叶斯法在建树中常用于构建概率图模型,如贝叶斯网络、条件随机场等。

贝叶斯法的核心思想是将建树问题转化为一个参数估计问题,通过计算后验概率来确定最优的模型参数。

在建树过程中,贝叶斯法可以通过引入先验分布和后验分布来进行参数估计和模型选择,从而得到具有较好泛化能力的建树模型。

最大似然法、邻接法和贝叶斯法是建树中常用的三种方法,它们各自具有不同的优势和适用范围。

最大似然法通过最大化观测数据的似然函数来确定参数值,适用于构建概率模型和决策树等。

邻接法通过计算样本间的相似度来构建树结构,适用于基于样本相似性的建树问题。

贝叶斯法通过考虑先验知识和观测数据的条件概率来进行建树,适用于构建概率图模型和参数估计问题。

最大似然法、邻接法和贝叶斯法是建树中常用的三种方法,它们在建树原理和应用领域上有着各自的特点。