利用SPSS判断两条回归曲线的差异

- 格式:doc

- 大小:25.00 KB

- 文档页数:1

回归分析中的线性关系和异方差性检验一、基本概念回归模型:i i el outcome ε+=mod ,),0(~i i N σε。

线性关系是指n n x b x b x b b el ++++= 22110mod ,即Model 是一个线性函数。

方差异性是指随机变量i ε的方差2i σ不全相等。

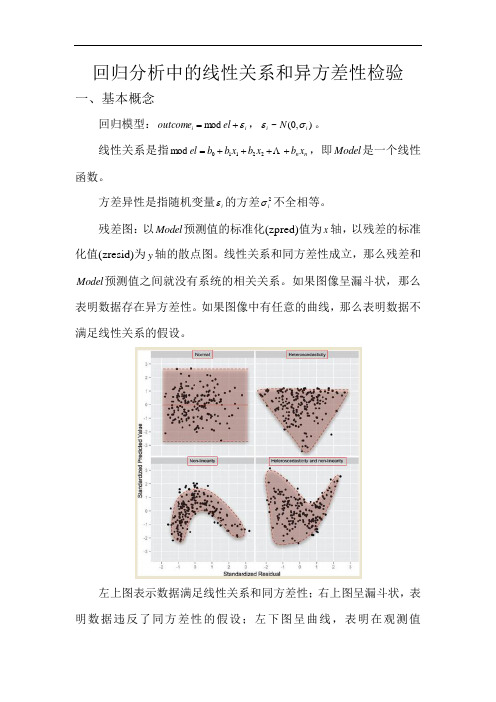

残差图:以Model 预测值的标准化(zpred)值为x 轴,以残差的标准化值(zresid)为y 轴的散点图。

线性关系和同方差性成立,那么残差和Model 预测值之间就没有系统的相关关系。

如果图像呈漏斗状,那么表明数据存在异方差性。

如果图像中有任意的曲线,那么表明数据不满足线性关系的假设。

左上图表示数据满足线性关系和同方差性;右上图呈漏斗状,表明数据违反了同方差性的假设;左下图呈曲线,表明在观测值(outcome)和预测变量(predicotr)之间存在非线性关系。

右下图表明数据不仅存在非线性关系,也存在异方差性。

二、异方差性检验方法1. Levene检验零假设:不同分组中的随机变量的方差相等。

当样本容量很大时,不同分组中的变量的方差的微小差异也会引起Levene检验是显著的(拒绝零假设)。

现在已经停止使用这个方法,因为:(a)在各分组的size不同的时候,异方差性才会引发问题,如果各分组的size相等,那么同方差性的假设是不相关的;(b)Levene检验在分组的size相等,样本容量很大时效果才好。

[Discovering Statistics using IBM SPSS Statistics]2. Hartley Fmax检验F max=方差比率=max{各分组中的方差}/min{各分组中的方差}显然,拒绝域是{F max > c}。

三、SPSS软件操作1. Levene检验操作步骤:(1) 点击’Analyze’ -> ’Descriptive Statistics’ -> ’Explore’;‘Factor List’:分组变量。

判断两条或多条标准曲线的差异,须检验残差,截距和斜率三项,分别有不同的统计学参数,残差用F检验,截距和斜率采用较为复杂的统计量。

2、从实际操作讲:多用协方差分析检验截距和斜率的差异,以SPSS为例:1.先重新整理数据,将y2数据列加到y1下面,变成一个变量y;将x2数据列加到x1下面,变成一个变量x;然后再设定一个新的分组变量group,原来第1组值为1,第2组值为2.2.进行协方差分析(第一步分析斜率是否无差异).Analyze->General Linear Model->UnivariateDependent List:填入y---------将y做为因变量Fixed Factor:填入groupCovaraites:填入x--------将x做为协变量Model:选CustomModel:填入x group x*group---------注意如果变量填入顺序不一样,结果也会不一样.Sum of squares下拉列表框:选TypeI然后点击ok,看结果里x*group这一行的Sig.P值,若大于0.05,则接受原假设,即两条回归直线的斜率无差异,否则拒绝.3.再来进行截距的无差异分析其实过程跟上面一样,只是Model里去掉了x*group交叉项.Analyze->General Linear Model->UnivariateDependent List:填入y---------将y做为因变量Fixed Factor:填入groupCovaraites:填入x--------将x做为协变量Model:选CustomModel:填入x group ---------注意如果变量填入顺序不一样,结果也会不一样.Sum of squares下拉列表框:选TypeI点击ok后,看group一行的Sig.P值,若P值大于0.05说明两条回归直线截距也无差异,若小于0.05说明截距是有差异的.PS:paired test是student-t检验的一种,但检验的结论是两组数据所来源总体的差异。

SPSS如何进行线性回归分析操作本节内容主要介绍如何确定并建立线性回归方程。

包括只有一个自变量的一元线性回归和和含有多个自变量的多元线性回归。

为了确保所建立的回归方程符合线性标准,在进行回归分析之前,我们往往需要对因变量与自变量进行线性检验。

也就是类似于相关分析一章中讲过的借助于散点图对变量间的关系进行粗略的线性检验,这里不再重复。

另外,通过散点图还可以发现数据中的奇异值,对散点图中表示的可能的奇异值需要认真检查这一数据的合理性。

一、一元线性回归分析用SPSS进行回归分析,实例操作如下:1.单击主菜单Analyze / Regression / Linear…,进入设置对话框如图7-9所示。

从左边变量表列中把因变量y选入到因变量(Dependent)框中,把自变量x选入到自变量(Independent)框中。

在方法即Method一项上请注意保持系统默认的选项Enter,选择该项表示要求系统在建立回归方程时把所选中的全部自变量都保留在方程中。

所以该方法可命名为强制进入法(在多元回归分析中再具体介绍这一选项的应用)。

具体如下图所示:2.请单击Statistics…按钮,可以选择需要输出的一些统计量。

如RegressionCoefficients(回归系数)中的Estimates,可以输出回归系数及相关统计量,包括回归系数B、标准误、标准化回归系数BETA、T值及显著性水平等。

Model fit 项可输出相关系数R,测定系数R2,调整系数、估计标准误及方差分析表。

上述两项为默认选项,请注意保持选中。

设置如图7-10所示。

设置完成后点击Continue返回主对话框。

回归方程建立后,除了需要对方程的显著性进行检验外,还需要检验所建立的方程是否违反回归分析的假定,为此需进行多项残差分析。

由于此部分内容较复杂而且理论性较强,所以不在此详细介绍,读者如有兴趣,可参阅有关资料。

3.用户在进行回归分析时,还可以选择是否输出方程常数。

线性回归—SPSS操作线性回归是一种用于研究自变量和因变量之间的关系的常用统计方法。

在进行线性回归分析时,我们通常假设误差项是同方差的,即误差项的方差在不同的自变量取值下是相等的。

然而,在实际应用中,误差项的方差可能会随着自变量的变化而发生变化,这就是异方差性问题。

异方差性可能导致对模型的预测能力下降,因此在进行线性回归分析时,需要进行异方差的诊断检验和修补。

在SPSS中,我们可以使用几种方法进行异方差性的诊断检验和修补。

第一种方法是绘制残差图,通过观察残差图的模式来判断是否存在异方差性。

具体的步骤如下:1. 首先,进行线性回归分析,在"Regression"菜单下选择"Linear"。

2. 在"Residuals"选项中,选择"Save standardized residuals",将标准化残差保存。

3. 完成线性回归分析后,在输出结果的"Residuals Statistics"中可以看到标准化残差,将其保存。

4. 在菜单栏中选择"Graphs",然后选择"Legacy Dialogs",再选择"Scatter/Dot"。

5. 在"Simple Scatter"选项中,将保存的标准化残差添加到"Y-Axis",将自变量添加到"X-Axis"。

6.点击"OK"生成残差图。

观察残差图,如果残差随着自变量的变化而出现明显的模式,如呈现"漏斗"形状,则表明存在异方差性。

第二种方法是利用Levene检验进行异方差性的检验。

具体步骤如下:1. 进行线性回归分析,在"Regression"菜单下选择"Linear"。

实验五异方差的检验与处理一、实验目的:1.掌握异方差检验的基本原理和方法2.掌握异方差的处理方法二、实验要求:1.利用SPSS实现异方差的检验与处理(一元与多元回归);2.掌握异方差检验的基本步骤和方法三、实验原理:1.异方差的检验方法:(1)残差图分析法(3种);(2)等级相关系数法:主要的步骤(见课本).2.异方差的处理方法:(1)加权最小二乘法:主要步骤与原理(2)方差稳定变换法四、实验例子:表4.1(1)利用SPSS建立y对x普通最小二乘回归,Analyze——regression——linear,结果如下:(2)提取残差,并作出残差图:误差随着x的增加呈现出增加的态势。

(3)计算等级相关系数,并进行检验(具体步骤见课本),从结果可以看出,通过P值可以看到拒绝原假设,即残差绝对值与变量之间显著相关,存在异方差。

Cor relations1.000.686**..0003131.686** 1.000.000.3131Correlation CoefficientSig. (2-tailed)NCorrelation Coefficient Sig. (2-tailed)N居民收入(万元)absRE S_1Spearman's rho居民收入(万元)absRE S_1Correlation is significant at the 0.01 level (2-tailed).**.(4)利用加权最小二乘估计对异方差进行处理,首先计算权数。

Analyze ——regression ——weight estimation ,结果如下根据以上结果可知, 1.5m 时对数似然函数达到最大,…….,(课本99页的一段分析),这说明加权最小二乘估计的效果好于普通最小二乘估计效果。

五、练习与作用:(1)课本127页第9题;(2)课本102页例4.4的SPSS实现;(3)课本127页第13题.T4.9(1)由上表可得回归方程:y=-0.831+0.004x由残差图可以看出明显存在异方差,误差的方差随x的增加而增大。

线性回归是很重要的一种回归方法,但是线性回归只适用于因变量为连续型变量的情况,那如果因变量为分类变量呢?比方说我们想预测某个病人会不会痊愈,顾客会不会购买产品,等等,这时候我们就要用到logistic回归分析了。

Logistic回归主要分为三类,一种是因变量为二分类得logistic回归,这种回归叫做二项logistic回归,一种是因变量为无序多分类得logistic回归,比如倾向于选择哪种产品,这种回归叫做多项logistic回归。

还有一种是因变量为有序多分类的logistic回归,比如病重的程度是高,中,低呀等等,这种回归也叫累积logistic回归,或者序次logistic回归。

二值logistic回归:选择分析——回归——二元logistic,打开主面板,因变量勾选你的二分类变量,这个没有什么疑问,然后看下边写着一个协变量。

有没有很奇怪什么叫做协变量?在二元logistic回归里边可以认为协变量类似于自变量,或者就是自变量。

把你的自变量选到协变量的框框里边。

细心的朋友会发现,在指向协变量的那个箭头下边,还有一个小小的按钮,标着a*b,这个按钮的作用是用来选择交互项的。

我们知道,有时候两个变量合在一起会产生新的效应,比如年龄和结婚次数综合在一起,会对健康程度有一个新的影响,这时候,我们就认为两者有交互效应。

那么我们为了模型的准确,就把这个交互效应也选到模型里去。

我们在右边的那个框框里选择变量a,按住ctrl,在选择变量b,那么我们就同时选住这两个变量了,然后点那个a*b的按钮,这样,一个新的名字很长的变量就出现在协变量的框框里了,就是我们的交互作用的变量。

然后在下边有一个方法的下拉菜单。

默认的是进入,就是强迫所有选择的变量都进入到模型里边。

除去进入法以外,还有三种向前法,三种向后法。

一般默认进入就可以了,如果做出来的模型有变量的p值不合格,就用其他方法在做。

再下边的选择变量则是用来选择你的个案的。

SPSS多元线性回归结果分析输出下⾯三张表第⼀张R⽅是拟合优度对总回归⽅程进⾏F检验。

显著性是sig。

结果的统计学意义,是结果真实程度(能够代表总体)的⼀种估计⽅法。

专业上,p 值为结果可信程度的⼀个递减指标,p 值越⼤,我们越不能认为样本中变量的关联是总体中各变量关联的可靠指标。

p 值是将观察结果认为有效即具有总体代表性的犯错概率。

如 p=0.05 提⽰样本中变量关联有 5% 的可能是由于偶然性造成的。

即假设总体中任意变量间均⽆关联,我们重复类似实验,会发现约 20 个实验中有⼀个实验,我们所研究的变量关联将等于或强于我们的实验结果。

(这并不是说如变量间存在关联,我们可得到 5% 或 95% 次数的相同结果,当总体中的变量存在关联,重复研究和发现关联的可能性与设计的统计学效⼒有关。

)在许多研究领域,0.05 的 p 值通常被认为是可接受错误的边界⽔平。

F检验:对于多元线性回归模型,在对每个回归系数进⾏显著性检验之前,应该对回归模型的整体做显著性检验。

这就是F检验。

当检验被解释变量y t与⼀组解释变量x1, x2 , ... , x k -1是否存在回归关系时,给出的零假设与备择假设分别是H0:b1 = b2 = ... = b k-1 = 0 ,H1:b i, i = 1, ..., k -1不全为零。

⾸先要构造F统计量。

由(3.36)式知总平⽅和(SST)可分解为回归平⽅和(SSR)与残差平⽅和(SSE)两部分。

与这种分解相对应,相应⾃由度也可以被分解为两部分。

SST具有T - 1个⾃由度。

这是因为在T个变差 ( y t -), t = 1, ..., T,中存在⼀个约束条件,即 = 0。

由于回归函数中含有k个参数,⽽这k个参数受⼀个约束条件制约,所以SSR具有k -1个⾃由度。

因为SSE中含有T个残差,= y t -, t = 1, 2, ..., T,这些残差值被k个参数所约束,所以SSE具有T - k个⾃由度。

判断两条或多条标准曲线的差异,须检验残差,截距和斜率三项,分别有不同的统计学参数,残差用F检验,截距和斜率采用较为复杂的统计量。

2、从实际操作讲:

多用协方差分析检验截距和斜率的差异,以SPSS为例:1.先重新整理数据,将y2数据列加到y1下面,变成一个变量y;将x2数据列加到x1下面,变成一个变量x;然后再设定一个新的分组变量group,原来第1组值为1,第2组值为2.

2.进行协方差分析(第一步分析斜率是否无差异).

Analyze->General Linear Model->Univariate

Dependent List:填入y---------将y做为因变量

Fixed Factor:填入group

Covaraites:填入x--------将x做为协变量

Model:选Custom

Model:填入x group x*group---------注意如果变量填入顺序不一样,结果也会不一样.

Sum of squares下拉列表框:选TypeI

然后点击ok,看结果里x*group这一行的Sig.P值,若大于0.05,则接受原假设,即两条回归直线的斜率无差异,否则拒绝.

3.再来进行截距的无差异分析

其实过程跟上面一样,只是Model里去掉了x*group交叉项.

Analyze->General Linear Model->Univariate

Dependent List:填入y---------将y做为因变量

Fixed Factor:填入group

Covaraites:填入x--------将x做为协变量

Model:选Custom

Model:填入x group ---------注意如果变量填入顺序不一样,结果也会不一样.

Sum of squares下拉列表框:选TypeI

点击ok后,看group一行的Sig.P值,若P值大于0.05说明两条回归直线截距也无差异,若小于0.05说明截距是有差异的.

PS:paired test是student-t检验的一种,但检验的结论是两组数据所来源总体的差异。

所以判断两回归曲线的差异,需用协方差分析或单独的检验统计两来判断截距和斜率的差异。