主成分回归能消除多重共线性吗?

- 格式:pdf

- 大小:282.63 KB

- 文档页数:5

本文主要是对多重共线性的处理(主成分回归法)的介绍。

1.思路:

A:确定是否存在共线

B:找出多重共线的自变量

C:用主成分回归法。

2:具体操作:

1)一般的书都有共线性的判断指标。

这里就省略了(^_^)

2)找出多多重共线性的自变量:

以下是具体操作:

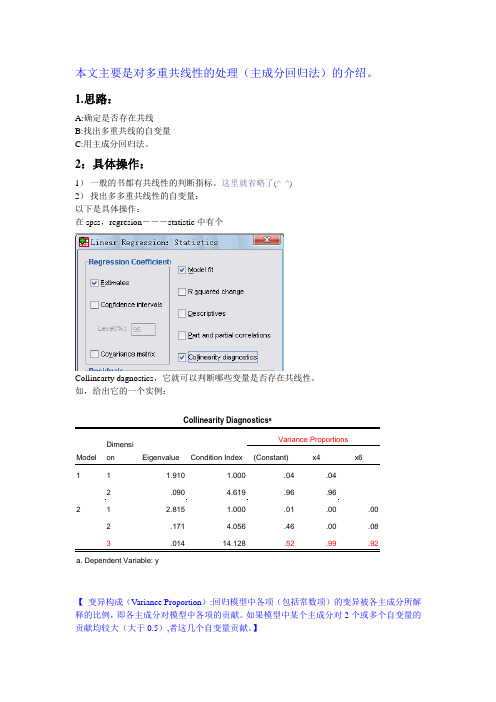

在spss,regresion―――statistic中有个

Collinearty dagnostics,它就可以判断哪些变量是否存在共线性。

如,给出它的一个实例:

【变异构成(V ariance Proportion):回归模型中各项(包括常数项)的变异被各主成分所解释的比例,即各主成分对模型中各项的贡献。

如果模型中某个主成分对2个或多个自变量的贡献均较大(大于0.5),者这几个自变量贡献。

】

上面例子可以看出,x4,x6之间存在共线性。

3)主成分回归。

这个包括3部分:

A:找到主成分:用上面确定了有共线的几个变量拿来做成分分析,保留主成分得分。

(这个在factor中,应该狠容易实现吧,那我就省略了,^_^)

B:回归分析:将A步骤求得的主成分得分,与其他的自变量(没共线性的其他自变量)拿来做回归分析,当然会得到回归模型。

(MODEL,代表)

C:用那些共线性变量,来替换MODEL中的主成分变量.

(因为可以用主成分回归系数,根据主成分的表达式,很容易用自变量代替主成分)。

主成分回归克服多重共线性的R语言实现作者:汪朋来源:《科技资讯》2015年第28期摘要:多重共线性是回归分析中容易出现的一类重要问题,现有的克服多重共线性的方法有很多,这其中主成分回归是非常有效的一种,但该方法计算复杂,必须借助于计算软件才能完成。

为此,本文在已有R函数的基础上,通过自编一定的R函数和代码,探讨了应用R语言实现主成分回归的过程。

最后的案例表明,通过R语言实现主成分回归来克服模型的多重共线性,过程简单,效果明显,且容易被学习者和应用者掌握。

关键词:主成分回归多重共线性 R语言中图分类号:文献标识码:A 文章编号:1672-3791(2015)03(b)-0000-001引言回归模型是应用最为广泛的统计模型之一,常被用来处理多变量间相依关系问题,而多重共线性问题是回归分析中一个非常棘手的问题,最早是R.Frisch提出。

大量实践表明,当模型存在严重的多重共线性时,模型的参数估计变得不够稳定,甚至出现估计的回归系数与其实际意义不相符,模型的显著性检验和预测功能失效等严重后果。

正因如此,从20世纪六七十年代至今,人们提出了多种方法来克服模型的多重共线性,比较常用的有逐步回归法、岭回归法和主成分回归法等。

逐步回归法是剔除变量,容易造成信息损失和结构分析的预期目的难以实现的问题;岭回归法要求选择比较准确的岭参数,而岭参数的选择主观性很强;相比之下,主成分回归法通过将自变量分解成几个不相关的主成分,能完全克服模型的多重共线性,且选择的主成分能基本上概括原变量的信息,使得主成分回归法成为克服多重共线性中的一种较为有效的方法,但该方法计算复杂,需要借助于计算软件才能完成。

目前主流的统计软件虽一般提供了主成分分析的功能,都基本上没有直接实现主成分回归的模块,因此,本文在R语言提供的主成分分析的函数的基础上,通过自编相关的函数,来探讨如何快速简便地运用主成分回归法克服回归模型的多重共线性。

二、主成分回归法的R语言实现过程主成分回归法是利用主成分分析找到解释变量的若干个主成份,由于主成份之间是互不相关的,因此考虑将被解释变量关于这些主成份进行回归,可以消除模型的多重共线性。

基于主成分回归的企业物流成本多元线性预测模型研究随着现代物流技术的逐步发展,企业的物流成本越来越成为一个重要的成本项目。

为了准确地预测物流成本,合理规划物流成本预算,企业需要建立一个科学的成本预测模型。

基于主成分回归的企业物流成本多元线性预测模型,可以通过主成分分析,将多个相关性较高的指标合并成一个主成分,从而简化了成本预测模型中的多元线性回归分析。

本文通过对基于主成分回归的企业物流成本多元线性预测模型的研究进行浅析,探讨其优缺点及运用范围。

一、主成分回归的理论基础主成分回归(Principal Component Regression, PCR)是将主成分分析(Principal Component Analysis,PCA)与多元回归分析相结合的一种预测模型。

多元回归模型是指依据多个自变量和一个因变量之间的函数关系,来预测因变量的取值的模型。

主成分分析则是一种在数据预处理中使用的数据降维技术,它可以经过数学转换,将相关性较高的多个指标合并成一个主成分,从而减少数据的冗余信息。

如此一来,我们通过主成分分析可以减少自变量间的相关性,从而研究多个自变量与因变量之间的关系。

将主成分分析与多元回归分析相结合,即可构建主成分回归模型。

该模型的优点在于能够聚焦于重要的自变量,排除高相关性多余自变量的干扰。

二、基于主成分回归的企业物流成本预测模型企业物流成本预测的关键是确定影响物流成本的指标及其权重。

传统的多元线性回归模型通常基于回归系数,难以识别关键自变量。

而基于主成分回归的模型,既可以避免多重共线性的问题,又可以通过主成分权值修正各自变量的权重,有效降低了计算维度。

因此,基于主成分回归的企业物流成本预测模型是一个相对准确和有实际应用价值的预测模型。

对于企业物流成本这一指标,长期来看,常常受到运费、包装、仓储、物流设施等影响。

若用传统的多元线性回归模型来预测企业物流成本,可能出现自变量之间的共线性问题。

在多元回归分析中,如果自变量之间相关程度过高,则会影响模型可靠性,因为模型无法确定某个自变量和因变量之间真实的关系。

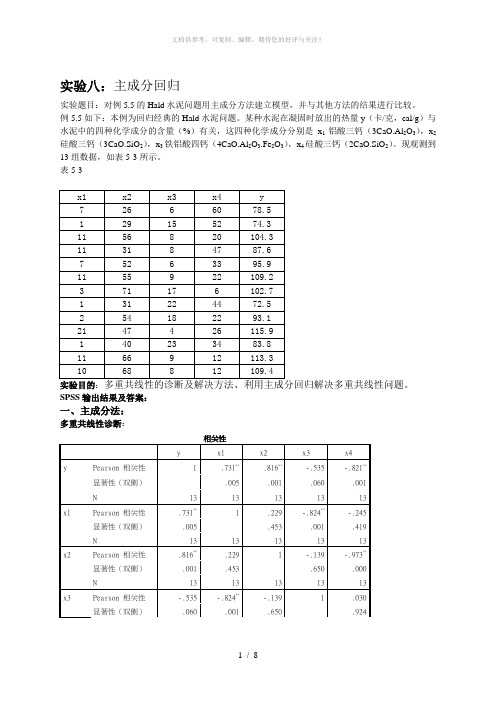

实验八:主成分回归实验题目:对例5.5的Hald水泥问题用主成分方法建立模型,并与其他方法的结果进行比较。

例5.5如下:本例为回归经典的Hald水泥问题。

某种水泥在凝固时放出的热量y(卡/克,cal/g)与水泥中的四种化学成分的含量(%)有关,这四种化学成分分别是x1铝酸三钙(3CaO.Al2O3),x2硅酸三钙(3CaO.SiO2),x3铁铝酸四钙(4CaO.Al2O3.Fe2O3),x4硅酸三钙(2CaO.SiO2)。

现观测到13组数据,如表5-3所示。

表5-3实验目的:SPSS输出结果及答案:一、主成分法:多重共线性诊断:N 13 13 13 13 13 x4 Pearson 相关性-.821**-.245 -.973**.030 1显著性(双侧).001 .419 .000 .924N 13 13 13 13 13**. 在 .01 水平(双侧)上显著相关。

由表可知,x1,x2,x4的相关性都比较大,较接近,所以存在多重共线性主成分回归:解释的总方差成份初始特征值提取平方和载入合计方差的 % 累积 % 合计方差的 % 累积 %1 2.236 55.893 55.893 2.236 55.893 55.8932 1.576 39.402 95.294 1.576 39.402 95.2943 .187 4.665 99.959 .187 4.665 99.9594 .002 .041 100.000 .002 .041 100.000提取方法:主成份分析。

输出结果显示有四个特征根,最大的是λ1=2.236,最小的是λ4=0.002。

方差百分比显示第一个主成分Factor1的方差百分比近56%的信息量;前两个主成分累计包含近95.3%的信息量。

因此取两个主成分就已经足够。

由于前两个主成分的方差累计已经达到95.3%,故只保留前两个主成分。

成份矩阵a成份1 2 3 4x1 .712 -.639 .292 .010x2 .843 .520 -.136 .026x3 -.589 .759 .275 .011x4 -.819 -.566 -.084 .027提取方法:主成分a.已提取了 4 个成份。

回归分析是统计学中常用的一种方法,它用于研究自变量和因变量之间的关系。

然而,在实际应用中,经常会遇到多重共线性的问题,这给回归分析带来了一定的困难。

本文将讨论回归分析中的多重共线性问题及解决方法。

多重共线性是指独立自变量之间存在高度相关性的情况。

在回归分析中,当自变量之间存在多重共线性时,会导致回归系数估计不准确,标准误差增大,对因变量的预测能力降低,模型的解释能力受到影响。

因此,多重共线性是回归分析中需要重点关注和解决的问题之一。

解决多重共线性问题的方法有很多种,下面将介绍几种常用的方法。

一、增加样本量增加样本量是解决多重共线性问题的一种方法。

当样本量足够大时,即使自变量之间存在一定的相关性,也能够得到较为稳健的回归系数估计。

因此,可以通过增加样本量来减轻多重共线性对回归分析的影响。

二、使用主成分回归分析主成分回归分析是一种常用的处理多重共线性问题的方法。

主成分回归分析通过将原始自变量进行线性变换,得到一组新的主成分变量,这些主成分变量之间不存在相关性,从而避免了多重共线性问题。

然后,利用这些主成分变量进行回归分析,可以得到更为准确稳健的回归系数估计。

三、岭回归岭回归是一种经典的解决多重共线性问题的方法。

岭回归通过对回归系数施加惩罚项,从而减小回归系数的估计值,进而降低多重共线性对回归分析的影响。

岭回归的思想是在最小二乘估计的基础上加上一个惩罚项,通过调节惩罚项的系数来平衡拟合优度和模型的复杂度,从而得到更为稳健的回归系数估计。

四、逐步回归逐步回归是一种逐步选择自变量的方法,可以用来解决多重共线性问题。

逐步回归可以通过逐步引入或剔除自变量的方式,来得到一组最优的自变量组合,从而避免了多重共线性对回归系数估计的影响。

以上所述的方法都可以用来解决回归分析中的多重共线性问题。

在实际应用中,应该根据具体的情况选择合适的方法来处理多重共线性问题,从而得到准确可靠的回归分析结果。

总之,多重共线性是回归分析中需要重点关注的问题,通过合适的方法来处理多重共线性问题,可以得到更为准确稳健的回归系数估计,从而提高回归分析的预测能力和解释能力。

用主成分法解决多重共线性问题一、多重共线性的表现线性回归模型中的解释变量之间由于存在精确相关关系或高度相关关系。

看似相互独立的指标本质上是相同的,是可以相互代替的,但是完全共线性的情况并不多见,一般出现的是在一定程度上的共线性,即近似共线性。

二、多重共线性的后果1.理论后果多重共线性是因为变量之间的相关程度比较高。

按布兰查德认为, 在计量经济学中, 多重共线性实质上是一个“微数缺测性”问题,就是说多重共线性其实是由样本容量太小所造成,当样本容量越小,多重共线性越严重。

多重共线性的理论主要后果:(1)完全共线性下参数估计量不存在;(2)近似共线性下OLS估计量非有效;(3)模型的预测功能失效;(4)参数估计量经济含义不合理2.现实后果(1)各个解释变量对指标最后结论影响很难精确鉴别;(2)置信区间比原本宽,使得接受假设的概率更大;(3)统计量不显著;(4)拟合优度的平方会很大;(5)OLS估计量及其标准误对数据微小的变化也会很敏感。

三、多重共线性产生的原因1.模型参数的选用不当,在我们建立模型时如果变量之间存在着高度的相关性2. 由于研究的经济变量随时间往往有共同的变化趋势,他们之间存在着共性。

例如当经济繁荣时,反映经济情况的指标有可能按着某种比例关系增长3. 滞后变量。

滞后变量的引入也会产生多重共线行,例如本期的消费水平除受本期的收入影响之外,还有可能受前期的收入影响,建立模型时,本期的收入水平就有可能和前期的收入水平存在着共线性。

四、多重共线性的识别1.方差扩大因子法( VIF)一般认为如果最大的VIF超过10,常常表示存在多重共线性。

2.容差容忍定法如果容差(tolerance)<=0.1,常常表示存在多重共线性。

3. 条件索引条件索引(condition index)>10,可以说明存在比较严重的共线性。

五、多重共线性的处理方法处理方法有多重增加样本容量、剔除因子法、PLS(偏最小二乘法)、岭回归法、主成分法。

偏最小二乘回归偏最小二乘回归(Partial Least Squares Regression,简称PLSR)是一种主成分回归方法,旨在解决多元线性回归中自变量数目较多,且存在共线性或多重共线性的问题。

本文将介绍偏最小二乘回归的原理、应用案例以及优缺点。

1. 偏最小二乘回归原理偏最小二乘回归是基于多元线性回归的一种方法,通过压缩自变量的空间,将高维的自变量转化为低维的潜在变量,从而避免了多重共线性的问题。

在偏最小二乘回归中,我们定义两个主成分,其中第一个主成分能最大化自变量与因变量之间的协方差,而第二个主成分垂直于第一个主成分,以此类推。

2. 偏最小二乘回归应用案例偏最小二乘回归在众多领域都有广泛的应用。

以下是一些常见的应用案例:2.1 化学分析在化学领域中,我们常常需要使用红外光谱仪等仪器进行样本的分析。

然而,由于样本中存在大量的杂质,导致光谱数据存在共线性等问题。

通过偏最小二乘回归可以降低样本数据的维度,提取出有用的信息,从而准确地进行化学成分的分析。

2.2 生物医学在生物医学领域中,研究人员常常需要通过大量的生理指标预测某种疾病的发生风险。

然而,由于生理指标之间存在相互关联,使用传统的线性回归模型时,很容易出现共线性的问题。

通过偏最小二乘回归,可以降低指标的维度,减少共线性对预测结果的影响,提高疾病预测的准确性。

2.3 金融领域在金融领域中,偏最小二乘回归也有广泛的应用。

例如,在股票市场的分析中,研究人员常常需要通过一系列宏观经济指标预测股票的涨跌趋势。

然而,这些指标之间往往存在较强的相关性,导致传统的回归模型难以提取出有效的信息。

通过偏最小二乘回归,可以从多个指标中提取出潜在的主成分,预测股票的涨跌趋势。

3. 偏最小二乘回归的优缺点3.1 优点(1)解决了多重共线性问题:偏最小二乘回归通过降低自变量的维度,有效地解决了多重共线性问题,提高了模型的稳定性和准确性。

(2)提取了潜在的主成分:通过偏最小二乘回归,我们可以从高维的自变量中提取出潜在的主成分,这些主成分更具有解释性,有助于理解自变量与因变量之间的关系。