随机变量的独立性

- 格式:ppt

- 大小:619.50 KB

- 文档页数:31

随机变量独立性判断随机变量的独立性和相关性随机变量的独立性和相关性是概率论和数理统计中的重要概念。

在实际问题中,我们经常需要判断随机变量之间是否相互独立或者相关。

本文将介绍如何判断随机变量的独立性和相关性。

一、什么是随机变量的独立性和相关性随机变量的独立性和相关性描述了随机变量之间的关系。

独立性:若两个随机变量X和Y的联合分布等于各自的边缘分布之积,即P(X=x, Y=y) = P(X=x)P(Y=y),则称X和Y独立。

相关性:若两个随机变量X和Y之间存在某种依赖关系,即它们的联合分布和边缘分布不相等,称X和Y相关。

二、判断随机变量的独立性和相关性的方法1. 统计方法利用样本数据进行统计分析,可以判断随机变量的独立性和相关性。

对于两个随机变量X和Y,如果它们的样本相关系数接近于0,可以认为X和Y近似独立;如果样本相关系数接近于1或-1,可以认为X和Y相关。

2. 图形方法通过绘制散点图可以直观地观察随机变量的相关性。

对于两个随机变量X和Y,如果它们的散点图呈现出线性关系,则可以认为X和Y相关;如果散点图呈现出无规律的分布,则可以认为X和Y近似独立。

3. 利用协方差和相关系数判断协方差和相关系数是判断随机变量相关性的重要指标。

协方差衡量了两个随机变量之间的线性相关性,若协方差为0,则可以认为两个随机变量不相关。

相关系数除了衡量两个随机变量的线性相关性,还可以衡量非线性相关性,相关系数的范围在-1至1之间,绝对值越接近1表示相关性越强,绝对值越接近0表示独立性越强。

三、应用举例1. 抛硬币问题假设一次抛硬币,X表示正面次数,Y表示反面次数。

在这个例子中,X和Y的取值只能是0或1,它们的联合分布如下:P(X=0, Y=0) = 1/2P(X=1, Y=0) = 1/2P(X=0, Y=1) = 1/2P(X=1, Y=1) = 1/2可以看出,X和Y的联合分布等于各自的边缘分布之积,即P(X=x, Y=y) = P(X=x)P(Y=y),因此X和Y是独立的。

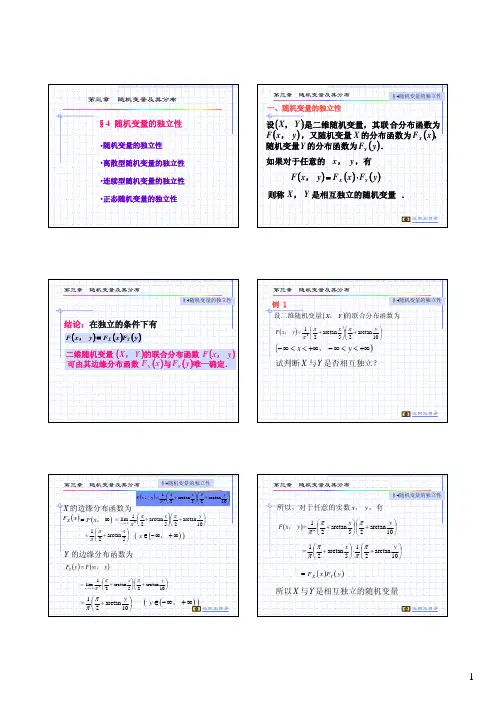

第三章随机变量及其分布§4随机变量的独立性第三章随机变量及其分布第三章随机变量及其分布第三章随机变量及其分布⎛⎞⎛1y x ππ第三章随机变量及其分布二、离散型随机变量的独立性第三章随机变量及其分布例2第三章随机变量及其分布第三章随机变量及其分布§4随机变量的独立性第三章随机变量及其分布§4随机变量的独立性第三章随机变量及其分布§4随机变量的独立性例3第三章随机变量及其分布第三章随机变量及其分布第三章随机变量及其分布三、连续型随机变量的独立性第三章随机变量及其分布第三章随机变量及其分布§2 边缘分布第三章随机变量及其分布第三章随机变量及其分布第三章随机变量及其分布{}第三章随机变量及其分布§4随机变量的独立性第三章随机变量及其分布§4随机变量的独立性X反之,如果随机变量Y相互独立,则对任意的与第三章随机变量及其分布第三章随机变量及其分布第三章随机变量及其分布第三章随机变量及其分布一、和的分布第三章随机变量及其分布§4 多维随机变量函数的分布解:,,,,的取值都是与由于4321Y X 第三章随机变量及其分布{}{}{}第三章随机变量及其分布§4 多维随机变量函数的分布第三章随机变量及其分布第三章随机变量及其分布§4 多维随机变量函数的分布第三章随机变量及其分布§4 多维随机变量函数的分布由于X , Y 的对称性可得第三章随机变量及其分布第三章随机变量及其分布§4 多维随机变量函数的分布例3第三章随机变量及其分布§4 多维随机变量函数的分布第三章随机变量及其分布+∞§4 多维随机变量函数的分布第三章随机变量及其分布§4 多维随机变量函数的分布例4第三章随机变量及其分布§4 多维随机变量函数的分布第三章随机变量及其分布+∞§4 多维随机变量函数的分布第三章随机变量及其分布§4 多维随机变量函数的分布例4(续)例5第三章随机变量及其分布§4 多维随机变量函数的分布第三章随机变量及其分布§4多维随机变量函数的分布()+∞−−−x z x 221第三章随机变量及其分布第三章随机变量及其分布推广至n 个随机变量的取大和取小第三章随机变量及其分布第三章随机变量及其分布§5 多维随机变量函数的分布第三章随机变量及其分布例7:教材10例8第三章随机变量及其分布第三章随机变量及其分布§5 多维随机变量函数的分布例8(续)第三章随机变量及其分布§5 多维随机变量函数的分布第三章随机变量及其分布第三章随机变量及其分布第三章随机变量及其分布§5 多维随机变量函数的分布例1(续)第三章随机变量及其分布§5 多维随机变量函数的分布例1(续)。

随机变量的独立性和相关性随机变量是概率论和数理统计中的重要概念,用于描述随机事件和随机现象的数值特征。

研究随机变量之间的关系对于深入理解概率和统计学的基本原理至关重要。

在这篇文章中,我们将探讨随机变量的独立性和相关性。

一、独立性独立性是指两个或多个随机变量之间的关系,即一个随机变量的取值对另一个随机变量的取值没有任何影响。

如果两个随机变量X和Y 是独立的,那么它们满足以下条件:P(X=x, Y=y) = P(X=x) * P(Y=y)其中P(X=x, Y=y)表示X等于x,Y等于y的概率,P(X=x)和P(Y=y)分别表示X等于x的概率和Y等于y的概率。

换句话说,当两个随机变量独立时,它们的联合概率等于各自的边缘概率的乘积。

独立性的意义在于可以简化概率计算。

如果X和Y是独立的,那么我们可以通过独立事件的性质计算它们的联合概率。

此外,独立性还可以应用于贝叶斯定理、条件概率和协方差等相关概念的推导与计算。

二、相关性相关性是指两个随机变量之间存在某种程度的关联或依赖关系。

如果两个随机变量X和Y相关,那么它们的取值是彼此依赖的,即当X的取值发生变化时,Y的取值也会随之变化。

在统计学中,相关性通过协方差和相关系数来度量。

协方差描述了两个随机变量之间的总体关系,定义为:cov(X,Y) = E[(X - E(X))(Y - E(Y))]其中cov(X,Y)表示X和Y的协方差,E(X)和E(Y)分别表示X和Y的期望(均值)。

协方差的数值可以为负、零或正,分别表示负相关、无相关或正相关。

相关系数是协方差的标准化形式,用于度量两个随机变量之间的线性相关程度。

相关系数的取值范围在-1和1之间,越接近-1或1表示相关性越强,越接近0表示相关性越弱或不存在。

三、独立性与相关性的区别独立性和相关性是两个不同的概念。

独立性是指两个或多个随机变量之间的独立关系,即一个变量的取值对另一个变量的取值没有影响。

相关性是指两个随机变量之间存在某种关联或依赖关系,即一个变量的取值会随着另一个变量的取值而变化。

独立性随机变量之间的独立性定义与判别随机变量是概率论与数理统计中的重要概念,在许多实际问题中起到了关键作用。

在随机变量的研究中,我们经常需要考虑多个随机变量的关系,其中独立性是一个重要的概念。

本文将探讨独立性随机变量之间的独立性的定义与判别方法。

一、独立性的定义在开始讨论独立性随机变量之间的独立性之前,我们先来了解一下独立性的定义。

设有两个随机变量X和Y,它们的联合概率分布函数为F(x, y),如果对于任意的x和y,X=x与Y=y的概率等于X=x的概率乘以Y=y的概率,即:P(X=x, Y=y) = P(X=x) * P(Y=y)上述等式成立时,我们称随机变量X与Y是独立的。

二、判别独立性的方法在实际问题中,我们需要判断随机变量之间是否独立。

下面介绍几种常见的判别独立性的方法。

1. 通过联合概率分布函数判断根据独立性的定义,我们可以通过联合概率分布函数来判断随机变量的独立性。

如果联合概率分布函数可以拆分成各个随机变量的边缘概率分布函数的乘积形式,即:F(x, y) = F_X(x) * F_Y(y)其中F_X(x)和F_Y(y)分别为X和Y的边缘概率分布函数,那么X与Y就是独立的。

2. 通过条件概率分布函数判断除了使用联合概率分布函数,我们还可以通过条件概率分布函数来判断随机变量的独立性。

如果对于任意的x和y,X=x给定条件下,Y=y的条件概率等于Y=y的边缘概率分布函数,即:P(Y=y|X=x) = P(Y=y)那么X与Y就是独立的。

3. 通过相关系数判断除了基于概率分布函数的判别方法,我们还可以使用相关系数来判断随机变量的独立性。

相关系数描述了两个随机变量之间的线性相关程度,如果两个随机变量X和Y是独立的,那么它们的相关系数为0。

因此,我们可以通过计算相关系数来判断随机变量之间是否独立。

4. 通过独立性检验判断除了上述方法,还可以使用独立性检验来判断随机变量之间是否独立。

独立性检验是一种统计检验方法,根据样本数据的观察值来推断总体数据的分布情况,进而判断随机变量之间是否独立。

概率与统计中的随机变量独立性概率和统计是数学中重要的分支,用于描述和分析事件发生的概率以及对观测数据进行统计推断。

在概率与统计中,随机变量是一个核心概念,用于描述随机试验的结果。

而随机变量独立性则是指两个或多个随机变量之间的相互关系,它在概率与统计中具有重要的地位。

随机变量独立性的概念首先,我们来讨论随机变量的概念。

随机变量是表示随机试验的结果的数值型变量,它可以是离散型的也可以是连续型的。

离散型随机变量可以取到有限个或者可数个数值,如掷骰子的点数。

而连续型随机变量则可以取到无限个数值,如某商品的销售额。

随机变量独立性是指两个或多个随机变量之间的相互关系。

当两个随机变量之间存在独立性时,它们的取值之间没有任何关联,即一个随机变量的取值不会对另一个随机变量的取值产生任何影响。

换句话说,知道一个随机变量的取值并不能提供任何关于另一个随机变量取值的信息。

随机变量独立性的判定在概率与统计中,我们常常需要判定两个或多个随机变量之间是否存在独立性。

判定随机变量独立性的方法主要有两种:通过概率定义和通过联合分布函数。

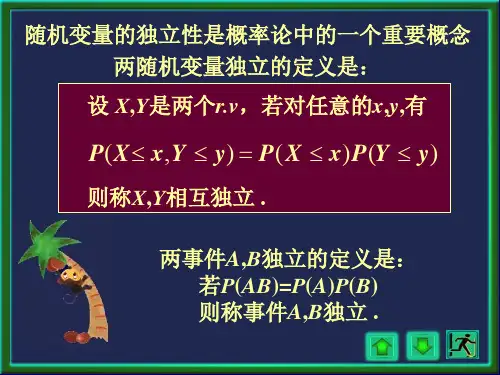

通过概率定义判定独立性是指判断两个随机变量的联合概率与各自的边缘概率之间的关系。

假设我们有两个随机变量X和Y,它们的边缘概率分别为P(X)和P(Y),而它们的联合概率为P(X,Y)。

如果满足以下条件,即P(X,Y) = P(X) * P(Y),则可以认为随机变量X和Y是独立的。

另一种判定随机变量独立性的方法是通过联合分布函数。

如果两个随机变量X和Y的联合分布函数可以表示为各自边缘分布函数的乘积形式,即F(X,Y) = F(X)* F(Y),则可以认为X和Y是独立的。

需要注意的是,在连续型随机变量的情况下,联合概率密度函数的乘积等于联合概率密度函数,而在离散型随机变量的情况下,联合概率质量函数的乘积等于联合概率质量函数。

随机变量独立性的意义随机变量独立性在概率与统计中具有重要的意义。

首先,随机变量独立性简化了概率计算和统计推断的过程。

随机变量的独立性与相关性统计学与概率论是自然科学的重要分支,而随机变量是统计学中的重要概念。

随机变量是一个数值变量,其取值由特定的随机过程而定。

在统计学中,我们需要研究随机变量之间的关系,包括它们的相关性和独立性。

一、随机变量的独立性随机变量的独立性是指两个或多个随机变量之间的取值没有任何关系。

也就是说,当两个或多个随机变量之间是独立的时候,它们的取值不受彼此的影响。

以两个硬币为例,假设我们投掷两个硬币,A表示第一个硬币的正反面,B表示第二个硬币的正反面。

我们可以用在A和B中都会出现正面的概率来表示两个硬币独立的概率。

即P(A=正面)×P(B=正面)。

另一个例子是,假设我们有两个骰子,X表示第一个骰子的点数,Y表示第二个骰子的点数。

在这种情况下,X和Y之间的独立性表现为两个事件之间的概率乘积等于这两个事件的交集。

即P(X=2)×P(Y=6)=1/36,因为这意味着第一个骰子的点数是2,第二个骰子的点数是6的概率。

二、随机变量的相关性相对于独立性而言,相关性表示出的是两个或多个随机变量之间的取值存在某种关系。

也就是说,当两个或多个随机变量之间是相关的时候,它们的取值受彼此的影响。

在统计学中,我们用协方差和相关系数来描述随机变量之间的相关性。

协方差是一个衡量两个随机变量之间关系强度的指标,其中正值表示正相关,负值表示负相关,而0表示没有相关性。

相关系数是协方差的标准化版本,其数值范围在-1到1之间,其中1表示完全正相关,-1表示完全负相关,而0表示没有相关性。

相关系数越接近1或-1,证明两个随机变量之间的关系越强。

需要注意的是,虽然相关性和独立性在概念上有所区别,但它们并非互斥的关系。

有时候,两个随机变量之间既有独立性又有相关性。

三、应用随机变量的独立性和相关性在统计学中拥有广泛的应用场景。

例如,在回归分析中,我们需要确定每个输入变量之间是否存在相关性或独立性,以确定模型中是否需要保留特定的变量。

随机变量的独立性及联合分布的定义及计算方法随机变量是统计学中一个重要的概念,指的是随机试验中可能取到的数值。

对于多个随机变量之间的关系,独立性和联合分布是常用的概念和方法。

本文将依次介绍随机变量独立性的定义和判定方法、随机变量的联合分布的定义和常见计算方法。

一、随机变量的独立性随机变量的独立性是指在给定条件下,多个随机变量之间不存在相关性,即一个随机变量的取值不会对其他随机变量的取值产生影响。

常用的判定方法包括:1. 互不影响如果两个随机变量之间互不影响,则这两个变量是独立的。

例如,投掷两个骰子,其中一个骰子的点数不会影响另一个骰子的点数,因此两个骰子的点数是独立的随机变量。

2. 相互独立如果多个随机变量之间的任意两个变量都是独立的,则这些随机变量是相互独立的。

例如,投掷三个骰子,每个骰子的点数都是独立的随机变量,因此三个骰子的点数是相互独立的随机变量。

3. 独立性定义下的概率乘法公式对于两个独立的随机变量X和Y,它们同时取到某个值的概率等于它们各自取到这个值的概率的乘积。

即P(X=x,Y=y)=P(X=x)P(Y=y)。

该公式也适用于多个独立的随机变量。

二、随机变量的联合分布多个随机变量的联合分布是指这些随机变量取值组合所对应的概率分布函数。

常用的计算方法包括:1. 联合分布函数对于两个随机变量X和Y,它们的联合分布函数定义为F(x,y)=P(X<=x,Y<=y)。

该函数可以用来计算任意两个随机变量的联合分布。

对于多个随机变量,联合分布函数的定义相应地拓展。

2. 联合概率密度函数对于连续型随机变量,它们的联合概率密度函数可以通过对应的联合分布函数求导得到。

即f(x,y)=∂^2 F(x,y)/∂x∂y。

该函数可以用来计算任意两个连续型随机变量的联合分布。

对于多个连续型随机变量,联合概率密度函数的定义相应地拓展。

3. 边缘分布和条件分布对于联合分布中的任意一个随机变量,我们都可以将它的概率分布函数单独计算出来,称为边缘分布。

随机变量的独立性与相关性随机变量的独立性与相关性是概率论和数理统计中重要的概念。

独立性是指两个或多个随机变量的取值之间没有相互影响的关系,而相关性则描述了随机变量之间的线性关系程度。

本文将分别介绍随机变量的独立性和相关性的定义、性质以及其在实际问题中的应用。

一、随机变量的独立性在概率论中,独立性是指两个或多个随机变量在任意条件下都是互相独立的。

具体而言,对于随机变量X和Y,如果对于任意的实数a 和b,满足以下等式:P(X ≤ a, Y ≤ b) = P(X ≤ a) · P(Y ≤ b),则称X和Y是独立的。

其中,P(X ≤ a, Y ≤ b)表示事件{X ≤ a}和{Y ≤ b}同时发生的概率。

独立性是一种极为重要的性质,它使得概率计算更加简化。

在实际问题中,我们可以利用独立性假设来简化分析,提高计算的效率。

例如,在投掷硬币的实验中,每一次投掷的结果都是独立的,因此可以通过简单的概率计算来确定投掷n次后获得正面朝上的次数。

二、随机变量的相关性相关性是指随机变量之间的线性关系程度。

对于两个随机变量X和Y,其相关性可以通过协方差或相关系数来衡量。

1. 协方差随机变量X和Y的协方差定义为:Cov(X, Y) = E[(X - E(X))(Y - E(Y))],其中,E(X)和E(Y)分别表示X和Y的期望值。

协方差可以看作是X与Y共同变动的程度。

如果Cov(X, Y) = 0,则称X和Y是不相关的。

如果Cov(X, Y) > 0,则X和Y是正相关的;如果Cov(X, Y) < 0,则X和Y是负相关的。

2. 相关系数相关系数是协方差的归一化形式,可以消除量纲的影响。

随机变量X和Y的相关系数定义为:ρ(X, Y) = Cov(X, Y) / (σ(X)σ(Y)),其中,σ(X)和σ(Y)分别表示X和Y的标准差。

相关系数的取值范围在-1到1之间,且满足如下性质:若ρ(X, Y) = 0,则X和Y不相关;若ρ(X, Y) > 0,则X和Y正相关;若ρ(X, Y) < 0,则X和Y负相关。