信源熵及平均互信息

- 格式:ppt

- 大小:540.50 KB

- 文档页数:43

熵、互信息、条件熵、相对熵熵是信息论中的一个重要概念,用来衡量随机变量的不确定性。

在信息论中,熵被定义为一个随机变量的平均信息量。

熵越大,表示随机变量的不确定性越高。

互信息是指两个随机变量之间的相关性。

互信息可以用来衡量两个随机变量之间的相互依赖程度。

互信息越大,表示两个随机变量之间的相关性越高。

条件熵是在给定某个条件下,随机变量的不确定性。

条件熵可以用来衡量在已知某些信息的情况下,对未知信息的不确定性。

条件熵越大,表示在给定条件下,随机变量的不确定性越高。

相对熵(也称为KL散度)是用来度量两个概率分布之间的差异性。

相对熵是一个非对称的指标,它衡量了在给定一个概率分布的情况下,使用另一个概率分布来表示该分布所需的额外的信息量。

熵、互信息、条件熵、相对熵在信息论中起着重要的作用,它们可以用来描述随机变量、概率分布之间的关系,并在许多领域中得到广泛的应用。

熵是信息论中最基本的概念之一。

它可以用来衡量一个随机变量的不确定性。

例如,在一个硬币正反面出现的概率相等的情况下,我们对于硬币的结果是完全不确定的,因此熵为1。

而当硬币正反面出现的概率不相等时,熵会变小,表示我们对于硬币结果的不确定性降低了。

互信息可以用来衡量两个随机变量之间的相关性。

例如,在一个骰子游戏中,如果我们知道一个骰子的结果,那么对于另一个骰子的结果将没有任何帮助,因为它们之间没有相关性。

在这种情况下,互信息为0。

而当两个骰子的结果是完全相同或完全相反的时候,互信息会达到最大值。

条件熵是在给定某个条件下,随机变量的不确定性。

例如,在一个扑克牌游戏中,如果我们已经知道了对手手中的一张牌,那么我们对于对手的牌的不确定性会减小。

条件熵可以用来衡量在给定一些信息的情况下,对未知信息的不确定性。

相对熵是用来度量两个概率分布之间的差异性。

例如,在自然语言处理中,我们可以使用相对熵来衡量两个文本之间的相似性。

相对熵越小,表示两个概率分布越接近,差异性越小。

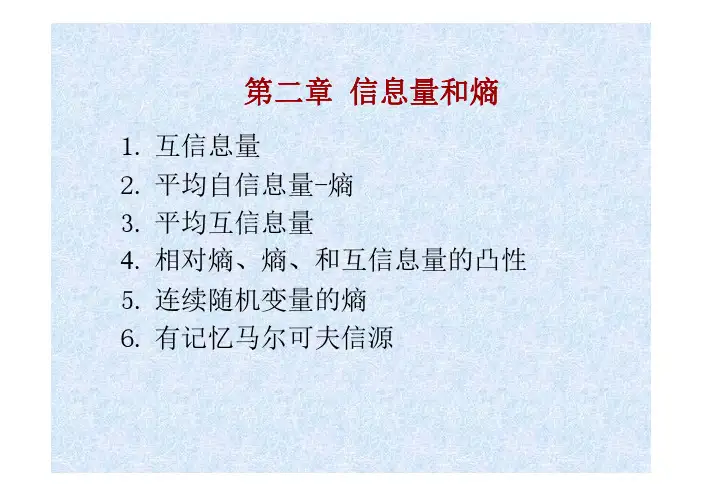

熵:信源各个离散消息的自信息量的数学期望(即概率加权的统计平均值)为信源的平均信息量,一般称为信源的信息熵,也叫信源熵或香农熵,有时也称为无条件熵或熵函数,简称熵。

自信息量:该事件发生的概率的对数的负值。

互信息量:对两个离散随机事件集X和Y,事件yj的出现给出关于事件xi的信息量,定义为互信息量。

或定义xi的后验概率与先验概率比值的对数为yj对xi的互信息量。

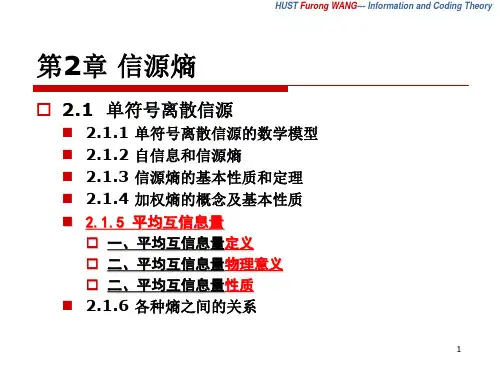

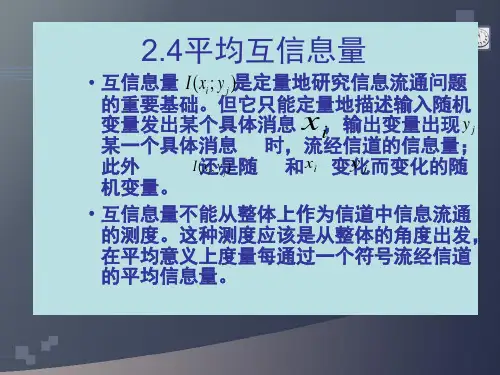

平均互信息量:定义互信息量I(xi;yj)在联合概率空间P(XY)中的统计平均值为Y对X的平均互信息量,简称平均互信息,也称平均交互信息量或交互熵。

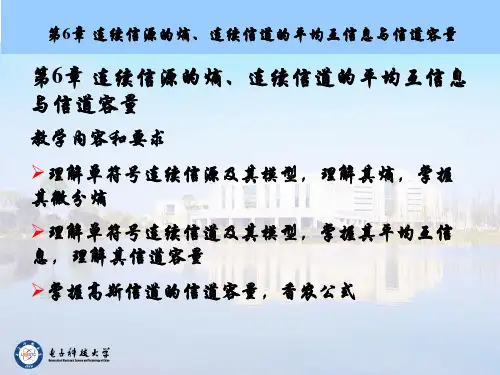

信道容量:单位时间内信道上所能传输的最大信息量.

信息三要素:信道,信源,信宿。

信道疑义度:输入空间X对输出空间Y的条件熵H(X|Y)=E[H(X|bj)]=﹣求和p(aibj)logp(ai|bj).

离散无记忆信源:离散信源在不同时刻发出的符号之间是无依赖的,彼此统计独立的。

离散平稳信源:输出的随机序列X=(X1X2…XN)中每个随机变量xi(i=1…N)取值是离散的,并且随机矢量X的各维概率分布不随时间平移而改变。

马尔科夫信源:信源发出的符号仅与在此之前发出的有限个符号有关,而与更早些时候发出的符号无关。

马尔科夫链:设{Xn,n属于N+}为一随机序列,时间参数集N+={0.1.2……},其状态空间S={S1,S2,…..SJ},若对所有n属于N+,有P{Xn=Sin|Xn-1=Sin-1……X1=Si1}=P{Xn=Sin|Xn-1=Sin-1}.则{Xn,n属于N+}为马尔科夫链。

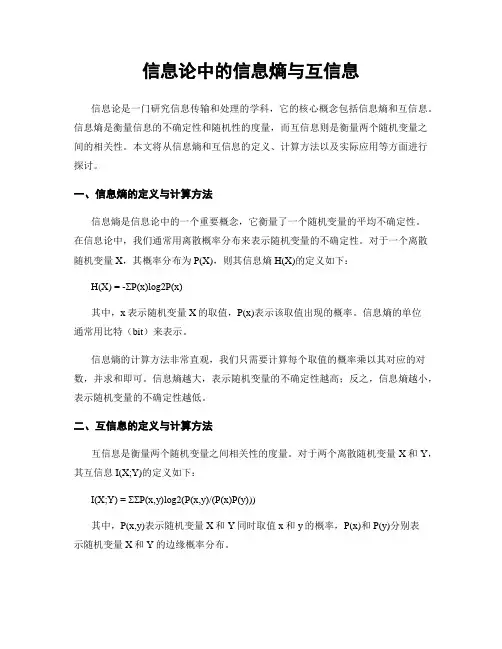

信息论中的信息熵与互信息信息论是一门研究信息传输和处理的学科,它的核心概念包括信息熵和互信息。

信息熵是衡量信息的不确定性和随机性的度量,而互信息则是衡量两个随机变量之间的相关性。

本文将从信息熵和互信息的定义、计算方法以及实际应用等方面进行探讨。

一、信息熵的定义与计算方法信息熵是信息论中的一个重要概念,它衡量了一个随机变量的平均不确定性。

在信息论中,我们通常用离散概率分布来表示随机变量的不确定性。

对于一个离散随机变量X,其概率分布为P(X),则其信息熵H(X)的定义如下:H(X) = -ΣP(x)log2P(x)其中,x表示随机变量X的取值,P(x)表示该取值出现的概率。

信息熵的单位通常用比特(bit)来表示。

信息熵的计算方法非常直观,我们只需要计算每个取值的概率乘以其对应的对数,并求和即可。

信息熵越大,表示随机变量的不确定性越高;反之,信息熵越小,表示随机变量的不确定性越低。

二、互信息的定义与计算方法互信息是衡量两个随机变量之间相关性的度量。

对于两个离散随机变量X和Y,其互信息I(X;Y)的定义如下:I(X;Y) = ΣΣP(x,y)log2(P(x,y)/(P(x)P(y)))其中,P(x,y)表示随机变量X和Y同时取值x和y的概率,P(x)和P(y)分别表示随机变量X和Y的边缘概率分布。

互信息的计算方法与信息熵类似,我们只需要计算每个取值同时出现的概率乘以其对应的对数,并求和即可。

互信息越大,表示两个随机变量之间的相关性越强;反之,互信息越小,表示两个随机变量之间的相关性越弱。

三、信息熵与互信息的实际应用信息熵和互信息在信息论中有广泛的应用,并且在许多领域中也得到了广泛的应用。

在通信领域中,信息熵被用来衡量信源的不确定性,从而确定数据传输的最佳编码方式。

互信息则可以用来衡量信道的容量,从而确定数据传输的最大速率。

在机器学习领域中,信息熵被用来衡量决策树的不确定性,从而确定最佳的划分属性。

互信息则可以用来衡量特征与标签之间的相关性,从而确定最佳的特征选择方法。

熵与信息论公式香农熵互信息的计算公式熵与信息论公式-香农熵与互信息的计算公式在信息论中,熵与互信息是两个重要的概念,它们经常被用于衡量信息的不确定性和相关性。

本文将详细介绍熵和互信息的定义和计算公式,并探讨它们在信息理论中的应用。

一、香农熵香农熵是信息论中用于度量随机变量不确定性的重要指标。

它可以理解为信息的平均度量,也可以理解为信息的缺乏度量。

对于离散型随机变量X,其熵H(X)的计算公式为:H(X) = -∑p(x)log2(p(x))其中,p(x)为随机变量X取某一值x的概率,log2表示以2为底的对数。

例如,假设有一个骰子,它的每个面出现的概率相等,即1/6。

那么骰子的熵可以通过以下计算得到:H(X) = -(1/6)log2(1/6) - (1/6)log2(1/6) - (1/6)log2(1/6) - (1/6)log2(1/6) - (1/6)log2(1/6) - (1/6)log2(1/6)根据计算公式,我们可以得到该骰子的熵为log2(6)≈2.58。

香农熵的计算过程可以理解为对每个可能取值的概率乘以该取值的信息量,并对所有情况求和。

熵越高,表示随机变量的不确定性越大。

二、互信息互信息是用于度量两个随机变量之间相关性的概念。

假设有两个离散型随机变量X和Y,它们的联合概率分布为p(x, y),边缘概率分布分别为p(x)和p(y)。

那么X和Y的互信息I(X;Y)的计算公式为:I(X;Y) = ∑∑p(x, y)log2(p(x, y)/(p(x)p(y)))互信息可以理解为两个随机变量之间共享的信息量。

当两个随机变量完全独立时,互信息为0;而当它们之间存在依赖关系时,互信息大于0。

三、应用熵和互信息在信息论中有广泛的应用。

其中,香农熵常被用于衡量信源中的信息量,例如在数据压缩算法中,熵越高的信源可以被更好地压缩。

互信息则常被用于衡量两个随机变量之间的相关性。

例如在机器学习中,互信息可用于特征选择和聚类分析。

《信息论与编码》实验1 绘制熵函数曲线一、实验目的熟悉工作环境及Matlab 软件 掌握绘图函数的运用 理解熵函数表达式及其性质 二、实验原理信息熵自信息量是针对信源的单个符号而言的,而符号是随机发生的,因此单个符号的不确定性不足于代表信源的不确定性性质,为此,可对所有符号的自信息量进行统计平均,从而得到平均不确定性。

熵的表示[]()()()()()log ()i i i i iiH X E I X p x I x p x p x ===-∑∑注意的问题熵是自信息量的统计平均,因此单位与自信息量的单位相同,与熵公式中所用对数的底有关:bit/符号、nat/符号、dit/符号、r 进制单位/符号。

特殊公式:某个pk=0时,0log0=0 (0lim log 0→=x x x )在熵的定义中忽略零概率事件。

平均互信息平均互信息量(I(X;Y))是统计平均意义下的先验不确定性与后验不确定性之 差,是互信息量的统计平均:,,(/)()(;)()(/)log()(/)()log()(;)===∑∑∑i j j j j i j ji ji i j i j i ji p x y p y I X y p y p x y p x p x y p x y p x I X Y()()()()()();/;/=-=-I X Y H X H X Y I Y X H Y H Y X三、实验内容1.用 Matlab 软件绘制二进熵函数曲线。

二元信源1011⎛⎫⎛⎫=≤≤ ⎪ ⎪-⎝⎭⎝⎭X p P p p二元信源的熵为(,1)log (1)log(1)-=----H p p p p p p绘制当p 从0到1之间变化时的二元信源的信息熵曲线.Matlab 程序: p=0.00001:0.001:1;h=-p.*log2(p)-(1-p).*log2(1-p); plot(p,h);title('二进熵函数曲线'); ylabel('H(p,1-p)') 2.绘制三元信源的熵三元信源1231212120,11()⎛⎫⎛⎫=≤≤ ⎪⎪--⎝⎭⎝⎭x x x X p p p p p p P x三元信源的熵为111111221212(,,1)log log (1)log(1)--=-------H p p p p p p p p p p p p 绘制当12,p p 从0到1之间变化时的三元信源的信息熵曲线.[p1,p2]=meshgrid(0.00001:0.001:1);h=-p1.*log2(p1)-p2.*log2(p2)-(1-p1-p2) .*log2(1-p1-p2); meshc(p1,p2,h); title('三进熵函数曲线');3.绘制平均互信息量图形对于二元对称信道的输入概率空间为0,1(),1ωωω⎡⎤⎡⎤=⎢⎥⎢⎥=-⎣⎦⎣⎦X P x平均互信息:根据:1()()(|)1===∑rj i j i i P b P a P b a所以:21(0)()(0|)(0)(0|0)(1)(0|1)ωω====+=+∑i i i P y P a P a P P P P p p(;)()(/)=-I X Y H Y H Y X 1()()(/)log(/)=-∑∑XYH Y P x P y x P y x 11()()[loglog ]=-+∑XH Y P x p p p p11()[loglog ]()()=-+=-H Y p p H Y H p p p21(1)()(0|)(0)(1|0)(1)(1|1)ωω====+=+∑i i i P y P a P a P P P P p p1111(;)()()()log ()log [log log ]()()()ωωωωωωωωωω=-=+++-+++=+-I X Y H Y H p p p p p p p p p p p p pH p p H p 绘制当,ωp 从0到1之间变化时的平均互信息熵曲线.[w,p] = meshgrid(0.00001:0.001:1);h=-(w.*(1-p)+(1-w).*p).*log2(w.*(1-p)+(1-w).*p)-(w.*p+(1-w).*(1-p)).*log2(w.*p+(1-w).*(1-p))+(p.*log2(p)+(1-p).*log2(1-p)) meshz(w,p,h) title('互信息'); ylabel('H(w,p,h)')四、实验报告要求 简述实验目的; 简述实验原理;分别绘制二元信源和三元信源的熵及平均互信息量图形。

平均互信息的三种表达公式平均互信息(Average Mutual Information)是一种用于衡量两个随机变量之间的相关性的指标。

它可以用于统计学、信息论和机器学习等领域,用于评估两个变量之间的依赖程度。

平均互信息有三种常见的表达公式,分别是:经验分布表达式、边缘分布和联合分布表达式、熵和条件熵表达式。

1. 经验分布表达式:平均互信息可以通过经验分布表达式来计算,这是一种基于观测样本的计算方法。

假设有两个离散型随机变量X和Y,它们的取值分别为x和y。

通过对大量的样本进行观测,可以得到它们的经验分布,即X和Y的联合经验分布P(X=x, Y=y)和边缘经验分布P(X=x)、P(Y=y)。

则平均互信息可以通过以下公式计算:I(X; Y) = Σx Σy P(X=x, Y=y) log(P(X=x, Y=y) / (P(X=x) *P(Y=y)))2. 边缘分布和联合分布表达式:平均互信息也可以通过边缘分布和联合分布的表达式来计算。

假设X和Y的边缘分布分别为P(X)和P(Y),联合分布为P(X, Y),则平均互信息可以表示为:I(X; Y) = Σx Σy P(X=x, Y=y) log(P(X=x, Y=y) / (P(X=x) *P(Y=y)))3. 熵和条件熵表达式:平均互信息还可以通过熵和条件熵的表达式来计算。

假设X和Y的熵分别为H(X)和H(Y),条件熵为H(X|Y),则平均互信息可以表示为:I(X; Y) = H(X) - H(X|Y)其中,熵H(X)可以通过以下公式计算:H(X) = -Σx P(X=x) log(P(X=x))条件熵H(X|Y)可以通过以下公式计算:H(X|Y) = -Σx Σy P(X=x, Y=y) log(P(X=x|Y=y))以上三种表达公式都是常用的计算平均互信息的方法。

在实际应用中,可以根据数据的不同形式和特点选择合适的表达公式进行计算。

平均互信息的计算可以帮助我们理解和分析随机变量之间的相关性,进而在数据分析、特征选择、模式识别等任务中发挥重要作用。