EqualLogic收集日志

- 格式:doc

- 大小:94.50 KB

- 文档页数:2

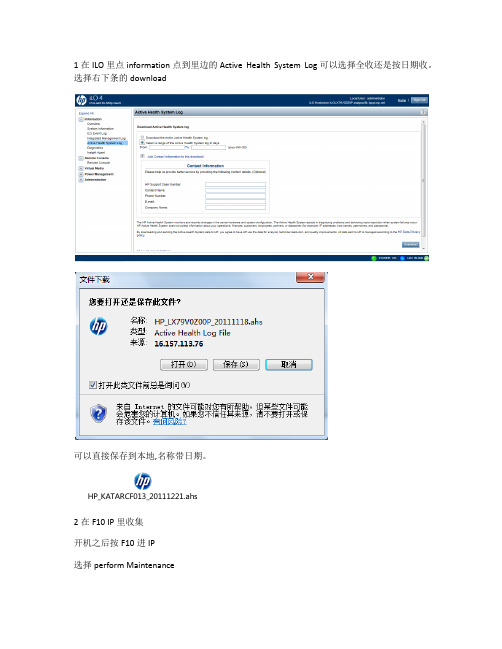

1在ILO里点information点到里边的Active Health System Log可以选择全收还是按日期收。

选择右下条的download

可以直接保存到本地,名称带日期。

HP_KATARCF013_20111221.ahs

2在F10 IP里收集

开机之后按F10进IP

选择perform Maintenance

选择第一个active health system download

可以在此写上case id 客户姓名公司名 email等信息

选download之后出现下图,所以这种方便收日志是需要USB key的。

第三种方法:

用工具收,但这个工具要先发给客户

请客户打开运行后桌面出现快捷方式

点开后如下图,如果要收日志点source里的Remote

点removt后

录入服务器的IP 用户名和密码

录入之后一样出现下图,一样还是要用USB key才行。

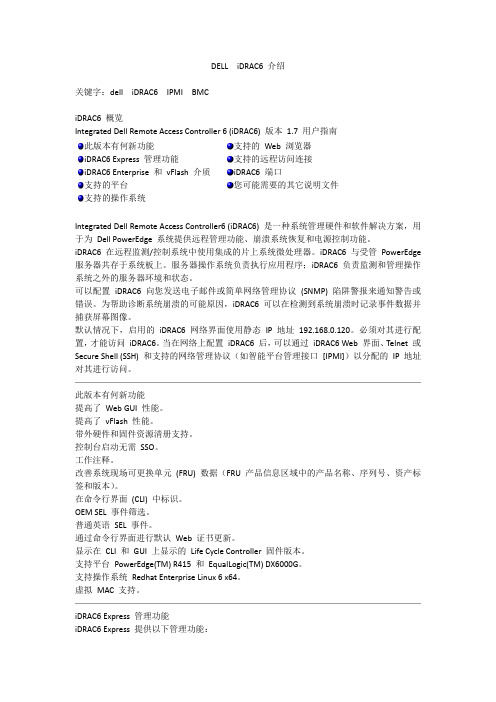

DELL iDRAC6介绍关键字:dell iDRAC6 IPMI BMCiDRAC6 概览Integrated Dell Remote Access Controller 6 (iDRAC6) 版本1.7 用户指南此版本有何新功能iDRAC6 Express 管理功能iDRAC6 Enterprise 和vFlash 介质支持的平台支持的操作系统支持的Web 浏览器支持的远程访问连接iDRAC6 端口您可能需要的其它说明文件Integrated Dell Remote Access Controller6 (iDRAC6) 是一种系统管理硬件和软件解决方案,用于为Dell PowerEdge 系统提供远程管理功能、崩溃系统恢复和电源控制功能。

iDRAC6 在远程监测/控制系统中使用集成的片上系统微处理器。

iDRAC6 与受管PowerEdge 服务器共存于系统板上。

服务器操作系统负责执行应用程序;iDRAC6 负责监测和管理操作系统之外的服务器环境和状态。

可以配置iDRAC6 向您发送电子邮件或简单网络管理协议(SNMP) 陷阱警报来通知警告或错误。

为帮助诊断系统崩溃的可能原因,iDRAC6 可以在检测到系统崩溃时记录事件数据并捕获屏幕图像。

默认情况下,启用的iDRAC6 网络界面使用静态IP 地址192.168.0.120。

必须对其进行配置,才能访问iDRAC6。

当在网络上配置iDRAC6 后,可以通过iDRAC6 Web 界面、Telnet 或Secure Shell (SSH) 和支持的网络管理协议(如智能平台管理接口[IPMI])以分配的IP 地址对其进行访问。

此版本有何新功能提高了Web GUI 性能。

提高了vFlash性能。

带外硬件和固件资源清册支持。

控制台启动无需SSO。

工作注释。

改善系统现场可更换单元(FRU) 数据(FRU 产品信息区域中的产品名称、序列号、资产标签和版本)。

软件开发中的日志收集与分析在现今互联网应用平台的快速发展下,软件开发成为了一个全新的行业。

软件开发行业的形成也促进了日志收集与分析这一技术的迅速发展。

在软件开发过程中,日志的收集与分析是非常重要的一部分,因为它可以有效地跟踪软件的运行状态和各项指标,保证软件的稳定性和高效性。

本文将探讨软件开发中的日志收集与分析。

一、日志收集日志收集是软件开发的基础步骤,指获取软件中发生的各种事件和行为的详细记录。

通过收集日志,可以深入了解程序的运行状态和程序在多种不同情况下的运行效果。

同时,作为软件开发的关键要素,日志记录可以用于对软件性能的评估以及问题的诊断与解决。

1、日志收集注意事项在日志收集过程中,需要注意如下事项:(1)记录必要信息:日志的记录必须包含必要的信息,例如:事件类型、时间、位置、参数等;(2)提高日志质量:日志记录需精细,避免出现重复、冗长、不符合业务逻辑等带来的干扰和噪音;(3)确定日志格式:日志格式应当标准化,并且可读性要好,方便后期处理;(4)合理设置日志级别:不同的场景需设置不同的日志级别,以方便定位问题;(5)保护用户隐私:需要保护用户敏感信息,不应将其写入日志中。

2、日志收集方式现在日志收集方式主要有以下几种:(1)本地日志:将日志记录在本地文件中,常用于桌面程序和本地应用;(2)远程日志:将日志记录在远程服务器上,常用于Web应用和分布式系统;(3)统一日志采集:通过统一的采集客户端收集分散在不同节点的日志,并将其聚合至统一的存储端口,常用于分布式系统、大数据平台等。

二、日志分析日志分析是指在日志收集的基础上,对日志数据进一步处理和分析,以获取有用信息的过程。

通过日志分析,可以对软件进行实时监管、运行监控和,为开发人员提供有用的性能评估和故障排除信息。

1、日志分析流程日志分析通常包括以下几个步骤:(1)日志收集:积极统计收集软件系统中产生的各类日志,统一存储至日志中心;(2)日志预处理:将日志中的非关键信息进行过滤,并对各类日志进行统一格式化处理;(3)日志转换:将日志中的内容按照特定的格式进行转换,以便后续的不同类型数据的处理;(4)数据挖掘:通过数据挖掘技术进行数据统计和分析,寻找问题和异常信息;(5)可视化展示:将挖掘结果进行可视化展示,便于用户进行数据分析和业务监控。

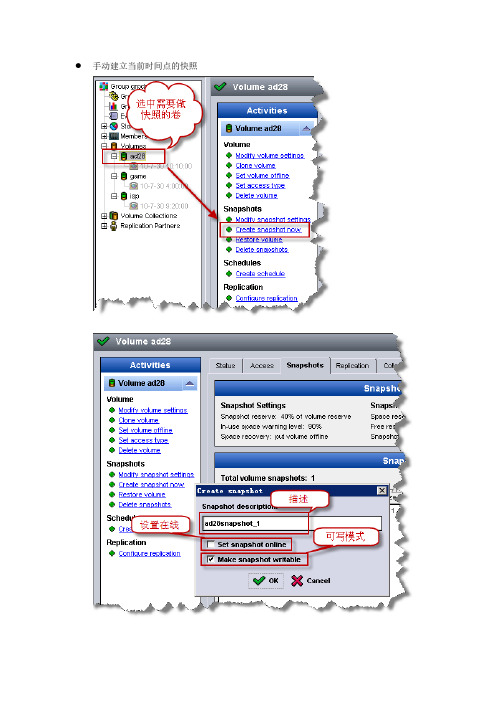

手动建立当前时间点的快照创建自动快照任务(这里演示的是按小时)使用批处理脚本制作快照这里我们会使用到的文件主体程序:EqlCliExec.pl 批处理需要调用的PERL程序EqlScript.pm PERL的模块iscsilogon.bat 批处理主体p.txt diskpart命令脚本其他文件(会自动生成):iscsi.log ISCSI日志newTarget.txtoldTargetSession.txtsnap.txt 保存了脚本创建的快照名主体批处理iscsilogon.bat说明(因涉及到帐号密码所以我假设盘柜的IP为192.168.0.100 帐号为root 密码abc#123 并用红字标出)@echo offrem windows iscsi logon tool V0.2 write by Lichengrem 4 files together ,this file p.txt and eqlscript tools(EqlCliExec.pl \ EqlScript.pm)remthe bat need perlsupprot ,download it from(/ASPN/Downloads/ActivePerl/):: check iscsi clientif not exist %windir%\system32\iscsiexe.exe goto exit:startISCSInet start "Microsoft iSCSI Initiator Service"::stopmssql servernet stop mssqlserver:LogoutTargetiscsicliSessionList|find /i "Session Id" > oldTargetSession.txtFOR /F "usebackqeol=; tokens=2 delims=:" %%I in (oldTargetSession.txt) do iscsicliLogoutTarget %%I::----删除快照:deleteSnapshotfor /f "usebackqeol=; tokens=4 delims= " %%I in (snap.txt) do EqlCliExec.pl -g 192.168.0.100 -a root -p abc#123 volume select isp snapshot delete %%I::----建立快照:creatSnapshotEqlCliExec.pl -g 192.168.0.100 -a root -p abc#123 volume select isp snapshot create-now online | find /i "isp" > snap.txtrem for /f "usebackqeol=; tokens=4 delims= " %%I in (snap.txt) do echo %%I > :LogonTarget::----iscsi建立连接iscsicliAddTargetPortal192.168.0.100 3260iscsicliListTargets|find /i "iqn" > newTarget.txtFOR /F "usebackqeol=; tokens=1 delims=" %%I in (newTarget.txt) do iscsicliLoginTarget %%I T * * * * * * * * * * * * * * * 0::----出盘(虚拟盘设置盘符),具体信息参考p.txt:assignLetterdiskpart /s p.txtecho iscsi.bat is run at %date% %time% >> iscsi.log::startmssql servernet start mssqlserverselect partition 1remove allassign letter fexit在这里我修改了部分代码建立了删除用脚本创建快照的批处理net stop mssqlserver:LogoutTargetiscsicliSessionList|find /i "Session Id" > oldTargetSession.txtFOR /F "usebackqeol=; tokens=2 delims=:" %%I in (oldTargetSession.txt) do iscsicliLogoutTarget %%I::----删除快照:deleteSnapshotfor /f "usebackqeol=; tokens=4 delims= " %%I in (snap.txt) do EqlCliExec.pl -g 192.168.0.100 -a root -p abc#123 volume select isp snapshot delete %%I注:因批处理中含有盘柜的真实IP帐号密码等,所以我们可以通过第3方bat2exe程序(Bat To Exe Converter.exe)将批处理转为可执行文件这样就不会泄露密码了快照在使用中的注意事项数据变化量大的卷不要保留过多的快照,因为每份快照最大占用空间将是卷使用空间的100%;脚本建立的快照是不会被自动删除的,所以要经常检查避免空间溢出,这将会导致VOLUME OFFLINE;合理的分配快照的可用空间,按现在的需求看快照可用空间为卷容量的40%,已经够用了,如果有必要的话可以设置为卷容量的100%(按以后的需求来动态分配)下图为检查快照使用容量。

Mac命令行如何使用Logstash进行日志收集和分析日志是应用程序和系统运行过程中产生的关键信息,用于故障排查、性能监测和安全分析等方面。

Logstash是由Elastic公司推出的开源工具,可以用于日志的收集、处理和分析。

在Mac上使用Logstash进行日志收集和分析,可以帮助我们更好地理解和优化应用程序和系统的运行状态。

以下是Mac命令行下使用Logstash进行日志收集和分析的步骤:1. 安装Java Development Kit (JDK)在Mac上使用Logstash之前,首先需要安装JDK。

打开终端,输入以下命令安装JDK:```brew install openjdk@11```2. 安装Logstash在终端中运行以下命令来安装Logstash:```brew tap elastic/tapbrew install elastic/tap/logstash-full```3. 创建Logstash配置文件在终端中使用编辑器创建一个Logstash配置文件,例如,使用vim编辑器创建一个名为`logstash.conf`的文件:```vim logstash.conf```在配置文件中添加以下内容,用于指定日志输入、过滤和输出的插件:```input {file {path => "/path/to/your/logfile.log"start_position => "beginning"}}filter {# 根据需要添加过滤规则}output {elasticsearch {hosts => ["localhost:9200"] # Elasticsearch的地址和端口index => "mylogs-%{+YYYY.MM.dd}" # 索引名称}}```将`/path/to/your/logfile.log`替换为您要收集和分析的实际日志文件路径。

常见⽇志收集⽅案及相关组件常见⽇志收集⽅案及相关组件⼀、常见⽇志收集⽅案1.1、EFK在Kubernetes集群上运⾏多个服务和应⽤程序时,⽇志收集系统可以帮助你快速分类和分析由Pod⽣成的⼤量⽇志数据。

Kubernetes中⽐较流⾏的⽇志收集解决⽅案是Elasticsearch、Fluentd和Kibana(EFK)技术栈,也是官⽅推荐的⼀种⽅案。

1)Elasticsearch:是⼀个实时的,分布式的,可扩展的搜索引擎,它允许进⾏全⽂本和结构化搜索以及对⽇志进⾏分析。

它通常⽤于索引和搜索⼤量⽇志数据,也可以⽤于搜索许多不同种类的⽂档。

2)Kibana:Elasticsearch通常与Kibana⼀起部署,kibana可以把Elasticsearch采集到的数据通过dashboard(仪表板)可视化展⽰出来。

Kibana允许你通过Web界⾯浏览Elasticsearch⽇志数据,也可⾃定义查询条件快速检索出elasticccsearch中的⽇志数据。

3)Fluentd:是⼀个流⾏的开源数据收集器,我们在 Kubernetes 集群节点上安装 Fluentd,通过获取容器⽇志⽂件、过滤和转换⽇志数据,然后将数据传递到 Elasticsearch 集群,在该集群中对其进⾏索引和存储。

1.2、ELK Stack1)Elasticsearch:⽇志存储和搜索引擎,它的特点有:分布式,零配置,⾃动发现,索引⾃动分⽚,索引副本机制,restful风格接⼝,多数据源,⾃动搜索负载等。

2)Logstash:是⼀个完全开源的⼯具,他可以对你的⽇志进⾏收集、过滤,并将其存储供以后使⽤(⽀持动态的从各种数据源搜集数据,并对数据进⾏过滤、分析、丰富、统⼀格式等操作。

)。

3)Kibana:是⼀个开源和免费的⼯具,Kibana可以为 Logstash 和 ElasticSearch 提供的⽇志分析友好的 Web 界⾯,可以帮助您汇总、分析和搜索重要数据⽇志。

硬件用户手册© 版权所有 2011-2013 Dell Inc. 保留所有权利。

Dell™ 和 EqualLogic® 是 Dell Inc. 的商标。

本文使用的所有商标和注册商标均属其各自所有者的财产。

本说明文件中的信息如有更改,恕不另行通知。

未经 Dell 书面许可,严禁以任何形式进行复制。

发布时间:2013 年 10 月部件号:110-6178-ZH-CN R1目录前言v1 基本设备信息1设备组件1设备前面板功能部件1设备背面板功能部件2将设备连接至电源4打开和关闭电源5关闭控制器电源6打开控制器电源6所需工具6技术规格62 更换组件9安全建议9所需工具9使用防静电腕带9更换控制器10卸下控制器10安装控制器11安装 SFP+ 收发器12更换电源设备12卸下电源设备12安装电源设备12卸下挡板13连接挡板14更换散热风扇14卸下风扇14安装风扇16更换设备16卸下设备16安装设备17返还故障硬件173 下一步操作19NAS 群集文档19附录 A: NOM 信息(仅限于墨西哥)21词汇表23索引25iiiDell EqualLogic FS7600硬件用户手册目录iv前言Dell™ EqualLogic® FS Series 设备与 PS Series 阵列相结合,提供高性能、高可用性、可扩展的 NAS 解决方案。

本手册介绍如何对 EqualLogic FS7600 设备的客户可更换组件进行维护和故障排除。

读者对象本指南中的信息适用于负责维护 EqualLogic FS7600 硬件的硬件管理员。

相关说明文件有关 FS Series 设备、PS Series 阵列、组、卷、阵列软件以及主机软件的详情,请登录到位于客户支持站点的说明文件页。

Dell 联机服务您可以使用以下步骤了解 Dell 产品和服务:1. 访问或在任何 Dell 产品信息中指定的 URL。

2. 使用地区菜单或单击指定您所在国家/地区或区域的链接。

Linux上的日志收集和分析工具比较ELKvsGraylogLinux上的日志收集和分析工具比较:ELK vs Graylog在现代的计算机系统中,日志收集和分析是至关重要的。

它们可以帮助管理员监控系统运行情况、诊断问题,并提供安全的实时警报。

对于Linux系统而言,有多种选择可供选择,其中两个主要的选项是ELK和Graylog。

本文将比较这两个工具,以帮助您了解它们的特点和适用场景。

ELK(Elasticsearch, Logstash, Kibana)是一个开源的日志收集和分析工具套件。

它包含三个主要组件:Elasticsearch、Logstash和Kibana。

Elasticsearch是一个实时分布式搜索和分析引擎,它可以快速地存储、搜索和分析大量的数据。

Logstash是一个用于数据收集、过滤、转换和发送的服务器端管道工具。

Kibana是一个用于展示和可视化数据的工具,它提供了强大的图表和仪表盘功能。

相比之下,Graylog是另一个功能强大的开源日志管理平台。

它提供了与ELK类似的功能,但有一些不同之处。

Graylog使用Elasticsearch作为其底层数据存储引擎,因此可以实现类似的实时搜索和分析功能。

然而,Graylog还提供了一些其他功能,例如可配置的警报和通知机制,以及用户和权限管理。

在性能方面,ELK和Graylog都可以处理大量的日志数据。

然而,根据具体的部署要求和硬件配置,它们之间的性能差异可能会有所不同。

ELK在大规模和高吞吐量的数据处理方面表现出色,但在处理较小规模的环境时可能会导致性能损失。

与之相反,Graylog在处理中小规模数据时表现得更加灵活和高效。

在用户界面方面,Kibana和Graylog都提供了直观且易于使用的界面。

Kibana的用户界面可以通过图表、仪表盘和搜索来展示和分析数据,而Graylog则提供了一个类似于电子邮件收件箱的界面,用户可以轻松地搜索、筛选和分析日志数据。

日志收集检索1. 任务概述日志收集检索是一项重要的技术,它可以帮助我们收集、存储和检索系统、应用程序和网络设备生成的日志数据。

通过对日志数据的分析和检索,我们可以及时发现问题、解决故障,并优化系统性能。

本文将介绍日志收集检索的基本概念、常见工具和最佳实践,帮助读者了解并应用这一技术。

2. 日志收集2.1 什么是日志日志是系统、应用程序或网络设备在运行过程中产生的记录事件的文件。

它包含了关键的信息,如操作、错误、警告、性能指标等。

通过分析日志,我们可以了解系统的运行情况、发现问题和优化性能。

2.2 日志收集的重要性日志收集是一项重要的任务,它可以帮助我们:•发现系统问题:通过分析日志,我们可以及时发现系统中的错误、警告和异常情况,从而及时采取措施解决问题。

•解决故障:当系统出现故障时,日志是排查问题的重要依据。

通过分析日志,我们可以找到故障的根本原因,并解决它。

•优化性能:通过分析日志,我们可以了解系统的性能瓶颈,并采取相应的措施进行优化,提高系统的性能和稳定性。

2.3 日志收集的方法日志收集可以通过以下几种方法实现:•手动收集:手动收集日志是最简单的方法,但也是最繁琐的方法。

它需要人工定期登录到系统、应用程序或网络设备上,将日志文件复制到指定位置。

•自动收集:自动收集日志是一种更高效和可靠的方法。

它可以通过配置系统、应用程序或网络设备,使其自动将日志发送到指定的收集器中。

•中心化收集:中心化收集是一种集中管理和存储日志的方法。

它可以通过使用日志收集工具,将分散在不同系统、应用程序和网络设备上的日志收集到统一的存储系统中。

2.4 常见的日志收集工具目前,市场上有许多成熟的日志收集工具,常见的有:•ELK Stack:ELK Stack是一个开源的日志收集和分析平台,由Elasticsearch、Logstash和Kibana三个组件组成。

它可以实时收集、存储和分析大量的日志数据,并提供强大的搜索和可视化功能。