自变量选择与逐步回归

- 格式:doc

- 大小:182.00 KB

- 文档页数:5

回归分析的回归方法

回归分析是一种统计分析方法,用于探索和建立自变量与因变量之间的关系。

在回归分析中,有多种回归方法可以使用,其中常见的包括线性回归、多项式回归、多元线性回归、逐步回归、岭回归和Lasso回归等。

1. 线性回归:最简单也是最常用的回归方法,假设自变量和因变量之间存在线性关系,通过最小化残差平方和来估计模型参数。

2. 多项式回归:在线性回归的基础上,将自变量的高阶项添加进模型,以更好地拟合非线性关系。

3. 多元线性回归:包含多个自变量和一个因变量的回归方法,考虑多个因素对因变量的影响。

4. 逐步回归:通过逐步选择自变量,不断添加或删除变量,以找出最合适的自变量集合。

5. 岭回归:一种通过引入正则化项来控制模型复杂度的回归方法,可以有效应对高维数据和共线性问题。

6. Lasso回归:与岭回归类似,也是一种使用正则化项来约束模型复杂度的方法,与岭回归不同的是,Lasso回归可以自动进行变量选择,倾向于将某些系数设为

零。

这些回归方法各有特点,选择合适的方法取决于具体问题的特点和数据的性质。

简述自变量选择的几个常用准则

自变量选择是统计建模中非常重要的一步,常用的准则包括以下几个:

1. 前向选择法(Forward Selection),从一个空模型开始,逐步加入自变量,每次加入一个自变量后,检验其对模型的贡献,选择对模型贡献最大的自变量加入模型。

2. 后向消元法(Backward Elimination),从包含所有自变量的模型开始,逐步剔除对模型贡献最小的自变量,直到剩下的自变量都对模型有显著影响。

3. 逐步回归法(Stepwise Regression),结合了前向选择法和后向消元法,既可以加入自变量,也可以剔除自变量,直到找到最佳的模型。

4. 最优子集选择法(Best Subset Selection),考虑所有可能的自变量组合,通过某种评价准则(如AIC、BIC等)选择最佳的自变量子集。

5. 正则化方法(Regularization),如岭回归(Ridge Regression)和Lasso回归(Lasso Regression)等,通过对系数施加惩罚来选择自变量,防止过拟合。

以上几种准则各有优缺点,选择合适的自变量选择方法需要根据具体问题和数据情况来决定。

同时,还需要考虑模型的解释性、预测准确性等因素,综合考虑选择最合适的自变量。

变量选择与逐步回归

1在建立回归模型时,对自变量进行筛选

2选择自变量的原则是对统计量进行显著性检验

(1)将一个或一个以上的自变量引入到回归模型中时,是否使得残差平方和(SSE)有显著地减少。

如果增加一个自变量使SSE的减少是显著的,则说明有必要将这个自变量引入回归模型,否则,就没有必要将这个自变量引入回归模型

确定引入自变量是否使SSE有显著减少的方法,就是使用F统计量的值作为一个标准,以此来确定是在模型中增加一个自变量,还是从模型中剔除一个自变量

3逐步回归:将向前选择和向后剔除两种方法结合起来筛选自变量。

在增加了一个自变量后,它会对模型中所有的变量进行考察,看看有没有可能剔除某个自变量;如果在增加了一个自变量后,前面增加的某个自变量对模型的贡献变得不显著,这个变量就会被剔除;按照方法不停地增加变量并考虑剔除以前增加的变量的可能性,直至增加变量已经不能导致SSE显著减少;在前面步骤中增加的自变量在后面的步骤中有可能被剔除,而在前面步骤中剔除的自变量在后面的步骤中也可能重新进入到模型中。

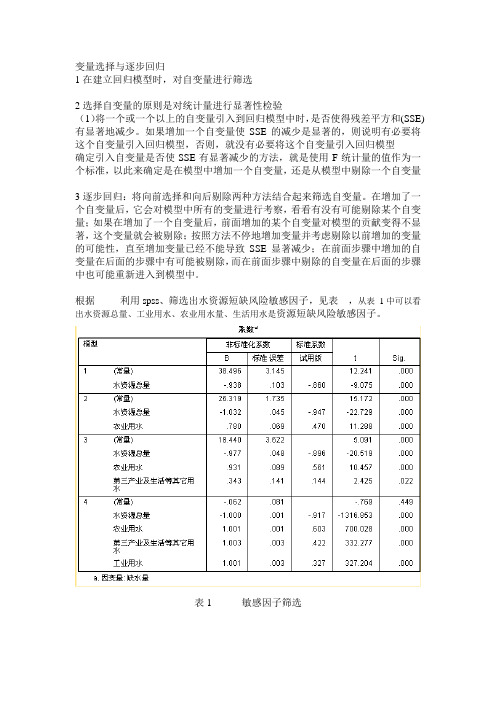

根据利用spss、筛选出水资源短缺风险敏感因子,见表,从表1中可以看出水资源总量、工业用水、农业用水量、生活用水是资源短缺风险敏感因子。

表1 敏感因子筛选。

报告中的变量选择和回归分析方法引言:报告中的变量选择和回归分析方法是数据分析和统计学中的重要内容。

在研究报告和学术论文中,合理选择变量和进行回归分析可以有效地揭示变量之间的关系,提高分析的准确性和可靠性。

本文将从六个方面对报告中的变量选择和回归分析方法进行详细论述。

一、变量选择的意义变量选择是指在进行回归分析时,从众多可能的自变量中选择出最为重要和相关的变量。

合理的变量选择可以减少冗余变量的存在,避免数据过拟合问题,并提高模型的预测能力和可解释性。

变量选择的意义在于提高研究的效率和有效性。

二、变量选择的方法1. 相关系数法:通过计算自变量与因变量之间的相关系数,选择与因变量关系最为密切的自变量。

相关系数法既简单又直观,但在多变量分析中无法考虑到变量之间的相互作用。

2. 正向选择法:从众多可能的自变量中,逐步添加具有显著影响力的变量,并根据模型的显著性检验去除不显著的变量。

正向选择法可以一步步剔除不相关的变量,但可能会错过一些有用的变量。

3. 逆向选择法:从包含所有自变量的模型开始,逐步去除不显著的变量,直到剩下的自变量都显著。

逆向选择法可以保留所有可能有用的变量,但可能出现模型过于复杂的问题。

三、回归分析的基本原理回归分析是通过建立数学模型,分析自变量对因变量的影响程度和方向。

常见的回归分析方法包括线性回归、多元回归、逻辑回归等。

回归分析需要满足一些基本的假设和前提,如线性关系、多元正态分布等。

四、回归分析的评价指标回归分析的结果需要进行评价,以判断模型的拟合程度和可靠性。

常用的评价指标包括判定系数(R平方)、均方根误差(RMSE)、残差等。

这些指标可以帮助研究者判断模型的准确性,并进行模型的改进和优化。

五、回归分析的解读和应用回归分析的结果需要进行解读,以揭示自变量与因变量之间的关系。

解读回归系数可以确定变量之间的正负相关关系,判断自变量对因变量的影响程度。

回归分析的应用广泛,可以用于预测、控制和优化等多个领域。

自变量选择与逐步回归一、全模型和选模型设研究某一实际问题,涉及对因变量有影响的因素共有m 个,由因变量y 和m 个自变量构成的回归模型εββββ+++++=m m x x x y 22110称为全模型。

如果从可供选择的m 个变量中选出p 个,由选出的p 个自变量组成的回归模型p pp pp p p p x x x y εββββ+++++= 22110称为选模型。

二、自变量选择对预测的影响自变量选择对预测的影响可以分为两种情况考虑,第一种情况是全模型正确而误用了选模型;第二种情况是选模型正确而无用了全模型。

以下是这两种情况对回归的影响。

1、全模型正确而误用选模型的情况性质1,在j x 与m p x x ,,1 +的相关系数不全为0时,选模型回归系数的最小二乘估计是全模型相应参数的有偏估计,即jjp jp E βββ≠=)ˆ((p j ,,2,1 =) 性质2,选模型的预测是有偏的。

性质3,选模型的参数估计有较小的方差。

性质4,选模型的预测残差有较小的方差。

性质5,选模型的均方误差比全模型预测的方差更小。

性质1和性质2表明,当全模型正确时,而舍去了m-p 个自变量,用剩下的p 个自变量去建立选模型,参数估计值是全模型相应参数的有偏估计,用其做预测,预测值也是有偏的。

这是误用选模型产生的弊端。

性质3和性质4表明,用选模型去作预测,残差的方差比用全模型去作预测的方差小,尽管用选模型所作的预测是有偏的,但得到的预测残差的方差下降了,这说明尽管全模型正确,误用选模型是有弊也有利的。

性质5说明,即使全模型正确,但如果其中有一些自变量对因变量影响很小或回归系数方差过大,丢掉这些变量之后,用选模型去预测,可以提高预测的精度。

由此可见,如果模型中包含了一些不必要的自变量,模型的预测精度就会下降。

2、选模型正确而误用全模型的情况全模型的预测值是有偏估计;选模型的预测方差小于全模型的预测方差;全模型的预测误差将更大。

《应用回归分析》自变量选择与逐步回归实验报告二、实验步骤:(只需关键步骤)步骤一:对六个回归自变量x1,x2……x6分别同因变量Y建立一元回归模型步骤二:分别计算这六个一元回归的六个回归系数的F检验值。

步骤三:将因变量y 分别与(x1, x2),(x1, x3), …, (x1, x m)建立m-1个二元线性回归方程, 对这m-1个回归方程中x2, x3, …, x m的回归系数进行F 检验,计算 F 值步骤四:重复步骤二。

三、实验结果分析:(提供关键结果截图和分析)1.建立全模型回归方程;由上图结果可知该问题的全模型方程为:Y=1347.986-0.641x1-0.317x2-0.413x3-0.002x4+0.671x5-0.008x62.用前进法选择自变量;从右图上可以看出:依次引入了变量x5、x1、x2最优回归模型为:Y^=874.583-0.611x1-0.353x2+0.637x5最优模型的复决定系数 :R^2=0.996调整后的复决定系数:R^2=0.9953.用后退法选择自变量;从上图上可以看出:依次剔除变量x4、x3、x6最优回归模型为:y^=874.583-0.611x1-0.353x2+0.637x5最优模型的复决定系数 R^2=0.996调整后的复决定系数R^2=0.995最优模型的复决定系数R^2=0.996调整后的复决定系数R^2=0.9954.用逐步回归法选择自变量;从上图上可以看出:依次引入了变量x5、x1、x2最优回归模型为:y^=874.583-0.611x1-0.353x2+0.637x5最优模型的复决定系数 R^2=0.996调整后的复决定系数R^2=0.9955.根据以上结果分三种方法的差异。

前进法和后退法以及逐步回归法的计算结果完全一致,但是在其计算上又有很大的差异,前进法就是当自变量一旦被选入,就永远保留在模型中。

后退法就是反向法,而逐步回归就比后退法更明确,逐步后退回归的方法。

自变量选择与逐回归————————————————————————————————作者:————————————————————————————————日期:自变量选择与逐步回归一、全模型和选模型设研究某一实际问题,涉及对因变量有影响的因素共有m 个,由因变量y 和m 个自变量构成的回归模型εββββ+++++=m m x x x y Λ22110称为全模型。

如果从可供选择的m 个变量中选出p 个,由选出的p 个自变量组成的回归模型p pp pp p p p x x x y εββββ+++++=Λ22110称为选模型。

二、自变量选择对预测的影响自变量选择对预测的影响可以分为两种情况考虑,第一种情况是全模型正确而误用了选模型;第二种情况是选模型正确而无用了全模型。

以下是这两种情况对回归的影响。

1、全模型正确而误用选模型的情况性质1,在j x 与m p x x ,,1Λ+的相关系数不全为0时,选模型回归系数的最小二乘估计是全模型相应参数的有偏估计,即jjp jp E βββ≠=)ˆ((p j ,,2,1Λ=) 性质2,选模型的预测是有偏的。

性质3,选模型的参数估计有较小的方差。

性质4,选模型的预测残差有较小的方差。

性质5,选模型的均方误差比全模型预测的方差更小。

性质1和性质2表明,当全模型正确时,而舍去了m-p 个自变量,用剩下的p 个自变量去建立选模型,参数估计值是全模型相应参数的有偏估计,用其做预测,预测值也是有偏的。

这是误用选模型产生的弊端。

性质3和性质4表明,用选模型去作预测,残差的方差比用全模型去作预测的方差小,尽管用选模型所作的预测是有偏的,但得到的预测残差的方差下降了,这说明尽管全模型正确,误用选模型是有弊也有利的。

性质5说明,即使全模型正确,但如果其中有一些自变量对因变量影响很小或回归系数方差过大,丢掉这些变量之后,用选模型去预测,可以提高预测的精度。

由此可见,如果模型中包含了一些不必要的自变量,模型的预测精度就会下降。

第5章自变量选择与逐步回归思考与练习参考答案自变量选择对回归参数的估计有何影响答:回归自变量的选择是建立回归模型得一个极为重要的问题。

如果模型中丢掉了重要的自变量, 出现模型的设定偏误,这样模型容易出现异方差或自相关性,影响回归的效果;如果模型中增加了不必要的自变量, 或者数据质量很差的自变量, 不仅使得建模计算量增大, 自变量之间信息有重叠,而且得到的模型稳定性较差,影响回归模型的应用。

自变量选择对回归预测有何影响答:当全模型(m元)正确采用选模型(p元)时,我们舍弃了m-p个自变量,回归系数的最小二乘估计是全模型相应参数的有偏估计,使得用选模型的预测是有偏的,但由于选模型的参数估计、预测残差和预测均方误差具有较小的方差,所以全模型正确而误用选模型有利有弊。

当选模型(p元)正确采用全模型(m 元)时,全模型回归系数的最小二乘估计是相应参数的有偏估计,使得用模型的预测是有偏的,并且全模型的参数估计、预测残差和预测均方误差的方差都比选模型的大,所以回归自变量的选择应少而精。

如果所建模型主要用于预测,应该用哪个准则来衡量回归方程的优劣C统计量达到最小的准则来衡量回答:如果所建模型主要用于预测,则应使用p归方程的优劣。

试述前进法的思想方法。

答:前进法的基本思想方法是:首先因变量Y对全部的自变量x1,x2,...,xm建立m 个一元线性回归方程, 并计算F检验值,选择偏回归平方和显着的变量(F值最大且大于临界值)进入回归方程。

每一步只引入一个变量,同时建立m-1个二元线性回归方程,计算它们的F检验值,选择偏回归平方和显着的两变量变量(F 值最大且大于临界值)进入回归方程。

在确定引入的两个自变量以后,再引入一个变量,建立m-2个三元线性回归方程,计算它们的F检验值,选择偏回归平方和显着的三个变量(F值最大)进入回归方程。

不断重复这一过程,直到无法再引入新的自变量时,即所有未被引入的自变量的F检验值均小于F检验临界值Fα(1,n-p-1),回归过程结束。

自变量选择与逐步回归一、全模型和选模型设研究某一实际问题,涉及对因变量有影响的因素共有m 个,由因变量y 和m 个自变量构成的回归模型εββββ+++++=m m x x x y 22110称为全模型。

如果从可供选择的m 个变量中选出p 个,由选出的p 个自变量组成的回归模型p pp pp p p p x x x y εββββ+++++= 22110称为选模型。

二、自变量选择对预测的影响自变量选择对预测的影响可以分为两种情况考虑,第一种情况是全模型正确而误用了选模型;第二种情况是选模型正确而无用了全模型。

以下是这两种情况对回归的影响。

1、全模型正确而误用选模型的情况性质1,在j x 与m p x x ,,1 +的相关系数不全为0时,选模型回归系数的最小二乘估计是全模型相应参数的有偏估计,即jjp jp E βββ≠=)ˆ((p j ,,2,1 =) 性质2,选模型的预测是有偏的。

性质3,选模型的参数估计有较小的方差。

性质4,选模型的预测残差有较小的方差。

性质5,选模型的均方误差比全模型预测的方差更小。

性质1和性质2表明,当全模型正确时,而舍去了m-p 个自变量,用剩下的p 个自变量去建立选模型,参数估计值是全模型相应参数的有偏估计,用其做预测,预测值也是有偏的。

这是误用选模型产生的弊端。

性质3和性质4表明,用选模型去作预测,残差的方差比用全模型去作预测的方差小,尽管用选模型所作的预测是有偏的,但得到的预测残差的方差下降了,这说明尽管全模型正确,误用选模型是有弊也有利的。

性质5说明,即使全模型正确,但如果其中有一些自变量对因变量影响很小或回归系数方差过大,丢掉这些变量之后,用选模型去预测,可以提高预测的精度。

由此可见,如果模型中包含了一些不必要的自变量,模型的预测精度就会下降。

2、选模型正确而误用全模型的情况全模型的预测值是有偏估计;选模型的预测方差小于全模型的预测方差;全模型的预测误差将更大。

自变量选择与逐步回归一、全模型和选模型设研究某一实际问题,涉及对因变量有影响的因素共有m 个,由因变量y 和m 个自变量构成的回归模型εββββ+++++=m m x x x y 22110称为全模型。

如果从可供选择的m 个变量中选出p 个,由选出的p 个自变量组成的回归模型p pp pp p p p x x x y εββββ+++++= 22110称为选模型。

二、自变量选择对预测的影响自变量选择对预测的影响可以分为两种情况考虑,第一种情况是全模型正确而误用了选模型;第二种情况是选模型正确而无用了全模型。

以下是这两种情况对回归的影响。

1、全模型正确而误用选模型的情况性质1,在j x 与m p x x ,,1 +的相关系数不全为0时,选模型回归系数的最小二乘估计是全模型相应参数的有偏估计,即jjp jp E βββ≠=)ˆ((p j ,,2,1 =) 性质2,选模型的预测是有偏的。

性质3,选模型的参数估计有较小的方差。

性质4,选模型的预测残差有较小的方差。

性质5,选模型的均方误差比全模型预测的方差更小。

性质1和性质2表明,当全模型正确时,而舍去了m-p 个自变量,用剩下的p 个自变量去建立选模型,参数估计值是全模型相应参数的有偏估计,用其做预测,预测值也是有偏的。

这是误用选模型产生的弊端。

性质3和性质4表明,用选模型去作预测,残差的方差比用全模型去作预测的方差小,尽管用选模型所作的预测是有偏的,但得到的预测残差的方差下降了,这说明尽管全模型正确,误用选模型是有弊也有利的。

性质5说明,即使全模型正确,但如果其中有一些自变量对因变量影响很小或回归系数方差过大,丢掉这些变量之后,用选模型去预测,可以提高预测的精度。

由此可见,如果模型中包含了一些不必要的自变量,模型的预测精度就会下降。

2、选模型正确而误用全模型的情况全模型的预测值是有偏估计;选模型的预测方差小于全模型的预测方差;全模型的预测误差将更大。

一个好的回归模型,并不是考虑的自变量越多越好。

在建立回归模型时,选择自变量的基本知道思想是少而精。

丢掉了一些对因变量y 有影响的自变量后,所付出的代价是估计量产生了有偏性。

然而,尽管估计是有偏的,但预测偏差的方差会下降。

另外,如果保留下来的自变量有些对因变量无关紧要,那么,方程中包括这些变量会导致参数估计和预测的有偏性和精度降低。

因此,在建立实际问题的回归模型时,应尽可能剔除那些可有可无的自变量。

三、所有子集回归1、所有子集的数目设在一个实际问题的回归建模中,有m 个可供选择的变量m x x x ,,,21 ,由于每个自变量都有入选和不入选两种情况,这样y 关于这些自变量的所有可能的回归方程就有m 2-1个,这里-1是要求回归模型中至少包含一个自变量,即减去模型中只包含常数项的这一种情况。

如果把回归模型中只包含常数项的这一种情况也算在内,那么所有可能的回归方程就有m 2个。

从另一个角度看,选模型包含的自变量数目p 有从0到m 共有m+1种不同的情况,而对选模型中恰包含p 个自变量的情况,从全部m 个自变量中选p 个的方法共有线性组合p m C 个,因而所有选模型的数目为:m m m m mC C C 210=+++ 。

2、关于自变量选择的几个准则把选模型的残差平方和记为p SSE ,当再增加一个新的自变量1+p x 时,相应的残差平方和记为1+p SSE 。

根据最小二乘估计的原理,增加自变量时残差平方和将减少,减少自变量时残差平方和将增加。

因此有p p SSE SSE ≤+1,它们的负决定系数分别为:SST SSE R p p 1211++-=,SST SSE R p p -=12,由于SST 是因变量的离差平方和,与自变量无关,因而有221p p R R ≥+,即当自变量子集在扩大时,残差平方和随之减少,而复决定系数2R 随之增大。

因此,如果按残差平方和越小越好的原则来选择自变量子集,或者为提高复决定系数,不论什么变量只要多取就行,则毫无疑问选的变量越多越好。

这样由于变量的多重共线性,给变量的回归系数估计值带来不稳定性,加上变量的测量误差积累,参数数目的增加,将使估计值的误差增大。

因此,从数据与模型拟合优劣的直观考虑出发,认为残差平方和SSE 最小的回归方程就是最好的,还曾用负相关系数R 来衡量回归拟合好坏都不能作为选择变量的准则。

准则一:自由度调整复决定系数达到最大。

当给模型增加自变量时,复决定系数也随之逐步增大,然而复决定系数的增大代价是残差自由度的减少,因为残差自由度等于样本个数与自变量个数之差。

自由度小意味着估计和预测可靠性低。

设)1(11122R p n n R a -----=为自由度调整后的复决定系数,其中,n 为样本容量,p 为自变量的个数。

在实际问题的回归建模中,自由度调整复决定系数2a R 越大,所对应的回归方程越好。

则所有回归子集中2a R 最大者对应的回归方程就是最优方程。

从另外一个角度考虑回归的拟合效果,回归误差项2σ的无偏估计为: SSE p n 11ˆ2--=σ,此无偏估计式中也加入了惩罚因子n-p-1,2ˆσ实际上就是用自由度n-p-1作平均的平均残差平方和。

当自变量个数从0开始增加时,SSE 逐渐减小,作为除数的惩罚因子n-p-1也随之减小。

当自变量个数从0开始增加时,2ˆσ先是开始下降然后稳定下来,当自变量个数增加到一定数量后,2ˆσ又开始增加。

这是因为刚开始时,随着自变量个数增加,SSE 能够快速减小,虽然作为除数的惩罚因子n-p-1也随之减小,但由于SSE 减小的速度更快,因而2ˆσ是趋于减小的。

当自变量数目增加到一定程度,应该说重要的自变量基本上都已经选上了,这时在增加自变量,SSE 减少不多,以至于抵消不了除数n-p-1的减小,最终又导致了2ˆσ的增加。

用平均残差平方和2ˆσ和调整的复决定系数作为自变量选元准则实际上是等价的。

因为有22ˆ11σSSTn R a --=,由于SST 是与回归无关的固定值,因而2a R 与2ˆσ是等价的。

2ˆσ小说明模型好,而2ˆσ小2a R 就会大也说明模型好。

准则二:赤池信息量AIC 达到最小。

设模型的似然函数为),(x L θ,θ的维数为p,x 为随即样本,则AIC 定义为:AIC=-2),ˆ(ln x L L θ+2p,其中Lθˆ为θ的极大似然估计;p 为未知参数的个数,式中右边的第一项是似然函数的对数乘以-2,第二项惩罚因子是未知参数个数的2倍。

似然函数越大估计量越好,现在AIC 是死然数的对数乘以-2再加上惩罚因子2p ,因而选择使AIC 达到最小的模型是最优模型。

在回归分析的建模过程中,对每一个回归子集计算AIC ,其中AIC 最小者所对应的模型是最优回归模型。

准则三:p C 统计量达到最小即使全模型正确,仍有可能选模型有更小的预测误差,p C 正是根据这一原理提出来的。

p C =p n SSE SSE m n m p2)1(+---,其中m SSE m n 11ˆ2--=σ为全模型中2σ的无偏估计。

选择使p C 最小的自变量子集,这个自变量子集对应的回归方程就是最优回归方程。

四、前进法前进法的思想是变量由少到多,每次增加一个,直至没有可引入的变量为止。

具体做法是首先将去全部m 个自变量,分别对因变量y 建立m 个一元线性回归方程,并分别计算这m 个一元回归方程的m 个回归系数的F 检验值,记为{}11211,,,m F F F ,选其最大者记为{}112111,,,max m j F F F F =,给定显著性水平α,若)2,1(1-≥n F F j α,则首先将j x 引入回归方程,为了方便,设j x 就是1x 。

接下来因变量y 分别与(21,x x ),(31,x x ),…,(m x x ,1)建立m-1个二元线性回归方程,对m-1个回归方程中m x x x ,,,32 的回归系数进行F 检验,计算F值,记为{}22322,,,m F F F ,选其最大者记为{}223222,,,max m j F F F F =,若)3,1(2-≥n F F j α,则接着将j x 引入回归方程。

依照上述方法接着做下去,直至所有未被引入方程的自变量的F 值均小于αF (1,n-p-1)时为止,这时,得到的回归方程就是最终确定的方程。

每步检验中的临界值αF (1,n-p-1)与自变量数目p 有关,实际使用当中,通常使用显著性p 值作检验。

五、后退法后退法与前进法相反,首先用全部m 个变量建立一个回归方程,然后在这m 个变量中选择一个最不重要的变量,将它从方程中剔除,即把回归系数检验的F 值最小者对应的自变量剔除。

设对m 个回归系数进行F 检验(偏F 统计量),记求得的F 值为{}m m m m F F F ,,,21 ,选其最小者记为{}m m m m m j F F F F ,,,min 21 =,给定显著性水平α,若)1,1(--≤m n F F m j α,则首先将j x 从回归方程中剔除,为了方便,设j x 就是m x 。

接着对剩下的m-1个自变量重新建立回归方程,进行回归系数的显著性检验,项上面那样计算出1-m j F ,如果又有)1)1(,1(1---≤-m n F F m j α,则剔除j x ,重新建立y 关于m-2个自变量的回归方程,依次下去,直至回归方程中所剩余的p 个自变量的F 检验值均大于临界值αF (1,n-p-1),没有可剔除的自变量为止。

这时,得到的回归方程就是最终确定的方程。

六、前进法和后退法的比较前进法和后退法显然都有明显的不足。

前进法可能存在这样的问题,即不能反映引进新的自变量后的变化情况。

因为某个自变量开始可能是显著的,但当引入其他自变量后它变得并不显著了,但是也没有机会将其剔除,即一旦引入,就是“终身制”的,这种只考虑引入,而没有考虑剔除的做法显然是不全面的。

后退法的明显不足是,一开始把全部自变量引入回归方程,这样计算量很大。

如果有些自变量不太重要,一开始就不引入,就可减少一些计算量;再就是一旦某个自变量被剔除,“一棍子就把它打死了”,再也没有机会重新进入回归方程。

如果问题涉及的自变量m x x x ,,,21 是完全独立的(或不相关),那么在取进α=出α时,前进法与后退法所建立的回归方程是相同的。

然而在实际中很难碰到自变量间真正无关的情况,尤其是经济问题中,所研究的绝大部分问题,自变量间都有一定的相关性。

这就会使得随着回归方程中变量的增加和减少,某些自变量对回归方程的影响也会发生变化。

这是因为自变量间的不同组合,由于它们相关的原因,对因变量y 的影响可能大不一样。

如果几个自变量的联合效应对y 有重要作用,但是单个自变量对y 的作用都不显著,那么前进法就不能引入这几个变量,而后退法却可以保留这几个自变量,这是后退法的一个优点。