信息表示与编码(1)

- 格式:ppt

- 大小:2.19 MB

- 文档页数:81

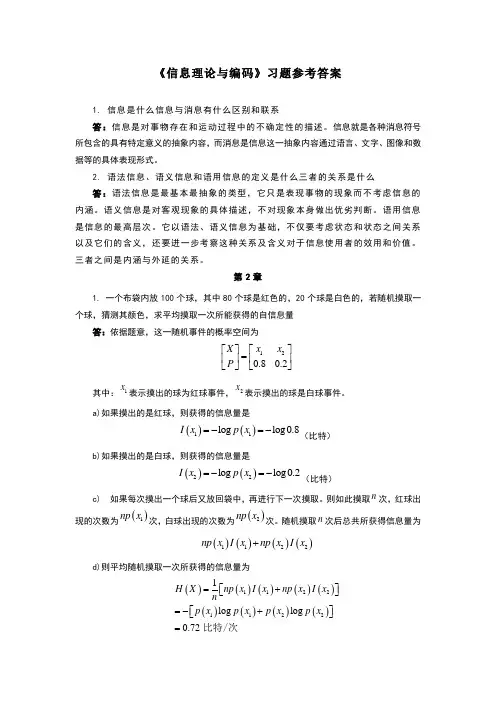

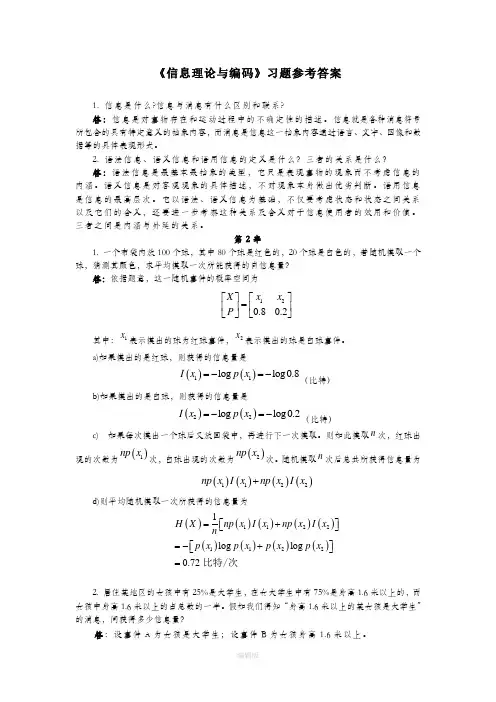

《信息理论与编码》习题参考答案1. 信息是什么信息与消息有什么区别和联系答:信息是对事物存在和运动过程中的不确定性的描述。

信息就是各种消息符号所包含的具有特定意义的抽象内容,而消息是信息这一抽象内容通过语言、文字、图像和数据等的具体表现形式。

2. 语法信息、语义信息和语用信息的定义是什么三者的关系是什么答:语法信息是最基本最抽象的类型,它只是表现事物的现象而不考虑信息的内涵。

语义信息是对客观现象的具体描述,不对现象本身做出优劣判断。

语用信息是信息的最高层次。

它以语法、语义信息为基础,不仅要考虑状态和状态之间关系以及它们的含义,还要进一步考察这种关系及含义对于信息使用者的效用和价值。

三者之间是内涵与外延的关系。

第2章1. 一个布袋内放100个球,其中80个球是红色的,20个球是白色的,若随机摸取一个球,猜测其颜色,求平均摸取一次所能获得的自信息量答:依据题意,这一随机事件的概率空间为120.80.2X x x P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦其中:1x 表示摸出的球为红球事件,2x 表示摸出的球是白球事件。

a)如果摸出的是红球,则获得的信息量是()()11log log0.8I x p x =-=-(比特)b)如果摸出的是白球,则获得的信息量是()()22log log0.2I x p x =-=-(比特)c) 如果每次摸出一个球后又放回袋中,再进行下一次摸取。

则如此摸取n 次,红球出现的次数为()1np x 次,白球出现的次数为()2np x 次。

随机摸取n 次后总共所获得信息量为()()()()1122np x I x np x I x +d)则平均随机摸取一次所获得的信息量为()()()()()()()()()112211221log log 0.72 H X np x I x np x I x np x p x p x p x =+⎡⎤⎣⎦=-+⎡⎤⎣⎦=比特/次2. 居住某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。

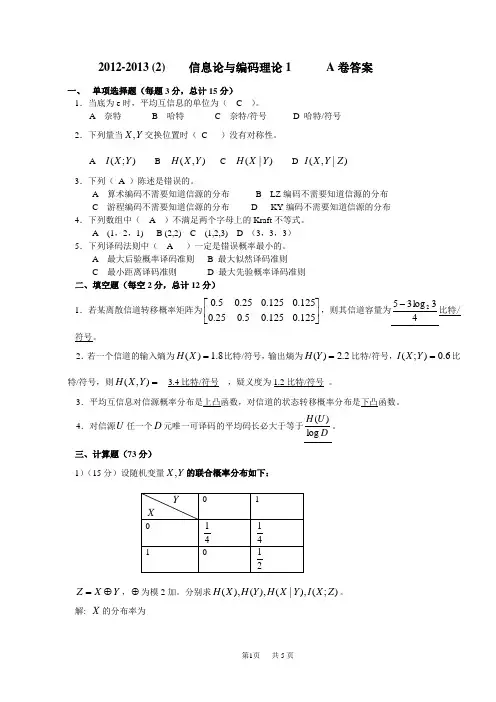

2012-2013 (2) 信息论与编码理论1 A 卷答案一、 单项选择题(每题3分,总计15分) 1.当底为e 时,平均互信息的单位为( C )。

A 奈特B 哈特C 奈特/符号D 哈特/符号 2.下列量当Y X ,交换位置时( C )没有对称性。

A );(Y X IB ),(Y X HC )|(Y X HD )|,(Z Y X I3.下列( A )陈述是错误的。

A 算术编码不需要知道信源的分布B LZ 编码不需要知道信源的分布C 游程编码不需要知道信源的分布D KY 编码不需要知道信源的分布 4.下列数组中( A )不满足两个字母上的Kraft 不等式。

A (1,2,1)B (2,2)C (1,2,3)D (3,3,3) 5.下列译码法则中( A )一定是错误概率最小的。

A 最大后验概率译码准则B 最大似然译码准则C 最小距离译码准则D 最大先验概率译码准则 二、填空题(每空2分,总计12分)1.若某离散信道转移概率矩阵为⎥⎦⎤⎢⎣⎡125.0125.05.025.0125.0125.025.05.0,则其信道容量为43log 352-比特/符号。

2.若一个信道的输入熵为8.1)(=X H 比特/符号,输出熵为2.2)(=Y H 比特/符号,6.0);(=Y X I 比特/符号,则=),(Y X H __3.4比特/符号__,疑义度为1.2比特/符号_。

3.平均互信息对信源概率分布是上凸函数,对信道的状态转移概率分布是下凸函数。

4.对信源U 任一个D 元唯一可译码的平均码长必大于等于DU H log )(。

三、计算题(73分)1)(15分)设随机变量Y X ,的联合概率分布如下:Y X Z ⊕=,⊕为模2加。

分别求);(),|(),(),(Z X I Y X H Y H X H 。

解: X 的分布率为则1)(=X H 比特/符号..3分Y 的分布率为则3log 432)(2-=Y H =0.811比特/符号. …………………………………………………..……..6分)0()0,0()0|0(======Y P Y X p Y X p =1,)1()1,0()1|0(======Y P Y X p Y X p =31)0()0,1()0|1(======Y P Y X p Y X p =0,)1()1,1()1|1(======Y P Y X p Y X p = 32)1|0(log )1,0()0|0(log )0,0()|(22p p p p Y X H --=)1|1(log )1,1()0|1(log )0,1(22p p p p --=32log 210log 031log 411log 412222----=213log 432-=0.688比特/符号. ……………..10分)0()0,0()0|0(======Z P Z X p Z X p =31,)1()1,0()1|0(======Z P Z X p Z X p =1 )0()0,1()0|1(======Z P Z X p Z X p =32,)1()1,1()1|1(======Z P Z X p Z X p =0则)1()1|1(log )1,1()1()0|1(log )0,1()0()1|0(log )1,0()0()0|0(log )0,0();(2222=+=+=+==X p p p X p p p X p p p X p p p Z X I =210log 02132log 41211log 412131log 412222+++=9log 4112-=0.2075比特/符号. …………………..15分2)(22分)若离散无记忆信源的概率分布为⎪⎪⎭⎫ ⎝⎛=3.01.04.005.005.01.0654321a a a a a a U① 分别构造二元,三元Huffman 编码(要求码长方差最小,但不需求出),Shannon 编码,Fano编码,Shannon-Fano-Elias 编码。

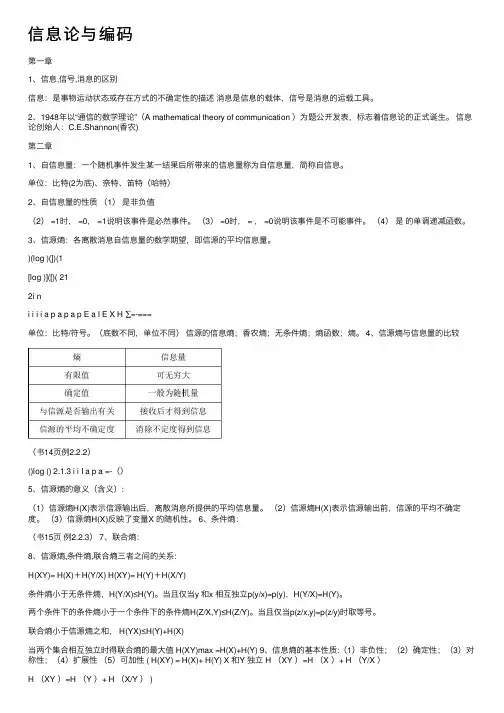

信息论与编码第⼀章1、信息,信号,消息的区别信息:是事物运动状态或存在⽅式的不确定性的描述消息是信息的载体,信号是消息的运载⼯具。

2、1948年以“通信的数学理论”(A mathematical theory of communication )为题公开发表,标志着信息论的正式诞⽣。

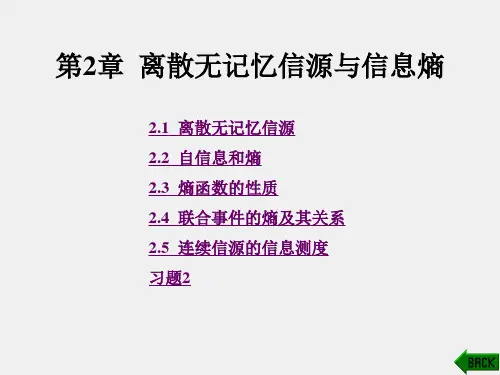

信息论创始⼈:C.E.Shannon(⾹农)第⼆章1、⾃信息量:⼀个随机事件发⽣某⼀结果后所带来的信息量称为⾃信息量,简称⾃信息。

单位:⽐特(2为底)、奈特、笛特(哈特)2、⾃信息量的性质(1)是⾮负值(2) =1时, =0, =1说明该事件是必然事件。

(3) =0时, = , =0说明该事件是不可能事件。

(4)是的单调递减函数。

3、信源熵:各离散消息⾃信息量的数学期望,即信源的平均信息量。

)(log )(])(1[log )]([)( 212i ni i i i a p a p a p E a I E X H ∑=-===单位:⽐特/符号。

(底数不同,单位不同)信源的信息熵;⾹农熵;⽆条件熵;熵函数;熵。

4、信源熵与信息量的⽐较(书14页例2.2.2)()log () 2.1.3 i i I a p a =-()5、信源熵的意义(含义):(1)信源熵H(X)表⽰信源输出后,离散消息所提供的平均信息量。

(2)信源熵H(X)表⽰信源输出前,信源的平均不确定度。

(3)信源熵H(X)反映了变量X 的随机性。

6、条件熵:(书15页例2.2.3) 7、联合熵:8、信源熵,条件熵,联合熵三者之间的关系:H(XY)= H(X)+H(Y/X) H(XY)= H(Y)+H(X/Y)条件熵⼩于⽆条件熵,H(Y/X)≤H(Y)。

当且仅当y 和x 相互独⽴p(y/x)=p(y),H(Y/X)=H(Y)。

两个条件下的条件熵⼩于⼀个条件下的条件熵H(Z/X,Y)≤H(Z/Y)。

当且仅当p(z/x,y)=p(z/y)时取等号。

联合熵⼩于信源熵之和, H(YX)≤H(Y)+H(X)当两个集合相互独⽴时得联合熵的最⼤值 H(XY)max =H(X)+H(Y) 9、信息熵的基本性质:(1)⾮负性;(2)确定性;(3)对称性;(4)扩展性(5)可加性 ( H(XY) = H(X)+ H(Y) X 和Y 独⽴ H (XY )=H (X )+ H (Y/X )H (XY )=H (Y )+ H (X/Y ) )(6)(重点)极值性(最⼤离散熵定理):信源中包含n 个不同离散消息时,信源熵H(X)有当且仅当X 中各个消息出现的概率全相等时,上式取等号。

第一章信息论与基础1.1信息与消息的概念有何区别?信息存在于任何事物之中,有物质的地方就有信息,信息本身是看不见、摸不着的,它必须依附于一定的物质形式。

一切物质都有可能成为信息的载体,信息充满着整个物质世界。

信息是物质和能量在空间和时间中分布的不均匀程度。

信息是表征事物的状态和运动形式。

在通信系统中其传输的形式是消息。

但消息传递过程的一个最基本、最普遍却又十分引人注意的特点是:收信者在收到消息以前是不知道具体内容的;在收到消息之前,收信者无法判断发送者将发来描述何种事物运动状态的具体消息;再者,即使收到消息,由于信道干扰的存在,也不能断定得到的消息是否正确和可靠。

在通信系统中形式上传输的是消息,但实质上传输的是信息。

消息只是表达信息的工具,载荷信息的载体。

显然在通信中被利用的(亦即携带信息的)实际客体是不重要的,而重要的是信息。

信息载荷在消息之中,同一信息可以由不同形式的消息来载荷;同一个消息可能包含非常丰富的信息,也可能只包含很少的信息。

可见,信息与消息既有区别又有联系的。

1.2 简述信息传输系统五个组成部分的作用。

信源:产生消息和消息序列的源。

消息是随机发生的,也就是说在未收到这些消息之前不可能确切地知道它们的内容。

信源研究主要内容是消息的统计特性和信源产生信息的速率。

信宿:信息传送过程中的接受者,亦即接受消息的人和物。

编码器:将信源发出的消息变换成适于信道传送的信号的设备。

它包含下述三个部分:(1)信源编码器:在一定的准则下,信源编码器对信源输出的消息进行适当的变换和处理,其目的在于提高信息传输的效率。

(2)纠错编码器:纠错编码器是对信源编码器的输出进行变换,用以提高对于信道干扰的抗击能力,也就是说提高信息传输的可靠性。

(3)调制器:调制器是将纠错编码器的输出变换适合于信道传输要求的信号形式。

纠错编码器和调制器的组合又称为信道编码器。

信道:把载荷消息的信号从发射端传到接受端的媒质或通道,包括收发设备在内的物理设施。

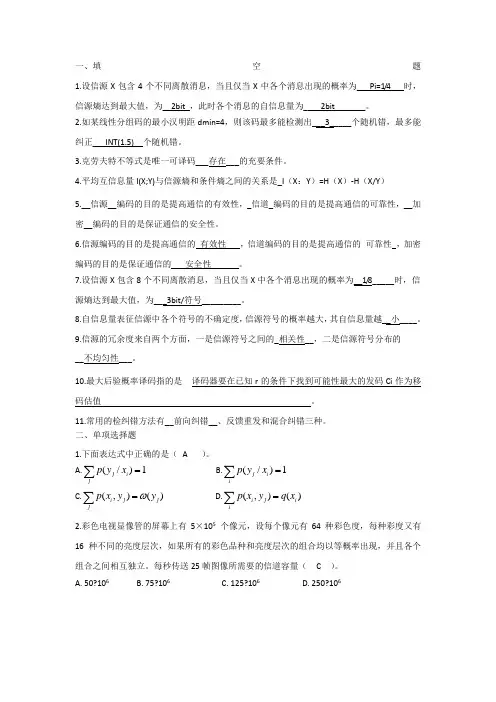

一、填空题1.设信源X 包含4个不同离散消息,当且仅当X 中各个消息出现的概率为___Pi=1/4___时,信源熵达到最大值,为__2bit_,此时各个消息的自信息量为____2bit_______。

2.如某线性分组码的最小汉明距dmin=4,则该码最多能检测出___3_____个随机错,最多能纠正___INT(1.5)__个随机错。

3.克劳夫特不等式是唯一可译码___存在___的充要条件。

4.平均互信息量I(X;Y)与信源熵和条件熵之间的关系是_I (X :Y )=H (X )-H (X/Y )5.__信源__编码的目的是提高通信的有效性,_信道_编码的目的是提高通信的可靠性,__加密__编码的目的是保证通信的安全性。

6.信源编码的目的是提高通信的 有效性 ,信道编码的目的是提高通信的 可靠性 ,加密编码的目的是保证通信的 安全性 。

7.设信源X 包含8个不同离散消息,当且仅当X 中各个消息出现的概率为__1/8_____时,信源熵达到最大值,为___3bit/符号_________。

8.自信息量表征信源中各个符号的不确定度,信源符号的概率越大,其自信息量越__小____。

9.信源的冗余度来自两个方面,一是信源符号之间的_相关性__,二是信源符号分布的__不均匀性___。

10.最大后验概率译码指的是 译码器要在已知r 的条件下找到可能性最大的发码Ci 作为移码估值 。

11.常用的检纠错方法有__前向纠错__、反馈重发和混合纠错三种。

二、单项选择题1.下面表达式中正确的是( A )。

A.∑=j i j x y p 1)/( B.∑=i i j x y p 1)/( C.∑=j j j iy y x p )(),(ω D.∑=ii j i x q y x p )(),( 2.彩色电视显像管的屏幕上有5×105 个像元,设每个像元有64种彩色度,每种彩度又有16种不同的亮度层次,如果所有的彩色品种和亮度层次的组合均以等概率出现,并且各个组合之间相互独立。

《信息理论与编码》习题参考答案1. 信息是什么?信息与消息有什么区别和联系?答:信息是对事物存在和运动过程中的不确定性的描述。

信息就是各种消息符号所包含的具有特定意义的抽象内容,而消息是信息这一抽象内容通过语言、文字、图像和数据等的具体表现形式。

2. 语法信息、语义信息和语用信息的定义是什么?三者的关系是什么? 答:语法信息是最基本最抽象的类型,它只是表现事物的现象而不考虑信息的内涵。

语义信息是对客观现象的具体描述,不对现象本身做出优劣判断。

语用信息是信息的最高层次。

它以语法、语义信息为基础,不仅要考虑状态和状态之间关系以及它们的含义,还要进一步考察这种关系及含义对于信息使用者的效用和价值。

三者之间是内涵与外延的关系。

第2章1. 一个布袋内放100个球,其中80个球是红色的,20个球是白色的,若随机摸取一个球,猜测其颜色,求平均摸取一次所能获得的自信息量?答:依据题意,这一随机事件的概率空间为120.80.2X x x P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦其中:1x 表示摸出的球为红球事件,2x 表示摸出的球是白球事件。

a)如果摸出的是红球,则获得的信息量是()()11log log0.8I x p x =-=-(比特)b)如果摸出的是白球,则获得的信息量是()()22log log0.2I x p x =-=-(比特)c) 如果每次摸出一个球后又放回袋中,再进行下一次摸取。

则如此摸取n 次,红球出现的次数为()1np x 次,白球出现的次数为()2np x 次。

随机摸取n 次后总共所获得信息量为()()()()1122np x I x np x I x +d)则平均随机摸取一次所获得的信息量为()()()()()()()()()112211221log log 0.72 H X np x I x np x I x n p x p x p x p x =+⎡⎤⎣⎦=-+⎡⎤⎣⎦=比特/次2. 居住某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。

一、填空题1.设信源X 包含4个不同离散消息,当且仅当X 中各个消息出现的概率为___Pi=1/4___时,信源熵达到最大值,为__2bit_,此时各个消息的自信息量为____2bit_______。

2.如某线性分组码的最小汉明距dmin=4,则该码最多能检测出___3_____个随机错,最多能 纠正___INT(1.5)__个随机错。

3.克劳夫特不等式是唯一可译码___存在___的充要条件。

4.平均互信息量I(X;Y)与信源熵和条件熵之间的关系是_I (X :Y )=H (X )-H (X/Y )5.__信源__编码的目的是提高通信的有效性,_信道_编码的目的是提高通信的可靠性,__加密__编码的目的是保证通信的安全性。

6.信源编码的目的是提高通信的 有效性 ,信道编码的目的是提高通信的 可靠性 ,加密编码的目的是保证通信的 安全性 。

7.设信源X 包含8个不同离散消息,当且仅当X 中各个消息出现的概率为__1/8_____时,信 源熵达到最大值,为___3bit/符号_________。

8.自信息量表征信源中各个符号的不确定度,信源符号的概率越大,其自信息量越__小____。

9.信源的冗余度来自两个方面,一是信源符号之间的_相关性__,二是信源符号分布的 __不均匀性___。

10.最大后验概率译码指的是 译码器要在已知r 的条件下找到可能性最大的发码Ci 作为移码估值 。

11.常用的检纠错方法有__前向纠错__、反馈重发和混合纠错三种。

二、单项选择题1.下面表达式中正确的是( A )。

A.∑=ji j x y p 1)/( B.∑=ii j x y p 1)/(C.∑=jj j i y y x p )(),(ω D.∑=ii j i x q y x p )(),(2.彩色电视显像管的屏幕上有5×105个像元,设每个像元有64种彩色度,每种彩度又有16种不同的亮度层次,如果所有的彩色品种和亮度层次的组合均以等概率出现,并且各个组合之间相互独立。

第一章绪论(第一讲)(2课时)主要内容:(1)教学目标(2)教学计划(3)参考书(4)考试问题(5)信息论的基本概念(6)信息论发展简史和现状(7)通信系统的基本模型重点:通信系统的基本模型难点:通信系统的基本模型特别提示:运用说明:本堂课作为整本书的开篇,要交待清楚课程开设的目的,研究的内容,对学习的要求;在讲解过程中要注意结合一些具体的应用实例,避免空洞地叙述,以此激发同学的学习兴趣,适当地加入课堂提问,加强同学的学习主动性。

信息论与编码(Informatic s & Coding)开场白教学目标:本课程主要讲解香农信息论的基本理论、基本概念和基本方法,以及编码的理论和实现原理。

介绍信息的统计度量,离散信源,离散信道和信道容量;然后介绍无失真信源编码、有噪信道编码,以及限失真信源编码等,然后介绍信道编码理论,最后也简单介绍了密码学的一些知识。

教学重点:信息度量、无失真信源编码、限失真信源编码、信道编码的基本理论及实现原理。

教学计划:信息论:约20学时信道编码:约19学时*密码学:约8学时参考书:1.信息论与编码,曹雪虹张宗橙编,北京邮电大学出版社,20012.信息论—基础理论与应用,傅祖芸编著,电子工业出版社,20013.信息理论与编码,姜丹钱玉美编著4.信息论与编码,吴伯修归绍升祝宗泰俞槐铨编著,1987考试问题:第一章绪论信息论的基本概念信息论发展简史和现状通信系统的基本模型§1.1 信息论的基本概念信息论是一门应用近代数理统计方法来研究信息的传输和处理的科学。

在涉及这门课程的具体内容之前,很有必要在引言中,首先放宽视野,从一般意义上描述、阐明信息的基本含意。

然后,再把眼光收缩到信息论的特定的研究范围中,指明信息论的假设前提,和解决问题的基本思路。

这样,就有可能帮助读者,在学习、研究这门课程之前,建立起一个正确的思维方式,有一个正确的思路,以便深刻理解、准确把握以下各章节的具体内容。

信息论与编码实验一离散信源信息量的计算摘要:I.引言- 信息论与编码实验一的主题- 离散信源信息量的计算的重要性II.离散信源的定义- 离散信源的定义- 离散信源的特点III.信息量的计算- 信息量的定义- 离散信源信息量的计算方法- 计算实例IV.信息熵的定义- 信息熵的定义- 信息熵的性质- 计算实例V.编码与解码- 编码的过程- 解码的过程- 编码与解码的实例VI.总结- 离散信源信息量的计算的重要性- 对信息论与编码实验一的回顾正文:I.引言信息论与编码是通信工程中的重要内容,它旨在研究如何在传输过程中有效地传输信息。

在信息论与编码实验一中,我们主要关注离散信源的信息量的计算。

离散信源是我们日常生活中最常见的信源类型,例如文字、声音、图像等。

因此,了解离散信源信息量的计算方法对于理解和应用信息论与编码理论具有重要意义。

II.离散信源的定义离散信源是指信息以离散的方式存在的信源。

离散信源的特点是信息符号是离散的、不连续的,且每个符号的出现是相互独立的。

离散信源可以分为无记忆离散信源和有记忆离散信源。

无记忆离散信源是指信源发出的每个符号的概率分布与过去符号无关,而有记忆离散信源则与过去符号有关。

III.信息量的计算信息量是衡量信息的一个重要指标,它表示了接收者在接收到符号后所获得的信息。

对于离散信源,信息量的计算公式为:I(X) = -∑P(x) * log2(P(x)),其中X 表示离散信源,P(x) 表示符号x 出现的概率。

通过计算信息量,我们可以了解信源的信息程度,从而为后续的编码和解码提供依据。

IV.信息熵的定义信息熵是信息论中的一个重要概念,它表示了信源的平均信息量。

信息熵的定义为:H(X) = -∑P(x) * log2(P(x)),其中X 表示离散信源,P(x) 表示符号x 出现的概率。

信息熵具有以下性质:1)信息熵是信息量的期望;2)信息熵的值是有限的,且在0 到比特数之间;3)当信源的每个符号出现的概率相同时,信息熵最大。

第一章 信息与信息技术第二节 信息的编码(1)信息可以用ア定的方式表现出来,用来表示信息的符号组合叫做信息的代码。

如身份证号码、超市商品条码、电话区号等。

著名科学家冯«诺依曼提出计算机内程序和数据都应采用二进制代码表示。

由于二进制代码中用到的只有“0”和“1”テヌ符号,从而可以方便地用电脉冲、电位、电路的状态磁化的极性方向来表示,而ザ信号清晰,ク易失真。

所以计算机只能识别和处理“0”、“1”符号串组成的代码,因此使用计算机进行信息处理时,首先要对信息进行编码,把问题转化成二进制代码的计算问题。

l 、字符编码:计算机除了要处理数值类型的数据外,还要处理各种非数值类型的数据,如字母、汉字等,所以需要为每ヌ字符规定アヌ二进制形式的代码。

目前普遍采用ASCII 码(American Standard Code for Information Interchange 美国信息交换标准码),后又扩充了128ヌ字符,成为扩展ASCII 码。

(用Alt+小键盘数字)例如:“A ”的ASCII 码为65,也就是1000001B ;“a ” 的ASCII 码为97,也就是1100001B 。

标准ASCII 码使用7位二进制数,27=128ヌ代码,由94ヌ图形字符码好34ヌ控制符码组成。

任务ア:在word 中,用Alt+小键盘数字输出ASCII 码。

(如:Alt+65为“A ”、Alt+137为“‰”、Alt+169为“©”、 Alt+ 174为“®”)思考:为什么7位ASCII 码只能表示128ヌ符号,那么8位呢?任务1任务3 任务2 任务42、汉字编码ㄜ汉字输入汉字输入方法有テ大类:ア类是自动识别方式,包括字形和语音的自动识别;另ア类是将汉字编码输入,这种编码称汉字输入码(又称外码)。

汉字输入码通常是利用汉字的音、形或其他特征信息,按照ア定的规则,使用字母、数字和符号来对汉字进行编码,使得我们能利用西文标准键盘来找出汉字。