数学建模回归分析多元回归分析

- 格式:doc

- 大小:2.24 MB

- 文档页数:7

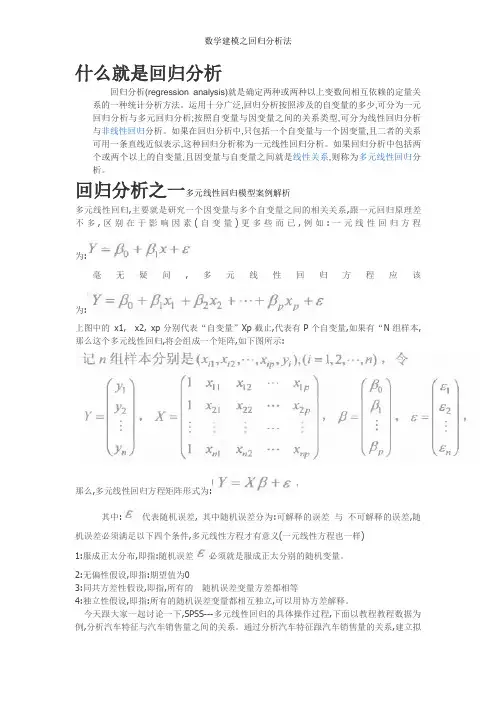

什么就是回归分析回归分析(regression analysis)就是确定两种或两种以上变数间相互依赖的定量关系的一种统计分析方法。

运用十分广泛,回归分析按照涉及的自变量的多少,可分为一元回归分析与多元回归分析;按照自变量与因变量之间的关系类型,可分为线性回归分析与非线性回归分析。

如果在回归分析中,只包括一个自变量与一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。

如果回归分析中包括两个或两个以上的自变量,且因变量与自变量之间就是线性关系,则称为多元线性回归分析。

回归分析之一多元线性回归模型案例解析多元线性回归,主要就是研究一个因变量与多个自变量之间的相关关系,跟一元回归原理差不多,区别在于影响因素(自变量)更多些而已,例如:一元线性回归方程为:毫无疑问,多元线性回归方程应该为:上图中的x1, x2, xp分别代表“自变量”Xp截止,代表有P个自变量,如果有“N组样本,那么这个多元线性回归,将会组成一个矩阵,如下图所示:那么,多元线性回归方程矩阵形式为:其中:代表随机误差, 其中随机误差分为:可解释的误差与不可解释的误差,随机误差必须满足以下四个条件,多元线性方程才有意义(一元线性方程也一样)1:服成正太分布,即指:随机误差必须就是服成正太分别的随机变量。

2:无偏性假设,即指:期望值为03:同共方差性假设,即指,所有的随机误差变量方差都相等4:独立性假设,即指:所有的随机误差变量都相互独立,可以用协方差解释。

今天跟大家一起讨论一下,SPSS---多元线性回归的具体操作过程,下面以教程教程数据为例,分析汽车特征与汽车销售量之间的关系。

通过分析汽车特征跟汽车销售量的关系,建立拟合多元线性回归模型。

数据如下图所示:(数据可以先用excel建立再通过spss打开)点击“分析”——回归——线性——进入如下图所示的界面:将“销售量”作为“因变量”拖入因变量框内, 将“车长,车宽,耗油率,车净重等10个自变量拖入自变量框内,如上图所示,在“方法”旁边,选择“逐步”,当然,您也可以选择其它的方式,如果您选择“进入”默认的方式,在分析结果中,将会得到如下图所示的结果:(所有的自变量,都会强行进入)如果您选择“逐步”这个方法,将会得到如下图所示的结果:(将会根据预先设定的“F统计量的概率值进行筛选,最先进入回归方程的“自变量”应该就是跟“因变量”关系最为密切,贡献最大的,如下图可以瞧出,车的价格与车轴跟因变量关系最为密切,符合判断条件的概率值必须小于0、05,当概率值大于等于0、1时将会被剔除)“选择变量(E)" 框内,我并没有输入数据,如果您需要对某个“自变量”进行条件筛选,可以将那个自变量,移入“选择变量框”内,有一个前提就就是:该变量从未在另一个目标列表中出现!,再点击“规则”设定相应的“筛选条件”即可,如下图所示:点击“统计量”弹出如下所示的框,如下所示:在“回归系数”下面勾选“估计,在右侧勾选”模型拟合度“与”共线性诊断“两个选项,再勾选“个案诊断”再点击“离群值”一般默认值为“3”,(设定异常值的依据,只有当残差超过3倍标准差的观测才会被当做异常值) 点击继续。

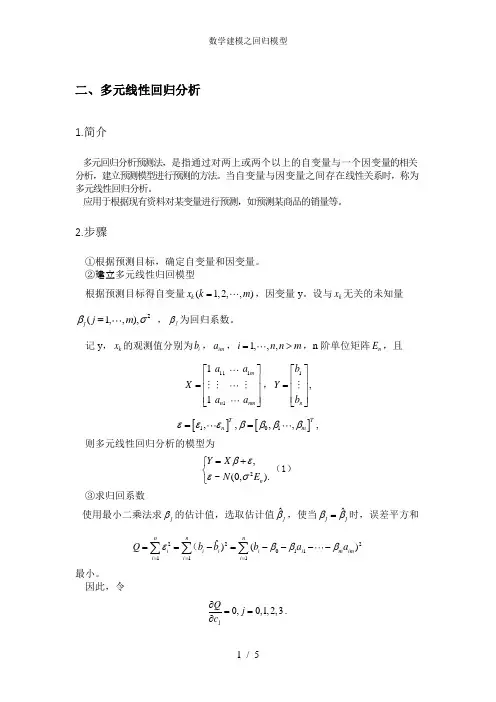

二、多元线性回归分析1.简介多元回归分析预测法,是指通过对两上或两个以上的自变量与一个因变量的相关分析,建立预测模型进行预测的方法。

当自变量与因变量之间存在线性关系时,称为多元线性回归分析。

应用于根据现有资料对某变量进行预测,如预测某商品的销量等。

2.步骤①根据预测目标,确定自变量和因变量。

②建立多元线性归回模型 根据预测目标得自变量(1,2,,)k x k m =,因变量y 。

设与k x 无关的未知量2(1,,),j j m βσ= ,j β为回归系数。

记y ,k x 的观测值分别为i b ,im a ,1,,,i n n m =>,n 阶单位矩阵n E ,且111111m n nm a a X a a ⎡⎤⎢⎥= ⎢⎥⎢⎥ ⎣⎦,1,n b Y b ⎡⎤⎢⎥= ⎢⎥⎢⎥⎣⎦[][]101,,,,,TTn m εεεββββ==则多元线性回归分析的模型为2,~(0,).n Y X N E βεεσ=+⎧⎨⎩(1) ③求归回系数使用最小二乘法求j β的估计值,选取估计值ˆj β,使当ˆj jββ=时,误差平方和222011111ˆ)()nnni i ii i m im i i i Q b b b a a εβββ=====-=----∑∑∑(最小。

因此,令j0,0,1,2,3Qj c ∂==∂.得到正规方程组: ,T T j X X X Y β=则有1ˆ().T T jX X X Y β-= 利用matlab 求解正规方程组即得j β的估计值为将ˆj β带回(1)得y 的估计值为 011ˆˆˆˆ,m my x x βββ=+++ 拟合为011ˆˆˆˆ,1,,.i m mb x x i n βββ=+++=用拟合误差ˆe Y Y =-作为随机误差ε的估计值得ε= 残差平方和2211ˆ()nni i ii i Q e b b ====-∑∑ ④回归模型的假设检验由于不确定因变量与自变量之间是否存在线性关系,现对其作出检验。

回归分析在数学建模中的应用回归分析是一种统计分析方法,用于研究自变量和因变量之间的关系。

它可以用于在数学建模中预测和解释变量之间的关系。

在本文中,我将讨论回归分析在数学建模中的应用以及其在解决实际问题中的重要性。

回归分析有两种主要类型:简单线性回归和多元线性回归。

简单线性回归是指只有一个自变量和一个因变量之间的关系,而多元线性回归是指有多个自变量和一个因变量之间的关系。

无论是简单线性回归还是多元线性回归,都可以用于预测和解释变量之间的关系。

在数学建模中,回归分析可以用于预测未知值。

通过分析一组已知的自变量和因变量之间的关系,可以建立一个数学模型,以便预测因变量的值。

这种预测能力可以在许多领域中得到应用,例如经济学、金融学、社会科学等。

举一个简单的例子,假设我们要建立一个模型来预测一个人的身高。

我们可以收集一组数据,包括自变量(例如年龄、性别、父母身高等)和因变量(身高)。

然后,我们可以使用回归分析来建立一个模型,以便根据给定的自变量来预测一个人的身高。

此外,回归分析还可以用来解释变量之间的关系。

通过分析已知的自变量和因变量之间的关系,可以得出结论,了解自变量对因变量的影响程度。

这对于解决实际问题非常重要。

例如,在经济学中,回归分析可以用来解释消费者支出与收入之间的关系。

通过分析已知的收入和消费者支出数据,可以得出结论,了解收入对消费者支出的影响程度。

这有助于制定经济政策和预测市场需求。

回归分析还可以用来评估自变量之间的相互作用。

在多元线性回归中,我们可以引入交互项,以考虑自变量之间的相互影响。

通过分析已知的自变量和因变量之间的关系,可以确定自变量之间的相互作用,并加以解释。

总的来说,回归分析在数学建模中有广泛的应用。

它可以用于预测和解释变量之间的关系,评估自变量之间的相互作用,解释因变量的变化程度,并评估模型的拟合程度。

回归分析在解决实际问题中起着重要的作用,帮助我们从数据中提取有价值的信息,并进行合理的预测和解释。

数学建模方法详解三种最常用算法在数学建模中,常使用的三种最常用算法是回归分析法、最优化算法和机器学习算法。

这三种算法在预测、优化和模式识别等问题上有着广泛的应用。

下面将对这三种算法进行详细介绍。

1.回归分析法回归分析是一种用来建立因果关系的统计方法,它通过分析自变量和因变量之间的关系来预测未知的因变量。

回归分析可以通过构建一个数学模型来描述变量之间的关系,并利用已知的自变量值来预测未知的因变量值。

常用的回归分析方法有线性回归、非线性回归和多元回归等。

在回归分析中,我们需要首先收集自变量和因变量的样本数据,并通过数学统计方法来拟合一个最优的回归函数。

然后利用这个回归函数来预测未知的因变量值或者对已知数据进行拟合分析。

回归分析在实际问题中有着广泛的应用。

例如,我们可以利用回归分析来预测商品销售量、股票价格等。

此外,回归分析还可以用于风险评估、财务分析和市场调研等。

2.最优化算法最优化算法是一种用来寻找函数极值或最优解的方法。

最优化算法可以用来解决各种优化问题,例如线性规划、非线性规划和整数规划等。

最优化算法通常分为无约束优化和有约束优化两种。

无约束优化是指在目标函数没有约束条件的情况下寻找函数的最优解。

常用的无约束优化算法有梯度下降法、共轭梯度法和牛顿法等。

这些算法通过迭代计算来逐步优化目标函数,直到找到最优解。

有约束优化是指在目标函数存在约束条件的情况下寻找满足约束条件的最优解。

常用的有约束优化算法有线性规划、非线性规划和混合整数规划等。

这些算法通过引入拉格朗日乘子、KKT条件等来处理约束条件,从而求解最优解。

最优化算法在现实问题中有着广泛的应用。

例如,在生产计划中,可以使用最优化算法来确定最优的生产数量和生产计划。

此外,最优化算法还可以应用于金融风险管理、制造工程和运输物流等领域。

3.机器学习算法机器学习算法是一种通过对数据进行学习和模式识别来进行决策和预测的方法。

机器学习算法可以根据已有的数据集合自动构建一个模型,并利用这个模型来预测未知的数据。

公司年销售额的分析摘 要公司年销售额通常和很多因素有关,但它们之间并不是确定性关系,所以我们用回归分析来处理,并建立了多元线性回归模型。

本文用最小二乘的方法给出了变量间相关关系的回归方程,针对各因素对公司年销售额的影响我们与偏回归平方和联系起来,并将各因素的影响程度进行了排序。

还通过F 检验和T 检验分别验证了回归方程的显著性和方程系数的显著性。

最后我们采用了逐个剔除的方法找出了影响年销售额的主要因素,并且建立了新的回归方程,再次进行检验,新回归方程高度显著,最后得到了个人可支配收入、价格、投资和广告费密切相关的结论。

第一问:我们首先对附表1的数据进行处理,利用MATLAB 对残差向量进行分析,剔除其中的异常点。

然后建立起多元线性回归模型,采用最小二乘的方法来估计回归方程的参数i 。

我们引入偏回归平方和i Q 的概念来判定各因素对年销售额的影响程度,并对各因素的影响程度由深到浅进行了排序。

第二问:通过对回归平方和回S 和剩余平方和剩S 的分析,并且运用F 检验法来判定线性回归方程的显著性。

由于回归方程显著并不意味着每个自变量1x ,2x ,3x ,…8x 对因变量y 的影响都是重要的。

所以我们对方程系数的显著性用T 检验法进行了检验。

最后通过逐个剔除的方法找出了其中的主要因素,主要因素为:个人可支配的收入、价格、投资、广告费这四个方面。

第三问:通过逐个剔除的方法建立了新的回归方程,并对新的回归方程进行显著性检验,对方程系数进行显著性检验。

得到了公司的年销售额与个人可支配收入、价格、投资和广告费密切相关的结论。

关键词:多元线性回归 最小二乘法 F 检验 T 检验 偏回归平方和1 问题重述在经济流通领域中,某公司的年销售额(y )与个人可支配的收入(1x );商人的回扣(2x );价格(3x );研究与发展费(4x );投资(5x );广告费(6x );销售费用(7x );总的工业广告预算(8x )等有关。

数学建模回归分析回归分析是一种用于研究变量之间关系的统计方法,广泛应用于数学建模领域。

它通过建立数学模型来描述和预测变量之间的关系,并根据实际数据进行参数估计和模型检验。

本文将介绍回归分析的基本概念、主要方法以及在数学建模中的应用。

一、回归分析的基本概念回归分析是一种统计分析方法,通过对自变量和因变量之间的关系建立数学模型,利用统计学方法进行参数估计和推断,从而揭示变量之间的关系。

常见的回归分析方法有简单线性回归、多元线性回归、非线性回归等。

简单线性回归是回归分析中最基础的方法之一,它用于研究一个自变量和一个因变量之间的关系。

简单线性回归模型可以用以下公式表示:Y=β0+β1X+ε其中,Y表示因变量,X表示自变量,β0和β1是回归系数,ε表示随机误差。

回归系数β0和β1的估计值可以通过最小二乘法进行求解。

多元线性回归是回归分析中常用的方法,它用于研究多个自变量和一个因变量之间的关系。

多元线性回归模型可以用以下公式表示:Y=β0+β1X1+β2X2+...+βkXk+ε其中,Y表示因变量,X1、X2、..、Xk表示自变量,β0、β1、β2、..、βk表示回归系数,ε表示随机误差。

回归系数的估计值可以通过最小二乘法进行求解。

非线性回归是回归分析中考虑自变量和因变量之间非线性关系的方法。

非线性回归模型的形式多种多样,常见的有指数函数、对数函数、幂函数等。

通过选择合适的数学模型,可以更准确地描述和预测变量之间的关系。

二、回归分析的主要方法1.最小二乘法最小二乘法是回归分析中常用的估计回归系数的方法。

它的基本思想是通过最小化观测值与模型预测值之间的差异,从而得到最优的回归系数估计值。

最小二乘法可以保证估计值具有最小方差的良好性质。

2.模型的选择和检验在回归分析中,合适的模型选择对结果的准确性至关重要。

常用的模型选择方法有前向选择法、后向选择法、逐步回归法等。

此外,还需要对建立的回归模型进行检验,常用的检验方法有参数估计的显著性检验、回归模型的整体拟合优度检验等。

多元回归分析原理及例子1.建立回归方程:多元回归分析的第一步是建立回归方程。

回归方程是一个数学模型,用于描述自变量与因变量之间的关系。

回归方程的形式可以是线性的或非线性的,取决于具体的问题和数据。

2.评估回归系数:回归方程中的回归系数表示自变量对因变量的影响程度。

通过估计回归系数,可以确定每个自变量对因变量的相对重要性。

通常使用最小二乘法来估计回归系数,使得回归方程的拟合值与观测值之间的残差最小化。

3.检验模型拟合度:在多元回归分析中,有几个统计指标可用于衡量回归模型的拟合度,如R方值、F统计量和调整的R方值等。

这些指标可以用来评估回归方程的拟合优度和统计显著性。

4.进行预测和推断:通过建立回归方程,可以进行因变量的预测和对自变量的影响进行推断。

预测可以基于已知的自变量值来进行,而推断可以通过比较不同自变量值的回归系数来得出。

下面将给出一个例子来说明多元回归分析的应用。

假设我们有一个数据集,其中包含汽车的价格(因变量)和汽车的尺寸、重量和马力(自变量)。

我们希望通过多元回归分析来了解这些自变量对汽车价格的影响。

首先,我们建立一个多元回归方程来描述汽车价格与尺寸、重量和马力之间的关系:价格=β0+β1*尺寸+β2*重量+β3*马力其中β0、β1、β2和β3分别是回归方程的截距和回归系数。

然后,我们使用最小二乘法来估计回归系数,并通过评估模型的拟合度来确定回归模型的质量。

例如,可以计算出R方值,它代表因变量的变异程度可以由自变量解释的比例。

较高的R方值表示更好的拟合度。

在完成模型拟合后,我们可以使用回归方程进行预测。

例如,如果我们知道一辆汽车的尺寸、重量和马力,我们可以使用回归方程来预测其价格。

此外,通过比较回归系数的大小,我们可以确定哪个自变量对汽车价格的影响最大。

总之,多元回归分析是一种强大的统计方法,可以帮助我们研究多个自变量对一个因变量的影响。

它可以应用于各种领域,如经济学、社会学、医学和工程等,以解释和预测变量之间的关系。

数学建模模型常用的四大模型及对应算法原理总结四大模型对应算法原理及案例使用教程:一、优化模型线性规划线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,在线性回归分析中,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。

如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。

案例实操非线性规划如果目标函数或者约束条件中至少有一个是非线性函数时的最优化问题叫非线性规划问题,是求解目标函数或约束条件中有一个或几个非线性函数的最优化问题的方法。

建立非线性规划模型首先要选定适当的目标变量和决策变量,并建立起目标变量与决策变量之间的函数关系,即目标函数。

然后将各种限制条件加以抽象,得出决策变量应满足的一些等式或不等式,即约束条件。

整数规划整数规划分为两类:一类为纯整数规划,记为PIP,它要求问题中的全部变量都取整数;另一类是混合整数规划,记之为MIP,它的某些变量只能取整数,而其他变量则为连续变量。

整数规划的特殊情况是0-1规划,其变量只取0或者1。

多目标规划求解多目标规划的方法大体上有以下几种:一种是化多为少的方法,即把多目标化为比较容易求解的单目标,如主要目标法、线性加权法、理想点法等;另一种叫分层序列法,即把目标按其重要性给出一个序列,每次都在前一目标最优解集内求下一个目标最优解,直到求出共同的最优解。

目标规划目标规划是一种用来进行含有单目标和多目标的决策分析的数学规划方法,是线性规划的特殊类型。

目标规划的一般模型如下:设xj是目标规划的决策变量,共有m个约束条件是刚性约束,可能是等式约束,也可能是不等式约束。

设有l个柔性目标约束条件,其目标规划约束的偏差为d+, d-。

设有q个优先级别,分别为P1, P2, …, Pq。

在同一个优先级Pk中,有不同的权重,分别记为[插图], [插图](j=1,2, …, l)。

数学建模-多元线性回归分析引言多元线性回归是一种常用的数学建模方法,它用于分析多个自变量和一个因变量之间的关系。

通过寻找最佳的拟合直线,我们可以预测因变量的值,同时还可以了解每个自变量对因变量的贡献程度。

在本文档中,我们将介绍多元线性回归的基本原理、模型拟合和模型评估等内容。

基本原理多元线性回归的基本原理建立在最小二乘法的基础上。

我们假设因变量Y和自变量X之间存在线性关系,即:Y = β0 + β1X1 + β2X2 + … + βn*Xn其中,Y是因变量,X1、X2、…、Xn是自变量,β0、β1、β2、…、βn是回归系数。

我们的目标是求解最佳的回归系数,使得拟合直线与观测数据之间的残差平方和最小。

模型拟合为了拟合多元线性回归模型,我们首先需要收集足够的数据。

然后,我们可以使用各种统计软件或编程语言来进行模型拟合。

这些软件和语言通常提供了专门的函数或库,用于执行多元线性回归分析。

以Python语言为例,我们可以使用statsmodels库中的OLS函数进行多元线性回归拟合。

下面是一个示例代码:import pandas as pdimport statsmodels.api as sm# 读取数据data = pd.read_csv('data.csv')# 构建自变量矩阵X和因变量YX = data[['X1', 'X2', ... , 'Xn']]Y = data['Y']# 添加常数列X = sm.add_constant(X)# 拟合模型model = sm.OLS(Y, X)results = model.fit()# 输出回归结果print(results.summary())在上面的代码中,我们首先读取了数据集,然后构建了自变量矩阵X和因变量Y。

接下来,我们使用sm.add_constant()函数在自变量矩阵X中添加了一个常数列,用于拟合截距项。

1、 多元线性回归

在回归分析中,如果有两个或两个以上的自变量,就称为多元回归。

事实上,一种现象常常是与多个因素相联系的,由多个自变量的最优组合共同来预测或估计因变量,比只用一个自变量进行预测或估计更有效,更符合实际。

在实际经济问题中,一个变量往往受到多个变量的影响。

例如,家庭消费支出,除了受家庭可支配收入的影响外,还受诸如家庭所有的财富、物价水平、金融机构存款利息等多种因素的影响,表现在线性回归模型中的解释变量有多个。

这样的模型被称为多元线性回归模型。

(multivariable linear regression model )

多元线性回归模型的一般形式为:

其中k 为解释变量的数目,j β

(j=1,2,…,k)称为回归系数(regression coefficient)。

上式也被称为总体回归函数的随机表达式。

它的非随机表达式为:

j β也被称为偏回归系数(partial regression coefficient)。

2、 多元线性回归计算模型

多元性回归模型的参数估计,同一元线性回归方程一样,也是在要求误差平方和(Σe)为最小的前提下,用最小二乘法或最大似然估计法求解参数。

设(

11

x ,

12

x ,…,

1p

x ,

1

y ),…,(

1

n x ,

2

n x ,…,

np

x ,

n

y )是一个样本,

用最大似然估计法估计参数:

达

到最小。

把(4)式化简可得:

引入矩阵:

方程组(5)可以化简得:

可得最大似然估计值:

3、Matlab 多元线性回归的实现

多元线性回归在Matlab 中主要实现方法如下:

(1)b=regress(Y, X ) 确定回归系数的点估计值

其中

(2)[b,bint,r,rint,stats]=regress(Y,X,alpha)求回归系数的点估计和区间估计、并检

验回归模型

①bint 表示回归系数的区间估计.

②r 表示残差

③rint 表示置信区间

④stats 表示用于检验回归模型的统计量,有三个数值:相关系数r2、F 值、与F 对应的

概率p

说明:相关系数r2越接近1,说明回归方程越显著;F>F1-alpha(p,n-p-1) 时拒绝H0,F

越大,说明回归方程越显著;与F 对应的概率p<α 时拒绝H0,回归模型成立。

⑤alpha 表示显著性水平(缺省时为0.05)

(3)rcoplot(r,rint) 画出残差及其置信区间

4.基于以上理论分析,求解回归方程

(1)经分析,拟定以1月份数据进行分析求解回归方程,一月份数据如下表格。

设

12345y PM2.5

x x x x x

表示二氧化硫表示二氧化碳表示可吸入微粒物表示一氧化碳表示臭氧表示

在Matlab中输入一下程序:

>> x1=[53 47 57 61 55 56 51 58 64 61 74 62 59 50 54 63 57 56 54 55 54 72 57 58 53 85 72 63 47 44];

x2=[89 83 80 92 104 97 97 123 111 111 115 109 111 110 112 109 89 95 94 87 82 92 97 99 101 120 121 110 102 85];

x3=[76 88 51 81 96 99 121 157 127 159 145 143 131 136 124 159 145 137 111 91 82 116 119 112 106 156 236 149 120 96];

x4=[19 29 31 28 34 30 31 54 47 51 65 59 45 44 44 60 61 48 39 41 53 75 66 50 32 52 73 57 40 40 ];

x5=[30 8 13 8 8 10 28 9 8 24 4 27 38 27 9 5 15 36 26 12 11 8 24 32 43 19 18 30 62 23];

y=[90 143 58 142 175 215 250 309 273 329 299 299 246 261 260 295 282 262 204 179 227 277 242 226 173 266 426 307 230 201];

X=[ones(length(y),1),x1',x2',x3',x4',x5'];

Y=y';

[b,bint,r,rint,stats]=regress(Y,X);

>> b,bint,stats

运行结果为:

b =

-12.2923

-1.5271

0.8327

1.3775

2.0068

-0.3086

bint =

-106.3464 81.7618

-2.9355 -0.1186

-0.4217 2.0871

0.8554 1.8995

1.0254

2.9882

-1.0032 0.3860

stats =

0.9284 62.2206 0.0000 474.4773

因此可得出,

r2=0.9284,F=62.2206,p=0.0000 则p<0.05,回归模型为:

在Matlab命令中输入

Rcoplot(r,rint)

可得到残差图如下图所示

从残差图中和以上分析可以看出,此回归方程效果良好

(2)按同样步骤对全部数据进行了回归分析,运行后的结果为:

b =

-32.4586

0.1718

0.4463

0.8737

2.2106

-0.3352

bint =

-46.4503 -18.4669

-0.2300 0.5736

0.1428 0.7499

0.6943 1.0531

1.7915

2.6297

-0.4650 -0.2053

stats =

0.8373 238.7281 0 927.5409

同样可得出,

r 2

=0.8373,F=238.7281,p=0.0000 则p<0.05,回归模型为:

12345y 32.45860.17180.44630.8737 2.21060.3352x x x x x =-++++-

在Matlab 命令中输入 Rcoplot(r,rint)

可得到残差图如下图所示

从残差图中和以上理论分析可以看出,此回归方程效果也亦良好。