香农的信息论的局限性及其推广研究

- 格式:docx

- 大小:21.06 KB

- 文档页数:10

对香农三大定理的分析与探讨摘要本文针对香农三大定理的内容,进行理论分析,探讨了无失真信源编码、有噪信道编码和保真度准则下的信源编码定理。

通过对离散信源熵的分析,延伸到了对扩展信源的理解,同时结合著名的香农公式和信息论与编码的发展史,指出了香农三大定理的意义。

一、香农第一定理香农第一定理主要研究信息的测度,对应的是无失真信源编码定理。

采用无失真最佳信源编码,可以使得用于每个信源符号的编码位数尽可能地小,但它的极限是原始信源的熵值,超过了这一极限就不可能实现无失真的译码。

1.1 离散信源熵1.1.1 信源的概念信源发出消息,消息载荷信息,而消息又具有不确定性,故而可以用随机变量或随机矢量来描述信源输出的消息。

从随机变量出发来研究信息,这正是香农信息论的基本假说。

而离散信源指的是这类信源输出的消息常以一个符号、一个符号的形式出现,这些符号的取值是有限的或者是可数的。

单符号离散信源只涉及一个随机事件,多符号离散信源则涉及多个随机事件。

1.1.2 信源熵的概念及其性质在度量信息的各种方法中,香农提出了解决信息度量问题的方法——熵,这是香农信息论最基本的,也是最重要的概念[1]。

信源熵,即信源的信息熵,又称香农熵、无条件熵,简称熵。

信源各个离散消息的自信息量的数学期望是信源的平均信息量,实质上是无记忆信源平均不确定度的度量。

信源熵表示在信源输出消息前,信源的平均不确定度,也表示在信源输出消息后,平均每个离散消息所提供的信息量,能够反映变量的随机性。

当消息出现的概率相同时,猜测每一个消息发生错误的概率均相同,说明等概率信源的不确定性最大,具有最大熵[2]。

1.2 无失真离散信源编码1.2.1 信源编码的概念信源编码处于通信系统的前端,直接对信源发出的信号进行变换处理。

通过压缩每个信源符号的平均比特数或信源的码率,以较少的码率来传送同样多的信息,增加单位时间内传送的平均信息量,来压缩信源的冗余度,从而提高通信的有效性。

香农和信息论克劳德·香农(Claude Elwood Shannon)1916年4月30日诞生于美国密执安州,他生长在一个有良好教育的环境,香农的祖父是一位农场主兼发明家,发明过洗衣机和许多农业机械,祖父的发明创造对香农影响很大。

此外,香农的家庭与大发明家爱迪生还有远亲关系。

在童年时代,香农还喜欢组装无线电收音机、练习莫尔斯电报码、研究密码学等等。

他有许多爱好,另人难以置信是香农可以熟练地玩一套杂技,他能骑着独轮车手里来回抛着三个球在贝尔实验室的大厅里骑来骑去。

他发明过有两个座位的独轮车,并使该独轮车好象偏离地心似的,骑在上面忽高忽低,像鸭子行走一样。

香农的一生都迷恋于平衡与控制稳定性。

他设计并建造了下棋机器、迷宫老鼠、杂耍器械以及智力阅读机等,下国际象棋的机器包括用3个指头能抓起棋子的手臂、蜂鸣器以及简单的记录装置。

这些活动表明香农有十分的好奇心和探索精神。

香农有一句名言是:“我感到奇妙的是事物何以集成一体。

”1936年香农在密执安大学获得数学与电气工程学士学位;1938年香农写出论文《继电器与开关电路的符号分析》,当时他就发现电话交换电路与布尔代数之间具有类似性,即把布尔代数的“真”与“假”和电路系统的“开”与“关”对应起来,并可用1和0表示。

随后又证明布尔代数的逻辑运算,可以通过继电器电路来实现,明确地给出了实现加、减、乘、除等运算的电子电路的设计方法,他在实践中进一步证明,可以采用能实现布尔代数运算的继电器或电子元件来制造计算机。

他奠定了数字电路的理论基础,并使计算机具有逻辑功能,从而使计算机既能用于数值计算,又具有各种非数值应用功能,使得以后的计算机在几乎任何领域中都得到了广泛的应用。

1941年他加入贝尔实验室数学部,工作到1972年。

1956年他成为MIT(麻省理工学院)客座教授,并于1958年成为终生教授,1978年成为名誉教授。

香农博士于2001年2月26日去世,享年84岁。

香农的信息论的局限性及其推广研究(一)立项依据与研究内容1.项目的立项依据【研究意义】关于香农信息论的局限性一直都有研究,但是信息的可靠性的研究一直在很大程度上受到忽视,比如香农(Shannon,又译申农、仙农)的信息论只是涉及到信息传输过程中的可靠性,香农对信息的定义和度量都从随机不确定性的角度来进行考虑。

目前信息的定义超过80种之多,但是信息的定义都缺乏对信息可靠性的考虑,一些信息的定义把信息当作对事物的一种真实的反映,然而信息的不可靠性是广泛存在的,从严格的角度来讲,信息很难是绝对可靠的,包括一些科学规律(一种特别的信息),也只能被证伪,而不能被证明是正确的,用于获取信息的人的感官和各种仪器设备也存在一定的不可靠性。

信息的不完备性,也是广泛存在的,往往由于条件的限制而不能得到完全的信息,如何将许多片面的信息进行融合,让信息更加完备,也是一个很重要的问题(特别说明:这里的可靠性是信息本身的可靠性,而不是信息传递、存储等方面的可靠性)。

信息的价值之所以存在,还是因为信息具有一定的可靠性,我们处于信息社会,各种各样的信息在急遽增长,如何很好利用信息,识别信息,提高信息的可靠性,将各种不完备,不可靠的信息进行利用、融合和提取,显然是非常重要的。

信息的可靠性不能完全靠人工来鉴别,人工作业有其不精确性,主观性,应当尽量采用信息技术来自动解决,减少人为判断。

互联网的出现使得信息不断急遽增长,人工处理这些浩如烟海的信息将是很困难,不现实的,需要建立相关的信息理论来通过计算机融合信息。

然而香农的信息论并不能解决这些问题,他的信息论仅仅适应于通信等很局限的领域。

一些学者提出了广义信息论、全信息理论,统一信息理论扩展了他的理论,但是这些理论都没有考虑信息的可靠性方面。

此外,它与其他的一些信息相关的学科在一定程度上是隔离的。

在申请人提出了信息的可靠性问题后,一些学者认为可靠性是信息的重要方面,建议笔者建立可靠信息论。

信息论在数据传输中的应用研究近年来,随着信息技术的飞速发展,数据传输已经成为现代社会中不可或缺的一部分。

在这个信息爆炸的时代,如何高效地传输和利用大量的数据成为了人们关注的焦点。

信息论作为一门独立的学科,正逐渐被广泛应用于数据传输领域。

本文将探讨信息论在数据传输中的应用研究,以及相关的挑战和未来的发展方向。

一、信息论的基本概念信息论是由香农(Claude Shannon)在1948年提出的,它研究的是信息的存储、压缩和传输。

信息在信息论中被量化为比特(bit),表示信息的最小单位。

在信息论中,还引入了熵(entropy)的概念,用来度量一组信息的不确定性。

熵越大,信息的不确定性就越高。

二、信息论在数据压缩中的应用数据压缩是将原始数据转换为更小的表示形式,从而减少数据的存储空间和传输带宽。

信息论的熵和编码理论为数据压缩提供了重要的基础。

通过使用无损压缩算法,如霍夫曼编码和算术编码,可以实现对数据进行高效的压缩。

这些算法根据各个符号的出现频率,为每个符号分配较短的编码。

例如,一些常用的英文字母被分配到更短的编码,而不常用的字母则被分配到较长的编码。

这种压缩方法可以显著减少数据的存储和传输成本。

三、信息论在信道编码中的应用信道编码是指在有噪声或有干扰的信道中,通过添加冗余数据来提高数据传输的可靠性的技术。

信息论中的信道容量概念被用来衡量在特定噪声条件下的最大数据传输速率。

在实际应用中,我们往往借助编码技术来接近这个最大容量。

常见的信道编码方法有海明码、卷积码和LDPC码等。

这些编码技术通过引入冗余来提供容错能力,可以通过纠错和检错算法来恢复传输过程中出现的错误。

信息论的信道编码理论为设计高效的信道编码方案提供了指导和分析工具。

四、信息论在网络通信中的应用网络通信是现代社会的重要组成部分,也是信息论应用的一个重要领域。

信息论通过研究网络的拓扑结构、路由算法和调度策略等问题,来提高网络通信的效率和可靠性。

香农信息定义分析与改进

香农信息论是由美国数学家克劳德·香农于20世纪40年代提出的一种通信理论。

该理论主要研究信息的传输、存储和处理,以及信息的可靠性和效率问题。

香农信息论最基本的概念是信息的概率论定义。

香农定义了信息量的度量方式,将信息的度量单位称为比特(bit)。

一个

比特的信息量等于用一个二进制数字表示一个事件发生的概率的负对数。

比如,如果一个事件发生的概率是1/2,那么该事件的信息量为1比特。

信息量越大,表示事件的不确定性越高,信息的重要性也就越大。

在香农信息论中,还引入了熵的概念。

熵是对一个随机变量的不确定性的度量,表示平均每个符号所包含的信息量。

熵越大,表示随机变量的不确定性越高,信息的平均度量也就越大。

熵可以用来衡量信息源的纯度和复杂性,对于设计有效的编码和压缩算法非常重要。

除了熵和信息量的概念之外,香农信息论还研究了信道容量和编码理论等问题。

信道容量是指在给定信噪比下,信道所能传输的最大有效信息量。

编码理论则研究如何用更少的比特表示更多的信息,以提高信息的传输效率和可靠性。

虽然香农信息论在通信领域有着广泛的应用,但也存在一些问题和改进的空间。

例如,香农信息论主要关注信息的传递和处理,但在现实生活中,信息的解释和理解也是非常重要的。

此外,随着技术的不断发展,信息的形式也越来越多样化,包括文本、图像、音频、视频等,如何应用香农信息论来处理多媒体信息,仍然需要进一步研究和改进。

香农信息论的局限性分析制作者:xxx 指导老师:xxx【内容摘要】:从新的角度指出了香农信息论的局限性,指出了它没有考虑信息的可靠性,完备性等特点,指出条件熵的计算公式问题并且进行了纠正,并且举例证明了条件熵可能增加,进而香农信息定义中的不确定性的减少也不是绝对的。

说明了为什么信息论能够在通信中得到应用,却不能很好地在日常生活中应用。

在这些分析的基础上给出了信息的新定义以及信息相关的一些模型。

【关键词】:信息论;条件熵;定义;可靠性引言香农(又译仙农,Shannon)信息论对信息技术的发展具有深远的影响。

但是信息论的应用一直现有通信等一些很局限的领域,信息论并不能够完全地适用于一些信息技术相关的领域。

关于香农信息论的局限性,许多学者都有认识,香农本人也反对将信息论滥用。

国内外一些学者从许多角度讨论了信息论的局限性,比如没有考虑语义,语用,没有考虑信息的模糊性和事件之间的相似性,没有考虑事件划分可能存在包含关系等。

笔者则指出,目前信息的定义都没有考虑信息的可靠性这一因素,则导致了信息论无法应用在众多的信息技术领域,比如人工智能,信息融合等领域。

1 信息定义的局限关于信息的定义据笔者搜索超过60种,香农的信息定义是比较流行的一个,他定义如下:信息是用以消除随机不确定性的东西。

还有许多学者对这个定义有所修改,但是这些定义都是考虑到消除的随机不确定性,并没有考虑到信息的可靠性。

还有一类定义,比如信息是被反映的物质的属性,信息是结构的表达等,都明显蕴含一个意思,信息是可靠的,是对物质、事物或者结构的一种正确的反映或者表达。

在所有的信息定义中,都没有发现它们对于可靠性以及类似的属性的考虑。

然而,信息之所以能够被利用,信息之所以被重视,它的可靠性是前提。

一旦信息足够的不可靠,信息的价值完全丧失,而且可能起反作用。

香农对信息的定义,对信息的度量,以及它的信息论,基本上都是考虑的是用熵来计算的随机不确定性,并没有考虑信息的可靠度,对信息的可靠度的考虑最多是从信息传递过程中的失真进行了考虑。

香农和信息论克劳德·香农(Claude Elwood Shannon)1916年4月30日诞生于美国密执安州,他生长在一个有良好教育的环境,香农的祖父是一位农场主兼发明家,发明过洗衣机和许多农业机械,祖父的发明创造对香农影响很大。

此外,香农的家庭与大发明家爱迪生还有远亲关系。

在童年时代,香农还喜欢组装无线电收音机、练习莫尔斯电报码、研究密码学等等。

他有许多爱好,另人难以置信是香农可以熟练地玩一套杂技,他能骑着独轮车手里来回抛着三个球在贝尔实验室的大厅里骑来骑去。

他发明过有两个座位的独轮车,并使该独轮车好象偏离地心似的,骑在上面忽高忽低,像鸭子行走一样。

香农的一生都迷恋于平衡与控制稳定性。

他设计并建造了下棋机器、迷宫老鼠、杂耍器械以及智力阅读机等,下国际象棋的机器包括用3个指头能抓起棋子的手臂、蜂鸣器以及简单的记录装置。

这些活动表明香农有十分的好奇心和探索精神。

香农有一句名言是:“我感到奇妙的是事物何以集成一体。

”1936年香农在密执安大学获得数学与电气工程学士学位;1938年香农写出论文《继电器与开关电路的符号分析》,当时他就发现电话交换电路与布尔代数之间具有类似性,即把布尔代数的“真”与“假”和电路系统的“开”与“关”对应起来,并可用1和0表示。

随后又证明布尔代数的逻辑运算,可以通过继电器电路来实现,明确地给出了实现加、减、乘、除等运算的电子电路的设计方法,他在实践中进一步证明,可以采用能实现布尔代数运算的继电器或电子元件来制造计算机。

他奠定了数字电路的理论基础,并使计算机具有逻辑功能,从而使计算机既能用于数值计算,又具有各种非数值应用功能,使得以后的计算机在几乎任何领域中都得到了广泛的应用。

1941年他加入贝尔实验室数学部,工作到1972年。

1956年他成为MIT(麻省理工学院)客座教授,并于1958年成为终生教授,1978年成为名誉教授。

香农博士于2001年2月26日去世,享年84岁。

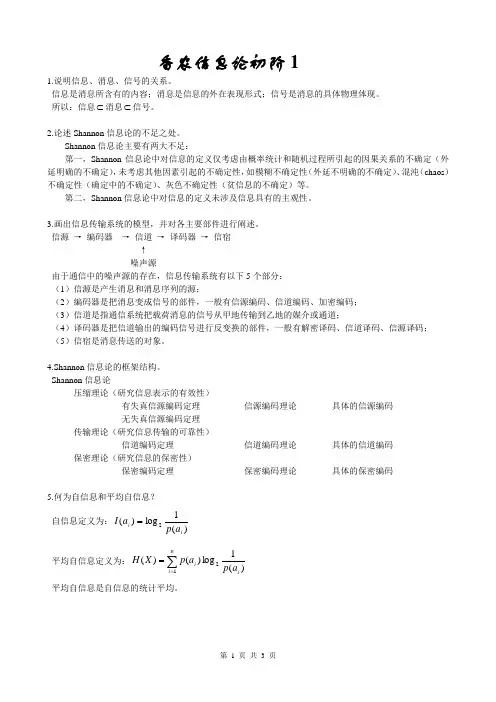

香农信息论初阶11.说明信息、消息、信号的关系。

信息是消息所含有的内容;消息是信息的外在表现形式;信号是消息的具体物理体现。

所以:信息⊂消息⊂信号。

2.论述Shannon 信息论的不足之处。

Shannon 信息论主要有两大不足:第一,Shannon 信息论中对信息的定义仅考虑由概率统计和随机过程所引起的因果关系的不确定(外延明确的不确定),未考虑其他因素引起的不确定性,如模糊不确定性(外延不明确的不确定)、混沌(chaos )不确定性(确定中的不确定)、灰色不确定性(贫信息的不确定)等。

第二,Shannon 信息论中对信息的定义未涉及信息具有的主观性。

3.画出信息传输系统的模型,并对各主要部件进行阐述。

信源 → 编码器 → 信道 → 译码器 → 信宿↑噪声源由于通信中的噪声源的存在,信息传输系统有以下5个部分:(1)信源是产生消息和消息序列的源;(2)编码器是把消息变成信号的部件,一般有信源编码、信道编码、加密编码;(3)信道是指通信系统把载荷消息的信号从甲地传输到乙地的媒介或通道;(4)译码器是把信道输出的编码信号进行反变换的部件,一般有解密译码、信道译码、信源译码;(5)信宿是消息传送的对象。

4.Shannon 信息论的框架结构。

Shannon 信息论压缩理论(研究信息表示的有效性)有失真信源编码定理 信源编码理论 具体的信源编码无失真信源编码定理传输理论(研究信息传输的可靠性)信道编码定理 信道编码理论 具体的信道编码保密理论(研究信息的保密性)保密编码定理 保密编码理论 具体的保密编码5.何为自信息和平均自信息?自信息定义为:)(1log )(2i i a p a I = 平均自信息定义为:)(1log )()(21ini i a p a p X H ∑==平均自信息是自信息的统计平均。

6.何为互信息和平均互信息?互信息的定义为:)()|(log );(2i j i j i a p b a p b a I = 平均互信息定义为:)()|(log )();()();(21111i j i n i mj n i m j ji j i j i a p b a p b a p b a I b a p Y X I ∑∑∑∑======平均互信息是互信息的统计平均。

香农信息论第二次世界大战期间跨学科研究繁盛,这种理论上的相得益彰对于创造信息技术的新浪潮来说,意义重大。

影响最为深远的科学突破之一是香农的信息论,它是我们今天对于传播的主要理解的基础,特别是新的传播技术的设计基础。

信息概念,作为信息的普遍测度标准的比特,以及从香农工作中衍生出来的传播模式,使得我们能够以一种在香农之前不可能存在的方式分析传播系统。

在传播学中,信息是一个中心概念,而香农的信息论成为传播学的根本范式。

什么是信息论信息以某种非同一般的方式运作。

一般来说,当它被有选择地分享时,它的价值就增加。

它不会因为使用而贬值,尽管它可以过时。

最为奇特的是,你可以在不放弃信息的情况下将其分发。

因此,它与货币或其他形式的能源,或物质在本质上截然不同。

香农的信息概念建立在热力学熵的等式的基础上,并将信息的测度单位定为比特。

比特的一个重要优点是:它能够为范围极其广泛的“物质-能量”所使用。

香农的传播模式香农为贝尔实验室工作,它关注传播系统,特别是电话系统的越来越广泛的信道能力。

香农的最初目标是简单的:改进受电子干扰,或噪音影响的电报或电话线上的信息传递。

他断定,最好的解决方法不是改进传递线路,而是更有效地包装信息。

1984年香农的两篇论文提出了一系列以数学形式表达的定理,涉及到一个讯息从一个地方向另一个地方的传递。

香农也阐述了传播所涉及的主要因素:信源、讯息、发射器、信号、噪音、接受到的信号、接受器和信宿。

香农的整体理论贡献被普遍称为信息论,尽管香农将之称为“传播的数学理论”。

传播被定义为“一个过程,通过这个过程,一个人的思想影响另一个人”。

因此,它被看做是有意图的。

在其著作《传播的数学理论》中,韦弗和香农都提供了一种同样的线性传播过程模式(信源、讯息、发射器、信号和噪音等)。

以其最简单的形式来说,这个模式表达了一种线性的、从左到右的传播概念。

传播学学者用它来关注传播效果,特别是大众传播的效果,尽管香农的意图是要解释传递讯息的信道能力,而不是它的效果。

香农信息论

香农信息论主要讨论点对点通信中的一些基本问题,最著名的结论包括其中的四大定理,也即为无失真信源编码定理,限失真信源编码定理,信道编码定理,信源信道分离定理。

香农信息论为目前的通信系统设计和编码都有不可忽视的指导意义,但其也有不足的地方,主要包括三方面,一个局限是香农得出的大部分结果,都是在理论上得到的极限值,虽然为通信系统的设计给出了非常有指导意思的理论界限,但实际系统中应该如何去达到这些界限,香农并没有给出,最典型的例子就是信道编码定理,虽然1948年香农就发明了信息论,但到90年代才找到或者再发现能够逼近香农极限的turbo码和LDPC码;再一个局限是香农的大部分结果都是在一定的理想条件或极限条件下推导出来的,在实际系统中,这些条件可能不能满足,因而不可能达到香农所得出的一些结论或界限,举一个例子,信源信道分离定理是在数据分组长度无穷大和静态信道条件下得到的,但实际系统中的编码可能会有分组长度和限制,信道也可能是时变的,因而产生出最近较新的所谓联合信源信道编码理论;最后一个是局限是点对点通信的局限性,因为通信的构架存在网络结构和多用户的结构,所以对于网络和多用户的情形,香农并没有更深入的研究,虽然他在50年代研究了two way channel,但并未得出有意义的结果,目前网络信息论或多用户信息论是一个比较活跃的领域,主要的有意义的结论在广播和多址接入信道,但都是退化的情形才成立的结论,更一般的情形,还有一些其他如中继信道等,还有待进一步研究。

综上,香农信息论的发展主要为网络信息论(目前中继信道比较活跃)、联合信源信道编码、多描述问题、高斯分布的码书的设计等,这些都是尚未解决的问题。

香农的信息论的局限性及其推广研究(一)立项根据与研究内容1.项目的立项根据【研究意义】关于香农信息论的局限性一直都有研究,但是信息的可靠性的研究一直在很大程度上受到忽视,比如香农(Shannon,又译申农、仙农)的信息论只是涉及到信息传输过程中的可靠性,香农对信息的定义与度量都从随机不确定性的角度来进行考虑。

目前信息的定义超过80种之多,但是信息的定义都缺乏对信息可靠性的考虑,一些信息的定义把信息当作对事物的一种真实的反映,然而信息的不可靠性是广泛存在的,从严格的角度来讲,信息很难是绝对可靠的,包含一些科学规律(一种特别的信息),也只能被证伪,而不能被证明是正确的,用于获取信息的人的感官与各类仪器设备也存在一定的不可靠性。

信息的不完备性,也是广泛存在的,往往由于条件的限制而不能得到完全的信息,如何将许多片面的信息进行融合,让信息更加完备,也是一个很重要的问题(特别说明:这里的可靠性是信息本身的可靠性,而不是信息传递、存储等方面的可靠性)。

信息的价值之因此存在,还是由于信息具有一定的可靠性,我们处于信息社会,各类各样的信息在急遽增长,如何很好利用信息,识别信息,提高信息的可靠性,将各类不完备,不可靠的信息进行利用、融合与提取,显然是非常重要的。

信息的可靠性不能完全靠人工来鉴别,人工作业有其不精确性,主观性,应当尽量使用信息技术来自动解决,减少人为推断。

互联网的出现使得信息不断急遽增长,人工处理这些浩如烟海的信息将是很困难,不现实的,需要建立有关的信息理论来通过计算机融合信息。

然而香农的信息论并不能解决这些问题,他的信息论仅仅习惯于通信等很局限的领域。

一些学者提出了广义信息论、全信息理论,统一信息理论扩展了他的理论,但是这些理论都没有考虑信息的可靠性方面。

此外,它与其他的一些信息有关的学科在一定程度上是隔离的。

在申请人提出了信息的可靠性问题后,一些学者认为可靠性是信息的重要方面,建议笔者建立可靠信息论。

由于可靠性可能过于狭隘,而使用相对信息论命名,除了考虑可靠性外,它具有更加深远的意义,有助于解决与解释更多的问题。

在密码分析方面,缺乏对信息的不确定性与信息融合的研究,比如当多个伪密钥存在的情况下,如何进行推断分析。

密码分析前已知的信息与密码分析得到的信息如何进行融合,密码分析得到的信息是不可靠的时候,或者者密码分析得到的信息只能得出某些需要熟悉的信息的不确定的概率分布且事先也对这些需要熟悉的信息从其他的角度得出某一概率分布时候,如何来得出更加完备与可靠的信息,都是尚未研究的领域。

【国内外研究现状及进展动态分析】香农信息论的局限性很早就被认识到,包含香农本人。

香农的信息论诞生不久,许多人将它推广到日常信息交流场合,因此出现纰漏。

香农也曾经辑文反对信息论的滥用。

与Shannon合著《通信的数学理论》一书的W. Weaver就提出通信的三个水平,而香农理论仅仅是其中一个水平。

为熟悉决语义信息问题,R. Carnap等人提出用逻辑概率代替普通概率,然后用Shannon 熵度量语义信息。

50年代末,Kullback提出Kullback信息公式。

60年代初,Brillouin提出可用Hartley公式的改进形式来度量非概率信息,比如测量数据的信息。

1965年,L. A. Zadeh提出模糊集合论,1968年,他又提出模糊事件,即模糊集合A 中事件的概率,与模糊集合的熵。

1972年,德鲁卡与特尔米尼提出了用来测度模糊事件的信息量的模糊信息熵公式。

70年代,H. Gottinger提出非概率信息,S.Guiasu提出了加权熵与效用信息,都产生了一定影响。

G. Jumarie还提出使用洛伦兹变换的相对信息,惋惜相对信息的定义并不自然,它与本项目的相对信息有很大的差别。

此后,R. Yager,M. Higashi与G. Klir,D. Dubois与H. Prade 等人又提出或者讨论了可能不确定性测度及相应的广义熵,这类方法只使用隶属度等主观测度而不使用事件发生的概率。

吴伟陵教授对广义熵与模糊信息做过探讨。

我国学者钟义信先生1981年针对香农信息论的熵公式只能度量概率信息的缺陷,提出了一种"广义信息函数"。

1985年,他又把该公式推广到语义信息与语用信息的度量,得到了语法,语义与语用信息的综合测度公式,即所谓"全信息"的计量模型。

1993年,鲁晨光提出广义信息论,指出香农信息论的局限性具体表现在:不便于度量语义信息、感受信息、信源信道可变时的信息与单个信号的信息。

鲁晨光提出了广义通信模型与可度量语义信息、感受信息及测量信号信息的广义信息测度;讨论了预测与检测的信息准则与优化理论。

George J. Klir则在模糊逻辑,不分明集这些不确定性方面作出了许多的研究。

斯托尼尔在90年代初提出统一的信息理论,他把信息看成是宇宙的一种基本属性,其目标是在信息物理学的基础上,并综合现有的操纵论,符号学,语言学,认知心理学等学科,构建一个所谓通常信息理论的框架。

这些新的理论都是在香农的基础上进行扩展,认识到了香农的一些局限性,都很重视对单重不确定性(信息熵)的研究,但是都没有考虑的信息的可靠性这一问题,即信息与客观事实与真理的符合程度,从信息表示的角度,也就是说没有考虑到信息的表示是不确定性的,如信息的表达中概率是变动的,随机的。

此外关于信息的定义非常多,但是并不存在公认的定义,绝大多数定义都没有考虑信息的可靠性,信息的定义也是以“信息是消除不确定性的东西”得到广泛的重视。

关于不确定性理论,有关的推理模型没有一个统一的模型,种类不计其数,其中比较著名的有:Shortliffe在1975年结合医疗专家系统MYCIN建立的确定性理论,Duda在1976年结合探矿专家系统PROSPECTOR建立的主观Bayes 推理,Dempster Shafer在1976年提出的证据理论,Zadeh在1978年提出的可能性理论,1983年提出的模糊逻辑与逻辑推理,Nilsson在1986年提出的概率逻辑,Pearl在1986年提出的信任网络。

八十年代以后,人们又提出了灰色系统理论、粗集理论、概念图、基于信比概念的知识处理与集对分析等新方法。

国内学者李德毅提出了云模型,何华灿提出了泛逻辑学。

但是不确定性理论通常是不够严谨的,甚至还存在一些冲突与悖论。

这些理论与概率论与信息论都是出现了不应该有的隔离,特别是与信息论与不确定性理论、信息融合相去甚远。

能够说信息与知识与智能已经隔离了,国内学者钟义信认识到这一问题,提出信息-知识-智能转换的规律,提出了一些框架。

在可靠性理论方面,要紧是研究工程、产品与系统的可靠性,其中包含软件产品的可靠性,涉及到信息的要紧是针对信息系统的可靠性、可靠性有关的信息的处理软件系统与可靠性有关的信息的分析与利用设计。

除申请人提出了信息的可靠性问题,同时分析了它与不确定性的关系外,目前尚未见到有对信息本身的可靠性有关的其他研究,而信息的可靠性问题比通常的可靠性问题更加复杂。

【要紧参考文献】[1]. Shannon C E. A mathematical theory of communication,Bell System Technical Journal,27 (1948),379—429,623—656[2]. 美〕威弗尔. 通讯的数学理论的新进展,系统论操纵论信息论经典文献选编,求实出版社,1989,612—636[3]. 汪培庄. 模糊集与随机集落影,北京师范大学出版社,1984.[4]. 宛天巍,王浣尘,张旭,信息测度方法的综述,系统工程理论方法应用,第14卷第6期,2005年12月[5]. Wierman, M.J.,Tastle, W.J. Placing the Dissonance Measure in the Context of Generalized Information Theory,Fuzzy Information Processing Society, 2006. NAFIPS 2006. Annual meeting of the North American, 3-6 June 2006 Page(s):253 - 256[6]. Peter Fleissner, Wolfgang Hofkirchner ,Emergent information Towards a unified information theory In: BioSystems 2-3(38)/1996,243-248[7]. Kullback S. Information and Statistics,John Wiley & Sons Inc.,New York,1959[8]. Aczel J and Forte B. Generalized entropies and the maximum entropy principle,In: Bayesian Entropy and Bayesian Methods in Applied Stastics,Cambridge University Press,Cambridge,1986,95—100[9]. Brillouin L. Science and Information Theory,Academic Press,New York,1962[10]. Zadeh L A. Probability measures of fuzzy events,Journal ofmathematical Analyses and Applications 23 (1968),421—427 [11]. De Luca A and Termini S. A definition of nonprobabilistic entropy in the setting of fuzzy sets,Infor. Contr. 20 (1972),201—312 [12]. Gottinger H W. Lecture notes on concepts and Measures of information,In 'Information Theory: New trends and Open Problems', G. Longo eds.,Springer Verlag,CISM(1975)[13]. 郝建民,纪念信息论创立五十周年,遥测遥控,1999年5月,第20卷第3期[14]. 钟义信.面向智能研究的全信息理论[J].北京邮电大学学报,2000,(1)[15].Klir, G. J. Uncertainty and Information: Foundations of Generalized Information Theory. John Wiley, Hoboken, NJ,2006[16]. 钟义信. 信息科学原理,福建人民出版社,1988[17]. 鲁晨光.广义信息论,中国科技大学出版社,1993[18]. Klir, G.J.Measuring uncertainty associated with convex sets of probability distributions: a new approach,Fuzzy Information Processing Society, 2005. NAFIPS 2005. Annual Meeting of the North American26-28 June 2005 Page(s):61 - 64[19]. 王勇,论信息的相对性,武汉:首届全国社会信息科学研讨会论文集,2007年06月[20]. George J. Klir.An update on generalized informationtheory[A].ISIPTA[C].2003.321~334[22]. 李德毅,不确定性人工智能,国防工业出版社, 2005年7月2.项目的研究内容、研究目标,与拟解决的关键科学问题【项目研究内容】(1)本项目借鉴前人对信息论的局限性的分析,从可靠性的角度来分析香农信息论的局限性,与其产生的根源,同时将信息论从相对信息的角度来进行推广。