Weka_数据挖掘软件使用指南

- 格式:docx

- 大小:309.78 KB

- 文档页数:7

电算化常用数据挖掘与机器学习工具操作指南在当今数字化时代,数据的快速增长和复杂性使得传统的数据处理方式已无法满足实际需求。

因此,数据挖掘和机器学习成为了解决大规模数据处理的重要工具。

本文将介绍电算化常用的数据挖掘和机器学习工具的操作指南,帮助读者更好地理解和应用这些工具。

一、WEKA软件WEKA是一个十分常用的机器学习工具,其功能强大、易于使用。

以下是WEKA软件的操作指南:1. 安装WEKA软件下载WEKA安装文件并按照提示完成软件的安装。

2. 数据预处理在WEKA中,选择“预处理”选项,对数据进行清洗、去除噪声、处理缺失值等操作,以获得干净的数据集。

3. 特征选择通过选择合适的特征,提高模型的准确性和效率。

使用WEKA的“特征选择”功能,可以根据不同的特征选择算法来进行特征选择。

4. 模型构建与评估选择合适的机器学习算法,使用WEKA中的“分类”或“回归”功能,进行模型的构建与训练。

同时,可以使用WEKA提供的交叉验证、混淆矩阵等评估工具,评估模型的性能。

5. 模型应用与保存完成模型的构建和评估后,可以使用WEKA对新数据进行预测和分类。

同时,也可以将模型保存下来,以备将来使用。

二、Python编程语言与相关库Python是一种广泛应用于数据挖掘和机器学习领域的编程语言,其丰富的库使得数据处理和模型构建变得更为便捷。

以下是使用Python进行数据挖掘和机器学习的操作指南:1. 安装Python环境与相关库首先,安装Python编程环境,并通过pip命令安装相关库,如NumPy、Pandas、Scikit-learn等。

2. 数据加载与预处理使用Pandas库加载数据,并利用库中的函数进行数据清洗、去除异常值等预处理操作。

3. 特征工程在数据挖掘和机器学习中,特征工程是提取和选择合适的特征,以增加模型的准确性和泛化能力。

可以利用特征选择、特征提取、特征变换等方法进行特征工程。

利用Scikit-learn库中的各种机器学习算法,可以构建多种模型。

Weka数据挖掘软件使用指南Weka 数据挖掘软件使用指南1. Weka简介该软件是WEKA的全名是怀卡托智能分析环境(Waikato Environment for Knowledge Analysis),它的源代码可通过得到。

Weka作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归、聚类、关联规则以及在新的交互式界面上的可视化。

如果想自己实现数据挖掘算法的话,可以看一看Weka的接口文档。

在Weka中集成自己的算法甚至借鉴它的方法自己实现可视化工具并不是件很困难的事情。

2. Weka启动打开Weka主界面后会出现一个对话框,如图:主要使用右方的四个模块,说明如下:Explorer使用Weka探索数据的环境,包括获取关联项,分类预测,聚簇等;(本文主要总结这个部分的使用)Experimenter运行算法试验、管理算法方案之间的统计检验的环境;KnowledgeFlow这个环境本质上和Explorer所支持的功能是一样的,但是它有一个可以拖放的界面。

它有一个优势,就是支持增量学习;SimpleCLI提供了一个简单的命令行界面,从而可以在没有自带命令行的操作系统中直接执行Weka命令;(某些情况下使用命令行功能更好一些)3.主要操作说明点击进入Explorer模块开始数据探索环境:3.1主界面进入Explorer模式后的主界面如下:3.1.1标签栏主界面最左上角(标题栏下方)的是标签栏,分为五个部分,功能依次是:1. Preprocess. 选择和修改要处理的数据;2. Classify. 训练和测试关于分类或回归的学习方案;3. Cluster. 从数据中学习聚类;4. Associate.从数据中学习关联规则;5. Select attributes. 选择数据中最相关的属性;6. Visualize.查看数据的交互式二维图像。

3.1.2载入、编辑数据标签栏下方是载入数据栏,功能如下:1.Open file.打开一个对话框,允许你浏览本地文件系统上的数据文件(.dat);2.Open URL.请求一个存有数据的URL 地址;3.Open DB.从数据库中读取数据;4.Generate.从一些数据生成器中生成人造数据。

weka使用教程Weka是一个强大的开源机器学习软件,它提供了各种功能和算法来进行数据挖掘和预测分析。

以下是一个简单的Wea使用教程,帮助您了解如何使用它来进行数据分析和建模。

1. 安装Weka:首先,您需要下载并安装Weka软件。

您可以从官方网站上下载Weka的最新版本,并按照安装说明进行安装。

2. 打开Weka:安装完成后,打开Weka软件。

您将看到一个欢迎界面,上面列出了各种不同的选项和功能。

选择“Explorer”选项卡,这将帮助您导航和执行不同的任务。

3. 导入数据:在Explorer选项卡上,点击“Open file”按钮以导入您的数据集。

选择您要导入的数据文件,并确认数据文件的格式和结构。

4. 数据预处理:在导入数据之后,您可能需要对数据进行预处理,以清除噪声和处理缺失值。

在Weka中,您可以使用各种过滤器和转换器来处理数据。

点击“Preprocess”选项卡,然后选择适当的过滤器和转换器来定义您的预处理流程。

5. 数据探索:在数据预处理之后,您可以使用Weka的可视化工具来探索您的数据。

点击“Classify”选项卡,然后选择“Visualize”选项。

这将显示您的数据集的可视化图表和统计信息。

6. 建立模型:一旦您对数据进行了足够的探索,您可以使用Weka的各种机器学习算法建立模型。

在“Classify”选项卡上选择“Choose”按钮,并从下拉菜单中选择一个适当的分类算法。

然后,使用“Start”按钮训练模型并评估模型的性能。

7. 模型评估:一旦您建立了模型,您可以使用Weka提供的评估指标来评估模型的性能。

在“Classify”选项卡上,选择“Evaluate”选项,Weka将自动计算模型的准确性、精确度、召回率等指标。

8. 导出模型:最后,一旦您满意您的模型性能,您可以将模型导出到其他应用程序或格式中。

在Weka中,点击“Classify”选项卡,选择“Save model”选项,并指定模型的保存位置和格式。

简介和回归简介什么是数据挖掘?您会不时地问自己这个问题,因为这个主题越来越得到技术界的关注。

您可能听说过像 Google 和 Yahoo! 这样的公司都在生成有关其所有用户的数十亿的数据点,您不禁疑惑,“它们要所有这些信息干什么?”您可能还会惊奇地发现 Walmart 是最为先进的进行数据挖掘并将结果应用于业务的公司之一。

现在世界上几乎所有的公司都在使用数据挖掘,并且目前尚未使用数据挖掘的公司在不久的将来就会发现自己处于极大的劣势。

那么,您如何能让您和您的公司跟上数据挖掘的大潮呢?我们希望能够回答您所有关于数据挖掘的初级问题。

我们也希望将一种免费的开源软件 Waikato Environment for Knowledge Analysis (WEKA) 介绍给您,您可以使用该软件来挖掘数据并将您对您用户、客户和业务的认知转变为有用的信息以提高收入。

您会发现要想出色地完成挖掘数据的任务并不像您想象地那么困难。

此外,本文还会介绍数据挖掘的第一种技术:回归,意思是根据现有的数据预测未来数据的值。

它可能是挖掘数据最为简单的一种方式,您甚至以前曾经用您喜爱的某个流行的电子数据表软件进行过这种初级的数据挖掘(虽然 WEKA 可以做更为复杂的计算)。

本系列后续的文章将会涉及挖掘数据的其他方法,包括群集、最近的邻居以及分类树。

(如果您还不太知道这些术语是何意思,没关系。

我们将在这个系列一一介绍。

)回页首什么是数据挖掘?数据挖掘,就其核心而言,是指将大量数据转变为有实际意义的模式和规则。

并且,它还可以分为两种类型:直接的和间接的。

在直接的数据挖掘中,您会尝试预测一个特定的数据点—比如,以给定的一个房子的售价来预测邻近地区的其他房子的售价。

在间接的数据挖掘中,您会尝试创建数据组或找到现有数据的模式—比如,创建“中产阶级妇女”的人群。

实际上,每次的美国人口统计都是在进行数据挖掘,政府想要收集每个国民的数据并将它转变为有用信息。

大数据导论实验报告

实验一

姓名abc

学号asadsdsa

报告日期

实验一

一.实验目的

1实验开源工具Weka的安装和熟悉;

2.数据理解,数据预处理的实验;

二.实验内容

1.weka介绍

2.数据理解

3.数据预处理

4.保存处理后的数据

三.实验过程

1.导入数据并修改选项

2.用weka.filters.unsupervised.attribute.ReplaceMissingValues处理缺失值

3.用weka.filters.unsupervised.attribute.Discretize离散化第一列数据

4.用weka.filters.unsupervised.instance.RemoveDuplicates删除重复数据

5.用weka.filters.unsupervised.attribute.Discretize离散化第六列数据

6.用weka.filters.unsupervised.attribute.Normalize归一化数据

7.保存数据

四.实验结果与分析

1.数据清理后的对比图,上面的是处理前的图,下图是处理后的图

分析:通过两图对比可发现图一中缺失的数据在图二中已经添加上。

2.离散化第一行后的对比图,图片为离散化之后的效果图

分析:此次处理目标为第一列,可发现处理后‘age’这一列的数据离散化了。

3.删除重复数据之后的效果图

5.离散化第六列后的效果图

分析:此次处理目标为第六列,可清楚看到发生的变化6.归一化后的效果图

此次处理的目标是10,12,13,14列,即将未离散化的数值列进行归一化处理。

WEKA使用教程目录1. 简介2. 数据格式3.数据准备4. 关联规则(购物篮分析)5. 分类与回归6. 聚类分析1. 简介WEKA的全名是怀卡托智能分析环境(Waikato Environment for Knowledge Analysis),它的源代码可通过/ml/weka得到。

同时weka也是新西兰的一种鸟名,而WEK A的主要开发者来自新西兰。

WEKA作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归、聚类、关联规则以及在新的交互式界面上的可视化。

如果想自己实现数据挖掘算法的话,可以看一看weka的接口文档。

在weka中集成自己的算法甚至借鉴它的方法自己实现可视化工具并不是件很困难的事情。

2005年8月,在第11届ACM SIGKDD国际会议上,怀卡托大学的Weka小组荣获了数据挖掘和知识探索领域的最高服务奖,Weka系统得到了广泛的认可,被誉为数据挖掘和机器学习历史上的里程碑,是现今最完备的数据挖掘工具之一(已有11年的发展历史)。

Weka的每月下载次数已超过万次。

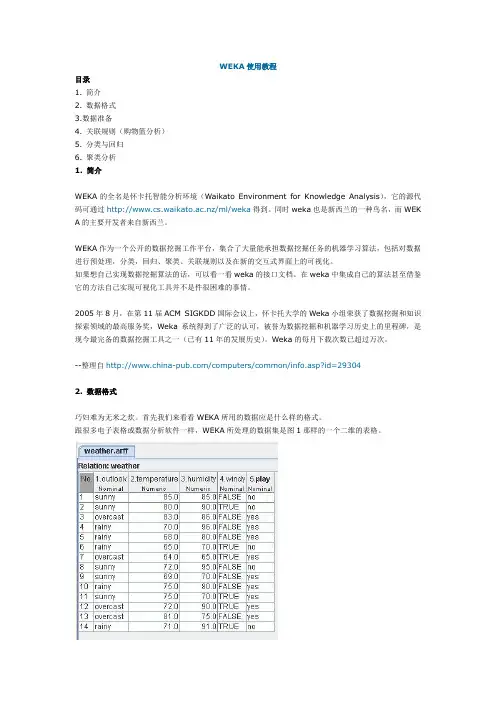

--整理自/computers/common/info.asp?id=293042. 数据格式巧妇难为无米之炊。

首先我们来看看WEKA所用的数据应是什么样的格式。

跟很多电子表格或数据分析软件一样,WEKA所处理的数据集是图1那样的一个二维的表格。

图1 新窗口打开这里我们要介绍一下WEKA中的术语。

表格里的一个横行称作一个实例(Instance),相当于统计学中的一个样本,或者数据库中的一条记录。

竖行称作一个属性(Attrbute),相当于统计学中的一个变量,或者数据库中的一个字段。

这样一个表格,或者叫数据集,在WEKA看来,呈现了属性之间的一种关系(Rela tion)。

图1中一共有14个实例,5个属性,关系名称为“weather”。

WEKA存储数据的格式是ARFF(Attribute-Relation File Format)文件,这是一种ASCII文本文件。

FlexDM:Simple,parallel and fault-tolerant data mining using WEKAMadison Flannery 1,David M.Budden 1and Alexandre Mendes 2*BackgroundLarge-scale analysis is an integral component of mod-ern life sciences research,and is becoming a necessary day-to-day task for many researchers lacking a strong programming or statistics background.This is epito-mised by genomics and epigenetics studies (e.g.those leveraging microarray and next generation sequencing technologies),which require data for tens-of-thousands of genes to be quantified and simultaneously analysed [1–3].Sophisticated machine learning and data mining tools have been introduced to address these requirements in the life sciences and other areas of quantitative research[4].Of these frameworks,WEKA (Waikato Environment for Knowledge Analysis)has been widely-adopted as a gold standard,having been cited more than 8000times in academic literature [5].Despite its proven success and widespread applica-tion,the WEKA Experimenter pipeline exhibits a num-ber of limitations that make it both a)difficult to apply to non-trivial data mining challenges in modern research,and b)remain robust and reliable against the exponential growth of data volume in the two decades since its ori-ginal development [6].Although other third-party exten-sions and plug-ins have been developed to address these limitations,these have been fragmentary solutions to a subset of the underlying issues [7,8].The following Sec-tion expands upon four major and inter-related limitations*Correspondence:******************************.au 2School of Electrical Engineering and Computer Science,The University of Newcastle,Callaghan 2308NSW,AustraliaFull list of author information is available at the end of thearticle©2015Flannery et al.Open Access This article is distributed under the terms of the Creative Commons Attribution 4.0International License (/licenses/by/4.0/),which permits unrestricted use,distribution,andreproduction in any medium,provided you give appropriate credit to the original author(s)and the source,provide a link to the Creative Commons license,and indicate if changes were made.The Creative Commons Public Domain Dedication waiver (/publicdomain/zero/1.0/)applies to the data made available in this article,unless otherwise stated.Flannery et al.Source Code for Biology and Medicine (2015) 10:13 DOI 10.1186/s13029-015-0045-3in WEKA and how these have been addressed in our new FlexDM software.ImplementationFlexDM addresses four fundamental limitations identified for machine learning/data mining experiments using the WEKA Experimenter and GUI(the most common ap-proach for non-experts,as more advanced features are unintuitive and overall poorly documented).These limita-tions and their FlexDM solutions are described below. It is important to note that FlexDM-generated result summaries are fully compatible with advanced WEKA features including the Analyse tab,which allows for statistical post-processing and visualisation of results. Reliance on WEKA experimenter GUIAlthough WEKA is built on-top of XML-based experiment specifications,this XML schema is highly-unreadable and clearly designed to be written exclusively from the WEKA GUI.The FlexDM XML scheme improves human readabil-ity and brevity while also providing extended functionality, as demonstrated in Fig.1.This new schema is sufficiently readable that non-programmers are able to create their own or modify the provided example to their individ-ual needs.Specification and optimisation of hyper-parametersIt is often unclear what combination of method hyper-parameters will yield the most insight from an experimental data-set,posing a need to evaluate many combinations of potential value assignments.WEKA provides only limited support for these feature through its CVParameterSelection and GridSearch functions,which are able to meta-optimise over1-or-2parameters respectively.FlexDM allows for numeric ranges to be specified for any number of com-bination of method hyper-parameters.Ranges may be represented in two forms:a set of categorical or numer-ical values;or a numeric interval with user-specified start,step and end values.FlexDM will automatically evaluate all combinations of parameter values and save the results as individual output files.The user can also specify their desired evaluation procedure(e.g.leave-one-out,k-fold cross-validation or test/training split). Optimising over several hyper-parameters inherently worsens the computational time complexity of the ex-periment,necessitating improved fault-tolerance and the ability to parallelise tasks to leverage modern processor architectures.These features are addressed below. Robustness and fault-toleranceThe WEKA Experimenter runs all experiments in series and does not generate a results file until the final experiment has concluded.Many large machine learn-ing experiments(e.g.in the life sciences[1–3])can take hours-or-days to conclude,particularly when meta-optimising over many combinations of hyper-parameters.Any software or hardware fault during this time will cause all intermediate results to be lost.By contrast,FlexDM automatically generates individual results files upon conclusion of each experiment,and provides functionality to allow a series of experiments to automatically resume from the most recent to suc-cessfully complete.Asynchronous parallel processingWEKA does not provide an intuitive means of utilising modern multi-core processing architectures,instead running a series of experiments on a single process and thread.FlexDM leverages the independent nature of individual experiments by introducing asynchronous and parallel processing.Similar features have been in-troduced in third-party packages including Weka-Parallel[7]and Grid-enabled Weka[8],but without the aforementioned FlexDM features necessary to maximise the value of this functionality.ResultsThis results section is separated into two parts:a practical example of the improved FlexDM XML schema when compared to its WEKA Experimenter equivalent;and an empirical analysis of the time taken to perform a large data mining task when distributed across multipleCPUs.Figure 1illustrates an example FlexDM XML input file for the execution of 20experiments,which simultaneously (and in parallel)meta-optimises the ‘confidence factor ’(c)hyper-parameter for two classification algorithms (J48and PART).Leave-one-out cross-validation was employed as the evaluation strategy,although k-fold cross-validation or percentage split could have been selected as appropriate for larger data-sets.FlexDM will load the XML file and specified data-set,asynchronously execute each experi-ment and summarise the results for each in individual files.FlexDM also creates a summary file reporting the overall experimental outcomes.This easy-to-read XML specification takes only 11lines to define a non-trivial series of experiments and hyper-parameter meta-optimisation tasks.By contrast,the equiva-lent WEKA Experimenter-interpreted XML specification requires 10-fold as many lines and is difficult to modify without reliance upon the GUI.These XML specifications are compared in Additional file 1.Figure 2illustrates the relative execution time for a FlexDM-enhanced WEKA experiment as a function of the number of allocated CPU cores (a user-specified parameter which defaults to the number of available cores minus 1).This test was completed on a desktop PC with a quad-core Intel i7processor.A near-linear speed-up is evident for n =1:4cores,with divergence due to background system tasks necessary within the host OS en-vironment.For n =5:8cores,the i7processor ’s hyper-threading capability is leveraged for further quasi-linear speed-up,resulting in an overall 5-fold reduction in exe-cution time when distributed across 8logical CPU cores.ConclusionsFlexDM enables flexible,fault tolerant and computa-tionally efficient data mining using WEKA.This frame-work has addressed four fundamental and interrelated limitations inherent to the standard WEKA Experi-menter and GUI pipeline,while providing a novel XML-based specification of data mining experiments that are expressive,succinct and easily understood/ex-tended by non-programmers.These improvements are necessary in the context of modern life sciences re-search,where the volume of data continues to increase at an exponential rate,and researchers without pro-gramming or statistics backgrounds are increasingly re-quired to perform non-trivial data mining and machine learning experiments.As we encourage other researchers to explore and adopt our software,FlexDM is implemented using ex-clusively open-source software and made available as a pre-configured virtual reference environment,using the approach recently described by Hurley et al .[9].A comprehensive FlexDM user guide,including reference environment instructions and examples/templates of XML experiment specifications,are available online at http://madiflannery.github.io/FlexDM/Availability and requirements Project Name:FlexDMProject home page:http://madiflannery.github.io/FlexDM/Operating system(s):Platform independent Programming language:JavaOther requirements:Java 1.7or higher License:GPLv2Additional fileCompeting interestsThe authors declare that they have no competing interests.Authors ’contributionsMF was responsible for the design,implementation and testing of the software,working under the supervision of AM,who conceived the study.DB helped with the design of the XML schema and was responsible for the preparation of the pre-configured bootable virtual environment.MF and DB created the supplementary material webpage.All authors read and approved the final manuscript.AcknowledgementsAM wishes to acknowledge the support of the School of ElectricalEngineering and Computer Science,The University of Newcastle,Australiaand its Work Integrated Learning program which made this study possible. The authors wish to thank Daniel G.Hurley,of the University of Melbourne’s Systems Biology Laboratory,for his assistance preparing and testing a virtual reference environment implementation of FlexDM.Author details1Systems Biology Laboratory,University of Melbourne,Parkville3010VIC, Australia.2School of Electrical Engineering and Computer Science,The University of Newcastle,Callaghan2308NSW,Australia.Received:20January2015Accepted:9November2015References1.Budden DM,Hurley DG,Cursons J,Markham JF,Davis MJ,Crampin EJ.Predicting expression:the complementary power of histone modificationand transcription factor binding data.Epigenetics Chromatin.2014;7(1):1–12.2.Budden,D.M.,D.G.Hurley,and E.J.Crampin,Predictive modelling of geneexpression from transcriptional regulatory elements.Briefings inbioinformatics.2014;16(4):616–28.3.Budden DM,Hurley DG,Crampin EJ.Modelling the conditional regulatoryactivity of methylated and bivalent promoters.Epigenetics Chromatin.2015;8(1):1–10.4.Marsden J et nguage individuation and marker words:Shakespeareand his maxwell’s demon.PLoS One.2013;8(6):e66813.5.Hall M et al.The WEKA data mining software:An update.ACM SIGKDDExplorations Newsl.2009;11(1):10–8.6.Holmes,G.,A.Donkin,and I.H.Witten.Weka:A machine learningworkbench.Proceedings of the IEEE2nd Australian and New ZealandConference on Intelligent Information Systems.Brisbane,Australia;1994.pp.357-61.7.Celis,S.and D.R.Musicant.Weka-parallel:machine learning in parallel.Northfield,USA:Technical Report,Carleton College,CS-TR;2002.8.Khoussainov R,Zuo X,Kushmerick N.Grid-enabled Weka:A toolkit formachine learning on the grid.ERCIM News.2004;59:47–8.9.Hurley,D.G.,D.M.Budden,and E.J.Crampin,Virtual Reference Environments:a simple way to make research reproducible.Briefings in bioinformatics.2014;16(5):901-3.。

Weka 数据挖掘软件使用指南1.Weka简介该软件是WEKA的全名是怀卡托智能分析环境(Waikato Environment for Knowledge Analysis),它的源代码可通过/ml/weka得到。

Weka作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归、聚类、关联规则以及在新的交互式界面上的可视化。

如果想自己实现数据挖掘算法的话,可以看一看Weka的接口文档。

在Weka中集成自己的算法甚至借鉴它的方法自己实现可视化工具并不是件很困难的事情。

2.Weka启动打开Weka主界面后会出现一个对话框,如图:主要使用右方的四个模块,说明如下:❑Explorer:使用Weka探索数据的环境,包括获取关联项,分类预测,聚簇等;❑Experimenter:运行算法试验、管理算法方案之间的统计检验的环境;❑KnowledgeFlow:这个环境本质上和Explorer所支持的功能是一样的,但是它有一个可以拖放的界面。

它有一个优势,就是支持增量学习;❑SimpleCLI:提供了一个简单的命令行界面,从而可以在没有自带命令行的操作系统中直接执行Weka命令(某些情况下使用命令行功能更好一些)。

3.主要操作说明点击进入Explorer模块开始数据探索环境。

3.1主界面进入Explorer模式后的主界面如下:3.1.1标签栏主界面最左上角(标题栏下方)的是标签栏,分为五个部分,功能依次是:❑Preprocess(数据预处理):选择和修改要处理的数据;❑Classify(分类):训练和测试关于分类或回归的学习方案;❑Cluster(聚类):从数据中学习聚类;❑Associate(关联):从数据中学习关联规则;❑Select attributes(属性选择):选择数据中最相关的属性;❑Visualize(可视化):查看数据的交互式二维图像。

3.1.2载入、编辑数据标签栏下方是载入数据栏,功能如下:❑Open file:打开一个对话框,允许你浏览本地文件系统上的数据文件(.dat);❑Open URL:请求一个存有数据的URL 地址;❑Open DB:从数据库中读取数据;❑Generate:从一些数据生成器中生成人造数据。

3.1.3其他界面说明接下来的主界面中依次是Filter(筛选器),Currtent relation(当前关系)、Attributes(属性信息)、Selected attribute(选中的属性信息)以及Class(类信息),分别介绍如下:❑Filter在预处理阶段,可以定义筛选器来以各种方式对数据进行变换。

Filter 一栏用于对各种筛选器进行必要设置。

Filter一栏的左边是一个Choose 按钮。

点击这个按钮就可选择Weka中的某个筛选器。

用鼠标左键点击这个choose左边的显示框,将出现GenericObjectEditor对话框。

用鼠标右键点击将出现一个菜单,你可从中选择,要么在GenericObjectEditor对话框中显示相关属性,要么将当前的设置字符复制到剪贴板。

❑Currtent relation显示当前打开的数据文件的基本信息:Relation(关系名),Instances(实例数)以及Attributes (属性个数)。

❑Attributes显示数据文件中的属性信息,并且包含四个操作按键:❑All:所有选择框都被勾选;❑None:所有选择框被取消;❑Invert:已勾选的选择框都被取消,反之亦然;❑Pattern:让用户基于Perl 5正则表达式来选择属性。

例如,用*_id选择所有名称以_id结束的属性。

底下显示的就是数据文件包含的属性,可以进行勾选等操作。

特别地,当数据预处理是不要某个属性时,将其各选,点击列表正下方的Remove按键即可删除这一属性:❑Selected attribute显示勾选的属性的基本信息。

❑Class显示属性中数据元组的直方图。

点击Visualize all按键可以查看所有属性中元组的直方图。

3.2实现基本数据挖掘功能:3.2.1 Associate(关联规则)注意:目前,Weka的关联规则分析功能仅能用来作示范,不适合用来挖掘大型数据集。

各部分功能说明如下:❑Associator切换到Associate选项卡。

单击choose按键,可以选择关联规则算法,系统默认关联规则分析算法是Apriori算法。

选择关联规则算法后,点Choose右边的文本框修改默认的参数,弹出的窗口中点More可以看到各参数的说明。

一下简列几项:upperBoundMinSupport:最小支持度上限removeAllMissingCols :移除具有遗失值的列lowerBoundMinSupport :最小支持度下限outputItemSets :如果有可能也输出项集significanceLevel:显著性水平classIndex:确定分类属性,如果设为-1,则最后一个属性为分类属性treatZeroAsMissing :将遗失值全部置为0numRules:在某种关联规则下取出的满足条件的规则数;metricType:关联、程度指标;注意:各种关联规则算法都是尤其使用范围的,并不是所有的属性的数据类型都能被某一算法处理,典型的例如Apriori算法。

因此可以在choose下拉菜单中选择Filter选项,在其中勾选待处理数据的属性的类型以滤除无法使用的算法。

要想知道每种算法都是用哪些数据类型,可以左击choose旁边的文本框,在弹出的菜单栏中单击capabilities选项可以看到这种算法能够处理的数据类型。

Result list点击Associator下方的start按键可以开始进行关联项分析,结果列表即出现在Result list中,右击出现更多选项可供选择。

Associator output这里显示关联分析结果,如图为一个例子:一次显示了10个符合条件的关联规则,并且在其后显示了关联规则的四项指标以供参考。

3.2.2 Classify(分类预测)该部分实现数据挖掘中的分类与预测功能,提供了各种主要的分类预测算法供使用者选择。

下面是界面各部分的介绍:❑Classifier在choose一栏中选择需要的分类算法,同样地方法,每当选择一个算法,这个算法便在choose左边的文本框中进行显示,单击他会出现一个菜单,其中包含了一些参数的设定和more 以及capabilities选项,欠着用来获取那些需要设定参数的具体信息,后者用来获取算法适合的属性数据类型,这一点是相似的,因此在对数据进行处理是也应该注意数据的属性类型,单击choose在下拉菜单中选择Filter按键可以进行数据类型的选择从而过滤掉不能使用的算法。

❑Test option提供四种测试模式:1. Using training set.根据分类器在用来训练的实例上的预测效果来评价它。

2. Supplied test set. 从文件载入的一组实例,根据分类器在这组实例上的预测效果来评价它。

点击Set…按钮将打开一个对话框来选择用来测试的文件。

3. Cross-validation.使用交叉验证来评价分类器,所用的折数填在Folds 文本框中。

4. Percentage split.从数据集中按一定百分比取出部分数据放在一边作测试用,根据分类器这些实例上预测效果来评价它。

取出的数据量由% 一栏中的值决定。

当一切准备就绪时,点击start按键开始分类过程,完成后Result list中会显示结果列表,并且Classifier output中会显示出结果。

右击Result list中的结果,可以看见多个选项,选择Visualize tree,新窗口里可以看到图形模式的决策树。

建议把这个新窗口最大化,然后点右键,选“Fit to screen”,可以把这个树看清楚些。

先运行一个结果解释其中一些内容,如图所示:第一行的Correctly Classified Instances表示当前参与分类的实例中被正确分类的实例数目,第二行Incorrectly Classified Instances表示未被正确分类的实例数目。

关于Confusion Matrix,解释如下:原本“pep”是“YES”的实例,有74个被正确的预测为“YES”,有64个错误的预测成了“NO”;原本“pep”是“NO”的实例,有30个被错误的预测为“YES”,有132个正确的预测成了“NO”。

74+64+30+132 = 300是实例总数,而(74+132)/300 = 0.68667正好是正确分类的实例所占比例。

这个矩阵对角线上的数字越大,说明预测得越好。

更多选项及解释内容参见:3.3.3Cluster(聚簇分析)聚簇分析的原理就是将为标定类的数据根据其相似性分为几个类,在同一类中的数据元组具有较强的相似性,而在不同类中的数据元组则没有相似性或者很弱。

现对其主要界面说明如下:❑Clusterer单击choose,在这里可以选择适当的聚簇算法,选择后该算法会出现在choose左边的文本框中,在单击弹出的菜单可以对参数进行设定。

同时在选择more或者capabilities选项可以查看每种设定表示的具体信息和该算法的适用范围(包括适用的数据类型信息等)。

❑Cluster modeCluster Mode一栏用来决定依据什么来聚类以及如何评价聚类的结果。

前三个选项和分类的情形是一样的:Use training set、Supplied test set 和Percentage split区别在于现在的数据是要聚集到某个类中,而不是预测为某个指定的类别。

第四个模式,Classes to clusters evaluation,是要比较所得到的聚类与在数据中预先给出的类别吻合得怎样。

和Classify面板一样,下方的下拉框是用来选择作为类别的属性的。

在Cluster mode 之外,有一个Store clusters for visualization的勾选框,该框决定了在训练完算法后可否对数据进行可视化。

设定按start开始进行,注意在其上方的可以允许我们忽略某些属性。

Result list与前面的情形一样,该栏对结果进行顺序显示。

右击每一项弹出选择菜单:如,Visualize cluster assignments和Visualize tree。

后者在它不可用时会变灰。

Clusterer output显示聚簇分析的结果。