信息论与编码原理_第7章_信道编码的基本概念

- 格式:ppt

- 大小:3.25 MB

- 文档页数:48

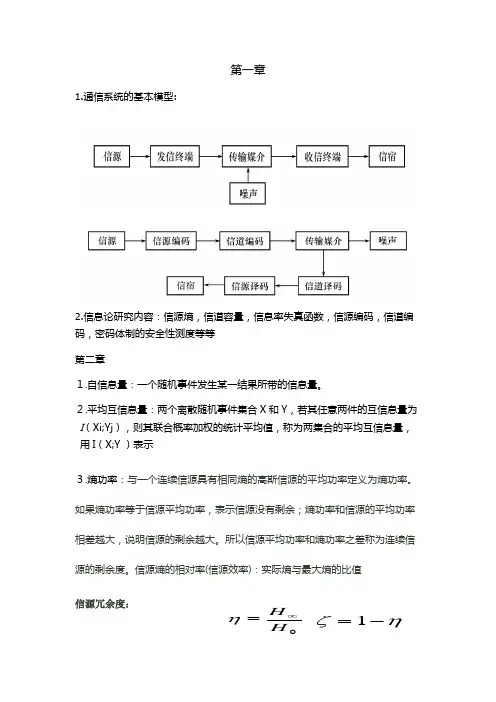

第一章1.通信系统的基本模型:2.信息论研究内容:信源熵,信道容量,信息率失真函数,信源编码,信道编码,密码体制的安全性测度等等第二章1.自信息量:一个随机事件发生某一结果所带的信息量。

2.平均互信息量:两个离散随机事件集合X 和Y ,若其任意两件的互信息量为 I (Xi;Yj ),则其联合概率加权的统计平均值,称为两集合的平均互信息量,用I (X;Y )表示3.熵功率:与一个连续信源具有相同熵的高斯信源的平均功率定义为熵功率。

如果熵功率等于信源平均功率,表示信源没有剩余;熵功率和信源的平均功率相差越大,说明信源的剩余越大。

所以信源平均功率和熵功率之差称为连续信源的剩余度。

信源熵的相对率(信源效率):实际熵与最大熵的比值信源冗余度:0H H ∞=ηηζ-=1意义:针对最大熵而言,无用信息在其中所占的比例。

3.极限熵:平均符号熵的N 取极限值,即原始信源不断发符号,符号间的统计关系延伸到无穷。

4.5.离散信源和连续信源的最大熵定理。

离散无记忆信源,等概率分布时熵最大。

连续信源,峰值功率受限时,均匀分布的熵最大。

平均功率受限时,高斯分布的熵最大。

均值受限时,指数分布的熵最大6.限平均功率的连续信源的最大熵功率:称为平均符号熵。

定义:即无记忆有记忆N X H H X H N X H X NH X H X H X H N N N N N N )()()()()()()(=≤∴≤≤若一个连续信源输出信号的平均功率被限定为p ,则其输出信号幅度的概率密度分布是高斯分布时,信源有最大的熵,其值为1log 22ep π.对于N 维连续平稳信源来说,若其输出的N 维随机序列的协方差矩阵C 被限定,则N 维随机矢量为正态分布时信源的熵最大,也就是N 维高斯信源的熵最大,其值为1log ||log 222N C e π+ 7.离散信源的无失真定长编码定理:离散信源无失真编码的基本原理原理图说明: (1) 信源发出的消息:是多符号离散信源消息,长度为L,可以用L 次扩展信源表示为: X L =(X 1X 2……X L )其中,每一位X i 都取自同一个原始信源符号集合(n 种符号): X={x 1,x 2,…x n } 则最多可以对应n L 条消息。

2.1信道编码原理

在一个噪声信道中,如果我们把调制/解调器和检测器看作是信道的一个组成部分。

那么一个数字通信系统模型可以用图2-1表示:(虚线框为假想的信道部分)

图2-1 数字通信系统模型

信道编码器的作用是以可控的方式在二进制信息序列里插入一些冗余度,以达到在接受端利用这些冗余度来克服信号在信道中受到的干扰和噪声的影响。

编码的一般过程是:每次取k 个比特的信息序列,把这个k 比特信息组映射成与之唯一对应的n 比特组,这些n 比特组称为码字。

在这种方式中,由信道编码引入的冗余量可以用比值/n k来衡量,该比值的倒数,即/k n称为码率。

信道编码器输出的二进制序列被送入调制器,进入信道。

调制器把二进制序列映射。

信息论与编码

信息论是一门研究信息传输、存储和处理的学科。

它的基本概念是由克劳德·香农于20世纪40年代提出的。

信息论涉及了许多重要的概念和原理,其中之一是编码。

编码是将信息从一种形式转换为另一种形式的过程。

在信息论中,主要有两种编码方式:源编码和信道编码。

1. 源编码(Source Coding):源编码是将信息源中的符号序列转换为较为紧凑的编码序列的过程。

它的目标是减少信息的冗余度,实现信息的高效表示和传输。

著名的源编码算法有霍夫曼编码和算术编码等。

2. 信道编码(Channel Coding):信道编码是为了提高信息在信道传输过程中的可靠性而进行的编码处理。

信道编码可以通过添加冗余信息来使原始信息转换为冗余编码序列,以增加错误检测和纠正的能力。

常见的信道编码算法有海明码、卷积码和LDPC码等。

编码在通信中起着重要的作用,它可以实现对信息的压缩、保护和传输的控制。

通过合理地选择编码方式和算法,可以在信息传输过程中提高传输效率和可靠性。

信息论和编码理论为信息传输和存储领域的发展提供了理论基础和数学工具,广泛应用于通信系统、数据压缩、加密解密等领域。

信息论与编码原理

信息论和编码原理是信息科学中重要的两个概念,它们对当今信息技术的发展有重要的影响。

信息论是探讨数据的数学理论,它主要研究在信息传输过程中,如何在有限的带宽和空间内有效地传输数据,从而获取最大的信息量。

它将信息压缩、加密、传输、解密等等放到一个数学模型中描述,以此提高信息的传输效率。

编码原理则是指在信息传输过程中,编码决定了有效传输的信息量。

编码是按照其中一种特定的规则将原信息转换成另一种形式的过程。

编码不仅能够减少上行数据量,还能增强安全性,防止数据在传输过程中的泄露,从而使信息可以被安全和精确地传输。

信息论和编码原理有着千丝万缕的关系,它们是相互依存的。

信息论提供了一个理论框架,以及不同的编码方法,来确定最适合特定情况下的信息传输效果。

然而,编码原理则可以提供不同编码方法,以根据信息论的模型,合理有效地进行信息传输。

因此,信息论和编码原理是相辅相成的。

当今,信息论和编码原理已成为当今信息技术发展的基础。

数学中的信息论与编码理论在没有信息论和编码理论的帮助下,我们现代社会的通信系统几乎无法存在。

信息论和编码理论是数学中一个重要的分支,它们的发展不仅深刻影响了通信技术的进步,也在其他领域起到了重要的作用。

本文将探讨数学中的信息论与编码理论的基本概念和应用。

一、信息论信息论是由美国数学家克劳德·香农在20世纪40年代提出的一门学科。

它的研究对象是信息,旨在衡量信息的传输效率和极限。

那么,什么是信息?信息是我们从一个消息中获得的知识或内容。

在信息论中,信息量的单位被称为“比特”(bit),它表示信息的最基本单位。

例如,当我们投掷一枚公平的硬币,出现正面的概率为50%,我们可以用1比特来表示这个消息,因为它提供了一个二进制的选择(正面或反面)。

在信息论中,还有一个重要的概念是“信息熵”。

信息熵用来衡量一个随机变量的不确定性。

一个有序的事件具有较低的信息熵,而一个随机的事件具有较高的信息熵。

例如,当我们已知一个硬币是公平的时候,投掷获得的信息熵最高,因为我们无法预测结果。

二、编码理论编码理论是信息论的一个重要组成部分。

它研究如何将信息转化为机器能够识别和处理的形式。

编码理论可以分为源编码和信道编码两个方面。

1. 源编码源编码是将源数据(比如文本、图像、声音等)进行压缩和表示的过程。

它的目标是将数据表示为更紧凑的形式,以便于存储和传输。

最著名的源编码算法之一是赫夫曼编码,它利用不同符号出现的频率进行编码,将出现频率较高的符号用较短的编码表示,从而实现数据的压缩。

2. 信道编码信道编码是为了在噪声干扰的信道中可靠地传输信息而设计的编码方法。

它通过引入冗余来纠正或检测传输过程中的错误。

最常见的信道编码方法是奇偶校验码和循环冗余检验码(CRC)。

这些编码方法能够检测和校正一定数量的错误,从而提高传输的可靠性。

三、信息论与编码理论的应用信息论和编码理论不仅在通信领域中发挥着重要作用,也在其他领域有广泛的应用。

信息论中的信息传输与信道编码信息论是一门研究信息传输与编码的学科,它的产生与发展始于20世纪40年代,其核心理论是由克劳德·香农于1948年提出的。

信息传输是指将信息从一个地方传递到另一个地方的过程,而信道编码则是指在信息传输的过程中,通过采用适当的编码方式来提高传输的可靠性以及效率。

1. 信息传输的基本原理信息传输是通过信号或消息的传递来实现的。

在信息论中,消息是指所要传递的信息内容,而信号则是指用来携带消息的物理量或波形。

信息传输的基本原理可概括为三个步骤:信源编码、信道传输和信宿解码。

1.1 信源编码信源编码是将待传输的消息进行编码,以便在信道传输中降低传输所需的带宽。

常用的信源编码方式包括香农-福普编码和哈夫曼编码等。

1.2 信道传输信道传输是指将编码后的信号通过信道传递到接收端。

信道可以是有线或无线的媒介,如光纤、电缆或无线电波等。

在信道传输过程中,信号可能会受到噪声的干扰,从而导致信息的丢失或错误。

1.3 信宿解码信宿解码是指在接收端对传输过来的信号进行解码,以恢复出原始的消息。

解码过程需要考虑信道传输过程中可能引入的噪声和误码等问题,并通过适当的解码算法进行纠正。

2. 信道编码的作用信道编码是信息论中的重要概念,它的主要作用是提高信道传输的可靠性和效率。

信道编码通过向待传输的消息添加冗余信息,使得在信道传输过程中能够检测和纠正部分错误,从而提高系统的抗干扰能力。

2.1 基本概念在信道编码中,常用的两个重要概念是编码率和纠错能力。

编码率是指在给定的信道条件下,传输的有效信息所占的比例。

纠错能力是指编码算法能够对传输过程中的错误进行检测和纠正的能力。

2.2 常用的信道编码方式常见的信道编码方式包括前向纠错编码(FEC)和自动重传请求(ARQ)等。

前向纠错编码通过在消息中添加冗余信息,使接收端能够检测和纠正部分错误。

而自动重传请求则是在接收端检测到错误时,向发送端请求重新发送丢失或错误的信息。

信息论与编码原理

信息论与编码原理是一门研究信息传输和编码方法的学科。

在信息论中,我们关注的是如何在信息传输过程中最大限度地减少误差或失真。

在信息传输中,我们要面对的主要问题是噪声的存在。

噪声是由于信道的不完美而引起的,它会引入误差,导致信息的失真。

为了减少误差,我们需要设计一套有效的编码方案。

编码的目标是通过改变信息的表示方式,使得信息能够在信道中更好地传输。

信息的编码可以分为两个阶段:源编码和信道编码。

源编码是将输入的信息进行压缩,减少信息的冗余性,以便更有效地传输。

信道编码则是为了增强信息的可靠性,通过引入冗余来提高抗干扰能力,使得信息能够在不完美的信道中更好地传输。

在源编码中,我们常用的方法有霍夫曼编码和算术编码。

这些方法可以根据不同符号出现的概率来选择合适的编码方式,以提高传输效率。

在信道编码中,我们主要使用纠错编码,如海明编码和卷积码。

这些编码可以通过添加额外的冗余信息,使得接收端可以检测和纠正部分错误,提高传输的可靠性。

此外,在信息论中还有一个重要的概念是信息熵。

信息熵可以用来度量一个随机变量的不确定性。

通过熵的计算,我们可以了解信源输出的平均信息量,从而为编码方案的设计提供指导。

总之,信息论与编码原理是一门非常重要的学科,它不仅为我

们提供了有效的信息传输和编码方法,还给我们提供了理论基础,帮助我们理解信息的本质和传输过程中的各种问题。