第6 章 最大似然估计法

- 格式:pdf

- 大小:182.84 KB

- 文档页数:27

概率论与数理统计期末复习重要知识点第二章知识点:1.离散型随机变量:设X 是一个随机变量,如果它全部可能的取值只有有限个或可数无穷个,则称X 为一个离散随机变量。

2.常用离散型分布:(1)两点分布(0-1分布): 若一个随机变量X 只有两个可能取值,且其分布为12{},{}1(01)P X x p P X x p p ====-<<,则称X 服从12,x x 处参数为p 的两点分布。

两点分布的概率分布:12{},{}1(01)P X x p P X x pp ====-<<两点分布的期望:()E X p =;两点分布的方差:()(1)D X p p =-(2)二项分布:若一个随机变量X 的概率分布由式{}(1),0,1,...,.k kn k n P x k C p p k n -==-=给出,则称X 服从参数为n,p 的二项分布。

记为X~b(n,p)(或B(n,p)).两点分布的概率分布:{}(1),0,1,...,.k k n kn P x k C p p k n -==-= 二项分布的期望:()E X np =;二项分布的方差:()(1)D X np p =-(3)泊松分布:若一个随机变量X 的概率分布为{},0,0,1,2,...!kP X k ek k λλλ-==>=,则称X 服从参数为λ的泊松分布,记为X~P (λ)泊松分布的概率分布:{},0,0,1,2,...!kP X k ek k λλλ-==>=泊松分布的期望:()E X λ=;泊松分布的方差:()D X λ=4.连续型随机变量:如果对随机变量X 的分布函数F(x),存在非负可积函数()f x ,使得对于任意实数x ,有(){}()xF x P X x f t dt-∞=≤=⎰,则称X 为连续型随机变量,称()f x 为X 的概率密度函数,简称为概率密度函数。

5.常用的连续型分布: (1)均匀分布:若连续型随机变量X 的概率密度为⎪⎩⎪⎨⎧<<-=其它,0,1)(bx a a b x f ,则称X 在区间(a,b )上服从均匀分布,记为X~U(a,b)均匀分布的概率密度:⎪⎩⎪⎨⎧<<-=其它,0,1)(b x a a b x f 均匀分布的期望:()2a bE X +=;均匀分布的方差:2()()12b a D X -= (2)指数分布:若连续型随机变量X 的概率密度为00()0xe xf x λλλ-⎧>>=⎨⎩,则称X 服从参数为λ的指数分布,记为X~e (λ)指数分布的概率密度:00()0xe xf x λλλ-⎧>>=⎨⎩指数分布的期望:1()E X λ=;指数分布的方差:21()D X λ=(3)正态分布:若连续型随机变量X的概率密度为22()2()x f x x μσ--=-∞<<+∞则称X 服从参数为μ和2σ的正态分布,记为X~N(μ,2σ)正态分布的概率密度:22()2()x f x x μσ--=-∞<<+∞正态分布的期望:()E X μ=;正态分布的方差:2()D X σ=(4)标准正态分布:20,1μσ==,2222()()x t xx x e dtϕφ---∞=标准正态分布表的使用: (1)()1()x x x φφ<=--(2)~(0,1){}{}{}{}()()X N P a x b P a x b P a x b P a x b b a φφ<≤=≤≤=≤<=<<=-(3)2~(,),~(0,1),X X N Y N μμσσ-=故(){}{}()X x x F x P X x P μμμφσσσ---=≤=≤={}{}()()a b b a P a X b P Y μμμμφφσσσσ----<≤=≤≤=-定理1: 设X~N(μ,2σ),则~(0,1)X Y N μσ-=6.随机变量的分布函数: 设X 是一个随机变量,称(){}F x P X x =≤为X 的分布函数。

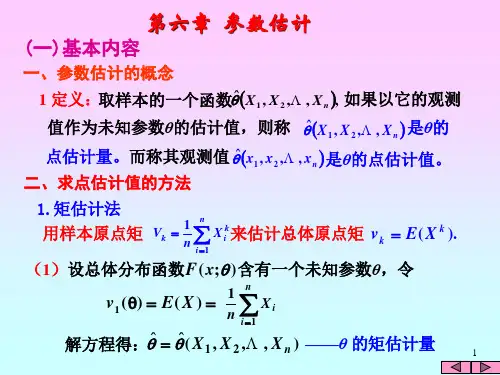

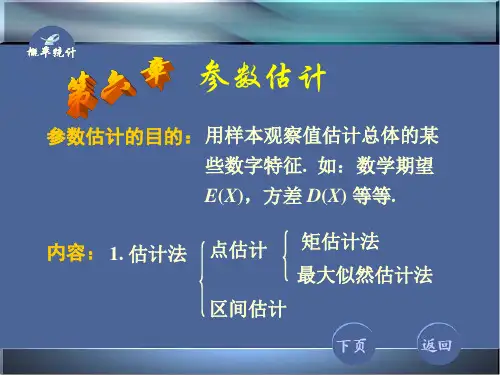

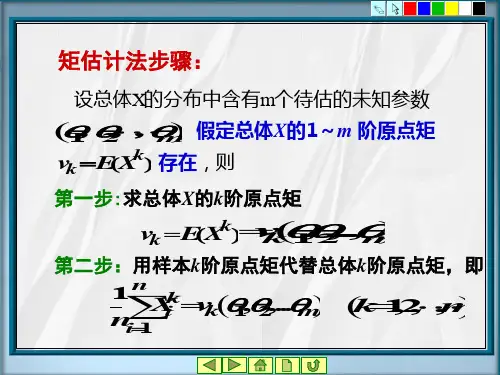

113第六章 参数估计一、 知识点1. 点估计的基本概念2. 点估计的常用方法(1) 矩估计法① 基本思想:以样本矩作为相应的总体矩的估计,以样本矩的函数作为相应的总体矩的同一函数的估计。

(2) 极大似然估计法设总体X 的分布形式已知,其中),,,(21k θθθθΛ=为未知参数,),,(21n X X X Λ为简单随机样本,相应的),,,(21n x x x Λ为它的一组观测值.极大似然估计法的步骤如下:① 按总体X 的分布律或概率密度写出似然函数∏==ni i n x p x x x L 121);();,,,(θθΛ (离散型)∏==ni i n x f x x x L 121);();,,,(θθΛ (连续型)若有),,,(ˆ21nx x x Λθ使得);,,,(max )ˆ;,,,(2121θθθn n x x x L x x x L ΛΛΘ∈=,则称这个θˆ为参数θ的极大似然估计值。

称统计量),,,(ˆ21nX X X Λθ为参数θ的极大似然估计量。

② 通常似然函数是l θ的可微函数,利用高等数学知识在k θθθ,,,21Λ可能的取值范围内求出参数的极大似然估计k l x x x nl l ,,2,1),,,,(ˆˆ21ΛΛ==θθ 将i x 换成i X 得到相应的极大似然估计量k l X X X nl l ,,2,1),,,,(ˆˆ21ΛΛ==θθ 注:当);,,,(21θn x x x L Λ不可微时,求似然函数的最大值要从定义出发。

3. 估计量的评选标准(1) 无偏性:设),,(ˆˆ21nX X X Λθθ=是参数θ的估计量,如果θθ=)ˆ(E ,则称θˆ为θ的无偏估计量。

(2) 有效性:设1ˆθ,2ˆθ是θ的两个无偏估计,如果)ˆ()ˆ(21θθD D ≤,则称1ˆθ较2ˆθ更有效。

4. 区间估计114 (1) 定义 设总体X 的分布函数族为{}Θ∈θθ),;(x F .对于给定值)10(<<αα,如果有两个统计量),,(ˆˆ111n X X Λθθ=和),,(ˆˆ122n X X Λθθ=,使得{}αθθθ-≥<<1ˆˆ21P 对一切Θ∈θ成立,则称随机区间)ˆ,ˆ(21θθ是θ的双侧α-1置信区间,称α-1为置信度;分别称1ˆθ和2ˆθ为双侧置信下限和双侧置信上限. (2) 单侧置信区间(3) 一个正态总体下未知参数的双侧置信区间(置信度为α-1)二、 习题 1. 选择题(1) 设n X X X ,,,21Λ是来自总体X 的一个样本,则以下统计量①)(211n X X + ②)2(14321n X X X X X n ++++-Λ ③)2332(101121n n X X X X +++-作为总体均值μ的估计量,其中是μ的无偏估计的个数是A.0B.1C.2D.3(2) 设321,,X X X 是来自正态总体)1,(μN 的样本,现有μ的三个无偏估计量321332123211216131ˆ;1254131ˆ;2110351ˆX X X X X X X X X ++=++=++=μμμ其中方差最小的估计量是A.1ˆμB.2ˆμC. 3ˆμD.以上都不是 (3) 设0,1,0,1,1为来自0-1分布总体B(1,p)的样本观察值,则p 的矩估计值为 。

最大似然估计计算公式

最大似然估计是一种常用的参数估计方法,它通过寻找最大化给定数据集的概率来估计参数的值。

在统计学中,我们经常面对未知参数的情况,而最大似然估计提供了一种有效的方法来估计这些参数。

在最大似然估计中,我们假设数据是从一个特定的概率分布中抽取的,并且我们希望找到使得这个数据集出现的概率最大的参数值。

换句话说,最大似然估计就是在给定数据集的情况下,寻找最有可能产生这个数据集的参数值。

举个例子来说,假设我们有一个硬币,我们不知道它是正面朝上的概率是多少。

我们可以进行一系列的抛硬币实验,然后利用这些实验的结果来估计这个概率。

最大似然估计就是通过最大化观测到的数据集出现的概率,来估计这个硬币正面朝上的概率。

在实际应用中,最大似然估计通常会涉及到一些复杂的数学计算,但是其基本思想是非常直观的。

通过找到使得观测数据出现概率最大的参数值,我们可以得到对未知参数的估计,从而对数据进行分析和预测。

最大似然估计在统计学中有着广泛的应用,比如在线性回归、逻辑回归、朴素贝叶斯分类器等模型中都会用到最大似然估计来估计参数。

它不仅在理论上具有重要意义,而且在实际应用中也被广泛采用。

总的来说,最大似然估计是一种重要的参数估计方法,通过最大化观测数据的出现概率来估计参数的值。

它在统计学中有着广泛的应用,是数据分析和模型建立中不可或缺的一部分。

通过深入理解最大似然估计的原理和应用,我们可以更好地理解数据背后的规律,从而做出更准确的预测和决策。

最大似然相位估计最大似然相位估计是一种常用的参数估计方法,在信号处理和通信领域有广泛的应用。

该方法基于最大似然估计原理,通过寻找能使观测信号的概率密度函数达到最大的参数值来估计信号的相位。

最大似然相位估计方法可以有效地提取信号中的相位信息,对于提高信号的解调和恢复的性能具有重要的意义。

在估计信号相位的问题中,通常假设信号是高斯分布的,且只有相位是未知的,其它参数如幅度和频率是已知的。

基于这些假设,可以通过对信号进行采样和处理,利用最大似然估计方法估计信号的相位。

最大似然相位估计方法的核心思想是找到最大化似然函数的参数值。

似然函数是给定观测信号的条件下,参数的取值的概率密度函数。

通过对似然函数取对数,可以将似然函数的最大化问题转化为最小化问题。

最大似然估计方法的目标是找到使似然函数取最小值的参数。

最大似然相位估计方法的具体实现步骤如下:1. 建立似然函数:首先根据观测信号的概率密度函数和已知参数,建立似然函数。

通常假设观测信号为高斯分布,因此似然函数可以表示为观测信号的概率密度函数。

2. 取对数化:对似然函数取对数,将似然函数的最大化问题转化为最小化问题。

对数化后的似然函数通常被称为对数似然函数。

3. 求导计算:对对数似然函数进行求导,计算其关于参数的一阶导数。

根据导数为零的条件,求得使对数似然函数取最小值的参数值。

4. 解方程求解:将导数为零的条件转化为方程,通过求解方程得到参数的估计值。

在实际计算中,通常采用迭代方法求解方程。

最大似然相位估计方法的优点是估计结果的无偏性和一致性,即在样本数量趋于无穷的情况下,估计值将无偏且收敛于真实值。

此外,最大似然相位估计方法在高斯噪声下具有最小均方误差的性质,可以提高信号的解调和恢复的性能。

然而,最大似然相位估计方法也存在一些限制。

首先,该方法对于非高斯分布的观测信号不适用。

其次,在实际应用中,观测信号通常存在噪声的影响,噪声的存在会导致估计结果的偏差。

因此,需要对噪声进行建模,并考虑噪声对估计结果的影响。

第六章 参数估计一、教材说明本章内容包括参数估计中基本的概念、参数估计的两种方法及评价估计量的四个标准.它们是参数估计最基本的内容,是以后学习参数估计其他内容的基础.1、 教学目的与教学要求(1) 使学生了解参数估计中最基本的点估计及相关概念; (2) 使学生掌握矩估计及最大似然估计的方法;(3) 使学生掌握评价估计量优劣的四个标准,尤其是前三个标准; (4) 使学生了解矩估计、最大似然估计的原理. 2、 本章的重点本章重点是求未知参数的矩估计与最大似然估计的方法以及如何对求出的估计量的优良性进行评价.二、教学内容本章主要分2节来讲述.一、参数估计问题这里所指的参数是指如下三类未知参数:1、 类型已知的分布中所含的未知参数θ.如二点分布b(1, p )中的概率p ;正态分布),(2σμN 中的μ和2σ;2、 分布中所含的未知参数θ的函数:如正态分布),(2σμN 的变量X 不超过给定值a 的概率)()(σμ-Φ=≤a a X P 是未知参数σμ,的函数;3、 分布的各种特征数也都是未知参数,如均值EX ,方差VarX ,分布中位数等等. 一般场合,常用θ表示参数,参数θ所有可能取值的集合称为参数空间,记为Θ.参数估计问题就是根据样本对上述各种参数做出估计.二、概率函数总体X 的概率函数),(θx p 是指:当X 为离散型总体时,),(θx p 就是总体的分布列;当X 为连续性总体时,),(θx p 就是总体的密度函数.三、参数估计形式分为点估计与区间估计.设n x x x ,,,21 是来自总体的样本,我们用一个统计量),,(1^^n x x θθ=的取值作为θ的估计值,^θ称为θ的点估计量,简称估计.若给出参数θ的估计是一个随机区间),(θθ,使这个区间),(θθ包含参数真值的概率大到一定程度,此时称),(θθ为参数θ的区间估计.§6.1点估计的几种方法教学目的:要求学生了解参数点估计的基本思想,理解参数点估计的基本概念,熟练运用替换原理、矩法估计和最大似然估计对参数进行估计.教学重点:矩法估计、最大似然估计.教学难点:运用矩法估计、最大似然估计对参数进行估计.教学内容:本节内容包括替换原理及矩法估计,最大似然估计.6.1.1 替换原理及矩法估计用样本矩去替换总体矩(矩可以是原点矩也可以是中心矩),用样本矩的函数去替换总体矩的函数,这就是替换原理.用替换原理得到的未知参数的估计量称为矩法估计.注 矩法估计适用于总体分布形式未知场合,因此只要知道总体相应的矩即可,而不必知道其具体分布. 一 矩法估计在总体分布位置的情况下,用样本矩去替换总体矩 如 用样本均值x 估计总体均值()E X ,即^()=E X x . 用样本方差2n s 估计总体方差Var()X ,即^2ar()=s n V X用事件A 出现的频率 估计事件A 发生的概率用样本p 分位数估计总体的p 分位数,特别地,用样本中位数去估计总体中位数. 例6.1.1 对某型号的20辆汽车记录其每5L 汽油的行驶里程,观测数据如下: 29.8 27.6 28.3 27.9 30.1 28.7 29.9 28.0 27.9 28.7 28.4 27.2 29.5 28.5 28.0 30.0 29.1 29.8 29.6 26.9经计算可得=28.695x ,2=0.9185n s ,0.5=28.6m ,由此给出总体均值,方差和中位数的估计分别为28.695,0.9185,28.6.二 概率函数),(θx p 已知时未知参数的矩法估计设总体的概率函数)(1k x p θθ,,; ,Θ∈),,(1k θθ 是未知参数,n x x x ,,,21 是 总体X 的样本,若)(kX E 存在,则)(jX E k j ,<∀存在.设k j X E k j j j ,,2,1),,,(1 ===θθνμ)(,如果k θθ,,1 也能够表示成k μμ,,1 的函数k j k j j ,,2,1),,,(1 ==μμθθ,则可给出j θ的矩估计量为k j a a k j j ,,2,1),,,(ˆˆ1 ==θθ,其中k j x n a n i ji j ,,2,1,11==∑=设),,(1k g θθη =是k θθ,,1 的函数,则利用替换原理可得到η的矩估计量)ˆ,,ˆ(ˆ1kg θθη =,其中j θˆ是j θ的矩估计,k j ,,2,1 =. 例6.1.2 设总体为指数分布,其密度函数为0,);(>=-x e x p xλλλ,n x x x ,,,21 为样本,0>λ为未知参数,求λ的矩估计.解 λλ1),(~=∴EX Exp X ,EX 1=∴λ,x1ˆ=∴λ为λ的矩估计. 注 21),(~λλ=∴VarX Exp X ,VarX1=∴λ SS 11ˆ2==∴λ也为λ的矩估计.因此矩估计不唯一,此时,尽量采用低阶矩给出未知参数的估计.例6.1.3 设总体],[~b a U X ,n x x x ,,,21 为样本,求b a ,的矩估计.解 12)(,2],,[~2a b VarX b a EX b a U X -=+=∴ 由⎪⎩⎪⎨⎧-=+=12)(22a b VarX b a EX ,得⎩⎨⎧+=-=VarX EX b VarX EX a 33, 所以b a ,的矩估计为ˆˆax b x ⎧=-⎪⎨=⎪⎩三 矩估计的步骤(1)计算总体的各阶矩jEX ,k j ,,2,1 =,令k j EX k j j j ,,2,1),,,(1 ===θθνμ;(2)解出j θ,即k j k j j ,,2,1),,,(1 ==μμθθ;(3)令k j a a k j j ,,2,1),,,(ˆˆ1 ==θθ,其中k j x n a n i ji j ,,2,1,11==∑=;(4)若),,(1k g θθη =,则)ˆ,,ˆ(ˆ1k g θθη =为η的矩估计量. 6.1.2 最大似然估计最大似然原理一个试验有若干个可能的结果A ,B ,C , ,若在一次试验中结果A 出现,则一般认为试验条件对结果A 出现有利,也即A 出现的概率最大.例6.1.4 设有外形完全相同的两个箱子,甲箱有99个白球和一个黑球,乙箱有99个黑球和一个白球,今随机抽取一箱,并从中随机抽取一球,如果取出白球,问这球是从哪一箱取出的?解 从甲乙两箱均可取出白球,但计算得P (取出白球甲箱)10099=〉〉P (取出白球乙箱)1001= 据最大似然原理,则认为该球是从甲箱取出的.例 6.1.5 产品分为合格品和不合格品两类,用随机变量X 表示某个产品是否合格,0=X 表示合格品,1=X 表示不合格品,从而),1(~p b X ,其中p 未知是不合格品率,现抽取n 个产品看是否合格,得到样本n x x x ,,,21 ,这批观测值发生的概率为:∑-∑=-=========-=-=∏∏ni ini iiix n x ni x x ni i i n n p pp p x X p x X x X x X p p L 11)1()1()(),,,()(1112211当n x x x ,,,21 已知时,)(p L 仅是p 的函数,既然一次抽样观测到n x x x ,,,21 ,此时应认为试验条件对该组样本的出现有利,即该组样本出现的概率最大,从而可求出当p =?时)(p L 达到最大,此时把求出的p =?做为参数p 的估计就得到p 的最大似然估计,问题转化为求)(p L 的最大值点.如果总体为连续型的,求未知参数的最大似然估计仍可转化为求)(p L 的最大值点问题.为此给出似然函数与最大似然估计的定义. 似然函数与最大似然估计定义 6.1.1 设总体X 的概率函数为Θ∈θθ),;(x p 是一个未知参数或几个未知参数组成的参数向量, n x x x ,,,21 为来自总体X 的样本,称样本的联合概率函数为似然函数,用),,;(1n x x L θ表示,简记为)(θL ,即∏===ni i n x p x x L L 11),(),,;()(θθθ如果统计量),,,(ˆˆ21nx x x θθ=满足 )(max )ˆ(θθθL L Θ∈= 则称),,,(ˆˆ21nx x x θθ=是θ的最大似然估计,简记为MLE. 由于x ln 是x 的单调增函数,因此对数似然函数)(ln θL 达到最大与似然函数)(θL 达到最大是等价的.求最大似然估计的两种方法 (1)似然方程法当)(θL 是可微函数时,)(θL 的极大值点一定是驻点,从而求最大似然估计往往借助于求下列似然方程(组)0)(ln =∂∂θθL 的解得到,而后利用最大值点的条件验证求出的是最大值点.例6.1.6 设一个试验有三种可能结果,其发生概率分别为23221)1(),1(2,θθθθ-=-==p p p ,现做了n 次实验,观测到三种结果发生的次数分别是321,,n n n ,求θ的最大似然估计.解 略.例6.1.7对正态总体),(2σμN ,),(2σμθ=是二维参数, n x x x ,,,21 为其样本,求2,σμ的最大似然估计.解:R x ex f X x ∈=--222)(21),;(~σμσπσμ所以似然函数为:∏=----∑===-ni x ni i ni x eeL 1)(22122212222)()2(21),(μσσμπσσπσμ取对数:∑=--+-=ni ixn L 12222)(21)ln 2(ln 2),(ln μσσπσμ分别对μ,2σ求导数:⎪⎪⎩⎪⎪⎨⎧=-+-=∂∂=-=∂∂∑∑==n i i ni i x n L x L 12422120ˆ)(212)(ln 0ˆ)(1)(ln μσσσμσμ )2()1(由(1)11n i i x x n =⇒μ==∑,代入(2)2221111()()n n i i i i x x x n n ==⇒σ=-μ=-∑∑∴2,σμ的极大似然估计值分别为: x x n n i i ==∑=11ˆμ;∑=-=n i i x x n 122)(1ˆσ 2,μσ的极大似然估计量分别为:11ˆn i i X x n μ===∑,222*11ˆ(-)n i i x x s n σ===∑ (2)定义法虽然求导函数是求最大似然估计量最常用的方法,但并不是所有场合求导都是有效的. 例6.1.8 设n x x x ,,,21 是均匀分布),0(~θU X 的样本,求θ的最大似然估计. 解:由已知X 概率函数为10(,)=0x p x θθθ⎧<≤⎪⎨⎪⎩,,其它(θ>0)设n x x x ,,,21 为取自X 的样本则,()11,0<()=;0,ni ni i x L f x θθθθ=⎧≤⎪=⎨⎪⎩∏其它⎪⎩⎪⎨⎧≤≤<=≤≤≤≤其它,0}{}{min 0111θθi ni i ni n x man x ,由于(,)p x θ与θ有关,不存在易解的似然方程,我们由定义,找)(θL 的最大值点,由)(θL 的表达式,θ越小nL θθ1)(=就越大因)(}{max n i L x x =≥θ,所以)(n x =θ时)(θL 达极大. 最大似然估计的不变性性质 如果θˆ是θ的最大似然估计,则对任一函数)(θg ,)ˆ(θg 是)(θg 的最大似然估计. 注 上述性质称为最大似然估计的不变性,从而使求复杂结构的参数的最大似然估计变得容易,具体应用略.例6.1.9 对正态总体),(2σμN ,),(2σμθ=是二维参数, n x x x ,,,21 为其样本,已知2,σμ的最大似然估计:11ˆn i i X x n μ===∑,222*11ˆ(-)n i i x x s n σ===∑,有最大似然估计的不变性可得标准差σ的MLE 为2*ˆs σ=, 概率3-(<3)=()P X μσΦ的MLE 为*3-()xsΦ, 总体0.90分位数0.900.90=+x u μσ⋅的MLE 为*0.90+x s u ⋅.§6.2点估计的评价标准教学目的:要求学生了解相合性、无偏性、有效性和均方误差的基本思想,理解相合性、无偏性、有效性和均方误差的基本概念,熟练掌握相合性、无偏性和有效性的判别方法.教学重点:相合估计、无偏估计和有效性.教学难点:如何确定相合估计、无偏估计和有效性.教学内容:本节内容包括相合性,无偏性,有效性和均方误差.我们已经看到,点估计有各种不同的求法,为了在不同的点估计间进行比较选择,就必须对各种点估计的好坏给出评价标准.数理统计中给出了众多的估计量评价标准,对同一估计量使用不同的评价标准可能会得到完全不同的结论,因此,在评价某一个估计好坏时,首先要说明是在哪一个标准下,否则所论好坏则毫无意义.但不管怎么说,有一个基本标准是所有的估计都应该满足的,它是衡量估计是否可行的必要条件,这就是估计的相合性.6.2.1 相合性定义6.2.1 设Θ∈θ为未知参数,),,,(ˆˆ21nn n x x x θθ=是θ的一个估计量,n 是样本容量,若对任一0>ε 有0)ˆ(lim =>-∞→εθθnn P 即),,,(ˆˆ21n n n x x x θθ=依概率收敛于θ,则称),,,(ˆˆ21nn n x x x θθ=为θ的相合估计. 相合性被认为是对估计的一个最基本要求,如果一个估计量在样本量不断增大时,它都不能把被估参数估计到任意指定的精度,那么这个估计是很值得怀疑的,通常,不满足相合性要求的估计一般不予考虑.注 证明估计的相合性一般可应用大数定律或直接用定义来证,有时借助于依概率收敛的性质.例6.2.1设n x x x ,,,21 是来自正态总体),(2σμN 的样本,则由辛钦大数定律及依概率收敛的性质知 :x 是μ的相合估计,*2s 是2σ的相合估计,2s 也是2σ的相合估计.相合性的判别定理定理6.2.1 设),,,(ˆˆ21nn n x x x θθ=是θ的一个估计量,若 0ˆlim ,ˆlim ==∞→∞→nn n n Var E θθθ 则),,,(ˆˆ21nn n x x x θθ=是θ的相合估计. 证明 由切比雪夫不等式知:0>∀ε有22)ˆ()ˆ(εθθεθθ-≤≥-nnE P222ˆ2ˆ)ˆ(θθθθθθ+-=-)()(n n n E E E 22ˆ2)ˆˆθθθθθ+-+=)(()(n n n E E Var=-∴∞→2)ˆ(lim θθn n E ]ˆ2)ˆ(ˆ[lim 22θθθθθ+-+∞→nn n n E E Var 02022=+⨯-+=θθθθ 所以 0)ˆ(lim )ˆ(lim 022=-≤≥-≤∞→∞→εθθεθθn n n n E P 所以0)ˆ(lim =≥-∞→εθθnn P .例 6.2.2 设n x x x ,,,21 是均匀分布),0(~θU X 的样本,证明:θ的最大似然估计)(ˆn x =θ是θ的相合估计. 分析 直接验证定理6.2.1的条件.证明 略.定理 6.2.2 若nk n n θθθˆ,,ˆ,ˆ21 分别是k θθ,,1 的相合估计,),,(1k g θθη =是k θθ,,1 的连续函数,则)ˆ,,ˆ(ˆ1nkn n g θθη =是),,(1k g θθη =的相合估计, 证明 略.例 6.2.3 设一个试验有三种可能结果,其发生概率分别为23221)1(),1(2,θθθθ-=-==p p p ,现做了n 次实验,观测到三种结果发生的次数分别是321,,n n n ,n n n n =++321证明:n n 11ˆ=θ,,1ˆ32n n -=θnn n 2ˆ213+=θ均是θ的相合估计.分析 直接验证定理6.2.2的条件. 证明 略.6.2.2 无偏性定义6.2.2 ),,,(ˆˆ21nx x x θθ=是θ的一个估计,Θ∈θ,若对Θ∈∀θ,有θθ=ˆE ,则称),,,(ˆˆ21nx x x θθ=是θ的无偏估计,否则称为有偏估计. 注 相合性是大样本所具有的性质,而无偏性对一切样本均可以用.无偏性可以改写成0)ˆ(=-θθE ,这表明无偏估计没有系统偏差,当我们使用),,,(ˆˆ21n x x x θθ=估计θ时,由于样本的随机性,),,,(ˆˆ21nx x x θθ=与θ总是有偏差的,这种偏差时而正,时而负,时而大,时而小,无偏性表示,把这些偏差平均起来其值为零,这就是无偏性的含义.例6.2.4 对任一总体而言,当总体的k 阶矩k μ存在时,样本的k 阶原点矩k a 是总体的k 阶矩k μ的无偏估计.当总体的2阶矩存在时,样本方差∑=--=ni i x x n S 122)(11是总体方差VarX 的无偏估计,但∑=-=ni i x x n S122*)(1不是总体方差VarX 的无偏估计. 注 无偏性不具有不变性,即若),,,(ˆˆ21nx x x θθ=是θ的一个无偏估计,一般而言)ˆ(θg 不是)(θg 的无偏估计,除非)ˆ(θg 是θˆ的线性函数.例6.2.5 设正态总体~X ),(2σμN ,,n x x x ,,,21 为其样本,∑=--=ni i x x n S 122)(11是2σ的无偏估计,证明:2S S =不是σ的无偏估计.证明 略.注 (1)无偏估计可以不存在;(2)无偏估计可以不唯一;(3)无偏估计未必是一个好的估计.具体例子略.6.2.3 有效性参数的无偏估计可以有很多,如何在无偏估计中进行选择?直观的想法是希望该估计围绕在参数真值的波动越小越好,波动大小可用方差来衡量,因此人们常用无偏估计的方差的大小作为度量无偏估计优劣的标准,这就是有效性.定义6.2.3 设21ˆ,ˆθθ是θ的两个无偏估计,如果对任意的Θ∈θ,有 )ˆ()ˆ(21θθVar Var ≤ 且至少有一个Θ∈θ使得上述不等式严格成立,则称1ˆθ比2ˆθ有效.例 6.2.6 设n x x x ,,,21 为取自某总体的样本,记总体均值为μ,总体方差为2σ,则11ˆx =μ,x =2ˆμ都是μ的无偏估计,且1ˆμ比2ˆμ有效. 证明 略.例 6.2.7 设n x x x ,,,21 为取自),0(~θU X 总体的样本,对θ的两个无偏估计)(211ˆ,2ˆn x nn x +==θθ,证明:1ˆθ比2ˆθ有效. 证明 略.6.2.4 均方误差无偏估计是估计的一个优良性质,对无偏估计我们还可以通过其方差进行有效性的比较,然而不能由此认为:有偏估计一定是不好的估计,在有些场合,有偏估计比无偏估计更优,这就涉及如何对有偏估计进行评价.一般而言,在样本量一定时,评价一个点估计的好坏使用的度量指标总是点估计值),,,(ˆˆ21nx x x θθ=与参数真值θ的距离的函数,最常用的函数是距离的平方.由于具有随机性,可以对该函数求期望,这就是下式给出的均方误差2)ˆ()ˆ(θθθ-=E MSE 简单的推导可得到2)ˆ()ˆ()ˆ(θθθθ-+=E Var MSE 若θθ=ˆE ,则)ˆ()ˆ(θθVar MSE =.当),,,(ˆˆ21n x x x θθ=不是θ的无偏估计时,对均方误差)ˆ(θMSE ,不仅要看其方差的大小,还要看偏差大小.在均方误差的标准下,有些有偏估计优于无偏估计.例 6.2.8 设n x x x ,,,21 为取自),0(~θU X 总体的样本,在均方误差的标准下,)(012ˆn x n n ++=θ是θ的有偏估计,但)(012ˆn x n n ++=θ要优于)(11ˆn x nn +=θ这个无偏估计. 证明 略.§6.3 最小方差无偏估计教学目的:要求学生了解最小方差无偏估计的基本思想,理解最小方差无偏估计的基本概念,能用零无偏估计法判别最小方差无偏估计.能计算总体分布的Fisher 信息量和待估参数的C-R 下界,能用C-R 不等式判别有效估计.掌握最大似然估计相合渐近正态性.教学重点:最小方差无偏估计、C-R 不等式.教学难点:零无偏估计法判断最小方差无偏估计和C-R 不等式.教学内容:本节内容包括:Rao-Blackwell 定理,最小方差无偏估计,Cramer-Rao 不等式.6.3.1 Rao-Blackwell 定理定理6.3.1 (Rao-Blackwell 定理)设X 和Y 是两个随机变量,(X)=,(X)>0E Var μ,我们用条件期望构造一个新的随机变量()Y ϕ,其定义为()=E(X|Y=y)Y ϕ,则有(())=,Var((Y))Var(X)E Y ϕμϕ≤.其中等号成立的充分必要条件是X 和()Y ϕ 几乎处处相等. 将定理6.3.1应用到参数估计问题中可得定理 6.3.2 设总体概率密度函数是(;)p x θ,12,,,n x x x 是其样本,12=(,,,)n T T x x x 是θ的充分统计量,则对θ的任一无偏估计^^12=(,,,)n x x x θθ,令~^=(|)E T θθ,则~θ也是θ的无偏估计,且~^Var()Var()θθ≤. 6.3.2 最小方差无偏估计定义6.3.1 对参数估计问题,设^θ是θ的无偏估计,若对θ的任一个无偏估计量~θ,在参数空间Θ上都有~~()()Var Var θθθθ≤则称^θ为θ的一致最小方差无偏估计,简记为UMVUE.如果UMVUE 存在,则它一定是充分统计量的函数.一般来说,如果依赖充分统计量的无偏估计只有一个,则它就是UMVUE. 下面给出一个UMVUE 的判断准则.定理6.3.3 设12=(,,,)n X x x x 是来自某总体的一个样本,^^=)X θθ(是θ的一个无偏估计,^<+Var θ∞(),若对任意一个满足(()=0E X ϕ)的()X ϕ都有 ^(,)=0,Cov θθϕθ∀∈Θ,则^θ是θ的UMVUE.例6.3.26.3.3 Gramer-Rao 不等式定义6.3.2 设总体的概率函数(;),,p x θθ∈Θ满足下列条件: (1) 参数空间Θ是直线上的一个开区;(2) 支撑{:(;)>0}S x p x θ=与θ无关; (3) 导数(;)p x θθ∂∂对一切,θ∈Θ都存在; (4) 对(;),p x θ积分与微分运算可交换次序,即(;)(;)p x dx p x dx θθθθ+∞+∞-∞-∞∂∂=∂∂⎰⎰(5) 期望2[ln (;)]E p x θθ∂∂存在.则称2()[ln (;)]I E p x θθθ∂=∂为总体分布的费希尔(Fisher )信息量. 例6.3.3定理6.3.4 (Gramer-Rao 不等式) 设定义6.3.2的条件满足,12,,,n x x x 是来自该总体X 的一个样本,12=(,,,)n T T x x x 为()g θ的任一无偏估计,若'()()=g g θθθ∂∂存在,且对一切,θ∈Θ对11--=1()=,,);)nn i n i g T x x p dx dx θθ∞∞∞∞∏⎰⎰((x 的微分可在积分号下进行,即'11--=1111--=1=1()=,,)(;))=,,)[ln ;)];))nn i ni nnn i i ni i g T x x p dx dx T x x p p dx dx dx θθθθθθ∞∞∞∞∞∞∞∞∂∂∂∂∏⎰⎰∏∏⎰⎰((x ((x (x对离散总体,则将上述积分改为求和符号后,等式仍然成立,则有'2[()]()()g Var T nI θθ≥ (6.3.9)该式称为克拉美-罗(C-R )不等式,'2[()]()g nI θθ称为()g θ的无偏估计的方差的C-R 下界,简称()g θ C-R 下界.特别,对θ的无偏估计^θ,有^1()()Var nI θθ≥.§6.4 贝叶斯估计教学目的:要求学生了解贝叶斯估计的相关内容. 教学重点:贝叶斯估计的思想和简单贝叶斯估计的计算.教学难点:贝叶斯估计的思想.教学内容:本节内容包括统计推断的基础,贝叶斯公式的密度函数形式,贝叶斯估计,共轭先验分布6.4.1 统计推断的基础统计推断是根据样本信息对总体分布或总体的特征数进行推断.统计推断用到两种信息:总体信息和样本信息,而贝叶斯学派则认为统计推断还用到第三种信息:先验信息. (1) 总体信息总体信息即总体分布或总体所属分布族提供的信息. (2) 样本信息样本信息即抽取样本所得观测值提供的信息.(3) 先验信息先验信息就是抽样之前有关统计问题的一些信息.例6.4.1基于上述三种信息进行统计推断的统计学称为贝叶斯统计学.贝叶斯学派的基本观点是:任一未知量θ都可看作随机变量,可用一个概率分布去描述,这个分布称为先验分布.6.4.2 贝叶斯公式的密度函数形式(1)总体依赖于参数θ的概率函数在经典统计中记为(;)p x θ,它表示参数空间Θ中不同的θ对应不同的分布.在贝叶斯统计学中记为(|)p x θ,它表示在随机变量θ取某个给定值时总体的条件概率函数.(2)根据参数 θ的先验信息确定先验分布πθ(). (3)从贝叶斯观点来看,样本的产生要分两步,首先设想从先验分布)(θπ产生一个样本0θ.第二步从)|(0θX p 中产生一组样本,这时样本),,(1n x x X =的联合条件概率函数为)|()|,()|(01010θθθi ni n x p x x p X p =∏== ,这个分布综合了总体信息和样本信息.(4) 由于0θ是设想出来的,故要用πθ()进行综合,样本X 和参数θ的联合分布为)()|(),(θπθθX p X h =.(5)有了样本观察值),,(1n x x X =后,对),(θX h 作如下分解:)()|(),(X m X X h θπθ=,)(X m 是X 的边际概率函数:⎰⎰ΘΘ==θθπθθθd X p d X h X m )()|(),()(,⎰Θ==θθπθθπθθθπd X p X p X m X h X )()|()()|()(),()|(,称为θ的后验分布.6.4.3 贝叶斯估计由后验分布)|(X θπ估计θ有三种常用方法:(1) 使用后验分布的密度函数最大值点作为θ的点估计的最大后验估计; (2) 使用后验分布的中位数作为θ的点估计的后验中位数估计; (3) 使用后验分布的均值作为θ的点估计的后验期望估计. 用的最多的是后验期望估计,一般简称贝叶斯估计,记为^B θ.例6.4.2 例6.4.36.4.4 共轭先验分布定义6.4.1 设θ是总体参数,)(θπ是其先验分布,若对任意的样本观测值得到的后验分布)|(X θπ与)(θπ属于同一分布族,则称该分布族是θ的共轭先验分布族。

第1章 极大似然估计极大似然估计是非线性模型中非常重要的一种估计方法。

最小二乘法是极大似然估计在线性模型中的特例。

1.1 似然函数假设随机变量x t 的概率密度函数为 f (x t ),其参数用θ= (θ1, θ2, …, θk ) 表示,则对于一组固定的参数 θ 来说,x t 的每一个值都与一定的概率相联系。

即给定参数θ,随机变量x t 的概率密度函数为f (x t )。

相反若参数 θ 未知,当得到观测值x t 后,把概率密度函数看作给定x t 的参数 θ 的函数,这即是似然函数。

L (θ | x t ) = f (x t | θ )似然函数L (θ | x t ) 与概率密度函数f (x t | θ ) 的表达形式相同。

所不同的是在f (x t | θ ) 中参数 θ 是已知的,x t 是未知的;而在L (θ | x t ) 中x t 是已知的观测值,参数 θ是未知的。

对于n 个独立的观测值x =(x 1, x 2, …, x n ),其联合概率密度函数为1(|)(|)ni i f f x ==∏x θθ其对应的似然函数为:11(|)(|)(|)nn i i i i LnL LnL x f x ====∑∏θx θθ经常使用的是对数似然函数,即对L (θ| x t )取自然对数:LnL (θ | x t ) =log[f (x t | θ )]例 1.1正态分布随机变量的似然函数设一组随机变量x i ,(i = 1, 2, …, n )是相互独立的,且服从正态分布N (μ,σ2)。

存在N 个独立的观测值x =(x 1, x 2, …, x n )。

x i 的似然函数为221/22()1(,|)(|,)exp (2)2i i i i x L x f x μμσμσπσσ⎛⎫-==-⎪⎝⎭=1i x μφσσ-⎛⎫- ⎪⎝⎭其中,φ表示标准正态分布的概率密度函数,2()2x x φ⎛⎫=- ⎪⎝⎭x i 的对数似然函数为:21(,|)ln()ln ()2i i i x LnL x μμσσφσ-⎛⎫=-+ ⎪⎝⎭其中,21ln ()ln(2)22x x φπ=--(x 1, x 2, …, x n )的联合似然函数为21(,|)ln()ln ()2n i i x n LnL μμσσφσ=-⎛⎫=-+ ⎪⎝⎭∑x=2221()ln()ln(2)222n i i x n n μσπσ=----∑ 例 1.2 泊松分布的对数似然函数假设每5分钟到达商店的顾客的数目服从Poisson 分布,有N 个样本观测值(x 1, x 2, …, x N )。