基于混合核函数的SVM及其应用(精)

- 格式:ppt

- 大小:519.50 KB

- 文档页数:20

粒子群算法优化混合核函数SVM及应用第一章:引言1.1 研究背景1.2 研究意义1.3 研究现状1.4 研究内容和方法1.5 论文结构第二章:混合核函数SVM的原理与方法2.1 SVM算法简介2.2 混合核函数2.3 混合核函数SVM的原理2.4 模型的求解第三章:粒子群算法的原理与应用3.1 粒子群算法简介3.2 粒子群算法的原理3.3 粒子群算法的应用第四章:基于粒子群算法的混合核函数SVM优化方法4.1 问题的建立4.2 优化目标和约束条件4.3 粒子群算法优化方法4.4 算法流程第五章:实验和结果分析5.1 实验设置5.2 实验结果分析5.3 算法的比较分析第六章:总结与展望6.1 研究成果总结6.2 研究工作不足6.3 研究展望参考文献第一章:引言1.1 研究背景随着机器学习和数据挖掘的快速发展,支持向量机(Support Vector Machine, SVM)作为一种强有力的分类工具在实际应用中得到广泛应用。

与此同时,混合核函数SVM也因其在处理非线性问题中具有更好的效果而受到越来越多的关注。

混合核函数SVM不仅可以处理多维特征空间的数据,而且在处理非线性问题时也能有效地避免过拟合问题。

然而,对于大规模数据集和高维特征集,SVM的训练时间会变得非常长,导致不可行或者具有实际用途性的难度。

因此,如何加快SVM的训练速度成为研究的重要方向之一。

1.2 研究意义优化混合核函数SVM的训练方法,可以提高算法的效率和准确性,更好地处理大规模和高维数据集。

粒子群算法(Particle Swarm Optimization, PSO)作为一种全局优化方法,在优化混合核函数SVM中具有潜在的应用价值。

因此,研究基于粒子群算法的混合核函数SVM优化方法,可以提高算法的收敛速度和准确率,并更好地处理大规模和高维数据集,具有重要的理论和应用价值。

1.3 研究现状当前,关于SVM的研究主要集中在算法改进和优化方法上。

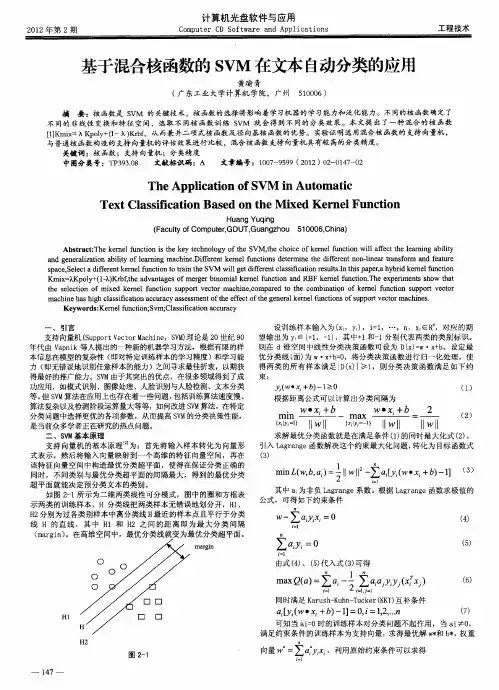

基于混合核函数的SVM在文本自动分类的应用摘要:核函数是SVM的关键技术,核函数的选择将影响着学习机器的学习能力和泛化能力。

不同的核函数确定了不同的非线性变换和特征空间,选取不同核函数训练SVM就会得到不同的分类效果。

本文提出了一种混合的核函数[1]Kmix=λKpoly+(1-λ)Krbf,从而兼并二项式核函数及径向基核函数的优势。

实验证明选用混合核函数的支持向量机,与普通核函数构造的支持向量机的评估效果进行比较,混合核函数支持向量机具有较高的分类精度。

关键词:核函数;支持向量机;分类精度中图分类号:TP393.08文献标识码:A文章编号:1007-9599 (2012) 02-0000-02 The Application of SVM in Automatic Text Classification Based on the Mixed Kernel FunctionHuang Yuqing(Faculty of Computer,GDUT,Guangzhou510006,China)Abstract:The kernel function is the key technology of the SVM,the choice of kernel function will affect the learning ability and generalization ability of learning machine.Different kernel functions determine the different non-linear transform and feature space,Select a different kernel function to train the SVM will get different classification results.In this paper,a hybrid kernel functionKmix=λKpoly+(1-λ)Krbf,the advantages of merger binomial kernelfunction and RBF kernel function.The experiments show that the selection of mixed kernel function support vector machine,compared to the combination of kernel function support vector machine has high classification accuracy assessment of the effect of the general kernel functions of support vector machines.Keywords:Kernel function;Svm;Classification accuracy一、引言支持向量机(Support Vector Machine,SVM)理论是20世纪90年代由Vapnik等人提出的一种新的机器学习方法,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力。

svm的一般过程

SVM的一般过程包括选择最优超平面、处理线性不可分问题、使用核函数映射等。

具体如下:

1. 选择最优超平面:SVM算法的目标是找到一个超平面,使得不同类别的数据点之间的间隔(margin)最大化。

这个超平面被称为最大边际超平面。

2. 处理线性不可分问题:当数据在原始特征空间中线性不可分时,SVM会通过核技巧将数据映射到高维空间,以便找到可以分开数据的超平面。

3. 使用核函数映射:核函数的选择对于SVM的性能至关重要,它能够将数据映射到高维空间,帮助SVM处理非线性问题。

常用的核函数包括线性核、多项式核、径向基函数(RBF)核等。

4. 求解对偶问题:为了找到最优超平面,SVM算法通常会求解一个对偶问题,这是因为在高维空间中直接求解原始问题可能会非常复杂。

通过求解对偶问题,可以更高效地找到最优超平面的参数。

5. 决策函数:得到最优超平面后,可以使用决策函数来对新的数据点进行分类。

决策函数会根据数据点与超平面的相对位置来判断其类别。

总的来说,SVM是一种强大的机器学习算法,它在很多领域都有广泛的应用,如图像识别、文本分类、生物信息学等。

尽管SVM在某些情况下可能不如一些新兴的深度学习模型流行,但它仍然是一个非常有价值的工具,特别是在数据集较小或者需要明确边界的情况下。

kernal function linear gaussianpolynomial 混合核函数核函数包括线性核、高斯核(也称为RBF核)和多项式核,以及它们的混合。

这些核函数在支持向量机(SVM)、核主成分分析(KPCA)等核方法中有着广泛的应用。

1. 线性核(Linear Kernel):公式: K(x,y)=x⋅y特点: 线性核将数据映射到无限维的特征空间,但在这个空间中只使用线性决策边界。

2. 高斯核(Gaussian Kernel, RBF Kernel):公式: K(x,y)=exp(−γ∣∣x−y∣∣2)其中γ 是高斯宽度参数。

特点: 高斯核或RBF核也称为平方指数核,常常在支持向量机中用于处理非线性问题。

它通过映射数据到高维空间来处理非线性问题,并在高维空间中使用线性决策边界。

3. 多项式核(Polynomial Kernel):公式: K(x,y)=(x⋅y+c)d其中c 和d 是多项式核的参数。

特点: 多项式核是一种非线性的核函数,可以用于处理非线性问题。

与高斯核类似,它也通过映射数据到特征空间来处理非线性问题,并在该空间中使用非线性决策边界。

4. 混合核(Mixture Kernel):混合核是将两种或多种核函数组合在一起形成的核函数。

例如,可以组合线性核和高斯核来创建一个混合核。

特点: 混合核可以结合不同核函数的优点,以适应不同的应用场景和数据特性。

例如,在某些情况下,线性核和高斯核的组合可能能够更好地捕捉数据的非线性特征。

使用哪种核函数取决于您的数据、应用和问题的性质。

对于某些问题,线性核可能就足够了;对于其他问题,可能需要使用非线性核,如高斯核或多项式核;而对于更复杂的问题,可能需要使用混合核。

傅里叶核函数 svm傅里叶核函数(Fourier Kernel Function)是一种常用于支持向量机(Support Vector Machine,SVM)的核函数。

SVM是一种常见的机器学习算法,用于分类和回归问题。

它基于找到能够有效划分两个不同类别的超平面。

傅里叶核函数是一种常用的核函数之一,可以将输入数据映射到高维特征空间,从而实现非线性分类。

傅里叶变换是一种信号处理技术,用于将信号从时域转换到频域。

在傅里叶变换中,信号可以表示为一系列不同频率的正弦和余弦函数的和。

傅里叶核函数利用了这种频域表示的特性,将输入数据从原始空间转换到特征空间,从而使SVM能够更好地处理非线性问题。

傅里叶核函数的计算公式如下:K(x, y) = exp(-γ ||ϕ(x) - ϕ(y)||²)其中,x和y是输入样本点,ϕ(x)和ϕ(y)是将x和y映射到高维特征空间后的结果,||·||表示向量的范数,γ是一个参数,控制了核函数的平滑程度。

傅里叶核函数的作用是通过计算输入样本点在特征空间中的距离来衡量它们之间的相似性。

如果两个样本点在特征空间中的距离越小,它们在原始空间中的相似性就越大。

相反,如果它们的距离越大,它们在原始空间中的相似性就越小。

这种距离度量可以帮助SVM更好地划分不同类别之间的边界。

傅里叶核函数的一个重要特点是它可以高效地计算,因为傅里叶变换的快速算法(Fast Fourier Transform,FFT)可以用于加速核函数的计算过程。

这使得傅里叶核函数在处理大规模数据时非常有用。

总结一下,傅里叶核函数是一种常用的核函数,用于支持向量机中处理非线性问题。

它通过将输入数据映射到高维特征空间,并计算样本点在特征空间中的距离来衡量它们之间的相似性。

傅里叶核函数的优势在于它能够高效地处理大规模数据,并且可以利用傅里叶变换的快速算法进行计算。

支持向量机(SVM )原理及应用一、SVM 的产生与发展自1995年Vapnik(瓦普尼克)在统计学习理论的基础上提出SVM 作为模式识别的新方法之后,SVM 一直倍受关注。

同年,Vapnik 和Cortes 提出软间隔(soft margin)SVM ,通过引进松弛变量i ξ度量数据i x 的误分类(分类出现错误时i ξ大于0),同时在目标函数中增加一个分量用来惩罚非零松弛变量(即代价函数),SVM 的寻优过程即是大的分隔间距和小的误差补偿之间的平衡过程;1996年,Vapnik 等人又提出支持向量回归 (Support Vector Regression ,SVR)的方法用于解决拟合问题。

SVR 同SVM 的出发点都是寻找最优超平面(注:一维空间为点;二维空间为线;三维空间为面;高维空间为超平面。

),但SVR 的目的不是找到两种数据的分割平面,而是找到能准确预测数据分布的平面,两者最终都转换为最优化问题的求解;1998年,Weston 等人根据SVM 原理提出了用于解决多类分类的SVM 方法(Multi-Class Support Vector Machines ,Multi-SVM),通过将多类分类转化成二类分类,将SVM 应用于多分类问题的判断:此外,在SVM 算法的基本框架下,研究者针对不同的方面提出了很多相关的改进算法。

例如,Suykens 提出的最小二乘支持向量机 (Least Square Support Vector Machine ,LS —SVM)算法,Joachims 等人提出的SVM-1ight ,张学工提出的中心支持向量机 (Central Support Vector Machine ,CSVM),Scholkoph 和Smola 基于二次规划提出的v-SVM 等。

此后,台湾大学林智仁(Lin Chih-Jen)教授等对SVM 的典型应用进行总结,并设计开发出较为完善的SVM 工具包,也就是LIBSVM(A Library for Support Vector Machines)。

• 100•风电功率的预测对风力发电系统具有重要意义,然而,风力发电的输出功率具有较大的波动性和间歇性,这对制定发电计划、调度运行带来了巨大的挑战。

本文介绍了一种基于SVM 算法对风电功率进行预测的方法,将风电功率的历史数据作为因变量,将其对应的影响风电功率的主要因素数据作为自变量,使用SVM 回归方法建立预测模型,找出最佳的模型参数,将需要预测的数据自变量输入到模型中,有效并准确地预测出风电功率数据,预测准确度可达到94%以上。

随着地球环境的污染和不可再生资源的过度消耗,人们把更多的目光投在了可再生资源身上。

风资源作为一种清洁能源,取之不尽,用之不竭,和目前常见的火力发电相比,没有污染排放,也没有煤炭资源消耗。

中国作为风资源储量巨大的国家,装机量逐年提高,从保护环境和节约资源的角度来看,风力发电具有良好的未来发展前景。

风电功率是风力发电系统中最为重要的指标之一,然而,风电功率会受到风速、风向角等因素的影响,因此对风电功率预测的准确性成为了关键。

国外风电功率预测研究工作起步较早,比较有代表性的方法主要有:丹麦的Riso 国家实验室的Prediktor 预测系统、西班牙的LocalPred 预测系统和德国AWPT 预测系统等。

其主要思想均是利用数值天气预测提供风机轮毂高度的风速、风向等预测信息,然后利用风电功率预测模块提供风电功率。

我国风力发电起步虽然较晚,但是在数十年来的发展趋势不容忽视,过快的发展速度导致了风电行业质量跟不上速度的结果。

在近些年,我国的风力发电领域开始由快速导向型发展转向质量导向型发展。

正是因为这种原因,我国风电功率预测在二十一世纪才开始受到行业重视,目前仍处于起步阶段。

我国目前正在开展基于人工神经网络、支持向量机等方法的风电功率预测模型研究,以及基于线性化和计算流体力学的物理模型方法,同时正在进行多种统计方法联合应用研究及统计方法与物理方法混合预测模型的研究。

本文采用机器学习中的支持向量机(SVM )算法,探讨其在风力发电机功率预测中的应用研究,将有功功率的历史数据及其对应的变量数据进行训练建模,并使用测试数据集对预测模型进行检验。

基于混合核函数的SVM在文本自动分类的应用黄瑜青【期刊名称】《计算机光盘软件与应用》【年(卷),期】2012(000)002【摘要】The kernel function is the key technology of the SVM,the choice of kernel function will affect the learning ability and generalization ability of learning machine.Different kernel functions determine the different non-linear transform and feature space,Select a different kernel function to train the SVM will get different classification results.In this paper, a hybrid kernel function Kmix=λKpoly+(1-λ)Krbf, the advantages of merger binomial kernel function and RBF kernel function.The experiments show that the selection of mixed kernel function support vectormachine,compared to the combination of kernel function support vector machine has high classification accuracy assessment of the effect of the general kernel functions of support vector machines.%核函数是SVM的关键技术,核函数的选择将影响着学习机器的学习能力和泛化能力。

svm的常用核函数支持向量机(Support Vector Machine, SVM)是一种通过构建最优超平面来实现分类的算法。

SVM的优点在于其具有高维性、通用性、准确性、鲁棒性和可扩展性等特点,它可以广泛应用于分类、回归和异常检测等领域。

在SVM中,核函数是非常重要的一部分,常用的SVM核函数有线性、多项式、径向基(高斯)和Sigmoid四种。

下面我们详细介绍一下这四种常用的SVM核函数。

一、线性核函数线性核函数是SVM中最简单的一种核函数,它能够处理两类数据线性可分的情况。

其公式如下:K(x, z) = x * z其中,x和z是向量。

在线性核函数的情况下,SVM算法实际上是一个线性分类器,只需找到一条直线将两类数据分开即可。

线性核函数对于分类任务而言具有较好的收敛速度和泛化性能。

K(x, z) = (x * z + r) ^ d其中,d表示多项式的阶数,r表示常数项。

多项式核函数通过提高数据的维度,将非线性可分的数据转换为线性可分的数据,提高了SVM的分类能力。

三、径向基核函数径向基(高斯)核函数也被称为RBF核函数,是SVM中应用最广泛的一种核函数。

其公式如下:K(x, z) = exp(- ||x - z||^2 / (2 * sigma ^ 2))其中,||x -z ||表示向量x和z之间的距离,sigma表示核函数的宽度参数。

径向基核函数适用于数据复杂、非线性可分或高维的分类情况,同时对参数的选择比较灵活。

四、Sigmoid核函数Sigmoid核函数是一种非常特殊的核函数,它可以将数据映射到[-1,1]的区间内。

其公式如下:K(x, z) = tanh(α x * z + b)其中,α和b是可调参数。

Sigmoid核函数适用于其他核函数无法处理的情况,但其分类效果通常不如径向基核函数和多项式核函数。

综上所述,SVM可以使用多种核函数进行分类处理,不同核函数具有不同的性质和适用范围。