Pattern Recognition

Term Project Report Using Visual Words for Image Classification

u9562171, 雷禹恆

1.Abstract

Visual words 近年來在image retrieval領域被大量使用。它是基於文字上的textual words,套用在影像上的類比,因此可將過去在text retrieval領域的技巧直接利用於image retrieval,也有助於large-scale影像搜尋系統的效率。Visual words的擷取大致上是將影像的SIFT features,在keypoint feature space上做K-means clustering的結果,以histogram來表示,是一種bag-of-features。除了可用於retrieval外,visual words也被用於image classification。本專題的目的就是將visual words作為影像特徵,並套用於multi-class image classification。

2.Introduction

Visual words (簡稱VWs) 近年來在image retrieval領域被大量使用,其motivation其實是從text retrieval領域而來,是基於文字上的textual words,套用在影像上的類比。

如同於一篇文章是由許多文字 (textual words) 組合而成,若我們也能將一張影像表示成由許多 “visual words” 組合而成,就能將過去在text retrieval領域的技巧直接利用於image retrieval;而以文字搜尋系統現今的效率,將影像的表示法「文字化」也有助於large-scale影像搜尋系統的效率。

在文獻 [1] 有提到motivation of visual words的細節。首先我們先回顧text retrieval 的過程:1. 一篇文章被parse成許多文字,2. 每個文字是由它的「主幹(stem)」來表示的。例如以 ‘walk’ 這個字來說,‘walk’、‘walking’、‘walks’ 等variants同屬於 ‘walk’ 這個主幹,在text retrieval system裡被視為同一個字。3. 排除掉每篇文章都有的極端常見字,例如 ‘the’ 和 ‘an’。4. 一篇文章文章的表示法,即以每個字出現頻率的histogram vector來表示。5. 在此histogram中,對於每個字其實都有給一個某種形式weight,例如Google利用PageRank [2] 的方式來做weighting。6. 在執行文字搜尋時,回傳和此query vector最接近(以角度衡量)的文章。

下一節將解釋影像中VW的特徵擷取流程,及其與此段之1.、2.、4.的類比。

3.Construction of Visual words

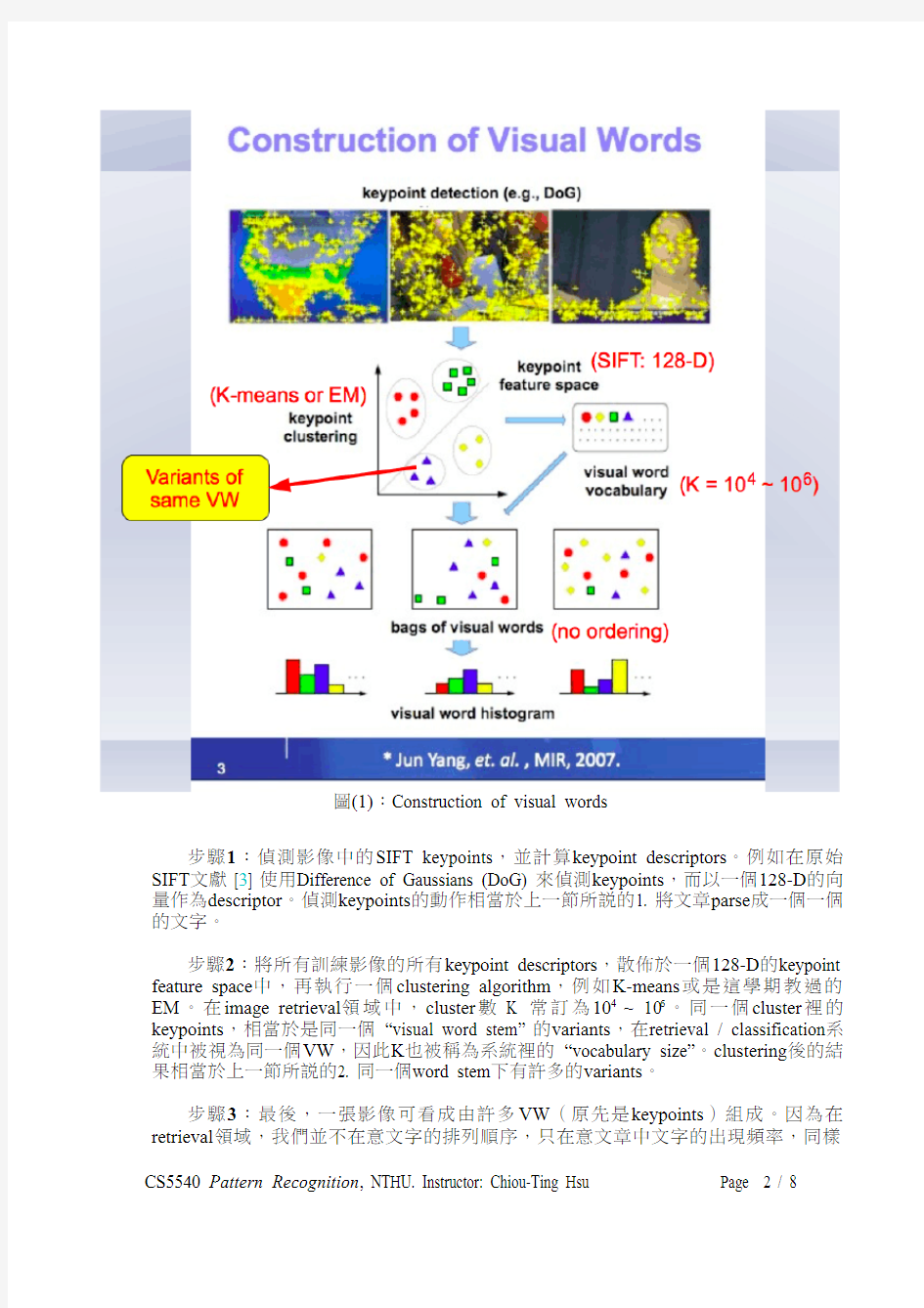

Visual words的建構流程可以用圖(1)來說明:

圖(1):Construction of visual words

步驟1:偵測影像中的SIFT keypoints,並計算keypoint descriptors。例如在原始SIFT文獻 [3] 使用Difference of Gaussians (DoG) 來偵測keypoints,而以一個128-D的向量作為descriptor。偵測keypoints的動作相當於上一節所說的1. 將文章parse成一個一個的文字。

步驟2:將所有訓練影像的所有keypoint descriptors,散佈於一個128-D的keypoint feature space中,再執行一個clustering algorithm,例如K-means或是這學期教過的EM。在image retrieval領域中,cluster數K 常訂為104~ 106。同一個cluster裡的keypoints,相當於是同一個 “visual word stem” 的variants,在retrieval / classification系統中被視為同一個VW,因此K也被稱為系統裡的 “vocabulary size”。clustering後的結果相當於上一節所說的2. 同一個word stem下有許多的variants。

步驟3:最後,一張影像可看成由許多VW(原先是keypoints)組成。因為在retrieval領域,我們並不在意文字的排列順序,只在意文章中文字的出現頻率,同樣

的道理,一張影像中我們只在乎每個VW stem的出現頻率。以這種概念構成的特徵被稱為 “Bag-of-features”,只在乎袋子裡有什麼物品,而不是物品的排列順序。因此影像特徵的表示法為根據VW出現頻率的 “visual word histogram”。這種概念與上一節4.

的文字出現頻率histogram相同。

結論:Visual words可看作是將影像中local的keypoint descriptors,套上clustering algorithm後,變成整張影像的global feature。

Visual words 除了大量用於image retrieval外,也可以直接作為features用於image classification。本專題的目的就是將visual words作為影像特徵,並套用於multi-class image classification。

4.Dataset

網路上屬於multi-class,每個class大量,但一張影像只有單一物件的dataset沒有想像中得好找。後來選擇了Caltech 101 [4] 的subset作為本次實驗的dataset。Caltech 101雖然有101種object class,但class裡夠多張影像的只有5種,資料夾名稱(重新命名名稱)分別是:airplanes(Airplane)、BACKGROUND_Google(None)、Faces_easy(Face)、Faces(未使用)、Motorbikes(Motorbike)。Faces和Faces_easy我只選擇切割比較好的Faces_easy來使用。另外我也挑掉不少label有瑕疵的影像,尤其是None類別雖然號稱為背景,裡面卻有很多時候出現人臉。還有極少數張取VW失敗的影像也被剔除。

最後剩下的dataset,我對於4個class分別以training : testing = 9 : 1的方式分配比例。各類的張數統計如表(1),可看出Airplane和Motorbike的量約為Face和None的兩倍。影像範例如圖(2),可看出None類別比較困難,因為各式各樣的內容都有,但其他三個類別就簡單許多,物體也少有被干擾的情況。

表(1):dataset中各類影像的張數統計

(b) Face

(a) Airplane

(c) Motorbike(d) None

圖(2):dataset中4類影像的範例

5.Experiment Results and Observations

本次實驗使用MATLAB R2009b (64-bit),系統環境是Mac OS X 10.6.3,Intel Cuo

2 Duo 2.16GHz processor,3G RAM。分類器必須配合libSVM [5] 的主package與

MATLAB interface。詳細使用說明見README.txt。

而使用的features: visual word histograms,是把原始圖片給實驗室學長姊後,請她們用實驗室的tools幫我轉成VW文字檔的,其中偵測keypoints的方式是Hessian Affine (HA),而非SIFT文獻上的Difference of Gaussians (DoG)。也就是說,feature extraction 的部分是training和testing皆事先完成。V ocabulary size分別有K = 10,000 (104),1,000 (103),及125 (53)。

Attempt 1:一開始我只使用作業學過的MATLAB內建SVM來分類。由於只支援binary classification,我用one-against-one的方式訓練了 C * (C-1) / 2 = 6個分類器,再用majority vote決定output值。使用人造data跑起來還算合理,但套進真實資料:K = 10,000的VW以後,外加手動測試了一些SVM參數,結果卻非常離譜地差。training與testing的confusion matrices如表(2):

training [720000 039100 007170 000331]

testing [80000440008000037000]

表(2):Attempt 1實驗的confusion matrices

可以看出training意外地完全被分對,testing卻完全被分到class 1(Airplane)。檢查之下發現在SVM train的過程中,所有的點都被歸類為support vectors,也就是本次實驗的結果極端地fit我的training data,對testing data幾乎沒有classification的能力。

Attempt 2:接著我改用libSVM的multi-class classifier來分類,配上其提供的parameter selection tools (grid.py)。實驗的結果好很多,整體accuracy可達90%以上。嘗試了K = 10,000和K = 1,000,其confusion matrix,每個class的recall與precision如表(3):

confusion=[76013043010079141032],recall=[0.950.980.990.86],precision=[0.950.980.990.87]

(a) K = 10,000:Accuracy = 95.4357% (230/241) confusion=[76013044000079142130],recall=[0.951.000.990.81],precision=[0.950.960.980.88]

(b) K = 1,000:Accuracy = 95.0207% (229/241)

表(3):Attempt 2的實驗數據

Attempt 2的結果遠優於Attempt 1,我認為可能是MATLAB內建的SVM能力無法應付本次的高維度dataset,或是只用人工測試少數SVM參數遠比用tools的效果差。另外從表(3)可看出,class 4 (None) 的recall和precision皆最差,符合預期,因為此類別的影像內容什麼都有,本身就比較困難,其他3個類別相對簡單很多,所以數據都蠻不錯的。本報告之後實驗結果,各個class的表現也符合這樣的現象。

Attempt 3:雖然Attempt 2的結果已經很好,dataset仍然存在著一個問題:我的dataset實際的dimensionality (K)是否真的有1,000、10,000那麼高?因此我接著多使用PCA (Principal Component Analysis) 來做轉換和降維,因為K = 10,000的PCA超出我自己電腦的運算能力,Attempt 3只測試K = 1,000。目標維度我利用保留多少百分比的total variance來決定,分別測試100%、99%、98%、97%、96%、95%。實驗數據如表(4):

Total Variance

Reduced

Dimension

Overall

Accuracy

Confusion (C), Recall (R), Precision (P)

100%1,00095.0207%

(229/241)C=[76013044000079142130

],R=[0.951.000.990.81],P=[0.950.960.980.88]

99%34895.0207%

(229/241)C=[75014044000079142031

],R=[0.941.000.990.84],P=[0.950.960.990.86]

98%19595.8506%

(231/241)C=[77012044000080041230

],R=[0.961.001.000.81],P=[0.950.980.960.94]

97%11895.4357%

(230/241)C=[77012044000179041230

],R=[0.961.000.990.81],P=[0.950.960.960.94]

96%7595.4357%

(230/241)C=[76013044000079141131

],R=[0.951.000.990.84],P=[0.950.980.980.89]

95%49

94.1909%

(227/241)C=[77012044000079162227

],R=[0.961.000.990.73],P=[0.930.960.960.90]表(4):Attempt 3的實驗數據 (K = 1,000 + PCA)

total variance = 100%其實和Attempt 2的K = 1,000是一樣的結果。從表(4)可發現,total variance降到95%,也就是維度一路降到49時,都有差不多水準的表現。後來測更低的90% (13維),accuracy就只剩下88.80%了。

總之,經過PCA之後的accuracy和Attempt 2比沒有增加,但是降維後的執行速度,不論是training或testing,皆比Attempt 2快很多。

Attempt 4:由之前PCA的經驗,我推斷此dataset最適合的vocabulary size (K)可能比設定的1,000、10,000小很多,介於K = 100 ~ 200之間。因此我再用一份 K = 125 (53)的dataset跑一次實驗,只做SVM parameter selection,不做PCA,發現也能得到很好的結果,如表(5):

confusion=[75014044000080042229],recall=[0.941.001.000.79],precision=[0.950.960.960.88]

Accuracy = 94.6058% (228/241)

表(5):Attempt 4的實驗數據 (K = 125, no PCA)

因此,本次visual word dataset的實際vocabulary size,可能比retrieval常用的 104 ~ 106 低很多。

6.Discussions

在實驗過程中,有幾個步驟面臨到需要決定參數問題,分別是:

1.SVM parameters (C, γ)

2.PCA target dimension (% of total variance retained)

3.V ocabulary size (K in K-means)

針對1.,因為有現成的libSVM parameter selection tools,所以只要讓電腦去選擇即可。針對2.,我的原則是,在能達到同樣classification水準下,選擇維度最低的。實驗發現在K = 1,000的dataset中,以95% of total variance降到49維都還有很好的表現。至於針對3.,由於我對實驗室擷取VW的tools不熟悉,資料都是事先請學長姊擷取好的,沒有辦法真的去嘗試每一種K,只用了K = 10,000、1,000、125進行實驗,算是一個缺點。

我在後期有想到一點,文獻 [1] 提到在text retrieval會把 “very common words”,例如 ‘a’、‘the’、‘is’、‘and’,從database剔除,或是想辦法降低它們的weights。這點在我的dataset裡並沒有做到,因為時間關係一時也想不到簡單又無缺點的方法。這或許是accuracy無法超越96%的原因之一。

最後,本次專題其實訂的問題算簡單,還有一些挑戰等待克服。例如本次的dataset: Caltech 101,我挑出來的4類有3類是將物體切割出來,容易分類的。未來可嘗試更困難的dataset,例如Caltech 256 [6],再組合其他網路上的dataset讓object classes 更多。除此之外,在object detection的問題中,快速localization或recognition [7] 也是很重要的。物體不會永遠佔滿影像的大半面積,以不同大小的sliding window尋找物體位置是很沒效率的做法;而類別增加時,一個一個去詢問SVM的output也不是很有效率。這些都是未來努力的方向。

7.Project hosting

本專題以open source的形式托管於Google Code,網址如下:

https://www.doczj.com/doc/6e12394877.html,/p/search

網站上除了有本次專題的程式碼、dataset、程式執行的demo影片、說明文件、本書面報告、投影片之外,未來的研究如屬於可公開的部分,也會繼續在專案網站上更新。

8.References

[1] Sivic, Zisserman, “Video Google: A Text Retrieval Approach to Object Matching in

Videos,” Proc. IEEE International Conference on Computer Vision, 2003.

[2] Brin, Page, “The anatomy of a large-scale hypertextual web search engine,” 7th Int.

WWW Conference, 1998.

[3] Lowe, “Distinctive image features from scale-invariant keypoints,”International

Journal of Computer Vision, vol. 60, no. 2, pp. 91–110, 2004.

[4] Caltech 101 dataset, https://www.doczj.com/doc/6e12394877.html,/Image_Datasets/Caltech101/

[5] C. C. Chang(張治中) and C. J. Lin(林智仁), “LIBSVM -- A Library for Support

Vector Machines,” https://www.doczj.com/doc/6e12394877.html,.tw/~cjlin/libsvm/

[6] Caltech 256 dataset, https://www.doczj.com/doc/6e12394877.html,/Image_Datasets/Caltech256/

[7] Yeh,Lee,Darrell,“Fast concurrent object localization and recognition,”IEEE

International Conference on Computer Vision and Pattern Recognition, 2009.

第12卷 第5期太赫兹科学与电子信息学报Vo1.12,No.5 2014年10月 Journal of Terahertz Science and Electronic Information Technology Oct.,2014 文章编号:2095-4980(2014)05-0726-05 一种基于词袋模型的图像分类方法 杨晓敏,严斌宇*,李康丽,苏冰山 (四川大学电子信息学院,四川成都 610064) 摘要:采用词袋模型(BoW)对图像进行分类,并针对传统词袋模型存在的不足进行了改进,提出了一种特征软量化的方式。软赋值量化通过将局部显著特征量化(SIFT)为与其距离最近 的若干个视觉单词,并对其进行加权,由此保存特征空间中的距离信息,从而解决硬赋值量化造 成的特征空间信息损失问题。通过在Caltech 101数据库进行实验,验证了本文方法的有效性,实 验结果表明,该方法能够大幅度提高图像分类的性能。 关键词:词袋模型;视觉词典;图像分类 中图分类号:TN911.73;TP391.4文献标识码:A doi:10.11805/TKYDA201405.0726 An image classification method based on bag of words model YANG Xiao-min,YAN Bin-yu*,LI Kang-li,SU Bing-shan (College of Electronics and Information Engineering,Sichuan University,Chengdu Sichuan 610064,China) Abstract:The Bag of Words(BoW) model is applied to object classification. An improved algorithm based on soft quantification is proposed. This algorithm quantifies the Scale-Invariant Feature Transform (SIFT) descriptor into several nearest visual words and performs weighting on them, which can conserve the space information. Therefore, it can avoid the information loss of eigen space caused by hard quantification. The experiments are carried out on Caltech 101 database. Experimental results show that the proposed method performs better than traditional method on image classification. Key words:Bag of Words model;visual words;image classification 近年来,图像数量的大量激增给图像识别、检索以及分类等问题带来了巨大的挑战。如何在浩瀚的数据中准确获得用户所需信息并进行处理,成为该领域亟待解决的问题之一。词袋模型最初应用于文档处理领域,将文档表示成顺序无关的关键词的组合,通过统计文档中关键词出现的频率来进行匹配。近几年来,计算机视觉领域的研究者们成功地将该模型的思想移植到图像处理领域[1–2],词袋模型(BoW)将图像库看成文档库,将一幅图像看作一篇文档。提取图像特征后,用其生成“视觉单词”,即生成字典,统计每幅图像的视觉单词出现频率,即可完成图像的词袋描述。为了进一步提高该模型的性能,使其在图像识别和分类领域得到更好的应用,研究者们一直致力于对模型的实现过程进行改进和优化[3–8]。 传统局部显著特征的量化就是计算每个局部显著特征与词典中所有视觉单词的最小距离,并将该局部特征用距离它最近的视觉单词进行量化[9–10]。这种方式下局部显著特征的量化仅仅是局部特征之间真实距离的一种粗糙的近似,局部特征在量化过程之中会损失空间信息。处于量化边界两侧的点,虽然实际距离很近,但是量化后其距离就会较大;而处于量化边界同侧的点,虽然实际距离可能很远,但是量化后距离很近。实际上,图像的噪声、场景光照变化、遮挡等因素,导致同一个物体某一区域在不同的图像中,局部显著特征会存在较大差异。在量化时,有可能被量化为不同的视觉单词。因此这种硬赋值方式的量化就会造成检索的错误。本文在传统词袋模型基础上,针对局部显著特征的量化算法进行研究,建立新的量化方式,保存局部显著特征的空间信息,以解决量化赋值带来的信息损失问题。实验结果表明本文方法能够提高图像检索的性能。 收稿日期:2014-07-08;修回日期:2014-08-13 基金项目:中国科学院数字地球重点实验室开放基金资助项目(No.2012LDE016);武汉大学测绘遥感信息工程国家重点实验室开放基金(No.12R03);高等学校博士学科点专项科研基金资助项目(20130181120005);四川省科技支撑计划资助项目(No.2014GZ0005);博士后基金资助项目(No.2014M552357);南京邮电大学江苏省图像处理与图像通信重点实验室开放基金资助项目(No.LBEK2013001). *通信作者:严斌宇 email:yby@https://www.doczj.com/doc/6e12394877.html,

视觉传达设计调研报告 随着人类文明的不断发展,各种视觉传达技术为我们提供了丰富多彩的视觉感受,并且已经从传统的美术、装饰发展到新闻、电子等新兴领域。广告媒介的发展也非常之迅速,据不完全统计,“十一五规划”期间,仅北京市大大小小的广告公司就有3000多家。时代呼唤高质量的广告和高质量的视觉传达设计人才。 一、视觉传达设计行业状况分析 视觉传达设计是指设计者利用平面视觉符号——文字、插图和标志,来传递给接受者各种信息的设计。创意产业在发达国家是一个兴旺的产业,利润极高,我国设计比欧美发达国家要落后30-50年,所以在设计领域有着巨大的发展空间,平面设计行业是最有发展潜力的行业之一。近日来,社会上对视觉传达设计专业方面的人才需求量与日俱增。虽然国内各主要艺术院校和综合性大学艺术系的有关专业都不断地在扩大招生人数,但培养出的设计专业人才还是远远不能满足社会的需要,呈现出供不应求的状态。由于商品市场的刺激和需求,视觉传达设计行业一直是社会热门行业。视觉传达设计行业的应用已无处不在,各类展览展示发布机构、超市、银行、大中型商场橱窗、企事业单位宣传机构等越来越多地依赖于视觉传达行业的介入。设计公司、装饰设计公司、装潢设计公司、广告公司等大量涌现,急需经过系统视觉传达设计专业培养的人才 二、视觉传达设计专业就业市场分析

设计的世界是一个竞争性强,瞬息万变的世界,要求广告从业人员对社会有准确的领悟,既对时尚潮流了如指掌,又对民族的,精典的,传统的设计元素领会透彻;既要关心商家想要做到什么,又要关心老百姓在想些什么;反应敏捷,思维活跃,有饱满的热情和充沛的精力。这一切没有长期的积累和训练是办不到的。很多很好的大学视觉传达设计专业教育正是从这样一点一滴小处着眼,从基础理论,基本思维,基本技巧,基本训练等方面为使学生成为一个合格的视觉传达设计师而做准备。现在视觉传达设计行业各媒体,包括电视、报纸、杂志、车体、车内、展位、户外、DM刊登都是很好的发展趋势,也被各商家所看好,虽然竞争激烈,但是如果在这一行业做久了,对自身也是一个相当的提高,而且有利于个人发展,对以后的从事行业也有一定的帮助。视觉传达设计作为一种有偿的、付费的信息传播形式,它利用各种传播媒介被设计内容传播给大众。同时,视觉传达设计也是文化观念的载体之一,在一定的社会文化环境中就会产生适应这种社会文化环境的广告。一方面,视觉传达设计受到特定的社会文化环境的影响,是反应社会文化的一面镜子;另一方面,视觉传达设计本身就是社会文化的一个组成部分,对整个社会文化有着潜移默化的巨大影响。因此,视觉传达设计除了宣传具体商品以外,还宣传了特定的社会价值观和文化价值观。 进入21世纪,人类不得不承认技术正在重新构造我们的现实,它已经成为一种强大的力量,在很大程度上控制和决定了社会、经济、文化及其未来的发展。计算机技术、网络信息技术、多媒体技术使人们直接面临“数字化生存”,与此同时,它们也冲击着传统的传达方式,视觉传达设计正在经历着一场数字化的革命。而这些先进的技术、先进的探索设备、先进的研究

一、等积变换模型 ⑴等底等高的两个三角形面积相等; 其它常见的面积相等的情况 ⑵两个三角形高相等,面积比等于它们的底之比; 两个三角形底相等,面积比等于它们的高之比。 如上图12::S S a b = ⑶夹在一组平行线之间的等积变形,如下图ACD BCD S S =△△; 反之,如果ACD BCD S S =△△,则可知直线AB 平行于CD 。 ⑷正方形的面积等于对角线长度平方的一半; ⑸三角形面积等于与它等底等高的平行四边形面积的一半; 五大模型 1S 2 S

二、鸟头定理(共角定理)模型 两个三角形中有一个角相等或互补,这两个三角形叫做共角三角形。 共角三角形的面积比等于对应角(相等角或互补角)两夹边的乘积之比。 如图,在ABC △中,,D E 分别是,AB AC 上的点(如图1)或D 在BA 的延长线上,E 在AC 上(如图2),则:():()ABC ADE S S AB AC AD AE =??△△ 图1 图2 三、蝴蝶定理模型 任意四边形中的比例关系(“蝴蝶定理”): ①1243::S S S S =或者1324S S S S ?=?②()()1243::AO OC S S S S =++ 蝴蝶定理为我们提供了解决不规则四边形的面积问题的一个途径.通过构造模型,一方面可以使不规则四边形的面积关系与四边形内的三角形相联系;另一方面,也可以得到与面积对应的对角线的比例关系。 梯形中比例关系(“梯形蝴蝶定理”) ①2213::S S a b = ②221324::::::S S S S a b ab ab =; ③梯形S 的对应份数为()2 a b +。

LDA(主题模型)算法 &&概念: 首先引入主题模型(Topic Model)。何谓“主题”呢?望文生义就知道是什么意思了,就是诸如一篇文章、一段话、一个句子所表达的中心思想。不过从统计模型的角度来说,我们是用一个特定的词频分布来刻画主题的,并认为一篇文章、一段话、一个句子是从一个概率模型中生成的。 LDA可以用来识别大规模文档集(document collection)或语料库(corpus)中潜藏的主题信息。它采用了词袋(bag of words)的方法,这种方法将每一篇文档视为一个词频向量,从而将文本信息转化为易于建模的数字信息。 LDA(Latent Dirichlet Allocation)是一种文档主题生成模型,也称为一个三层贝叶斯概率模型,包含词、主题和文档三层结构。所谓生 注:每一篇文档代表了一些主题所构成的一个概率分布,而每一个主题又代表了很多单词所构成的一个概率分布。 备注: 流程(概率分布):→→ 许多(单)词某些主题一篇文档 /**解释:LDA生成过程 *对于语料库中的每篇文档,LDA定义了如下生成过程(generativeprocess): *1.对每一篇文档,从主题分布中抽取一个主题; *2.从上述被抽到的主题所对应的单词分布中抽取一个单词; *3.重复上述过程直至遍历文档中的每一个单词。 **/ 把各个主题z在文档d中出现的概率分布称之为主题分布,且是一个多项分布。把各个词语w在主题z下出现的概率分布称之为词分布,这个词分布也是一个多项分布。

&&深入学习: 理解LDA,可以分为下述5个步骤: 1.一个函数:gamma函数 2.四个分布:二项分布、多项分布、beta分布、Dirichlet分布 3.一个概念和一个理念:共轭先验和贝叶斯框架 4.两个模型:pLSA、LDA(在本文第4 部分阐述) 5.一个采样:Gibbs采样 本文便按照上述5个步骤来阐述,希望读者看完本文后,能对LDA有个尽量清晰完整的了解。同时,本文基于邹博讲LDA的PPT、rickjin的LDA数学八卦及其它参考资料写就,可以定义为一篇学习笔记或课程笔记,当然,后续不断加入了很多自己的理解。若有任何问题,欢迎随时于本文评论下指出,thanks。 1 gamma函数 整体把握LDA 关于LDA有两种含义,一种是线性判别分析(Linear Discriminant Analysis),一种是概率主题模型:隐含狄利克雷分布(Latent Dirichlet Allocation,简称LDA),本文讲后者(前者会在后面的博客中阐述)。 另外,我先简单说下LDA的整体思想,不然我怕你看了半天,铺了太长的前奏,却依然因没见到LDA的影子而显得“心浮气躁”,导致不想再继续看下去。所以,先给你吃一颗定心丸,明白整体框架后,咱们再一步步抽丝剥茧,展开来论述。 按照wiki上的介绍,LDA由Blei, David M.、Ng, Andrew Y.、Jordan于2003年提出,是一种主题模型,它可以将文档集中每篇文档的主题以概率分布的形式给出,从而通过分析一些文档抽取出它们的主题(分布)出来后,便可以根据主题(分布)进行主题聚类或文本分类。同时,它是一种典型的词袋模型,即一篇文档是由一组词构成,词与词之间没有先后顺序的关系。此外,一篇文档可以包含多个主题,文档中每一个词都由其中的一个主题生成。 LDA的这三位作者在原始论文中给了一个简单的例子。比如假设事先给定了这几个主题:Arts、Budgets、Children、Education,然后通过学习的方式,获取每个主题Topic对应的词语。如下图所示:

视觉传达毕业论文范文 一、论文说明 本团队专注于毕业论文写作与辅导服务,擅长案例分析、编程仿真、图表绘制、理论分析等,论文写作300起,具体价格信息联系 二、论文范文参考如下 网络媒体的视觉传达设计研究 思路: 新世纪是网络发展的时代,人类社会正经历着一场前所未有的信息革命。随着以计算机、通信和信息技术为支柱的互联网络的迅速普及,人类生活的方方面面发生了极大的变化。继印刷、声音、图像诸媒体之后,网络被称为第四媒体,网络综合了声音、图像、图形、文字等多种信息载体,代表着一种崭新的信息交流方式。目前国内外网络。 题目:网页的视觉传达与设计表现研究 思路: 视觉传达设计作为利用视觉符号准确传递信息的同时给受众以视觉美感的设计活动,从诞生之初就与媒介有着密不可分的关系。媒介技术的发展带动视觉传达设计不断进步,作为视觉传达设计的最新发展形式,以数字媒介为载体的视觉传达以新技术创造新的设计语言和新的设计形态,在设计观念、设计流程、设计方法等方面都产生了转变,为视觉传。 题目:现代视觉传达设计中的多感官表达研究 思路: 一个世纪以来,视觉传达设计以其丰富的形象特征和独特的表现手法极大地

拓展了人们的经验领域,丰富了人们对客观世界信息的掌握,对现代人们的物质生活、情感体验以至思维方式等各方面都产生了一定的影响。随着物质生活现代化的飞速发展,人们在物质需要逐渐满足的同时,越来越重视自身的感官需求。同时,新媒介的普及和发展在很大程度上冲击了传。 题目:视觉传达设计的绿色化研究 思路: 本文从我国视觉传达设计及其在应用性范畴内的基本现状出发,通过对视觉传达设计的涵义、基本要求及特性的重读和再认识,深入剖析其发展过程、当前现实状况及凸现的主要问题,认为当今视觉传达设计的作品质量亟需提高,同时设计作品投放到社会生活空间的形式数量有待于调控。在这些分析研究之上,结合绿色设计理念,提出视觉传达设计的。 题目:论新媒介视觉传达设计发展中的媒介和发展中的视觉传达设计 思路: 新媒介的发展引起了社会生活的巨大变化,同样在视觉传达设计领域也发生了从设计形式到设计内容的变化。本论文着重讨论新媒介视觉传达设计的特点,分析其设计内容,比较传统视觉传达设计以探求视觉传达设计的发展趋势。视觉传达设计与媒介有密不可分的关系,媒介的发展推动了视觉传达设计的。 题目:基于观者位移产生的动态错觉在视觉传达设计中的应用 思路: 在图像信息激增的读图时代,受众面对海量视觉信息的刺激已渐渐变得麻木,视觉传达设计仅仅囿于静态的视觉语言已不能再持续吸引受众的注意。基于观者位移产生的动态错觉在视觉传达设计中的应用,相对于静态的传达方式更能吸引观者的注意力,使其产生浓厚的视觉兴趣,并且观者对信息的记忆度和识别度也大大提高。动态错觉在视觉传达设计中的应用推。

图像分类学习笔记:词袋模型和空间金字塔匹配 Image Classification Framework: Bag-of-Words &Spatial Pyramid Matching 一、基础:词袋模型(Bag of Words ) Bag-of-Words (词袋、词包)模型,或称Bag of Features 模型,源于文本分类技术。在信息检索中,假定对于一个文本,忽略其词序和语法、句法。将其仅仅看作是一个词的集合,每个词都是彼此概率独立的。这样可以通过文档中单词出现的频率来对文档进行描述与表达。Csurka 等[1]于2004年将其引入计算机视觉领域。 其核心思想在于,图像可以视为一种文档对象,图像中不同的局部区域或其特征可看作构成图像的词汇,其中相近的区域或其特征可以视作为一个词。这样,可以把每幅图像描述为一个局部区域/关键点(Patches/Key Points)特征的无序集合。理论对应关系如下:文档单词字典图像特征聚类中心特征聚类集合 用词袋模型生成对一张图像的描述向量的处理步骤: 1、局部特征提取 通过兴趣点检测、密集采样或随机采集,结合图割区域、 显著区域等方式获得图像各处的局部特征。常用的是 SIFT 特征和Dense SIFT 特征。 2、构建视觉词典 在整个训练集上提取局部特征后,使用某种聚类算法(如K-means)将局部特征进行聚类,每个聚类中心可以看作是词典中的一个视觉词汇(Visual Word),相当于文本检索中的词,视觉词汇由聚类中心对应特征形成的码字(code word)来表示(可看作一种特征量化过程)。所有视觉词汇形成一个视觉词典(Visual Vocabulary),词典中所含词的个数反映了词典的大小。

基于BIM模型制作施工模拟及演示动画的总结 李博关锦鹏 一、BIM模型介绍 公司拟定于2014年12月25日进行吕梁新城供水一期工程项目的投标,为在投标中展示公司技术实力与施工水平,投标前公司领导决定为该项目制作施工模拟及效果演示动画。 该项目模型由Revit软件制作,建模工作早于2014年9月份开始并于2014年11月中旬完成,模型包含净水厂的工艺管道系统、热力系统、排污系统、雨排水系统、自用水系统以及各车间互联管道等,此外还根据土建图纸制作了各车间的简化模型并标示名称。 二、动画制作过程 演示动画使用NavisWorks软件制作,于2012年12月15日开始12月21日结束,历时一周。动画内容包括整体鸟瞰和主工艺管道漫游、各管道系统展示、模拟施工演示、设计问题检查等内容。具体制作过程如下: 1、对模型中的管道系统及建筑物建立多个选择集,以便渲染及模拟施工时能够快速准确选择对象。 2、选择背景颜色并使用Autodesk Rendering为各个选择集中的对象染色,染色完成后对各对象颜色进行调整。 3、使用保存视点功能制作漫游动画并导出。 4、使用TimeLiner功能制作模拟施工演示动画并导出。

5、通过隐藏与显示使不同系统单独显示并截图保存。 6、使用Revit软件对模型显示的设计问题进行截图,修改问题后再次截图。 7、使用PPT制作图片的演示文稿以及各段视频间的衔接字母的演示文稿并导出动画。 8、使用视频合成软件将上述素材合成为一个视频,加背景音乐,加水印。 三、动画制作经验总结 1、在NavisWorks中建立选择集通常是通过从选择树中选取进行的。选择树中的根目录为Revit文件名称,二级目录为图层名称也即Revit文件中的标高名称。换言之,Revit建模过程中,在某个标高上建立的模型转化到NavisWorks中就必然出现在该标高名称的图层(即选择树根目录)中。NavisWorks图层中的项目名称与Revit建模时对项目的命名名称一致,而选择树则会将同一名称的对象和同一类型的对象归类。根据上述规律,我们在建模时如果将同系统管道与管件命名成相同名称或在指定的标高下建模,在NavisWorks的选择树中则极易选取。如图:

模型一 三角形等高模型 已经知道三角形面积的计算公式: 三角形面积=底?高2÷ 从这个公式我们可以发现:三角形面积的大小,取决于三角形底和高的乘积. 如果三角形的底不变,高越大(小),三角形面积也就越大(小); 如果三角形的高不变,底越大(小),三角形面积也就越大(小); 这说明当三角形的面积变化时,它的底和高之中至少有一个要发生变化.但是,当三角形的底和高同时发生变化时,三角形的面积不一定变化.比如当高变为原来的3倍,底变为原来的13 ,则三角形面积与原来的一样.这 就是说:一个三角形的面积变化与否取决于它的高和底的乘积,而不仅仅取决于高或底的变化.同时也告诉我们:一个三角形在面积不改变的情况下,可以有无数多个不同的形状. 在实际问题的研究中,我们还会常常用到以下结论: ①等底等高的两个三角形面积相等; ②两个三角形高相等,面积比等于它们的底之比; 两个三角形底相等,面积比等于它们的高之比; 如图 12::S S a b = b a S 2S 1 D C B A ③夹在一组平行线之间的等积变形,如右上图ACD BCD S S =△△; 三角形等高模型与鸟头模型

反之,如果ACD BCD S S △△,则可知直线AB 平行于CD . ④等底等高的两个平行四边形面积相等(长方形和正方形可以看作特殊的平行四边形); ⑤三角形面积等于与它等底等高的平行四边形面积的一半; ⑥两个平行四边形高相等,面积比等于它们的底之比; 两个平行四边形底相等,面积比等于它们的高之比.

【例 1】 你有多少种方法将任意一个三角形分成:⑴ 3 个面积相等的三角形; ⑵ 4个面积相等的三角形;⑶6个面积相等的三角形。 【解析】 ⑴ 如下图,D 、E 是BC 的三等分点,F 、G 分别是对应线段的中点, 答案不唯一: C E D B A F C D B A G D B A ⑵ 如下图,答案不唯一,以下仅供参考: ⑸ ⑷⑶⑵⑴ ⑶如下图,答案不唯一,以下仅供参考: 【例 2】 如图,BD 长12厘米,DC 长4厘米,B 、C 和D 在同一条直线上。 ⑴ 求三角形ABC 的面积是三角形ABD 面积的多少倍? ⑵ 求三角形ABD 的面积是三角形ADC 面积的多少倍? 【解析】 因为三角形ABD 、三角形ABC 和三角形ADC 在分别以BD 、BC 和DC 为底时,它们的高都是从A 点向BC 边上所作的垂线,也就是说三个三角形的高相等。 于是:三角形ABD 的面积12=?高26÷=?高 三角形ABC 的面积124=+?()高28÷=?高 三角形ADC 的面积4=?高22÷=?高 所以,三角形ABC 的面积是三角形ABD 面积的43 倍; 三角形ABD 的面积是三角形ADC 面积的3倍。 【例 3】 如右图,ABFE 和CDEF 都是矩形,AB 的长是4厘米,BC 的长是3厘米, 那么图中阴影部分的面积是 平方厘米。 C D B A

视觉传达的相关问题研究: 1、设计科学与艺术设计的关系问题 2、视觉传达的有效性问题 3、视觉传达设计的功能性与艺术性的辩证思考 4、关于视觉传达的主体与客体问题研究 5、视觉传达的功能性研究等 6、视觉传达媒介研究 图形创意 1、图形创意与平面设计的关系问题研究 2、图形创意训练方法研究 3、视觉图形与概念传达问题的研究 4、图形创意表现手法的研究 5、图形创意法则研究 6、摄影类图形创意分析 7、绘写类图形创意分析研究 8、图形创意与创造性思维的相关研究 9、图形创意与构图的关系分析研究 10、图形创意信息传递的研究 11、图形创意与电脑辅助设计的研究 12、图形创意与插图的关系 13、图形创意的手法和材料的研究 14、图形创意种色彩的研究

15、图形创意的形象演绎过程的研究 16、图形创意与团关系的研究 招贴设计研究 1、广告的定位问题研究 2、广告的媒体研究 3、招贴画的艺术性与功能性的研究 4、招贴画的设计元素研究(图形、色彩、文字、图形、板式、装饰性的点线面、标志) 5、招贴设计创意思维研究 6、招贴设计的教育性功能研究、 7、招贴设计二维空间尺度研究 8、绘画手段在招贴设计制作中应用研究 9、招贴新形势的探索研究等 书籍装帧设计相关问题研究 1、书籍装帧新型结构探索研究 2、书籍装帧设计中的内容与形式和谐关系的探索研究 3、读者类群的分析与书籍装帧设计的定位研究 4、书籍类别的分析与书籍装帧风格研究 5、书籍装帧设计材料的探索与研究 6、影响书记传播推广比设计因素研究 7、民族图书设计的探索研究 8、系列书籍设计的探索与研究

9、书籍设计之中版式、色彩、构成、文字、图形等元素的探索研究 10、封面设计与书籍装帧整体设计的关系 11、书籍装帧设计中的封面、扉页、环衬、勒口、次目、空白页、赠献、版权页的整体配合关系的研究 12、插图相关问题的研究 包装设计相关问题研究 1、包装设计中的材料探索与研究 2、包装设计中的结构探索与研究 3、包装设计中内外包装的和谐关系的探索与研究 4、包装设计中的色彩、构成、文字、图形、肌理等元素的研所与研究 5、包装设计中不同产品的消费群定位分析研究 6、系列包装设计的探索与研究 7、包装设计中的民族性、地域性的探索与研究 8、包装设计中造型的探索与研究 9、包装设计与环境保护之间的关系的探索与研究 10、包装设计与产品附加值的探索与研究 11、包装设计与消费者心理的探索与研究 12、包装设计中广告与宣传效应作用的探索与研究 13、礼品包装设计的探索与研究 VI设计相关问题研究 1、企业标志设计与企业精神的探讨与研究

小学平面几何五大模型 一、共角定理 两个三角形中有一个角相等或互补,这两个三角形叫做共角三角形. 共角三角形的面积比等于对应角(相等角或互补角)两夹边的乘积之比. 如图在ABC △中,,D E 分别就是,AB AC 上的点如图 ⑴(或D 在BA 的延长线上,E 在AC 上),则:():()ABC ADE S S AB AC AD AE =??△△ 证明:由三角形面积公式S=1/2*a*b*sinC 可推导出 若△ABC 与△ADE 中, ∠BAC=∠DAE 或∠BAC+∠DAE=180°, 则 ADE ABC S S ??=AE AD AC AB ?? 二、等 积模型 ①等底等高的两个三角形面积相等; ②两个三角形高相等,面积比等于它们的底之比; 两 个三 角形底相等,面积比 等于它们的高之比; 如下图12::S S a b = ③夹在一组平行线之间的等积变形,如右图ACD BCD S S =△△; 反之,如果ACD BCD S S =△△,则可知直线AB 平行于CD . ④等底等高的两个平行四边形面积相等(长方形与正方形可以瞧作特殊的平行四边形); ⑤三角形面积等于与它等底等高的平行四边形面积的一半; ⑥两个平行四边形高相等,面积比等于它们的底之比;两个平行四边形底相等,面积比等于它们的高之比. 三、蝶形定理 1、任意四边形中的比例关系(“蝶形定理”): ① 1243::S S S S =或者1324S S S S ?=? ② ()()1243::AO OC S S S S =++ 速记:上×下=左×右 蝶形定理为我们提供了解决不规则四边形的面积问题的一个途径.通过构造模型,一方面 可以使不规则四边形的面积关系与四边形内的三角形相联系;另一方面,也可以得到与面积对应的对角线的比例关系. 2、梯形中比例关系(“梯形蝶形定理”): b a S 2 S 1 D C B A

三维人体动态计算机模拟及仿真系统 (一) LifeMOD生物力学数字仿真软件 1. 简介 LifeMOD 生物力学数字仿真软件是在 MSC.ADAMS 基础上,进行二次开发,用以研究人体生物力学特征的数字仿真软件,是当今最先进、最完整的人体仿真软件。LifeMOD 生物力学数字仿真软件可用于建立任何生物系统的生物力学模型。这种仿真技术可使研究人员建立各种各样的人体生物力学模型,模拟和仿真人体的运动,并深入地了解人体动作背后的力学特性以及动作技能控制规律。鉴于LifeMOD 生物力学数字仿真软件的强大功能,它成功地应用于生物力学、工程学、康复医学等多个领域。 2. 厂商 美国BRG(Biomechanics Research Group)公司具有超过20年的与世界顶级研究机构和商业机构的成功合作历史,包括体育器材生产商、整形外科、人体损伤研究机构、高校和研究院所、政府机构、医疗器械生产商以及空间技术研究机构,在生物力学、工程学、康复医学等许多行业中有卓越的名誉。 3. 型号 LifeMOD 2008.0.0 4. 功能 LifeMOD 生物力学数字仿真软件的功能强大、先进而且普遍适用。 LifeMOD 生物力学数字仿真软件可用于建立任何生物系统的生物力学模型。这种仿真技术可使研究人员建立各种各样的人体生物力学模型;这些模型既能够再现现实的人体运动,也能够按照研究者的意愿预测非现实的人体运动;通过人体动作的模拟和仿真,计算出人体在运动过程中的运动学和动力学数据,从而使研究者能够深入地了解人体动作背后的力学特性以及动作技能控制规律。 在体育领域,利用LifeMOD的个性化建模和强大的计算能力,不但可以将运动员的比赛和训练情况进行再现并分析运动学、动力学特征,而且能够根据运动员各自的生理特征来进行不同情况的仿真,进行优化分析,进而达到优化运动员技术的目的,从而指导和帮助运动训练。 5. 软件特性 LifeMOD 生物力学数字仿真软件是创建成熟、可信的人体模型的工具。它具有以下特性: ● 快速生成人体模型。能在不到一分钟的时间里完成人体模型的创建。● 完整的骨骼/皮肤/肌肉模型。具有骨骼、皮肤、肌肉的人体模型与受试 对象是成比例的。 ● 可根据研究需要,建立不同精度的人体模型。(简单的是19环节18关

小学奥数-几何五大模型(蝴蝶模型) -CAL-FENGHAI-(2020YEAR-YICAI)_JINGBIAN

模型三 蝴蝶模型(任意四边形模型) 任意四边形中的比例关系(“蝴蝶定理”): S 4 S 3 S 2 S 1O D C B A ①1243::S S S S =或者1324S S S S ?=? ②()()1243::AO OC S S S S =++ 蝴蝶定理为我们提供了解决不规则四边形的面积问题的一个途径。通过构造模型,一方面可以使不规则四边形的面积关系与四边形内的三角形相联系;另一方面,也可以得到与面积对应的对角线的比例关系。 【例 1】 (小数报竞赛活动试题)如图,某公园的外轮廓是四边形ABCD ,被对角线AC 、BD 分成四 个部分,△AOB 面积为1平方千米,△BOC 面积为2平方千米,△COD 的面积为3平方千米,公园由陆地面积是6.92平方千米和人工湖组成,求人工湖的面积是多少平方千米? 【例 2】 O D C B A 【分析】 根据蝴蝶定理求得312 1.5AOD S =?÷=△平方千米,公园四边形ABCD 的面积是 123 1.57.5+++=平方千米,所以人工湖的面积是7.5 6.920.58-=平方千米 【巩固】如图,四边形被两条对角线分成4个三角形,其中三个三角形的面积已知, 求:⑴三角形BGC 的面积;⑵:AG GC = 任意四边形、梯形与相似模 型

B 【解析】 ⑴根据蝴蝶定理,123BGC S ?=?,那么6BGC S =; ⑵根据蝴蝶定理,()():12:361:3AG GC =++=. () 【例 3】 四边形ABCD 的对角线AC 与BD 交于点O (如图所示)。如果三角形ABD 的面积等于三角 形BCD 的面积的1 3 ,且2AO =,3DO =,那么CO 的长度是DO 的长度的_________倍。 A B C D O H G A B C D O 【解析】 在本题中,四边形ABCD 为任意四边形,对于这种”不良四边形”,无外乎两种处理方 法:⑴利用已知条件,向已有模型靠拢,从而快速解决;⑵通过画辅助线来改造不良四边形。看到题目中给出条件:1:3ABD BCD S S =,这可以向模型一蝴蝶定理靠拢,于是得 出一种解法。又观察题目中给出的已知条件是面积的关系,转化为边的关系,可以得到第二种解法,但是第二种解法需要一个中介来改造这个”不良四边形”,于是可以作AH 垂直BD 于H ,CG 垂直BD 于G ,面积比转化为高之比。再应用结论:三角形高相同,则面积之比等于底边之比,得出结果。请老师注意比较两种解法,使学生体会到蝴蝶定理的优势,从而主观上愿意掌握并使用蝴蝶定理解决问题。 解法一:∵::1:3ABD BDC AO OC S S ??==, ∴236OC =?=, ∴:6:32:1OC OD ==. 解法二:作AH BD ⊥于H ,CG BD ⊥于G . ∵1 3 ABD BCD S S ??=, ∴13 AH CG =, ∴13 AOD DOC S S ??=, ∴13 AO CO =, ∴236OC =?=, ∴:6:32:1OC OD ==. 【例 4】 如图,平行四边形ABCD 的对角线交于O 点,CEF △、OEF △、ODF △、BOE △的面积 依次是2、4、4和6。求:⑴求OCF △的面积;⑵求GCE △的面积。

Pattern Recognition Term Project Report Using Visual Words for Image Classification u9562171, 雷禹恆 1.Abstract Visual words 近年來在image retrieval領域被大量使用。它是基於文字上的textual words,套用在影像上的類比,因此可將過去在text retrieval領域的技巧直接利用於image retrieval,也有助於large-scale影像搜尋系統的效率。Visual words的擷取大致上是將影像的SIFT features,在keypoint feature space上做K-means clustering的結果,以histogram來表示,是一種bag-of-features。除了可用於retrieval外,visual words也被用於image classification。本專題的目的就是將visual words作為影像特徵,並套用於multi-class image classification。 2.Introduction Visual words (簡稱VWs) 近年來在image retrieval領域被大量使用,其motivation其實是從text retrieval領域而來,是基於文字上的textual words,套用在影像上的類比。 如同於一篇文章是由許多文字 (textual words) 組合而成,若我們也能將一張影像表示成由許多 “visual words” 組合而成,就能將過去在text retrieval領域的技巧直接利用於image retrieval;而以文字搜尋系統現今的效率,將影像的表示法「文字化」也有助於large-scale影像搜尋系統的效率。 在文獻 [1] 有提到motivation of visual words的細節。首先我們先回顧text retrieval 的過程:1. 一篇文章被parse成許多文字,2. 每個文字是由它的「主幹(stem)」來表示的。例如以 ‘walk’ 這個字來說,‘walk’、‘walking’、‘walks’ 等variants同屬於 ‘walk’ 這個主幹,在text retrieval system裡被視為同一個字。3. 排除掉每篇文章都有的極端常見字,例如 ‘the’ 和 ‘an’。4. 一篇文章文章的表示法,即以每個字出現頻率的histogram vector來表示。5. 在此histogram中,對於每個字其實都有給一個某種形式weight,例如Google利用PageRank [2] 的方式來做weighting。6. 在執行文字搜尋時,回傳和此query vector最接近(以角度衡量)的文章。 下一節將解釋影像中VW的特徵擷取流程,及其與此段之1.、2.、4.的類比。 3.Construction of Visual words Visual words的建構流程可以用圖(1)來說明:

摘要:经过半个多世纪的发展,仿真技术已经成为对人类社会发展进步具有重要影响的一门综合性学科。本文对建模与仿真技术发展趋势作了比较全面的分析。仿真建模方法更加丰富,更加需要仿真建模具有互操作性和可重用性,仿真建模与可信度评估成为仿真建模发展的重要支柱;仿真体系结构逐渐形成标准,仿真系统层次化、网络化已成为现实,仿真网格将是下一个重要发展方向;仿真应用领域更加丰富,向复杂系统领域发展,并将更将贴近人们的生活。 经过半个多世纪的发展,仿真技术已经成为人类社会发展进步具有重要影响的一门综合性学科。仿真技术的领域不在局限于某些尖端学科技术研究领域,而成为一项被众多学科领域广泛采用的通用型技术。半个世纪以来,仿真救赎一方面始终是建模技术、计算技术和其他信息技术最先的应用者,另一方面是对计算技术和网络技术等的发展不断提出新的挑战。 在我国建模与仿真方法是随着应用需求的发展不断的进步,近十年来仿真技术发展是沿着以应用需求牵引建模与仿真系统开发、以建模与仿真系统带动建模与仿真技术突破、以建模与仿真技术促进建模与仿真系统发展、将建模与仿真系统又服务于应用良性循环的道路向前发展。 仿真技术研究人员一方面不断地扩展仿真应用领域,另一方面,其他领域研究的丰富成果与不断促使仿真技术人员从新的角度、新的高度、新的广度认识建模与仿真。在近半个世纪的积累和近十年的快速发展的基础上,建模与仿真技术已经成为以相似原理、模型理论、系统技术、信息技术以及仿真应用领域的有关专业技术为基础,以计算机系统、与应用相关的物理效应设备及仿真器为工具,利用模型对已有的或设想的系统进行研究、分析、实验与运行的一门综合性技术。 仿真建模的发展 仿真是基于建模的活动,模型建立、实现、验证、应用是仿真过程不变的主题。随着时代的发展,仿真模型包含的内容大大扩展,建模方法日益多样,模型交互性和重要性变的越来越重要,模型的校核与验证的成功为仿真中必要步骤。 -----------------------------------系统仿真学报杨明张冰王子才哈尔滨工业大学,哈尔滨150001 基本概念 系统:按照某些规律结合起来,互相作用、互相依存的所有实体的集合或总和。模型:从特定应用角度,表达对象系统特征与特性的形式。仿真:用物理模型或数学模型代替实际系统进行实验和研究。 对象系统:仿真、分析与研究的对象。仿真系统:实施仿真的系统。 仿真分类:

农作物空间格局动态变化模拟模型(CROPS)构建 夏天1,2, 吴文斌1,2,*, 余强毅1,2, 杨鹏1,2, 周清波1,2, 唐华俊1,2(1.农业部农业信息技术重点实验室,北京100081;2.中国农业科学院农业资源与农业区划研究所,北京100081) 摘要:农作物空间格局指特定区域内农作物种植结构、空间分布等信息,是农业土地系统的核心内容之一,也是农业结构调整的重要依据。随着空间模拟技术的发展,农业土地系统的时空动态表达成为可能,但传统模型方法更多关注土地利用类型的转化,而忽视耕地内部农作物格局时空特征的表达。本研究基于CLUE-S土地利用变化模拟模型,进行了概念模型设计、框架和模块重建、参数本底化和校正,研究并提出一个适用于我国农作物空间格局动态变化模拟模型(CROPS,Crop Pattern Simulator)的可行架构,使其能够实现区域尺度土地利用变化与农作物空间格局变化的双层动态模拟。CROPS模型采用了两层次嵌套模拟的模型结构,第一个层次实现对耕地空间格局动态变化过程和状态的表达,第二层次基于第一层次的模拟输出的耕地空间格局,实现耕地内部的农作物空间格局动态变化的有效模拟。CROPS模型主要包括非空间和空间两个大模块,空间模块又包括空间模块I和空间模块II。CROPS模型在东北三省进行了区域应用,结果表明,模型总体模拟效果较好,能够科学合理的表达耕地空间格局和农作物空间格局的动态变化过程。 关键词:农作物空间格局;动态变化;CROPS模型 0引言 农作物空间格局特指一个区域内农作物种植结构、分布、熟制和种植方式等信息[1],是农业土地系统的核心内容之一。一方面,农作物空间格局能够反映蕴藏于农业土地系统内部的诸多服务功能,如粮食安全、农田碳库、生物质能源生产等;另一方面,其反映了空间范围内人类利用农业生产资源的状况,是农作物结构调整和优化的重要依据[2-4]。因此,开展农作物空间格局变化过程及特征研究具有较高的实用价值和重要的科学意义。 近年来,国内外很多学者针对农作物格局及其变化进行了相关研究[5]。统计调查方法是较早且较为常用的方法之一,即以一定的行政区为基本单元进行农作物面积统计分析[6, 7],但这种方法往往忽略了分析单元内部的空间异质性,而且主观性较强。随着遥感、地理信息系统等空间信息技术的发展,农作物格局的空间显性表达(Spatially-explicit representation)逐步成为可能。如[8]利用MODIS遥感数据提取了区域农作物种植结构;[9]同样利用MODIS 数据,实现了我国南方15省(市、自治区)各类水稻(早稻、晚稻和单季稻)种植面积的快速识别;Gao利用航片和遥感影像(TM/ETM+)分析了中国黑龙江省1958,1980,2000三个时间段水稻空间格局变化情况[10]。Montero利用GIS技术构建了藤类植物生长分布模型[11][12]模拟展示了新疆棉花种植面积时空格局演变特征,并揭示当地棉花种植业发展的主要驱动力;吴文斌利建立了农作物播种面积变化模拟系统,分析研究了2005-2035年间世界主要农作物(水稻、玉米、小麦和大豆)播种面积变化的数量特征和空间格局[13]。自1997年至今,美国农业部国家农业统计中心(USDA-NASS,National Agricultural Statistics Service of the US Department of Agriculture)不惜花费大量人力物力,将多源中高分辨率遥感影像与统计调查数据相结合,制作了每年一期的耕地内部作物分布图(CDL,Cropland data layers),供后续研究使用[14]。 不难发现,遥感技术是提取农作物空间分布信息的有效方法,但其相对成本较高,不利于获取大区域、长时间序列的农作物空间格局及其动态变化特征。而空间模拟技术作为遥感 夏天为博士后吴文斌为副研究员余强毅为助理研究员杨鹏为研究员周清波为研究员唐华俊为研究员 通讯作者:吴文斌Email:wuwenbin@https://www.doczj.com/doc/6e12394877.html, 基金项目:国家自然科学基金项目(40930101,40971218,41271112),国家重点基础研究发展计划项目(“973”计划)(2010CB951504)