稀疏判别分析

- 格式:doc

- 大小:56.50 KB

- 文档页数:16

高维数据分析与处理的方法与应用随着科学技术的发展,许多领域中产生了越来越多的高维数据。

高维数据是指数据量大、特征维数多的数据,通过对这些数据进行分析和处理,可以得到很多有用的信息,如发现数据间的联系、提取重要的特征以及预测未来的趋势。

然而,高维数据的分析和处理也面临着许多挑战,如维数灾难、数据稀疏性、过拟合等问题。

本文将介绍一些高维数据分析和处理的方法和应用,帮助读者更好地理解和应用这些方法。

一、高维数据的表示和降维高维数据包含了大量的特征维度,这也就让数据的表示和可视化变得十分困难。

因此,高维数据的降维是解决这个问题的关键。

常用的降维方法有主成分分析(PCA)、线性判别分析(LDA)、局部线性嵌入(LLE)等。

其中,PCA是一种广泛应用的降维方法,它可以找到数据中的主要成分,并将数据映射到一个新的低维空间中。

LDA是一种有监督的降维方法,它可以将数据映射到一个新的低维空间,并尽量分开不同类别之间的距离。

LLE是一种非线性的降维方法,它通过保持数据之间的局部距离来将数据映射到一个新的低维空间中。

二、高维数据的聚类和分类高维数据的聚类和分类是数据挖掘和机器学习中的重要问题。

在高维空间中,数据点往往是稀疏的,这也就使得常用的聚类和分类方法不太适用。

常用的聚类算法有k-means、层次聚类等,而分类算法则有支持向量机(SVM)、朴素贝叶斯(NB)等。

这些算法通常基于计算数据间距离或相似度来进行聚类或分类。

然而,在高维空间中,距离计算很容易受到噪声和无关特征的影响,导致分类或聚类效果不佳。

因此,设计更有效的高维数据聚类和分类方法还是一个重要的研究方向。

三、高维数据的特征提取和选择在高维数据分析过程中,通常需要从大量的特征中提取出有用的信息。

常用的特征提取方法有主成分分析、奇异值分解、独立分量分析等。

这些方法通常可以有效地提取出数据中的主要特征,减少维数并降低噪声影响。

在特征选择方面,可以通过计算特征与目标变量之间的关系来衡量特征的重要性,从而选择出最相关的特征。

在高维数据建模过程中如何解决失真问题研究随着互联网和计算机科技的迅速发展,数据已成为了各个行业和领域中不可缺少的一部分。

这些数据一般都是高维的,也就是说,它们包含了很多种复杂的特征。

高维数据的特点对于数据分析、建模和处理带来了很大的难度,因为高维数据会带来失真问题,影响数据的可靠性和准确性。

因此,在高维数据建模过程中如何解决失真问题,成为了当下我们需要研究和探讨的问题之一。

一、高维数据的特点和建模方法高维数据的特点可以总结为维度高、特征多、复杂度大、噪声影响大、样本稀疏等。

为了更好地利用这些数据,我们需要选择正确的建模方法,以减少高维数据中失真问题的影响。

非常经典的建模方法包括PCA主成分分析和LDA线性判别分析,都使用在高维数据分析领域,可以降低维度,减少噪声影响和特征冗余。

二、高维数据失真问题的原因及影响在对高维数据进行处理时,常常会遇到失真问题。

这是因为数据在高维空间中的分布会出现很多奇怪的现象,如维度灾难、过拟合和欠拟合等问题。

这些问题会导致数据分析结果失真、不准确,并且模型预测的可靠性会下降。

因此,在高维数据的建模过程中,失真问题是一项重要的挑战。

三、在高维数据建模中如何解决失真问题1.特征选择方法高维数据中的特征多,但并不是所有的特征都对建模有价值。

因此,我们可以通过特征选择方法,选择最具有代表性和重要性的特征,来降低维度和特征冗余的问题。

特征选择方法有很多,如过滤式、包裹式和嵌入式等方法,其选择基于不同的准则,如信息熵、相关性、惩罚和区分度等。

2.数据降维方法数据降维通常是用来降低维度和减少特征冗余的问题,从而提高数据模型的质量和可靠性。

在高维数据分析中,常用的降维方法有PCA主成分分析、LDA线性判别分析和SVD奇异值分解等方法。

这些方法可以在不损失信息的情况下,将体积庞大的高维数据降维到低维,从而简化问题。

3.使用特殊的算法对于高维数据的建模,我们可以使用一些特殊的算法来降低失真的影响。

金融数据挖掘技术的常见问题与解决方案研究随着金融市场的不断发展和复杂化,金融数据的规模和复杂性也呈现出快速增长的趋势。

为了从这些海量的数据中获取有用的信息和洞察力,金融数据挖掘技术应运而生。

然而,金融数据挖掘技术在实际应用过程中常常面临一些常见的问题。

本文将针对这些问题进行探讨,并提出相应的解决方案。

首先,一个常见的问题是数据质量。

金融数据往往存在着严重的不完整、不准确和不一致等问题。

这可能是由于数据收集和整理过程中的错误、重复录入或者数据源的不可靠性所造成的。

为了解决这个问题,可以采取以下几个措施。

首先,建立完善的数据收集和整理流程,确保数据的准确性和一致性。

其次,对数据进行清洗和去重的操作,以剔除掉无效的数据。

最后,使用数据验证和纠错算法,自动识别和修复异常数据。

其次,金融数据的高维度和稀疏性也是一个常见的问题。

由于金融数据通常包含大量的特征变量,而与这些变量相关的数据点通常是非常稀疏的。

这给数据挖掘任务带来了挑战。

为了解决这个问题,可以采用降维技术,如主成分分析(PCA)或线性判别分析(LDA),来减少数据的维度并保留最重要的特征。

此外,可以采用稀疏建模技术,如Lasso回归或稀疏编码,来处理稀疏性问题。

另外,金融数据挖掘还面临着模型选择和参数优化的问题。

在实际应用中,如何选择合适的挖掘模型以及优化模型的参数对于挖掘结果的准确性和可解释性都起着重要的作用。

为了解决这个问题,可以采用交叉验证和网格搜索的方法,通过比较不同模型在不同参数设置下的性能来选择最佳模型和参数组合。

此外,还可以使用集成学习方法,如随机森林或梯度提升树,来结合多个模型以提高预测性能。

此外,金融数据挖掘过程中还常常遇到样本不平衡的问题。

在金融领域中,欺诈检测、风险评估等任务中正常样本往往远远多于异常样本。

这样的样本不平衡会导致挖掘模型的偏差和低召回率。

为了解决这个问题,可以采用过采样和欠采样的方法对样本进行调整,使得正负样本比例更为均衡。

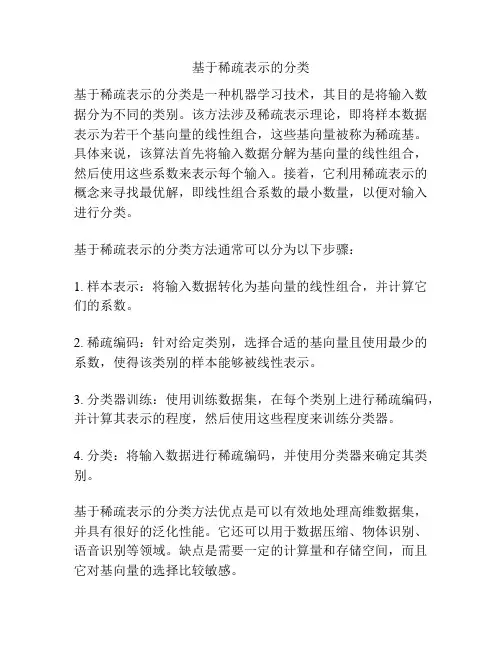

基于稀疏表示的分类

基于稀疏表示的分类是一种机器学习技术,其目的是将输入数据分为不同的类别。

该方法涉及稀疏表示理论,即将样本数据表示为若干个基向量的线性组合,这些基向量被称为稀疏基。

具体来说,该算法首先将输入数据分解为基向量的线性组合,然后使用这些系数来表示每个输入。

接着,它利用稀疏表示的概念来寻找最优解,即线性组合系数的最小数量,以便对输入进行分类。

基于稀疏表示的分类方法通常可以分为以下步骤:

1. 样本表示:将输入数据转化为基向量的线性组合,并计算它们的系数。

2. 稀疏编码:针对给定类别,选择合适的基向量且使用最少的系数,使得该类别的样本能够被线性表示。

3. 分类器训练:使用训练数据集,在每个类别上进行稀疏编码,并计算其表示的程度,然后使用这些程度来训练分类器。

4. 分类:将输入数据进行稀疏编码,并使用分类器来确定其类别。

基于稀疏表示的分类方法优点是可以有效地处理高维数据集,并具有很好的泛化性能。

它还可以用于数据压缩、物体识别、语音识别等领域。

缺点是需要一定的计算量和存储空间,而且它对基向量的选择比较敏感。

维度规约常用方法维度规约是机器学习和数据挖掘中常用的一种方法,用于降低数据维度,提高模型训练效果和运行效率。

在大多数实际问题中,数据集的维度往往很高,可能包含数千个甚至更多的特征。

高维数据不仅会导致计算复杂度的增加,还可能导致维度灾难问题,即样本密度稀疏、距离度量困难等问题。

因此,维度规约是必不可少的预处理步骤之一。

在维度规约中,常用的方法包括主成分分析(PCA)、线性判别分析(LDA)、因子分析(FA)、非负矩阵分解(NMF)等。

下面将分别介绍这些方法的原理和应用场景。

主成分分析(PCA)是一种常用的无监督学习方法,其主要思想是通过线性变换将高维数据映射到低维空间中,使得映射后的数据具有最大的方差。

PCA可以提取出数据中的主要特征,减少冗余信息。

在实际应用中,PCA常用于降维可视化和数据压缩等领域。

线性判别分析(LDA)是一种经典的有监督学习方法,其主要目标是通过线性变换将数据投影到低维空间中,同时最大化类间距离和最小化类内距离。

与PCA不同的是,LDA考虑了类别信息,因此在分类问题中具有更好的表现。

LDA常用于模式识别、人脸识别等领域。

因子分析(FA)是一种基于潜在变量模型的维度规约方法,其主要假设是观测变量由若干个潜在变量和随机误差共同决定。

FA通过估计潜在变量和因子载荷矩阵来实现维度规约。

FA常用于心理学、市场调研等领域,用于发现隐藏在观测数据背后的潜在结构。

非负矩阵分解(NMF)是一种常用的非线性维度规约方法,其主要思想是将非负矩阵分解为两个非负矩阵的乘积。

NMF适用于非负数据的降维和特征提取,常用于图像处理、文本挖掘等领域。

除了上述方法,还有一些其他常用的维度规约方法,如独立成分分析(ICA)、稀疏编码(Sparse Coding)、随机投影(Random Projection)等。

这些方法在不同的场景下具有不同的适用性和效果,并且可以结合使用以获得更好的维度规约效果。

总结起来,维度规约是机器学习和数据挖掘中重要的预处理步骤,常用方法包括PCA、LDA、FA、NMF等。

协方差矩阵奇异的充分必要条件协方差矩阵在统计学中扮演着非常重要的角色,它描述了随机变量之间的相互关系。

然而,在某些情况下,协方差矩阵可能是奇异的。

这种情况下,矩阵的逆矩阵不存在,导致了许多问题。

因此,研究协方差矩阵的奇异性是非常重要的。

那么,协方差矩阵奇异的充分必要条件是什么呢?首先,我们来了解一下什么是协方差矩阵。

协方差矩阵是一个对称矩阵,它的元素描述了随机变量之间的协方差,即一个变量的变化如何影响另一个变量。

它通常表示为S或Σ,是一个n×n矩阵,其中n为变量的数量。

如果数据集中的变量不相关,则协方差矩阵是对角矩阵,它的非对角线元素均为零。

这是因为如果两个变量之间没有关系,则它们的协方差为零。

这也是协方差矩阵为正定矩阵,逆矩阵存在的情况。

然而,在某些情况下,变量之间存在线性相关性,这导致了协方差矩阵的奇异性。

因此,协方差矩阵奇异的充分必要条件是存在线性相关性。

简单来说,如果某些变量之间存在线性关系,则协方差矩阵就会变得奇异。

在这种情况下,协方差矩阵的逆矩阵不存在,导致了许多问题。

当协方差矩阵奇异时,一些统计方法可能不可靠。

例如,主成分分析(PCA)和线性判别分析(LDA)均基于协方差矩阵,但如果矩阵奇异,则这些方法无法进行。

此外,线性回归模型的参数估计也会受到影响。

但是,即使协方差矩阵奇异,我们仍然可以有许多方法来处理它。

例如,我们可以使用正则化方法来解决协方差矩阵的奇异性问题。

正则化方法通常是在协方差矩阵上加上一个正则项,以使矩阵非奇异。

常见的正则化方法包括岭回归(ridge regression)和lasso回归(lasso regression)。

另外,我们还可以使用PCA或LDA的变体来处理奇异的协方差矩阵。

例如,分别是主成分分析的稀疏主成分分析(sparse PCA)和线性判别分析的方差最大化线性判别分析(maximum variance LDA)。

这些变体可以通过引入约束条件来解决矩阵奇异性问题。

稀疏编码的分类与回归问题解决方法稀疏编码是一种在机器学习领域中被广泛应用的技术,它在分类和回归问题的解决中发挥着重要的作用。

本文将探讨稀疏编码在分类与回归问题中的应用,并介绍一些解决这些问题的方法。

一、稀疏编码的概念和原理稀疏编码是一种基于信号表示的方法,它的目标是通过寻找一个稀疏表示来描述输入信号。

稀疏表示意味着只有很少的元素对信号的表示起到重要作用,而其他元素则可以忽略。

这种表示方式可以帮助我们提取出输入信号中最重要的特征,从而有效地解决分类和回归问题。

稀疏编码的原理是通过最小化表示误差来寻找最佳的稀疏表示。

具体而言,稀疏编码可以通过以下优化问题来定义:min ||x - Dα||^2 + λ||α||_1其中,x是输入信号,D是字典矩阵,α是稀疏表示,||·||_1表示L1范数,λ是正则化参数。

通过解决这个优化问题,我们可以得到输入信号的稀疏表示,从而实现特征提取和降维的目的。

二、稀疏编码在分类问题中的应用在分类问题中,稀疏编码可以用于特征提取和模式识别。

通过将输入信号表示为稀疏向量,我们可以选择最相关的特征,并将其用于分类器的训练和预测。

一种常见的方法是使用稀疏编码作为特征选择的工具。

通过将输入信号表示为稀疏向量,我们可以选择其中非零元素对应的特征作为最相关的特征。

这样,我们可以将特征空间降维,并且只保留最重要的特征,从而提高分类器的性能。

另一种方法是使用稀疏编码作为特征提取的方法。

通过将输入信号表示为稀疏向量,我们可以选择其中非零元素对应的特征作为提取出的特征。

这样,我们可以得到一个更加紧凑和有信息量的特征表示,从而提高分类器的性能。

三、稀疏编码在回归问题中的应用在回归问题中,稀疏编码可以用于特征选择和模型建立。

通过将输入信号表示为稀疏向量,我们可以选择其中非零元素对应的特征作为最相关的特征,并将其用于回归模型的训练和预测。

一种常见的方法是使用稀疏编码作为特征选择的工具。

通过将输入信号表示为稀疏向量,我们可以选择其中非零元素对应的特征作为最相关的特征。

第一章数据挖掘与其它数据处理方法1.1数据挖掘与传统分析方法的区别数据挖掘与传统的数据分析(如查询、报表、联机应用分析)的本质区别是数据挖掘是在没有明确假设的前提下去挖掘信息、发现知识。

数据挖掘所得到的信息应具有先未知,有效和可实用三个特征。

先前未知的信息是指该信息是预先未曾预料到的,既数据挖掘是要发现那些不能靠直觉发现的信息或知识,甚至是违背直觉的信息或知识,挖掘出的信息越是出乎意料,就可能越有价值,在商业应用中最典型的例子就是一家连锁店通过数据挖掘发现了小孩尿布和啤酒之间有着惊人的联系。

1.2数据挖掘和数据仓库大部分情况下,数据挖掘都要先把数据从数据仓库中拿到数据挖掘库或数据集市中(见图8.1 )。

从数据仓库中直接得到进行数据挖掘的数据有许多好处。

数据仓库的数据清理和数据挖掘的数据清理差不多,如果数据在导入数据仓库时已经清理过,那很可能在做数据挖掘时就没必要在清理一次了,而且所有的数据不一致的问题都已经被解决了。

数据挖掘库可能是数据仓库的一个逻辑上的子集,而不一定非得是物理上单独的数据库。

但如果数据仓库的计算资源已经很紧张,那最好还是建立一个单独的数据挖掘库根据挖掘的任务可以分为:分类和预测模型发现、数据总结和聚类、关联规则发现、序列模式发现、相似模式发现和混沌模式发现等。

根据挖掘对象来分,数据挖掘方法有面向关系数据库、空间数据库、时态数据库、文本数据源、多媒体数据库、面向对象数据库、异质数据库以及WEB言息等。

根据挖掘方法来分,数据挖掘方法可分为机器学习方法、统计方法、神经网络方法和数据库方法。

其中机器学习可细分为归纳学习方法、基于范例学习、遗传算法等;统计方法可细分为回归分析、判别分析、聚类分析、探索性分析等;神经网络方法可细分为前向神经网络、自组织神经网络等;数据库方法主要是多维数据分析或联机分析方法,另外还有面向属性的归纳方法。

数据挖掘之所以被称为未来信息处理的骨干技术之一,主要在于它以一种全新的概念改变着人类利用数据的方式。

主成分的实际含义

主成分的实际意义需要结合到实际应用中,其往往不是最终目的,重要的是利用降维的思想来综合分析原始信息,利用有限的主成分来解释规律,从而进行相关研究。

知识拓展:

主成分分析主要应用在哪些方面?

主成分分析往往不是目的,而是达到目的的一种手段,即某些研究的中间过程。

主要用途为:①在多元回归中,主要解决变量间的共线性问题,避免回归稀疏的不合理现象。

②在因子分析、聚类分析、判别分析中用于减少变量个数,即降维。

③在综合评价中,还可以作为确定变量权重的依据。

稀疏判别分析摘要:针对流形嵌入降维方法中在高维空间构建近邻图无益于后续工作,以及不容易给近邻大小和热核参数赋合适值的问题,提出一种稀疏判别分析算法(seda)。

首先使用稀疏表示构建稀疏图保持数据的全局信息和几何结构,以克服流形嵌入方法的不足;其次,将稀疏保持作为正则化项使用fisher判别准则,能够得到最优的投影。

在一组高维数据集上的实验结果表明,seda是非常有效的半监督降维方法。

关键词:判别分析;稀疏表示;近邻图;稀疏图sparse discriminant analysischen xiao.dong1*, lin huan.xiang 21.school of information and engineering, zhejiang radio and television university, hangzhou zhejiang 310030, china;2.school of information and electronicengineering,zhejiang university of science and technology, hangzhou zhejiang 310023, chinaabstract:methods for manifold embedding exists in the followingissues: on one hand, neighborhood graph is constructed in such the high-dimensionality of original space that it tends to work poorly; on the other hand, appropriate values for the neighborhood size and heat kernel parameter involved in graph construction is generally difficult to be assigned. to address these problems, a novel semi-supervised dimensionality reduction algorithm called sparse discriminant analysis (seda) is proposed. firstly, seda sets up a sparse graph to preserve the global information and geometric structure of the data based on sparse representation. secondly, it applies both sparse graph and fisher criterion to seek the optimal projection. experiments on a broad range of data sets show that seda is superior to many popular dimensionality reduction methods.methods for manifold embedding have the following issues: on one hand, neighborhood graph is constructed in such high.dimensionality of original space that it tends to work poorly; on the other hand, appropriate values for the neighborhood size and heat kernel parameter involved in graph construction are generally difficult to be assigned. to address these problems, a new semi.supervised dimensionalityreduction algorithm called sparse discriminant analysis (seda) was proposed. firstly, seda set up a sparse graph to preserve the global information and geometric structure of the data based on sparse representation. secondly, it applied both sparse graph and fisher criterion to seek the optimal projection. the experimental results on a broad range of data sets show that seda is superior to many popular dimensionality reduction methods.key words:discriminant analysis; sparse representation; neighborhood graph; sparse graph0 引言在信息检索、文本分类、图像处理和生物计算等应用中,所面临的数据都是高维的。

由于维数灾难,直接处理这些数据变得非常困难1]。

最常用的方法就是通过使用降维(dimensionality reduction,dr)技术来降低这些高维数据的维数。

降维的目的就是在低维空间中尽量真实地刻画输入数据,减少它们的复杂性,提高计算效率。

基于降维后所期望得到的信息,现有的降维可以分为三类:判别方法1-8]、几何方法9-11]和基于判别和几何方法12-14]。

基于可获得的先验信息,降维方法又可分为[15]:监督方法8,12,16-17]和无监督方法1,2,4,6,9,11]。

上述多数方法都可以被统一到图嵌入框架中8,11],因此,图的构建成为这些方法的核心问题。

事实上,对这些方法来说,构建一个高质量的图仍是个开放问题17]。

目前,流形嵌入方法(manifold embedding)使用k近邻技术和ε建近邻图(neighborhood graph)9,18]。

一旦这种近邻图被构建,边的权值由gaussian函数或者局部重构关系来决定。

这种近邻图构建方法通常存在以下几个问题19]:首先,大多数算法中的近邻图是预先构建,因此,它未必有益于后续的降维工作;其次,近邻图通常是在高维空间中构建,这样构建的图在后续的工作中表现差强人意;最后,近邻图需要的两个参数,即近邻的大小k)和热核参数(σ),通常不容因此,在降维方法中研究图的构建显得尤为重要。

另外,多数无监督降维方法在寻找投影方向过程中忽略了部分先验信息的作用,以至于它们往往不能得到最优的投影3,14]。

监督降维方法需要大量有标记样本作训练样本,限制了它的应用14]。

最近,半监督降维方法得到越来越多研究人员的关注[3,5,7,10,13-15]。

这类方法是利用少量有标记样本和大量无标记样本寻找最优的投影方向。

与监督方法相比,它更适合实际应用,与无监督方法相比,有较高的效率。

然而,现有的一些半监督降维方法通常面临和流形嵌入方法相同的问题,即近邻图构建。

如:半监督判别分析算法(semi.supervised discriminant analysis,sda)10]和半监督局部fisher判别分析算法(semi.supervised local fisher discriminant analysis,self)14]。

为了解决这些问题,本文提出一个新颖的稀疏判别分析(sparse discriminant analysis,seda)算法,seda通过使用稀疏重建技术解决流形嵌入方法中近邻图构建问题。

同时,新方法在降维过程中又能同时利用有标记和无标记样本寻找投影,提高了算法效率。

具体地说,seda有以下4个特点。

1)seda拥有同其他半监督降维方法(如sda、self)相同的特征。

如,它是线性的方法,也容易地拓展到非线性空间。

因此,可以解决外样本问题。

另外, seda使用稀疏重构技术来保存样本的几何结构,这有利于降低算法的计算复杂度。

2)seda不需要调节模型参数,如热核宽度和近邻参数。

通常,这些参数需要使用交叉验证技术给它们分配数值,但交叉验证方法既需要训练样本,还非常耗时。

相比之下,seda不需要处理这些参数。

因此,它简单实用。

3)与fisher判别分析(fisher discriminant analysis,fda)16]相同,seda是一个全局算法。

但不同的是,seda使用稀疏表示来重构样本,以至于它包含了局部几何信息。

4)由于seda在求解投影向量过程中使用了有标记和无标记样本,因此,它与流形嵌入方法相比有好的效率。

同时,seda可以容易地拓展到监督降维中。

1 相关工作根据先验信息的不同类型,半监督降维方法一般可分为两类:一类是使用有类标号的样本来引导降维过程10,14,20,22-23];另一类是使用成对约束(must.link和cannot.link)来指导降维3,5,7,10,15,20-21]。

事实上,使用有类标号的样本可以得到成对约束,但不能由成对约束得到样本的类标号。

因此,这两类方法之间存在着一定的相关性。

下面简单回顾三个有代表性的半监督降维算法。

1.1 半监督判别分析半监督判别分析算法(sda)10]是一个较为流行的基于样本标号的半监督降维方法。

它使用基于fda判别准则寻找投影,其实质是fda的半监督化。

sda首先需要刻画高维空间中近邻样本之间的关系。

详细地说,给定一个样本集x,构建一个k近邻的近邻图g来建模近邻样本之间的关系。

如果图中两个顶点x i和x j互为近邻,那么它们之间就存在一条边,相应的权值矩阵为p,其定义如下:根据上述理论分析,得到如下结论。

1)从算法1不难发现,seda简单且易执行。

自从liu等26]改进lasso算法以后,优化l1s。

第三步借助于谱回归10]计算出投影向量,并使用nystrom27]2)对于每一个样本x i,利用稀疏约束,其重构都是使用样本集的所有样本。

因此,通过使用稀疏权值矩阵s,seda3)不同于现有半监督算法使用局部保持技术来求解投影, seda 使用稀疏保持投影作为正则化项寻找投影方向。