文本相似度的计算方法

- 格式:docx

- 大小:24.34 KB

- 文档页数:6

jaccard文本相似度算法Jaccard文本相似度算法:从原理到应用引言:在信息爆炸的时代,文本数据的处理和分析变得越来越重要。

文本相似度是文本处理领域的一个重要问题,它可以帮助我们衡量两个文本之间的相似程度。

Jaccard文本相似度算法是一种常用的文本相似度计算方法,本文将从原理到应用,对Jaccard算法进行详细介绍。

一、Jaccard文本相似度算法的原理Jaccard算法是基于集合的相似度计算方法,它的原理非常简单。

假设我们有两个文本A和B,我们可以将它们分别看作两个集合,其中每个元素表示文本中的一个词语。

Jaccard算法通过计算两个集合的交集和并集的比值,来衡量两个文本之间的相似程度。

具体来说,假设文本A的词语集合为A1,文本B的词语集合为B1,那么Jaccard相似度可以通过以下公式计算:J(A,B) = |A1∩B1| / |A1∪B1|其中,|A1∩B1|表示A1和B1的交集的大小,|A1∪B1|表示A1和B1的并集的大小。

二、Jaccard文本相似度算法的应用Jaccard算法在文本处理和信息检索领域有着广泛的应用。

1. 文本聚类文本聚类是将具有相似主题的文本分组的任务。

Jaccard算法可以用来衡量两个文本之间的相似程度,从而帮助将相似的文本聚类到一起。

通过计算所有文本之间的Jaccard相似度,可以构建一个相似度矩阵,然后使用聚类算法进行文本聚类。

2. 文本分类文本分类是将文本分到不同类别的任务。

Jaccard算法可以用来比较待分类文本与已知类别文本的相似程度,从而帮助将待分类文本分到合适的类别。

通过计算待分类文本与每个类别的Jaccard相似度,可以选择相似度最高的类别作为分类结果。

3. 文本相似度搜索文本相似度搜索是根据给定的查询文本,从文本库中找到与之相似的文本的任务。

Jaccard算法可以用来计算查询文本与文本库中文本的相似程度,从而帮助检索相似的文本。

通过计算查询文本与每个文本的Jaccard相似度,可以选择相似度高于一定阈值的文本作为搜索结果。

1.信息检索中的重要发明TF-IDF1.1TFTerm frequency即关键词词频,是指一篇文章中关键词出现的频率,比如在一篇M个词的文章中有N个该关键词,则(公式1.1-1)为该关键词在这篇文章中的词频。

1.2IDFInverse document frequency指逆向文本频率,是用于衡量关键词权重的指数,由公式(公式1.2-1)计算而得,其中D为文章总数,Dw为关键词出现过的文章数。

2.基于空间向量的余弦算法2.1算法步骤预处理→文本特征项选择→加权→生成向量空间模型后计算余弦。

2.2步骤简介2.2.1预处理预处理主要是进行中文分词和去停用词,分词的开源代码有:ICTCLAS。

然后按照停用词表中的词语将语料中对文本内容识别意义不大但出现频率很高的词、符号、标点及乱码等去掉。

如“这,的,和,会,为”等词几乎出现在任何一篇中文文本中,但是它们对这个文本所表达的意思几乎没有任何贡献。

使用停用词列表来剔除停用词的过程很简单,就是一个查询过程:对每一个词条,看其是否位于停用词列表中,如果是则将其从词条串中删除。

图2.2.1-1中文文本相似度算法预处理流程2.2.2文本特征项选择与加权过滤掉常用副词、助词等频度高的词之后,根据剩下词的频度确定若干关键词。

频度计算参照TF公式。

加权是针对每个关键词对文本特征的体现效果大小不同而设置的机制,权值计算参照IDF公式。

2.2.3向量空间模型VSM及余弦计算向量空间模型的基本思想是把文档简化为以特征项(关键词)的权重为分量的N维向量表示。

这个模型假设词与词间不相关(这个前提造成这个模型无法进行语义相关的判断,向量空间模型的缺点在于关键词之间的线性无关的假说前提),用向量来表示文本,从而简化了文本中的关键词之间的复杂关系,文档用十分简单的向量表示,使得模型具备了可计算性。

在向量空间模型中,文本泛指各种机器可读的记录。

用D(Document)表示文本,特征项(Term,用t表示)指出现在文档D中且能够代表该文档内容的基本语言单位,主要是由词或者短语构成,文本可以用特征项集表示为D(T1,T2,…,Tn),其中Tk是特征项,要求满足1<=k<=N。

文本类型数据的特征提取以及相似度计算随着信息技术的发展,文本数据不断增长,如何从大量的文本数据中提取有用的信息成为一项重要任务。

而文本特征提取和相似度计算是解决这一问题的关键步骤。

一、文本特征提取特征提取是将文本数据转化为计算机可以处理的数值向量的过程。

常用的文本特征提取方法有:1.词袋模型(Bag-of-Words):将文本看作是由词汇组成的集合,构建一个词汇表,然后统计每个词汇在文本中的出现频率。

这种方法忽略了词汇的顺序和语法结构,只关注词汇的频率。

2.TF-IDF:TF-IDF(Term Frequency-Inverse Document Frequency)是一种衡量词汇在文本中重要性的方法。

它通过计算词频和逆文档频率的乘积来衡量词汇在文本中的重要程度。

3.Word2Vec:Word2Vec是一种基于神经网络的词嵌入模型,可以将词汇映射到一个低维向量空间中。

这种方法能够捕捉词汇之间的语义关系,同时保留了词汇的语法结构。

二、相似度计算相似度计算是衡量文本之间相似程度的方法。

常用的相似度计算方法有:1.余弦相似度:余弦相似度是通过计算两个向量之间的夹角余弦值来衡量它们的相似程度。

在文本特征提取中,可以将文本表示为向量,然后计算它们之间的余弦相似度。

2.编辑距离:编辑距离是衡量两个字符串之间相似程度的方法。

它通过计算将一个字符串转换为另一个字符串所需的最少编辑操作次数来衡量它们的相似程度。

3.基于语义的相似度:基于语义的相似度是通过计算两个文本之间的语义距离来衡量它们的相似程度。

常用的方法有基于词向量的相似度计算和基于语义网络的相似度计算。

三、应用场景文本特征提取和相似度计算在许多领域都有广泛的应用。

以下是一些常见的应用场景:1.文本分类:通过提取文本的特征,并计算不同文本之间的相似度,可以实现文本的自动分类。

例如,可以将新闻文章分类为政治、经济、体育等不同类别。

2.信息检索:通过计算查询文本和文档之间的相似度,可以实现信息的准确检索。

文本相似度的计算方法嘿,咱今儿就来说说这文本相似度的计算方法。

你想啊,这世界上的文本那可真是多得像天上的星星一样,那怎么来判断它们之间有多相似呢?其实啊,就跟咱平时认人似的。

咱看一个人,会看他的长相、身材、穿着打扮啥的,来判断是不是咱认识的那个。

文本相似度的计算也差不多是这么个道理。

比如说,最简单的一种方法就是直接看字词。

就好比两个人,都穿了一样颜色的衣服,那是不是就有点相似啦?文本里要是有很多相同的字词,那相似度可能就会高一些。

再复杂点呢,还得考虑字词出现的频率。

好比一个人总爱穿红衣服,另一个偶尔穿穿,那感觉还是不太一样吧?字词在文本里出现的频率高,那重要性可能就更大,对相似度的影响也就更大。

还有呢,句子的结构也很重要啊!如果两个文本的句子结构都差不多,那不是也挺像的嘛。

就像两个人走路的姿势都很像,那你可能就会觉得他们有点关联。

这还不算完,语义也是得考虑进去的。

有些词虽然不一样,但是意思差不多呀,这也能说明有相似之处呢。

就好像说“高兴”和“开心”,虽然字不同,但表达的意思很接近呀。

计算文本相似度可不像咱想象的那么简单哦!这可不是随便看看就能搞定的事儿。

得像个细心的侦探一样,一点点去分析、去比较。

那有人可能会问了,算这个文本相似度有啥用呢?用处可大啦!比如说在查重的时候,看看有没有抄袭的情况。

要是两篇文章相似度太高,那是不是得引起注意呀?还有在信息检索的时候,能帮我们更快地找到相似的内容呢。

咱再想想,要是没有这些计算方法,那不是乱套啦?到处都是重复的内容,咱找个有用的信息得多费劲呀!所以说呀,这文本相似度的计算方法可真是个好东西。

总之呢,文本相似度的计算方法就像是一把钥匙,能打开文本世界里的各种秘密。

它让我们能更好地理解和处理那些海量的文本信息,让一切都变得更加有序和清晰。

你说它重不重要?它可太重要啦!咱可得好好研究研究这些方法,让它们为我们服务,让我们的文本世界更加精彩!。

AI写作的文本相似度文本相似度是指对于给定的两段文本,通过计算它们之间的相似性得到的一个数值,用来衡量这两段文本之间的语义相似程度。

随着人工智能技术的发展,AI写作也逐渐应用于文本相似度的计算与评估。

一、什么是文本相似度文本相似度是通过对文本进行特征提取和计算相似性指标,来确定文本之间的相似程度。

一般来说,相似度计算可以分为以下几个步骤:1. 文本预处理:对文本进行分词、去除停用词、统一大小写等处理,以保证后续计算的准确性。

2. 特征提取:选择适当的特征表示方法,常见的方法有词袋模型、TF-IDF、Word2Vec等,通过将文本转化为向量表示。

3. 相似度计算:根据特征表示的向量计算文本之间的相似度,常用的计算方法有余弦相似度、编辑距离、Jaccard相似系数等。

二、AI在文本相似度中的应用AI在文本相似度中的应用主要有两个方面:文本匹配和文本分类。

1. 文本匹配文本匹配是指通过计算两段文本之间的相似度,来判断它们是否相关或者近义。

在搜索引擎、问答系统、信息检索等场景下,文本匹配可以帮助用户快速找到相关文档或者回答问题。

AI技术可以应用于文本匹配任务中,通过学习大规模的语料库,构建模型对文本进行语义建模,从而提高文本匹配的准确度。

2. 文本分类文本分类是将文本划分到预定义的类别中。

对于相似的文本,可以通过计算它们之间的相似度,来确定它们是否属于同一类别。

在垃圾邮件过滤、情感分析、新闻分类等任务中,文本分类可以帮助系统自动将文本归类,提高处理效率和准确性。

AI技术可以通过学习大量的标注数据,训练出针对文本分类的模型,从而实现高效的自动分类。

三、AI写作与文本相似度AI写作技术借助文本相似度计算,可以为写作提供帮助和参考。

通过与大量的语料库进行比较,AI可以帮助创作者改进文章的语言表达,扩充文章的内容,并提供更加准确和流畅的写作建议。

1. 语言表达改进AI写作可以通过文本相似度的计算,分析出文章中的语言表达问题,并给出提示和建议。

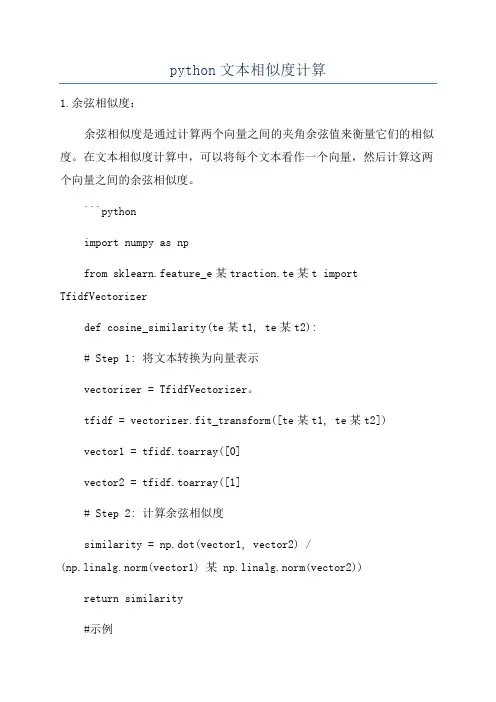

python文本相似度计算1.余弦相似度:余弦相似度是通过计算两个向量之间的夹角余弦值来衡量它们的相似度。

在文本相似度计算中,可以将每个文本看作一个向量,然后计算这两个向量之间的余弦相似度。

```pythonimport numpy as npfrom sklearn.feature_e某traction.te某t import TfidfVectorizerdef cosine_similarity(te某t1, te某t2):# Step 1: 将文本转换为向量表示vectorizer = TfidfVectorizer。

tfidf = vectorizer.fit_transform([te某t1, te某t2])vector1 = tfidf.toarray([0]vector2 = tfidf.toarray([1]# Step 2: 计算余弦相似度similarity = np.dot(vector1, vector2) /(np.linalg.norm(vector1) 某 np.linalg.norm(vector2))return similarity#示例te某t1 = "这是第一段文本。

"te某t2 = "这是第二段文本。

"similarity = cosine_similarity(te某t1, te某t2)print("余弦相似度:", similarity)``````pythonimport jellyfishdef edit_distance(te某t1, te某t2):distance = jellyfish.levenshtein_distance(te某t1, te某t2) similarity = 1 - (distance / ma某(len(te某t1), len(te某t2)))return similarity#示例te某t1 = "这是第一段文本。

文本查重算法

文本查重算法主要用于检测文本的相似度或重复度,以下是几种常见的文本查重算法:

字符串匹配算法:这是最基本的文本相似度计算方法,主要通过将两个文本字符串进行逐个字符的比较,计算相同字符的数量占总字符数的比例来判断文本的相似度。

但是,这种方法对于大量文本的比对速度较慢,且只能检测出完全相同的文本。

哈希算法:哈希算法可以快速计算出文本的哈希值,然后通过比对哈希值来判断文本的相似度。

但是,哈希算法存在哈希冲突的问题,即不同的文本可能会产生相同的哈希值,从而导致误判。

N-gram算法:N-gram算法是一种基于文本分词的方法,将文本分成N个连续的词组,然后比对词组的相似度来判断文本的相似度。

N-gram算法可以识别出部分相似的文本,相对于字符串匹配算法和哈希算法,其检测精度更高。

向量空间模型算法:向量空间模型算法是一种基于文本向量化的方法,将文本转换成向量,然后计算向量之间的相似度来判断文本的相似度。

这种方法可以识别出语义相似的文本,相对于其他算法,其检测精度更高。

此外,还有一些其他的文本查重算法,如Jaccard相似度算法、MinHash算法、SimHash算法等。

这些算法各有优缺点,可

以根据具体的应用场景和需求选择合适的算法进行文本查重。

请注意,文本查重算法的选择和使用需要考虑到文本的长度、复杂度、语言特性等因素,以及算法的准确性、效率和可扩展性等因素。

在实际应用中,可能需要结合多种算法和技术来提高查重的准确性和效率。

余弦相似度计算文本相似度

文本相似度是指两个文本之间的相似程度,是一种重要的文本探索工具。

其中,余弦相似度是一种最为广泛应用的文本相似度计算方法。

余弦相似度计算是一种测量两个文档之间语义相似度以及文档特征之间的相关性的方法。

其原理是使用空间向量来表示文本,将文本投影到同一空间,计算出这两条文本之间的余弦分布(类似度)。

如果两个文档的余弦值接近1,就表明两个文档的特征几乎相同,其相似度高。

余弦相似度可以通过使用一些机器学习技术来向量化文本。

包括文档向量化,词袋模型,TF-IDF算法等等。

文档向量化是通过定义每篇文档向量来表示每篇文档的重要性来计算文本相似度,同时引入一些惯例化处理,使得文档特征更加清晰。

词袋模型通过构建联想词数据库来表示文档特征,并使用分布式语言模型技术来计算文档相似度。

最后使用TF-IDF算法来衡量文本语义,以及计算文本相似度。

因此,余弦相似度是一种有效的文本相似度计算方法,使用此方法可以通过向量化的文本特征来计算相似度,较好地应用到计算机自然语言处理领域中。

文本相似度算法基本原理文本相似度算法是指对两个文本进行比较,评估它们之间的相似程度的一种方法。

在文本处理的相关领域中,文本相似度算法被广泛应用于引擎、信息检索、文本聚类、文本分类、文本摘要等任务中。

本文将介绍几种常见的文本相似度算法的基本原理。

一、基于词频统计的文本相似度算法最简单的文本相似度算法之一是基于词频统计的算法。

该算法通过统计两个文本中共同出现的词语的个数,并计算它们的相似度。

算法的基本步骤如下:1.分词:将待比较的文本进行分词,将文本划分为一组词语。

2.统计词频:统计每个词在两个文本中出现的次数。

3.计算相似度:根据词频计算相似度。

常用的相似度度量方法包括余弦相似度、欧氏距离等。

这种方法的优点是简单直观,计算效率高。

但是它忽略了词语的顺序和上下文信息,无法有效处理一词多义、词序不同的情况。

二、基于向量空间模型的文本相似度算法向量空间模型是一种常见的文本表示方法,它将文本表示为一个高维向量,通过计算向量之间的距离或相似度来度量文本之间的相似程度。

基于向量空间模型的文本相似度算法的基本步骤如下:1.文本表示:将文本转化为向量表示。

常用的方法包括词袋模型和TF-IDF模型。

词袋模型将文本中的词语组成一个向量,向量的每个维度对应一个词语,维度值为该词在文本中的词频。

TF-IDF模型在词袋模型的基础上,通过加权计算,考虑了词语在文本集合中的重要性。

2.计算相似度:根据向量表示计算文本的相似度。

常用的相似度度量方法包括余弦相似度、欧氏距离、曼哈顿距离等。

基于向量空间模型的文本相似度算法可以更好地考虑词语的顺序和上下文信息,可以处理一词多义、词序不同的情况。

但是它对文本长度较敏感,对于长文本计算复杂度较高。

三、基于词嵌入的文本相似度算法词嵌入是一种将词语映射到连续向量空间的方法,它可以很好地保留了词语的语义信息。

基于词嵌入的文本相似度算法通过计算词嵌入向量之间的距离或相似度来度量文本之间的相似程度。

java 文本相似度的计算方法Java 文本相似度的计算方法在自然语言处理和文本挖掘领域,文本相似度的计算是一项重要的任务。

计算两个文本之间的相似度可以帮助我们识别重复内容、进行文本聚类和推荐系统等任务。

本文将介绍几种常用的 Java 文本相似度计算方法,涵盖了基于统计特征、基于编码和基于深度学习的方法。

基于统计特征的方法1. 余弦相似度•使用词袋模型将文本表示为向量;•计算两个文本向量之间的余弦相似度;•根据余弦相似度的值判断文本之间的相似度。

2. Jaccard 相似度•将文本按照词集合的形式表示;•计算两个文本集合的交集和并集的比值;•根据 Jaccard 相似度的值判断文本之间的相似度。

3. TF-IDF•计算文档集合中每个词的 TF-IDF 值;•将每个文本表示为 TF-IDF 向量;•使用余弦相似度计算两个文本向量之间的相似度。

基于编码的方法1. 编辑距离•计算两个文本之间的编辑距离,即将一个文本转化为另一个文本所需的最少操作次数;•常用的操作包括插入、删除和替换字符;•编辑距离越小,表示两个文本越相似。

2. Hamming 距离•适用于文本长度相等的情况;•计算两个文本对应位置不同字符的数量;•Hamming 距离越小,表示两个文本越相似。

3. Levenshtein 距离•计算两个文本之间的最小编辑距离;•可以处理文本长度不等的情况;•Levenshtein 距离越小,表示两个文本越相似。

1. Word2Vec•使用 Word2Vec 模型将文本中的每个词表示为向量;•将文本表示为词向量的平均值或加权平均值;•使用余弦相似度计算两个文本向量之间的相似度。

2. Doc2Vec•使用 Doc2Vec 模型将文本表示为向量;•使用生成的文本向量计算文本之间的相似度。

3. Siamese Neural Networks•使用具有共享权重的两个神经网络来学习文本的表示;•将文本表示为神经网络的输出向量;•使用余弦相似度计算两个文本向量之间的相似度。

jaro-winkler 方法计算文本相似度

Jaro-Winkler方法是一种计算两个字符串之间相似度的方法,它基于Jaro算法并对其进行了一些改进。

Jaro-Winkler方法的基本思想是:如果两个字符串在相同位置上的字符相同,则它们的相似度增加;如果字符不同,则它们的相似度不增加。

同时,该方法还考虑了字符顺序的影响,即如果两个字符串中相同位置上的字符顺序不一致,则它们的相似度会降低。

具体来说,Jaro-Winkler方法使用了以下公式来计算两个字符串之间的相似度:

sim(s1, s2) = 0.1 * (m/l + (m - 1)/m) + 0.9 * (min(t1, t2) / max(t1, t2))

其中:

m表示两个字符串中匹配的字符数;

l表示两个字符串的长度;

t1和t2表示两个字符串中匹配字符的位置之差的绝对值;

sim(s1, s2)表示两个字符串之间的相似度。

需要注意的是,Jaro-Winkler方法是一种启发式算法,其计算结果可能受到数据集、参数设置等因素的影响。

因此,在使用该方法计算字符串相似度时,需要充分考虑其适用范围和局限性。

使用自然语言处理进行文本匹配和相似度计算的方法自然语言处理(Natural Language Processing,简称NLP)是人工智能领域中的一个重要分支,它致力于研究和开发用于处理和理解人类语言的计算机算法和模型。

在NLP中,文本匹配和相似度计算是两个重要的任务,它们在信息检索、机器翻译、文本分类等应用中具有广泛的应用。

一、文本匹配文本匹配是指判断两个文本之间的关联程度。

在实际应用中,文本匹配可以分为两种情况:精确匹配和模糊匹配。

1. 精确匹配精确匹配是指完全相同的文本之间的匹配。

常见的精确匹配方法有哈希算法和字符串匹配算法。

哈希算法通过将文本映射成固定长度的哈希值,然后比较哈希值是否相等来判断文本是否匹配。

常用的哈希算法有MD5和SHA-1等。

字符串匹配算法通过比较两个文本中的每个字符是否相等来判断文本是否匹配。

常见的字符串匹配算法有暴力匹配算法、KMP算法和Boyer-Moore算法等。

2. 模糊匹配模糊匹配是指在文本匹配过程中允许一定的差异。

常见的模糊匹配方法有编辑距离算法和余弦相似度算法。

编辑距离算法是通过计算两个文本之间的最小编辑距离来判断文本是否匹配。

编辑距离是指将一个字符串转换成另一个字符串所需的最少操作次数,包括插入、删除和替换字符。

余弦相似度算法是通过计算两个文本之间的夹角余弦值来判断文本是否匹配。

夹角余弦值越接近1,表示两个文本越相似。

二、相似度计算相似度计算是指衡量两个文本之间的相似程度。

在实际应用中,相似度计算可以分为词级相似度和句子级相似度。

1. 词级相似度词级相似度是指计算两个文本中每个词之间的相似度,然后将相似度进行加权平均得到文本之间的相似度。

常见的词级相似度计算方法有词向量和词汇包含关系。

词向量是将每个词映射成一个向量,然后通过计算向量之间的余弦相似度来衡量词之间的相似度。

常用的词向量模型有Word2Vec、GloVe和FastText等。

词汇包含关系是指通过判断一个词是否包含在另一个词中来衡量词之间的相似度。

中文相似度匹配算法相似度匹配算法是自然语言处理领域的一项重要任务,可以通过比较两个文本的相似程度来进行文本分类、信息检索、摘要生成等应用。

在中文文本中,相似度匹配算法也起着重要的作用。

下面将介绍几种常用的中文相似度匹配算法。

1. 余弦相似度算法(Cosine Similarity)余弦相似度通过计算两个向量之间的夹角余弦值来衡量它们的相似程度。

在文本匹配问题中,通常将文本向量化表示为词袋模型,然后计算两个文本向量之间的余弦相似度。

该算法简单、易于理解,且在实践中通常表现良好。

3. Jaccard相似度算法(Jaccard Similarity)Jaccard相似度算法用于衡量两个集合之间的相似程度。

在中文文本中,可以将文本切分成词语,并将词语作为集合的元素,然后计算两个文本集合之间的Jaccard相似度。

该算法常用于文本分类、信息检索等任务。

4. 词共现矩阵算法(Co-occurrence Matrix)词共现矩阵算法通过统计两个文本中词语的共现频率来计算它们的相似度。

在中文文本中,可以将文本切分成词语,并构建词语的共现矩阵。

然后可以使用余弦相似度等算法来计算两个文本之间的相似度。

该算法常用于文本聚类、关键词提取等任务。

随着深度学习在自然语言处理领域的广泛应用,基于深度学习的相似度匹配算法取得了显著的进展。

例如,可以使用卷积神经网络(CNN)或循环神经网络(RNN)来学习句子级别或词语级别的表示,并通过计算表示之间的距离来进行相似度匹配。

此外,还可以使用预训练的语言模型(如BERT、GPT等)来计算文本之间的相似度。

文本相似度匹配算法余弦

余弦相似度是一种用于衡量两个文本向量夹角余弦值的算法,其值域为[-1,1]。

余弦相似度越接近1,表明两个文本向量的夹角越接近0度,即两个文本越相似;余弦相似度越接近-1,表明两个文本向量的夹角越接近180度,即两个文本越不相似。

以下是使用余弦相似度进行文本相似度匹配的步骤:

1. 文本分词:将待匹配的两个文本进行分词处理,将文本转换为词频向量。

2. 词频统计:统计每个词在文本中出现的频率,构建词频向量。

3. 归一化处理:将词频向量进行归一化处理,消除不同文本长度对相似度计算的影响。

4. 计算余弦值:使用余弦公式计算两个词频向量的夹角的余弦值,得到两个文本的相似度得分。

5. 匹配结果:根据相似度得分判断两个文本的相似程度,返回匹配结果。

需要注意的是,余弦相似度算法对于文本的语义和语境的把握可能不够准确,因此在实际应用中需要结合其他算法进行优化和改进。

文本余弦相似度计算文本余弦相似度是一种常用的文本相似度计算方法,用于衡量两个文本之间的相似程度。

在自然语言处理中有着广泛的应用,例如文本分类、聚类、信息检索等。

本文将介绍文本余弦相似度的基本原理及其应用。

一、文本余弦相似度的基本原理文本余弦相似度是基于向量空间模型的文本表示方法。

在向量空间模型中,将文本表示成向量形式,每个维度对应一个词语,向量的值表示该词语在文本中的权重。

文本相似度的计算可简化为计算文本向量的夹角,夹角越小表示文本越相似。

具体而言,文本余弦相似度的计算过程如下:1.文本预处理:将文本转换为词语列表,并进行分词、去除停用词、词干提取等操作,以减少噪音和数据维度。

2.构建词袋模型:基于预处理后的词语列表构建词袋模型,统计每个词语在文本中出现的次数,形成向量表示。

3.计算词频-逆文档频率(TF-IDF):根据词袋模型计算每个词语的TF-IDF值,其中TF表示词频,IDF表示逆文档频率。

TF-IDF考虑了词语在文本中的重要性和在整个语料库中的普遍程度,可以更好地反映文本的特征。

4.计算余弦相似度:对于两个文本A和B,分别计算它们的TF-IDF向量,然后取两个向量的内积除以它们的模长乘积,得到余弦相似度。

二、文本余弦相似度的应用1.文本分类:将待分类文本与已有文本进行相似度比较,根据相似度确定其类别。

常用的方法有K近邻算法和支持向量机(SVM)等。

2.文本聚类:将语料库中相似的文本聚合到一起,形成具有相似主题的簇。

聚类算法如K均值算法、层次聚类等。

3.信息检索:在搜索引擎中,将用户查询语句与数据库中的文本进行相似度计算,返回与查询语句最相似的文本结果。

4.文本相似度分析:用于计算两个文本之间的相似程度,例如判断两篇文章是否为抄袭、计算两个句子的相似度等。

文本余弦相似度作为一种基于词语权重的文本相似度计算方法,具有以下的优点:1.对于文本的长度不敏感:文本余弦相似度不考虑文本的长度,只关注词语的权重和分布,因此能够较好地应对长文本和短文本的相似度计算。

Python 文本语义相似度计算一、概述在自然语言处理领域中,文本语义相似度计算是一个重要的问题。

它可以用于文本分类、信息检索、问答系统等多个领域。

Python 作为一种简洁而强大的编程语言,具有丰富的自然语言处理库和工具,为文本语义相似度计算提供了很好的支持。

二、常用的方法1. 基于词向量的方法基于词向量的方法是将文本表示为词的向量,然后计算两个文本向量的相似度。

Word2Vec、GloVe 等词向量模型是常用的工具。

2. 基于句向量的方法基于句向量的方法是将整个句子表示为一个向量,然后计算两个句子向量的相似度。

Doc2Vec、BERT 等模型可以用于生成句向量。

3. 基于语义图的方法基于语义图的方法是构建一个语义图来表示文本之间的关系,然后利用图上的算法计算文本的相似度。

TextRank 等算法是常用的方法。

三、Python 中的工具和库1. GensimGensim 是一个专注于文本语义建模的 Python 库,它包含了Word2Vec、Doc2Vec 等模型的实现。

通过 Gensim,我们可以很容易地计算文本的语义相似度。

2. spaCyspaCy 是一个用于自然语言处理的库,它提供了丰富的功能和语料库,包括词向量、句向量的计算等。

我们可以使用 spaCy 来计算文本的语义相似度。

3. NetworkXNetworkX 是一个用于复杂网络分析的库,我们可以利用它来构建和分析文本的语义图,计算文本之间的相似度。

四、示例代码1. 基于词向量的方法```pythonimport gensimmodel =gensim.models.KeyedVectors.load_word2vec_format('path/to/w ord2vec.bin', binary=True)similarity = model.wv.similarity('文本1', '文本2')print(similarity)```2. 基于句向量的方法```pythonimport spacynlp = spacy.load('en_core_web_md')doc1 = nlp('This is a sentence.')doc2 = nlp('This is another sentence.')similarity = doc1.similarity(doc2)print(similarity)```3. 基于语义图的方法```pythonimport networkx as nximport itertoolstext1 = 'This is a sentence.'text2 = 'This is another sentence.'tokens1 = text1.split()tokens2 = text2.split()graph = nx.Graph()graph.add_nodes_from(tokens1)graph.add_nodes_from(tokens2)for word1, word2 in itertools.product(tokens1, tokens2):if word1 != word2:graph.add_edge(word1, word2)similarity = nx.similarity.graph_edit_distance(graph1, graph2) print(similarity)```五、总结Python 提供了丰富的工具和库,可以很方便地进行文本语义相似度计算。

短文本相似度最好算法

下面我将介绍几种目前被认为较好的短文本相似度算法:

1.基于词向量的方法:词向量是将每个词映射到一个实数向量的表示

方法。

这种方法先将短文本中的词转换成词向量,然后计算两个短文本的

词向量之间的相似度。

这种方法能够捕捉到词语的语义信息,但对于短文

本来说可能存在词量不足的问题。

2.基于句子向量的方法:句子向量是将整个句子映射到一个实数向量

的表示方法。

这种方法在计算相似度时直接比较两个句子的向量。

这种方

法能够捕捉到整个句子的语义信息,但在捕捉细粒度的语义差异上可能存

在一定的限制。

3.基于注意力机制的方法:注意力机制是一种用来选择输入中相关部

分的机制。

这种方法可以通过计算两个短文本中每个词之间的注意力得分,来衡量两个短文本的相似度。

通过引入注意力机制,可以更加细致地考虑

不同词的重要性。

4.基于图神经网络的方法:图神经网络是一种能够处理图结构数据的

神经网络模型。

在短文本相似度任务中,可以将每个短文本看作一个节点,将两个短文本之间的相似度看作边的权重,从而构建一个图结构。

通过图

神经网络的学习和推理,可以得到两个短文本的相似度。

以上是一些常见的短文本相似度算法,它们各有优缺点,适用于不同

的场景和数据集。

在实际应用中,还可以根据具体需求选择合适的算法或

者进行组合使用,以达到最好的相似度计算效果。

相似度计算方面 Jaccard相似度:集合之间的Jaccard相似度等于交集大小与并集大小的比例。适合的应用包括文档文本相似度以及顾客购物习惯的相似度计算等。 Shingling:k-shingle是指文档中连续出现的任意k个字符。如果将文档表示成其k-shingle集合,那么就可以基于集合之间的Jaccard相似度来计算文档之间的文本相似度。有时,将shingle哈希成更短的位串非常有用,可以基于这些哈希值的集合来表示文档。 最小哈希:集合上的最小哈希函数基于全集上的排序转换来定义。给定任意一个排列转换,集合的最小哈希值为在排列转换次序下出现的第一个集合元素。 最小哈希签名:可以选出多个排列转换,然后在每个排列转换下计算集合的最小哈希值,这些最小哈希值序列构成集合的最小哈希签名。给定两个集合,产生相同哈希值的排列转换所占的期望比率正好等于集合之间的Jaccard相似度。 高效最小哈希:由于实际不可能产生随机的排列转换,因此通常会通过下列方法模拟一个排列转换:选择一个随机哈希函数,利用该函数对集合中所有的元素进行哈希操作,其中得到的最小值看成是集合的最小哈希值。 签名的局部敏感哈希:该技术可以允许我们避免计算所有集合对或其最小哈希签名对之间的相似度。给定集合的签名,我们可以将它们划分成行条,然后仅仅计算至少有一个行条相等的集合对之间的相似度。通过合理选择行条大小,可以消除不满足相似度阈值的大部分集合对之间的比较。

向量空间距离方面 欧式距离:n维空间下的欧式距离,是两个点在各维上差值的平方和的算数平方根。适合欧式空间的另一个距离是曼哈顿距离,指两个点各维度的差的绝对值之和。 Jaccard距离:1减去Jaccard相似度也是一个距离测度。 余弦距离:向量空间下两个向量的夹角大小。 编辑距离:该距离测度应用于字符串,指的是通过需要的插入、删除操作将一个字符串处理成另一个字符串的操作次数。编辑距离还可以通过两个字符串长度之和减去两者最长公共子序列长度的两倍来计算。 海明距离:应用于向量空间。两个向量之间的海明距离计算的是它们之间不相同的位置个数。

索引辅助方面 字符索引:如果将集合表示成字符串,且需要达到的相似度阈值接近1。那么就可以将每个字符串按照其头部的一小部分字母建立索引。需要索引的前缀的长度大概等于整个字符串的长度乘以给定的最大的Jaccard距离。 位置索引:我们不仅可以给出索引字符串前缀中的字符,也可以索引其在前缀中的位置。如果两个字符串共有的一个字符并不出现在双方的第一个位置,那么我们就知道要么存在某些前面的字符出现在并集但不出现在交集中,那么在两个字符串中存在一个更前面的公共字符。这样的话,我们就可以减少需要比较的字符串对数目。 后缀索引:我们不仅可以索引字符串前缀中的字符及其位置,还可以索引当前字符后缀的长度,即字符串中该字符之后的位置数量。由于相同字符但是后缀长度不同意味着有额外的字符必须出现在并集但不出现在交集中,因此上述结构能够进一步减少需要比较的字符串数目。

总结 以上的一些概念和方法可以配合使用,可以基本满足许多场景下的相似度计算。相似度计算又可以为相关推荐做基础。怎么做好词的粒度切分,怎么划定阈值,选择何种距离测算,如何优化实现方法还是要下很多功夫的。

两个例子 Levenshtein其实是编辑距离,下面计算编辑距离的方法是把两个String串里的字/词当成一个矩阵来比较和计算。 [java] view plaincopy

1. package zbf.search.recommend; 2. 3. public class LevenshteinDis { 4. 5. public static void main(String[] args) { 6. // 要比较的两个字符串 7. String str1 = "相似度计算方法"; 8. String str2 = "文本相似项发现"; 9. levenshtein(str1, str2); 10. } 11. 12. public static void levenshtein(String str1, String str2) { 13. 14. int len1 = str1.length(); 15. int len2 = str2.length(); 16. 17. int[][] dif = new int[len1 + 1][len2 + 1]; 18. 19. for (int a = 0; a <= len1; a++) { 20. dif[a][0] = a; 21. } 22. for (int a = 0; a <= len2; a++) { 23. dif[0][a] = a; 24. } 25. 26. int temp; 27. for (int i = 1; i <= len1; i++) { 28. for (int j = 1; j <= len2; j++) { 29. if (str1.charAt(i - 1) == str2.charAt(j - 1)) { 30. temp = 0; 31. } else { 32. temp = 1; 33. } 34. // 取三个值中最小的 35. dif[i][j] = min(dif[i - 1][j - 1] + temp, dif[i][j - 1] + 1,

36. dif[i - 1][j] + 1); 37. } 38. } 39. System.out.println("字符串\"" + str1 + "\"与\"" + str2 + "\"的比较"); 40. System.out.println("差异步骤:" + dif[len1][len2]); 41. // 计算相似度 42. float similarity = 1 - (float) dif[len1][len2] 43. / Math.max(str1.length(), str2.length()); 44. System.out.println("相似度:" + similarity); 45. } 46. 47. private static int min(int... is) { 48. int min = Integer.MAX_VALUE; 49. for (int i : is) { 50. if (min > i) { 51. min = i; 52. } 53. } 54. return min; 55. } 56. 57. }

下面是余弦距离计算的例子: [java] view plaincopy

1.