基于Attention-BiLSTM的中文命名实体识别

- 格式:pdf

- 大小:1.07 MB

- 文档页数:6

基于改进的序列标注算法的中文命名实体识别研究中文命名实体识别(Chinese Named Entity Recognition, CNER)是自然语言处理(Natural Language Processing, NLP)领域中的一项重要任务,旨在对中文文本中的命名实体(包括人名、地名、机构名等)进行识别与分类。

由于中文语言的复杂性和歧义性,CNER一直以来都是NLP领域的一个挑战。

为了提高命名实体识别的准确率和效率,许多研究者开始探索改进序列标注算法在CNER中的应用。

序列标注是一种基于统计机器学习的方法,通常使用条件随机场(Conditional Random Fields, CRF)作为模型,对标注序列进行预测。

在CNER任务中,输入为一段中文文本,输出为文本中的所有命名实体及其对应的类别(如人名、地名等)。

为了将中文文本转化为机器可以理解的结构,一般需要进行分词(Word Segmentation)和词性标注(Part-of-Speech Tagging)等预处理工作。

当前CRF是最流行的序列标注算法,然而其在CNER中仍存在一些问题。

首先,CRF模型的训练需要大量的标注数据,而中文命名实体标注数据难以获取;其次,CRF模型对文本特征的提取能力有限,很难处理多样化的中文命名实体。

为了克服这些限制,一些研究者开始探索改进的序列标注方法。

一种方法是引入上下文向量(Context-Dependent Embeddings, CDE),通过学习特定的上下文表达,将CRF模型的特征表示能力提高。

同时,还可以利用迁移学习(Transfer Learning)技术,在其他语言上预训练好的模型(如BERT模型)中提取中文命名实体的特征表示。

另一种方法是基于深度学习(Deep Learning),利用卷积神经网络(Convolutional Neural Networks, CNNs)和递归神经网络(Recurrent Neural Networks, RNNs)等深度模型,将CRF模型的特征提取能力进一步增强。

基于深度学习的中文命名实体识别研究中文命名实体识别(Chinese Named Entity Recognition,NER)是自然语言处理(Natural Language Processing,NLP)领域中重要且具有挑战性的任务之一。

它旨在识别文本中具有特定意义的实体,例如人名、地名、机构名等,为信息抽取、问答系统、机器翻译等应用提供基础支持。

近年来,随着深度学习的发展,基于深度学习的中文命名实体识别取得了显著的进展。

本文将重点介绍基于深度学习的中文命名实体识别的研究现状和方法。

首先,我们将介绍中文命名实体识别的任务描述。

中文命名实体识别的目标是在给定的中文文本中准确识别出人名、地名、机构名等具有特殊意义的实体。

例如,在句子“华南理工大学位于广州市天河区”中,“华南理工大学”为机构名,“广州市天河区”为地名。

中文命名实体识别的难点在于中文的单字词率较高,且在不同实体之间出现的隐式特征不明显。

接下来,我们将介绍基于深度学习的中文命名实体识别的方法。

深度学习在中文命名实体识别中广泛应用,并取得了很好的效果。

其中,卷积神经网络(Convolutional Neural Network,CNN)和长短时记忆网络(Long Short-Term Memory,LSTM)是常用的深度学习模型。

在基于卷积神经网络的方法中,一般采用卷积层和最大池化层进行特征提取和降维,然后将提取到的特征输入全连接层进行分类。

通过多层卷积和池化操作,可以捕捉到文本中不同粒度的特征,并提取到上下文信息。

此外,为了进一步提高模型的性能,可以采用预训练的词向量进行初始化,利用外部的语料库来增强模型的泛化能力。

在基于长短时记忆网络的方法中,LSTM模型能够对长文本序列进行建模,并通过记忆单元来记住重要的上下文信息。

这种模型对于中文命名实体识别任务的上下文依赖性非常有帮助。

通过设计合适的输入输出结构,可以将LSTM模型作为序列标记模型应用于中文命名实体识别任务中。

基于BERT-BiLSTM-CRF模型的油气领域命名实体识别高国忠;李宇;华远鹏;吴文旷【期刊名称】《长江大学学报(自然科学版)》【年(卷),期】2024(21)1【摘要】针对油气领域知识图谱构建过程中命名实体识别使用传统方法存在实体特征信息提取不准确、识别效率低的问题,提出了一种基于BERT-BiLSTM-CRF模型的命名实体识别研究方法。

该方法首先利用BERT(bidirectional encoder representations from transformers)预训练模型得到输入序列语义的词向量;然后将训练后的词向量输入双向长短期记忆网络(bi-directional long short-term memory,BiLSTM)模型进一步获取上下文特征;最后根据条件随机场(conditional random fields,CRF)的标注规则和序列解码能力输出最大概率序列标注结果,构建油气领域命名实体识别模型框架。

将BERT-BiLSTM-CRF模型与其他2种命名实体识别模型(BiLSTM-CRF、BiLSTM-Attention-CRF)在包括3万多条文本语料数据、4类实体的自建数据集上进行了对比实验。

实验结果表明,BERT-BiLSTM-CRF 模型的准确率(P)、召回率(R)和F_(1)值分别达到91.3%、94.5%和92.9%,实体识别效果优于其他2种模型。

【总页数】9页(P57-65)【作者】高国忠;李宇;华远鹏;吴文旷【作者单位】长江大学地球物理与石油资源学院;中国石油勘探开发研究院【正文语种】中文【中图分类】TP391.1;TE19【相关文献】1.基于有向图模型的旅游领域命名实体识别2.基于主动学习的试油气井控领域命名实体识别模型3.基于BERT模型的检验检测领域命名实体识别4.基于BERT-BiLSTM-CRF算法的电网领域命名实体识别模型5.基于BERT-BiLSTM-CRF模型的地理实体命名实体识别因版权原因,仅展示原文概要,查看原文内容请购买。

中文命名实体识别中的深度学习算法研究随着人工智能技术的不断发展,自然语言处理已经成为了很多应用场景下必需的技术。

其中,命名实体识别(Named Entity Recognition,NER)技术是比较重要的一部分,主要用于识别自然语言文本中的实体,例如人名、地名、组织机构名、日期、时间等等。

针对中文命名实体识别,过去的一些研究主要采用的是基于规则的方法,和传统的机器学习算法如支持向量机(Support Vector Machine,SVM)和条件随机场(Conditional Random Fields,CRF)等。

但是这些方法在实际应用中面临着很大的挑战,特别是在处理中文语言时。

近年来,随着深度学习技术的兴起,基于深度学习的方法也逐渐成为中文命名实体识别的热门研究方向,其优势在于可以学习到更加复杂的语言特征和上下文信息,从而提高了识别的准确性。

下面将介绍一些目前比较常用的深度学习算法,它们在中文命名实体识别中的应用情况以及优缺点。

1. BiLSTM + CRF双向长短时记忆网络(Bidirectional Long Short-Term Memory,BiLSTM)是一种基于循环神经网络(Recurrent Neural Networks,RNN)的架构,可以学习到文本序列中的上下文信息。

条件随机场(CRF)则是一种常见的序列标注模型,可以考虑文本序列中的依赖关系。

将BiLSTM和CRF结合起来,可以获得比单独使用CRF或者BiLSTM效果更好的模型。

在中文命名实体识别中,一些研究已经采用了BiLSTM+CRF模型,取得了不错的效果。

例如,Jiang等人在2016年提出了一种基于卷积神经网络(Convolutional Neural Network,CNN)和BiLSTM+CRF的模型,将这两种结构相互连接,实现了对实体的准确识别。

但是BiLSTM模型在处理较长文本时,时间和空间复杂度较高,需要考虑对于超长的句子的处理。

基于深度学习的中文命名实体识别研究章节一:引言(200字)随着互联网的快速发展和大数据时代的到来,对中文语言处理方面的研究不断深入。

命名实体识别作为中文语言处理的重要任务之一,在信息抽取、机器翻译、问答系统等应用领域有着广泛的应用。

如何高效、准确地识别中文文本中的命名实体,一直是学术界和工业界关注的热门议题。

本文将重点研究基于深度学习的中文命名实体识别。

章节二:命名实体识别概述(200字)命名实体识别是从文本中识别特定类别的实体,如人名、地名和组织名等。

中文命名实体的识别相对于英文具有更大的挑战,因为中文语言中没有明确的词汇边界和空格。

近年来,深度学习的发展为命名实体识别提供了新的解决思路,其在自然语言处理领域取得了显著的成果。

章节三:深度学习在命名实体识别中的应用(300字)深度学习在中文命名实体识别中发挥了重要作用。

基于深度学习的模型可以自动地学习到特征表示,避免了传统方法依赖于手工设计特征的局限性。

常用的深度学习模型包括循环神经网络(RNN)、长短期记忆网络(LSTM)和卷积神经网络(CNN)。

这些模型具有良好的记忆能力和泛化能力,能够有效地捕捉文本中的上下文信息,提高命名实体识别的准确性。

章节四:数据预处理(300字)数据预处理是中文命名实体识别的关键步骤之一。

首先,需要将文本进行分词,使得中文文本能够被模型正确处理。

其次,需建立字典,并将文本中的中文字符映射为对应的向量表示。

此外,为了克服数据样本不均衡性,可以采用过采样或欠采样等方法。

数据预处理的目标是使得输入数据能够被深度学习模型高效地处理。

章节五:模型设计与训练(300字)基于深度学习的中文命名实体识别模型的设计与训练是一个重要的环节。

在模型设计方面,可以结合LSTM和CRF(条件随机场)模型,LSTM用于建模上下文信息,CRF用于建模标签之间的依赖关系。

在训练阶段,可以采用随机梯度下降法(SGD)进行优化,通过最小化损失函数来更新模型参数。

《基于注意力机制的命名实体识别研究》篇一一、引言随着人工智能和自然语言处理技术的快速发展,命名实体识别(Named Entity Recognition, NER)已成为自然语言处理领域的重要任务之一。

命名实体识别旨在从文本中识别出具有特定意义的实体,如人名、地名、机构名等。

近年来,基于深度学习的命名实体识别方法取得了显著的成果,其中,注意力机制在命名实体识别任务中发挥着重要作用。

本文将重点研究基于注意力机制的命名实体识别方法,探讨其优势和挑战。

二、相关工作在过去的几十年里,命名实体识别一直是自然语言处理领域的热点问题。

传统的命名实体识别方法主要基于规则和词典,然而这些方法往往难以处理复杂的语言现象和未知的命名实体。

随着深度学习的发展,基于神经网络的命名实体识别方法逐渐成为主流。

其中,循环神经网络(RNN)、长短期记忆网络(LSTM)和卷积神经网络(CNN)等在命名实体识别任务中取得了较好的效果。

然而,这些方法在处理长距离依赖和上下文信息时仍存在局限性。

近年来,注意力机制被广泛应用于自然语言处理领域,包括命名实体识别任务。

注意力机制可以通过关注输入序列中的关键信息,提高模型的表达能力和泛化能力。

三、基于注意力机制的命名实体识别方法本文提出一种基于注意力机制的命名实体识别方法。

该方法主要包括以下几个步骤:1. 输入层:将文本数据输入到模型中,并进行预处理操作,如分词、去除停用词等。

2. 嵌入层:将预处理后的文本数据转换为向量表示,以便于模型进行学习和计算。

3. 编码层:采用双向长短期记忆网络(BiLSTM)对输入序列进行编码,捕捉上下文信息。

4. 注意力层:在编码层的基础上,引入注意力机制,对输入序列中的关键信息进行加权,以便模型更好地关注重要的信息。

5. 输出层:根据加权后的信息,通过全连接层进行分类和预测,得到命名实体的类别和位置信息。

四、实验与分析为了验证基于注意力机制的命名实体识别方法的有效性,我们在公开数据集上进行实验。

基于深度学习的中文命名实体识别研究引言命名实体识别是自然语言处理领域的一个重要研究方向,它的目的是从文本中识别出人名、地名、组织机构等实体信息。

随着深度学习在自然语言处理领域的崛起,基于深度学习的命名实体识别在近年来得到了广泛的应用和深入的研究。

本文将主要介绍基于深度学习的中文命名实体识别的研究。

一、命名实体识别的基本概念命名实体识别(Named Entity Recognition,NER)是指从文本中识别出具有特定意义的实体。

命名实体包括人名、地名、组织机构、时间、日期等。

NER 是自然语言处理中的一项基本任务,对其他自然语言处理任务如自动摘要、句法分析、信息提取等任务均有重要作用。

二、基于深度学习的命名实体识别技术基于深度学习的命名实体识别技术主要采用各种深度神经网络模型,如循环神经网络(Recurrent Neural Network,RNN)、长短时记忆网络(Long Short-Term Memory,LSTM)、卷积神经网络(Convolutional Neural Network,CNN)等。

以 LSTM 为例,它是一种特殊的循环神经网络结构,通过加入输入门、遗忘门和输出门等结构,解决了传统循环神经网络在训练过程中出现的梯度消失和梯度爆炸等问题。

在命名实体识别任务中,LSTM 能够有效地学习到输入序列中的上下文信息。

三、基于深度学习的中文命名实体识别的研究现状1.基于序列标注的方法最初的中文命名实体识别方法主要采用基于统计学方法的序列标注方法,如最大熵模型、条件随机场(Conditional Random Fields,CRF)等。

这些方法利用特征工程手段,对中文分词、词性标注、字形、上下文等特征进行提取和选择,并基于这些特征进行建模和预测。

这些方法在中文命名实体识别中有一定的效果,但是需要进行大量的特征选择和工程,且不易扩展和泛化。

2.基于深度学习的方法近年来,随着深度学习技术的发展,基于深度学习的中文命名实体识别方法逐渐成为研究热点。

基于BERT-BiLSTM-CRF的中医医案命名实体识别方法胡为;刘伟;石玉敬

【期刊名称】《计算机时代》

【年(卷),期】2022()9

【摘要】中医医案蕴含着丰富的中医经验知识,研究如何有效的从中医医案文本中挖掘有用实体信息具有重要意义。

基于中国现代名医医案数据集,提出一种基于BERT-BiLSTM-CRF模型的中医医案命名实体识别方法。

首先使用BERT语言模型进行文本特征提取,然后通过BiLSTM算法来获取上下文的信息,最后通过CRF算法来获取全局最优解并最终输出中医医案命名实体结果。

实验表明,该方法相比于以往的中医医案命名实体方法的准确率、召回率、F1值有明显提升。

【总页数】5页(P119-122)

【作者】胡为;刘伟;石玉敬

【作者单位】湖南中医药大学信息科学与工程学院

【正文语种】中文

【中图分类】TP389.1

【相关文献】

1.基于条件随机场的中医临床医案症状命名实体抽取研究

2.基于LSTM-CRF的中医医案症状命名实体抽取研究

3.基于Bert-BiLSTM-CRF的中医文本命名实体识别

4.基于BiLSTM-CRF的中医医案命名实体识别

5.基于BERT-BiLSTM-CRF的农产品信息文本命名实体识别研究及应用展望

因版权原因,仅展示原文概要,查看原文内容请购买。

《基于注意力机制的命名实体识别研究》篇一一、引言命名实体识别(Named Entity Recognition,NER)是自然语言处理(NLP)领域的一项重要任务,主要任务是从文本中识别并分类出具有特定含义的实体,如人名、地名、组织机构名等。

近年来,随着深度学习技术的发展,尤其是基于注意力机制的神经网络模型在NER任务中取得了显著的成果。

本文旨在探讨基于注意力机制的命名实体识别研究,以期为相关研究提供参考。

二、相关工作在过去的几十年里,命名实体识别一直是NLP领域的研究热点。

传统的NER方法主要基于规则、词典和手工特征等方法。

然而,这些方法往往需要大量的领域知识和人工干预。

近年来,随着深度学习技术的发展,尤其是循环神经网络(RNN)、长短期记忆网络(LSTM)和注意力机制等在NER任务中取得了显著的成果。

其中,基于注意力机制的模型可以自动学习文本中的关键信息,提高了识别的准确率。

三、基于注意力机制的命名实体识别模型本文提出了一种基于注意力机制的命名实体识别模型,该模型主要包含以下几个部分:1. 嵌入层:将输入文本转换为计算机可以处理的数值形式。

这一层通常使用词向量(Word Embedding)技术将文本转换为高维向量空间中的向量表示。

2. 编码层:采用双向LSTM对输入文本进行编码,提取文本的上下文信息。

双向LSTM可以同时考虑文本的上下文信息,提高了识别的准确率。

3. 注意力机制层:在编码层的基础上,引入注意力机制,使模型能够自动学习文本中的关键信息。

具体地,通过计算每个单词与当前单词的相似度,为每个单词分配不同的权重,从而提取出对当前单词最重要的信息。

4. 解码层:根据编码层和注意力机制层的信息,采用条件随机场(CRF)等算法进行实体识别和分类。

四、实验与分析为了验证本文提出的模型的性能,我们在多个公开数据集上进行了实验。

实验结果表明,基于注意力机制的命名实体识别模型在多个数据集上均取得了较好的性能,相较于传统的NER方法和不引入注意力机制的模型,本文提出的模型在准确率、召回率和F1值等指标上均有明显的提升。

基于深度学习的中文命名实体识别与关系抽取技术研究概述中文命名实体识别(Chinese Named Entity Recognition, CNER)和关系抽取(Relation Extraction, RE)是自然语言处理中的重要任务。

命名实体识别旨在从文本中识别出具有特定意义的实体,如人名、地名、组织机构等。

关系抽取则是从文本中提取出实体之间的关系,如雇佣、拥有等。

本文将基于深度学习探讨中文命名实体识别与关系抽取的技术研究。

1. 中文命名实体识别技术研究中文命名实体识别是信息提取、问答系统、机器翻译等自然语言处理任务的重要基础。

随着深度学习的兴起,基于神经网络的方法成为了命名实体识别的主流。

常见的深度学习模型包括循环神经网络(Recurrent Neural Network, RNN)和卷积神经网络(Convolutional Neural Network, CNN)。

其中,循环神经网络通过遍历输入序列,保留上下文信息,逐步学习并预测每个字的标签。

长短期记忆网络(Long Short-Term Memory, LSTM)和门控循环单元(Gated Recurrent Unit, GRU)是两种经典的循环神经网络结构,能更好地捕捉长距离依赖关系。

卷积神经网络则通过卷积操作在局部观察下提取特征,并通过池化层减少参数数量。

针对中文命名实体识别,可以使用卷积神经网络对字向量进行卷积操作,然后将得到的特征输入到全连接层进行分类。

此外,还可以结合预训练的字向量模型,如Word2Vec、GloVe等,来进一步提升命名实体识别的性能。

通过在大规模语料上预训练词向量,并将其作为输入特征传递给深度学习模型,可以更好地捕捉词语的语义信息。

2. 中文关系抽取技术研究中文关系抽取旨在从文本中提取出实体之间的关系,为自然语言处理任务中的重要环节。

与中文命名实体识别类似,深度学习方法也在中文关系抽取中取得了显著的效果。

目前,常用的深度学习模型包括基于卷积神经网络的方法和基于循环神经网络的方法。

基于深度学习的中文命名实体抽取技术研究近年来,深度学习技术的发展让机器学习的应用范围愈发广泛。

命名实体抽取( Named Entity Recognition)技术作为一种关键的自然语言处理技术,在文本挖掘、信息抽取及机器翻译等方面有着广泛的应用价值。

在中文语境下,命名实体抽取技术受到语言特性的影响,如词汇复杂性、多义性及语法困难等,因此在中文命名实体识别中具有挑战性。

然而,通过多年的实践和技术的不断进步,基于深度学习的中文命名实体抽取技术取得了令人瞩目的成果,本文将就该技术的研究现状做一概括。

一、中文命名实体抽取技术的基本步骤首先,我们需要明确中文命名实体的分类种类,目前主流的分类有:PER (人名) 、 LOC (地名)、 ORG (组织机构) 、TIME (时间) 等。

中文命名实体抽取技术通常包含以下基本步骤:1.分词(Word Segmentation):中文分词是中文自然语言处理的第一步。

中文作为一种非空格分隔的语言,单词之间没有间隔,因此需要对文本进行字级别或词级别的分割。

分词的目的是将中文文本分割成具有语义单元的词汇序列,以便后续任务的进行。

2. 词性标注 (Part-of-Speech Tagging):词性标注是为每个词语标记其所处于的上下文中的语法角色。

词性标注在决策某些自然语言处理任务的基础上,是很重要的预处理步骤之一。

3.实体识别:在得到分割好的文本序列和每个词的词性标注后,下一步就是通过标记的信息检测出各个类别的命名实体,实现对文本中命名实体的抽取。

二、基于深度学习的中文命名实体抽取技术近年来,随着深度学习技术的迅速发展,很多研究人员开始使用深度学习技术来解决中文命名实体识别的问题。

针对中文自然语言处理的特点,本文总结以下几种基于深度学习的中文命名实体抽取技术:1、循环神经网络(Recurrent Neural Networks)循环神经网络是一类特殊的神经网络,它们能够处理不定长序列输入和输出,可以直接对文本建模。

基于深度学习的中文命名实体识别技术研究近年来,随着大数据和人工智能技术的不断发展,命名实体识别技术在信息抽取、文本分类、自然语言处理等领域得到了广泛的应用。

而中文命名实体识别技术在许多领域中也发挥了越来越重要的作用。

本文将针对基于深度学习的中文命名实体识别技术进行研究。

一、介绍中文命名实体识别是指自然语言处理中对于句子中的实体进行识别和分类。

例如在一段新闻文本中,将人名、地名、机构名等识别出来,并进行分类,以便后续处理。

命名实体识别一般包含三个主要的任务:分词、实体标注和实体分类。

其中分词是将文本中的词进行分割,而实体标注和实体分类是将实体进行分类。

传统的中文命名实体识别技术主要依赖于规则或者机器学习算法。

其中规则方法是基于人工规则制定的,往往需要大量的专家知识和长时间的调试才能够取得良好的效果。

而基于机器学习算法的方法,通常需要进行大量的特征工程,而且一旦特征提取不足或者特征选择不合理,识别效果就会受到较大的影响。

基于深度学习的中文命名实体识别技术则是一种新的识别方法。

它可以自动地从大量的数据中提取有用的特征,而无需人工干预,同时也能够利用大规模语料库中的上下文信息,提高识别效果。

二、基于深度学习的中文命名实体识别技术基于深度学习的中文命名实体识别技术主要分为两种方法:基于循环神经网络和基于卷积神经网络。

1. 基于循环神经网络循环神经网络(RNN)是一种非常适合序列数据处理的神经网络。

在中文命名实体识别中,RNN往往用于捕捉长依赖关系,将上文中的信息传递给下文。

RNN主要由两个结构组成:隐藏层和输出层。

隐藏层是网络循环起来的主要结构,它将上一个时刻的输出和当前时刻的状态作为输入,经过非线性转换之后生成当前时刻的状态。

输出层则将当前时刻的状态作为输入,经过一个激活函数进行非线性处理后输出结果。

其中,长短时记忆网络(LSTM)是最经典的循环神经网络之一。

LSTM具有门控机制,可以通过特定的门实现决定是否保留当前网络状态。

第33卷 第5期 2019年9月湖 南 工 业 大 学 学 报Journal of Hunan University of TechnologyVol.33 No.5 Sep. 2019

doi:10.3969/j.issn.1673-9833.2019.05.013

收稿日期:2018-03-28基金项目:国家自然科学基金资助项目(61402165),湖南省自然科学基金资助项目(2018JJ2098),湖南工业大学重点 基金资助项目(17ZBLWT001KT006)作者简介:冀相冰(1992-),男,山东聊城人,湖南工业大学硕士生,主要研究方向为自然语言处理与知识工程, E-mail:jxiangbing@163.com通信作者:朱艳辉(1968-),女,湖南湘潭人,湖南工业大学教授,主要从事自然语言处理与知识工程的教学与研究, E-mail:swayhzhu@163.com

基于Attention-BiLSTM的中文命名实体识别冀相冰1, 2,朱艳辉1, 2,李 飞1, 2,徐 啸1, 2(1.湖南工业大学 计算机学院,湖南 株洲 412007;2. 智能信息感知及处理技术湖南省重点实验室,湖南 株洲 412007)

摘 要:提出一种基于Attention-BiLSTM(attention-bidirectional long short-term memory)深度神经网络的命名实体识别方法。应用BiLSTM神经网络自动学习文本的隐含特征,可以解决传统识别方法存在长距离依赖等问题;引入注意力机制(attention mechanism)对文本全局特征做重要度计算,获取文本局部特征,解决了传统深度学习方法不能充分提取特征的问题;在预训练过程中加入维基百科知识,进一步提升了命名实体识别系统的性能。实验表明,所提方法在SIGHAN 2006 Bakeoff-3评测数据集上获得了优良的识别性能。关键词:命名实体识别;注意力机制;BiLSTM;深度学习;局部特征中图分类号:TP391 文献标志码:A 文章编号:1673-9833(2019)05-0073-06引文格式:冀相冰,朱艳辉,李 飞,等. 基于Attention-BiLSTM的中文命名实体识别[J]. 湖南工业大学学报,2019,33(5):73-78.

Entity Recognition of Chinese Names Based on Attention-BiLSTM

JI Xiangbing1, 2,ZHU Yanhui1, 2,LI Fei1, 2,XU Xiao1, 2(1. College of Computer Science,Hunan University of Technology,Zhuzhou Hunan 412007,China; 2. Hunan Key Laboratory of Intelligent Information Perception and Processing Technology,Zhuzhou Hunan 412007,China)

Abstract:This paper proposes a named entity recognition method based on Attention-BiLSTM (attention-

bidirectional long short-term memory) deep neural network. Using BiLSTM neural network to automatically learn the implicit features of text can solve the problem of long-distance dependence of traditional recognition methods. Attention mechanism is used to calculate the importance of text global features, obtain local features of text, and solve the traditional deep learning method can not fully extract the feature problem; adding Wikipedia knowledge in the pre-training process further improves the performance of the named entity recognition system. Experiments show that the proposed method achieves excellent recognition performance on the SIGHAN 2006 Bakeoff-3 evaluation data set.Keywords:named entity recognition;attention mechanism;BiLSTM;deep learning;local feature

1 研究背景命名实体识别(named entity recognition,NER)是自然语言处理任务中关键的步骤之一,它的主要任

务是识别非结构化文本数据中的具有特定含义的实体(地名、机构、事件、专用名词等),在事件检测、74湖 南 工 业 大 学 学 报 2019年智能客服等领域有非常广泛的应用。中文命名实体种类繁多,覆盖领域较广,从海量的文本中自动抽取出人们所需要的价值信息可以满足各行业需求,因此具有重大意义。针对命名实体识别任务中存在的问题,学者们已经进行了许多深入的研究。M. Sundermeyer等[1]通过LSTM(long short-term memory)神经网络进行语言建模,根据困惑性和单词错误率构建评估模型并验证2个量的强相关性。Duan H. Z.等[2]利用常用属性、窗口大小和序列标签设置不同的特征模板的功能组合,提高了中文命名实体识别的性能。A. Borthwick[3]把最大熵统计模型应用到命名实体识别中,该研究对信息提取任务具有特殊意义。R. Collobert等[4]提出了一种统一的神经网络和学习算法,该算法根据传统人工标注的特点,对大量未标注的训练数据学习内部隐含特征,取得了较好的效果。N. Greenberg等[5]利用BiLSTM+CRF方法在多个生物医学数据集上联合抽取训练,获得了较优效果。Liu X. H.等[6]通过研究推特领域的命名实体识别,提出进行两阶段标签来利用类似推文中的冗余信息,取得了较好的F值。Feng Y. H.等[7]等利用词嵌入+ CRF的领域专用术语识别方法,增加了词嵌入和术语嵌入的相似性,形成了特征向量,解决了传统方法忽视语义的问题。Wang G. Y.等[8]利用一种混合深度神经网络(deep neural networks,DNN)进行实验,挖掘了嵌入在无标签语料库中的隐式信息,其实验效果比条件随机场模型要好。J. Mayfield等[9]使用支持向量机(support vector machine,SVM)训练数据的特征,利用简单的静态函数将边际产出转换为估计得概率,对英文和德文进行了识别。D. Klein等[10]讨论了字符级HMM(hidden Markov model)和最大熵条件马尔可夫模型,他们在英语测试数据集上取得了良好的效果。D. Bahdanau等[11]在神经网络中,引入注意力机制,解决了自然语言处理领域的机器翻译问题。传统深度学习在NER提取特征过程中,过于重视文本全局特征,因而忽视了局部特征对命名实体识别的重要影响。一段文本中命名实体的识别可能仅与局部信息有关,且每个字词对其他实体的贡献程度不同,过多的冗余信息只会对命名实体识别带来负面影响。本文提出基于Attention-BiLSTM-CNN-CRF的深度神经网络模型并以其进行中文命名实体识别。首先对语料集进行预训练词向量,利用卷积神经网络(convolutional neural network,CNN)提取句子中的字符表示向量,并将字嵌入向量和字符表示向量联合起来馈送到BiLSTM神经网络中;然后利用注意力机制在文本全局特征上获取局部特征;最后根据文本的全局特征和局部特征使用CRF解码整个句子的最优标注序列。

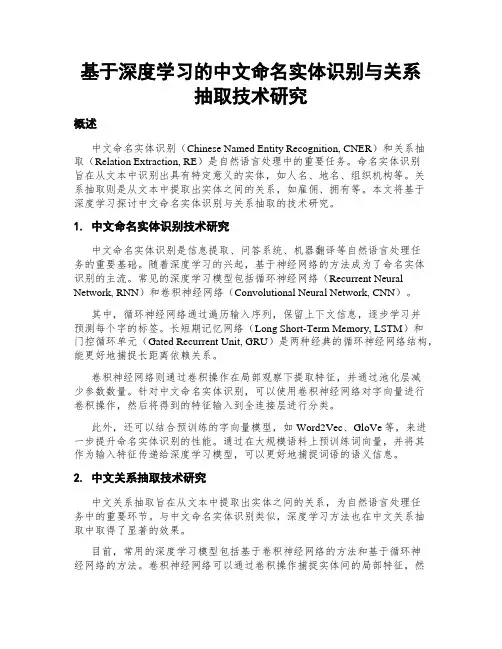

2 基于Attention-BiLSTM的中文命

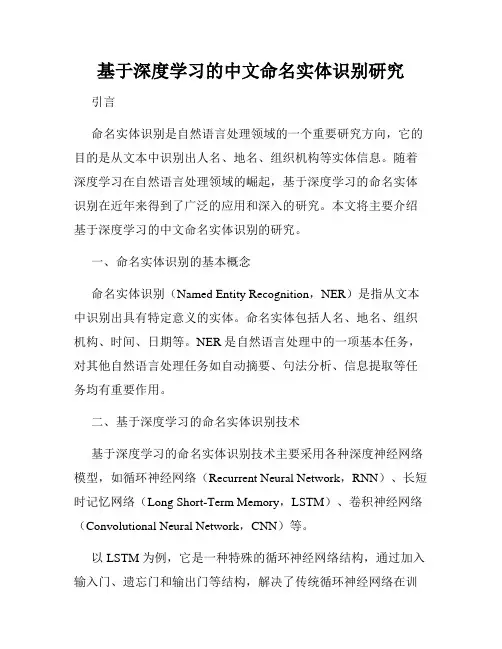

2.1 Attention-BiLSTM模型循环神经网络(recurrent neural network,RNN)是一个强大的连接模型族,从理论上来说,RNN可以捕获长距离的依赖[12],但是在实际情况中却容易出现梯度爆炸或消失问题,长短期记忆网络(long short-term memory,LSTM)[13]可以很好地解决这类

问题。本研究提出了基于注意力机制的BiLSTM模型,以机构命名实体“篮球管理中心”作为实例进行表示,如图1所示。

LSTM由3个门组成,通过联结存储单元,利用几个门控制早期状态中需要忘记信息的比例和输入存储单元的比例,从而能够捕获长距离依赖。LSTM强大的性能可以解决很多序列标签标注的任务,因为它可以访问文本过去和未来的情况。它的基本思路是将所有序列展开为2个单独的隐藏状态,其中一个向前捕获历史的信息,另外一个向后捕获未来的信息,随后将前后两个隐藏状态联结起来,对上下文信息进行标签标记,形成全局特征输出。然后将BiLSTM的输出向量输入Attention层进一步进行局部特征提取,最后将全局特征和局部特征一起馈送到CRF层。

图1 Attention-BiLSTM模型结构Fig.1 Attention-BiLSTM model structure

名实体识别模型