在做分类时常常需要估算不同样本之间的相似性度量(SimilarityMeasurement),这时通常采用的方法就是计算样本间的“距离”(Distance)。采用什么样的方法计算距离是很讲究,甚至关系到分类的正确与否。对常用的相似性度量作一个总结。1.欧氏距离2.曼哈顿距离3. 切比雪夫距离4. 闵可夫斯基距离5.标准化欧氏距离6.马氏距离7.夹角余弦8.汉明距离9.杰卡德距离&杰卡德相似系数10.相关系数&相关距离11.信息熵12.兰氏距离13.斜交空间距离14.最大-最小相似度15.指数相似度16.KL距离

1. 欧氏距离(EuclideanDistance)

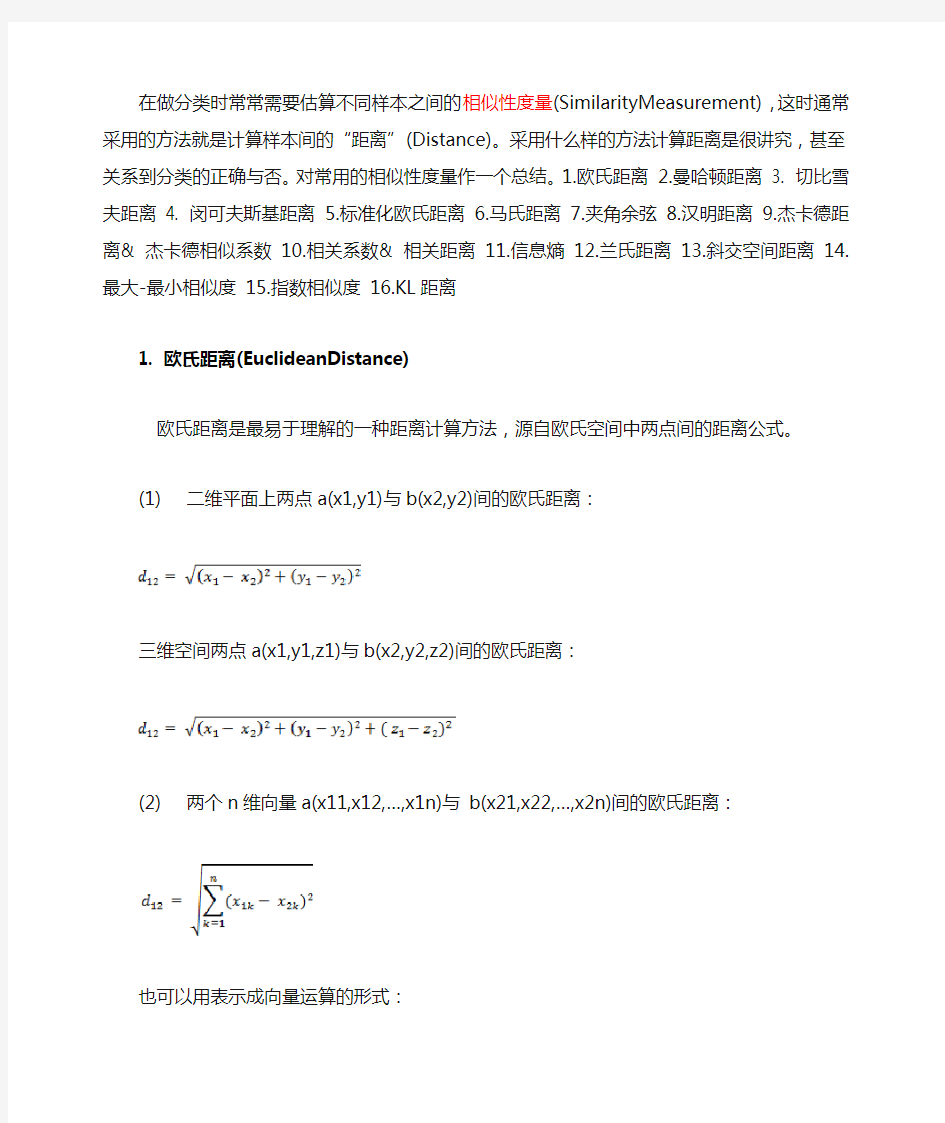

欧氏距离是最易于理解的一种距离计算方法,源自欧氏空间中两点间的距离公式。

(1)二维平面上两点a(x1,y1)与b(x2,y2)间的欧氏距离:

三维空间两点a(x1,y1,z1)与b(x2,y2,z2)间的欧氏距离:

(2)两个n维向量a(x11,x12,…,x1n)与b(x21,x22,…,x2n)间的欧氏距离:

也可以用表示成向量运算的形式:

(4)Matlab计算欧氏距离

Matlab计算距离主要使用pdist函数。若X是一个M×N的矩阵,则pdist(X)将X矩阵M行的每一行作为一个N维向量,然后计算这M个向量两两间的距离。

例子:计算向量(0,0)、(1,0)、(0,2)两两间的欧式距离

X= [0 0 ; 1 0 ; 0 2]

D= pdist(X,'euclidean')

结果:

D=

1.0000

2.0000 2.2361

2. 曼哈顿距离(ManhattanDistance)又称绝对值距离

从名字就可以猜出这种距离的计算方法了。想象你在曼哈顿要从一个十字路口开车到另外一个十字路口,驾驶距离是两点间的直线距离吗?显然不是,除非你能穿越大楼。实际驾驶距离就是这个“曼哈顿距离”。而这也是曼哈顿距离名称的来源,曼哈顿距离也称为城市街区距离(CityBlock distance)。

(1)二维平面两点a(x1,y1)与b(x2,y2)间的曼哈顿距离

(3)Matlab计算曼哈顿距离

例子:计算向量(0,0)、(1,0)、(0,2)两两间的曼哈顿距离

X= [0 0 ; 1 0 ; 0 2]

D= pdist(X, 'cityblock')

结果:

D=

1 2 3

3. 切比雪夫距离( Chebyshev Distance )

国际象棋玩过么?国王走一步能够移动到相邻的8个方格中的任意一个。那么国王从格子(x1,y1)走到格子(x2,y2)最少需要多少步?自己走走试试。你会发现最少步数总是max(| x2-x1 | , | y2-y1 | ) 步。有一种类似的一种距离度量方法叫切比雪夫距离。

(1)二维平面两点a(x1,y1)与b(x2,y2)间的切比雪夫距离

(2)两个n维向量a(x11,x12,…,x1n)与b(x21,x22,…,x2n)间的切比雪夫距离

这个公式的另一种等价形式是

看不出两个公式是等价的?提示一下:试试用放缩法和夹逼法则来证明。

(3)Matlab计算切比雪夫距离

例子:计算向量(0,0)、(1,0)、(0,2)两两间的切比雪夫距离

X= [0 0 ; 1 0 ; 0 2]

D= pdist(X, 'chebychev')

结果:

D=

1 2 2

4. 闵可夫斯基距离(MinkowskiDistance)

闵氏距离不是一种距离,而是一组距离的定义。

(1)闵氏距离的定义

两个n维变量a(x11,x12,…,x1n)与b(x21,x22,…,x2n)间的闵可夫斯基距离定义为:

其中p是一个变参数。

当p=1时,就是曼哈顿距离

当p=2时,就是欧氏距离

当p→∞时,就是切比雪夫距离

根据变参数的不同,闵氏距离可以表示一类的距离。

(2)闵氏距离的缺点

闵氏距离,包括曼哈顿距离、欧氏距离和切比雪夫距离都存在明显的缺点。

举个例子:二维样本(身高,体重),其中身高范围是150~190,体重范围是50~60,有三个样本:a(180,50),b(190,50),c(180,60)。那么a与b之间的闵氏距离(无论是曼哈顿距离、欧氏距离或切比雪夫距离)等于a与c之间的闵氏距离,但是身高的10cm真的等价于体重的10kg么?因此用闵氏距离来衡量这些样本间的相似度很有问题。

简单说来,闵氏距离的缺点主要有两个:(1)将各个分量的量纲(scale),也就是“单位”当作相同的看待了。(2)没有考虑各个分量的分布(期望,方差等)可能是不同的。

(3)Matlab计算闵氏距离

例子:计算向量(0,0)、(1,0)、(0,2)两两间的闵氏距离(以变参数为2的欧氏距离为例)

X= [0 0 ; 1 0 ; 0 2]

D= pdist(X,'minkowski',2)

结果:

D=

1.0000

2.0000 2.2361

5. 标准化欧氏距离(Standardized Euclidean distance )

(1)标准欧氏距离的定义

标准化欧氏距离是针对简单欧氏距离的缺点而作的一种改进方案。标准欧氏距离的思路:既然数据各维分量的分布不一样,好吧!那我先将各个分量都“标准化”到均值、方差相等吧。均值和方差标准化到多少呢?这里先复习点统计学知识吧,假设样本集X的均值(mean)为m,标准差(standarddeviation)为s,那么X的“标准化变量”表示为:

而且标准化变量的数学期望为0,方差为1。因此样本集的标准化过程(standardization)用公式描述就是:

标准化后的值= ( 标准化前的值-分量的均值) /分量的标准差

经过简单的推导就可以得到两个n维向量a(x11,x12,…,x1n)与b(x21,x22,…,x2n)间的标准化欧氏距离的公式:

如果将方差的倒数看成是一个权重,这个公式可以看成是一种加权欧氏距离(WeightedEuclidean distance)。

(2)Matlab计算标准化欧氏距离

例子:计算向量(0,0)、(1,0)、(0,2)两两间的标准化欧氏距离(假设两个分量的标准差分别为0.5和

D= pdist(X, 'seuclidean',[0.5,1])

结果:

D=

2.0000 2.0000 2.8284

6. 马氏距离(MahalanobisDistance)

(1)马氏距离定义

有M个样本向量X1~Xm,协方差矩阵记为S,均值记为向量μ,则其中样本向量X到u的马氏距离表示为:

而其中向量Xi与Xj之间的马氏距离定义为:

若协方差矩阵是单位矩阵(各个样本向量之间独立同分布),则公式就成了:

也就是欧氏距离了。

若协方差矩阵是对角矩阵,公式变成了标准化欧氏距离。

(2)马氏距离的优缺点:量纲无关,排除变量之间的相关性的干扰。

(3)Matlab计算(1 2),( 1 3),( 2 2),( 3 1)两两之间的马氏距离

X = [1 2; 1 3; 2 2; 3 1]

Y = pdist(X,'mahalanobis')

结果:

Y=

2.3452 2.0000 2.3452 1.2247 2.4495 1.2247

7. 夹角余弦(Cosine)

有没有搞错,又不是学几何,怎么扯到夹角余弦了?各位看官稍安勿躁。几何中夹角余弦可用来衡量两个向量方向的差异,机器学习中借用这一概念来衡量样本向量之间的差异。

(1)在二维空间中向量A(x1,y1)与向量B(x2,y2)的夹角余弦公式:

(2)两个n维样本点a(x11,x12,…,x1n)和b(x21,x22,…,x2n)的夹角余弦

类似的,对于两个n维样本点a(x11,x12,…,x1n)和b(x21,x22,…,x2n),可以使用类似于夹角余弦的概念来衡量它们间的相似程度。即:

夹角余弦取值范围为[-1,1]。夹角余弦越大表示两个向量的夹角越小,夹角余弦越小表示两向量的

夹角越大。当两个向量的方向重合时夹角余弦取最大值1,当两个向量的方向完全相反夹角余弦取最小值-1。从方向上区分差异,对绝对的数值并不敏感。

(3)Matlab计算夹角余弦

例子:计算(1,0)、( 1,1.732)、(-1,0)两两间的夹角余弦

X= [1 0 ; 1 1.732 ; -1 0]

D= 1- pdist(X, 'cosine') % Matlab中的pdist(X,'cosine')得到的是1减夹角余弦的值

结果:

D=

0.5000 -1.0000 -0.5000

8. 汉明距离(Hammingdistance)

(1)汉明距离的定义

两个等长字符串s1与s2之间的汉明距离定义为将其中一个变为另外一个所需要作的最小替换次数。例如字符串“1111”与“1001”之间的汉明距离为2。

应用:信息编码(为了增强容错性,应使得编码间的最小汉明距离尽可能大)。

(2)Matlab计算汉明距离

Matlab中2个向量之间的汉明距离的定义为2个向量不同的分量所占的百分比。

例子:计算向量(0,0)、(1,0)、(0,2)两两间的汉明距离

X = [0 0 ; 1 0 ; 0 2];

D = PDIST(X, 'hamming')

结果:

D=

0.5000 0.5000 1.0000

9. 杰卡德相似系数(Jaccardsimilarity coefficient)

(1) 杰卡德相似系数

两个集合A和B的交集元素在A,B的并集中所占的比例,称为两个集合的杰卡德相似系数,用符号J(A,B)表示。

杰卡德相似系数是衡量两个集合的相似度一种指标。

(2) 杰卡德距离

与杰卡德相似系数相反的概念是杰卡德距离(Jaccarddistance)。杰卡德距离可用如下公式表示:

杰卡德距离用两个集合中不同元素占所有元素的比例来衡量两个集合的区分度。

(3)杰卡德相似系数与杰卡德距离的应用

可将杰卡德相似系数用在衡量样本的相似度上。

样本A与样本B是两个n维向量,而且所有维度的取值都是0或1。例如:A(0111)和B(1011)。

q:样本A是1,样本B是0的维度的个数

r:样本A是0,样本B是1的维度的个数

s:样本A与B都是0的维度的个数

那么样本A与B的杰卡德相似系数可以表示为:

这里p+q+r可理解为A与B的并集的元素个数,而p是A与B的交集的元素个数。

而样本A与B的杰卡德距离表示为:

(4)Matlab计算杰卡德距离

Matlab的pdist函数定义的杰卡德距离跟我这里的定义有一些差别,Matlab中将其定义为不同的维度的个数占“非全零维度”的比例。

例子:计算(1,1,0)、(1,-1,0)、(-1,1,0)两两之间的杰卡德距离

X= [1 1 0; 1 -1 0; -1 1 0]

D= pdist( X , 'jaccard')

结果

D=

0.5000 0.5000 1.0000

10. 相关系数( Correlation coefficient )与相关距离(Correlation distance)

(1)相关系数的定义

相关系数是衡量随机变量X与Y相关程度的一种方法,相关系数的取值范围是[-1,1]。相关系数的绝对值越大,则表明X与Y相关度越高。当X与Y线性相关时,相关系数取值为1(正线性相关)或-1(负线性相关)。

(2)相关距离的定义

(3)Matlab计算(1, 2 ,3 ,4 )与( 3 ,8 ,7 ,6 )之间的相关系数与相关距离

X = [1 2 3 4 ; 3 8 7 6]

C = corrcoef( X' ) %将返回相关系数矩阵

D = pdist( X , 'correlation')

结果:

C=

1.0000 0.4781

0.4781 1.0000

D=

0.5219

其中0.4781就是相关系数,0.5219是相关距离。

信息熵并不属于一种相似性度量。信息熵是衡量分布的混乱程度或分散程度的一种度量。分布越分散(或者说分布越平均),信息熵就越大。分布越有序(或者说分布越集中),信息熵就越小。

计算给定的样本集X的信息熵的公式:

参数的含义:

n:样本集X的分类数

pi:X中第i类元素出现的概率

信息熵越大表明样本集S分类越分散,信息熵越小则表明样本集X分类越集中。。当S中n个分类出现的概率一样大时(都是1/n),信息熵取最大值log2(n)。当X只有一个分类时,信息熵取最小值0

12.兰氏距离(Lance and Williams distance,或Canberra Distance)

兰氏距离定义为

与马氏距离一样,兰氏距离对数据的量纲不敏感。不过兰氏距离假定变量之间相互独立,没有考虑变量之间的相关性。

13.斜交空间距离

在m维空间中,使大量具有相关性的变量的谱系结构不发生变形,采用斜交空间距离,其公式为:

其中,rij为变量i和变量j之间的相关系数。m为样本数量,n为样本特征数。

14.最大-最小相似度(Max-Min Similarity)

这里,有三种度量方法:

假定,则有

15.指数相似度

其中各种相似性度量是第i个值的方差。余弦相似度、Max-Min 相似度以及指数相似度等度量方法的取值范围都在[0,1]内。

16.KL距离(又称为相对熵或者KL Divergence,即Kullback-Leibler divergence)

KL距离不符合对称性,即多数情况下各种相似性度量不成立,KL 距离也不符合三角形不等式,即各种相似性度量也不一定成立。

pdist函数

调用格式:Y=pdist(X,’metric’)

说明:用‘metric’指定的方法计算X 数据矩阵中对象之间的距离。

X:一个m×n的矩阵,它是由m个对象组成的数据集,每个对象的大小为n。

'metric’取值如下:

‘euclidean’:欧氏距离(默认);

‘seuclidean’:标准化欧氏距离;

‘mahalanobis’:马氏距离;

‘cityblock’:布洛克距离;

‘minkowski’:明可夫斯基距离;

‘cosine’:余弦距离;

‘correlation’:相关距离;

‘hamming’:海明距离;

‘jaccard’:杰卡德距离;

‘chebychev’:切比雪夫距离。

详解协方差与协方差矩阵

协方差的定义

对于一般的分布,直接代入E(X)之类的就可以计算出来了,但真给你一个具体数值的分布,要计算协方差矩阵,根据这个公式来计算,还真不容易反应过来。

记住,X、Y是一个列向量,它表示了每种情况下每个样本可能出现的数。比如给定

则X表示x轴可能出现的数,Y表示y轴可能出现的。注意这里是关键,给定了4个样本,每个样本都是二维的,所以只可能有X和Y两种维度。所以

用中文来描述,就是:

协方差(i,j)=(第i列的所有元素-第i列的均值)*(第j列的所有元素-第j列的均值)

这里只有X,Y两列,所以得到的协方差矩阵是2x2的矩阵,下面分别求出每一个元素:

所以,按照定义,给定的4个二维样本的协方差矩阵为:

用matlab计算这个例子

z=[1,2;3,6;4,2;5,2]

cov(z)

ans =

2.9167 -0.3333

-0.3333 4.0000

可以看出,matlab计算协方差过程中还将元素统一缩小了3倍。所以,协方差的matlab计算公式为:

协方差(i,j)=(第i列所有元素-第i列均值)*(第j列所有元素-第j列均值)/(样本数-1)

下面在给出一个4维3样本的实例,注意4维样本与符号X,Y就没有关系了,X,Y表示两维的,4维就直接套用计算公式,不用X,Y那么具有迷惑性的表达了。

(3)与matlab计算验证

Z=[1 2 3 4;3 4 1 2;2 3 1 4]

cov(Z)

ans =

1.0000 1.0000 -1.0000 -1.0000

1.0000 1.0000 -1.0000 -1.0000

-1.0000 -1.0000 1.3333 0.6667

-1.0000 -1.0000 0.6667 1.3333

可知该计算方法是正确的。我们还可以看出,协方差矩阵都是方阵,它的维度与样本维度有关(相等)。

理解协方差矩阵的关键就在于牢记它计算的是不同维度之间的协方差,而不是不同样本之间,拿到一个样本矩阵,我们最先要明确的就是一行是一个样本还是一个维度,心中明确这个整个计算过程

欧氏距离vs 马氏距离

我们熟悉的欧氏距离虽然很有用,但也有明显的缺点。它将样品的不同属性(即各指标或各变量)之间的差别等同看待,这一点有时不能满足实际要求。例如,在教育研究中,经常遇到对人的分析和判别,个体的不同属性对于区分个体有着不同的重要性。因此,有时需要采用不同的距离函数。如果用dij表示第i个样品和第j个样品之间的距离,那么对一切i,j和k,dij应该满足如下四个条件:

①当且仅当i=j时,dij=0 ②dij>0 ③dij=dji(对称性)④dij≤dik+dkj(三角不等式)

显然,欧氏距离满足以上四个条件。满足以上条件的函数有多种,本节将要用到的马氏距离也是其中的一种。

第i个样品与第j个样品的马氏距离dij用下式计算:

dij =(x i 一x j)’S-1(x i一xj)

其中,x i 和x j分别为第i个和第j个样品的m个指标所组成的向量,S为样本协方差矩阵。

马氏距离是由印度统计学家马哈拉诺比斯(P. C. Mahalanobis)提出的,表示数据的协方差距离。它是一种有效的计算两个未知样本集的相似度的方法。与欧式距离不同的是它考虑到各种特性之间的联系(例如:一条关于身高的信息会带来一条关于体重的信息,因为两者是有关联的),并且是尺度无关的(scale-invariant),即独立于测量尺度。马氏距离不受量纲的影响,两点之间的马氏距离与原始数据的测量单位无关;由标准化数据和中心化数据(即原始数据与均值之差)计算出的二点之间的马氏距离相同。马氏距离还可以排除变量之间的相关性的干扰。它的缺点是夸大了变化微小的变量的作用。

1)马氏距离的计算是建立在总体样本的基础上的,这一点可以从上述协方差矩阵的解释中可以得出,也就是说,如果拿同样的两个样本,放入两个不同的总体中,最后计算得出的两个样本间的马氏距离通常是不相同的,除非这两个总体的协方差矩阵碰巧相同;

2)在计算马氏距离过程中,要求总体样本数大于样本的维数,否则得到的总体样本协方差矩阵逆矩阵不存在,这种情况下,用欧式距离来代替马氏距离,也可以理解为,如果样本数小于样本的维数,这种情况下求其中两个样本的距离,采用欧式距离计算即可。

3)还有一种情况,满足了条件总体样本数大于样本的维数,但是协方差矩阵的逆矩阵仍然不存在,比如A(3,4),B(5,6);C(7,8),这种情况是因为这三个样本在其所处的二维空间平面内共线(如果是大于二维的话,比较复杂???)。这种情况下,也采用欧式距离计算。

4)在实际应用中“总体样本数大于样本的维数”这个条件是很容易满足的,而所有样本点出现3)中所描述的情况是很少出现的,所以在绝大多数情况下,马氏距离是可以顺利计算的,但是马氏距离的计算是不稳定的,不稳定的来源是协方差矩阵,这也是马氏距离与欧式距离的最大差异之处。

—178 — 基于数据挖掘的符号序列聚类相似度量模型 郑宏珍,初佃辉,战德臣,徐晓飞 (哈尔滨工业大学智能计算中心,264209) 摘 要:为了从消费者偏好序列中发现市场细分结构,采用数据挖掘领域中的符号序列聚类方法,提出一种符号序列聚类的研究方法和框架,给出RSM 相似性度量模型。调整RSM 模型参数,使得RSM 可以变为与编辑距离、海明距离等价的相似性度量。通过RSM 与其他序列相似性度量的比较,表明RSM 具有更强的表达相似性概念的能力。由于RSM 能够表达不同的相似性概念,从而使之能适用于不同的应用环境,并在其基础上提出自组织特征映射退火符号聚类模型,使得从消费者偏好进行市场细分结构研究的研究途径在实际应用中得以实现。 关键词:符号序列聚类;数据挖掘;相似性模型 Symbolic Sequence Clustering Regular Similarity Model Based on Data Mining ZHENG Hong-zhen, CHU Dian-hui, ZHAN De-chen, XU Xiao-fei (Intelligent Computing Center, Harbin Institute of Technology, Harbin 264209) 【Abstract 】From a consumer point of the sequence of preference, data mining is used in the field of symbolic sequence clustering methods to detect market segmentation structure. This paper proposes a symbolic sequence clustering methodology and framework, gives the similarity metric RSM model. By adjusting RSM model, parameters can be changed into RSM and edit distance, Hamming distance equivalent to the similarity metric. RSM is compared with other sequence similarity metric, and is more similar to the expression of the concept of capacity. As to express different similarity, the concept of RSM can be applied to different applications environment. Based on the SOM annealing symbol clustering model, the consumer preference for market segmentation can be studied in the structure, which means it is realized in practical application. 【Key words 】symbolic sequence clustering; data mining; similarity model 计 算 机 工 程Computer Engineering 第35卷 第1期 V ol.35 No.1 2009年1月 January 2009 ·人工智能及识别技术·文章编号:1000—3428(2009)01—0178—02文献标识码:A 中图分类号:TP391 1 概述 在经济全球化的环境下,面对瞬息万变的市场和技术发展,企业要想在国内外市场竞争中立于不败之地,必须对客户和市场需求做出快速响应。目前,通过市场调研公司或企业自身的信息系统,收集来自市场和消费者的数据相对容易,而如何理解数据反映的市场细分结构和需求规律却是相当困难的。 为解决这一问题,许多研究者选择消费者的职业、收入、年龄、性别等特征数据作为细分变量,利用统计学传统聚类方法得到市场细分结构[1-2]。在实际应用中,不同的细分变量会导致不同的市场细分结果[3]。 为此,本文从用户偏好序列数据对市场进行细分。通过对符号序列数据相似性的研究,给出一个可形式化的RSM 相似性度量模型和算法概要。该度量模型考虑了2对象之间相似与相异2个方面的因素,通过参数的调整,可以根据问题的具体性质表达不同的相似性概念。并在此基础上,将在数值型数据领域表现良好的SOM 神经网络引入到符号序列数据的聚类问题上,给特征符号序列的机器自动识别提供了可能性。 2 符号序列聚类问题 序列聚类问题作为发现知识的一种重要的探索性技术,受到数据挖掘与知识发现研究领域的极大重视。企业决策者在进行市场和产品相关战略时,迫切需要某些技术手段来理解序列数据,这也正是本文研究的序列聚类问题的工程背景。 下面给出符号序列的相关定义。 定义1 设12{,,,}n A a a a ="为有限符号表,A 中的l 个符号12,,,l a a a "构成的有序集称为符号序列,记为s = 12{,,,}l a a a ",并称l 是s 的长度,记为s 。A 上所有有限长 度符号序列集合记为A *。例如:符号表{a , b , c , d , e , f , g },则

相似性和相异性的度量 相似性和相异性是重要的概念,因为它们被许多数据挖掘技术所使用,如聚类、最近邻分类和异常检测等。在许多情况下,一旦计算出相似性或相异性,就不再需要原始数据了。这种方法可以看作将数据变换到相似性(相异性)空间,然后进行分析。 首先,我们讨论基本要素--相似性和相异性的高层定义,并讨论它们之间的联系。为方便起见,我们使用术语邻近度(proximity)表示相似性或相异性。由于两个对象之间的邻近度是两个对象对应属性之间的邻近度的函数,因此我们首先介绍如何度量仅包含一个简单属性的对象之间的邻近度,然后考虑具有多个属性的对象的邻近度度量。这包括相关和欧几里得距离度量,以及Jaccard和余弦相似性度量。前二者适用于时间序列这样的稠密数据或二维点,后二者适用于像文档这样的稀疏数据。接下来,我们考虑与邻近度度量相关的若干重要问题。本节最后简略讨论如何选择正确的邻近度度量。 1)基础 1. 定义 两个对象之间的相似度(similarity)的非正式定义是这两个对象相似程度的数值度量。因而,两个对象越相似,它们的相似度就越高。通常,相似度是非负的,并常常在0(不相似)和1(完全相似)之间取值。 两个对象之间的相异度(dissimilarity)是这两个对象差异程度的数值度量。对象越类似,它们的相异度就越低。通常,术语距离(distance)用作相异度的同义词,正如我们将介绍的,距离常常用来表示特定类型的相异度。有时,相异度在区间[0, 1]中取值,但是相异度在0和之间取值也很常见。 2. 变换 通常使用变换把相似度转换成相异度或相反,或者把邻近度变换到一个特定区间,如[0, 1]。例如,我们可能有相似度,其值域从1到10,但是我们打算使用的特定算法或软件包只能处理相异度,或只能处理[0, 1]区间的相似度。之所以在这里讨论这些问题,是因为在稍后讨论邻近度时,我们将使用这种变换。此外,这些问题相对独立于特定的邻近度度量。 通常,邻近度度量(特别是相似度)被定义为或变换到区间[0, 1]中的值。这样做的动机是使用一种适当的尺度,由邻近度的值表明两个对象之间的相似(或相异)程度。这种变换通常是比较直截了当的。例如,如果对象之间的相似度在1(一点也不相似)和10(完全相似)之间变化,则我们可以使用如下变换将它变换到[0, 1]区间:s' = (s-1)/9,其中s和s'分别是相似度的原值和新值。一般来说,相似度到[0, 1]区间的变换由如下表达式给出:s'=(s-min_s) / (max_s - min_s),其中max_s和min_s分别是相似度的最大

1 相似度文献总结 相似度有两种基本类别: (1)客观相似度,即对象之间的相似度是对象的多维特征之间的某种函数关系,比如对象之间的欧氏距离;(2)主观相似度,即相似度是人对研究对象的认知关系,换句话说,相似度是主观认知的结果,它取决于人及其所处的环境,主观相似度符合人眼视觉需求,带有一定的模糊性[13]。 1.1 客观相似度 客观相似度可分为距离测度、相似测度、匹配测度。它们都是衡量两对象客观上的相近程度。客观相似度满足下面的公理,假设对象 A 与B 的相似度判别为(,)A B δ,有: (1) 自相似度是一个常量:所有对象的自相似度是一个常数,通常为 1,即 (,)(,)1A A B B δδ== (2) 极大性:所有对象的自相似度均大于它与其他对象间的相似度,即 (,)(,)(,)(,)A B A A A B B B δδδδ≤≤和。 (3) 对称性:两个对象间的相似度是对称的,即(,)(,)A B B A δδ=。 (4) 唯一性:(,)1A B δ=,当且仅当A B =。 1.1.1 距离测度 这类测度以两个矢量矢端的距离为基础,因此距离测度值是两矢量各相应分量之差的函数。设{}{}'' 1212,,,,,,,n n x x x x y y y y == 表示两个矢量,计算二者之间距离测度的具体方式有多种,最常用的有: 1.1.1.1 欧氏距离:Euclidean Distance-based Similarity 最初用于计算欧几里德空间中两个点的距离,假设 x ,y 是 n 维空间的两个点,它们之间的欧几里德距离是: 1/221(,)()n i i i d x y x y x y =??=-=-????∑(1.1)

颜色直方图: 全局颜色直方图:反映的是图像中颜色的组成分布,即出现了哪些颜色以及各种颜色出现的概率,Swain 和 Ballard最先提出了使用颜色直方图作为图像颜色特征的表示方法。他们还指出:颜色直方图相对于图像的以观察轴为轴心的旋转以及幅度不大的平移和缩放等几何变换是不敏感的,颜色直方图对于图像质量的变化(如模糊)也不甚敏感。颜色直方图的这种特性使得它比较适合于检索图像的全局颜色相似性的场合,即通过比较颜色直方图的差异来衡量两幅图像在颜色全局分布上的差异。 颜色直方图的主要性质有:直方图中的数值都是统计而来,描述了该图像中关于颜色的数量特征,可以反映图像颜色的统计分布和基本色调;直方图只包含了该图像中某一颜色值出现的频数,而丢失了某象素所在的空间位置信息;任一幅图像都能唯一的给出一幅与它对应的直方图,但不同的图像可能有相同的颜色分布,从而就具有相同的直方图,因此直方图与图像是一对多的关系;如将图像划分为若干个子区域,所有子区域的直方图之和等于全图直方图;一般情况下,由于图像上的背景和前景物体颜色分布明显不同,从而在直方图上会出现双峰特性,但背景和前景颜色较为接近的图像不具有这个特性。 累加直方图:当图像中的特征并不能取遍所有可取值时,统计直方图中会出现一些零值。这些零值的出现会对相似性度量的计算带来影响,从而使得相似性度量并不能正确反映图像之间的颜色差别。为解决这个问题,在全局直方图的基础上,Stricker和Orengo进一步提出了使用“累加颜色直方图”的概念。在累加直方图中,相邻颜色在频数上是相关的。相比一般直方图,虽然累加直方图的存储量和计算量有很小的增加,但是累加直方图消除了一般直方图中常见的零值,也克服了一般直方图量化过细过粗检索效果都会下降的缺陷。一般的颜色直方图由于颜色空间是三维的,具有相同的三通道独立分布,但其联合分布并不为一。这种不考虑联合分布的方法,会导致在结果集中不相似的图像数目增加。

在数据分析和数据挖掘的过程中,我们经常需要知道个体间差异的大小,进而评价个体的相似性和类别。最常见的是数据分析中的相关分析,数据挖掘中的分类和聚类算法,如K最近邻(KNN)和K均值(K-Means)。当然衡量个体差异的方法有很多,最近查阅了相关的资料,这里整理罗列下。 为了方便下面的解释和举例,先设定我们要比较X个体和Y个体间的差异,它们都包含了N个维的特征,即X=(x1, x2, x3, … x n),Y=(y1, y2, y3, … y n)。下面来看看主要可以用哪些方法来衡量两者的差异,主要分为距离度量和相似度度量。 距离度量 距离度量(Distance)用于衡量个体在空间上存在的距离,距离越远说明个体间的差异越大。 欧几里得距离(Euclidean Distance) 欧氏距离是最常见的距离度量,衡量的是多维空间中各个点之间的绝对距离。公式如下: 因为计算是基于各维度特征的绝对数值,所以欧氏度量需要保证各维度指标在相同的刻度级别,比如对身高(cm)和体重(kg)两个单位不同的指标使用欧式距离可能使结果失效。 明可夫斯基距离(Minkowski Distance) 明氏距离是欧氏距离的推广,是对多个距离度量公式的概括性的表述。公式如下: 这里的p值是一个变量,当p=2的时候就得到了上面的欧氏距离。 曼哈顿距离(Manhattan Distance) 曼哈顿距离来源于城市区块距离,是将多个维度上的距离进行求和后的结果,即当上面的明氏距离中p=1时得到的距离度量公式,如下:

切比雪夫距离(Chebyshev Distance) 切比雪夫距离起源于国际象棋中国王的走法,我们知道国际象棋国王每次只能往周围的8格中走一步,那么如果要从棋盘中A格(x1, y1)走到B格(x2, y2)最少需要走几步?扩展到多维空间,其实切比雪夫距离就是当p趋向于无穷大时的明氏距离: 其实上面的曼哈顿距离、欧氏距离和切比雪夫距离都是明可夫斯基距离在特殊条件下的应用。 马哈拉诺比斯距离(Mahalanobis Distance) 既然欧几里得距离无法忽略指标度量的差异,所以在使用欧氏距离之前需要对底层指标进行数据的标准化,而基于各指标维度进行标准化后再使用欧氏距离就衍生出来另外一个距离度量——马哈拉诺比斯距离(Mahalanobis Distance),简称马氏距离。 相似度度量 相似度度量(Similarity),即计算个体间的相似程度,与距离度量相反,相似度度量的值越小,说明个体间相似度越小,差异越大。 向量空间余弦相似度(Cosine Similarity) 余弦相似度用向量空间中两个向量夹角的余弦值作为衡量两个个体间 差异的大小。相比距离度量,余弦相似度更加注重两个向量在方向上的差异,而非距离或长度上。公式如下: 皮尔森相关系数(Pearson Correlation Coefficient) 即相关分析中的相关系数r,分别对X和Y基于自身总体标准化后计算空间向量的余弦夹角。公式如下:

(一)概述 为什么要数据挖掘(Data Mining)? 存在可以广泛使用的大量数据,并且迫切需要将数据转转换成有用的信息和知识 什么是数据挖掘? 数据挖掘(Data Mining)是指从大量数据中提取或“挖掘”知识。 对何种数据进行数据挖掘? 关系数据库、数据仓库、事务数据库 空间数据 超文本和多媒体数据 时间序列数据 流数据 (二)数据预处理 为什么要预处理数据? 为数据挖掘过程提供干净、准确、简洁的数据,提高数据挖掘的效率和准确性,是数据挖掘中非常重要的环节; 数据库和数据仓库中的原始数据可能存在以下问题: 定性数据需要数字化表示 不完整 含噪声 度量单位不同 维度高 数据的描述 度量数据的中心趋势:均值、加权均值、中位数、众数 度量数据的离散程度:全距、四分位数、方差、标准差 基本描述数据汇总的图形显示:直方图、散点图 度量数据的中心趋势 集中趋势:一组数据向其中心值靠拢的倾向和程度。 集中趋势测度:寻找数据水平的代表值或中心值。 常用的集中趋势的测度指标: 均值: 缺点:易受极端值的影响 中位数:对于不对称的数据,数据中心的一个较好度量是中位数 特点:对一组数据是唯一的。不受极端值的影响。 众数:一组数据中出现次数最多的变量值。 特点:不受极端值的影响。有的数据无众数或有多个众数。

度量数据的离散程度 反映各变量值远离其中心值的程度(离散程度),从另一个侧面说明了集中趋势测度值的代表程度。 常用指标: 全距(极差):全距也称极差,是一组数据的最大值与最小值之差。 R=最大值-最小值 组距分组数据可根据最高组上限-最低组下限计算。 受极端值的影响。 四分位距 (Inter-Quartilenge, IQR):等于上四分位数与下四分位数之差(q3-q1) 反映了中间50%数据的离散程度,数值越小说明中间的数据越集中。 不受极端值的影响。 可以用于衡量中位数的代表性。 四分位数: 把顺序排列的一组数据分割为四(若干相等)部分的分割点的数值。 分位数可以反映数据分布的相对位置(而不单单是中心位置)。 在实际应用中四分位数的计算方法并不统一(数据量大时这些方法差别不大)。对原始数据: SPSS中四分位数的位置为(n+1)/4, 2(n+1)/4, 3 (n+1)/4。 Excel中四分位数的位置分别为(n+3)/4, 2(n+1)/4,(3 n+1)/4。 如果四分位数的位置不是整数,则四分位数等于前后两个数的加权平均。 方差和标准差:方差是一组数据中各数值与其均值离差平方的平均数,标准差是方差正的平方根。 是反映定量数据离散程度的最常用的指标。 基本描述数据汇总的图形显示 直方图(Histogram):使人们能够看出这个数据的大体分布或“形状” 散点图 如何进行预处理 定性数据的数字化表示: 二值描述数据的数字化表示 例如:性别的取值为“男”和“女”,男→1,女→0 多值描述数据的数字化表示 例如:信誉度为“优”、“良”、“中”、“差” 第一种表示方法:优→1,良→2,中→3,差→4 第二种表示方法:

在做分类时常常需要估算不同样本之间的相似性度量(SimilarityMeasurement),这时通常采用的方法就是计算样本间的“距离”(Distance)。采用什么样的方法计算距离是很讲究,甚至关系到分类的正确与否。对常用的相似性度量作一个总结。1.欧氏距离2.曼哈顿距离3. 切比雪夫距离4. 闵可夫斯基距离5.标准化欧氏距离6.马氏距离7.夹角余弦8.汉明距离9.杰卡德距离& 杰卡德相似系数10.相关系数& 相关距离11.信息熵12.兰氏距离13.斜交空间距离14.最大-最小相似度15.指数相似度16.KL距离 1. 欧氏距离(EuclideanDistance) 欧氏距离是最易于理解的一种距离计算方法,源自欧氏空间中两点间的距离公式。 (1)二维平面上两点a(x1,y1)与b(x2,y2)间的欧氏距离: 三维空间两点a(x1,y1,z1)与b(x2,y2,z2)间的欧氏距离: (2)两个n维向量a(x11,x12,…,x1n)与 b(x21,x22,…,x2n)间的欧氏距离: 也可以用表示成向量运算的形式: (4)Matlab计算欧氏距离 Matlab计算距离主要使用pdist函数。若X是一个M×N的矩阵,则pdist(X)将X矩阵M行的每一行作为一个N维向量,然后计算这M个向量两两间的距离。 例子:计算向量(0,0)、(1,0)、(0,2)两两间的欧式距离 X= [0 0 ; 1 0 ; 0 2] D= pdist(X,'euclidean') 结果: D= 1.0000 2.0000 2.2361 2. 曼哈顿距离(ManhattanDistance)又称绝对值距离 从名字就可以猜出这种距离的计算方法了。想象你在曼哈顿要从一个十字路口开车到另外一个十字路口,驾驶距离是两点间的直线距离吗?显然不是,除非你能穿越大楼。实际驾驶距离就是这个“曼哈顿距离”。而这也是曼哈顿距离名称的来源,曼哈顿距离也称为城市街区距离(CityBlock distance)。 (1)二维平面两点a(x1,y1)与b(x2,y2)间的曼哈顿距离

1.4 数据仓库和数据库有何不同?有哪些相似之处? 答:区别:数据仓库是面向主题的,集成的,不易更改且随时间变化的数据集合,用来支持管理人员的决策,数据库由一组内部相关的数据和一组管理和存取数据的软件程序组成,是面向操作型的数据库,是组成数据仓库的源数据。它用表组织数据,采用ER数据模型。 相似:它们都为数据挖掘提供了源数据,都是数据的组合。 1.3 定义下列数据挖掘功能:特征化、区分、关联和相关分析、预测聚类和演变分析。使用你熟悉的现实生活的数据库,给出每种数据挖掘功能的例子。 答:特征化是一个目标类数据的一般特性或特性的汇总。例如,学生的特征可被提出,形成所有大学的计算机科学专业一年级学生的轮廓,这些特征包括作为一种高的年级平均成绩(GPA:Grade point aversge)的信息, 还有所修的课程的最大数量。 区分是将目标类数据对象的一般特性与一个或多个对比类对象的一般特性进行比较。例如,具有高GPA 的学生的一般特性可被用来与具有低GPA 的一般特性比较。最终的描述可能是学生的一个一般可比较的轮廓,就像具有高GPA 的学生的75%是四年级计算机科学专业的学生,而具有低GPA 的学生的65%不是。 关联是指发现关联规则,这些规则表示一起频繁发生在给定数据集的特征值的条件。例如,一个数据挖掘系统可能发现的关联规则为:major(X, “computing science”) ? owns(X, “personal computer”) [support=12%, confidence=98%] 其中,X 是一个表示学生的变量。这个规则指出正在学习的学生,12% (支持度)主修计算机科学并且拥有一台个人计算机。这个组一个学生拥有一台个人电脑的概率是98%(置信度,或确定度)。 分类与预测不同,因为前者的作用是构造一系列能描述和区分数据类型或概念的模型(或功能),而后者是建立一个模型去预测缺失的或无效的、并且通常是数字的数据值。它们的相似性是他们都是预测的工具: 分类被用作预测目标数据的类的标签,而预测典型的应用是预测缺失的数字型数据的值。 聚类分析的数据对象不考虑已知的类标号。对象根据最大花蕾内部的相似性、最小化类之间的相似性的原则进行聚类或分组。形成的每一簇可以被看作一个对象类。聚类也便于分类法组织形式,将观测组织成类分 层结构,把类似的事件组织在一起。 数据演变分析描述和模型化随时间变化的对象的规律或趋势,尽管这可能包括时间相关数据的特征化、区分、关联和相关分析、分类、或预测,这种分析的明确特征包括时间序列数据分析、序列或周期模式匹配、和基于相似性的数据分析 2.3 假设给定的数据集的值已经分组为区间。区间和对应的频率如下。――――――――――――――――――――――――――――――――――――― 年龄频率――――――――――――――――――――――――――――――――――――― 1~5 200 5~15 450 15~20 300 20~50 1500 50~80 700 80~110 44 ―――――――――――――――――――――――――――――――――――――计算数据的近似中位数值。 解答:先判定中位数区间:N=200+450+300+1500+700+44=3194;N/2=1597 ∵ 200+450+300=950<1597<2450=950+1500; ∴ 20~50 对应中位数区间。

优先出版 计 算 机 应 用 研 究 第32卷 -------------------------------- 基金项目:黑龙江省教育厅科学技术研究资助项目(12541125) 作者简介:高雪瑶(1979-),女,黑龙江省哈尔滨市人,副教授硕导,博士,主要研究方向为计算机图形学与CAD(gaoxueyao@https://www.doczj.com/doc/c5107643.html,);姜宏山(1989-),男,硕士研究生,主要研究方向为计算机图形学与CAD ;张春祥(1974-),男,教授硕导,博士,主要研究方向为计算机图形学与自然语言处理;卢志茂(1972-),男,教授硕导,博士,主要研究方向为自然语言处理. 基于面匹配的模型相似性度量方法 * 高雪瑶1a ,姜宏山1a ,张春祥1b ,卢志茂2 (1.哈尔滨理工大学 a .计算机科学与技术学院;b .软件学院,哈尔滨 150080;2.大连理工大学 计算机科学与技术学院,辽宁 大连 116024) 摘 要:模型相似性度量是CAD 模型检索中的一个重要问题。为了准确地衡量两个模型的相似程度,本文提出了一种基于面匹配的模型相似性计算方法。使用面邻接图表示模型的拓扑结构,根据面的组成边数来构造两个模型之间的面匹配矩阵,同时,使用贪心算法来计算模型之间的相似性。在实验中,使用本文所提出的方法来度量目标CAD 模型和源CAD 模型之间的相似程度。实验结果表明:该方法能够有效地衡量模型之间的差异。 关键词:模型相似性;面邻接图;面匹配矩阵;贪心算法 中图分类号:TP391.7 文献标志码:A Method of model similarity measurement based on face matching GAO Xue-yao 1a , JIANG Hong-shan 1a , ZHANG Chun-xiang 1b , LU Zhi-mao 2 (1. a. School of Computer Science & Technology, b. School of Software, Harbin University of Science & Technology, Harbin 150080, China; 2. School of Computer Science & Technology, Dalian University of Technology, Dalian 116024, China) Abstract: Model similarity measurement is an important problem in retrieval of CAD models. In order to measure the similarity degree between two models precisely, this paper proposes a method to compute the similarity of models based on face matching. It uses a face relational graph to express the topological structure in the model and constructs the face matching matrix between two models. At the same time, it applies the greedy algorithm to compute the similarity between these two models. In experiments, it uses the proposed method of this paper to measure the similarity degree between target CAD model and source CAD model. Experimental results show that the method can measure the difference of models efficiently. Key Words: model similarity; face relational graph; face matching matrix; greedy algorithm 0 引言 CAD 模型相似性计算是三维模型检索中的重要组成部分,对检索系统的效率和可靠性都有着很大程度的影响。针对现有模型检索算法对局部细节特征描述不充分的现状,白晓亮提出了一种基于最大公共子图的三维CAD 模型检索算法。提取CAD 模型的B-Rep 信息,使用属性邻接图来表示模型。利用最大公共子图来检测CAD 模型中所包含的相似特征,根据相似特征来实现CAD 模型的相似性评价[1]。张欣提出了一种利用属性图来比较CAD 模型形状相似性的算法。根据图的邻接矩阵和顶点属性来构造图顶点序列,通过动态编程求出最大公共子图,得到CAD 模型之间的形状相似度。根据求出的未知模型与已知模型之间的形状相似度,利用概率方法来实现未知模型的自动语义标注[2]。王小凤提取三维模型深度图像边界方向的直方图和Zernike 矩特征,利用特征距离来度量两个模型之间的相似性[3]。王洪申利用模型的B-rep 表示过滤出与欲检索结构组成面相似 的面。通过删除不相关的面,将可能相似的局部结构从待检索模型中分离出来。利用二分图最优匹配算法计算分离出来的结构和欲检索结构之间的相似系数,以度量模型之间的相似程度 [4]。Tao 使用面属性关系图来表示CAD 模型,将实体模型的表 面边界分解为局部凸面、凹面和平面。在分解过程中,保持其突出几何特征数量的最小化。利用区域代码来描述表面区域以及它们在CAD 模型中的连接关系。通过比较区域属性代码来评估两个模型之间的相似性[5]。Wang 在三维模型表面任取若干个点,记录每个点的法向量,连接任意两点形成线段。计算线段的欧几里得距离,求出两端点的法向量与该线段的夹角。根据两个夹角将所得线段分为三个集合。针对每个集合,使用欧几里得距离来构造形状分布曲线。通过比较模型的三条形状分布曲线来求出两个模型的相似度[6]。Supasasi 使用Reeb 图来表示三维模型的结构属性,将其分解为若干个子部件。利用姿态无关的形状符号来描述每一个子部件的表面。使用最大公共子图来表示其拓扑结构,以度量三维模型之间的相似程度[7]。Wei

距离和相似性度量 相似性度量或者距离函数对于像聚类,邻域搜索这样的算法是非常重要的。前面也提到,网页去重复也是相似性应用的一个例子。然而,如何定义个合适的相似或者距离函数,完全依赖于手头的任务是什么。一般而言,定义一个距离函数d(x,y),需要满足以下几个准则:1. d(x,x) = 0 ;//到自己的距离为0 2. d(x,y)>=0 // 距离要非负 3. 对称性,d(x,y) = d(y,x) //如果A到B距离是a,那么B 到A的距离也应该是a 4. 三角形法则(两个之和大于第三边)d(x,k)+ d(k,y) >= d(x,y) 满足这4个条件的距离函数很多,一般有几类是比较常见的,通常来自比较直观的形象,如平面的一个两点的直线距离。下面讨论应用比较广泛的几类距离或相似性度量函数,欧拉距离,余弦函数cosine,Pearson函数,Jaccard index,edit distance。如果一个对象d(如:一篇文档)表示成一个n维的向量(d1,d2,….,dn),每一个维度都为对象的一个特征,那么这些度量函数极容易得到应用。1.范数和欧拉距离 欧拉距离,来自于欧式几何(就是我们小学就开始接触的几何学),在数学上也可以成为范数。如果一个对象对应于空

间的一个点,每一个维度就是空间的一个维度。特殊情况,如果n=1,那么,小学我们就学过,直线上两个点的距离是|x1-x2|。推广到高纬情况,一个很自然的想法是,把每一个维度的距离加起来不就可以呢。这就形成了传说中的一范数:看,是不是很简单。有一范数就有二范数,三范数。。。无穷范数。其实,二范数来的更加直观,我们都知道二维空间,三维空间的两点的距离公式。他就是二范数,在二维三维上的形式了。 好了,一鼓作气,p范数(p-norm) 无穷范数: 空间两点的距离公式(2-范数),是最常用的距离公式,他就是传说中的欧拉距离。多简单。2. cosine similarity cosine similarity是备受恩宠啊,在学向量几何的时候,应该接触过这个神奇的公式 分子是两 个向量的点积,||A||是向量的长度,这个公式神奇的地方是,随着角度的变化的,函数是从-1,1变化的。向量夹角的余 弦就是两个向量的相似度。cosine similarity 说,如果两个 向量的夹角定了,那么无论一个向量伸长多少倍,他们的相似性都是不变的。所以,应用cosine 相似性之前,要把对 象的每一个维度归一化。在搜索引擎技术中,cosine 相似性在计算查询和文档的相似性的时得到了很好的应用。对查询

数据挖掘之相似性度量 机器学习或数据挖掘,就是在数据中寻求答案的算法。 而寻求的答案就是训练完成的数据模型。 大部分的数据建模方法都属于这两种: 1)数据汇总,对数据进行简洁的近似描述 如pagerank、聚类 2)特征抽取 如频繁项集(同时频繁出现的元素子集)、相似项(共同元素比例较高的集合对) 在机器学习或数据挖掘之前,还需要概率,或信息论的一些相关知识,现实世界的对象需要转换为计算机的度量方式。 1. TF.IDF 2. 熵的相关概念 3. 相似度的度量及计算 4. 对文本相似度的分析 5. 局部敏感Hash的分析LSH 6. 查找相似项的处理流程 7. 几种距离度量方式 相关知识: 1. TF.IDF 文本分类时,一个重要指标:TF.IDF,分为两个阶段:同一文档中的统计;以文档为粒度,所有文档的统计。 TF: term frequency 词项频率,同一篇文档中,所有词项出现频率的归一化 IDF:inverse document frequency 逆文档频率,所有文档数目,与某一词出现的

文档的数目的比率关系 其中的关系: 不仅仅是一个公式,里面包含了信息论中熵的概念。IDF就是一个特定条件下关键词的概率分布的交叉熵。应用了对数运算。 2. 熵的相关概念 熵,表示信息量的大小,与概率相关。随机变量的不确定性越大,即概率小,其熵也就越大,将其搞清楚,所需的信息量也就越大。 -Pi * log(2, Pi) 求和。一个系统越混乱,则每个变量的概率越小,其熵也就越大。 信息论在通信编码的表示也是一样的,一个变量,在系统中的概率越小,其编码也就越长,因为短的编码要留给概率大的变量。即熵越大,其编码也就越长,这样压缩的效率就比较高。发送一段信息,其需要的编码长度(二进制),也就是 -Pi * log(2, Pi) 求和。或者,可以说,熵越大,信息量越大,一个概率较低的词,可能就是系统信息比较关键的词。 互信息:两个随机变量的相关/依赖程度,可以用来解释一个变量已知时,另外一个变量的不确定的变化。即不确定信息的减少量。 自信息:一个随机变量(信源)发出的信息,这个信息所带来的信息量的度量。一次事件发生的提供的信息量-log(2, Pi),有时与熵的含义相同(当事件只发生一次时)。 而熵是平均信息量,所有自信息的期望。当信息确定时,确定场(无随机性)的熵最小。等概场的熵最大。 熵率:又称字符熵、词熵。信息量的大小随着消息长度的增加而增加。-(1/n)(求和Pi*log(2, Pi)) 联合熵:同联合分布函数的形式类似,联合随机变量所表示的平均信息量(期望)。H(x, y) = -求和P(x,y) log(2, P(x, y)) 条件熵:H(y|x) = -求和P(x,y) log(2, P(y|x)) 联合熵 = 条件熵 + 单变量熵, H(x, y) = H(y|x) + H(x) 互信息的熵 I (x; y) = H(x) - H(y | x) = H(y) - H(y|x), 描述了X中包含有多少Y的信息量,或者是Y中包含了多少X的信息量。 当X, Y相互独立,则其互信息为0. 当I(x; y) >> 0,则两个事件X,Y高度相关;当I(x; y)<<0,则两个事件X,Y 互补分布。

第一章 1、数据仓库就是一个面向主题的、集成的、相对稳定的、反映历史变化的数据集合。 2、元数据是描述数据仓库内数据的结构和建立方法的数据,它为访问数据仓库提供了一个信息目录,根据数据用途的不同可将数据仓库的元数据分为技术元数据和业务元数据两类。 3、数据处理通常分成两大类:联机事务处理和联机分析处理。 4、多维分析是指以“维”形式组织起来的数据(多维数据集)采取切片、切块、钻取和旋转等各种分析动作,以求剖析数据,使拥护能从不同角度、不同侧面观察数据仓库中的数据,从而深入理解多维数据集中的信息。 5、ROLAP是基于关系数据库的OLAP实现,而MOLAP是基于多维数据结构组织的OLAP实现。 6、数据仓库按照其开发过程,其关键环节包括数据抽取、数据存储与管理和数据表现等。 7、数据仓库系统的体系结构根据应用需求的不同,可以分为以下4种类型:两层架构、独立型数据集合、以来型数据结合和操作型数据存储和逻辑型数据集中和实时数据仓库。 8、操作型数据存储实际上是一个集成的、面向主题的、可更新的、当前值的(但是可“挥发”的)、企业级的、详细的数据库,也叫运营数据存储。 9、“实时数据仓库”以为着源数据系统、决策支持服务和仓库仓库之间以一个接近实时的速度交换数据和业务规则。 10、从应用的角度看,数据仓库的发展演变可以归纳为5个阶段:以报表为主、以分析为主、以预测模型为主、以运营导向为主和以实时数据仓库和自动决策为主。 第二章 1、调和数据是存储在企业级数据仓库和操作型数据存储中的数据。 2、抽取、转换、加载过程的目的是为决策支持应用提供一个单一的、权威数据源。因此,我们要求ETL 过程产生的数据(即调和数据层)是详细的、历史的、规范的、可理解的、即时的和质量可控制的。 3、数据抽取的两个常见类型是静态抽取和增量抽取。静态抽取用于最初填充数据仓库,增量抽取用于进行数据仓库的维护。 4、粒度是对数据仓库中数据的综合程度高低的一个衡量。粒度越小,细节程度越高,综合程度越低,回答查询的种类越多。 5、使用星型模式可以从一定程度上提高查询效率。因为星型模式中数据的组织已经经过预处理,主要数据都在庞大的事实表中。 6、维度表一般又主键、分类层次和描述属性组成。对于主键可以选择两种方式:一种是采用自然键,另一种是采用代理键。 7、雪花型模式是对星型模式维表的进一步层次化和规范化来消除冗余的数据。 8、数据仓库中存在不同综合级别的数据。一般把数据分成4个级别:早期细节级、当前细节级、轻度综合级和高度综合级。 第三章 1、SQL Server SSAS提供了所有业务数据的同意整合试图,可以作为传统报表、在线分析处理、关键性能指示器记分卡和数据挖掘的基础。 2、数据仓库的概念模型通常采用信息包图法来进行设计,要求将其5个组成部分(包括名称、维度、类别、层次和度量)全面地描述出来。 3、数据仓库的逻辑模型通常采用星型图法来进行设计,要求将星型的各类逻辑实体完整地描述出来。 4、按照事实表中度量的可加性情况,可以把事实表对应的事实分为4种类型:事务事实、快照事实、线性项目事实和事件事实。 5、确定了数据仓库的粒度模型以后,为提高数据仓库的使用性能,还需要根据拥护需求设计聚合模型。 6、在项目实施时,根据事实表的特点和拥护的查询需求,可以选用时间、业务类型、区域和下属组织等多种数据分割类型。

讨论一般时间序列相似的度量方式 1、概念: 时间序列的相似性度量是衡量两个时间序列的相似程度的方法。它是时间序列分类、聚类、异常发现等诸多数据挖掘问题的基础;也是时间序列挖掘的核心问题之一。 2、意义: 时间序列式进行序列查询、分类、预测的基本工作,寻求一种好的度量对提高挖掘任务的效率和准确性有着至关重要的意义。 3、影响因素: 两个序列是否相似,主要看它们的变化趋势是否一致。由于时间序列数据的复杂性特点,实际中不可能存在两条完全相同的时间序列,即使相似的时间序列往往也会呈现出各种各样的变化。所以,任何两个序列之间都存在着某种差异,影响这种差异的主要因素有: (1)噪声:现实的大多数时间序列数据都存在噪声,体现在图形上式指数据的曲线不光滑,即存在“毛刺”。 (2)振幅平移:即两条形态相似的时间序列分别绕高低不同的均值波动。(3)振幅伸缩:即两条时间序列的变化趋势相同,但其中一条时间序列在纵轴上似乎被拉伸或者压缩过一样,即两个序列的振幅不同。 (4)时间轴伸缩:是指两条时间序列的波形相似,但其中一条时间序列在时间轴上按比例伸缩。 (5)线性漂移:是指两条时间序列的波动节奏相似,但其中一条时间序列呈现线性递增或递减趋势。 (6)不连续性:是指两条时间序列整体的波动趋势相同,只是在别的时间点或段出现间断。

然而,在实际应用中情况要复杂得多,往往是以上多种因素交织在一起。时间序列的相似性并没有一个客观的定义,具有一定的个人偏好性,也就是说,不同的人或不同的应用场合对各种差异影响的重视程度是不一样的。给定两条时间序列 {}12,,....,n X x x x =和{}12=,,....m Y y y y ,相似性度量的问题就是在各种各样差异因素的影响下,寻求一个合适的相似性度量函数(),Sim X Y ,使得该函数能很好地反映时间序列数据的特点。 4、方法:目前时间序列相似性度量,最常用的有Minkowski 距离和动态时间弯曲。 一、Minkowski 距离 给定两条时间序列{}{}1 212....=....n n X x x x Y y y y =和 它们之间的Minkowski 距离如下: ()11,n p p i i i d X Y x y =??=- ???∑ Minkowski 距离是一种距离度量,因为它满足距离的三个条件: (1) 非负性:()(),0,,,0d X Y X Y d X Y ≥==当且仅当; (2) 对称性:()(),,;d X Y d Y X = (3) 三角不等式:()()(),,,d Y Z d X Y d X Z ≤+ 大多简单的相似性度量是Minkowski 距离及其它的变种,Minkowski 距离的优点是简单、直观且计算复杂度不高,与时间序列的长度成线性关系即序列长度的增加不会造成计算复杂程度的迅速提高。所以当训练集比较大时,Minkowski 距离比其他更有效。但是Minkowski 距离不支持时间序列的线性漂移和时间弯曲,且无法处理不等长的时间序列。