k-means文本聚类

- 格式:doc

- 大小:63.50 KB

- 文档页数:6

聚类算法:K-Means和DBSCAN的比较K-Means和DBSCAN是两种常见的聚类算法,它们在数据挖掘和机器学习领域具有重要的应用价值。

本文将比较这两种算法的优缺点、适用场景等方面,以期帮助读者更好地理解它们的特点和区别。

1. K-Means算法K-Means算法是一种基于距离的聚类算法,它的基本思想是将数据集划分为K个簇,使得每个样本点都属于与其最近的簇。

具体来说,K-Means算法的工作流程如下:(1)随机初始化K个中心点;(2)将每个样本点分配到距离最近的中心点所对应的簇中;(3)更新每个簇的中心点,即将该簇内所有样本点的均值作为新的中心点;(4)重复执行步骤(2)和(3),直到中心点不再发生变化或达到迭代次数上限。

K-Means算法的优点包括实现简单、计算高效等,适用于数据量较大的情况。

但它也存在一些缺点,比如对初始中心点的选择敏感,容易陷入局部最优解,不适用于发现非凸簇等情况。

2. DBSCAN算法DBSCAN(Density-Based Spatial Clustering of Applications with Noise)算法是一种基于密度的聚类算法,它的核心思想是通过样本点的密度来发现聚类簇。

DBSCAN算法的具体步骤如下:(1)以任意顺序选择一个未访问的样本点;(2)计算该样本点的邻域内的样本点个数,若超过预设的阈值,则标记为核心点,否则标记为噪声点;(3)将与核心点密度相连的样本点放入同一个簇中,并继续递归地扩展该簇;(4)重复执行步骤(1)和(2),直到所有样本点都被访问为止。

DBSCAN算法的优点在于可以发现任意形状的簇,并且对噪声数据具有鲁棒性,不受初始参数的影响。

但它也存在一些局限性,比如对密度不同的簇难以处理,对参数的敏感性较强等。

3. K-Means和DBSCAN的比较K-Means和DBSCAN是两种不同的聚类算法,它们在很多方面存在明显的差异。

下面将分别从适用场景、对数据特点的适应性、算法复杂度等方面对它们进行比较。

文本聚类过程文本聚类是一种将文本数据分组的技术,它可以将相似的文本归为一类,从而更好地理解和分析文本数据。

文本聚类过程包括以下几个步骤:1. 数据预处理在进行文本聚类之前,需要对文本数据进行预处理。

预处理包括去除停用词、词干提取、词向量化等步骤。

去除停用词是指去除一些常见的无意义词汇,如“的”、“是”等。

词干提取是指将单词的不同形态转化为其基本形式,如将“running”转化为“run”。

词向量化是指将文本数据转化为向量形式,以便于计算相似度。

2. 特征提取在进行文本聚类之前,需要将文本数据转化为特征向量。

常用的特征提取方法包括词袋模型、TF-IDF模型等。

词袋模型是指将文本数据转化为一个词汇表,然后统计每个单词在文本中出现的次数,将其转化为向量形式。

TF-IDF模型是指将每个单词的重要性加权,以便于更好地区分不同的文本。

3. 相似度计算在进行文本聚类之前,需要计算文本之间的相似度。

常用的相似度计算方法包括余弦相似度、欧几里得距离等。

余弦相似度是指将文本向量进行归一化,然后计算它们之间的夹角余弦值。

欧几里得距离是指计算文本向量之间的欧几里得距离。

4. 聚类算法在进行文本聚类之前,需要选择合适的聚类算法。

常用的聚类算法包括K-Means算法、层次聚类算法等。

K-Means算法是一种基于距离的聚类算法,它将文本数据分为K个簇,每个簇的中心点是该簇中所有文本向量的平均值。

层次聚类算法是一种基于相似度的聚类算法,它将文本数据分为一棵树形结构,每个节点代表一个簇,节点之间的距离表示簇之间的相似度。

5. 聚类评估在进行文本聚类之后,需要对聚类结果进行评估。

常用的聚类评估指标包括轮廓系数、互信息等。

轮廓系数是指将每个文本向量与其所属簇中其他文本向量的相似度与该文本向量与其他簇中文本向量的相似度进行比较,以评估聚类结果的质量。

互信息是指将聚类结果与真实标签进行比较,以评估聚类结果的准确性。

文本聚类是一种重要的文本分析技术,它可以帮助我们更好地理解和分析文本数据。

kmeans的聚类算法K-means是一种常见的聚类算法,它可以将数据集划分为K个簇,每个簇包含相似的数据点。

在本文中,我们将详细介绍K-means算法的原理、步骤和应用。

一、K-means算法原理K-means算法基于以下两个假设:1. 每个簇的中心是该簇内所有点的平均值。

2. 每个点都属于距离其最近的中心所在的簇。

基于这两个假设,K-means算法通过迭代寻找最佳中心来实现聚类。

具体来说,该算法包括以下步骤:二、K-means算法步骤1. 随机选择k个数据点作为初始质心。

2. 将每个数据点分配到距离其最近的质心所在的簇。

3. 计算每个簇内所有数据点的平均值,并将其作为新质心。

4. 重复步骤2和3直到质心不再变化或达到预定迭代次数。

三、K-means算法应用1. 数据挖掘:将大量数据分成几组可以帮助我们发现其中隐含的规律2. 图像分割:将图像分成几个部分,每个部分可以看做是一个簇,从而实现图像的分割。

3. 生物学:通过对生物数据进行聚类可以帮助我们理解生物之间的相似性和差异性。

四、K-means算法优缺点1. 优点:(1)简单易懂,易于实现。

(2)计算效率高,适用于大规模数据集。

(3)结果可解释性强。

2. 缺点:(1)需要预先设定簇数K。

(2)对初始质心的选择敏感,可能会陷入局部最优解。

(3)无法处理非球形簇和噪声数据。

五、K-means算法改进1. K-means++:改进了初始质心的选择方法,能够更好地避免陷入局部最优解。

2. Mini-batch K-means:通过随机抽样来加快计算速度,在保证精度的同时降低了计算复杂度。

K-means算法是一种常见的聚类算法,它通过迭代寻找最佳中心来实现聚类。

该算法应用广泛,但也存在一些缺点。

针对这些缺点,我们可以采用改进方法来提高其效果。

一、介绍k-means 聚类法k-means 聚类法是一种常见的数据聚类算法,可以根据数据的特征将样本分成不同的类别。

这种方法是一种无监督学习算法,它不需要事先标记好的训练数据,可以自动对数据进行聚类。

在商业领域,k-means 聚类法常常用于客户分级,通过对客户数据进行聚类,可以更好地了解客户裙体的特征和需求,从而为企业的营销和销售提供有力支持。

二、k-means 聚类法的原理k-means 聚类法的原理比较简单,主要包括以下几个步骤:1. 初始化 k 个聚类中心,可以随机选择数据集中的 k 个样本作为初始聚类中心。

2. 将数据集中的每个样本分配到距离最近的聚类中心所在的类别中。

3. 对每个类别内的样本计算新的聚类中心,即将该类别内所有样本的均值作为新的聚类中心。

4. 重复步骤 2 和 3,直到聚类中心不再发生变化或者变化小于一个设定的阈值。

通过上述步骤,k-means 聚类法可以将数据分成 k 个不同的类别,每个类别内的样本具有较高的相似度,在客户分级的场景中,可以根据客户的消费行为、偏好等特征,将客户分成不同的类别。

三、客户分级excel的步骤在实际操作中,我们可以使用 Excel 软件进行客户分级,以下是具体的步骤:1. 数据准备将客户的相关数据整理成一个表格,包括客户的消费金额、购物频次、地理位置等信息。

确保数据的准确性和完整性。

2. 导入数据在 Excel 中导入准备好的客户数据表格,点击“数据”选项卡,选择“从表格导入数据”,将数据导入到 Excel 软件中。

3. 聚类分析在 Excel 中选择“数据”选项卡,点击“数据分析”按钮,在弹出的对话框中选择“聚类”分析,然后选择“k-means 聚类法”。

4. 设置参数在弹出的设置界面中,选择要进行聚类的数据区域,并设置聚类的数量 k。

可以根据实际情况选择合适的聚类数量,通常可以通过绘制肘部法则图来确定最佳的聚类数量。

5. 进行聚类点击“确定”按钮,Excel 将会根据 k-means 聚类法对客户数据进行分组,并在新的工作表中展示聚类结果。

k-means参数详解K-Means 是一种常见的聚类算法,用于将数据集划分成K 个不同的组(簇),其中每个数据点属于与其最近的簇的成员。

K-Means 算法的参数包括聚类数K,初始化方法,迭代次数等。

以下是一些常见的K-Means 参数及其详细解释:1. 聚类数K (n_clusters):-说明:K-Means 算法需要预先指定聚类的数量K,即希望将数据分成的簇的个数。

-选择方法:通常通过领域知识、实际问题需求或通过尝试不同的K 值并使用评估指标(如轮廓系数)来确定。

2. 初始化方法(init):-说明:K-Means 需要初始的聚类中心点,初始化方法决定了这些初始中心点的放置方式。

-选择方法:常见的初始化方法包括"k-means++"(默认值,智能地选择初始中心点以加速收敛)和"random"(从数据中随机选择初始中心点)。

3. 最大迭代次数(max_iter):-说明:K-Means 算法是通过迭代优化来更新聚类中心的。

max_iter 参数定义了算法运行的最大迭代次数。

-调整方法:如果算法没有收敛,你可以尝试增加最大迭代次数。

4. 收敛阈值(tol):-说明:当两次迭代之间的聚类中心的变化小于阈值tol 时,算法被认为已经收敛。

-调整方法:如果算法在较少的迭代后就收敛,可以适度增加tol 以提高效率。

5. 随机种子(random_state):-说明:用于初始化算法的伪随机数生成器的种子。

指定相同的种子将使得多次运行具有相同的结果。

-调整方法:在调试和复现实验时,可以使用相同的随机种子。

这些参数通常是实现K-Means 算法时需要关注的主要参数。

在实际应用中,还可以根据数据的特性和问题的需求来选择合适的参数值。

通常,通过尝试不同的参数组合并使用评估指标(如轮廓系数)来评估聚类结果的质量。

k-means聚类算法研究及应用

K-means聚类算法研究及应用

一、简介

K-means聚类算法是一种非监督学习算法,它是一种广泛应用在模式分类和无监督式学习的数据挖掘技术。

它使用了基于距离的聚类算法,以相似性作为衡量子簇类别的标准,任务是将样本(属性)空间中的数据分为K个不同的类,使聚类的误差平方和最小化:通常假设样本由簇中心所处的子空间所构建,每个子空间由一个簇中心控制,因此K-means算法常常被形象地称为“均值聚类”算法。

二、原理

K-means聚类算法是一种迭代算法,它的基本思想是:首先,随机选取若干个“簇中心”,然后将其他的数据点根据其与“簇中心”的距离,归到最近的“簇中心”所代表的簇中。

然后根据新聚集的簇,重新更新这些“簇中心”;如此不断迭代,最终计算得到一组稳定的“簇中心”,这组“簇中心”所代表的簇就是最后的结果了。

三、应用

1、生物信息学:K-means聚类算法用于基因芯片和定量PCR,以及蛋白质表达数据。

2、计算机视觉:K-means用于图像分割,聚类,像素重新分配等。

3、自然语言处理:K-means用于文本聚类,文档分类,文本挖掘等方面。

4、机器学习:K-means用于各种拟合问题,比如参数估计,探索异常

值等等。

四、总结

K-means聚类算法是一种简单高效的聚类算法,它可以有效地将数据空间分割成几个簇,属于非监督学习算法,它的核心在于划分数据空间,对数据的模式分类和无监督式学习有较好的应用,如生物信息学、计

算机视觉、自然语言处理、机器学习等领域。

主题聚类算法主题聚类算法是一类用于将文本数据按照主题或话题进行分组的算法。

这些算法旨在通过分析文本中的词汇、语法和语境等特征,自动将文档划分为不同的主题群组。

以下是一些常见的主题聚类算法:1. K均值聚类(K-Means Clustering):这是一种常见的聚类算法,通过将数据点分配到 k 个簇中,使得每个数据点到其簇中心的距离最小化。

在文本聚类中,数据点可以是文档,而簇则对应于主题。

2. 层次聚类(Hierarchical Clustering):这种算法构建一个层次结构的簇,通过逐步合并或分裂簇,直到达到某个停止条件。

这样的方法可以形成一个层次树,使得用户可以根据需要选择不同层次的聚类结果。

3. 谱聚类(Spectral Clustering):这种方法通过利用数据的谱结构来进行聚类。

在文本聚类中,可以使用文本数据的词汇共现矩阵或 TF-IDF 矩阵,然后应用谱聚类算法来识别主题。

4. LDA(Latent Dirichlet Allocation): LDA 是一种概率主题模型,被广泛应用于文本数据的主题建模。

它假设每个文档是由多个主题混合而成的,每个主题又由多个词汇组成。

LDA 通过迭代推断来发现文档和主题之间的关系。

5. DBSCAN(Density-Based Spatial Clustering of Applications with Noise): DBSCAN 是一种基于密度的聚类算法,不仅可以处理球状簇,还可以发现任意形状的簇。

在文本聚类中,可以使用文本向量的密度信息来进行聚类。

6. NMF(Non-Negative Matrix Factorization): NMF 是一种矩阵分解方法,它可以应用于文本数据的主题建模。

NMF 假设文档矩阵是由两个非负矩阵的乘积组成,这两个矩阵分别对应于文档和主题。

这些算法可以根据具体任务的需求和数据特点来选择。

在实际应用中,通常需要根据数据的特点进行调参和优化。

K-means算法是一种常用的聚类分析方法,其应用场景广泛,包括数据挖掘、图像处理、文本分析等领域。

以下是一个简单的K-means算法应用实例,用于对一组二维数据进行聚类分析:

1.准备数据:首先,需要准备一组二维数据,这些数据可以是随机生成的,也

可以是从实际数据集中抽取的。

在本例中,我们使用随机生成的数据。

2.初始化聚类中心:选择K个初始聚类中心,这些中心点通常是随机选取的。

在本例中,我们选择三个初始中心点。

3.分配数据点到聚类中心:根据每个数据点到各个聚类中心的距离,将每个数

据点分配到最近的聚类中心所在的簇中。

在本例中,我们使用欧氏距离作为距离度量标准。

4.更新聚类中心:根据每个簇内所有数据点的平均值,重新计算每个簇的聚类

中心。

在本例中,我们计算每个簇内所有数据点的平均值,并将其作为新的聚类中心。

5.重复步骤3和4:重复步骤3和4,直到聚类中心不再发生变化或者达到预

设的迭代次数。

在本例中,我们迭代10次。

6.结果展示:最终得到的聚类结果可以通过图形化方式展示出来。

在本例中,

我们将每个簇用不同的颜色表示,并绘制出聚类结果图。

通过以上步骤,我们可以得到K-means算法的应用实例。

在实际应用中,需要根据具体的数据集和问题选择合适的参数和方法,并对结果进行合理的解释和分析。

kmean计算聚类中心点K-means是一种常用的聚类算法,用于将数据集分成多个类别,并找出每个类别的聚类中心点。

在本文中,我们将讨论K-means算法的原理、应用和优缺点。

一、K-means算法原理K-means算法是一种迭代的聚类算法,其基本步骤如下:1. 初始化:随机选择K个数据点作为初始聚类中心点。

2. 分类:将数据集中的每个数据点分配到与其最近的聚类中心点所属的类别。

3. 更新:根据每个类别中的数据点,重新计算聚类中心点的位置。

4. 重复步骤2和步骤3,直到聚类中心点的位置不再改变,或者达到预定的迭代次数。

二、K-means算法应用K-means算法在数据挖掘和机器学习领域被广泛应用,例如:1. 客户细分:根据客户的消费行为和偏好,将客户分成不同的群体,以便进行个性化的营销策略。

2. 图像压缩:通过将相似的像素点归为一类,用聚类中心点来代替这些像素点,从而实现图像的压缩。

3. 文本分类:将文本数据根据语义和主题进行分类,以便进行信息检索、情感分析等应用。

4. 基因表达谱聚类:将基因表达谱数据分成不同的基因簇,以便研究基因的功能和相互作用。

三、K-means算法优缺点K-means算法具有以下优点:1. 简单而高效:K-means算法的原理和实现都相对简单,计算效率较高。

2. 可解释性强:K-means算法的结果易于理解和解释,每个聚类中心点代表一个类别。

3. 可扩展性好:K-means算法适用于大规模的数据集,并且可以通过并行化和分布式计算来加速处理。

然而,K-means算法也存在一些缺点:1. 对初始聚类中心点敏感:初始聚类中心点的选择可能导致不同的聚类结果,需要多次运行算法来选择最佳结果。

2. 需要预先指定聚类数量:K-means算法需要事先确定聚类的数量K,而这个值可能不容易确定。

3. 对离群点敏感:离群点的存在可能会对聚类的结果产生较大的影响,导致聚类中心点偏离实际的数据分布。

k-means聚类算法简介k-means 算法是一种基于划分的聚类算法,它以k 为参数,把n 个数据对象分成k 个簇,使簇内具有较高的相似度,而簇间的相似度较低。

1. 基本思想k-means 算法是根据给定的n 个数据对象的数据集,构建k 个划分聚类的方法,每个划分聚类即为一个簇。

该方法将数据划分为n 个簇,每个簇至少有一个数据对象,每个数据对象必须属于而且只能属于一个簇。

同时要满足同一簇中的数据对象相似度高,不同簇中的数据对象相似度较小。

聚类相似度是利用各簇中对象的均值来进行计算的。

k-means 算法的处理流程如下。

首先,随机地选择k 个数据对象,每个数据对象代表一个簇中心,即选择k 个初始中心;对剩余的每个对象,根据其与各簇中心的相似度(距离),将它赋给与其最相似的簇中心对应的簇;然后重新计算每个簇中所有对象的平均值,作为新的簇中心。

不断重复以上这个过程,直到准则函数收敛,也就是簇中心不发生明显的变化。

通常采用均方差作为准则函数,即最小化每个点到最近簇中心的距离的平方和。

新的簇中心计算方法是计算该簇中所有对象的平均值,也就是分别对所有对象的各个维度的值求平均值,从而得到簇的中心点。

例如,一个簇包括以下 3 个数据对象{(6,4,8),(8,2,2),(4,6,2)},则这个簇的中心点就是((6+8+4)/3,(4+2+6)/3,(8+2+2)/3)=(6,4,4)。

k-means 算法使用距离来描述两个数据对象之间的相似度。

距离函数有明式距离、欧氏距离、马式距离和兰氏距离,最常用的是欧氏距离。

k-means 算法是当准则函数达到最优或者达到最大的迭代次数时即可终止。

当采用欧氏距离时,准则函数一般为最小化数据对象到其簇中心的距离的平方和,即。

其中,k 是簇的个数,是第i 个簇的中心点,dist(,x)为X 到的距离。

2. Spark MLlib 中的k-means 算法Spark MLlib 中的k-means 算法的实现类KMeans 具有以下参数。

如何进行高效的文本聚类和文本分类文本聚类和文本分类是自然语言处理中常见的任务,可以帮助我们理解和组织大量的文本数据。

下面我将从数据准备、特征提取和模型选择等方面介绍如何进行高效的文本聚类和文本分类。

一、数据准备1.收集文本数据:首先需要收集要进行聚类或分类的文本数据,可以通过网页爬虫、API接口或文本文件等方式进行数据收集。

2.数据清洗:对收集到的数据进行清洗,包括删除重复数据、去除噪声数据、处理缺失值等。

可以使用正则表达式、文本处理库等工具进行清洗操作。

3.数据预处理:对文本数据进行预处理,如分词、去除停用词、词形还原等。

可以使用分词工具(如jieba中文分词库)、停用词表和词干提取库等进行处理。

二、特征提取1.词袋模型(Bag of Words):将文本数据转换成向量表示,常用的方法是使用词袋模型。

将文本中的每个词作为一个特征,统计每个词在文本中的出现次数或者使用TF-IDF进行加权。

2. Word2Vec:将文本中的每个词映射为一个向量表示,可以通过Word2Vec等方法进行词向量训练。

可以使用预训练的词向量模型,也可以根据自己的数据训练词向量。

3.文本表示方法:除了词袋模型和词向量之外,还可以使用其他方法进行文本表示,如主题模型(如LDA)、句子向量(如doc2vec)等。

三、聚类方法1. K-means:K-means是一种常见的聚类算法,它将数据集分成K 个不同的簇。

可以使用sklearn中的KMeans实现,通过调节簇的个数K来进行聚类。

2.层次聚类:层次聚类将数据集组织成层次结构,可以根据距离或相似度进行聚类。

可以使用sklearn中的AgglomerativeClustering 实现。

3. DBSCAN:DBSCAN是一种基于密度的聚类算法,可以发现任意形状的簇。

可以使用sklearn中的DBSCAN实现。

四、分类方法1.朴素贝叶斯分类器:朴素贝叶斯分类器是一种简单而高效的分类算法,基于贝叶斯定理和特征条件独立假设。

Statistics and Application 统计学与应用, 2020, 9(2), 265-276Published Online April 2020 in Hans. /journal/sahttps:///10.12677/sa.2020.92029The Movie Content of K-Means ClusteringAnalysisLijuan YuanYunnan University of Finance and Economics, Kunming YunnanReceived: Mar. 26th, 2020; accepted: Apr. 10th, 2020; published: Apr. 17th, 2020AbstractWith the improvement of living standards, people’s spiritual life is becoming more and more co-lorful. As a part of people’s pursuit of spiritual culture and cultural innovation, film has become the focus of attention. In a fast-paced social environment, being able to choose your favorite movie in a short period of time is undoubtedly the best case. To improve the quality of people searching and selecting movies, one way is to categorize existing movies by theme. There are two ways to classify texts according to topics: supervised and unsupervised learning. Supervised learning re-quires manual labeling, which is very time-consuming and labor-intensive. Unsupervised learning can actively classify categories based on movie content, which not only saves time, but also reduc-es the economic consumption caused by manual labeling. Therefore, from the perspective of mov-ie content, this paper proposes to use K-Means clustering method to the unsupervised classifica-tion of movies. Finally, the classification results are visualized. In each category, movies have a common theme.KeywordsMovie Content, Topic Classification, Unsupervised Learning, K-Means Clustering基于电影内容的K-Means聚类分析袁丽娟云南财经大学,云南昆明收稿日期:2020年3月26日;录用日期:2020年4月10日;发布日期:2020年4月17日摘要随着生活水平的日益提高,人们的精神生活越来越丰富多彩。

k-means公式

k-means公式是一种聚类分析方法,它通过将数据集中的对象分配到若干个簇中来达到目的。

k-means公式的基本思想是:以随机选取的k个样本点为中心,将所有样本点依据距离这k个中心点的距离进行划分,形成k个簇,然后重新计算每个簇的中心点(也就是均值),再根据新的中心点重新划分每个样本点,如此反复迭代,直至所有样本点无法分配到更优的簇中,也就是说,当簇内的样本点之间的距离不能再减少时,停止迭代。

用数学公式表示,k-means公式就是求解使得簇内样本点之间距离最小的簇均值$\mu_1,\mu_2,...,\mu_k$,即:

$$\min_{\mu_1,\mu_2,...,\mu_k}\sum_{i=1}^n\sum_ {j=1}^k r_{ij}||x_i-\mu_j||^2$$

其中,$r_{ij}$表示样本点$x_i$被分配到簇$j$,$\mu_j$表示簇$j$的均值,$||x_i-\mu_j||^2$表示

$x_i$与$\mu_j$的距离的平方。

目录1 概念及应用背景 (1)1.1概念 (1)1.2应用背景................................................................................... 错误!未定义书签。

2 系统设计框架..................................................................................... 错误!未定义书签。

2.1总体框架................................................................................... 错误!未定义书签。

2.2文本聚类的具体过程 (1)3应用程序具体实现及说明 (3)3.1获取文档的输入....................................................................... 错误!未定义书签。

3.2提取文档的TF/IDF权重 (3)3.3 k-means进行数据聚类 (4)4 实验结果及分析................................................................................. 错误!未定义书签。

4.1实验结果................................................................................... 错误!未定义书签。

4.2结果分析................................................................................... 错误!未定义书签。

5结论...................................................................................................... 错误!未定义书签。

5.1实验结论................................................................................... 错误!未定义书签。

5.2个人感受................................................................................... 错误!未定义书签。

附录:项目框架和主程序代码............................................................. 错误!未定义书签。

1 概念及应用背景1.1概念文本聚类(Text clustering)是在没有学习的条件下对文本集合进行组织或划分的过程,其主要依据著名的聚类假设:同类的文档相似度较大,而不同类的文档相似度较小。

作为一种无监督的机器学习方法,聚类由于不需要训练过程,以及不需要预先对文档手工标注类别,因此具有一定的灵活性和较高的自动化处理能力,已经成为对文本信息进行有效地组织、摘要和导航的重要手段,为越来越多的研究人员所关注。

1.2文本聚类的具体过程1 文本信息的预处理文本聚类的首要问题是如何将文本内容表示成为数学上可分析处理的形式,即建立文本特征,以一定的特征项(如词条或描述)来代表目标文本信息。

要建立文本信息的文本特征,常用的方法是:对文本信息进行预处理(词性标注、语义标注),构建统计词典,对文本进行词条切分,完成文本信息的分词过程。

对于中文的处理,Lucene中文分词组件je-analysis.jar是个不错的包,其分词方法主要有以下两种:MMAnalyzer analyzer = new MMAnalyzer();//采用正向最大匹配的中文分词算法,相当于分词粒度等于0MMAnalyzer analyzer = new MMAnalyzer(int wordLength);//参数为分词粒度:当字数等于或超过该参数,且能成词时,该词就被切分出来2 文本信息特征的建立文本信息的特征表示模型有多种,常用的有布尔逻辑型、向量空间型、概率型以及混合型等。

其中,向量空间模型(Vector Space Model,VSM) 是近几年来应用较多且效果较好的方法之一。

1969 年,Gerard Salton 提出了向量空间模型VSM ,它是文档表示的一个统计模型。

该模型的主要思想是:将每一文档都映射为由一组规范化正交词条矢量张成的向量空间中的一个点。

对于所有的文档类和未知文档,都可以用此空间中的词条向量(T1 ,W 1 ,T 2 ,W2 ,…, Tn , Wn )来表示( 其中,Ti 为特征向量词条;Wi 为Ti 的权重)。

一般需要构造一个评价函数来表示词条权重,其计算的唯一准则就是要最大限度地区别不同文档。

这种向量空间模型的表示方法最大的优点在于将非结构化和半结构化的文本表示为向量形式,使得各种数学处理成为可能。

3 文本信息特征集的缩减VSM 将文本内容表示成数学上可分析处理的形式,但是存在的一个问题是文档特征向量具有惊人的维数。

因此,在对文本进行聚类处理之前,应对文本信息特征集进行缩减。

通常的方法是针对每个特征词条的权重排序,选取预定数目的最佳特征作为结果的特征子集。

选取的数目以及采用的评价函数都要针对具体问题来分析决定。

4 文本聚类在将文本内容表示成数学上可分析处理的形式后,接下来的工作就是在此数学形式的基础上,对文本进行聚类处理。

文本聚类主要有 2 种方法:基于概率[6] 和基于距离。

基于概率的方法以贝叶斯概率理论为基础,用概率的分布方式描述聚类结果。

基于距离的方法,就是以特征向量表示文档,将文档看成向量空间中的一个点,通过计算点之间的距离进行聚类。

目前,基于距离的文本聚类比较成熟的方法大致可以分为 2 种类型:层次凝聚法和平面划分法。

对于给定的文件集合D={d1, d2,…,di ,…, dn},层次凝聚法具体过程如下:(1) 将D中的每个文件di 看成一个具有单个成员的簇ci ={di}这些簇构成了D的一个聚类C={c1 ,c2 ,…,ci ,…,cn};(2) 计算C中每对簇(ci ,cj)之间的相似度sim{ci ,cj};(3) 选取具有最大相似度的簇对(ci ,cj)将ci和cj合并为一个新的簇ck =sim ci∪cj,从而构成了D的一个新的聚类C =(c1, c2,…,cn-1);(4) 重复上述步骤,直至C中剩下一个簇为止。

该过程构造出一棵生成树,其中包含了簇的层次信息以及所有簇内和簇间的相似度。

对于给定的文件集D={d1 , d2 ,…,di ,…, dn},平面划分法的具体过程如下:(1) 确定要生成簇的数目k;(2) 按照某种原则生成k个聚类中心作为聚类的种子S=(s1,s2,…,si,…,sk);(3) 对D中的每个文件di,依次计算它与各个种子sj的相似度sim (di,sj);(4) 选取具有最大相似度的种子,将di归入以sj为聚类中心的簇cj,从而得到D的一个聚类C={ci ,cj};(5) 重复此步骤若干次,以得到较为稳定的聚类结果。

这2种类型各有优缺点。

层次凝聚法能够生成层次化的嵌套簇,准确度较高。

但在每次合并时,需要全局地比较所有簇之间的相似度,并选出最佳的2个簇,因此执行速度较慢,不适合大量文件的集合。

而平面划分法相对来说速度较快,但是必须事先确定k 的取值,且种子选取的好坏对群集结果有较大影响。

2 k-means聚类方法原理计算两篇文档的相似度,最简单的做法就是用提取文档的TF/IDF权重,然后用余弦定理计算两个多维向量的距离。

能计算两个文本间的距离后,用标准的k-means算法就可以实现文本聚类了。

这里会用到TF/IDF权重,用余弦夹角计算文本相似度,用方差计算两个数据间欧式距离,用k-means进行数据聚类。

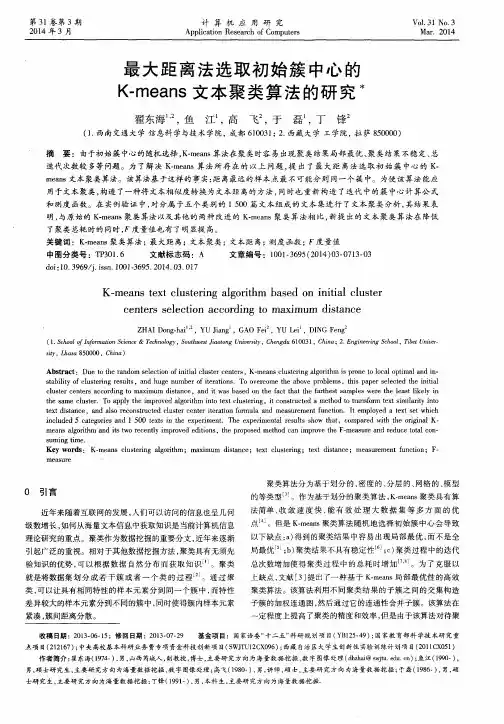

其具体实现过程为:图2-1 文本聚类具体实现过程2.1提取文档的TF/IDF权重TF-IDF(term frequency–inverse document frequency)的主要思想是:如果某个词或短语在一篇文章中出现的频率TF高,并且在其他文章中很少出现,则认为此词或者短语具有很好的类别区分能力,适合用来分类。

TFIDF实际上是:TF*IDF,TF词频(Term Frequency),IDF反文档频率(Inverse Document Frequency)。

TF表示词条t在文档d中出现的频率。

IDF的主要思想是:如果包含词条t的文档越少,IDF越大,则说明词条t具有很好的类别区分能力。

假如document1和document2的term的TF/IDF分别是t11,t12,t13,...t1n和t21,t22,t23,...,t2n.他们之间的相似性可以用余弦定理来表示。

则:cos(d1,d2) = d1和d2的内积/(d1的长度*d2的长度) = (t11*t21 + t12*t22 + t13*t23 + ... + t1n*t2n)/(|d1|*|d2|);d1 = sqrt(t11*t11 + t12*t12 + t13*t13 + ... + t1n*t1n)。

夹角越大,相似性越大;为1则表示d1和d2一致。

例如一篇文档文件的总词语数是100个,而词语“母牛”出现了3次,那么“母牛”一词在该文件中的词频就是0.03 (3/100)。

一个计算文件频率(DF) 的方法是测定有多少份文件出现过“母牛”一词,然后除以文件集里包含的文件总数。

所以,如果“母牛”一词在1,000份文件出现过,而文件总数是10,000,000份的话,其文件频率就是0.0001 (1000/10,000,000)。

最后,TF-IDF分数就可以由计算词频除以文件频率而得到。

以上面的例子来说,“母牛”一词在该文件集的TF- IDF分数会是300 (0.03/0.0001)。

下面简单介绍下基本的计算步骤:(1) 文档预处理:1)文档分词;2)移除停用词;3)单词正规化处理(2) 分出的单词作为索引项(或单词表),它们代表的就是向量空间的项向量(3) 计算项权值:这包括要计算1)词频;2)倒排文件频率;3)TF-IDF权值(4) 计算文档之间的相似度,用余弦相似度(cosine similarity)一同使用于向量空间模型中,用以判断两份文件之间的相似性。

这里将文档分词从其中提取文档的TF/IDF权重中分离出来,文档分词采用je-analysis-1.5.3.jar中的jeasy.analysis.MMAnalyzer类,该类需依赖于lucene2.4~2.9版本的包,使用方法很简单:MMAnalyzer mm = new MMAnalyzer();String result = mm.segment(str,splitor);// splitor是切词后各词组的分隔符,这里使用" "如文档内容为字符串"奥运拳击入场基本分邹市明夺冠对手浮出水面",则分词后的结果为"奥运拳击入场基本分邹市明夺冠对手浮出水面"。