k-means聚类算法的研究全解

- 格式:doc

- 大小:176.50 KB

- 文档页数:15

三维k-means聚类算法

在机器学习和数据挖掘领域,聚类是一种常见的数据分析技术,它通过将数据点分组成具有相似特征的簇来发现数据的内在结构。

而k-means算法是一种常用的聚类算法,它通过迭代的方式将数据

点分配到k个簇中,以最小化簇内的方差来实现聚类。

在三维空间中,数据通常具有更加复杂的特征和结构,因此传

统的二维k-means算法在处理三维数据时可能会面临一些挑战。

为

了解决这个问题,研究人员提出了三维k-means聚类算法,它是对

传统k-means算法的扩展,专门用于处理三维数据。

三维k-means聚类算法的核心思想与传统的k-means算法类似,都是通过迭代的方式不断优化簇的中心位置,以最小化簇内的方差。

然而,由于三维数据的特殊性,三维k-means算法在计算簇中心和

数据点之间的距离时需要考虑更多的因素,比如数据点在三个维度

上的坐标。

在实际应用中,三维k-means聚类算法可以被广泛应用于各种

领域,比如医学影像分析、气象数据分析、地质勘探等。

通过对三

维数据的聚类分析,可以帮助人们更好地理解数据的内在结构,发

现隐藏在数据中的规律和特征,为进一步的数据分析和应用提供有力的支持。

总之,三维k-means聚类算法是一种针对三维数据特点设计的聚类算法,它能够有效地处理三维数据,并在各种领域中发挥重要作用。

随着对三维数据分析需求的不断增加,相信三维k-means聚类算法将会得到更广泛的应用和进一步的发展。

kmeans算法原理K-Means算法,又叫k均值算法,是一种比较流行的数据聚类算法,它是一种迭代聚类算法,旨在将数据分为K个聚类,每个聚类具有最相似的数据点。

K-Means算法最初被使用于一些研究领域,例如音频处理和图像处理,但是在数据挖掘和机器学习领域中,K-Means 算法也被广泛使用,用于挖掘和识别隐藏的模式和结构,以及比较大型数据集的好处。

K-Means算法的基本原理K-Means算法是一种基于迭代的聚类算法,它利用距离公式将数据集分为k个不同的聚类,每个聚类具有最相似的数据点。

K-Means 算法的基本流程如下:(1)首先,确定数据集中簇的数量K。

(2)然后,将数据集中的每个数据点分配到K个不同的聚类。

(3)最后,按照每个聚类的平均值更新每个聚类的中心点,并将每个数据点根据距离新的聚类中心点的距离重新分配到新的聚类中。

K-Means算法的优点(1)K-Means算法的计算容易,它的时间复杂度较低,可以在大数据集上应用。

(2)可以用来快速对大型数据集进行聚类,可以轻松发现隐藏在数据中的模式和结构。

(3)K-Means算法也可以用来进行压缩,K-Means算法可以确定数据元素的聚类,从而减少数据集的大小。

(4)K-Means算法也可以用来发现预测模型,K-Means可以用来挖掘和识别隐藏的模式和结构,从而发现预测模型。

K-Means算法的缺点(1)K-Means算法为聚类选择的K值敏感,只有当K值适当时,K-Means算法才能得到最佳结果。

(2)K-Means算法在处理非球形数据集时效果不佳,K-Means算法会将数据分配到最近的聚类中心,但是对于非球形数据集来说,最近的聚类中心并不能很好的表示数据。

(3)K-Means算法在选择聚类中心的时候也有一定的局限性,K-Means算法选择的聚类中心受到初始值的影响,因此算法的结果受初始值的影响。

结论K-Means算法可以有效的将大型数据集分割成不同的聚类,是聚类分析中一种最常用的算法。

kmeans聚类算法原理与步骤K-means聚类算法原理与步骤K-means聚类算法是一种常用的无监督学习算法,用于将数据集划分成不同的类别。

该算法的原理和步骤如下:一、算法原理1. 初始化:选择K个初始的聚类中心点,可以是随机选择或者根据领域知识进行选择。

2. 数据分配:根据欧氏距离等度量方式,将每个样本点分配到与其最近的聚类中心点所代表的类别。

3. 聚类中心更新:根据当前分配的聚类结果,重新计算每个类别的聚类中心点。

4. 重复步骤2和步骤3,直到聚类中心点不再发生变化或达到预设的迭代次数。

5. 输出最终的聚类结果。

二、算法步骤1. 选择聚类的数量K:根据问题的具体要求和领域知识,确定聚类的数量K。

2. 初始化聚类中心点:从数据集中随机选择K个样本点作为初始的聚类中心点。

3. 计算样本点到聚类中心点的距离:对于每个样本点,计算其与各个聚类中心点之间的距离,常用的距离度量方式是欧氏距离。

4. 将样本点分配到最近的聚类中心点所代表的类别:将每个样本点分配到与其最近的聚类中心点所代表的类别,形成初始的聚类结果。

5. 更新聚类中心点:根据当前的聚类结果,重新计算每个类别的聚类中心点,通常是计算类别内样本点的均值。

6. 重复步骤3和步骤5,直到聚类中心点不再发生变化或达到预设的迭代次数。

如果聚类中心点不再发生变化,则算法收敛;如果达到预设的迭代次数,但聚类中心点仍在发生变化,则可以考虑增加迭代次数或调整聚类的数量K。

7. 输出聚类结果:将最终的聚类结果输出,每个样本点属于某个类别。

三、算法优缺点1. 优点:- K-means算法简单易实现,计算效率高。

- 对大规模数据集有较好的可扩展性。

- 聚类结果具有较好的可解释性。

2. 缺点:- 对初始聚类中心点的选择敏感,可能会得到不同的聚类结果。

- 对噪声和异常点较为敏感,可能会影响聚类结果的准确性。

- 需要提前确定聚类的数量K,如果选择不当可能会影响聚类结果。

K-means聚类算法的研究的开题报告一、选题背景K-means聚类算法是一种常用的聚类算法,它可以把数据分成K个簇,每个簇代表一个聚类中心。

该算法适用于大数据分析、图像分析等领域。

由于其具有简单、快速、效果明显等特点,因此备受研究者的关注。

二、研究意义K-means聚类算法在大数据分析、图像分析等领域的应用广泛,研究该算法有着十分重要的意义。

本次研究将对该算法进行探究,通过改进和优化算法,提高其聚类效果和运行效率,为实际应用提供更加可靠、有效的解决方案。

三、研究内容与方法本研究将围绕K-means聚类算法展开,重点探讨以下内容:1. K-means聚类算法原理及优缺点分析2. 基于距离的K-means聚类算法优化3. 基于密度的K-means聚类算法研究4. 算法的实现与效果评估在研究方法上,将采用文献调研、数学统计方法、算法实现和效果评估等多种方法对K-means聚类算法进行研究。

四、计划进度安排本研究总计时长为12周,具体进度安排如下:第1-2周:文献调研,研究K-means聚类算法的原理和优缺点分析第3-4周:基于距离的K-means聚类算法优化第5-6周:基于密度的K-means聚类算法研究第7-8周:算法实现第9-10周:效果评估第11-12周:论文撰写和答辩准备五、预期研究结果本研究将针对K-means聚类算法进行深入探究,并尝试改进和优化算法,提高其聚类效果和运行效率。

预期研究结果将包括以下几个方面:1.对该算法的优缺点进行全面分析,揭示其内在机制和局限性。

2.基于距离和密度两种方法对算法进行优化,提高其聚类效果和运行效率。

3.通过实验评估算法效果,得出具体的结论。

4.输出论文成果,向相关领域进行贡献。

六、研究的难点1.算法优化的设计,需要具备一定的数学和计算机知识。

2.实验的设计需要满足实际应用场景,需要有较强的应用能力。

3.研究过程中可能遇到一些技术难点,需要耐心解决。

七、可行性分析K-means聚类算法是广泛使用的算法之一,其研究具有实际意义和可行性。

k-means聚类算法研究及应用

K-means聚类算法研究及应用

一、简介

K-means聚类算法是一种非监督学习算法,它是一种广泛应用在模式分类和无监督式学习的数据挖掘技术。

它使用了基于距离的聚类算法,以相似性作为衡量子簇类别的标准,任务是将样本(属性)空间中的数据分为K个不同的类,使聚类的误差平方和最小化:通常假设样本由簇中心所处的子空间所构建,每个子空间由一个簇中心控制,因此K-means算法常常被形象地称为“均值聚类”算法。

二、原理

K-means聚类算法是一种迭代算法,它的基本思想是:首先,随机选取若干个“簇中心”,然后将其他的数据点根据其与“簇中心”的距离,归到最近的“簇中心”所代表的簇中。

然后根据新聚集的簇,重新更新这些“簇中心”;如此不断迭代,最终计算得到一组稳定的“簇中心”,这组“簇中心”所代表的簇就是最后的结果了。

三、应用

1、生物信息学:K-means聚类算法用于基因芯片和定量PCR,以及蛋白质表达数据。

2、计算机视觉:K-means用于图像分割,聚类,像素重新分配等。

3、自然语言处理:K-means用于文本聚类,文档分类,文本挖掘等方面。

4、机器学习:K-means用于各种拟合问题,比如参数估计,探索异常

值等等。

四、总结

K-means聚类算法是一种简单高效的聚类算法,它可以有效地将数据空间分割成几个簇,属于非监督学习算法,它的核心在于划分数据空间,对数据的模式分类和无监督式学习有较好的应用,如生物信息学、计

算机视觉、自然语言处理、机器学习等领域。

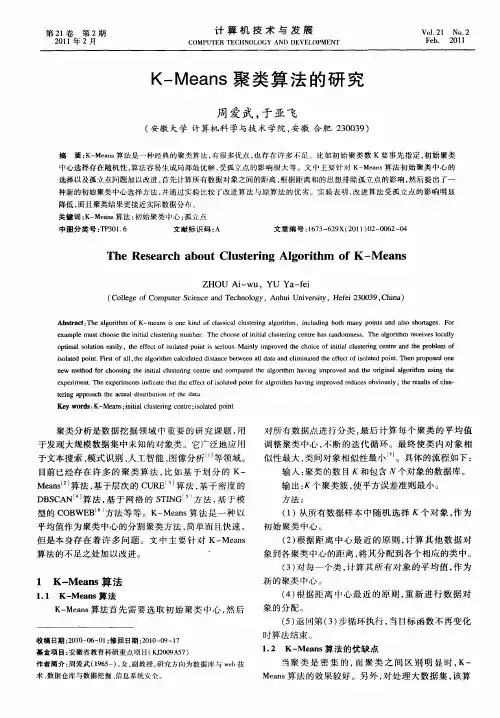

K-Means聚类算法的研究周爱武;于亚飞【摘要】The algorithm of K-means is one kind of classical clustering algorithm, including both many points and also shortages.For example must choose the initial clustering number.The choose of initial clustering centre has randomness.The algorithm receives locally optimal solution easily, the effect of isolated point is serious.Mainly improved the choice of initial clustering centre and the problem of isolated point.First of all ,the algorithm calculated distance between all data and eliminated the effect of isolated point.Then proposed one new method for choosing the initial clustering centre and compared the algorithm having improved and the original algorithm using the experiment.The experiments indicate that the effect of isolated point for algorithm having improved reduces obviously, the results of clustering approach the actual distribution of the data.%K-Means算法是一种经典的聚类算法,有很多优点,也存在许多不足.比如初始聚类数K要事先指定,初始聚类中心选择存在随机性,算法容易生成局部最优解,受孤立点的影响很大等.文中主要针对K-Means算法初始聚类中心的选择以及孤立点问题加以改进,首先计算所有数据对象之间的距离,根据距离和的思想排除孤立点的影响,然后提出了一种新的初始聚类中心选择方法,并通过实验比较了改进算法与原算法的优劣.实验表明,改进算法受孤立点的影响明显降低,而且聚类结果更接近实际数据分布.【期刊名称】《计算机技术与发展》【年(卷),期】2011(021)002【总页数】4页(P62-65)【关键词】K-Means算法;初始聚类中心;孤立点【作者】周爱武;于亚飞【作者单位】安徽大学,计算机科学与技术学院,安徽,合肥,230039;安徽大学,计算机科学与技术学院,安徽,合肥,230039【正文语种】中文【中图分类】TP301.6聚类分析是数据挖掘领域中重要的研究课题,用于发现大规模数据集中未知的对象类。

聚类算法研究聚类算法是一种无监督学习方法,用于将大量数据集划分为不同的组,每个组中的样本具有相似的特征或属性。

聚类算法在数据挖掘、模式识别、图像分析等领域有着广泛的应用。

K-means算法是最常用的聚类算法之一。

该算法将数据集划分为K个簇,其中每个簇通过计算簇内样本的均值来表示。

算法的步骤如下:1. 随机选择K个样本作为初始簇的中心点。

2. 对于每个样本,计算其到每个簇中心点的距离,并将其归类到距离最近的簇。

3. 更新簇的中心点,计算每个簇中样本的均值作为新的中心点。

4. 重复步骤2和步骤3,直到簇的中心点不再改变或者达到预定的迭代次数。

K-means算法简单易实现,但对初始簇中心点的选择较为敏感,也有可能陷入局部最优解。

此外,K-means算法假设每个样本点都属于某个簇,因此对于异常值或者噪声点的处理较为困难。

另一个常用的聚类算法是层次聚类算法。

该算法基于样本间的相似性或者距离,将样本逐步地合并为不同层次的簇。

层次聚类分为凝聚型和分裂型两种方法。

凝聚型层次聚类从每个样本作为一个初始簇开始,然后根据样本间的相似性逐步合并簇,直到达到预定的簇数或者合并停止的条件。

这种方法可以得到树状的簇结构,以便于进一步的数据分析和可视化。

分裂型层次聚类从将所有样本作为一个初始簇开始,然后根据样本间的相似性逐步分裂成多个簇,直到达到预定的簇数或者分裂停止的条件。

这种方法可以自底向上地构建簇结构,以便于区分不同层次的簇。

聚类算法在数据挖掘中有着广泛的应用,可以用于分析市场细分、用户行为、图像分析、语音识别等领域。

聚类算法可以帮助发现数据中的隐藏规律和模式,为决策和预测提供基础。

但同时也需要注意聚类结果的解释和评估,避免过于主观或者不准确的结果。

目录1. 问题描述 (2)2. 设计要求 (2)3. 需求分析 (3)4. 详细设计 (3)5. 测试及运行结果 (4)6. 程序源码及注释 (5)7. 课程设计心得体会 (15)1.问题描述k-means 算法是根据聚类中的均值进行聚类划分的聚类算法。

输入:聚类个数k ,以及包含n 个数据对象的数据。

输出:满足方差最小标准的k 个聚类。

处理流程:Step 1. 从n 个数据对象任意选择k 个对象作为初始聚类中心;Step 2. 循环Step 3到Step 4直到每个聚类不再发生变化为止;Step 3. 根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离,并根据最小距离重新对相应对象进行划分;Step 4. 重新计算每个(有变化)聚类的均值(中心对象)k-means 算法的工作过程说明如下:首先从n 个数据对象任意选择k 个对象作为初始聚类中心,而对于所剩下的其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类。

然后,再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值),不断重复这一过程直到标准测度函数开始收敛为止。

一般都采用均方差作为标准测度函数,具体定义如下:21∑∑=∈-=k i i i E C p m p (1)其中E 为数据库中所有对象的均方差之和,p 为代表对象的空间中的一个点,m i 为聚类C i 的均值(p 和m i 均是多维的)。

公式(1)所示的聚类标准,旨在使所获得的k 个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。

2.设计要求 首先从n 个数据对象任意选择 k 个对象作为初始聚类中心;而对于所剩下其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类;然 后再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值);不断重复这一过程直到标准测度函数开始收敛为止。

K-means聚类算法实验总结在本次实验中,我们深入研究了K-means聚类算法,对其原理、实现细节和优化方法进行了探讨。

K-means聚类是一种无监督学习方法,旨在将数据集划分为K个集群,使得同一集群内的数据点尽可能相似,不同集群的数据点尽可能不同。

实验步骤如下:1. 数据准备:选择合适的数据集,可以是二维平面上的点集、图像分割、文本聚类等。

本实验中,我们采用了二维平面上的随机点集作为示例数据。

2. 初始化:随机选择K个数据点作为初始聚类中心。

3. 迭代过程:对于每个数据点,根据其与聚类中心的距离,将其分配给最近的聚类中心所在的集群。

然后,重新计算每个集群的聚类中心,更新聚类中心的位置。

重复此过程直到聚类中心不再发生明显变化或达到预设的迭代次数。

4. 结果评估:通过计算不同指标(如轮廓系数、Davies-Bouldin指数等)来评估聚类效果。

实验结果如下:1. K-means聚类能够有效地将数据点划分为不同的集群。

通过不断迭代,聚类中心逐渐趋于稳定,同一集群内的数据点逐渐聚集在一起。

2. 在实验中,我们发现初始聚类中心的选择对最终的聚类结果有一定影响。

为了获得更好的聚类效果,可以采用多种初始聚类中心并选择最优结果。

3. 对于非凸数据集,K-means算法可能会陷入局部最优解,导致聚类效果不佳。

为了解决这一问题,可以考虑采用其他聚类算法,如DBSCAN、层次聚类等。

4. 在处理大规模数据集时,K-means算法的时间复杂度和空间复杂度较高,需要进行优化。

可以采用降维技术、近似算法等方法来提高算法的效率。

通过本次实验,我们深入了解了K-means聚类算法的原理和实现细节,掌握了其优缺点和适用场景。

在实际应用中,需要根据数据集的特点和需求选择合适的聚类算法,以达到最佳的聚类效果。

k-means聚类算法实验总结-回复K-means聚类算法是一种常用的无监督学习算法,广泛应用于数据挖掘、图像分割、文本分类等领域。

本文将基于我对K-means聚类算法的实验总结,分步详细介绍这一算法的原理、实验设置、实验结果及其分析。

希望通过本文的总结,读者能够对K-means算法有一个更全面的了解。

一、算法原理K-means聚类算法的原理比较简单,其基本步骤如下:1. 初始化k个聚类中心,可以是随机选择样本或根据经验预设;2. 对于每个样本,计算其与各个聚类中心的距离,并将其划分到距离最近的聚类中心所属的类别;3. 调整聚类中心的位置,将各个类别内的样本点的均值作为新的聚类中心,重复步骤2,直到聚类中心的位置不再变化或达到预设的最大迭代次数。

二、实验设置为了验证K-means聚类算法的性能,我选择了UCI机器学习库中的Iris 数据集作为实验数据集。

该数据集包含150个样本,每个样本有4个属性。

为了方便可视化,将数据集中的前两个属性作为横纵坐标,将样本点分布在二维平面上。

在实验中,我使用Python编程语言实现了K-means聚类算法,并使用matplotlib库绘制了聚类结果的散点图。

实验中设置聚类的类别数k为3,迭代次数上限为100。

三、实验结果及分析执行K-means聚类算法后,得到了如下图所示的聚类结果:[图1 聚类结果图]根据聚类结果可以看出,三个类别的样本点被分别用不同的颜色表示,并且通过散点图可以很直观地看到各个样本点与聚类中心的距离。

为了更客观地评估K-means的聚类性能,我采用了两项指标:聚类准确率和轮廓系数。

聚类准确率是将聚类结果与原始类别进行对比,计算分类正确的样本数量占总样本数量的比例。

通过计算实验结果,我得到了聚类准确率为85.33。

轮廓系数是一种评价聚类结果的衡量指标,其数值范围在-1到1之间,越接近于1表示聚类越紧密、样本点越相似,越接近于-1表示聚类越分散、样本点越不相似。

K -means 聚类算法研究综述摘要:总结评述了K -means 聚类算法的研究现状,指出K -means 聚类算法是一个NP 难优化问题,无法获得全局最优。

介绍了K -means 聚类算法的目标函数,算法流程,并列举了一个实例,指出了数据子集的数目K ,初始聚类中心选取,相似性度量和距离矩阵为K -means 聚类算法的3个基本参数。

总结了K -means 聚类算法存在的问题及其改进算法,指出了K -means 聚类的进一步研究方向。

关键词:K -means 聚类算法;NP 难优化问题;数据子集的数目K ;初始聚类中心选取;相似性度量和距离矩阵Review of K-means clustering algorithmAbstract: K-means clustering algorithm is reviewed. K-means clustering algorithm is a NP hard optimal problem and global optimal result cannot be reached. The goal , main steps and example of K-means clustering algorithm are introduced. K-means algorithm requires three user-specified parameters: number of clusters K , cluster initialization , and distance metric. Problems and improvement of K-means clustering algorithm are summarized then. Further study directions of K-means clustering algorithm are pointed at last.Key words: K-means clustering algorithm; NP hard optimal problem; number of clusters K; cluster initialization; distance metricK -means 聚类算法是由Steinhaus 1955年、Lloyed 1957年、Ball & Hall 1965年、McQueen 1967年分别在各自的不同的科学研究领域独立的提出。

Matlab中的聚类分析与聚类算法详解绪论数据分析是现代科学和工程领域中非常重要的一项技术。

随着互联网和物联网技术的发展,数据的规模和复杂度不断增加,数据分析越来越成为解决实际问题的关键。

聚类分析是一种常用的数据分析技术,它通过将数据样本划分成具有相似性的组或簇,从而揭示数据的内在结构和模式。

在Matlab中,聚类分析功能强大且易于使用,提供了多种聚类算法,如K-means、层次聚类等。

本文将详细介绍Matlab 中的聚类分析方法及其算法。

一、K-means算法K-means算法是聚类分析中最经典且最常用的算法之一。

它将数据样本划分成K个簇,并迭代地优化簇的中心,使得簇内的样本与簇中心的距离最小化。

在Matlab中,使用kmeans函数可以轻松实现K-means算法。

K-means算法的步骤如下:1. 随机选择K个样本作为初始的K个簇中心。

2. 计算每个样本与簇中心的距离,将样本分配到离其最近的簇。

3. 更新每个簇的中心,即计算簇内所有样本的平均值。

4. 重复步骤2和步骤3,直到簇中心不再变化或达到迭代次数。

K-means算法的优点是简单、高效,并且可以处理大规模数据。

但是,它对初始簇中心的选择敏感,容易陷入局部最优解。

二、层次聚类算法层次聚类算法是另一种常见的聚类分析方法。

它通过计算样本之间的相似性,逐步合并或划分样本,构建聚类层次结构。

在Matlab中,使用clusterdata函数可以实现层次聚类算法。

层次聚类算法的步骤如下:1. 将每个样本作为一个初始簇。

2. 计算任意两个簇之间的相似性,常用的相似性度量包括欧氏距离、相关系数等。

3. 合并相似性最高的两个簇,得到新的簇。

4. 重复步骤2和步骤3,直到所有样本被合并为一个簇或达到设定的簇数。

层次聚类算法的优点是可以得到聚类层次结构,方便分析和可视化。

然而,它对数据规模较大时计算复杂度较高。

三、谱聚类算法谱聚类算法是一种基于图论的聚类方法,在处理复杂数据时具有较好的性能。

聚类kmeans算法聚类kmeans算法是一种常用的数据挖掘算法,它利用机器学习技术进行分类,可以有效解决大数据环境中的数据挖掘问题。

这种算法具有较高的精度和准确性,因此被广泛应用于各种环境中。

k-means聚类算法的基本原理是将数据点分成K个聚类,每一个聚类都与聚类中心具有最短的距离,即该聚类中心所形成的簇是所有数据点中距离最近的。

k-means算法可以自动从原始输入数据中挖掘出有价值的信息,是进行数据聚类分析的有力工具。

k-means算法的核心是聚类中心的改变,它将数据分为K个类。

该算法的运行过程包括:(1)确定聚类中心;(2)将数据集分组;(3)求出每个聚类的损失函数;(4)设置停止迭代的条件。

在每一次迭代中,算法根据损失函数更新聚类中心,直到最优聚类中心出现或者聚类中心不再变化,聚类结果即被输出。

由于k-means算法的算法精度依赖于聚类中心的选择,因此先进的变体算法添加了许多改进措施来提高聚类的准确性,也增强了聚类中心的可靠性。

改进的k-means算法还可以避免聚类中心收敛所需时间的过长,从而使大规模数据示例聚类的效率提高。

此外,该算法对超参数的选择和调节提供了更多的灵活性,它可以更好地满足多种类型的实际应用需求。

目前,k-means聚类算法广泛应用于不同领域,如市场营销、推荐系统、影响力分析、社会网络分析、计算机视觉等。

通过使用k-means 算法,可以有效地进行分类,从而提取有价值的信息,提升数据处理的准确性和效率,节省人力成本。

然而,k-means算法也存在一些缺点。

首先,该算法的计算复杂度较高,且依赖于聚类中心的选取,容易出现局部最优解,从而导致聚类精度不高。

其次,由于k-means算法的归纳模型有一定的局限性,因此不能处理无界和多维数据集。

最后,该算法只适用于某些特定的场景,并不能满足所有数据挖掘应用中的要求。

未来,k-means算法仍然将受到更多的关注,未来的研究将继续改进该算法,提升其精度和效率,使之能更好地满足实际应用的要求。

《融合标签文本的k-means聚类和矩阵分解算法》篇一一、引言在当今的信息时代,随着互联网技术的快速发展,数据呈现出爆炸式增长。

面对海量的数据,如何有效地进行数据处理和挖掘,成为了研究的热点问题。

其中,文本数据是数据的重要组成部分,其处理和分析对于许多领域具有重要意义。

本文提出了一种融合标签文本的K-Means聚类和矩阵分解算法,旨在提高文本数据处理和分析的效率和准确性。

二、相关技术背景1. K-Means聚类算法:K-Means是一种常用的聚类算法,它通过计算数据点之间的相似性,将数据划分为K个不同的簇。

在文本数据挖掘中,K-Means可以用于对文本进行分类和聚类。

2. 矩阵分解算法:矩阵分解是一种常用的降维技术,可以将高维数据映射到低维空间。

在文本数据处理中,矩阵分解可以用于提取文本数据的特征,降低数据的维度。

3. 标签文本:标签文本是一种包含标签信息的文本数据,标签信息对于文本的处理和分析具有重要意义。

在本文中,我们利用标签信息对文本数据进行预处理和分类。

三、融合标签文本的K-Means聚类算法本文提出的融合标签文本的K-Means聚类算法,主要包含以下几个步骤:1. 数据预处理:首先对文本数据进行预处理,包括去除停用词、词干提取等操作,将文本数据转化为向量形式。

2. 标签提取:利用标签信息,提取出与文本数据相关的标签,为后续的聚类和矩阵分解提供依据。

3. K-Means聚类:根据提取出的标签信息和文本数据的向量表示,利用K-Means算法对文本数据进行聚类。

在聚类过程中,根据标签信息对聚类结果进行优化。

4. 结果评估:对聚类结果进行评估,采用轮廓系数等指标对聚类效果进行量化评估。

四、矩阵分解算法的应用在本文中,我们采用了非负矩阵分解(NMF)算法对文本数据进行处理。

NMF可以将高维的文本数据映射到低维空间,提取出文本数据的特征。

具体步骤如下:1. 数据矩阵构建:将预处理后的文本数据构建成数据矩阵。

k-means聚类算法的研究1.k-means算法简介1.1 k-means算法描述给定n个对象的数据集D和要生成的簇数目k,划分算法将对象组织划分为k个簇(k<=n),这些簇的形成旨在优化一个目标准则。

例如,基于距离的差异性函数,使得根据数据集的属性,在同一个簇中的对象是“相似的”,而不同簇中的对象是“相异的”。

划分聚类算法需要预先指定簇数目或簇中心,通过反复迭代运算,逐步降低目标函数的误差值,当目标函数收敛时,得到最终聚类结果。

这类方法分为基于质心的(Centroid-based)划分方法和基于中心的(Medoid-based)划分方法,而基于质心的划分方法是研究最多的算法,其中k-means算法是最具代表和知名的。

k-means算法是1967年由MacQueen首次提出的一种经典算法,经常用于数据挖掘和模式识别中,是一种无监督式的学习算法,其使用目的是对几何进行等价类的划分,即对一组具有相同数据结构的记录按某种分类准则进行分类,以获取若干个同类记录集。

k-means聚类是近年来数据挖掘学科的一个研究热点和重点,这主要是因为它广泛应用于地球科学、信息技术、决策科学、医学、行为学和商业智能等领域。

迄今为止,很多聚类任务都选择该算法。

k-means算法是应用最为广泛的聚类算法。

该算法以类中各样本的加权均值(成为质心)代表该类,只用于数字属性数据的聚类,算法有很清晰的几何和统计意义,但抗干扰性较差。

通常以各种样本与其质心欧几里德距离总和作为目标函数,也可将目标函数修改为各类中任意两点间欧几里德距离总和,这样既考虑了类的分散度也考虑了类的紧致度。

k-means算法是聚类分析中基于原型的划分聚类的应用算法。

如果将目标函数看成分布归一化混合模型的似然率对数,k-means算法就可以看成概率模型算法的推广。

k-means算法基本思想:(1)随机的选K个点作为聚类中心;(2)划分剩余的点;(3)迭代过程需要一个收敛准则,此次采用平均误差准则。

(4)求质心(作为中心);(5)不断求质心,直到不再发生变化时,就得到最终的聚类结果。

k-means聚类算法是一种广泛应用的聚类算法,计算速度快,资源消耗少,但是k-means算法与初始选择有关系,初始聚类中心选择的随机性决定了算法的有效性和聚类的精度,初始选择不一样,结果也不一样。

其缺陷是会陷于局部最优。

1.2 k-means算法实现步骤k-means聚类算法的处理流程如下:首先,随机选择k个对象,每个对象代表一个簇的初始均值或中心;对剩余的每个对象,根据其与各簇中心的距离,将它指派到最近(或最相似)的簇,然后计算每个簇的新均值,得到更新后的簇中心;不断重复,直到准则函数收敛。

通常,采用平方误差准则,即对于每个簇中的每个对象,求对象到其中心距离的平方和,这个准则试图生成的k个结果簇尽可能地紧凑和独立。

1.2.1 k-means聚类算法的形式化描述算法:k-means输入:聚类个数k,以及包含n个数据对象的数据库D输出:满足方差最小标准的k个聚类处理流程:Step1 从n个数据对象任意选择k个对象作为初始聚类中心;Step2 根据簇中对象的平均值,将每个对象重新赋给最类似的簇;Step3 更新簇的平均值,即计算每个簇中对象的平均值;Step4 循环Step2到Step3直到每个聚类不再发生变化为止。

1.2.2 k-means聚类算法的具体步骤1)Function k-means()2)输入:包含n个对象的数据集及簇的数目3)输出:k个簇的集合4)初始化k个簇中心{w1,w2,…,w k},其中w j= i l,j ∈{1,2,…,k},l ∈{1,2,…,n}5)使每一个聚类C j与簇中心w j中相对应6)repeat7)for每一个输入向量i l,其中l ∈{1,2,…,n } do8)将i l分配给最近的簇中心w j*所属的聚类C j*(即|i l—w j*|≦|i l—w j|),j ∈(1,2,…,k))9)for 每一个聚类C j,其中j ∈{1,2,…,k}10)将簇中心更新为当前的C j中所有样本的中心点,即|iwjlj cij lC∈∑=11)计算准则函数E12) Until E 不再明显地改变或者聚类的成员不再变化1.2.3 相关定义(1)两个数据对象间的距离:①明氏距离(Minkowski Distance )∑==p k x x x x d 11/qq jk ik j i )|-|(),( (公式1)这里的x i =( x i1,x i2,…,x ip )和x j =( x j1,x j2,…,x jp )是两个p 维的数据对象并且 i≠j 。

②欧式距离(Euclidean Distance )当明氏距离中q=2时,公式1即欧式距离。

∑==p k x x x x d 11/22jk ik j i )|-|(),( (公式2)③马氏距离(Mahalanobis Distance )p p ⨯=∑)(ij σ (公式3) 其中∑==nk x x x x n 1j k j i k i ij )-)(-(1-1σ,i ,j=1,2…,p 。

如果∑-1存在,则马氏距离为 ),(),(),(j i 1T j i j i 2x x x x x x d M -∑= (公式4)④兰式距离(Canberra Distance ):∑=+=p k L x x x x x x d 1jkik jk ik j i |-|p 1),( (公式5) (2)准则函数E对于K-means 算法,通常使用准则函数E ,也就是误差平方和(Sum of Squared Error ,SSE )作为度量聚类质量的目标函数。

∑∑=∈=ki C x i x d E 1i 2),(C (公式6)其中,d( )表示两个对象之间的距离,可以利用明氏、欧式、马氏或兰氏距离求得。

对于相同的k 值,更小的SSE 说明簇中对象越集中。

对于不同的k 值,越大的k 值应该越小的SSE 。

2.k-means 算法应用实例k-means 聚类广泛应用于地球科学、信息技术、决策科学、医学、行为学和商业智能等领域。

现以其在气象、遥感两个方面的应用为例,使用MATLAB语言编程,实现k-means算法的应用。

2.1 k-means算法应用实例(一)以我国主要城市2008年1~4月份的平均气温数据为基础,使用MATLAB语言编程,实现k-means算法。

2.1.1 算法代码(1)k-means算法主程序k=3;x =[ -3.0 0.6 9.1 15.8-3.6 -0.7 8.6 15.8-2.0 2.5 10.6 16.3-5.5 -3.3 7.1 13.1-12.1 -9.3 3.4 11.4-12.6 -7.9 3.8 12.2-15.6 -9.4 3.0 12.1-17.6 -10.5 2.7 11.34.2 4.0 11.4 15.91.52.5 11.3 15.63.7 3.9 12.7 17.11.02.7 12.5 16.811.0 9.1 15.3 19.33.5 5.5 14.6 18.7-2.0 1.0 10.3 16.3-0.7 2.8 12.1 16.91.2 4.9 14.4 18.52.3 5.5 15.2 18.912.8 11.6 20.1 23.29.4 10.4 19.1 22.916.9 13.3 20.9 25.36.27.3 15.5 19.03.7 5.4 13.4 17.21.02.2 11.8 15.710.7 8.5 13.7 18.01.5 1.4 5.6 10.1-1.7 1.8 12.5 16.4-6.6 -4.1 9.1 13.8-9.6 -7.9 3.4 8.3-10.2 -7.7 7.3 13.4-15.6 -9.6 5.2 11.1];[n,d] = size(x);bn=round(n/k*rand);%第一个随机数在前1/K的范围内nc=[x(bn,:);x(2*bn,:);x(3*bn,:)];%初始聚类中心for i=1:length(x),if cid(i)==1,plot(x(i,1),x(i,2),'r*') % 显示第一类hold onelseif cid(i)==2,plot(x(i,1),x(i,2),'b*') %显示第二类hold onelseif cid(i)==3,plot(x(i,1),x(i,2),'g*') %显示第三类hold onendendendendstrt=['红色*为第一类;蓝色*为第二类;绿色*为第三类' ];text(-4,-3.6,strt);(2)kmeans函数如下:%BasicKMeans.m主类function [cid,nr,centers] = kmeans(x,k,nc)[n,d] = size(x);% 设置cid为分类结果显示矩阵cid = zeros(1,n);% Make this different to get the loop started.oldcid = ones(1,n);% The number in each cluster.nr = zeros(1,k);% Set up maximum number of iterations.maxgn= 100;iter = 1;while iter < maxgn%计算每个数据到聚类中心的距离for i = 1:ndist = sum((repmat(x(i,:),k,1)-nc).^2,2);[m,ind] = min(dist); % 将当前聚类结果存入cid中cid(i) = ind;endfor i = 1:k%找到每一类的所有数据,计算他们的平均值,作为下次计算的聚类中心ind = find(cid==i);nc(i,:) = mean(x(ind,:));% 统计每一类的数据个数nr(i) = length(ind);endend% Now check each observation to see if the error can be minimized some more. % Loop through all points.maxiter = 2;iter = 1;move = 1;while iter < maxiter & move ~= 0move = 0;% 对所有的数据进行再次判断,寻求最佳聚类结果for i = 1:ndist = sum((repmat(x(i,:),k,1)-nc).^2,2);r = cid(i); % 将当前数据属于的类给rdadj = nr./(nr+1).*dist'; % 计算调整后的距离[m,ind] = min(dadj); % 早到该数据距哪个聚类中心最近if ind ~= r % 如果不等则聚类中心移动cid(i) = ind;%将新的聚类结果送给cidic = find(cid == ind);%重新计算调整当前类别的聚类中心nc(ind,:) = mean(x(ic,:));move = 1;endenditer = iter+1;endcenters = nc;if move == 0disp('No points were moved after the initial clustering procedure.')elsedisp('Some points were moved after the initial clustering procedure.')end2.1.2 使用数据2.1.3 分类效果及结果分析(1)聚类过程No points were moved after the initial clustering procedure.cid =Columns 1 through 182 2 2 1 1 1 1 1 2 2 2 23 2 2 2 2 2Columns 19 through 313 3 3 3 2 2 3 2 2 1 1 1 1nr =9 16 6centers =-11.7111 -7.7444 5.0000 11.85560.6625 2.8750 11.6313 16.375011.1667 10.0333 17.4333 21.2833(2)分类效果图图1 案例一效果图(3)分类结果分析在本案例中主要是对全国主要城市的气温进行k-means聚类分析,从而总结出不同地区相同时间段内气温变化的相似性和差异性。