卷积神经网络 ppt课件

- 格式:ppt

- 大小:451.00 KB

- 文档页数:23

![[课件]卷积神经网络CNNPPT](https://uimg.taocdn.com/ce758cf9a58da0116c174978.webp)

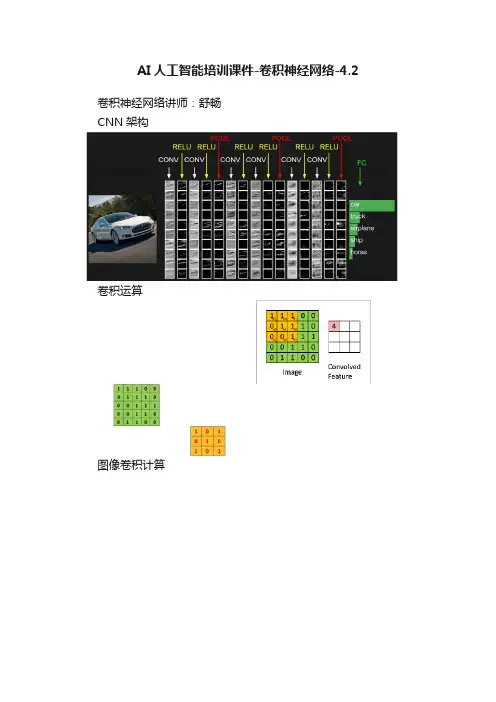

AI人工智能培训课件-卷积神经网络-4.2卷积神经网络讲师:舒畅CNN架构卷积运算图像卷积计算卷积层输出大小计算设图片大小为L*L,卷积核为k*k,步长stride为s,填充padding 为p,则卷积运算后输出的大小为O=(L-k+2*p)/s+1激活函数(relu)采用relu原因引入非线性函数作为激励函数,这样深层神经网络不再是输入的线性组合(原始感知机),可以逼近任意函数若采用sigmoid等函数,算激活函数时为指数运算,计算量大而采用Relu激活函数,整个过程的计算量减小对于深层网络,sigmoid函数反向传播时,很容易就会出现梯度消失的情况(在sigmoid接近饱和区时,变换太缓慢,导数趋于0,这种情况会造成信息丢失),从而无法完成深层网络的训练。

池化层全连接层Softmax分类器cat car frog 3.2 5.1 -1.7catcar frog Softmax函数Softmax分类器3.25.1-1.7catcarfrog Softmax 分类器3.2 5.1 -1.7 unnormalized log probabilities exp normalizeprobabilities L_i = -log(0.13) = 0.89 24.5 164.0 0.18 0.13 0.87 0.00 unnormalized probabilities交叉熵(cross entropy)信息量:假设X是一个离散型随机变量,其取值集合为χ,概率分布函数p(x)=P(X=x), x∈χ,则定义事件X=x0的信息量为:交叉熵:分类问题中的使用:MSE损失函数MSE(Mean Squared Error)m表示样本数量,loss为m个样本的loss均值技术成就梦想。