基于激光雷达和相机信息融合的目标检测及跟踪

- 格式:pdf

- 大小:2.87 MB

- 文档页数:11

相机和激光雷达联合标定方法

1. 你知道相机和激光雷达联合标定有多重要吗?就像给它们俩配了一把精准的钥匙!比如在自动驾驶中,让相机和激光雷达能默契配合,更好地识别路况。

2. 相机和激光雷达联合标定的方法之一,就是找到它们的最佳契合点呀!就好比给两个好朋友牵线搭桥,让他们合作无间。

就像无人配送中,它们的完美标定能让包裹准确送达呢!

3. 嘿,有没有想过如何巧妙地让相机和激光雷达联合标定呢?这就像是一场精妙的舞蹈编排!比如在智能安防领域,它们标定好了才能准确守护我们的安全呀。

4. 相机和激光雷达联合标定的这个过程,可不简单呢!就像打造一件精细的工艺品,需要耐心和技巧。

比如说在地图绘制中,精准的标定能让地图更加精确无误。

5. 哇哦,探索相机和激光雷达联合标定方法真的很有趣呢!就好像进入了一个神奇的科技世界。

在工业检测中,这样的标定能大大提高检测效率呀!

6. 难道你不想深入了解相机和激光雷达联合标定吗?这可是开启高科技大门的钥匙呢!像在航空航天中,它们的精确标定对任务成功至关重要。

7. 你看,相机和激光雷达联合标定的秘密就在这里啦!如同挖掘宝藏一样让人兴奋。

比如在智能家居中,能让家居系统更加智能贴心。

8. 哎呀呀,找到合适的相机和激光雷达联合标定方法太关键啦!简直就是让它们成为最佳搭档。

就像是在医疗领域,帮助医生更精准地诊断病情。

9. 相机和激光雷达联合标定真的超级重要啊!它们的完美结合能带来无数可能。

不管是哪个领域,这都是提升科技水平的关键呀!

结论:相机和激光雷达联合标定方法的探索和应用非常有意义,能为各个领域带来巨大的价值和进步。

深度相机和激光雷达数据融合的算法深度相机和激光雷达是两种常用的传感器,用于获取环境的三维信息。

深度相机可以通过红外光或结构光等方式获得场景中物体的距离信息,而激光雷达则通过发射激光束并测量其返回时间来得到物体的距离。

这两种传感器各自具有优势和局限性,因此将它们的数据融合起来可以提供更准确和鲁棒的三维感知结果。

本文将介绍深度相机和激光雷达数据融合的算法原理和方法。

深度相机和激光雷达数据融合的算法可以分为以下几个步骤:1.数据获取:首先,需要分别从深度相机和激光雷达中获取数据。

对于深度相机,可以使用其SDK或驱动程序获取每个像素点的深度值。

而对于激光雷达,可以通过发送激光束并记录其返回时间来获取点云数据。

2.数据预处理:获得深度图和点云数据后,需要进行一些预处理操作,以减少噪声和异常值的影响。

比如可以使用高斯滤波或中值滤波等滤波算法对深度图进行平滑处理,去除掉一些孤立的噪声点。

同时,还可以对点云数据进行降采样操作,以减少数据量和计算复杂度。

3.数据对齐:深度相机和激光雷达的坐标系通常不完全一致,因此需要进行数据对齐操作。

这可以通过将深度图的像素坐标映射到激光雷达坐标系中,或者将点云数据投影到深度图像素坐标中来实现。

对齐后的数据可以更方便地进行后续处理和分析。

4.物体识别和跟踪:融合深度相机和激光雷达数据之后,可以利用这些数据来进行物体识别和跟踪。

可以使用机器学习或深度学习的方法来训练分类器或目标检测器,从而实现对不同类别物体的识别。

同时,还可以使用点云信息来进行物体跟踪,比如利用点云的形状、运动等特征来进行目标跟踪。

5.地图构建和建模:融合深度相机和激光雷达数据还可以用于地图构建和环境建模。

可以使用SLAM(Simultaneous Localization and Mapping)算法来实时构建环境地图,并同时估计传感器的位置和姿态。

这可以在无人驾驶、机器人导航等应用中提供精确的定位信息。

6.融合算法:最后,需要将深度相机和激光雷达的数据融合起来,以得到更准确和完整的三维信息。

相机和激光雷达融合评价指标相机和激光雷达是两种常见的传感器技术,它们在自动驾驶、智能机器人和安防监控等领域有着广泛的应用。

相机主要通过图像采集来获取环境信息,而激光雷达则通过激光束扫描测量物体的距离和形状。

将相机和激光雷达融合可以充分利用它们的优势,提高环境感知的精度和可靠性。

在自动驾驶领域,相机和激光雷达的融合是实现环境感知的重要手段。

相机可以提供高分辨率的图像信息,可以用于识别和跟踪车辆、行人和道路标志等。

而激光雷达可以提供精确的距离和形状信息,可以用于建立精准的环境地图和障碍物检测。

将相机和激光雷达的数据进行融合,可以综合利用它们的优势,提高自动驾驶系统的感知能力和决策准确性。

相机和激光雷达的融合可以通过多种方法实现,常用的方法包括传统的传感器融合算法和深度学习算法。

传统的传感器融合算法主要基于概率统计理论,通过将相机和激光雷达的数据进行融合,得到更加准确和可靠的环境模型。

而深度学习算法则通过神经网络的训练和学习,自动从相机和激光雷达的数据中提取特征和信息,并进行融合。

这些算法可以提高环境感知的精度和鲁棒性。

相机和激光雷达的融合在智能机器人领域也有着广泛的应用。

相机可以用于物体识别和目标跟踪等任务,而激光雷达可以用于建立环境地图和导航规划。

将相机和激光雷达的数据进行融合,可以提高机器人的环境感知和导航能力,使其能够更加精确和安全地执行任务。

在安防监控领域,相机和激光雷达的融合可以提高监控系统的效果和可靠性。

相机可以用于人脸识别和行为分析等任务,而激光雷达可以用于精确的距离测量和运动检测。

将相机和激光雷达的数据进行融合,可以提高监控系统的准确性和实时性,更好地满足安防需求。

然而,相机和激光雷达的融合也面临一些挑战。

首先,相机和激光雷达的数据具有不同的特点和表示方式,如何有效地将它们进行融合是一个复杂的问题。

其次,相机和激光雷达的数据存在噪声和误差,如何准确地估计和校正这些误差也是一个难题。

此外,相机和激光雷达的融合还需要考虑实时性和计算复杂度等问题。

基于雷达成像的目标检测与跟踪算法研究近年来,雷达在目标检测与跟踪领域发挥了重要作用。

基于雷达成像的目标检测与跟踪算法研究旨在通过分析雷达数据,实现目标的准确检测和跟踪。

该算法具有无人机、自动驾驶汽车、安防监控等领域的广泛应用前景。

1. 引言目标检测与跟踪是计算机视觉和图像处理领域的重要问题。

雷达成像技术通过发射无线电信号,接收并处理其反射回来的信号,从而实现对目标的探测和跟踪。

相比传统的视觉成像技术,雷达成像具有强大的穿透能力,能够在各种复杂环境下实现目标的检测与跟踪。

2. 雷达目标检测算法雷达目标检测算法主要分为两类:基于经典机器学习的方法和基于深度学习的方法。

基于经典机器学习的方法包括常见的滤波算法、线性判别分析、支持向量机等,并采用特征提取和分类器构建的方式进行目标检测。

而基于深度学习的方法主要使用卷积神经网络(CNN)进行特征提取和分类任务。

这两种方法在不同的场景下都能取得较好的效果。

3. 雷达目标跟踪算法雷达目标跟踪算法是在目标检测的基础上,通过分析连续帧之间的目标位置和特征变化,预测目标的未来位置。

目前常用的雷达目标跟踪算法包括卡尔曼滤波器、粒子滤波器、相关滤波器等。

这些算法通过对目标的运动进行建模,并利用观测数据进行状态估计,实现目标的准确跟踪。

4. 雷达目标检测与跟踪融合算法为了提高目标检测与跟踪的准确性和稳定性,研究者们提出了一系列的融合算法。

融合算法将目标检测和目标跟踪的结果进行信息交互,从而实现对目标的更加准确地检测和跟踪。

常见的融合算法包括多目标跟踪、多传感器数据融合等。

这些算法能够充分利用多来源的信息,提高目标的识别和跟踪效果。

5. 算法评估与挑战对于雷达目标检测与跟踪算法的评估主要包括准确率、召回率、速度等指标。

主流的评估数据集有IRMAS、Kitti、Apollo等。

此外,雷达目标检测与跟踪算法还面临一些挑战,如目标遮挡、多目标追踪、检测与跟踪时延等。

未来的研究中应该解决这些挑战,并提出更加准确和稳定的算法。

深度相机和激光雷达数据融合的算法实现介绍全文共四篇示例,供读者参考第一篇示例:深度相机和激光雷达是两种常见的感知设备,它们在自动驾驶、机器人导航、三维环境重建等领域起着至关重要的作用。

深度相机可以提供准确的RGB-D图像,而激光雷达则可以提供高精度的点云数据。

将这两种传感器的数据融合在一起,可以提高感知系统的鲁棒性和准确性。

本文将介绍深度相机和激光雷达数据融合的算法实现。

一、数据获取与预处理深度相机和激光雷达通常以不同的频率和分辨率采集数据,在进行融合之前,需要将它们的数据对齐和校准。

将深度相机获取的RGB-D图像和激光雷达获取的点云数据转换到同一个坐标系中。

然后,根据两种数据的特点(例如分辨率、精度)对其进行预处理,例如去除噪声、滤波、尺度对齐等操作。

二、数据融合算法数据融合算法主要包括传感器融合和特征融合两种方法。

1. 传感器融合传感器融合是将深度相机和激光雷达的数据直接融合在一起。

常见的方法包括投影和拼接。

投影是将点云数据投影到RGB-D图像上,得到一个混合的点云图像。

拼接是将RGB-D图像和点云数据拼接到一起,得到一个新的混合图像。

传感器融合可以提高数据的完整性和丰富性。

2. 特征融合特征融合是将深度相机和激光雷达的特征数据融合在一起,例如特征点、边缘、平面等。

常见的方法包括特征匹配、特征插值、特征融合等。

特征融合可以提高数据的稳定性和准确性。

三、实现与优化在实际应用中,数据融合算法需要考虑实时性和准确性。

一方面,需要考虑算法的复杂度和计算性能,保证算法能够在实时场景下运行。

需要不断优化算法,提高数据的精度和稳定性。

常见的优化方法包括深度学习、SLAM、稀疏优化等。

总结深度相机和激光雷达数据融合是一项复杂而重要的技术,在自动驾驶、机器人导航等领域有着广泛的应用前景。

通过合理的数据获取、预处理、融合算法、实现与优化,可以更好地利用深度相机和激光雷达的优势,提高感知系统的性能和稳定性。

希望本文对数据融合算法的介绍有所帮助,同时也希望读者能够在实践中不断探索和创新,为深度相机和激光雷达数据融合技术的发展贡献自己的力量。

激光雷达与相机融合(六)-------⽬标检测与跟踪ros实时版本部分中,将之前的优达学城的整套⽬标检测与跟踪算法改写为ros实时处理,但改写完成后利⽤我现有的数据包实时检测跟踪,并计算TTC,发现效果不尽⼈意啊。

算法的鲁棒性整体较差,环境稍微复杂⼀点计算的碰撞时间就有问题,甚⾄为负值。

另外在实际运⾏时,还会时不时出现core dumped内存泄漏的问题,不知道是哪⾥写的有问题,有同学发现错误欢迎留⾔交流,万分感谢。

⼤概讲解⼀下整套算法结构。

1.整体框架这⼀部分的代码被我改写为⼀个ros package的形式,包名为ros_detection_tracking,包下有两个节点-----ros_ttc和project,project节点在上⼀个博客中已经详细解释了。

在这个包中Cmakelist.txt⽂件中project的部分被我注释了,需要运⾏的朋友可以⾃⾏找到下列⼏⾏取消注释,编译就可以运⾏project节点了。

#add_executable(projector src/project/project.cpp)#target_link_libraries(projector ${catkin_LIBRARIES}# ${OpenCV_LIBS})#add_dependencies(projector ${${PROJECT_NAME}_EXPORTED_TARGETS} ${catkin_EXPORTED_TARGETS})主要的头⽂件存放在⽬录include下,源程序存放在src/ros_ttc⽬录下,配置⽂件放置在cfg⽬录下,YOLO的相关配置和权重⽂件放置在dat/yolo⽬录下。

2.主要函数写成了⼀个节点实现,⽅法简单粗暴,该节点的主体加上构造函数就只有三个函数。

分别是主要的回调函数、参数加载函数、以及初始化构造函数。

void detectandtrack_callback(const sensor_msgs::Image::ConstPtr &img,const sensor_msgs::PointCloud2::ConstPtr &pc);void initParams();DetectandTrack();当然,绝⼤部分的调⽤到的函数都在其余的源⽂件中。

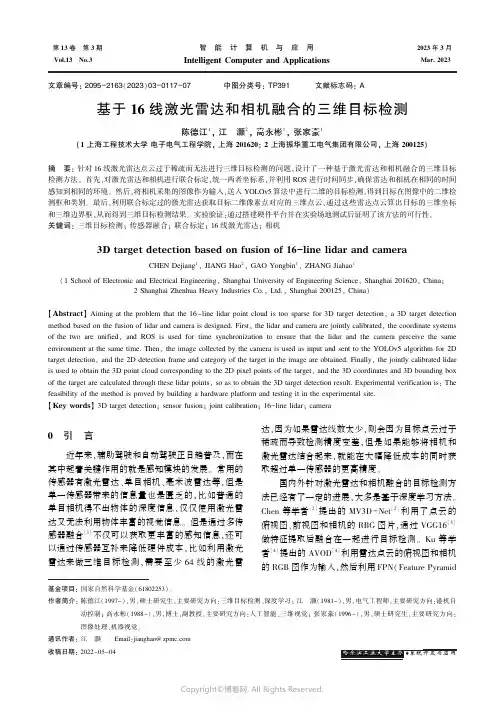

第13卷㊀第3期Vol.13No.3㊀㊀智㊀能㊀计㊀算㊀机㊀与㊀应㊀用IntelligentComputerandApplications㊀㊀2023年3月㊀Mar.2023㊀㊀㊀㊀㊀㊀文章编号:2095-2163(2023)03-0117-07中图分类号:TP391文献标志码:A基于16线激光雷达和相机融合的三维目标检测陈德江1,江㊀灏2,高永彬1,张家豪1(1上海工程技术大学电子电气工程学院,上海201620;2上海振华重工电气集团有限公司,上海200125)摘㊀要:针对16线激光雷达点云过于稀疏而无法进行三维目标检测的问题,设计了一种基于激光雷达和相机融合的三维目标检测方法㊂首先,对激光雷达和相机进行联合标定,统一两者坐标系,并利用ROS进行时间同步,确保雷达和相机在相同的时间感知到相同的环境㊂然后,将相机采集的图像作为输入,送入YOLOv5算法中进行二维的目标检测,得到目标在图像中的二维检测框和类别㊂最后,利用联合标定过的激光雷达获取目标二维像素点对应的三维点云,通过这些雷达点云算出目标的三维坐标和三维边界框,从而得到三维目标检测结果㊂实验验证:通过搭建硬件平台并在实验场地测试后证明了该方法的可行性㊂关键词:三维目标检测;传感器融合;联合标定;16线激光雷达;相机3Dtargetdetectionbasedonfusionof16-linelidarandcameraCHENDejiang1,JIANGHao2,GAOYongbin1,ZHANGJiahao1(1SchoolofElectronicandElectricalEngineering,ShanghaiUniversityofEngineeringScience,Shanghai201620,China;2ShanghaiZhenhuaHeavyIndustriesCo.,Ltd.,Shanghai200125,China)ʌAbstractɔAimingattheproblemthatthe16-linelidarpointcloudistoosparsefor3Dtargetdetection,a3Dtargetdetectionmethodbasedonthefusionoflidarandcameraisdesigned.First,thelidarandcameraarejointlycalibrated,thecoordinatesystemsofthetwoareunified,andROSisusedfortimesynchronizationtoensurethatthelidarandthecameraperceivethesameenvironmentatthesametime.Then,theimagecollectedbythecameraisusedasinputandsenttotheYOLOv5algorithmfor2Dtargetdetection,andthe2Ddetectionframeandcategoryofthetargetintheimageareobtained.Finally,thejointlycalibratedlidarisusedtoobtainthe3Dpointcloudcorrespondingtothe2Dpixelpointsofthetarget,andthe3Dcoordinatesand3Dboundingboxofthetargetarecalculatedthroughtheselidarpoints,soastoobtainthe3Dtargetdetectionresult.Experimentalverificationis:Thefeasibilityofthemethodisprovedbybuildingahardwareplatformandtestingitintheexperimentalsite.ʌKeywordsɔ3Dtargetdetection;sensorfusion;jointcalibration;16-linelidar;camera基金项目:国家自然科学基金(61802253)㊂作者简介:陈德江(1997-),男,硕士研究生,主要研究方向:三维目标检测㊁深度学习;江㊀灏(1981-),男,电气工程师,主要研究方向:港机自动控制;高永彬(1988-),男,博士,副教授,主要研究方向:人工智能㊁三维视觉;张家豪(1996-),男,硕士研究生,主要研究方向:图像处理㊁机器视觉㊂通讯作者:江㊀灏㊀㊀Email:jianghao@zpmc.com收稿日期:2022-05-040㊀引㊀言近年来,辅助驾驶和自动驾驶正日趋普及,而在其中起着关键作用的就是感知模块的发展㊂常用的传感器有激光雷达㊁单目相机㊁毫米波雷达等,但是单一传感器带来的信息量也是匮乏的,比如普通的单目相机得不出物体的深度信息,仅仅使用激光雷达又无法利用物体丰富的视觉信息㊂但是通过多传感器融合[1]不仅可以获取更丰富的感知信息,还可以通过传感器互补来降低硬件成本,比如利用激光雷达来做三维目标检测,需要至少64线的激光雷达,因为如果雷达线数太少,则会因为目标点云过于稀疏而导致检测精度变差,但是如果能够将相机和激光雷达结合起来,就能在大幅降低成本的同时获取超过单一传感器的更高精度㊂国内外针对激光雷达和相机融合的目标检测方法已经有了一定的进展,大多是基于深度学习方法㊂Chen等学者[2]提出的MV3D-Net[2]利用了点云的俯视图㊁前视图和相机的RBG图片,通过VGG16[3]做特征提取后融合在一起进行目标检测㊂Ku等学者[4]提出的AVOD[4]利用雷达点云的俯视图和相机的RGB图作为输入,然后利用FPN(FeaturePyramidNetwork)进行特征提取,同样获得了精确的检测结果㊂Qi等学者[5]提出的Frustum-PointNet先利用RGB图像中目标的二维边界框进行点云预处理,将对应的雷达点云分离出来,然后将这些属于对应目标的点云输入到PointNet[6]中进行特征提取,从而回归出三维目标检测结果㊂但是这些方法都是依赖于64线的激光雷达,当前64线的激光雷达价格昂贵,对于一些大型车辆,如轮胎吊大车㊁重型卡车等,如果想要激光雷达全覆盖,就需要至少2 4个激光雷达,这将带来昂贵的安装成本㊂本文考虑到64线激光雷达的局限性,基于16线激光雷达和相机两种传感器,设计了一种三维目标检测方法㊂首先,将雷达和相机进行空间和时间上的联合标定,获取相互间的刚体变换矩阵,通过刚体变换统一坐标系后再将雷达点云按照相机的内参矩阵投影到图片上,获取二维像素点和三维雷达点云之间的对应关系㊂然后,将相机图片送入YOLOv5算法进行二维目标检测[7],得出目标的二维像素范围,利用联合标定过的雷达获取这些二维像素对应的三维点云,最后利用这些三维点云算出目标的三维坐标和边界框㊂通过实际场景测试证明了该方法的可行性㊂1㊀硬件平台的搭建和标定硬件的合理安装和精准标定是算法有效运行的基础,本文设计的实验平台如图1所示㊂图1中,左侧为16激光雷达,右侧为球形相机,中间通过钢架进行固定㊂因为雷达内包含转子,在雷达运行的过程中会产生较强的晃动,所以必须做好固定措施㊂为了能够适应室外天气,采用带球罩的相机,方便遮风挡雨,而且能够自由调整方向,但是球形相机畸变较为严重,所以需要做好相机的标定工作[8]㊂在进行相机标定时,需要采集各个角度的标定板图片再进行标定,这样标定出的相机内参更精确㊂ZZXXYY相机激光雷达图1㊀硬件平台设计图Fig.1㊀Hardwareplatformdesigndiagram㊀㊀多传感器融合除了进行空间上的同步,还需要进行时间上的同步㊂空间上的同步即多传感器联合标定统一坐标系,时间上的同步是指同步传感器获取数据的时间戳,保证2个传感器是在相同的时间感知到同样的物体㊂1.1㊀激光雷达和相机的联合标定激光雷达和相机有着各自的坐标系[9],参见图1中的坐标轴㊂其中,激光雷达的X轴朝前,Y轴朝左,Z轴朝上㊂相机的X轴朝右,Y轴朝下,Z轴朝前,需要通过联合标定的方式算出2个坐标系之间的刚体变换矩阵㊂刚体变换的公式为:RPl+t=Pc(1)㊀㊀其中,R为3ˑ3的旋转矩阵;t为3ˑ1的平移向量;Pl为激光雷达下物体的坐标;Pc为相机坐标系下物体的坐标㊂本文采用的多传感器联合标定原理是让2个传感器同时感知到相同的三维点,这些物体在不同的传感器里有各自的坐标,可以通过多组对应点构成方程组,但是这些点在数据采集时不一定是绝对精准的,可能会因为各种原因产生误差,所以不存在绝对解,而是存在一个近似的最优解,让标定后的传感器感知误差最小,误差表达方式为:err=ðNi=1RPli+t-Pci 2(2)㊀㊀故而可以采用类似求解点云配准的方式利用SVD解出2个传感器之间的刚体变换,其中旋转矩阵R的求解方法为:H=(A-centroidA)(B-centroidB)T[U,S,V]=SVD(H)R=VUT(3)㊀㊀其中,A为激光雷达在激光雷达的坐标系中感受到的一组点;B为相机在相机坐标系中感受到的同一组点;centroid为对应点群的中心㊂求解出R后就可以进一步求出t,求解方式见下式:RˑA+t=BRˑcentroidA+t=centroidBt=centroidB-RˑcentroidA(4)㊀㊀求解出旋转矩阵R和平移向量t后,就可以直接将雷达的坐标系直接转换到相机的坐标系,这时雷达扫描出的点云在经过变换后将处于相机的坐标系中㊂1.2㊀激光雷达和相机的时间同步不同种类的传感器运行频率也并不相同,相机在25Hz左右,激光雷达在20Hz左右㊂传感器除了扫描频率,数据传输速率也不一样,所以相同时间811智㊀能㊀计㊀算㊀机㊀与㊀应㊀用㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第13卷㊀发生的事情从传感器到达计算机的时间很可能并不一致,数据存在时间错位,如图2所示,所以需要给传感器产生的数据打上时间戳,并且采用合理的同步算法进行数据同步㊂时间轴激光雷达点云相机图片(a )正常的顺序(b )不正常的顺序激光雷达点云相机图片图2㊀传感器数据同步Fig.2㊀Sensordatasynchronization㊀㊀本文采取的方式是利用ROS中的MessageFilters进行时间同步㊂ROS是最常用的机器人操作系统之一,将传感器数据抽象成Topic进行数据的发布和订阅,并通过消息队列的方式对数据进行缓存㊂MessageFilters同时订阅激光雷达驱动和相机驱动发布的Topic,但只有在两者时间戳满足时间差要求时才会触发回调函数对传感器数据进行处理,而过期或者时间戳相差较大的数据则会舍弃掉㊂这样就可以保证雷达和相机是在相同的时间感知到相同的环境㊂2㊀算法实现本文主要应用场景是基于激光雷达和相机两种传感器融合起来在大车前进的车道线内进行三维目标检测,将检测的结果反馈给大车的控制中心㊂通过相机进行车道线检测和二维目标识别,并通过雷达赋予目标三维信息,从而得到目标的三维坐标和边界框,对具体算法实现流程,可给出研究论述如下㊂2.1㊀车道线检测本文针对车道线内的兴趣区域进行目标检测,所以先通过相机进行车道线检测㊂当前对于车道线检测已经有了很多有效的方法,但是大多基于深度学习的方式,相对复杂㊂而本文场景中的车道线具有一定的规律,不存在弯曲的部分,所以可以通过霍夫变换算法进行车道线提取[10],算法流程如图3所示㊂㊀㊀图3中,通过相机采集到的RGB格式的图片为图3(a),然后将图片从RGB域转到HSV域得到图片㊁即图3(b),进行转换主要是为了根据可行驶区域的颜色过滤出可能是车道线的部分,有助于排除干扰信息㊂在本算法中,过滤条件为[H,S,V]的数值介于[20,60,30]和[40,200,255]之间,阈值设置范围相对较广能够保证算法在各种光照下的检测鲁棒性㊂接下来再通过Gassian平滑滤波和Candy滤波得到可能是车道线的轮廓图㊁见图3(c),根据得到的轮廓图使用霍夫变换算法,对轮廓图中的直线进行检测,直到找到所有的直线㊂由于找到的直线不一定属于车道线,需要根据直线的长短㊁斜率等信息进行分类㊂在这里,先使用K-means聚类算法将直线分为2类,一类属于左侧车道线,一类属于右侧车道线,最后再根据左㊁右侧车道线的斜率特征做进一步过滤㊂将两侧车道线的集合取均值就得到了完整的车道线表达式,处理后的车道线检测效果见图3(d)㊂(a )相机原图(b )H S V 域转换(d )H o u g h 变换(c )滤波去噪图3㊀车道线检测算法流程Fig.3㊀Lanedetectionalgorithmflowchart2.2㊀二维目标检测确定兴趣区域后,再检测兴趣区域内的目标,本文需要精度高㊁运行速度快的二维目标检测算法㊂YOLO系列是具有高性能的二维目标检测算法,本文采用最新版本的YOLOv5㊂YOLOv5实现了端到端的目标检测,输入图片即可输出检测结果,检测精度高㊁且检测速度快㊂YOLOv5的算法网络结构[11]如图4所示㊂㊀㊀图4中,主要包括骨干网络㊁颈部网络和检测头㊂骨干网络通过CSPNet结构减少GPU显存占用,避免重复的梯度信息,加速模型训练和运行,让模型更加轻量和高效,其检测效果如图5所示㊂除了较高的检测精度和极快的运行速度,YOLOv5本身基于COCO[12]数据集进行训练,有着丰富的检测种类和预训练模型,本文的应用场景主要检测人㊁汽911第3期陈德江,等:基于16线激光雷达和相机融合的三维目标检测车和卡车三种目标,这3类目标现已存在于预训练模型的检测范围中㊂针对部分车辆分类不准确的问题,通过采集和定制当前场景下的数据集,基于预训练模型还可以做进一步的优化与完善,提升准确率㊂B o t t l e N e c kC S P B o t t l e N e c k C S P C o n v 1?1C o n v 1?1C o n v 1?1B o t t l e N e c kC S PC o n v 3?3S 2C o n c a tB o t t l e N e c kC S P C o n v 3?3S 2C o n c a tC o n v 1?1U p S a m p l e C o n c a t B o t t l e N e c k C S PC o n v 1?1U p S a m p l e C o n c a tB o t t l e N e c kC S P B o t t l e N e c k C S PS P P C S P S P PC o n v C o n c a t C r o s s S t a g e P a r t i a l N e t w o r k S p a t i a l P y r a m i d P o o l i n gC o n v o l u t i o n a l L a y e rCo n c a t e n a t e F u n c t i o n B a c k b o n e :C S P D a r k n e t N e c k :P A N e tH e a d :Y o l o L a y e r图4㊀YOLOv5网络结构图Fig.4㊀YOLOv5networkstructurediagram(a)行人检测㊀㊀㊀㊀㊀㊀㊀(b)汽车检测图5㊀YOLOv5检测效果Fig.5㊀YOLOv5detectioneffect2.3㊀激光雷达地面点云去除激光雷达在扫描时有很大一部分点云出自地面,这部分点云对于本文的应用场景属于无效信息,并且会拖慢算法运行速度,因此需要过滤掉㊂常用的地面去除算法是基于RANSAC[13]的平面拟合算法,通过多次尝试将地面所处的平面拟合出来,再进行去除,但是计算量较大,而且本文应用场景中有很多平面高台,所以并不适合在该场景中应用㊂本文采用栅格立柱过滤法[14]㊂方法中,将点云空间按照栅格划分,栅格竖起来形成立柱,立柱中的最高点为Hij,最低点为hij,这里的ij为立柱的索引值,如果该立柱满足布尔表达式:Hij-hij<s(5)㊀㊀其中,s为高度阈值,即立柱中的高度差不超过阈值,则该立柱中的点云为地面㊂如果超出阈值,则说明该立柱中的点云有较大的起伏,可能属于路面上的物体㊂地面点云去除算法的效果如图6所示㊂(a)全部点云㊀㊀㊀㊀(b)地面点云㊀㊀㊀㊀(c)有效点云图6㊀地面点云去除效果Fig.6㊀Groundpointcloudremovaleffect㊀㊀由图6可知,图6(a)为16线激光雷达扫描环境后输出的全部点云,图6(b)为算法检测出的地面部分,将其剥离之后可以得到非地面部分的有效点云,见图6(c)㊂2.4㊀三维目标检测相机在成像的过程中丢失了深度信息[15],所以通过相机进行目标检测只能获取二维的结果,即只能得出目标在图像中的位置和目标的种类,但是无法知道目标的实际大小和实际的三维坐标㊂研究可知,通过联合标定的激光雷达可以补足这个缺陷㊂首先将激光雷达投影到相机成像平面上并保留对应关系,投影算法为:021智㊀能㊀计㊀算㊀机㊀与㊀应㊀用㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第13卷㊀uv1æèçççöø÷÷÷=1Zfx0cx0fycy001æèçççöø÷÷÷XYZæèçççöø÷÷÷=def1ZKP(6)㊀㊀其中,P为雷达中的三维点,用X,Y,Z表示三维坐标,经过相机内参K的转换后得到像素坐标u,v㊁即在图像中的坐标,这样就可以由每个雷达反射点找到在图片中的位置,同时也可以通过像素点得到对应雷达反射点的三维空间坐标,即可以获取二维像素点和三维雷达点云的映射关系㊂通过激光雷达和相机的联合标定可以在将雷达点云变换到相机坐标系后,接着再利用相机标定得到的内参矩阵K,这样就具备了将雷达点云投影到相机图片上的所有条件,投影效果如图7所示㊂(a)相机图片㊀㊀㊀㊀(b)雷达点云㊀㊀㊀(c)点云投影效果图7㊀激光雷达和相机联合标定后的投影效果Fig.7㊀Projectioneffectafterjointcalibrationofthelidarandthecamera㊀㊀至此,通过将二维目标检测阶段的结果作为三维目标检测阶段的输入,将2DBoundingBox中的像素点转化成三维的雷达点云,对这部分雷达点云进行3DBoundingBox求解[16],计算步骤如下:首先,计算点云的质心PC,质心是指物体质量的中心,但是点云是没有质量的,所以这里假设点的质量为单位1即可,得到点云质心坐标为(c0,c1,c2),计算公式为:PC=(c0,c1,c2)=1n(ðni=0xi,ðni=0yi,ðni=0zi)(7)然后,计算出点云的协方差,其中P已经减去了质心PѳP-PC,点云归一化后的协方差矩阵为:C=cov(x,x)cov(x,y)cov(x,z)cov(y,x)cov(y,y)cov(y,z)cov(z,x)cov(z,y)cov(z,z)æèçççöø÷÷÷(8)最后,求解出协方差矩阵的特征向量(e0,e1,e0ˑe1),结合点云信息和特征向量即可解出3DBoundingBox的所有信息,求解公式为:R=quaternion(e0,e1,e0ˑe1)Dc=12(Pmax+Pmin)t=RˑDc+(c0,c1,c2)(9)㊀㊀其中,R为BoundingBox的旋转;Pmax和Pmin为点云的极大值和极小值;Dc为对角线的中点;t为BoundingBox的平移向量;BoundingBox的宽㊁高㊁深度分别为xmax-xmin,ymax-ymin和zmax-zmin㊂由此得到了3DBoundingBox所需的所有信息,实现了二维检测到三维检测的升维㊂3㊀实验测试实验平台硬件主要由16线激光雷达和球形相机构成,使用的工控机配置为Intel(R)Core(TM)i7-8700CPU@3.20GHz,RTX2060GPU,32G内存㊂实验硬件平台与安装位置如图8所示㊂图8㊀硬件平台与安装位置Fig.8㊀Hardwareplatformandinstallationlocation㊀㊀实验内容为:将传感器硬件平台安装在大车前方1.5m高处,大车本身行驶在车道线内,当传感器在车道线内前方20m内检测到障碍物时,需要及时将信号传递给大车的控制中心,控制中心根据障碍物的种类和距离进行告警和制动㊂通过设置实验测试场景进行测试,测试目标包括行人㊁汽车和卡车三个种类,让3个种类的目标分布在车道线内的不同距离和位置,测试结果见表1㊂表1㊀实验检测精度Tab.1㊀Experimentaldetectionaccuracy检测目标二维目标检测精度mAP/%三维目标检测误差F2/m行人86.70.2汽车87.10.5卡车85.50.8㊀㊀检测效果可视化如图9所示㊂图9中,左侧为车道线检测和二维目标检测的可视化效果,右侧为雷达点云视角中的三维目标检测效果㊂㊀㊀(a)二维检测结果㊀㊀㊀㊀㊀㊀㊀㊀(b)三维检测结果图9㊀目标检测效果可视化Fig.9㊀Visualizationoftargetdetectioneffect121第3期陈德江,等:基于16线激光雷达和相机融合的三维目标检测㊀㊀此外,根据自动化港口码头需求,开发了一套后端系统及UI界面㊂其中,后端系统基于ROS操作系统开发,将消息通讯抽象为Topic,满足实时性要求㊂UI界面如图10所示,通过相机和雷达的IP进行控制,当在车道线上检测到障碍物时进行告警,并且将告警信息记录在日志中,方便后期查询㊂图10㊀三维目标检测报警系统UIFig.10㊀UIof3Dtargetdetectionalarmsystem4㊀结束语本文针对16线激光雷达输出点云过于稀疏而无法进行三维目标检测的问题,提出了一种基于16线激光雷达和相机融合的三维目标检测方法㊂通过联合标定从空间上统一了激光雷达和相机的坐标系,并利用ROS从时间上对齐了激光雷达和相机的数据㊂接下来,采用相机的三维投影算法在二维像素和三维点云之间建立了映射关系㊂最后,对目标点云进行包围框的计算,将二维检测结果升级至三维㊂实验结果表明:该方法可以有效检测车道线内的目标,理论上可以满足大型车辆三维目标检测的需求㊂参考文献[1]GRAVINAR,ALINIAP,GHASEMZADEHH,etal.Multi-sensorfusioninbodysensornetworks:State-of-the-artandresearchchallenges[J].InformationFusion,2017,35:68-80.[2]CHENXiaozhi,MAHuimin,WANJi,etal.Multi-view3dobjectdetectionnetworkforautonomousdriving[C]//ProceedingsoftheIEEEconferenceonComputerVisionandPatternRecognition.Honolulu,HI,USA:IEEE,2017:1907-1915.[3]SENGUPTAA,YEYuting,WANGR,etal.Goingdeeperinspikingneuralnetworks:VGGandresidualarchitectures[J].FrontiersinNeuroscience,2019,13:95.[4]KUJ,MOZIFIANM,LEEJ,etal.Joint3dproposalgenerationandobjectdetectionfromviewaggregation[C]//2018IEEE/RSJInternationalConferenceonIntelligentRobotsandSystems(IROS).Madrid,Spain:IEEE,2018:1-8.[5]QICR,LIUWei,WUChenxia,etal.Frustumpointnetsfor3dobjectdetectionfromrgb-ddata[C]//ProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognition.SaltLakeCity,UT,USA:IEEE,2018:918-927.[6]QICR,SUHao,MOKaichun,etal.Pointnet:Deeplearningonpointsetsfor3dclassificationandsegmentation[C]//ProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognition.Honolulu,Hawaii:IEEE,2017:652-660.[7]ZHAOZhongqiu,ZHENGPeng,XUShoutao,etal.Objectdetectionwithdeeplearning:Areview[J].IEEETransactionsonNeuralNetworksandLearningSystems,2019,30(11):3212-3232.[8]RUSURB,COUSINSS.3dishere:Pointcloudlibrary(pcl)[C]//2011IEEEInternationalConferenceonRoboticsandAutomation.Shanghai,China:IEEE,2011:1-4.[9]PUSZTAIZ,HAJDERL.AccuratecalibrationofLiDAR-camerasystemsusingordinaryboxes[C]//ProceedingsoftheIEEEInternationalConferenceonComputerVisionWorkshops.Venice,Italy:IEEE,2017:394-402.[10]DUXinxin,TANKK.Vision-basedapproachtowardslanelinedetectionandvehiclelocalization[J].MachineVisionandApplications,2016,27(2):175-191.[11]KUZNETSOVAA,MALEVAT,SOLOVIEVV.DetectingapplesinorchardsusingYOLOv3andYOLOv5ingeneralandclose-upimages[C]//InternationalSymposiumonNeuralNetworks.Cham:Springer,2020:233-243.[12]LINTY,MAIREM,BELONGIES,etal.Microsoftcoco:Commonobjectsincontext[C]//EuropeanConferenceonComputerVision.Cham:Springer,2014:740-755.[13]ISASNM,SHUKORSAA,RAHIMNA,etal.Pointclouddatasegmentationusingransacandlocalization[J].IOPConferenceSeries:MaterialsScienceandEngineering,2019,705(1):012004.(下转第128页)稍高,符合设计要求㊂综合比较后可知,本电路负载调整率和线性调整率都很高㊂在负载和电压快速变化的情况下能快速恢复,输出正常电压㊂表1㊀与其他文献的LDO相比Tab.1㊀ComparedwithLDOsfromotherliterature参数输入电压范围/V输出电压/V输出电流/mA线性调整率/(mV㊃V-1)负载调整率/(uV㊃mA-1)本文8 405.01000.054012.5文献[5]5.5 305.02000.650046.0文献[6]4.5 281.8200.00852.6文献[7]3.9 202.58000.509045.8文献[8]5.2 165.04001.100029.03㊀结束语本文设计了基于华虹0.18umBCD工艺,高压㊁宽范围输入的LDO电路,在大负载下其线性调整率和负载调整率分别达到54uV/V㊁12.5μV/mA,并且在电源和负载瞬态变化时,负载都有6μs的快速恢复时间㊂在对温度进行仿真时,也表明该芯片能在-50ħ 165ħ的环境下正常工作,输入电压在8 40V,能驱动最大负载100mA,静态电流小于200uA,同时能稳定输出5V电压㊂因此该芯片可用于电机驱动芯片当中㊂参考文献[1]陈贵灿,邵志标,程军,等.CMOS集成电路设计[M].西安:西安交通大学出版社,2000.[2]刘雷.高压LDO的研究与设计[D].成都:电子科技大学,2021.[3]孙蕊.一种宽输入范围低噪声LDO线性稳压器的研究与设计[D].合肥:合肥工业大学,2020.[4]谭传武,傅宗纯.改进型自偏置带隙基准源电路设计[J].电子设计工程,2021,29(13):47-50.[5]吴霞,鲍言锋,邓婉玲,等.基于0.35μmCMOS工艺的高温高压LDO芯片设计[J].电子技术应用,2021,47(12):120-125.[6]LISheng,XINXiaoning,RENJian,etal.Designofcapacitor-lessLDOappliedtolowpowersupplywithhigh-precisionbandgap[J].JournalofPhysics:ConferenceSeries,2021,1754(1):012034.[7]MANIKANDANP,BINDUB.High-PSRcapacitorlessLDOwithadaptivecircuitforvaryingloads[J].JournalofCircuits,SystemsandComputers,2020,29(11):2050178:1-2050178:12.[8]SLAMTIA,MEHDAOUIY,CHENOUNID,etal.Adualfrequencycompensationtechniquetoimprovestabilityandtransientresponseforathreestagelow-drop-outlinearregulator[J].MMEP,2021,8(2):219-229.[9]张艳飞,曹正州.一种宽范围输入电压的驱动电路设计[J].电子与封装,2020,20(12):34-39.[10]戴靖遥,赵宏亮.一种具有低线性调整率的带隙基准源电路设计[J].微处理机,2017,38(06):37-41.[11]马姗姗,唐威,刘伟.300mA快速瞬态响应的无电容型LDO设计[J].电子元件与材料,2021,40(11):1118-1122.[12]SAKOLSKIO,POONGODANPK,VANSELOWF,etal.Afeedforwardcompensatedhigh-voltagelinearregulatorwithfastresponse,high-currentsinkingcapability[J].IEEESolid-StateCircuitsLetters,2020,3:114-117.[13]MURPHREERC,SAJIBR,SHAMIMA,etal.ASiCCMOSlinearvoltageregulatorforhigh-temperatureapplications[J].IEEETransactionsonPowerElectronics,2020,35(1):913-923.[14]李建平.一种高温CMOS低压差线性稳压器设计[D].北京:北京交通大学,2020.[15]吴美中.宽输入高稳定性低压差线性稳压器的设计[D].西安:西安电子科技大学,2020.(上接第122页)[14]POSTICAG,ROMANONIA,MATTEUCCIM.Robustmovingobjectsdetectioninlidardataexploitingvisualcues[C]//2016IEEE/RSJInternationalConferenceonIntelligentRobotsandSystems(IROS).Daejeon,Korea:IEEE,2016:1093-1098.[15]KUOJ,MUGLIKARM,ZHANGZ,etal.RedesigningSLAMforarbitrarymulti-camerasystems[C]//2020IEEEInternationalConferenceonRoboticsandAutomation(ICRA).IEEE,2020:2116-2122.[16]RUSURB,COUSINSS.3dishere:Pointcloudlibrary(pcl)[C]//2011IEEEInternationalConferenceonRoboticsandAutomation.Shanghai,China:IEEE,2011:1-4.。

激光雷达与相机融合算法1.引言1.1 概述概述:激光雷达与相机融合算法是一种将激光雷达和相机数据相结合的技术,通过对两种传感器数据进行融合处理,可以提高目标检测、跟踪和定位等方面的性能。

激光雷达技术能够提供高精度的距离和三维点云数据,而相机技术则能够提供丰富的颜色和纹理信息。

将这两种不同类型的数据进行融合,可以更全面地感知环境,进而实现更准确、鲁棒的目标识别与定位。

相较于单一的传感器,激光雷达与相机融合算法具有以下优势。

首先,通过融合两种传感器的数据,可以综合利用它们各自的优点,如激光雷达的高精度和相机的丰富信息。

这样可以在保持高精度的基础上,提供更多的场景信息,从而更准确地理解周围环境。

其次,激光雷达和相机的数据可以相互补充,互为验证。

激光雷达能够准确获取物体的距离和位置信息,而相机则能够提供更具语义化的图像信息。

通过将二者融合,可以有效提升目标检测和定位的准确性。

此外,激光雷达与相机融合算法还能够增强对于低纹理、遮挡等场景的感知能力,从而提高系统的鲁棒性和可靠性。

激光雷达与相机融合算法在自动驾驶、机器人导航、三维地图构建等领域具有广阔的应用前景。

在自动驾驶领域,通过融合激光雷达和相机数据,可以实现对周围环境的全面感知,并提供更准确的障碍物检测与识别,从而提高自动驾驶车辆的安全性和可靠性。

在机器人导航领域,激光雷达和相机的融合可以提供更丰富和准确的环境感知数据,使机器人能够更精确地定位和导航。

在三维地图构建领域,融合算法能够更好地还原环境的三维结构,并提供更准确的地图信息。

综上所述,激光雷达与相机融合算法具有重要的意义和广泛的应用前景。

通过将两种不同类型的传感器数据进行融合处理,可以在保持高精度的基础上,提供更全面、准确的环境感知和定位能力,从而推动自动驾驶、机器人导航等领域的发展和应用。

1.2文章结构文章结构部分的内容可以包括以下几个方面:激光雷达与相机融合算法这篇文章主要包括三个部分的内容。

激光雷达与相机融合标定的关键技术激光雷达与相机融合标定的关键技术激光雷达与相机融合标定是实现机器人感知和环境建模的关键技术之一。

通过准确地确定激光雷达和相机之间的几何关系和传感器参数,可以将它们的测量结果进行融合,从而提高机器人的感知能力和决策准确性。

下面,将按照步骤解释激光雷达与相机融合标定的关键技术。

第一步是获取标定数据。

为了进行标定,需要同时采集激光雷达和相机的数据。

可以使用一个机器人平台,将激光雷达和相机固定在同一位置上,并在不同的方向和角度下进行数据采集。

这些数据将用于之后的标定算法。

第二步是提取特征点。

对于激光雷达和相机的数据,需要提取共同的特征点。

激光雷达的数据可以直接使用其测量点的坐标作为特征点,而相机的数据则需要通过图像处理算法提取特征点,例如角点或边缘点。

提取的特征点应该具有良好的重复性和稳定性。

第三步是建立特征点匹配关系。

将激光雷达和相机的特征点进行匹配,可以确定它们之间的对应关系。

可以使用特征描述子或几何模型匹配算法来实现这一步骤。

匹配的准确性对于之后的标定结果至关重要。

第四步是求解标定参数。

通过已经匹配的特征点,可以利用几何关系或最小二乘法求解出激光雷达和相机之间的转换矩阵和其他参数。

这些参数包括旋转矩阵、平移矩阵和相机的内参矩阵等。

第五步是评估标定结果。

对标定结果进行评估可以检查其准确性和稳定性。

可以使用重投影误差等指标来评估标定结果,并根据需要对标定参数进行微调和优化。

最后一步是应用标定参数。

将求解出的标定参数应用于机器人的感知和决策过程中。

通过将激光雷达和相机的测量结果进行融合,可以提高机器人对周围环境的感知能力,实现更准确的目标检测、地图构建和路径规划等任务。

总之,激光雷达与相机融合标定是一项复杂而关键的技术,可以提高机器人的感知能力和决策准确性。

通过获取标定数据、提取特征点、建立匹配关系、求解标定参数、评估结果和应用标定参数等步骤,可以实现激光雷达与相机之间的准确标定,并将其应用于机器人的感知和环境建模中。

基于双目视觉的激光雷达与相机融合标定基于双目视觉的激光雷达与相机融合标定基于双目视觉的激光雷达与相机融合标定是一种常用的技术,可以用于同时获取激光雷达和相机的三维信息,从而实现更准确的环境感知和目标识别。

下面将介绍一种基于双目视觉的激光雷达与相机融合标定的步骤。

步骤一:准备工作首先,需要准备一个安装了激光雷达和相机的平台,并确保它们的坐标系已经定义好。

同时,还需要一些标定板,如棋盘格标定板,用于标定相机的内参。

步骤二:相机内参标定将标定板放置在平台上,保证相机能够看到整个标定板,并拍摄一系列标定板的照片。

然后,使用相机标定算法,如张正友标定法,对这些照片进行分析,计算出相机的内参,即相机的焦距、畸变系数等。

步骤三:激光雷达与相机标定将标定板放置在平台上,并保证激光雷达和相机都能够看到整个标定板。

然后,让激光雷达和相机同时扫描标定板,并记录下对应的三维点云和二维图像。

将这些数据输入到激光雷达与相机标定算法中,如ICP(Iterative Closest Point)算法,进行匹配和计算。

最终,得到激光雷达和相机之间的外参,即它们的相对位姿关系。

步骤四:验证与精度评估利用标定结果,将激光雷达和相机的数据进行融合,获取更准确的点云数据。

然后,通过对比融合后的点云数据与实际场景的差异,评估标定的精度。

可以使用一些评估指标,如均方根误差(RMSE)等,来衡量标定的准确度。

步骤五:应用与优化将标定结果应用于实际项目中,如自动驾驶、机器人导航等。

通过实际场景的应用,可以进一步优化标定结果,提高融合后数据的精确性和实时性。

综上所述,基于双目视觉的激光雷达与相机融合标定是一项重要的技术,可以实现激光雷达和相机数据的融合,提高环境感知和目标识别的准确性。

通过以上步骤的执行和优化,可以得到较为准确的标定结果,并将其应用于实际项目中。

基于相机与激光雷达融合的目标定位与跟踪相机与激光雷达技术在目标定位与跟踪领域有着广泛的应用。

相机可以获取图像信息,而激光雷达则可以获取目标的三维空间坐标。

将相机和激光雷达数据进行融合处理,可以提高目标定位和跟踪的准确性与稳定性。

本文将探讨基于相机与激光雷达融合的目标定位与跟踪技术。

一、相机与激光雷达的工作原理相机是以图像采集为基础的设备,能够通过光学透镜获取目标的二维视觉信息。

相机通过光敏元件将光信号转换为电信号,进而得到目标的图像信息。

激光雷达则是通过发射激光束并接收其反射信号来获取目标的三维空间坐标。

激光雷达利用激光的传播时间和反射信号的强度,可以实现对目标的精确定位。

二、相机与激光雷达融合的方法1. 数据融合方法相机与激光雷达数据的融合可以通过多种方法实现,其中包括传感器级融合、特征级融合和决策级融合。

传感器级融合是将相机和激光雷达的原始数据进行结合,得到更准确的目标信息。

特征级融合则是提取相机和激光雷达数据的特征,并将其进行融合,以获取更全面的目标信息。

决策级融合是在相机和激光雷达数据的基础上,通过决策算法对目标进行定位与跟踪。

2. 目标定位与跟踪方法基于相机与激光雷达融合的目标定位与跟踪方法主要包括滤波器方法和特征点匹配方法。

滤波器方法包括卡尔曼滤波器和粒子滤波器等,能够通过对目标的系统动力学和观测信息进行滤波处理,从而实现对目标运动的估计和预测。

特征点匹配方法则是通过提取相机和激光雷达数据的特征点,并通过匹配算法进行目标的定位与跟踪。

三、相机与激光雷达融合的应用基于相机与激光雷达融合的目标定位与跟踪技术在无人驾驶、智能交通系统和机器人导航等领域有着广泛的应用。

在无人驾驶领域,相机与激光雷达融合可以实现对车辆、行人等交通参与者的准确定位与跟踪,从而实现车辆的智能驾驶。

在智能交通系统中,相机与激光雷达融合可以实现对交通流量的检测与监控,提高交通拥堵的预测与管理。

在机器人导航领域,相机与激光雷达融合可以实现对环境中障碍物的精确定位与避障。

激光雷达的目标检测与跟踪算法研究激光雷达(Light Detection and Ranging, LiDAR)是一种能够测量目标在空间中的位置和距离的传感器。

它通过发射激光脉冲并接收反射回来的激光束,从而实现对目标的探测和距离测量。

激光雷达广泛应用于自动驾驶、机器人导航、环境感知等领域,目标检测和跟踪是激光雷达在这些应用中的关键技术之一。

一、激光雷达目标检测算法激光雷达目标检测算法的目标是从激光雷达点云数据中识别出目标的位置和形状。

这些算法通常分为基于滤波的算法和基于聚类的算法两大类。

基于滤波的算法是通过一系列的滤波操作,去除激光雷达点云中的噪声和杂散点,提取出目标的特征。

常用的滤波算法包括高斯滤波、中值滤波和自适应滤波等。

这些滤波算法可以有效降低噪声对目标检测的影响,提高检测算法的准确性和稳定性。

基于聚类的算法是将点云数据分成不同的类别,每个类别代表一个目标。

常用的聚类算法有基于密度的聚类算法和基于形状的聚类算法。

基于密度的聚类算法通过计算点云样本之间的密度来判别是否属于同一个类别,进而识别出目标。

基于形状的聚类算法则是通过计算点云的形状特征来判断是否属于同一个目标类别。

二、激光雷达目标跟踪算法激光雷达目标跟踪算法的目标是在连续的激光雷达点云数据中,追踪已被检测到的目标,并预测目标的位置和运动轨迹。

目标跟踪算法通常分为两类:基于特征的算法和基于滤波的算法。

基于特征的算法是通过提取目标的特征信息,并将其与已有的目标模型进行匹配,从而实现目标的跟踪。

常见的特征包括目标的形状、颜色、纹理等。

这些特征可以通过机器学习算法进行学习和分类,用于目标的识别和跟踪。

基于滤波的算法则是通过建立目标运动模型和观测模型,利用滤波器对目标状态进行估计和预测。

常用的滤波算法包括卡尔曼滤波、粒子滤波和扩展卡尔曼滤波等。

这些滤波算法能够有效地处理目标的不确定性和运动模型的非线性。

三、激光雷达目标检测与跟踪算法的应用激光雷达目标检测与跟踪算法在自动驾驶、机器人导航和环境感知等领域有广泛的应用。

基于相机激光雷达融合的目标检测方法作者:周沫张春城何超来源:《专用汽车》2024年第02期摘要:針对单一传感器在自动驾驶车辆环境感知系统中易受环境干扰的问题,通过融合激光雷达点云数据和相机图像数据,提出一种强鲁棒性的目标检测方法。

首先,通过YOLOv4和Pointpillars分别实现相机的2D目标检测和激光雷达的3D目标检测;然后将点云从3D投影到2D笛卡尔坐标下并计算相机帧下的3D边框;进而将相机帧中的3D边界框转换为图像上的2D边框;最后,计算在同一图像上显示的相机和激光雷达检测框的IOU指标后进行边框融合并修正融合后的目标置信度,最终输出目标的融合框、类别和距离信息。

在KITTI数据集上的实验结果表明,相较单一传感器的目标检测方法,所提出的方法通过点云和图像数据的优势互补提高了目标检测的精度。

关键词:点云图像;后期融合;置信度修正;目标检测中图分类号:U472.9;TP391.4 收稿日期:2023-11-20DOI:10.19999/ki.1004-0226.2024.02.0191 前言由于自动驾驶车辆环境感知系统中传感器本身硬件性能的局限性,基于单一传感器的目标检测技术有很大的局限性,多传感器融合目标检测技术可以实现不同传感器间的优势互补,因此近年来多传感器融合技术受到了广泛的关注。

传感器融合可以分为前期、中期和后期融合[1]。

前融合即数据级融合,直接融合不同传感器的原始数据,具有较高的准确性,但不易将不同维度的数据统一,数据处理量大,实时性较低。

中期融合即特征级融合,对不同数据分别提取原始特征,再融合多个特征,根据目标已有特征对融合特征进行匹配,获得目标的信息。

后融合即结果级融合,分别在不同的原始数据下检测得到在该数据类型下的目标包络框、类别、位置等信息,然后对目标的包络框等信息进行融合。

后融合的方法具有较高的鲁棒性且不受传感器类别的影响。

国内外学者近年来对传感器融合技术已经有了一定的研究。

无人驾驶车辆中基于激光雷达与相机的目标检测与跟踪技术的应用研究目前,随着无人驾驶技术的迅猛发展,基于激光雷达与相机的目标检测与跟踪技术成为了无人驾驶车辆中关键的技术之一。

本文将重点探讨该技术在无人驾驶车辆中的应用研究。

目标检测与跟踪技术是指在图像或视频中识别和追踪感兴趣目标的能力。

在无人驾驶车辆中,准确地检测和跟踪周围的行人、车辆和障碍物对于保证车辆的安全驾驶至关重要。

而基于激光雷达与相机的目标检测与跟踪技术能够充分利用这两种传感器的优势,提高目标检测与跟踪的准确性和鲁棒性。

首先,激光雷达在无人驾驶车辆中起到了关键的作用。

激光雷达能够以非常高的精度获取周围环境的三维信息,生成点云数据。

通过对点云数据进行处理和分析,可以有效地检测周围的障碍物并提供其位置、尺寸等关键信息。

在目标检测与跟踪中,激光雷达可以被用来提取物体的形状、距离和速度等特征,进而帮助无人驾驶车辆准确地感知周围环境。

同时,相机作为另一种重要的传感器,能够获取图像信号并提供丰富的语义信息。

相机可以提供更多的细节和特征,例如颜色、纹理和形状等,有助于提高目标检测和跟踪的准确性。

相机还可以通过计算和分析图像中的像素值和灰度变化,对目标进行分割和识别。

基于激光雷达与相机的目标检测与跟踪技术主要分为两个阶段:目标检测和目标跟踪。

在目标检测阶段,通过综合利用激光雷达和相机的信息,识别出图像中的感兴趣目标。

一种常用的方法是将激光雷达数据转换为二维图像,与相机图像进行融合。

通过将两种传感器的信息进行融合,可以提高目标检测的准确性和鲁棒性。

在目标跟踪阶段,通过建立目标模型和运动模型,实现对目标的实时追踪。

利用激光雷达数据,可以估计目标的位置、速度和运动轨迹等信息。

通过与相机图像相结合,可以进一步提取目标的外观特征,例如颜色和纹理信息。

结合两种传感器的信息,可以实现对目标的准确跟踪,从而为无人驾驶车辆提供更精确的环境感知和决策依据。

基于激光雷达与相机的目标检测与跟踪技术在无人驾驶领域具有广阔的应用前景。

基于雷达与相机融合的车辆检测与跟踪技术研究随着自动驾驶技术的发展,车辆检测与跟踪技术在智能交通领域扮演着至关重要的角色。

基于雷达与相机融合的车辆检测与跟踪技术能够克服各个传感器单独使用时的局限性,提高车辆检测与跟踪的准确性与鲁棒性。

本文将从传感器选型、数据融合、目标检测与跟踪算法等方面进行研究。

首先,传感器选型是基于雷达与相机融合的车辆检测与跟踪技术的关键。

传统上,雷达可以提供较为准确的距离与速度信息,但对于车辆形状与细节等信息难以捕捉;而相机则能够提供丰富的视觉信息,但对于距离与速度的测量不够精确。

因此,选择具有高分辨率、大视野与较高精度的雷达与相机传感器进行融合是至关重要的。

其次,在数据融合方面,需要将雷达与相机的数据进行校准与配准,确保两者具有相同的空间参考系。

常见的方法是利用外部标定板进行标定,通过解算相机与雷达之间的变换矩阵,将雷达点云与相机图像对齐。

融合后的数据可以提供丰富的立体几何信息与视觉特征,提高车辆检测与跟踪的精度与鲁棒性。

然后,在目标检测与跟踪算法方面,可以利用融合后的雷达与相机数据进行目标检测与跟踪。

目标检测阶段主要利用相机图像进行目标识别与定位,常见的算法包括基于深度学习的物体检测算法(如Faster R-CNN、YOLO等)以及基于特征提取与机器学习的方法(如HOG+SVM等)。

在目标跟踪阶段,可以利用雷达点云数据进行目标运动状态的估计与预测,常见的算法包括基于卡尔曼滤波的运动估计算法以及基于粒子滤波的目标追踪算法。

最后,在车辆检测与跟踪技术应用中,还需要考虑实时性与鲁棒性的问题。

实时性可以通过对算法进行优化与并行化来提高,例如使用GPU进行加速计算;而鲁棒性则需要考虑不同天气、光照等环境下的适应性。

此外,还可以使用多传感器融合、多模态特征以及时空信息等方法来进一步提高检测与跟踪的性能。

综上所述,基于雷达与相机融合的车辆检测与跟踪技术具有广阔的应用前景。

通过选择合适的传感器、进行准确的数据融合与应用有效的目标检测与跟踪算法,可以提高自动驾驶汽车的安全性与智能化水平。

基于相机激光雷达融合的目标检测方法摘要:现阶段,我国科学技术飞速发展。

传感器作为能够获取车辆周围环境信息的设备,在智能驾驶领域有着重要的地位。

激光雷达能探测三维环境中目标物的空间信息,具有测距精度高、测量范围大等优点,但无法提供被探目标的颜色和纹理信息;相机可获取被探目标的颜色和外观等较为丰富的语义特征,但探测精度受光照及其他自然条件的影响较大。

为克服单传感器探测的局限性,智能驾驶系统通常采用相机和激光雷达等多传感设备实现对环境的感知,通过这些传感器数据的同步融合,发挥各个传感器的优势,提高目标识别的可靠性。

其中传感器的外参数标定是数据同步融合的关键。

关键词:相机;激光雷达;融合目标;检测方法引言多传感器融合在移动机器人自主导航领域应用广泛。

激光雷达和相机传感器是自动驾驶应用中最常见的感知传感器,相机可以提供丰富的色彩信息和其他特征,用于提取被检测物体的不同特征;激光雷达传感器可以准确检测物体的三维位置和结构。

为了增强目标检测和分类,可以将这两个传感器的数据进行融合,以获得更详细和准确的目标信息。

在使用传感器过程中,采集的图像数据和点云数据都是基于各自传感器的坐标系,数据融合的前提是将两个传感器的数据转换到同一坐标系中。

1激光雷达与相机的联合标定1.1数据采集由于传感器位于试验车车身的不同位置,每个传感器都有自身独立的坐标系。

为获得相机图像检测结果与激光雷达点云检测结果的一致性描述,需利用联合标定的方法将每个传感器的独立坐标系转换为统一坐标系,以实现传感器数据间的相互关联与空间同步。

联合标定通常采用标定物关联策略,利用标定物在不同传感器坐标系中的坐标值求解不同坐标系之间的转换参数。

采用平面靶标定法,将一个平面靶(标定板)置于激光雷达和相机前,通过多次变换标定板位姿生成多组约束,然后对不同位姿的平面靶特征点进行匹配,以求得不同坐标系之间的旋转、平移矩阵。

靶标定法的数据采集场地应选择在视野开阔、背景干扰物少、可在不同视野位置采样的地点。