基于多元线性回归的数据挖掘技术

- 格式:doc

- 大小:22.00 KB

- 文档页数:2

二元logistics回归模型二元Logistics回归模型是基于多元线性回归模型的一种拓展,常常被应用于对离散性变量进行预测和建模。

相比于线性回归模型,Logistics回归模型更加适用于进行二分类问题的预测与建模,如疾病的预测、工业故障的预测等等。

1. Logistics回归模型的基本概念Logistics回归模型是一种广义线性回归模型的拓展,用于进行二分类问题的预测和建模。

在Logistics回归模型中,变量的取值是离散的,通常为二元,即只有两种取值。

Logistics回归模型利用了一种对数函数的变换方式对概率进行建模,当用于分类时,将其变为一个二元分类问题。

2. Logistics回归模型与线性回归模型的比较Logistics回归模型的主要特征是对进行二元分类的问题构建了一个可概率化的模型,相对于线性回归模型,Logistics模型更适用于类别间存在差异较大的情况。

Logistics模型看上去很简单,但在实际应用中是非常灵活和强大的。

与其他的想法相比,Logistics模型更具解释性和可解释性,而且在处理二元分类问题时明显优于其他方法。

3. Logistics回归模型的优点Logistics回归模型采用了对数函数的变换方式,使得分类结果呈现一个概率分布,而且概率分布可以自然地映射到0-1的区间内,使得分类结果具有明显的解释性。

除此之外,Logistics回归模型的二元分类结果也可以被解释为对相应事件的预测概率,而不像其他的方法对分类结果缺乏明确的概率预测解释。

4. Logistics回归模型的原理Logistics回归模型的原理可以通过应用最大似然估计来进行求解。

最大似然估计假设观察到的数据是在一定条件下出现的,我们需要通过对这些已知的数据建立一个参数的似然函数,并通过最大化这个似然函数来获得最佳的参数值组合。

基于这种方法,我们可以快速得到一个用于预测二元分类结果的Logistics回归模型。

多元回归分析原理回归分析是一种处理变量的统计相关关系的一种数理统计方法。

回归分析的基本思想是: 虽然自变量和因变量之间没有严格的、确定性的函数关系, 但可以设法找出最能代表它们之间关系的数学表达形式。

回归分析主要解决以下几个方面的问题:(1) 确定几个特定的变量之间是否存在相关关系, 如果存在的话, 找出它们之间合适的数学表达式;(2) 根据一个或几个变量的值, 预测或控制另一个变量的取值, 并且可以知道这种预测或控制能达到什么样的精确度;(3) 进行因素分析。

例如在对于共同影响一个变量的许多变量(因素)之间, 找出哪些是重要因素, 哪些是次要因素, 这些因素之间又有什么关系等等。

回归分析有很广泛的应用, 例如实验数据的一般处理, 经验公式的求得, 因素分析, 产品质量的控制, 气象及地震预报, 自动控制中数学模型的制定等等。

多元回归分析是研究多个变量之间关系的回归分析方法, 按因变量和自变量的数量对应关系可划分为一个因变量对多个自变量的回归分析(简称为“一对多”回归分析)及多个因变量对多个自变量的回归分析(简称为“多对多”回归分析), 按回归模型类型可划分为线性回归分析和非线性回归分析。

本“多元回归分析原理”是针对均匀设计3.00软件的使用而编制的, 它不是多元回归分析的全面内容, 欲了解多元回归分析的其他内容请参阅回归分析方面的书籍。

本部分内容分七个部分, §1~§4介绍“一对多”线性回归分析, 包括数学模型、回归系数估计、回归方程及回归系数的显著性检验、逐步回归分析方法。

“一对多”线性回归分析是多元回归分析的基础, “多对多”回归分析的内容与“一对多”的相应内容类似, §5介绍“多对多”线性回归的数学模型, §6介绍“多对多”回归的双重筛选逐步回归法。

§7简要介绍非线性回归分析。

§1 一对多线性回归分析的数学模型§2 回归系数的最小二乘估计§3 回归方程及回归系数的显著性检验§4 逐步回归分析§5 多对多线性回归数学模型§6 双重筛选逐步回归§7 非线性回归模型§1 一对多线性回归分析的数学模型设随机变量与个自变量存在线性关系:, (1.1)(1.1)式称为回归方程, 式中为回归系数, 为随机误差。

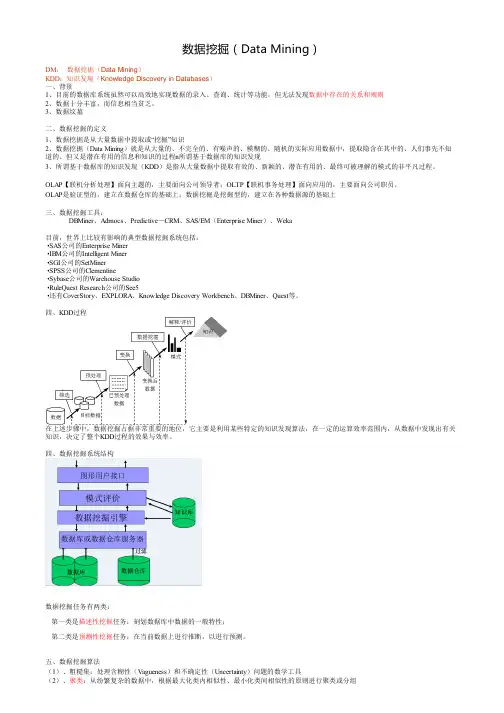

数据挖掘(Data Mining)DM:数据挖掘(Data Mining)KDD:知识发现(Knowledge Discovery in Databases)一、背景1、目前的数据库系统虽然可以高效地实现数据的录入、查询、统计等功能,但无法发现数据中存在的关系和规则2、数据十分丰富,而信息相当贫乏。

3、数据坟墓二、数据挖掘的定义1、数据挖掘是从大量数据中提取或“挖掘”知识2、数据挖掘(Data Mining)就是从大量的、不完全的、有噪声的、模糊的、随机的实际应用数据中,提取隐含在其中的、人们事先不知道的、但又是潜在有用的信息和知识的过程n所谓基于数据库的知识发现3、所谓基于数据库的知识发现(KDD)是指从大量数据中提取有效的、新颖的、潜在有用的、最终可被理解的模式的非平凡过程。

OLAP【联机分析处理】面向主题的,主要面向公司领导者;OLTP【联机事务处理】面向应用的,主要面向公司职员。

OLAP是验证型的,建立在数据仓库的基础上;数据挖掘是挖掘型的,建立在各种数据源的基础上三、数据挖掘工具:DBMiner、Admocs、Predictive-CRM、SAS/EM(Enterprise Miner)、Weka目前,世界上比较有影响的典型数据挖掘系统包括:•SAS公司的Enterprise Miner•IBM公司的Intelligent Miner•SGI公司的SetMiner•SPSS公司的Clementine•Sybase公司的Warehouse Studio•RuleQuest Research公司的See5•还有CoverStory、EXPLORA、Knowledge Discovery Workbench、DBMiner、Quest等。

四、KDD过程在上述步骤中,数据挖掘占据非常重要的地位,它主要是利用某些特定的知识发现算法,在一定的运算效率范围内,从数据中发现出有关知识,决定了整个KDD过程的效果与效率。

基于数据挖掘的航空机票价格预测研究在如今的信息时代,各种数据在我们的生活中扮演着越来越重要的角色。

而航空机票价格则可以被视为一种特殊的数据,它受到许多因素的影响,比如航空公司的运营策略、当前市场的供需关系、航线的距离和运输模式等等。

对于不同的旅客而言,机票价格往往是出行的一个重要因素,在这个背景下,使用数据挖掘技术来预测机票价格变化也成为了研究的一个热点问题。

一、数据挖掘技术所谓数据挖掘,通俗来说,就是从海量数据中提取出有意义、具有价值的信息和知识。

这个过程一般包括如下几个步骤:(1)数据清洗:首先需要从庞杂的海量数据中筛选出与你研究问题相关的数据,并对这些数据进行清洗、处理,以保证可靠性和准确性。

(2)数据集成:在数据清洗的基础上,需要将来自不同数据源的数据进行整合,构建一个完整的数据集。

(3)数据转换:将数据集进行预处理,并将之转化为适合建立模型的形式。

(4)建立模型:在数据预处理完成后,便可以建立模型,通过不同的算法,提取出有用的预测变量。

(5)模型评估:通过比较模型的预测效果,选择一个最佳模型。

(6)模型应用:根据模型的预测结果,预测机票价格的变化。

二、机票价格变化的影响因素机票价格的波动不仅仅是由市场本身的供求关系决定的,还会受到各种其他因素的影响。

下面,我们将会介绍一些影响机票价格变化的主要因素。

(1)航线距离:航线的距离是影响机票价格的一个重要因素,航程越长通常价格越高。

(2)时间:机票价格往往会随着时间的流逝而发生变化,特别是出发日期和旅行季节的变化可能会导致价格的大幅波动。

(3)航空公司:不同航空公司之间的机票价格可能会有较大的差异,在市场竞争较激烈的时候,价格的差异有时候能达到较大的幅度。

(4)交通工具:不同种类的交通工具对于机票价格的影响因素也不同。

例如,直达航班往往价格高于转机航班,商务舱价格往往高于经济舱价格。

(5)市场竞争:市场竞争的影响因素也是机票价格的一个非常重要的决定因素,不同航空公司针对相同市场会采用不同的运营策略,在某些情况下这会直接影响到机票的价格。

数据挖掘是20世纪90年代中期兴起的决策支持新技术,是基于大规模数据库的决策支持系统的核心,它是从数据库中发现知识的核心技术。

数据挖掘能够对数据库中的数据进行分析,以获得对数据更加深入的了解。

数据挖掘技术经历了三个演变时期。

第一时期称为机器学习时期,在这时期人们将已知的并且已经成功解决的事例输入计算机,由计算机对输入的事例进行总结产生相应的规则,在把总结出来的这些规则应用于实践;第二时期称为神经网络技术时期,这一时期人们关注的重点主要是在知识工程领域,向计算机输入代码是知识工程的重要特征,然而,专家们在这方面取得的成果并不理想,因为它投资大、效果差。

第三时期称为KDD时期,即数据挖掘现阶段所处的时期。

它是在20世纪80年代神经网络理论和机器学习理论指导下进一步发展的成果。

当时的KDD全称为数据库知识发现。

它一般是指从样本数据中寻找有用信息或联系的全部方法,如今人们已经接受这个名称,并用KDD这个词来代替数据挖掘的全部过程。

这里我们需要指出的是数据挖掘只是整个KDD过程中的一个重要过程。

数据仓库技术的发展促进了数据挖掘的发展,因为数据仓库技术为数据挖掘提供了原动力。

但是,数据仓库并不是数据挖掘的唯一源泉,数据挖掘不但可以从数据库中提取有用的信息,而且还可以从其它许多源数据中挖掘有价值的信息。

数据挖掘(Data Mining,DM),也称数据库中知识发现(knowlegde discovery in database,KDD),就是从大量的、不完全的、有噪声的、模糊的及随机的实际数据中提取隐含在其中的、未知的、但又是潜在有用的信息和知识的过程。

现在与之相应的有很多术语,如数据分析、模式分析、数据考古等。

我们从数据挖掘的定义中可以看出它包含了有几层意义:所使用的样本数据一般要求是有代表性的、典型的、可靠的;在样本数据中发现的规律是我们需要的;在样本数据中发现的规律能够被我们理解、接受、运用。

数据挖掘过程从数据库中发现知识,简称KDD,是20世纪80年代末开始的,现在人们把KDD 过程可定义为从数据集中识别出有效的、新颖的、潜在有用的,以及最终可以理解的模式的高级处理过程[14]。

数据挖掘的10大算法数据挖掘的10大算法数据挖掘是指通过分析大量数据,并利用各种算法和技术,从中提取有用信息的过程。

在数据挖掘的过程中,有许多经典的算法被广泛应用。

下面介绍了数据挖掘领域中的10大算法。

1. 决策树算法决策树算法是一种基于树状结构的分类和回归算法。

它通过一系列的规则判断来对数据进行分类或者预测。

决策树算法可解释性强,适用于处理离散型和连续型数据。

2. 随机森林算法随机森林算法是一种集成学习的方法,通过构建多个决策树,取多个决策树的结果进行投票或取平均值得到最终的分类结果。

随机森林算法通过使用随机样本和属性选择,可以有效减少过拟合的风险。

3. 朴素贝叶斯算法朴素贝叶斯算法是一种基于贝叶斯定理的分类算法。

它假设每个特征与其他特征独立,并通过计算后验概率来进行分类。

朴素贝叶斯算法简单易懂,适用于处理文本分类等问题。

4. 支持向量机算法支持向量机算法是一种二分类算法,通过构建超平面来对数据进行分类。

它通过将数据映射到高维空间,使得数据集在高维空间中线性可分,从而能够处理非线性问题。

5. K均值聚类算法K均值聚类算法是一种无监督学习算法,用于将数据分成K个不同的簇。

它通过计算数据点与聚类中心的距离来确定数据点的簇归属,不断迭代直到达到收敛条件。

6. 线性回归算法线性回归算法是一种预测算法,用于建立变量间的线性关系模型。

它通过最小化残差平方和来拟合数据,并预测一个或多个连续型变量的数值。

7. 主成分分析算法主成分分析算法是一种降维算法,通过线性变换将数据转换为低维空间。

它通过保持数据的方差最大化来提取最重要的特征。

8. 关联规则算法关联规则算法用于发现数据集中的频繁项集和关联规则。

它通过计算项集之间的支持度和置信度来确定频繁项集和关联规则。

关联规则算法广泛应用于市场篮子分析和推荐系统等领域。

9. 遗传算法遗传算法是一种模拟自然界中生物进化过程的优化算法。

它通过模拟遗传操作,如选择、交叉和变异,从解空间中找到一个近似最优解。

数据挖掘的模型数据挖掘(Data Mining)是指从大量的数据中寻找隐藏在其中的有价值的信息,并将其转化为可理解的形式,以支持决策和预测。

数据挖掘的模型则是实现数据挖掘技术的基础,它们用来描述和分析数据的特征、关系和规律,从而揭示出数据的潜在知识。

一、分类模型分类模型用于将数据划分到不同的预定义类别中。

常见的分类模型包括决策树、朴素贝叶斯、支持向量机等。

决策树是一种树状结构,通过判断数据的特征值按照一定条件分支,最终到达叶子节点预测其所属类别。

朴素贝叶斯模型基于贝叶斯定理,通过计算条件概率来预测类别。

支持向量机则使用超平面在特征空间中对数据进行分类。

二、回归模型回归模型用于预测和估计数值型数据的输出。

它适用于分析因变量与一个或多个自变量之间的关系。

线性回归模型是最简单的回归模型,它假设自变量和因变量之间存在线性关系。

除了线性回归模型外,还有多项式回归、岭回归等模型。

三、聚类模型聚类模型将数据根据其相似性分为不同的类别或群组。

常见的聚类算法有K均值聚类、层次聚类、DBSCAN等。

K均值聚类是一种迭代算法,将数据分为K个簇,使得同一簇内的数据点更加相似。

层次聚类将数据根据相似性构建层次化的聚类结果。

DBSCAN则是一种基于密度的聚类算法,将密度相连的数据点划分为一个簇。

四、关联规则模型关联规则模型用于发现数据中的相互关联性,即数据项之间的频繁关系。

常见的关联规则算法有Apriori算法和FP-Growth算法。

Apriori算法基于频繁项集的性质,通过逐层搜索,找到频繁项集和关联规则。

FP-Growth算法则通过构建FP树来挖掘频繁项集和关联规则。

五、时序模型时序模型用于处理数据的时序性,可以进行时间序列预测、序列模式挖掘等任务。

常见的时序模型有ARIMA模型、LSTM模型等。

ARIMA模型是一种基于时间序列的预测模型,通过分析时间序列的自相关性和滞后关系,来预测未来的趋势。

LSTM模型则是一种递归神经网络,能够学习序列数据中的长期依赖关系。

多元线性回归模型及其应用摘要多元线性回归研究一个因变量、与两个或两个以上自变量的回归,是反映一种现象或事物的数量依多种现象或事物的数量的变动而相应地变动的规律。

建立多个变量之间线性或非线性数学模型数量关系式的统计方法。

多元线性回归模型主要分为建模、基本假设、检验、预测等。

检验是建立模型的核心,包括拟合检验、F 检验、T 检验。

本文采用2005-2006年全国财政支出数据和2005年全国各地生产总值数据,建立多元线性回归模型,预测2006年全国各地生产总值,并与实际数据分析比较。

建模使用了SPSS 和MATLAB 软件。

1.引言在回归分析中,如果有两个或两个以上的自变量,就称为多元回归。

事实上,一种现象常常是与多个因素相联系的,由多个自变量的最优组合共同来预测或估计因变量,比只用一个自变量进行预测或估计更有效,更符合实际。

因此多元线性回归比一元线性回归的实用意义更大。

在实际经济问题中,一个变量往往受到多个变量的影响。

因此本文运用多元线性回归模型分析2005年全国各地财政支出对生产总值的影响,并对2006年生产总值进行预测,将预测值与实际数据进行比较,从而体现多元线性回归模型预测的准确性。

2.模型建立2.1准备数据本文选取2005年我国31个省、市、自治区的地区生产总值和13个重要支出项,分别是:1x 为基本建设支出,2x 为企业挖潜改造资金,3x为科技三项费用,4x 为农业支出,5x 为农林水利气象等部门事业费,6x为工业交通部门事业费,7x 为流动部门事业费,8x 为教育事业费,9x 为科学事业费,10x为卫生经费,11x 为行政管理费,12x 为公检法司支出,13x 为城市维护费。

y 为地区生产总值。

(数据单位为:万元)2.2建模将13个重要支出项设为自变量,用)13,,1(,,21 =p x x x p 表示;将地区生产总值y 设为因变量。

采用最小二乘法拟合一个多元线性回归模型,采用数学软表2.1因而y 对13个自变量的线性回归方程为:13121110987654321953.40696.55111.46360.81117.62639.50668.188590.11767.43598.95032.6681.26770.25892.4182809ˆx x x x x x x x x x x x x y+++--+-+---+--= (2.1)2.3模型检验首先,对模型(2.1)进行拟合优度的检验,采用数学软件SRSS 计算样2R 2R 表2.2 模型汇总由表2.2可知,模型(2.1)拟合效果很好。

基于数据挖掘的英语四级成绩分析与预测作者:王士虎吕纪荣冯波来源:《电脑知识与技术》2014年第03期摘要:阐述了数据挖掘的概念和算法,重点介绍了线性回归算法,基于多元线性回归算法分析了影响大学英语四级的诸多因素。

根据数据挖掘思想,收集历史数据并适当加以变换,使用统计分析技术对影响大学英语四级的诸多因素进行分析,得出了大学英语四级成绩与其影响因素之间的线性回归关系,拟合程度较高,可用于四级成绩预测,对学生学习和学校教学管理有很大的指导作用和使用价值。

关键词:英语四级;数据挖掘;统计分析;线性回归;预测中图分类号:TP301.6 文献标识码:A 文章编号:1009-3044(2014)03-0452-031 概述近几年,我国高等教育蓬勃发展,中华人民共和国国家统计局最新数据(2012年)显示,我国现有普通高等学校2442所,高校在校生人数2391.3万,其实现在的实际数字要大于统计局2012年的数据。

我国2013年毕业生数量699万,2013年号称“史上最难就业季”,而2014年的727万毕业生应该是遇上了“史上最最难就业季”。

面对这样的激烈竞争与“史上最难就业季”,用人单位对于人才的录用也更为苛刻,大学英语四级已经成为了很多用人单位的筛选条件。

如何才能顺利通过大学英语四级呢?很多在校大学生不清楚怎样能通过四级,很多教师也不知道如何管理以帮助学生通过四级。

学生的英语四级成绩到底和哪些因素有着千丝万缕的联系呢?因此,使用数据挖掘技术探索和研究并解决这些问题已经成为部分高校极为重视的教育课题。

这对于提高学生自身素质和竞争力,提升就业质量,促进部分高校的发展有一定的理论意义和实用价值。

2 数据挖掘2.1 数据挖掘概念数据挖掘(Data Mining, DM)是一个利用各种分析方法与技术,从大量的、不完全的、有噪声的、模糊的、随机的数据中提取隐含在其中的、人们事先不知道的、但又是潜在有用的信息和知识的过程。

多元线性回归与非线性回归的比较与分析回归分析是一种广泛应用于数据挖掘、机器学习、统计学等领域的一种方法。

线性回归是回归分析中最常用的一种方法,但是有时候我们需要考虑更为复杂的模型,比如多元线性回归和非线性回归模型。

那么什么是多元线性回归和非线性回归?它们有什么不同?我们该如何选择合适的回归模型呢?本文将从理论和实践两方面对这些问题进行探讨。

1. 多元线性回归多元线性回归是一种线性回归模型,与简单线性回归不同的是,它考虑多个自变量对因变量的影响。

可以用下面的公式来表示:Y = β0 + β1X1 + β2X2 + … + βpXp + ɛ其中,Y是因变量,X1 ~ Xp是自变量,β0 ~ βp是模型的系数,ɛ是误差项。

在多元线性回归中,我们需要对变量之间的相关性进行检验。

如果变量之间存在多重共线性,会导致模型的不稳定性和准确性。

因此,在多元线性回归中,我们需要通过方差膨胀因子、特征选择等方法来解决多重共线性的问题。

2. 非线性回归当自变量和因变量之间的关系不是线性的时候,我们需要使用非线性回归模型。

比如,当因变量随着自变量的增加呈指数增长或递减的趋势,就可以使用指数回归模型;当因变量随着自变量的增加呈对数增长或递减的趋势,就可以使用对数回归模型。

非线性回归的建模过程和多元线性回归类似,但是对于不同的非线性模型,我们需要使用不同的方法进行参数估计。

例如,对于指数回归模型,我们可以使用最小二乘法或非线性最小二乘法进行参数估计。

3. 多元线性回归与非线性回归的比较在实际应用中,我们需要根据数据本身的性质来选择合适的回归模型。

如果数据呈现出线性关系,那么多元线性回归是一个理想的选择;如果数据呈现出非线性关系,那么非线性回归模型会更为合适。

在多元线性回归模型中,我们有比较丰富的理论基础和应用方法,可以广泛应用于各种场景。

多元线性回归模型的优点是简单、易解释、易拓展和广泛适用。

而在非线性回归模型中,我们需要根据数据本身的特点进行调整和优化,因此建模过程会稍显复杂。

数据挖掘概念随着数据量的不断增长,数据挖掘成为了一门越来越重要的技术。

数据挖掘可以帮助我们从大量数据中发现有意义的信息,提供决策支持和预测能力。

本文将介绍数据挖掘的基本概念、主要技术和应用领域。

一、数据挖掘的基本概念1. 数据挖掘的定义数据挖掘是从大量数据中自动发现模式、关系、趋势和异常的过程。

它是一种用于从数据中提取有价值信息的技术,可以帮助我们更好地理解和利用数据。

2. 数据挖掘的任务数据挖掘的主要任务包括分类、聚类、关联规则挖掘、异常检测和预测等。

分类是将数据分为不同的类别,聚类是将数据分为相似的组,关联规则挖掘是发现数据之间的关联关系,异常检测是发现数据中的异常值,预测是根据历史数据预测未来的趋势。

3. 数据挖掘的流程数据挖掘的流程包括数据准备、数据清洗、特征选择、模型构建、模型评估和模型应用等步骤。

数据准备是指从数据源中获取数据并进行预处理,数据清洗是指处理数据中的噪声和异常值,特征选择是指选择对数据分析有用的特征,模型构建是指使用算法构建数据模型,模型评估是指评估模型的准确性和可靠性,模型应用是指将模型应用于实际问题中。

二、数据挖掘的主要技术1. 分类分类是将数据分为不同的类别。

分类算法包括决策树、朴素贝叶斯、支持向量机等。

决策树是一种基于树形结构的分类方法,通过划分数据集来构建决策树。

朴素贝叶斯是一种基于贝叶斯定理的分类方法,它假设特征之间相互独立。

支持向量机是一种基于间隔最大化的分类方法,它可以处理高维数据和非线性分类问题。

2. 聚类聚类是将数据分为相似的组。

聚类算法包括K均值、层次聚类等。

K均值是一种基于距离的聚类方法,它将数据分为K个簇。

层次聚类是一种基于树形结构的聚类方法,它将数据层层聚合,形成层次结构。

3. 关联规则挖掘关联规则挖掘是发现数据之间的关联关系。

关联规则挖掘算法包括Apriori、FP-Growth等。

Apriori算法是一种基于频繁项集的关联规则挖掘方法,它通过扫描数据集来发现频繁项集。

多元线性回归(multiple linear regression)Multiple linear regression in data miningContent:Review of 2.1 linear regression2.2 cases of regression processSubset selection in 2.3 linear regressionPerhaps the most popular and predictive mathematical model is the multivariate linear regression model. You're already in the data, modelIn the course of decision making, we studied the multiple linear regression model. In this statement, we will build on the basis of these knowledgeThe test applies multiple linear regression model in data mining. Multiple linear regression models are used for numerical data mining situationsIn. For example, demographic and historical behavior models are used to predict customer use of credit cards, based on usage and their environmentTo forecast the equipment failure time, often in the past through the travel vacation travel expenses forecast record, at the inquiry officeWindow through the history, product sales, information and other staff forecast the needs of workers, through historical information to predict cross sales of product salesAnd to predict the impact of discounts on sales in retail.In this note, we review the process of multiple linear regression. Here we stress the need to divide data into two categories: TrainingThe data set and the validation data set make it possible to validate multiple linear regression models and require a loose assumption: error obeysNormal distribution. After these reviews, we introduce methods for determining subsets of independent variables to improve prediction.An overview of 2.1 linear regressionIn this discussion, we briefly review the multivariate linear models encountered in the course of data, models, and decision making. AA continuous random variable is called a dependent variable, Y, and some independent variables,. Our purpose is to use independent variablesA linear equation that predicts the value of a dependent variable (also known as a response variable). The modulus that is known as the independent variable for the prediction purposeType is:Pxxx, (21)Epsilon, beta, beta, beta, +++++=ppxxxY,... 22110 (1)Wherein, epsilon is a "noise" variable, which is a normal distribution with a mean value of 0 and a standard deviation of delta (we don't know its value)Random variable. We don't know the values of these coefficients, P, beta, beta,..., 10. We estimate all of these from the data obtained(p+2) the value of an unknown parameter.These data include the N line observation points, also known as instances, which are represented as instances;. throughThese estimates of the beta coefficients are calculated by minimizing the variance and minimum of the values between the predicted and observed data. Variance sumIs expressed as follows:Ipiiixxxy,...,, 21ni,..., 2,1=Sigma =....Nippiiixxxy1222110) (beta, beta, beta)Let us represent the value of the coefficients by making the upper type minimized. These are our estimates of the unknown values,''2'1'0,...,, P, beta, beta, betaThe estimator is also referred to in the literature as OLS (ordinary least squares). Once we have calculated these estimates,We can use the following formula to compute unbiased estimates:^ ^1^0, -, P, beta, beta 2, Delta 2^, DeltaObservation point factorResiduals and = =...= = SigmaNiippiiixxxypn12221102^()...11, beta, beta, beta DeltaThe values we insert in the linear regression model (1) are based on the values of the known independent variablesPredict the value of dependent variable. The predictor variables are calculated according to the following formula:^ ^1^0,..., P, beta, beta, pxxx,..., 21^YPpxxxY^2^21^1^0^Beta beta beta beta ++++=...In the sense that they are unbiased estimates (the mean is true) and that there is a minimum variance compared with other biased estimates,The predictions based on this formula are the best possiblepredictive values if we make the following assumptions:1. Linear hypothesis: the expected value of dependent variable is a linear equation about the independent variablePppxxxxxxYE beta beta beta beta ++++=...), | (2211021,...2, independence hypothesis: random noise variable I epsilonIndependent in all lines. Here I epsilonThe noise is observed at the first I observation pointMachine variable, i=1,2,... N;3. Unbiased hypothesis: noise stochastic variable I epsilonThe expected value is 0, that is, for i=1,2,... N has 0) (=iE epsilon);4, the same variance hypothesis: for i=1,2,... And n's I epsilonThe standard deviation has the same value as delta;5. Normality hypothesis: noise stochastic variable I epsilonNormal distribution.There is an important and interesting fact for our purpose, that is, even if we give up the hypothesis of normalitySet 5) and allow noise variables to obey arbitrary distributions, and these estimates are still well predicted. We can watch BenQThe prediction of these estimators is the best linear predictor due to their minimum expected variance. In other words, in all linear modelsAnd, as defined in equation (1), the model uses a least squares estimator,^ ^1^0, -, P, beta, betaWe will give the minimum of the mean square. And describe the idea in detail in the next section.Normal distribution assumptions are used to derive confidence intervals for predictions. In data mining applications, we have two different data sets:The training data set and the validation data set, these two data sets contain typical relationships between independent variables and dependent variables. Training dataSets are used to estimate regression coefficients. Validation data sets are used to form retention samples without calculating regression coefficientsEstimated value. This allows us to estimate the errors in our predictions without assuming that the noise variables are normally distributedPoor. We use training data to fit the model and estimate the coefficients. These estimated coefficients are used for all validation data setsExamples make predictions. Compare the actual dependent variable values for each example's prediction and validation data sets. The mean square difference allows usCompare the different models and estimate the accuracy of the model in forecasting.^ ^1^0, -, P, beta, beta2.2 cases of regression processWe use examples from Chaterjee, Hadi, and Price to evaluate the performance of managers in big financial institutionsThe process of multivariate linear regression is shown.The data shown in Table 2.1 are derived from a survey of office staff at a department of a major financial institutionSub. Dependent variable is a measure of the efficiency of a department leading by the agency's managers. All dependent variables and independent variables are25 employees are graded from 1 to 5 in different aspects of the management's work. As a result, for each variableThe minimum is 25 and the maximum is 125. These ratings are a survey of 25 employees in each department and 30 employees in each departmentAnswer。

数据挖掘中的分类与回归算法比较数据挖掘是指从大量数据中自动发现隐藏的模式和知识的过程。

分类和回归是数据挖掘中两种常用的算法,它们可以用于预测未来的数据或分类新数据,可以较好地帮助企业或个人做出决策。

两种算法都有其优点和缺点,下面将分别对它们进行比较,以帮助读者更好地理解两种算法的应用场景。

1. 分类算法分类是一种有监督学习(Supervised Learning),它可以根据已知特征,预测未知数据的类别。

根据分类算法的不同实现方式,可以分为规则型分类算法和统计型分类算法。

(1)规则型分类算法规则型分类算法,利用人类专家知识搭建分类规则,根据规则进行分类。

这种算法精度高,可以处理复杂问题,但缺点是分类规则的建立过程需要耗费大量时间和人力物力,并且可能会由于时间和环境的变化而失效。

常见的规则型分类算法有决策树、贝叶斯分类和专家系统等。

(2)统计型分类算法统计型分类算法,是根据已有数据的经验,建立一个概率模型,再根据新数据计算它属于各类别的概率,从而进行分类。

这种算法可以避免规则型分类算法的缺点,但是对数据质量要求高,训练时间较长。

常见的统计型分类算法有K最近邻算法、朴素贝叶斯算法,以及逻辑回归算法等。

2. 回归算法回归算法是有监督学习的一种,用于预测数值型数据。

根据回归算法的不同实现方式,可以分为参数化回归和非参数化回归。

(1)参数化回归参数化回归是一种基于参数求解的回归算法,通常利用最小二乘法求解回归系数。

这种算法简单易懂、计算速度快,但是对数据的分布假设比较严格,对离群点敏感,并且容易出现过拟合问题。

常见的参数化回归算法有线性回归算法和多项式回归算法等。

(2)非参数化回归非参数化回归不需要确定传入模型的参数,而是使用一些假设函数来预测未知数据。

它是基于统计学习理论、核心思想和机器学习理论来构建的,常用的偏差较小、方差较大的模型。

常见的非参数化回归算法有K邻近和决策树等。

3. 算法的比较分类算法和回归算法都是数据挖掘领域中常见的算法,它们的应用前景非常广阔。

第29卷第5期 2007年5月 水利电力机械

TER CONSERVANCY&ELECTRIC P0 R MACHINERY Vo1.29 No.5

May.2007

多元线性回归算法的研究和应用 The study and application of the arithmetic of linearity regression 薛素静,上官同英 (华北水利水电学院信息工程系,河南郑州450011) 摘要:研究多元线性回归算法,利用相关系数分析,筛选与预测结果密切相关的影响因素作为自变量,建立 多元线性回归方程,并进行误差分析。收集有关的宏观经济数据和企业内部数据,通过回归方程预测下一年 度的利润总额,为企业的管理和工作计划制定提供可靠的理论依据。 关键词:数据仓库;数据挖掘;多元线性回归算法 中图分类号:TP271 .71 文献标识码:B 文章编号:1006—6446(2007)05—0059—02

O引言 电信行业是一个数据密集的行业,利用传统的 数据库管理技术已不能满足从海量业务数据中提取 有效信息、建立综合的信息资源平台的需求,而数据 仓库和数据挖掘技术提供了有效的技术支持。随着 电信行业竞争的El趋激烈,国内几大电信运营商相 继开发了基于数据仓库和数据挖掘技术的经营分析 系统,并投入使用。利用多元线性回归算法进行业 务预测分析是经营分析系统的一个重要组成部分。 电信运营商基于El常生产经营上的分析并引入更深 层次的分析模型,进行了宏 观的经营决策分析,并根据 国家宏观经济情况和对过去 几年经营数据的分析,预测 企业未来可能达到的利润, 制定企业未来的发展规划。

1分析的目的 根据经营分析系统中的 原始数据和国家宏观数据,

经营和资源配置作出决策。 2分析中所使用的数据模型 在实际的生产经营中,影响收入(因变量y)的 自变量不止1个,因此,必须引入多元回归模型。 在该次分析中,首先利用相关系数分析,对所有 影响因素进行筛选, 即:选取1≥ID( ,y)≥0.9和一0.9≥ID( , y)≥一1的因素进行分析。 示例如下:变量VAR00094为业务的收入,变量 vAR00018为某省国民经济和社会发展总量与速度 指标——财政支出总额。

数据挖掘的六步法数据挖掘是从大量的数据中自动提取出有用信息的技术。

它的应用范围包括:商业、医疗、金融、政府等各个领域。

数据挖掘的成功与否,很大程度上取决于使用的方法和技巧。

在这篇文章中,我们将介绍一种经典的数据挖掘方法,即六步法。

第一步:问题定义在进行数据挖掘前,我们需要明确要解决的问题,并对问题进行定义。

这个步骤非常重要,因为在整个数据挖掘过程中,我们都需要以这个问题为导向,不断迭代调整模型,直到达到最终的目标。

例如,我们要构建一个预测房价的模型,那么我们需要明确问题的定义:预测房价的结果需要有多大的误差范围?预测结果需要具备多高的准确性?这些问题的定义将直接影响我们在后续步骤中进行的数据预处理和建模方法的选择。

第二步:数据收集在进行数据挖掘之前,我们需要收集有关问题的数据。

数据的来源可以是公司内部的数据库,也可以是公共数据集。

无论哪种方式,我们需要仔细选择数据集,保证其准确度、完整度和可靠性。

例如,在预测房价的案例中,我们可以收集包括房屋面积、房龄、地理位置等在内的相关数据。

这些数据将帮助我们建立一个预测模型。

第三步:数据预处理在对数据进行分析前,我们需要对数据进行预处理。

数据预处理包括:数据清洗、数据集成、数据转换和数据规约。

数据清洗:处理缺失值、异常值和重复值。

这样,我们可以保证数据的准确性和完整性。

数据集成:将多个数据集合并起来,生成一个新的数据集。

这样做可以帮助我们更全面地了解数据。

数据转换:将数据转换为使用的格式。

例如,将所有字符型变量转换为数值型变量。

数据规约:简化数据,去除噪声。

第四步:模型构建在完成数据预处理后,我们可以开始构建模型。

模型可以基于统计学方法、机器学习方法或人工智能方法。

例如,在预测房价的案例中,我们可以使用线性回归模型、决策树模型、神经网络模型等方法建立模型。

第五步:模型评估在构建模型后,我们需要对模型进行评估和优化。

这一步骤可以帮助我们了解模型的表现,以及如何改进模型的性能。

一、数据预处理1)数据清洗(主要用于填补数据记录中的遗漏数据,识别异常数据,以及纠正数据中的不一致问题):①遗漏数据处理:忽略该条记录(遗漏比例较大时不很有效),手工填补遗漏值(大规模数据可行性差),利用缺省值填补遗漏值,利用均值填补遗漏值,利用同类别均值填补遗漏值(尤其在进行分类挖掘时),利用最可能的值填补遗漏值(可以利用回归分析、贝叶斯计算公式或决策树推断出该条记录特定属性的最大可能的取值,最常用)②噪声数据处理:Bin方法,聚类方法,人机结合检查方法,回归方法(如线性回归方法,多变量回归方法)③不一致数据处理:2)数据集成处理(来自多个数据源的数据):模式集成,冗余问题(冗余属性),数据值冲突检测与消除3)数据转换处理(用于将数据转换成适合数据挖掘的形式):平滑处理(bin方法,聚类方法,回归方法),合计处理,数据泛化处理,规格化(最大最小规格化方法,零均值规格化方法,十基数变换规格化方法),属性构造,4)数据消减:数据立方合计(主要用于构造数据仓库操作),维数消减(主要用于检测和消除无关、弱相关、或冗余的属性),数据压缩(利用编码技术压缩数据集的大小,方法:小波分析(更适合对高维数据进行处理变换),主要素分析(PCA)(能较好地处理稀疏数据)),数据块消减(利用更简单的数据表达形式来取代原有的数据如:参数模型(如线性回归模型),非参数模型(聚类、采样[SRSWOR方法,SRSWR方法,聚类采样方法,分层采样方法]、直方图(等宽方法,等高方法,V-Optimal方法,MaxDiff方法)等)),离散化与概念层次生成5)离散化和概念层次树生成:数值概念层次树生成(Bin方法,直方图方法,聚类分析方法,基于熵的离散化方法,自然划分分段方法(3-4-5规则)),类别概念层次树生成二、数据泛化1)数据立方方法(OLAP方法)2)基于属性的归纳方法(AOI方法)三、属性相关分析属性相关分析过程:数据收集,利用保守AOI方法进行属性相关分析,利用所确定评估标准评估每个初选后的属性,消除无关或弱相关的属性,利用AOI方法生成概念描述四、分类与预测。

数据挖掘始于20世纪90年代,它的发展伴随着数据存储成本的下降以及数据量

的高速的增长。数据挖掘的理论基础是统计学,回归分析是统计学上非常重要的

分析手段。数据挖掘的主要目的是要建立有效的模型,人们能够在模型中发现一

些曾经无法解读或是忽略的信息。好的模型能够彻底改变人们对 数据的解读方

法以及未来利用数据的方法。数据挖掘 技术发展至今已有一些较为成熟的方法,

在解决实际 问题中,最主要的是确定该用哪种方法以及如何改进 这些方法,从

而能够更好的依据具体情况来进行数据 挖掘,这极大的依赖以往实践的经验。

在建立模型后, 还需对模型进行测试与改进,以期能更好的面对未来 数据。数

据挖掘同时是大数据技术的基础,是未来数 据处理研究的主要发展方向。

数据挖掘(Data Mining)是从大量的、不完全的、有噪声的、模糊的、模糊的、随机的数据中

提取隐含在其中的、人们事先不知道的、但又是潜在有用的信息和知识的过程。随着信息技

术的高速发展,人们积累的数据量急剧增长,动辄以TB计,如何从海量的数据中提取有用

的知识成为当务之急。数据挖掘就是为顺应这种需要应运而生发展起来的数据处理技术。是

知识发现(Knowledge Discovery in Database)的关键步骤。其中回归分析就是数据挖掘方法

中统计方法算法之一,它就是用回归方程来表示变量间的数量关系

数据挖掘在电子商务中的应用是一个将信息转化为商业知识的过程。首先,明确数据挖掘的

对象,确定商业应用主题。其次,围绕商业主题收集数据源,并对数据进行清理、转换、集

成等技术处理,装载进入数据仓库,并选取合适的数据挖掘算法,构建数据挖掘模型,从目

标数据中提取有价值的商业知识,包括商业规则、模式、模型和图表等。对结果进行分析和

验证,调整数据挖掘模型,从而保证结果的可靠性和实用性。最后,将商业知识集成到电子

商务中心,融合专家知识与领域规则,为商业活动提供决策支持,如图1所示。

通过对这些数据的存储、运算、管理以及分析,除了用以优化自身的界面、服务、管理和产品之外,淘宝

还可以对外提供至少三类具备极大商业价值的数据与信息。第一类是针对消费者,方便其购物与消费的数

据信息,包括各类商品及店铺信息、促销信息等;第二类是针对店铺以及卖方,可有效提升其店铺管理及

商品销售效果的数据信息,包括消费者的消费行为、网络使用行为、媒体接触及使用行为,市场发展及行

业竞争数据与信息等;第三类是可以提供给社会及第三方机构帮助其了解电商企业以及淘宝相关的数据集

信息,包括销售数据、购买数据、交易数据、消费者行为数据等。

在市场的经济活动中,经常会遇到某一市场现象的发展和变化取决于几个影响因素的情况,也就是一个因

变量和几个自变量有依存关系的情况。而且有时几个影响因素主次难以区分,或者有的因素虽属次要,但

也不能略去其作用。例如,某一商品的销售量既与人口的增长变化有关,也与商品价格变化有关。这时采

用一元回归分析预测法进行预测是难以奏效的,需要采用多元回归分析预测法。

多元回归分析预测法,是指通过对两上或两个以上的自变量与一个因变量的相关分析,建立预测模型

进行预测的方法。当自变量与因变量之间存在线性关系时,称为多元线性回归分析。

这种技术通常用于预测分析,时间序列模型以及发现变量之间的因果关系。例如,司机

的鲁莽驾驶与道路交通事故数量之间的关系,最好的研究方法就是回归

在这五个步骤中,模式化是数据挖掘的核心,用的最广泛又最为经典的模式

化方法当数数理统计分析,一般情况下,在数据库或数据仓库字段之间存在两种

关系:函数关系(能用函数公式表示的确定关系)和相关关系(不能用函数公式

表示,但仍是相关确定关系),对它们可进行回归分析、相关分析、主成分分析。

3.2 数据挖掘模型的建立