Ch5状态空间搜索策略

- 格式:ppt

- 大小:4.95 MB

- 文档页数:53

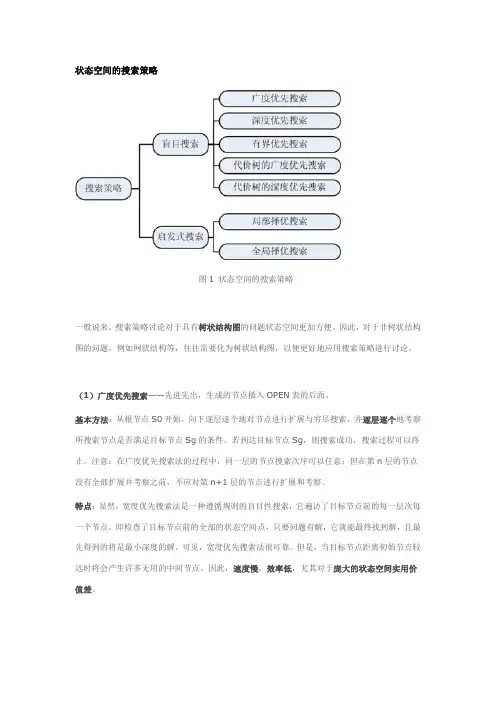

状态空间的搜索策略图1 状态空间的搜索策略一般说来,搜索策略讨论对于具有树状结构图的问题状态空间更加方便。

因此,对于非树状结构图的问题,例如网状结构等,往往需要化为树状结构图,以便更好地应用搜索策略进行讨论。

(1)广度优先搜索——先进先出,生成的节点插入OPEN表的后面。

基本方法:从根节点S0开始,向下逐层逐个地对节点进行扩展与穷尽搜索,并逐层逐个地考察所搜索节点是否满足目标节点Sg的条件。

若到达目标节点Sg,则搜索成功,搜索过程可以终止。

注意:在广度优先搜索法的过程中,同一层的节点搜索次序可以任意;但在第n层的节点没有全部扩展并考察之前,不应对第n+1层的节点进行扩展和考察。

特点:显然,宽度优先搜索法是一种遵循规则的盲目性搜索,它遍访了目标节点前的每一层次每一个节点,即检查了目标节点前的全部的状态空间点,只要问题有解,它就能最终找到解,且最先得到的将是最小深度的解。

可见,宽度优先搜索法很可靠。

但是,当目标节点距离初始节点较远时将会产生许多无用的中间节点。

因此,速度慢,效率低,尤其对于庞大的状态空间实用价值差。

(2)深度优先搜索——后进先出,生成的节点插入OPEN表的前面。

基本方法:从根节点S0开始,始终沿着纵深方向搜索,总是在其后继子节点中选择一节点来考察。

若到达目标节点Sg,则搜索成功;若不是目标节点,则再在该节点的后继子节点中选一考察,一直如此向下搜索,直到搜索找到目标节点才停下来。

若到达某个子节点时,发现该节点既不是目标节点又不能继续扩展,就选择其兄弟节点再进行考察。

依此类推,直到找到目标节点或全部节点考察完毕,搜索过程才可以终止或结束。

特点:方式灵活,规则易于实现,对于有限状态空间并有解时,必能找到解。

例如,当搜索到某个分支时,若目标节点恰好在此分支上,则可较快地得到解。

故在一定条件下,可实现较高求解效率。

但是,在深度优先搜索中,一旦搜索进入某个分支,就将沿着该分支一直向下搜索。

这时,如果目标节点不在此分支上,而该分支又是一个无穷分支,则就不可能得到解。

强化学习(Reinforcement Learning)是一种机器学习方法,其目标是通过与环境的交互学习最优的行为策略。

在强化学习中,智能体通过与环境的互动,尝试不同的行为,并根据环境的反馈来调整自己的策略,使得在未来能够获得更高的奖励。

强化学习算法中的策略搜索方法是其中的重要组成部分,它涉及到如何在策略空间中寻找最优的策略。

本文将详细介绍强化学习算法中的策略搜索方法。

在强化学习中,智能体通过与环境的交互来学习最优的策略。

其中,策略是指智能体在每个状态下选择不同行为的概率分布。

策略搜索方法就是寻找最优的策略。

在强化学习中,有两种主要的策略搜索方法:基于值函数的方法和基于策略梯度的方法。

基于值函数的方法是一种通过估计值函数来寻找最优策略的方法。

值函数表示在每个状态下选择不同行为所能获得的期望回报。

通过估计值函数,智能体可以选择在每个状态下能够获得最大回报的行为,从而找到最优的策略。

值函数的估计可以通过动态规划、蒙特卡洛方法或者时序差分方法来实现。

这种方法的优点是可以稳定地找到最优策略,但是在策略空间较大时,计算复杂度会很高。

基于策略梯度的方法是一种直接优化策略参数的方法。

它通过不断调整策略参数来最大化长期回报。

在这种方法中,智能体通过采样的方式来估计策略的梯度,并通过梯度上升法来更新策略参数。

这种方法的优点是可以处理高维、连续的策略空间,并且可以直接优化策略,但是其收敛性和稳定性较差。

除了以上两种主要的策略搜索方法外,还有一些其他的策略搜索方法,如进化策略、遗传算法等。

这些方法通过模拟生物进化的过程来搜索最优策略,通常适用于高维、非线性的策略空间。

在实际应用中,不同的策略搜索方法适用于不同的问题和环境。

基于值函数的方法适用于状态空间较小、离散的环境,而基于策略梯度的方法适用于状态空间较大、连续的环境。

此外,进化策略等方法适用于需要全局搜索的问题。

总之,强化学习算法中的策略搜索方法是寻找最优策略的关键步骤之一。