条件概率密度函数的最大似然估计

- 格式:ppt

- 大小:1.98 MB

- 文档页数:26

条件概率与似然函数的关系概率统计是现代统计学的基础,其中条件概率和似然函数是两个重要的概念。

它们在统计推断、机器学习和数据分析等领域中发挥着重要作用。

本文将探讨条件概率与似然函数的关系,以及它们在实际问题中的应用。

条件概率是指在已知某个事件发生的条件下,另一个事件发生的概率。

用数学符号表示为P(A|B),表示在事件B已经发生的情况下,事件A发生的概率。

条件概率的计算可以通过贝叶斯定理来实现,即P(A|B) = P(B|A) * P(A) / P(B)。

其中,P(B|A)表示在事件A发生的条件下事件B发生的概率,P(A)和P(B)分别表示事件A和事件B 发生的概率。

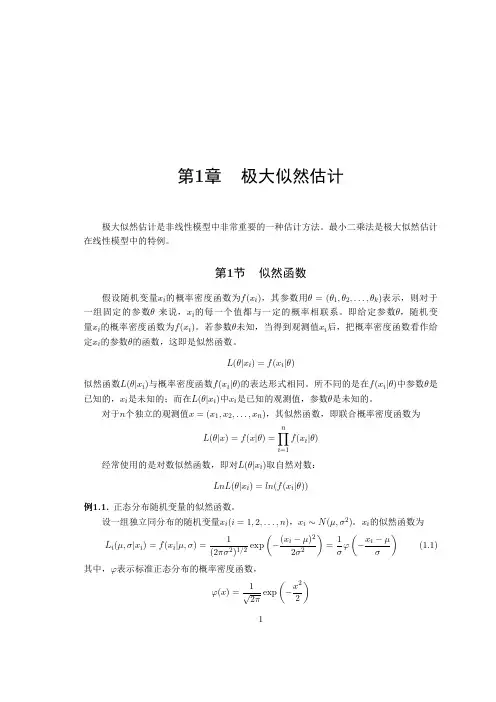

似然函数是统计学中用于估计模型参数的重要工具。

它表示在给定观测数据的条件下,模型参数的可能性。

似然函数通常用L(θ|X)表示,其中θ表示模型的参数,X表示观测数据。

似然函数的计算可以通过将观测数据代入概率密度函数(或概率质量函数)来实现。

似然函数的值越大,表示给定数据下模型参数的可能性越大。

条件概率和似然函数之间存在一定的关系。

实际上,条件概率可以看作是似然函数的一种特殊形式。

具体来说,当我们将条件概率P(A|B)看作是在已知事件B的条件下,事件A的似然函数L(A|B)时,两者的计算方式是相同的。

因此,条件概率和似然函数是密切相关的,可以互相转化和使用。

条件概率和似然函数在实际问题中有着广泛的应用。

在统计推断中,我们常常需要根据观测数据来估计模型的参数。

这时,我们可以通过最大似然估计的方法来选择使得似然函数最大化的参数值。

这相当于选择使得在给定观测数据条件下模型参数最有可能的取值。

而条件概率则可以用来解释给定某些条件下,某个事件发生的可能性。

在机器学习中,条件概率和似然函数也扮演着重要角色。

例如,在分类问题中,我们常常需要根据已知的特征信息来判断某个样本属于哪个类别。

这时,我们可以使用条件概率来计算在给定特征条件下,样本属于各个类别的概率,并选择概率最大的类别作为预测结果。

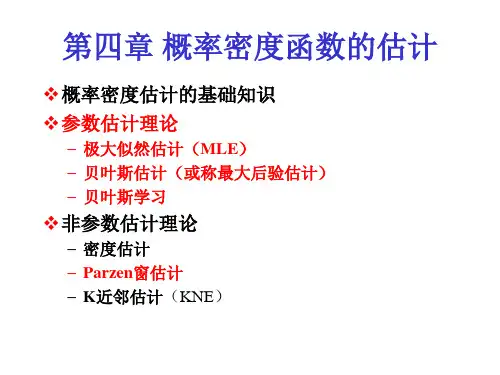

概率密度函数及稳定性计算稳定性是指在其中一种条件下,随机变量的特征是否保持不变。

稳定性计算常常用于研究时间序列的性质,比如随机变量之间的相关性和队列的稳定性等。

最小二乘法是一种常用的拟合方法,通过将实际观测值和拟合值之间的平方差最小化来确定概率密度函数的参数。

在计算概率密度函数时,我们首先需要选择一个函数形式,并确定参数的初值。

然后,我们通过最小二乘法来不断调整参数,直到我们得到最优的参数估计。

最大似然估计法是另一种常用的概率密度函数计算方法。

在最大似然估计法中,我们假设观测值是从一些特定的概率密度函数中独立地抽取得到的。

然后,我们通过最大化似然函数来确定概率密度函数的参数。

最大似然估计法通常是求解一个非线性方程组的优化问题,可以使用数值方法进行计算。

稳定性的计算是通过观察随机变量的序列和特性来确定的。

稳定性的度量可以通过相关性、方差和均值等指标来计算。

常见的稳定性计算方法包括平稳性检验、相关系数计算和时间序列模型拟合等。

平稳性检验是判断时间序列是否具有稳定性的常用方法之一、平稳性检验通常基于对时间序列的自相关性、偏自相关性和白噪声的检验。

常见的平稳性检验方法包括Augmented Dickey-Fuller检验、协整检验和单位根检验等。

相关系数计算是另一种常用的稳定性计算方法。

相关系数用来度量两个随机变量之间的线性关系。

常见的相关系数包括皮尔逊相关系数和斯皮尔曼等级相关系数。

相关系数范围为-1到1,当相关系数为0时表示两个变量之间不存在线性关系。

时间序列模型拟合是一种常用的稳定性计算方法。

时间序列模型可以用来预测未来的观测值,并判断序列的稳定性。

常见的时间序列模型包括自回归移动平均模型(ARMA)、自回归模型(AR)和移动平均模型(MA)等。

总结起来,概率密度函数及其稳定性计算是概率论和统计学中重要的概念和方法之一、概率密度函数的计算可以使用最小二乘法和最大似然估计法来完成,而稳定性的计算则可以通过平稳性检验、相关系数计算和时间序列模型拟合等方法进行。

最大似然估计(Maximum likelihood estimation)(通过例子理解)之前看书上的一直不理解到底什么是似然,最后还是查了好几篇文章后才明白,现在我来总结一下吧,要想看懂最大似然估计,首先我们要理解什么是似然,不然对我来说不理解似然,我就一直在困惑最大似然估计到底要求的是个什么东西,而那个未知数θ到底是个什么东西TT似然与概率在统计学中,似然函数(likelihood function,通常简写为likelihood,似然)是一个非常重要的内容,在非正式场合似然和概率(Probability)几乎是一对同义词,但是在统计学中似然和概率却是两个不同的概念。

概率是在特定环境下某件事情发生的可能性,也就是结果没有产生之前依据环境所对应的参数来预测某件事情发生的可能性,比如抛硬币,抛之前我们不知道最后是哪一面朝上,但是根据硬币的性质我们可以推测任何一面朝上的可能性均为50%,这个概率只有在抛硬币之前才是有意义的,抛完硬币后的结果便是确定的;而似然刚好相反,是在确定的结果下去推测产生这个结果的可能环境(参数),还是抛硬币的例子,假设我们随机抛掷一枚硬币1,000次,结果500次人头朝上,500次数字朝上(实际情况一般不会这么理想,这里只是举个例子),我们很容易判断这是一枚标准的硬币,两面朝上的概率均为50%,这个过程就是我们根据结果来判断这个事情本身的性质(参数),也就是似然。

结果和参数相互对应的时候,似然和概率在数值上是相等的,如果用θ 表示环境对应的参数,x 表示结果,那么概率可以表示为:P(x|θ)P(x|θ)是条件概率的表示方法,θ是前置条件,理解为在θ 的前提下,事件 x 发生的概率,相对应的似然可以表示为:理解为已知结果为 x ,参数为θ (似然函数里θ 是变量,这里## 标题 ##说的参数是相对与概率而言的)对应的概率,即:需要说明的是两者在数值上相等,但是意义并不相同,是关于θ 的函数,而 P 则是关于 x 的函数,两者从不同的角度描述一件事情。

最大似然估计法是一种可以用来估计参数的数学方法,它是统计学中

最常用的估计方法之一。

本文将介绍最大似然估计法解题的步骤。

第一步:确定似然函数。

最大似然估计法是一种在给定数据条件下求

取参数和特征值的估计方法,它将一个参数模型的似然函数定义为样

本数据的概率密度。

要确定这个似然函数,我们必须首先确定模型的

数学表达式,这一步是重要的,它将决定似然函数的形式,因此决定

最大似然估计法的参数模型。

第二步:求取参数的似然估计值。

在确定了似然函数后,我们就可以

计算出参数的似然估计值了。

由于模型中参数之间可能存在相关性,

这时就可以使用最大似然估计法来求解参数估计值。

最大似然估计值

就是求出似然函数概率密度最大值点所代表的参数值。

第三步:解释解决结果。

在获得了参数的似然估计值后,可以对拟合

后的结果进行解释,说明为什么模型准确地估计了参数值。

最后,最大似然估计是一种有效的数学方法,本文介绍了最大似然估

计法解题的步骤,也就是确定似然函数,求取参数的似然估计值,以

及解释解决结果。

并且,本文还强调了最大似然估计法的重要性和有

用性,在实际应用中,最大似然估计法可以给出准确可靠的估计结果。

最大似然估计公式了解最大似然估计的计算公式最大似然估计(Maximum Likelihood Estimation, MLE)是概率统计学中常用的一种参数估计方法,旨在通过大量观测数据,根据最有可能(最大似然)导致观测结果发生的参数值,来估计未知参数的值。

在概率模型中,假设数据服从某一分布,而最大似然估计能够找出使得观测数据出现概率最大的参数值。

一、最大似然估计的基本概念最大似然估计的基本思想是通过选择合适的参数值,使得观测数据出现的概率最大化。

在给定观测数据和参数模型的前提下,我们可以通过最大化似然函数来获得最可信的参数估计。

似然函数(Likelihood Function)是指在给定某个参数值的条件下,观测数据出现的可能性。

似然函数的计算公式如下:L(θ|x) = f(x|θ)其中,L代表似然函数,θ代表参数值,x代表观测数据。

f(x|θ)表示基于参数θ的概率密度函数或概率质量函数。

似然函数的求解就是寻找使得给定观测数据出现概率最大的参数值。

二、最大似然估计的计算公式在进行最大似然估计时,我们通常需要计算似然函数的极大值点。

为了简化计算,我们常使用对数似然函数(Log-Likelihood Function)来替代似然函数。

对数似然函数的计算公式如下:ln L(θ|x) = Σ ln f(xi|θ)其中,ln表示自然对数,Σ表示求和运算。

ln L(θ|x)表示对数似然函数,xi表示第i个观测数据。

利用对数似然函数,最大似然估计的目标就是寻找使得对数似然函数最大的参数估计值。

为了找到使对数似然函数最大的参数值,我们需要采用数值优化的方法,例如梯度下降法或牛顿法等。

三、最大似然估计的应用最大似然估计广泛应用于各个领域的数据建模和参数估计中。

以下是最大似然估计在常见概率模型中的应用实例:1. 二项分布:最大似然估计可以用于估计二项分布的参数p,即成功的概率。

在伯努利试验或二项试验中,成功与失败的结果按独立的概率p和1-p发生。

最大似然估计算法最大似然估计(Maximum Likelihood Estimation, MLE)是一种常用的参数估计方法,广泛应用于统计学和机器学习领域。

它基于概率论的理论基础,通过寻找使得观测数据出现的概率最大的参数值,来估计未知的参数。

1.定义似然函数:假设观测数据是从一个概率分布中生成的,我们需要定义一个参数化的概率分布,并将数据带入概率分布中。

这个概率分布通常是一个概率密度函数(对连续变量)或概率质量函数(对离散变量)。

2.建立似然函数:将观测数据的概率密度函数(或概率质量函数)表达式,带入参数化概率分布中,得到关于参数的函数。

这个函数称为似然函数。

3.计算似然函数的对数:为了方便计算和分析,通常会计算似然函数的对数,这样可以将乘积转化为求和,且便于计算导数。

4.极大化似然函数:通过求解似然函数的极值问题,找到使得似然函数取得最大值时的参数值,这个参数值称为最大似然估计量,通常用θ^表示。

5.参数估计:得到最大似然估计量后,我们就可以用它来估计未知参数的值。

最大似然估计的重要性在于它具有很好的统计性质,例如一致性和渐近正态性。

一致性指的是当样本量趋近于无穷时,最大似然估计量会以概率1收敛到真实参数值。

渐近正态性则是指当样本量足够大时,最大似然估计量的分布近似服从高斯分布。

这些性质使得最大似然估计成为了一种广泛使用的参数估计方法。

最大似然估计在实际应用中有很多应用,例如线性回归、逻辑回归和混合高斯模型等。

最大似然估计也可以通过解析解或者数值优化的方法来求解。

对于简单的问题,通常可以通过求导数等条件来解析求解,而对于复杂的问题,通常需要借助数值优化算法。

总结起来,最大似然估计是一种常用的参数估计方法,通过最大化观测数据出现的概率来估计未知参数。

它具有良好的统计性质并广泛应用于统计学和机器学习领域。

mlem迭代重建算法引言:mlem(最大似然期望最大化)算法是一种用于图像重建的迭代算法。

它基于最大似然估计的原理,通过迭代的方式逐步优化图像重建结果。

本文将介绍mlem算法的原理和应用,并探讨其优点和局限性。

一、mlem算法原理mlem算法是一种基于统计学原理的图像重建方法,其核心原理是最大似然估计。

该方法通过估计图像在给定投影数据下的条件概率密度函数,来重建原始图像。

mlem算法将图像重建问题转化为一个优化问题,通过迭代的方式逐步优化图像重建结果。

具体而言,mlem算法的步骤如下:1. 初始化图像重建结果为一个与原始图像大小相同的全零矩阵;2. 根据初始化的图像重建结果,计算出给定投影数据下的条件概率密度函数;3. 使用条件概率密度函数对投影数据进行估计,得到当前迭代下的重建图像;4. 更新图像重建结果,将当前迭代下的重建图像作为下一次迭代的初始值;5. 重复步骤2~4,直到满足停止准则。

二、mlem算法应用mlem算法在医学影像领域得到了广泛的应用。

例如,它可以用于X射线计算机断层扫描(CT)图像的重建。

在CT图像重建中,mlem算法可以根据投影数据估计出患者体内的组织密度分布,从而重建出高质量的CT图像。

mlem算法还可以应用于其他领域的图像重建问题,如核磁共振成像(MRI)和正电子发射断层扫描(PET)等。

在这些应用中,mlem算法可以根据不同的投影数据和重建模型,实现对原始图像的准确重建。

三、mlem算法优点mlem算法具有以下几个优点:1. 算法原理简单:mlem算法基于最大似然估计原理,理论基础坚实,易于理解和实现。

2. 精度高:mlem算法通过迭代优化的方式,逐步提高图像重建的精度,能够得到较为准确的重建结果。

3. 可适应不同场景:mlem算法可以根据不同的投影数据和重建模型,适应不同的图像重建问题,具有一定的灵活性和通用性。

4. 并行计算能力强:mlem算法的迭代过程可以并行计算,可以利用多核处理器或分布式计算平台加速计算过程。