概率密度函数的估计

- 格式:pdf

- 大小:455.64 KB

- 文档页数:27

分布函数与概率密度函数的参数估计方法在概率统计学中,分布函数和概率密度函数是用来描述随机变量的性质的重要工具。

而参数估计则是根据给定的样本数据,通过某种方法对分布函数和概率密度函数中的未知参数进行估计的过程。

本文将介绍分布函数与概率密度函数的参数估计方法,包括最大似然估计、矩估计以及贝叶斯估计。

最大似然估计(Maximum Likelihood Estimation,MLE)是一种常用的参数估计方法。

其核心思想是选择使得给定数据样本出现概率最大的参数值作为估计值。

对于给定的样本数据x1,x2,…,xn,假设其分布函数为F(x;θ),其中θ为未知参数。

最大似然估计的目标是找到使得样本数据出现概率最大的参数值θ^。

具体来说,最大似然估计通过对似然函数L(θ)=∏(i=1)^n f(xi;θ)(其中f(x;θ)为概率密度函数)取对数,并对参数θ进行求导来求解参数值θ^。

矩估计(Method of Moments,MoM)是另一种常用的参数估计方法。

其基本原理是利用样本矩与理论分布矩的对应关系进行参数估计。

对于给定的样本数据x1,x2,…,xn,假设其概率密度函数为f(x;θ),其中θ为未知参数。

矩估计的目标是使样本矩与理论矩之间的差异最小化,即找到使得原始矩和样本矩最接近的参数值θ^。

除了最大似然估计和矩估计之外,贝叶斯估计(Bayesian Estimation)是一种基于贝叶斯理论的参数估计方法。

其核心思想是将未知参数视为一个随机变量,并基于先验分布和样本数据来求得后验分布。

贝叶斯估计不仅考虑了样本数据的信息,还考虑了先验信息的影响,因此对于样本数据较少或者不确定性较高的情况下,贝叶斯估计能够提供更稳健的参数估计结果。

总结起来,分布函数与概率密度函数的参数估计方法主要包括最大似然估计、矩估计和贝叶斯估计。

最大似然估计通过最大化样本数据出现的概率来估计参数,矩估计通过比较样本矩和理论矩之间的差异来估计参数,而贝叶斯估计则综合考虑了先验分布和样本数据来求得后验分布。

概率密度估计

1 概率密度估计

概率密度估计(Probability Density Estimation,简称PDE)也称为密度函数估计,旨在描述一个随机变量X的概率密度函数,从而

帮助准确定量分析研究变量X的特征。

通常,概率密度估计的过程可以分解为两个步骤。

第一步是从样

本中提取该变量的直方图,然后以某种函数形式拟合该直方图,得到

其对应的概率密度函数。

其中,最常用的函数形式为高斯分布(Gaussian Distribution)的普通分布、泊松分布(Poisson Distribution)、多元正态分布(Multivariate Normal Distribution)、双截止分布(Binomial Distribution)、逻辑正态

分布(Log-normal Distribution)等。

第二步就是根据拟合出概率密度函数形状,运用其特点和参数,

得到该变量的最佳估计,便于对样本进行更有效率的分析。

比如,在

高斯分布模型下,样本拟合出的方差可以帮助我们判断数据的稳定性。

概率密度估计被广泛应用于贝叶斯统计分析、学习理论、社会科

学研究等,是发现重要模式并探寻变量分布的重要工具。

总之,概率密度估计是一项核心重要的数据分析技术,其解释力、拟合能力和模型大小的理论基础为研究者们收集总结数据,比较复杂

的变量特征提供了可靠信息。

概率密度函数及稳定性计算稳定性是指在其中一种条件下,随机变量的特征是否保持不变。

稳定性计算常常用于研究时间序列的性质,比如随机变量之间的相关性和队列的稳定性等。

最小二乘法是一种常用的拟合方法,通过将实际观测值和拟合值之间的平方差最小化来确定概率密度函数的参数。

在计算概率密度函数时,我们首先需要选择一个函数形式,并确定参数的初值。

然后,我们通过最小二乘法来不断调整参数,直到我们得到最优的参数估计。

最大似然估计法是另一种常用的概率密度函数计算方法。

在最大似然估计法中,我们假设观测值是从一些特定的概率密度函数中独立地抽取得到的。

然后,我们通过最大化似然函数来确定概率密度函数的参数。

最大似然估计法通常是求解一个非线性方程组的优化问题,可以使用数值方法进行计算。

稳定性的计算是通过观察随机变量的序列和特性来确定的。

稳定性的度量可以通过相关性、方差和均值等指标来计算。

常见的稳定性计算方法包括平稳性检验、相关系数计算和时间序列模型拟合等。

平稳性检验是判断时间序列是否具有稳定性的常用方法之一、平稳性检验通常基于对时间序列的自相关性、偏自相关性和白噪声的检验。

常见的平稳性检验方法包括Augmented Dickey-Fuller检验、协整检验和单位根检验等。

相关系数计算是另一种常用的稳定性计算方法。

相关系数用来度量两个随机变量之间的线性关系。

常见的相关系数包括皮尔逊相关系数和斯皮尔曼等级相关系数。

相关系数范围为-1到1,当相关系数为0时表示两个变量之间不存在线性关系。

时间序列模型拟合是一种常用的稳定性计算方法。

时间序列模型可以用来预测未来的观测值,并判断序列的稳定性。

常见的时间序列模型包括自回归移动平均模型(ARMA)、自回归模型(AR)和移动平均模型(MA)等。

总结起来,概率密度函数及其稳定性计算是概率论和统计学中重要的概念和方法之一、概率密度函数的计算可以使用最小二乘法和最大似然估计法来完成,而稳定性的计算则可以通过平稳性检验、相关系数计算和时间序列模型拟合等方法进行。

概率密度估计置信区间

概率密度估计的置信区间是用来描述对真实概率密度函数进行估计时的不确定性范围。

一般情况下,我们使用统计方法对数据进行分析,并根据样本数据来估计概率密度函数。

常用的概率密度估计方法包括核密度估计和参数估计。

在进行概率密度估计时,我们可以得到一个估计的概率密度函数。

然而,由于样本数据的有限性以及估计方法的不确定性,估计的概率密度函数可能与真实概率密度函数存在一定的偏差。

为了描述估计结果的不确定性,我们可以计算概率密度估计的置信区间。

置信区间是指对于给定置信水平(通常选择95%或99%),在重复抽样下,包含真实概率密度函数的区间的概率。

计算概率密度估计的置信区间需要考虑估计方法的方差以及样本数据的大小。

常见的计算方法包括基于正态分布近似的方法(如渐进法和Bootstrap法)以及基于非参数统计的方法(如Jackknife法和交叉验证法)。

总之,概率密度估计的置信区间提供了对估计结果的不确定性进行量化的方法,可以帮助我们评估概率密度估计的可靠性和稳定性。

1。

概率密度函数的估计与应用概率密度函数(probability density function,简称PDF)是概率论和数理统计中常用的概念,广泛应用于可变量的分布描述、数据拟合以及随机变量的概率计算中。

在实际应用中,我们经常用到概率密度函数的估计,以求得随机变量的分布特征和统计学参数,从而为数据分析和建模提供有力支撑。

一、概率密度函数的基本概念及分布函数概率密度函数是描述随机变量取值的概率分布的一种数学模型。

简单来说,概率密度函数是一个连续函数,其在某个点的导数表示该点处的概率密度,对于某个区间上的积分则表示该区间内的概率和。

当随机变量服从某一分布时,我们可以通过该分布的概率密度函数来描述其分布特征。

分布函数是概率密度函数的一个相关概念,其所描述的是随机变量取值在某一范围内的累积概率。

与概率密度函数不同的是,分布函数是一个非降的右连续函数,其在某一点的最左极限为该点处的概率。

二、概率密度函数的估计方法根据大数定律和中心极限定理,我们可以利用样本数据来对总体的概率密度函数进行估计。

这里介绍两种常用的概率密度函数估计方法,分别是核密度估计和最大似然估计。

1. 核密度估计核密度估计将样本数据和一个给定的核函数结合起来,通过计算核函数在每个观测值处的值和分布范围,得到在该点处的概率密度函数估计值。

核密度估计的优点在于其所得到的概率密度函数是一个连续函数,并且无需对数据做出具体的分布假设。

2. 最大似然估计最大似然估计是一种常用的参数估计方法,其原理是选择某个分布参数(如均值、方差、形状参数等),使得样本数据在该分布下的概率最大。

对于正态分布、指数分布等常见分布,最大似然估计具有较好的稳健性和准确性。

三、概率密度函数的应用概率密度函数的应用十分广泛,下面将简单介绍几个常见的应用场景。

1. 数据拟合在数据分析和建模中,常常需要使用概率密度函数来对数据进行拟合。

通过使用不同的概率密度函数,可以描述不同类型的随机变量,如正态分布、指数分布、泊松分布等。

概率密度函数的估计非参数估计概率密度函数(Probability Density Function, PDF)的估计是统计学中一项重要的任务,用于描述随机变量的概率分布。

这是一种非参数估计方法,即不对概率分布函数做任何假设,而是通过对样本数据进行分析来估计其分布。

这种非参数估计方法的优点之一是其灵活性,可以应用于各种类型的数据分布。

而参数估计方法则需要对分布函数做出假设,如果假设不合理,估计结果可能会产生偏差。

非参数估计方法通常涉及以下步骤:1.数据收集:从样本数据中获取一组观测值。

2.直方图估计:直方图是一种用于表示数据分布的图形,可以将数据集划分为若干个区间,并计算每个区间内的观测值数量。

通过对直方图进行归一化,可以获得概率密度函数的估计。

3.核密度估计:核密度估计是一种将每个观测值都视为一个概率密度函数的方法。

在估计过程中,为每个观测值放置一个核函数,并对所有核函数求和得到概率密度函数的估计。

4.非参数回归:非参数回归是一种使用滑动窗口来减小噪声的方法。

在非参数回归中,通过在每个数据点周围放置一个窗口,并计算窗口内数据点的平均值或加权平均值来估计概率密度函数。

以上方法都可以用来估计概率密度函数,具体选择哪种方法取决于数据的特点和假设。

非参数估计方法有以下优点:1.适用广泛:非参数估计方法不需要对概率分布函数做出任何假设,因此可以适用于各种类型的数据分布。

2.灵活性:非参数估计方法可以避免对数据分布做出错误的假设,因此对于未知的数据分布可以获得较好的估计。

3.鲁棒性:非参数估计方法对噪声和异常值相对较为鲁棒,不会对这些因素产生过大的影响。

然而,非参数估计方法也存在一些缺点:1.计算复杂度高:非参数估计方法通常需要大量的计算来获得准确的估计结果。

2.模型选择困难:由于非参数估计方法没有对概率分布做出假设,因此对于模型的选择可能比较困难。

在实际应用中,非参数估计方法常常结合参数估计方法使用。

参数估计方法可以提供一些假设的分布函数,而非参数估计方法可以通过对残差分布进行检验来判断假设是否合理。

概率密度函数的估计参数估计概率密度函数(Probability Density Function,简称PDF)是概率统计学中一个非常重要的概念,用于描述连续随机变量的概率分布情况。

参数估计是统计学中一个关键的问题,它指的是通过样本数据来估计总体分布的参数。

本文将对概率密度函数的参数估计方法进行详细介绍。

一、参数估计的目标参数估计的目标是找到一组最合适的参数值,使得概率密度函数能够较好地拟合样本数据分布。

一般来说,参数估计可以分为两种类型:点估计和区间估计。

点估计是指利用样本数据直接估计出概率密度函数的参数值,而区间估计则是对参数进行区间估计,给出一个参数取值的范围。

二、点估计的方法1. 最大似然估计(Maximum Likelihood Estimation,简称MLE)最大似然估计是一种常用的参数估计方法,其基本思想是寻找一组参数值,使得样本观测值出现的概率最大。

对于给定的样本数据,若假设一个概率分布模型,并通过极大化似然函数来求解参数值,就得到了最大似然估计。

2. 矩估计(Moment Estimation)矩估计是通过样本矩直接估计总体矩的方法。

对于连续型分布而言,可以通过样本矩来估计分布的矩,从而得到参数的估计值。

3. 最大后验概率估计(Maximum A Posteriori Estimation,简称MAP)最大后验概率估计是贝叶斯估计的一种特殊情况,其基本思想是在最大化后验概率与似然函数的乘积,从而得到参数的估计值。

相对于最大似然估计,最大后验概率估计将先验分布考虑在内,可以有效地克服样本容量小引起的估计不准的问题。

三、区间估计的方法1. 置信区间估计(Confidence Interval Estimation)置信区间估计是通过样本数据计算出一个参数的区间估计范围,其置信水平表征了参数估计值位于置信区间内的可能性大小。

常用的置信区间估计方法有:正态分布置信区间估计、大样本置信区间估计、Bootstrap置信区间估计等。

解:最大似然估计:总体分布密度为N (),1μ,21σ=,估计量为μ 对数似然函数为()()1ln |Nk k H P x μμ==∑其中()()21|]2k k P x x μμ=-- ∴()()2111[ln 2]22Nk K H x μπμ==∑--- 解得:11N i i x N μ∧==∑贝叶斯估计:()~(0,1)P N μ总体分布密度为(,1)N μ由公式可知,μ的估计值为011111N k k N x N N N μμ∧==∑+++ 因为00μ= ∴111111N N k k k k N x x N N N μ∧===∑=∑++ ∴贝叶斯估计值为111Nk k x N μ∧==∑+解:{}12,N x x x x =1(,)(1)x x f x p p p -=-∴对数似然估计函数为111()ln (1)ln ln(1)1k k N N x x k k k p H p p p x N p p -===∑-=∑+-- 对p 求导有:1()111[]11N k k dH p x N dp p p p ==∑-+-- 求极值有:11(1)1Nkk N x p p p =∑=-- ∴11Nk k p x N ∧==∑ 最大似然估计为11N k k p x N ∧==∑解:由于损失函数为平方误差损失函数,因此由定理3.1()()||E x p x d θθθθθθ∧==⎰ 又根据题意,先验分布()()101f P P =<<,因此求得样本集的联合分布为: ()()()111||*1i i N N x x i i i f X P f x P P P -==⎡⎤==-⎣⎦∏∏ 记所有样本的和为1N i i S x ==∑,则有:()()|*1N S S f X P P P -=-根据贝叶斯公式,求得后验概率为:()()()()()()()()()10|**1*||**1*N S S N S Sf X P f P P P f P f P X f X P f P dP P P f P dP θ---==⎡⎤⎡⎤-⎣⎦⎣⎦⎰⎰注意到上式的分母为对P 的定积分,因此与P 无关,那么又由P 的贝叶斯估计量方程为: ()()10*|P P f P X dP ∧=⎰ 带入则有:()()()()()()111001**1**1*N S S N S P P P f P dP P P f P dP ∧-+-=--⎰⎰ 将()()101f P P =<<代入上式求积分,得:()()()()()(){}101111111000*1*111*1|*11N S S N S N S N S S S S P P f P dP P d P P P P P S S -----+++⎡⎤-=⎣⎦-=-+-+⎰⎰⎰ 重复进行上述变换,则得到两个积分项:()()()()()10!*1121N S S N S P P dP S S N --⎡⎤-=⎣⎦+++⎰ ()()()()()()110!*12312N S S N S P P dP S S N N -+-⎡⎤-=⎣⎦++++⎰ 因此求得P 的贝叶斯估计值为:11122N i i x S P S N ∧=++==++∑。

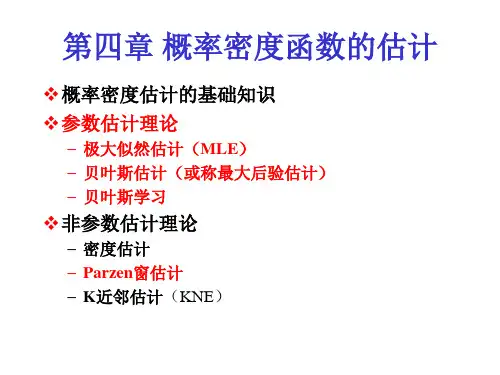

Xuegong Zhang, Tsinghua University贝叶斯决策: 已知)(i P ω和)|(i p ωx ,对未知样本分类(设计分类器) 实际问题: 已知一定数目的样本,对未知样本分类(设计分类器)怎么办? 一种很自然的想法:首先根据样本估计)|(i p ωx 和)(i P ω,记)|(ˆi p ωx 和)(ˆi P ω 然后用估计的概率密度设计贝叶斯分类器。

——(基于样本的)两步贝叶斯决策“模式识别基础”教学课件希望:当样本数∞→N 时,如此得到的分类器收敛于理论上的最优解。

为此, 需 )|()|(ˆi N i p pωωx x ⎯⎯→⎯∞→)()(ˆi N iP P ωω⎯⎯→⎯∞→ 重要前提:z 训练样本的分布能代表样本的真实分布,所谓i.i.d 条件 z 有充分的训练样本本章研究内容:① 如何利用样本集估计概率密度函数?Xuegong Zhang, Tsinghua University“模式识别基础”教学课件3.2参数估计的基本概念和方法 (part1)参数估计(parametric estimation):z已知概率密度函数的形式,只是其中几个参数未知,目标是根据样本估计这些参数的值。

几个名词:统计量(statistics):样本的某种函数,用来作为对某参数的估计θ∈参数空间(parametric space):待估计参数的取值空间ΘXuegong Zhang, Tsinghua University ② 各类样本集i X ,c i ,,1L =中的样本都是从密度为)|(i p ωx 的总体中独立抽取出来的,(独立同分布,i.i.d.)③ )|(i p ωx 具有某种确定的函数形式,只其参数θ未知 ④ 各类样本只包含本类分布的信息其中,参数θ通常是向量,比如一维正态分布),(21σµi N ,未知参数可能是⎥⎦⎤⎢⎣⎡=2i i i σµθ此时)|(i p ωx 可写成),|(i i p θωx 或)|(i p θx 。

“模式识别基础”教学课件鉴于上述假设,我们可以只考虑一类样本,记已知样本为{}N x x x ,,,21L =X似然函数(likelihood function ))|()|,,,()|()(121θθθθi Ni N x p x x x p p l ∏====L X—— 在参数θ下观测到样本集X 的概率(联合分布)密度基本思想:θθˆ=)(θlXuegong Zhang, Tsinghua University的解(必要条件)。

若未知参数不止一个,即Ts ],,,[21θθθθL =,记梯度算子Ts ⎥⎦⎤⎢⎣⎡∂∂∂∂∂∂=∇θθθθ,,,21L 则最大似然估计量的必要条件由S 个方程组成:0)(=∇θθH“模式识别基础”教学课件讨论:z 如果)(θl 或)(θH 连续可导,存在最大值,且上述必要条件方程组有唯一解,则其解就是最大似然估计量。

(比如多元正态分布)。

z 如果必要条件有多解,则需从中求似然函数最大者z 若不满足连续可导,则无一般性方法,用其它方法求最大(见课本均匀分布例)Xuegong Zhang, Tsinghua University 以单变量正态分布为例T ],[21θθθ=,µθ=1,22σθ= ⎥⎥⎦⎤⎢⎢⎣⎡⎟⎠⎞⎜⎝⎛−−=221exp 21)|(σµσπθx x p样本集 {}N x x x ,,,21L =X“模式识别基础”教学课件似然函数 )|()|()ln(1θθk Nk x p p x ∏===X对数似然函数 )|(ln )(ln )(1θθk N k x P x l H ∑===最大似然估计量θˆ满足方程 0)|(ln )(1=∇=∇∑=θθθθk Nk x p H而Xuegong Zhang, Tsinghua University解得k Nk x N∑===111ˆˆθµ2122)ˆ(1ˆˆµθσ−==∑=k Nk x N“模式识别基础”教学课件3.2 参数估计的基本概念和方法 (part2)3.2.2 贝叶斯估计和贝叶斯学习(一)贝叶斯估计思路与贝叶斯决策类似,只是离散的决策状态变成了连续的估计。

思考题:请课后与贝叶斯决策比较Xuegong Zhang, Tsinghua University 13损失函数:把θ估计为θ所造成的损失,记为),(θθλ期望风险:x x d d p R d E θθθθλΘ),(),ˆ(∫∫=x x x d d p p dEθθθθλΘ)()|(),ˆ(∫∫=x x x d p R dE)()|ˆ(θ∫=其中, dE =x ,Θθ∈“模式识别基础”教学课件条件风险:θθθθλθΘd p R )|(),ˆ()|ˆ(x x ∫=d E =x最小化期望风险 ⇒ 最小化条件风险 (对所有可能的x )有限样本集下,最小经经验风险:θθθθλθΘd p R )|(),ˆ()|ˆ(X X ∫=贝叶斯估计量:(在样本集X 下)使条件风险(经验风险)最小的估计量θˆ。

Xuegong Zhang, Tsinghua University15定理3.1 自学证明过程如果采用平方误差损失函数,则θ的贝叶斯估计量θˆ是在给定x 时θ的条件期望,即∫Θ==θθθθθd p E )|(]|[ˆx x同理可得到,在给定样本集X 下,θ的贝叶斯估计是:∫Θ==θθθθθd p E )|(]|[ˆX X “模式识别基础”教学课件求贝叶斯估计的方法:(平方误差损失下)(1)确定θ的先验分布 )(θp(2)求样本集的联合分布 )|()|(1θθi Ni p p x ∏==X(3)求θ的后验概率分布∫Θ=θθθθθθd p p p p p )()|()()|()|(X X X(4)求θ的贝叶斯估计量 ∫Θ=θθθθd p )|(ˆXXuegong Zhang, Tsinghua University 17(二)贝叶斯学习考虑学习样本个数N ,记样本集{}N x x x ,,,21L =X1>N 时有 )|()|()|(1θθθ−=N N Np p p XXx因此有递推后验概率公式:∫−−=θθθθθθd p p p p p N NN N N)|()|()|()|()|(11XXX xx“模式识别基础”教学课件设)()|(θθp p =°X ,则随着样本数增多,可得后验概率密度函数序列:)(θp ,)|(1x θp ,L ),,|(21x x θp—— 参数估计的递推贝叶斯方法(Recursive Bayes Incremental Learning ) 如果此序列收敛于以真实参数值为中心的δ函数,则称样本分布具有贝叶斯学习(Bayesian Learning )性质。

此时)()ˆ|()|(x x x p p p N ===∞→θθXXuegong Zhang, Tsinghua University 19“模式识别基础”教学课件估计量的性质与评价标准 —— 无偏性、有效性和一致性· 无偏性: θθ=)],,,(ˆ[21NE x x x L 渐近无偏性: θθ∞→=N NE ]ˆ[ · 有效性:对估计1ˆθ和2ˆθ,若方差)ˆ()ˆ(2212θσθσ<,则1ˆθ更有效· 一致性:0>∀ε,()0ˆlim =>−∞→εθθNN PXuegong Zhang, Tsinghua University 21),(~)(∑µN p x ∑==Ni i N11ˆx µ,∑=−−=∑Ni T i iN 1)ˆ)(ˆ(1ˆµµx x一维:∑==N i i x N 11ˆµ,∑=−=N i i x N 122)ˆ(1ˆµσ“模式识别基础”教学课件3.3.2 贝叶斯估计和贝叶斯学习示例(一)贝叶斯估计一维,),(~)|(2σµµN x p ,2σ已知,估计µ假设先验分布 ),(~)(200σµµN p结论: 0220222020ˆµσσσσσσµ+++=N m N N NN∑Xuegong Zhang, Tsinghua University 23若00=σ, 则0ˆµµ≡ (先验知识可靠,样本不起作用) 若σσ>>0,则N m =µˆ (先验知识十分不确定,完全依靠样本信息)(二)贝叶斯学习()22,~21exp 21)|(NN N NN N N µp σµσµµσπ⎪⎭⎪⎬⎫⎪⎩⎪⎨⎧⎟⎟⎠⎞⎜⎜⎝⎛−−=X“模式识别基础”教学课件∫=µµµd p p p N N )|()|()|(x x X X0220222020µσσσσσσµ+++=N m N N N N2202202σσσσσ+=N N当∞→N 时,02→N σ,δµ→)|(X p 函数。

()222,~1exp 1)|(N N N N p σσµµ+⎪⎬⎫⎪⎨⎧⎟⎟⎞⎜⎜⎛−−=x x XXuegong Zhang, Tsinghua University 25非监督参数估计指样本类别未知,但各类条件概率密度函数的形式已知,根据所有样本估计各类密度函数中的参数。

本节只介绍非监督最大似然估计的思路“模式识别基础”教学课件3.4.1 非监督参数估计的最大似然法(一)假设条件:1. 样本集{}N x x ,,1L =X 中的样本属于C 个类别,但不知各样本属哪类2. 类先验概率)(i P ω,c i ,,1L =已知3. 类条件概率密度形式已知 ),|(i i p θωx ,c i ,,1L =4. 未知是仅是c 个参数向量c θθθ,,,21L 的值所有未知参数组成的向量记为[]T θθθθ,,,L =Xuegong Zhang, Tsinghua University 27设样本集X 中的样本是从混合密度为)|(θx p 的总体中独立抽取的,即满足独立同分布条件,θ确定但未知,则 似然函数)|()|()(1θθθi Ni p p l x ∏===X对数似然函数 )|(ln )](ln[)(1θθθi Ni p l H x ∑===最大似然估计θˆ就是使)(θl 或)(θH 取最大的θ值。

“模式识别基础”教学课件(三)可识别性问题求出θˆ,就得到了c θθˆ,,ˆ1L ,即从混合密度函数中恢复出了分量密度函数。