概率密度估计及近邻法

- 格式:ppt

- 大小:6.10 MB

- 文档页数:62

1、概率密度函数在分类器设计过程中(尤其是贝叶斯分类器),需要在类的先验概率和类条件概率密度均已知的情况下,按照一定的决策规则确定判别函数和决策面。

但是,在实际应用中,类条件概率密度通常是未知的。

那么,当先验概率和类条件概率密度都未知或者其中之一未知的情况下,该如何来进行类别判断呢?其实,只要我们能收集到一定数量的样本,根据统计学的知识,可以从样本集来推断总体概率分布。

这种估计方法,通常称之为概率密度估计。

它是机器学习的基本问题之一,其目的是根据训练样本来确定x(随机变量总体)的概率分布。

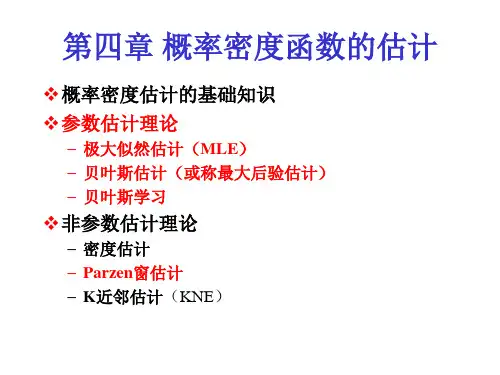

密度估计分为参数估计和非参数估计两种。

2、参数估计参数估计:根据对问题的一般性认识,假设随机变量服从某种分布(例如,正态分布),分布函数的参数可以通过训练数据来估计。

参数估计可以分为监督参数估计和非监督参数估计两种。

参数估计当中最常用的两种方法是最大似然估计法和贝叶斯估计法。

监督参数估计:样本所属类别及条件总体概率密度的形式已知,表征概率密度的某些参数是未知的。

非监督参数估计:已知样本所属的类别,但未知总体概率密度函数的形式,要求推断出概率密度本身。

3、非参数估计非参数估计:已知样本所属的类别,但未知总体概率密度函数的形式,要求我们直接推断概率密度函数本身。

即,不用模型,只利用训练数据本身来对概率密度做估计。

非参数估计常用的有直方图法和核方法两种;其中,核方法又分为Pazen窗法和KN近领法两种。

概率密度估计--参数估计与非参数估计我们观测世界,得到了一些数据,我们要从这些数据里面去找出规律来认识世界,一般来说,在概率上我们有一个一般性的操作步骤1. 观测样本的存在2. 每个样本之间是独立的3. 所有样本符合一个概率模型我们最终想要得到的是一个概率密度的模型,有了概率密度模型以后,我们就可以统计预测等非常有用的地方,因此,首要任务是找出一些概率分布的概率密度模型。

我们来分析一下上面的三个步骤,第一第二都很好解决,关于第三点,我们可以有不同的处理方式如果我们已经对观测的对象有了一些认识,对观测的现象属于那种类型的概率密度分布已经了解了,只是需要确定其中的参数而已,这种情况就是属于参数估计问题。

![[数学]第3章 概率密度函数估计 - 西安电子科技大学](https://uimg.taocdn.com/fb4cb24c680203d8cf2f2475.webp)

机器学习之概率密度估计写在前面的话:本文简述概率密度估计的方法以及代码实现,其中包括极大似然估计和非参数方法,非参数方法包括 parzen窗和knn(k近邻)算法。

注意,重点不是推导过程,而是最最最基本的实现方法!代码是用python,老师给的是.mat文件,本意是matlab,奈何我没好好学。

代码也不够简单,欢迎批评。

都是手动实现,knn用集成库也实现了一下,确实简单粗暴。

在文末会放入几篇个人认为比较容易理解的链接。

基本问题:已知一定数目的样本(类别已知),对未知样本分类,转化为数学语言就是——已知?(?_? )和?(?|?_?)对未知样本分类•首先根据样本估计p(x∣wi)p(x∣wi) p(x|w_i)p(x∣wi) 和p(wi)p(wi) p(w_i)p(wi),记pˆ(x∣wi)p^(x∣wi) \hat{p}(x|w_i)p^(x∣wi ) 和pˆ(x∣wi)p^(x∣wi) \hat{p}(x|w_i)p^(x∣wi)•然后用估计的概率密度设计贝叶斯分类器重要前提•训练样本的分布能代表样本的真实分布,样本满足独立同分布条件–independent and identically distributed (i.i.d条件)•有充分的训练样本关键就是求p(x∣wi)p(x∣wi) p(x|w_i)p(x∣wi) !一. 参数估计 (parametric methods)已知概率密度函数p(x∣wi)p(x∣wi) p(x|w_i)p(x∣wi) 的形式,只是其中几个参数未知,目标是根据样本估计这些参数的值。

最大似然估计(Maximum Likelihood Estimation)l(θ)=p(x∣θ)=∏Ni=1p(xi∣θ)l(θ)=p(x∣θ)=∏i=1Np(xi∣θ)l(\theta) = p(x|\theta) =\prod_{i=1}^{N}p(x_i|\theta) l(θ)=p(x∣θ)=i=1∏N p(xi∣θ)我来大白话解释一下,样本集 x已知,而参数 ? 未知, ?(?)反映的是不同? 取值下,取得当前样本的可能性。