矩阵乘法的OpenMP实现及性能分析

- 格式:doc

- 大小:210.50 KB

- 文档页数:10

一、实验目的1. 理解矩阵乘法的概念和运算规则。

2. 掌握矩阵乘法的编程实现方法。

3. 通过实验验证矩阵乘法的正确性。

二、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 库:NumPy三、实验原理矩阵乘法是指两个矩阵相乘的运算。

设矩阵A为m×n的矩阵,矩阵B为n×p的矩阵,则它们的乘积C为一个m×p的矩阵。

矩阵乘法的运算规则如下:C[i][j] = Σ(A[i][k] B[k][j]),其中k为1到n的整数。

四、实验步骤1. 导入NumPy库。

```pythonimport numpy as np```2. 定义矩阵A和B。

```pythonA = np.array([[1, 2], [3, 4]])B = np.array([[5, 6], [7, 8]])```3. 计算矩阵A和B的乘积C。

```pythonC = np.dot(A, B)```4. 打印结果。

```pythonprint("矩阵A:")print(A)print("矩阵B:")print(B)print("矩阵C(A乘B):")print(C)```五、实验结果与分析1. 运行实验程序,得到以下结果:```矩阵A:[[1 2][3 4]]矩阵B:[[5 6][7 8]]矩阵C(A乘B):[[19 22][43 50]]```2. 分析结果:- 矩阵A为2×2的矩阵,矩阵B为2×2的矩阵,它们的乘积C为2×2的矩阵。

- 根据矩阵乘法的运算规则,我们可以计算出矩阵C的每个元素。

- 实验结果与理论计算相符,说明矩阵乘法的编程实现是正确的。

六、实验总结1. 本实验成功实现了矩阵乘法的编程,验证了矩阵乘法的正确性。

2. 通过实验,加深了对矩阵乘法概念和运算规则的理解。

3. NumPy库在矩阵运算方面具有强大的功能,为编程提供了便利。

OpenMP的应用与实现OpenMP的应用与实现随着计算机技术的不断发展,程序员们需要在更短的时间内开发出更高效、更快速的程序,以满足现代科学和工程领域对计算的需求。

在多核处理器和集群系统的背景下,一种新的编程技术——OpenMP,应运而生。

OpenMP为C、C++和Fortran等语言提供了一种简单而有效的方式来并行化应用程序,可显著加速程序的执行速度。

本文将介绍OpenMP的应用与实现。

一、OpenMP的基本概念OpenMP是一种可移植、可扩展的共享内存并行编程技术,被广泛用于高性能计算应用中。

它可以在现有的串行代码中添加共享内存并行性,从而提高程序的效率。

OpenMP采用指令集合作,程序员可以通过在应用程序中添加特定的OpenMP指令,来控制并行执行的细节。

这些指令将告诉编译器如何将串行代码并行化。

OpenMP的并行模型是基于线程的共享内存模型。

线程是程序执行的最小单元,可以实现不同的计算任务同时运行。

OpenMP使用共享内存模型,即多个线程可以访问同一块内存,从而实现数据的共享。

为了保证数据的安全性,OpenMP提供了同步机制,可以保证共享资源的一致性和正确性。

二、OpenMP指令OpenMP定义了一系列指令,用于控制多线程的创建、同步和运行。

下面是一些常用的OpenMP指令:1. #pragma omp parallel该指令用于创建一个并行区域。

在这个区域内所有指令都会被多个线程执行。

当线程遇到这个指令时,会创建一个线程队列,然后每个线程会执行这个指令块内的内容。

2. #pragma omp for该指令用于循环并行化。

在多核处理器或者集群系统中,循环的迭代次数可以分配给不同的线程来并行执行,从而加速程序的执行速度。

3. #pragma omp sections该指令用于将代码分成多个段,每个段可以由不同的线程执行。

4. #pragma omp critical该指令用于保证在同一时间只有一个线程可以执行指定的代码块。

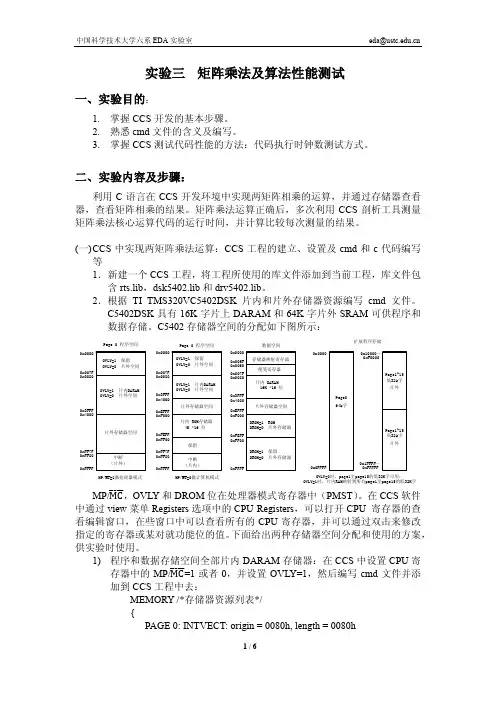

多核软件设计实验指导――OpenMP矩阵相乘开发者:开发时间:版本号:一. 问题描述矩阵相乘是线性代数中最常见的问题之一,它在数值计算中有广泛的应用,在计算机的世界里,矩阵相乘扮演着一个不可或缺的角色。

设A 和B 是2个 n n ⨯ 矩阵,,它们的乘积AB 同样是一个n n ⨯矩阵。

A 和B 乘积矩阵C 中元素C ]][[]][[1]][[j k B k i A nk j i ∑==二、串行算法描述若以上面的定义来计算A 和B 的乘积矩阵C ,则每计算C 的一个元素]][[j i C ,需要作n 次乘法运算和n -1次加法运算。

因此,算出矩阵C 的2n 个元素所需的计算时间为)(3n O 。

从程序运行的效率上来分析,如果n 比较大的时候,会耗费大量的空间和时间。

20世纪60年代末期,Strassen 采用了类似在大整数乘法中用过的分治技术,将计算2个n 阶矩阵乘积所需的计算时间改进到)()(81.27log n n O =O ,其基本思想还是使用分治法。

显然,这也没能够大幅度地提高运行速度和效率。

将矩阵a 与矩阵b 相乘得到矩阵c 的代码如下:for(i=0;i<dim;i++){ for(j=0;j<dim;j++){ c(i,j)=0;for(k=0;k<dim;k++){c(i ,j)+=a(i ,k)*b(k,j);}}}三、并行算法下面使用了OpenMP ,修改后的矩阵相乘程序使最外面的迭代在多个线程间静态分割,如图(a )所示:#pragma omp paralllel default(private) shared(a,b,c,dim) num_threads(2) #pragma omp for schedule(static)for(i=0;i<dim;i++){ for(j=0;j<dim;j++){ c(i,j)=0;for(k=0;k<dim;k++){c(i ,j)+=a(i ,k)*b(k,j);}}}Static调度类的一般形式为schedule(static[,chunk-size])。

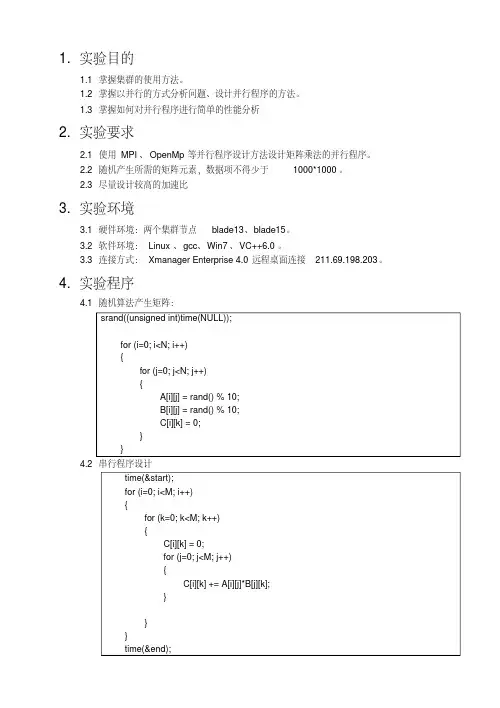

1. 实验目的1.1掌握集群的使用方法。

1.2掌握以并行的方式分析问题、设计并行程序的方法。

1.3掌握如何对并行程序进行简单的性能分析2. 实验要求2.1使用MPI、OpenMp等并行程序设计方法设计矩阵乘法的并行程序。

2.2随机产生所需的矩阵元素,数据项不得少于1000*1000。

2.3尽量设计较高的加速比3. 实验环境3.1硬件环境:两个集群节点blade13、blade15。

3.2软件环境:Linux、gcc、Win7、VC++6.0。

3.3连接方式:Xmanager Enterprise4.0远程桌面连接211.69.198.203。

4. 实验程序4.1随机算法产生矩阵:srand((unsigned int)time(NULL));for (i=0; i<N; i++){for (j=0; j<N; j++){A[i][j] = rand() % 10;B[i][j] = rand() % 10;C[i][k] = 0;}}4.2串行程序设计time(&start);for (i=0; i<M; i++){for (k=0; k<M; k++){C[i][k] = 0;for (j=0; j<M; j++){C[i][k] += A[i][j]*B[j][k];}}}4.3并行程序设计MPI_Init(&argc,&argv) 和MPI_Finalize() MPI_Init用来初始化MPI执行环境,建立多个MPI 进程之间的联系,为后续通信做准备。

而MPI_Finalize则是结束MPI执行环境。

这两个函数就是定义MPI程序的并行区的,除了检测是否初始化的函数之外,不应该在这两个函数定义的区域外调用其它MPI函数。

这两个函数都返回整型值,标识函数是否调用成功。

intMPI_Comm_rank(MPI_Comm comm, int *rank) MPI_Comm_rank函数用来标识各个MPI进程,获取调用该函数进程的进程号,将自身与其他进程区分。

OpenMp实现矩阵乘法与相关内容分析姓名:XXX学号:XXXXXXXXXX日期:2015年6月1.概述1.1实验内容:1)用OpenMP实现最基本的数值算法“矩阵乘法”2)掌握for编译指导语句3)对比不同进程数对并行效率的影响4)对比不同阶数对并行效率的影响5)对比不同阶矩阵转置前后效率提升的影响1.2 实验环境:1)硬件环境:CPU为20核心40线程、32G内存计算机2)软件环境:Linux、G++、OpenMPI3)编程语言:C++1.3 程序描述:用OpenMP编写两个n阶方阵a和b相乘的程序,a和b中的所有值均为1~100的随机数,n可在input文件中规定,结果存放在方阵c中,其中乘法用for编译指导语句实现并行化操作输入:input文件,其中为方阵的阶数n、并行域的进程数输出:每个子函数的执行时间、方阵a、b、c中的值程序的源代码如下:其中的子函数分别是:串行计算,转置后的串行计算,OpenMP并行计算,转置后的OpenMP 并行计算,打印三个矩阵。

#include<iostream>#include<stdlib.h>#include<sys/time.h>#include<omp.h>#include<math.h>#include<fstream>using namespace std;#define MAX 2000int a[MAX][MAX], b[MAX][MAX];int c[MAX][MAX];//计时器class timer{struct timeval start,end;double time_use;public:void clock_on(){gettimeofday(&start,NULL); //Get the time of starting}void clock_end(){gettimeofday(&end,NULL); //Get the time of ending}void time(){time_use=(__sec)*1000+ (__usec)/1000; //Get the time(ms) cout<<"totally use:"<<time_use/1000<<"s"<<endl;}};//串行计算矩阵乘法void Serial(int n){int i, j, k;for(i=0;i<n;i++) //Initialize the matrix c{for(j=0;j<n;j++){c[i][j]=0;}}for(i = 0;i<n;i++){for(j=0;j<n;j++){for(k=0;k<n;k++){c[i][j]=c[i][j]+a[i][k]*b[k][j];}}}}//串行计算转置后的矩阵乘法void Serial_Transposition(int n){int i, j, k;for(i=0;i<n;i++) //Initialize the matrix c{for(j=0;j<n;j++){c[i][j]=0;}}for(j=0;j<n;j++){for(k=0;k<n;k++){r[k]=b[k][j];}for(i=0;i<n;i++){for(k=0;k<n;k++){c[i][j]=c[i][j]+a[i][k]*r[k];}}}}//并行计算矩阵乘法void Parallel_OMP(int n, int num_thread){int i, j, k;omp_set_num_threads(num_thread);for(i=0;i<n;i++) //Initialize the matrix c{for(j=0;j<n;j++){c[i][j]=0;}}#pragma omp parallel shared(a,b,c) private(i,j,k){#pragma omp for schedule(dynamic) //Types of scheduling:static,dynamic,guided for(i=0;i<n;i++){for(j=0;j<n;j++){for(k=0;k<n;k++){c[i][j]=c[i][j]+a[i][k]*b[k][j];}}}}}//并行计算转置后的矩阵乘法void Parallel_OMP_Transposition(int n, int num_thread){int i, j, k;int r[n];omp_set_num_threads(num_thread);for(i=0;i<n;i++) //Initialize the matrix c{for(j=0;j<n;j++){c[i][j]=0;}#pragma omp parallel shared(a,b,c) private(i,j,k){#pragma omp for schedule(dynamic) //Types of scheduling:static,dynamic,guided for(j=0;j<n;j++){for(k=0;k<n;k++){r[k]=b[k][j];}for(i=0;i<n;i++){for(k=0;k<n;k++){c[i][j]=c[i][j]+a[i][k]*r[k];}}}}}//打印三个矩阵void print(int n){int i,j;for(i=0;i<n;i++){printf("\n");for(j=0;j<n;j++){printf("%10d ",a[i][j]);}}printf("\n");for(i=0;i<n;i++){printf("\n");for(j=0;j<n;j++){printf("%10d ",b[i][j]);}}printf("\n");for(i=0;i<n;i++){printf("\n");for(j=0;j<n;j++){printf("%10d ",c[i][j]);}}printf("\n");}//主程序int main(){int n, num_thread;int i,j;timer clock;FILE *fp;fp=fopen("input","r");if(fp==NULL)return -1;while(!feof(fp)){fscanf(fp,"%d%d",&n,&num_thread);}fclose(fp);for(i=0;i<n;i++) //Give matrix a and b some random values between 1 and 100.{for(j=0;j<n;j++){a[i][j]= rand()%100+1;b[i][j]= rand()%100+1;}}printf("\nSerial:\n\n");clock.clock_on();Serial(n);clock.clock_end();clock.time();print(n);printf("\nSerial_Transposition:\n\n");clock.clock_on();Serial_Transposition(n);clock.clock_end();clock.time();print(n);printf("\nParallel_OMP:\n\n");clock.clock_on();Parallel_OMP(n,num_thread);clock.clock_end();clock.time();print(n);printf("\nParallel_OMP_Transposition:\n\n");clock.clock_on();Parallel_OMP_Transposition(n,num_thread);clock.clock_end();clock.time();print(n);return 0;}1.4 对转置算法的说明由于矩阵的数据存储为按行存储,在直接做矩阵乘法时,需要不停地读取b中每一列的数据,而这些数据没有连续存储,这样会使得读取数据的时间增大。

基于OpenMP的并行矩阵乘法1. 概述并行计算是当代计算机科学领域中的一个重要研究方向,随着多核和并行处理器的广泛应用,利用并行计算技术提高计算效率成为了迫切的需求。

矩阵乘法作为线性代数中的重要运算,在科学计算、图形学和机器学习等领域有着广泛的应用。

基于OpenMP的并行矩阵乘法算法能够充分利用多核处理器的并行计算能力,提高计算效率。

2. OpenMP并行编程简介OpenMP是一种基于共享内存的并行编程技术,可以在C/C++、Fortran等编程语言中使用。

它通过在源代码中嵌入一些指令来实现并行化,使得程序员可以很方便地对现有代码进行并行化改造。

OpenMP提供了一系列的指令和库函数,使得并行程序的编写变得更加容易。

3. 矩阵乘法的串行算法矩阵乘法的串行算法是最常见的,其时间复杂度为O(n^3)。

对于两个矩阵A和B相乘,其乘积矩阵C的元素C[i][j]计算方式为:C[i][j] = ΣA[i][k]*B[k][j],其中k取值范围为1到矩阵的行数或列数。

串行算法的实现比较简单,但在大规模矩阵计算时效率较低。

4. 基于OpenMP的并行矩阵乘法算法基于OpenMP的并行矩阵乘法算法可以利用多核处理器的并行计算能力,提高计算效率。

下面我们将介绍一种基于OpenMP的并行矩阵乘法算法的实现方法。

5. 并行矩阵乘法的实现在使用OpenMP进行并行化时,可以针对矩阵乘法中的循环结构进行并行化处理。

以矩阵乘法C=AB为例,其中A为m×n矩阵,B为n×p矩阵,C为m×p矩阵。

我们可以将矩阵乘法按照不同的方法进行并行化,并结合OpenMP的指令进行并行计算。

一种常见的方法是使用循环并行化,将内层的乘法运算循环并行化,即将矩阵C的计算过程并行化。

另一种方法是使用数据并行化,将矩阵A、B、C的元素分配给不同的线程进行计算,然后将结果合并得到最终结果。

6. 并行矩阵乘法算法的优化在实际应用中,我们可以针对具体的矩阵大小和计算资源进行优化。

mpi openmp 案例MPI和OpenMP是并行计算中常用的编程模型,它们可以在多核和分布式系统中实现并行计算,提高计算效率。

本文将介绍一些MPI和OpenMP的案例,以展示它们在实际应用中的优势和用法。

引言概述:MPI和OpenMP是并行计算中常用的编程模型,它们分别适用于分布式和共享内存系统。

MPI(Message Passing Interface)是一种消息传递的并行编程模型,适用于分布式系统中的并行计算;而OpenMP是一种共享内存的并行编程模型,适用于多核系统中的并行计算。

下面将分别介绍它们在实际应用中的案例。

正文内容:1. MPI案例1.1 分布式矩阵乘法- 使用MPI实现矩阵乘法可以将计算任务分配给不同的进程,每个进程负责计算一部分矩阵乘法的结果。

- 使用MPI的消息传递机制,进程之间可以相互通信,将计算结果进行汇总,得到最终的矩阵乘法结果。

- 这种分布式矩阵乘法可以充分利用分布式系统的计算资源,提高计算效率。

1.2 并行排序算法- 使用MPI可以将排序任务分配给不同的进程,每个进程负责排序一部分数据。

- 进程之间可以通过消息传递机制交换数据,实现分布式的排序算法。

- 这种并行排序算法可以大大减少排序的时间复杂度,提高排序的效率。

2. OpenMP案例2.1 并行矩阵运算- 使用OpenMP可以将矩阵运算任务分配给不同的线程,每个线程负责计算一部分矩阵运算的结果。

- 多个线程可以共享内存,可以直接访问共享的数据,减少了数据的拷贝和通信开销。

- 这种并行矩阵运算可以充分利用多核系统的计算资源,提高计算效率。

2.2 并行图像处理- 使用OpenMP可以将图像处理任务分配给不同的线程,每个线程负责处理一部分图像数据。

- 多个线程可以并行地对图像进行处理,提高了图像处理的速度。

- 这种并行图像处理可以广泛应用于图像处理领域,如图像滤波、图像分割等。

总结:MPI和OpenMP是并行计算中常用的编程模型,它们分别适用于分布式和共享内存系统。

Science &Technology Vision 科技视界0前言在信息化技术不断发展的今天,人们处在“大数据”时代。

由于数据量巨大,普通的串行计算方式计算效率低下,无法满足人们对数据进行快速处理的需求。

因此,如何能够提高计算机处理“大数据”的计算效率已成为人们日益关注的话题。

为了减少计算时间、提升计算效率,并行计算的出现成为解决上述问题的有效方法。

与普通的串行计算相比,并行计算将计算任务分配到计算机的多个处理器协同处理,从而提高计算效率。

随着并行计算结果的发展,并行算法也逐渐成熟。

目前,人们采用的并行计算技术大致可能分为两种:一是基于CPU (Central Processing Unit )多核多线程的并行计算;二是基于GPU (Graphics Processing Unit )的通用并行计算。

对于CPU 并行计算,根据并行粒度的不同可分为“共享式内存结构”和“分布式内存结构”[1]。

对于“共享式内存结构”的并行计算,OpenMP (Open Multi -Processing )作为该类型计算技术的代表,已被广泛应用于数据处理及科学计算中。

采用OpenMP 做并行计算具有编程简单、源程序改变小等优点[2]。

基于GPU 的并行计算技术是近年来发展起来的新技术。

与基于CPU 的并行计算相比,GPU 并行计算具有硬件成本低、加速效果显著的优点。

随着NVIDIA 通用计算架构CUDA (Compute Unified Device Architecture )的提出,人们用GPU 做并行计算的编程难度大为降低[3]。

本文旨在采用CPU -OpenMP 和GPU -CUDA 并行计算技术进行不同阶矩阵的乘法运算,并对比这两种并行计算技术相对于串行计算(CPU 单线程)的加速效果。

此外,我们也对GPU -CUDA 计算所产生的计算误差进行了简要分析。

1CPU-OpenMP 和GPU-CUDA 并行计算技术CPU -OpenMP 是一种API (Application Program Interface ),用于编写可移植的多线程应用程序,并且无需进行复杂的线程创建、同步、负载平衡和销毁工作。

MPI实现矩阵乘法概述矩阵乘法是一个常见的数值计算问题,可以在并行计算环境下实现高效的并行计算。

MPI(Message Passing Interface)是一种常用的并行计算框架,可以实现分布式内存系统中的通信和并行计算。

本文将介绍如何使用MPI实现矩阵乘法,并分析其性能和效果。

算法概述矩阵乘法的基本算法是通过循环遍历两个矩阵的元素并进行乘法运算,最后将结果累加。

使用MPI实现矩阵乘法的一种常见方法是将矩阵划分为多个子矩阵,然后将子矩阵分配给不同的进程进行计算。

具体步骤如下: 1. 初始化MPI环境,获得进程总数和当前进程编号。

2. 由主进程读取矩阵A和矩阵B,并将它们划分为块矩阵,发送给其他进程。

3. 每个进程接收到划分后的块矩阵,进行局部矩阵乘法运算。

4. 各进程将局部计算结果发送给主进程。

5. 主进程接收到所有局部计算结果,将它们累加得到最终结果。

数据划分在实现MPI矩阵乘法时,需要将输入矩阵划分为块矩阵,以便将它们分配给不同的进程进行计算。

具体的划分方法有很多种,常用的有行划分和列划分两种方法。

行划分行划分是将输入矩阵按行进行划分,即将每一行分配给不同的进程进行计算。

这种划分方法在实现上比较简单,可以保证每个进程获得连续的内存空间,有利于数据访问的局部性。

但如果矩阵的行数远大于进程的数量时,可能会导致负载不均衡,部分进程的计算时间较长。

列划分列划分是将输入矩阵按列进行划分,即将每一列分配给不同的进程进行计算。

这种划分方法在实现上稍微复杂一些,需要注意数据的发送和接收顺序。

但如果矩阵的列数远大于进程的数量时,可以很好地均衡计算负载,提高计算效率。

在选择数据划分方法时,需要根据具体的应用场景和计算需求进行权衡。

样例代码下面是一个使用MPI实现矩阵乘法的示例代码:#include <stdio.h>#include <mpi.h>#define N 10#define M 10int main(int argc, char *argv[]) {int rank, size;int A[N][M], B[N][M], C[N][M];int local_A[N/size][M], local_C[N/size][M];MPI_Init(&argc, &argv);MPI_Comm_rank(MPI_COMM_WORLD, &rank);MPI_Comm_size(MPI_COMM_WORLD, &size);if (rank == 0) {// 读取矩阵A和矩阵Bfor (int i = 0; i < N; i++) {for (int j = 0; j < M; j++) {A[i][j] = i + j;B[i][j] = i - j;}}}// 将矩阵A划分为块矩阵,并发送给其他进程MPI_Scatter(A, N*M/size, MPI_INT, local_A, N*M/size, MPI_INT, 0, MPI_COMM_ WORLD);// 分配给每个进程的子矩阵进行矩阵乘法for (int i = 0; i < N/size; i++) {for (int j = 0; j < M; j++) {for (int k = 0; k < N; k++) {local_C[i][j] += local_A[i][k] * B[k][j];}}}// 将局部计算结果发送给主进程MPI_Gather(local_C, N*M/size, MPI_INT, C, N*M/size, MPI_INT, 0, MPI_COMM_W ORLD);if (rank == 0) {// 输出最终结果for (int i = 0; i < N; i++) {for (int j = 0; j < M; j++) {printf("%d ", C[i][j]);}printf("\n");}}MPI_Finalize();return 0;}性能分析使用MPI实现矩阵乘法可以充分利用并行计算资源,提高计算效率。

opengl 矩阵列主序矩阵乘法运算摘要:I.简介- 介绍OpenGL 矩阵和列主序- 矩阵乘法在OpenGL 中的重要性II.矩阵和列主序- 定义矩阵和列主序- 解释矩阵乘法III.OpenGL 中的矩阵乘法- 矩阵乘法在OpenGL 中的用途- 实现矩阵乘法的步骤IV.结论- 总结OpenGL 矩阵乘法的意义- 鼓励进一步学习和探索正文:OpenGL 是一种用于渲染2D 和3D 图形的编程接口,广泛应用于游戏、模拟和可视化等领域。

在OpenGL 中,矩阵是一个重要的概念,用于描述物体在空间中的位置和运动。

列主序是一个与矩阵相关的概念,它指定了矩阵中元素的排列顺序。

在OpenGL 中,列主序通常为“column-major order”,即按列优先排列。

矩阵乘法是矩阵运算中的一种,它用于将两个矩阵相乘得到一个新的矩阵。

在OpenGL 中,矩阵乘法被广泛应用于变换、投影和视图等操作。

矩阵乘法的定义如下:设矩阵A 和矩阵B 分别为m x n 和p x q 的矩阵,则矩阵C = A * B 是一个m x p 的矩阵,其元素为:c[i][j] = Σ (a[i][k] * b[k][j])其中,Σ表示对k 进行求和,范围为1 到n。

在OpenGL 中,矩阵乘法的实现通常遵循以下步骤:1.将矩阵A 和矩阵B 按照列主序排列。

2.对于矩阵A 中的每一行,将其与矩阵B 中的每一列进行点乘操作,得到一个新的向量。

3.将得到的新向量按照列主序排列,得到矩阵C。

通过矩阵乘法,我们可以在OpenGL 中实现物体的平移、旋转、缩放等变换,从而实现复杂的图形渲染效果。

python中矩阵的乘法矩阵是计算机科学中非常基础的数据结构,而在Python中,对于矩阵的运算,可以使用NumPy库进行计算。

其中,矩阵的乘法操作是非常常见的一个运算,下面将详细介绍Python中矩阵的乘法操作原理及其实现方法。

1、矩阵乘法的原理在介绍矩阵乘法的原理前,我们需要首先了解一下矩阵的结构。

在Python中,矩阵都是以二维列表的形式存在的,我们可以将一个矩阵写成如下形式:A = [[1, 2, 3],[4, 5, 6],[7, 8, 9]]其中,矩阵A的第一行为[1, 2, 3],第二行为[4, 5, 6],第三行为[7, 8, 9]。

对于两个矩阵A和B,如果它们的维度分别是m×n和n×p,那么它们可以进行乘法运算,得到一个新的矩阵C,其维度为m×p。

例如,对于以下两个矩阵A和B:A = [[1, 2],[3, 4]]B = [[5, 6],[7, 8]]它们的维度分别为2×2和2×2,因此它们可以进行矩阵乘法运算。

矩阵乘法运算的定义为:C(i,j) = sum(A(i,k) * B(k,j)), k=1 to n其中,C(i,j)表示矩阵C中第i行第j列元素的值,A(i,k)表示矩阵A中第i行第k列元素的值,B(k,j)表示矩阵B中第k行第j列元素的值。

对于一个新的矩阵C的每个元素,都需要根据上述公式计算获得。

对于上述的矩阵乘法运算,需要满足一定的条件才能进行。

具体要求如下:1)A矩阵的列数必须等于B矩阵的行数;2)结果矩阵C的行数等于A矩阵的行数,列数等与B矩阵的列数。

2、Python中矩阵乘法的实现方法在Python中,可以采用NumPy库中的dot()函数进行矩阵乘法的运算。

该函数的参数为两个二维列表,返回值为两个参数的矩阵乘积。

具体语法如下:import numpy as npC = np.dot(A, B)其中,A和B均为二维列表,C为A和B的矩阵乘积。

一. 实验目的1) 用OpenMP 实现最基本的数值算法“矩阵乘法" 2) 掌握for 编译制导语句 3) 对并行程序进行简单的性能二. 实验环境1) 硬件环境:32核CPU 、32G 内存计算机;2) 软件环境:Linux 、Win2003、GCC 、MPICH 、VS2008;4) Windows 登录方式:通过远程桌面连接192。

168.150。

197,用户名和初始密码都是自己的学号。

三。

实验内容1. 用OpenMP 编写两个n 阶的方阵a 和b 的相乘程序,结果存放在方阵c 中,其中乘法用for 编译制导语句实现并行化操作,并调节for 编译制导中schedule 的参数,使得执行时间最短,写出代码. 方阵a 和b 的初始值如下:⎥⎥⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎢⎢⎣⎡-++++=12,...,2,1,..2,...,5,4,31,...,4,3,2,...,3,2,1n n n n n n n a ⎥⎥⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎢⎢⎣⎡=1,...,1,1,1..1,...,1,1,11,...,1,1,11,...,1,1,1b输入:方阵的阶n 、并行域的线程数 输出:c 中所有元素之和、程序的执行时间 提示:a,b ,c 的元素定义为int 型,c 中所有元素之各定义为long long 型。

Windows 计时:用<time 。

h>中的clock_t clock ( void )函数得到当前程序执行的时间 Linux 计时:#include 〈sys/time.h〉timeval start,end;gettimeofday(&start,NULL);gettimeofday(&end,NULL);cout〈<"execution time:"<〈(end。

tv_sec—start。

tv_sec)+(double)(_usec—start。

一. 实验目的1) 用OpenMP 实现最基本的数值算法“矩阵乘法” 2) 掌握for 编译制导语句 3) 对并行程序进行简单的性能二. 实验环境1) 硬件环境:32核CPU 、32G 内存计算机;2) 软件环境:Linux 、Win2003、GCC 、MPICH 、VS2008;4) Windows 登录方式:通过远程桌面连接192.168.150.197,用户名和初始密码都是自己的学号。

三. 实验内容1. 用OpenMP 编写两个n 阶的方阵a 和b 的相乘程序,结果存放在方阵c 中,其中乘法用for 编译制导语句实现并行化操作,并调节for 编译制导中schedule 的参数,使得执行时间最短,写出代码。

方阵a 和b 的初始值如下:⎥⎥⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎢⎢⎣⎡-++++=12,...,2,1,..2,...,5,4,31,...,4,3,2,...,3,2,1n n n n n n n a ⎥⎥⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎢⎢⎣⎡=1,...,1,1,1..1,...,1,1,11,...,1,1,11,...,1,1,1b 输入:方阵的阶n 、并行域的线程数 输出:c 中所有元素之和、程序的执行时间 提示:a,b,c 的元素定义为int 型,c 中所有元素之各定义为long long 型。

Windows 计时:用<time.h>中的clock_t clock( void )函数得到当前程序执行的时间 Linux 计时: #include <sys/time.h> timeval start,end;gettimeofday(&start,NULL);gettimeofday(&end,NULL);cout<<"execution time:"<< (__sec)+(double)(__usec)/ 1000000<<"seconds" <<endl;答:在windows下使用Microsofe Visual Studio编程,源代码如下:#include<omp.h>#include<stdio.h>#include<time.h>#define NN 2000int a[NN][NN], b[NN][NN];long long c[NN][NN];void solve(int n, int num_thread){int i, j, t, k, time;clock_t startTime, endTime;long long sum;omp_set_num_threads(num_thread);for(i=0;i<n;i++)//对矩阵a和矩阵b进行初始化{t=i+1;for(j=0;j<n;j++){a[i][j]=t++;b[i][j]=1;}}startTime=clock();sum=0;#pragma omp parallel shared(a,b,c) private(i,j,k){#pragma omp for schedule(dynamic)for(i=0;i<n;i++){for(j=0;j<n;j++){c[i][j]=0;for(k=0;k<n;k++){c[i][j]+=a[i][k]*b[k][j];}}}}for(i=0;i<n;i++)for(j=0;j<n;j++) sum+=c[i][j];endTime=clock();time=endTime-startTime;printf("sum=%lld time=%dms\n",sum,time);}int main(){int n, num_thread;while(scanf("%d%d",&n,&num_thread)!=EOF){solve(n,num_thread);}return 0;}2.分析矩阵相乘程序的执行时间、加速比和效率:方阵阶固定为1000,节点数分别取1、2、4、8、16和32时,为减少误差,每项实验进行5次,取平均值作为实验结果。

答:串行执行时程序的执行时间为:T = 15.062s加速比=顺序执行时间/并行执行时间效率=加速比/节点数表1 不同节点数下程序的执行时间(秒)1 2 4 8 16 32节点数实验结果第1次16.640 8.172 4.078 2.125 1.093 0.594第2次16.422 8.156 4.172 2.141 1.078 0.578第3次16.406 8.266 4.078 2.125 1.094 0.563第4次16.781 8.172 4.079 2.109 1.094 0.563第5次16.422 8.171 4.078 2.125 1.093 0.578平均值16.5342 8.1874 4.0970 2.1250 1.0904 0.5752图1 不同节点数下程序的执行时间图2 不同节点数下程序的加速比图3 不同节点数下程序的效率执行时间的分析:随着节点数的增加,程序的执行时间减少,大概可以从结果中得出,随着节点书的增加一倍,执行时间减少一半加速比的分析:随着节点数的增加,程序的加速比增加,大概可以从结果中得出,随着节点书的增加一倍,加速相应的增加接近一倍效率的分析:随着节点数的增加,程序的效率逐渐减少3.分析矩阵相乘程序的问题规模与效率的关系:固定节点数为4,让方阵阶从200到1600之间变化,每隔100取一个值。

(为了减少时间,每项实验可只执行1次)答:表2 相同节点数下不同问题规模程序的执行时间与效率方阵阶数并行执行时间串行执行时间效率200 0.015 0.047 0.783333 300 0.016 0.109 1.703125 400 0.063 0.297 1.178571 500 0.156 0.657 1.052885 600 0.406 1.64 1.009852 700 0.907 3.578 0.986218 800 1.609 6.36 0.988191 900 2.578 10.109 0.980314 1000 3.812 14.891 0.976587 1100 5.39 21.032 0.97551 1200 7.344 28.734 0.978145 1300 9.688 37.937 0.978969 1400 12.422 48.64 0.978908 1500 15.656 60.938 0.973077 1600 19.234 74.829 0.972614图3.1 不同问题规模下程序的效率问题规模与效率的关系分析:随着问题规模的增加,程序的效率趋于稳定,但是略微有点下降。

嵌套循环中,如果外层循环迭代次数较少时,如果将来CPU核数增加到一定程度时,创建的线程数将可能小于CPU核数。

另外如果内层循环存在负载平衡的情况下,很难调度外层循环使之达到负载平衡。

下面以矩阵乘法作为例子来讲述如何将嵌套循环并行化,以满足上述扩展性和负载平衡需求。

一个串行的矩阵乘法的函数代码如下:/**矩阵串行乘法函数@param int*a -指向要相乘的第个矩阵的指针@param int row_a -矩阵a的行数@param int col_a -矩阵a的列数@param int *b –指向要想成的第个矩阵的指针@param int row_b -矩阵b的行数@param int col_b -矩阵b的列数@param int *c -计算结果的矩阵的指针@param int c_size -矩阵c的空间大小(总元素个数)@return void –无*/void Martrix_Multiply(int *a, int row_a,int col_a,int*b,int row_b,int col_b,int*c,int c_size){If(col_a!=row_b||c_size<row_a*col_b){return;}int i,j,k;//#pragma omp for private(i,j,k)for(i = 0;i<row_a;i++){int row_i=i*col_a;int row_c=i*col_b;for(j=0;j<col_b;j++){c[row_c+j]=0;for(k=0;k<row_b;k++){c[row_c+j]+=a[row_i+k]*b[k*col_b+j];}}}}如果在外层循环前面加上OpenMP的for语句时,它就变成了一个并行的矩阵乘法函数,但是这样简单地将其并行化显然无法满足前面所述的扩展性需求。

其实可以采用一个简单地方法将最外层循环和第2层循环合并成一个循环,下面便是采用合并循环后的并行实现。

void Parallel_Matrix_Multiply(int *a,int row_a,int col_a,int *b,int row_b,int col_b,int *c,int c_size){If(col_a!=row_b){return;}int i,j,k;int index;int border=row_a*col_b;i=0;j=0;//#pragma omp parallel private(i,j,k) num_threads(dtn(border,1))for(index = 0;index<border;index++){i=index/col_b;j=index%col_b;int row_i=i*col_a;int row_c=i*col_b;c[row_c+j]=0;for(k=0;k<row_b;k++){c[row_c+j]+=a[row_i+k]*b[k*col_b+j];}}}从上面代码可以看出,合并后的循环便捷border=row_a*col_b;即等于原来的两个循环边界之积,然后再循环中计算出原来的外层循环和第2层循环的迭代变量i和j,采用除法和取余来求出i和j的值。

需要值得注意的是,上面求i和j的值必须要保证循环迭代的独立性,即不能有循环迭代间的依赖关系。

不能讲求i和j的值得过程优化成如下的形式if(j==col_b){j=0;i++;}//.......此处代表实际的矩阵乘法代码j++;上面这种优化,省去了除法,效率高,但是只能在串行代码中使用,因为它存在循环迭代间的依赖关系,无法将其正确地并行。