信息论基础 第三章 数据压缩与信源编码I-文档资料

- 格式:ppt

- 大小:1.56 MB

- 文档页数:33

信息论基础知识主要内容:信源的数学模型 信源编码定理 信源编码算法 信道容量 通信的容限第 1 页 2011-2-21引言一、信息论的研究范畴 信息论是研究信息的基本性质及度量方法,研究信息的获取、传输、存储和处理的一般规律的科学。

狭义信息论:通信的数学理论,主要研究信息的度量方 法,各种信源、信道的描述和信源、信道的编码定理。

实用信息论:信息传输和处理问题,也就是狭义信息 论方法在调制解调、编码译码以及检测理论等领域的应用。

广义信息论,包括信息论在自然和社会中的新的应用, 如模式识别、机器翻译、自学习自组织系统、心理学、生物 学、经济学、社会学等一切与信息问题有关的领域。

第 2 页 2011-2-21二、信息论回答的问题通信信道中,信息能够可靠传 输的最高速率是多少?噪声信道编码定理 噪声信道编码定理信息进行压缩后,依然可以从已压 缩信息中以无差错或低差错恢复的 最低速率是多少?香农信源编码理论 香农信源编码理论最佳系统的复杂度是多少?第 3 页2011-2-21三、香农的贡献香农(Claude Elwood Shannon,1916~2001年), 美国数学家,信息论的创始人。

创造性的采用概率论的方法来研究通信中的问题,并且对 信息给予了科学的定量描述,第一次提出了信息熵的概念。

1948年,《通信的数学理论》(A mathematical theory of communication ) 以及1949年,《噪声下的通信》标志了信息论的创立。

1949年,《保密通信的信息理论》,用信息论的观点对信息保密问题做了 全面的论述,奠定了密码学的基础。

1959年,《保真度准则下的离散信源编码定理》,它是数据压缩的数学基 础,为信源编码的研究奠定了基础。

1961年发表“双路通信信道”,开拓了多用户信息理论(网络信息论)的研 究;第 4 页 2011-2-21四、信息论发展历史1924年 奈奎斯特(Nyquist,H.)总结了信号带宽和信息速率之 间的关系。

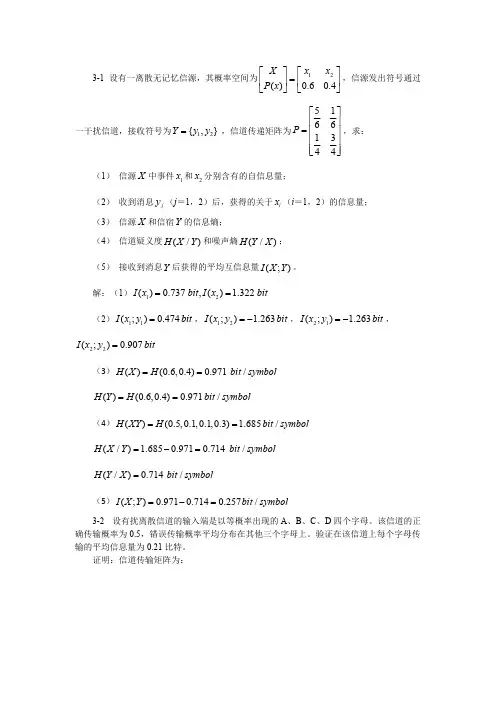

3-1 设有一离散无记忆信源,其概率空间为,信源发出符号通过12()0.60.4X x x P x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦一干扰信道,接收符号为,信道传递矩阵为,求:12{,}Y y y =51661344P ⎡⎤⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦(1) 信源中事件和分别含有的自信息量;X 1x 2x (2) 收到消息(j =1,2)后,获得的关于(i =1,2)的信息量;j y i x (3) 信源和信宿的信息熵;X Y (4) 信道疑义度和噪声熵;(/)H X Y (/)H Y X (5) 接收到消息后获得的平均互信息量。

Y (;)I X Y 解:(1)12()0.737,() 1.322I x bit I x bit==(2),,,11(;)0.474I x y bit =12(;) 1.263I x y bit =-21(;) 1.263I x y bit =-22(;)0.907I x y bit=(3)()(0.6,0.4)0.971/H X H bit symbol==()(0.6,0.4)0.971/H Y H bit symbol==(4)()(0.5,0.1,0.1,0.3) 1.685/H XY H bit symbol==(/) 1.6850.9710.714/H X Y bit symbol =-=(/)0.714/H Y X bit symbol=(5)(;)0.9710.7140.257/I X Y bit symbol=-=3-2 设有扰离散信道的输入端是以等概率出现的A 、B 、C 、D 四个字母。

该信道的正确传输概率为0.5,错误传输概率平均分布在其他三个字母上。

验证在该信道上每个字母传输的平均信息量为0.21比特。

证明:信道传输矩阵为:,信源信宿概率分布为:,11112666111162661111662611116662P ⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦1111()(){,,,}4444P X P Y ==H(Y/X)=1.79(bit/符号),I(X;Y)=H(Y)- H(Y/X)=2-1.79=0.21(bit/符号)3-3 已知信源包含两种消息:,且,信道是有扰的,X 12,x x 12()() 1/2P x P x ==信宿收到的消息集合包含。

数字通信中的信源编码和信道编码摘要:如今社会已经步入信息时代,在各种信息技术中,信息的传输及通信起着支撑作用.而对于信息的传输,数字通信已经成为重要的手段。

本论文根据当今现代通信技术的发展,对信源编码和信道编码进行了概述性的介绍。

关键词:数字通信;通信系统;信源编码;信道编码Abstract:Now it is an information society。

In the all of information technologies,transmission and communication of information take an important effect。

For the transmission of information,Digital communication has been an important means。

In this thesis we will present an overview of source coding and channel coding depending on the development of today’s communica tion technologies.Key Words:digital communication; communication system; source coding; channel coding1.前言通常所谓的“编码”包括信源编码和信道编码。

编码是数字通信的必要手段。

使用数字信号进行传输有许多优点, 如不易受噪声干扰,容易进行各种复杂处理,便于存贮,易集成化等。

编码的目的就是为了优化通信系统.一般通信系统的性能指标主要是有效性和可靠性.所谓优化,就是使这些指标达到最佳。

除了经济性外,这些指标正是信息论研究的对象.按照不同的编码目的,编码可主要分为信源编码和信道编码。

在本文中对此做一个简单的介绍.2.数字通信系统通信的任务是由一整套技术设备和传输媒介所构成的总体—-通信系统来完成的.电子通信根据信道上传输信号的种类可分为模拟通信和数字通信.最简单的数字通信系统模型由信源、信道和信宿三个基本部分组成.实际的数字通信系统模型要比简单的数字通信系统模型复杂得多。

信息论中的压缩算法与信源编码技术信息论是计算机科学中一门非常重要的学科,它是研究信息的量度、传输和处理等方面的学问。

与之相关的压缩算法和信源编码技术,在提高信息传输效率和数据存储能力方面都起到了重要的作用。

本文将从基本概念出发,逐步介绍信息论中的压缩算法与信源编码技术。

一、信息论基本概念信息论中的信息量是用“比特”来衡量的。

比特是计算机基础中非常常见的术语,它来自于二进制系统的数字“0”和“1”。

在计算机的存储器、通信网络、显示器等方面,都可以看到比特的身影。

一个比特可以表示两个不同的状态,如开关状态的“开/关”或者逻辑电平的“高/低”。

这两种状态可以分别用数字“0”和“1”来表示。

在信息论中,信息量是用比特数(bit)来衡量的。

一个比特可以表示两种选项中的一种,所以一个比特只能表示“是”或“否”、“真”或“假”这样的两种情况。

但是,当一个系统有多于两个状态时,用比特来衡量信息量就不太方便了。

例如,要描述两个人之间的关系,两个状态已经无法表示,我们需要多个比特来表示信息量。

当我们想知道一个字母的出现概率时,比特显然也是不够的。

在这种情况下,我们需要使用“信息熵”来描述。

信息熵通常用H来表示,它是指在一个信息源中可能出现的各种符号的概率的负对数的加权平均值。

具体地说,信息熵的公式为:H(S) = -Σp(x)×log p(x)其中,S表示一个符号集, x表示S中的每个符号,p(x)表示符号x在各次独立的实验中出现的概率。

信息熵的单位是比特(bit)。

越低的信息熵意味着信息源中包含的信息越少,信息的压缩率也就越高。

二、压缩算法压缩算法主要用于数据的压缩和解压缩。

其中,压缩是指减少数据文件的大小,解压缩则是指将压缩后的数据文件还原为原始数据文件。

数据压缩算法大致可分为两类:无损压缩和有损压缩。

无损压缩算法是指在压缩过程中保持数据的完整性,原始数据经过压缩后可以完全还原。

而有损压缩算法则是为了得到更高的压缩率,而在压缩过程中舍弃一些数据,所以解压后的数据不是完全一样的。