信息论基础 第三章 数据压缩与信源编码I-精选文档

- 格式:ppt

- 大小:1.56 MB

- 文档页数:33

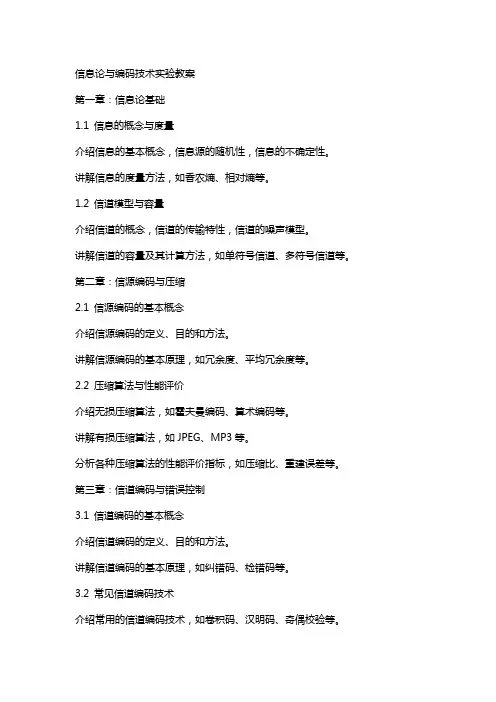

信息论与编码技术实验教案第一章:信息论基础1.1 信息的概念与度量介绍信息的基本概念,信息源的随机性,信息的不确定性。

讲解信息的度量方法,如香农熵、相对熵等。

1.2 信道模型与容量介绍信道的概念,信道的传输特性,信道的噪声模型。

讲解信道的容量及其计算方法,如单符号信道、多符号信道等。

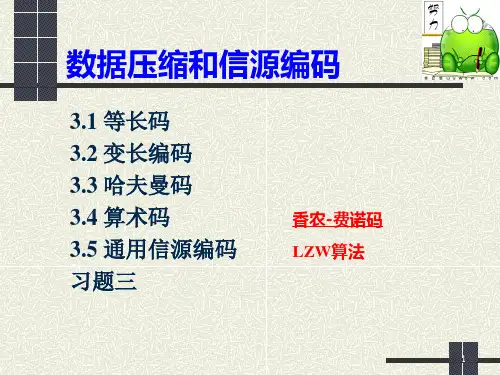

第二章:信源编码与压缩2.1 信源编码的基本概念介绍信源编码的定义、目的和方法。

讲解信源编码的基本原理,如冗余度、平均冗余度等。

2.2 压缩算法与性能评价介绍无损压缩算法,如霍夫曼编码、算术编码等。

讲解有损压缩算法,如JPEG、MP3等。

分析各种压缩算法的性能评价指标,如压缩比、重建误差等。

第三章:信道编码与错误控制3.1 信道编码的基本概念介绍信道编码的定义、目的和方法。

讲解信道编码的基本原理,如纠错码、检错码等。

3.2 常见信道编码技术介绍常用的信道编码技术,如卷积码、汉明码、奇偶校验等。

分析各种信道编码技术的性能,如误码率、编码效率等。

第四章:数字基带传输4.1 数字基带信号与基带传输介绍数字基带信号的概念,数字基带信号的传输特性。

讲解数字基带信号的传输方法,如无编码调制、编码调制等。

4.2 基带传输系统的性能分析分析基带传输系统的性能指标,如误码率、传输速率等。

讲解基带传输系统的优化方法,如滤波器设计、信号调制等。

第五章:信号检测与接收5.1 信号检测的基本概念介绍信号检测的定义、目的和方法。

讲解信号检测的基本原理,如最大后验概率准则、贝叶斯准则等。

5.2 信号接收与性能分析分析信号接收的方法,如同步接收、异步接收等。

讲解信号接收性能的评价指标,如信噪比、误码率等。

第六章:卷积编码与Viterbi算法6.1 卷积编码的基本原理介绍卷积编码的定义、结构及其多项式。

讲解卷积编码的编码过程,包括初始状态、状态转移和输出计算。

6.2 Viterbi算法及其应用介绍Viterbi算法的原理,算法的基本步骤和性能。

讲解Viterbi算法在卷积编码解码中的应用,包括路径度量和状态估计。

信息论基础知识主要内容:信源的数学模型 信源编码定理 信源编码算法 信道容量 通信的容限第 1 页 2011-2-21引言一、信息论的研究范畴 信息论是研究信息的基本性质及度量方法,研究信息的获取、传输、存储和处理的一般规律的科学。

狭义信息论:通信的数学理论,主要研究信息的度量方 法,各种信源、信道的描述和信源、信道的编码定理。

实用信息论:信息传输和处理问题,也就是狭义信息 论方法在调制解调、编码译码以及检测理论等领域的应用。

广义信息论,包括信息论在自然和社会中的新的应用, 如模式识别、机器翻译、自学习自组织系统、心理学、生物 学、经济学、社会学等一切与信息问题有关的领域。

第 2 页 2011-2-21二、信息论回答的问题通信信道中,信息能够可靠传 输的最高速率是多少?噪声信道编码定理 噪声信道编码定理信息进行压缩后,依然可以从已压 缩信息中以无差错或低差错恢复的 最低速率是多少?香农信源编码理论 香农信源编码理论最佳系统的复杂度是多少?第 3 页2011-2-21三、香农的贡献香农(Claude Elwood Shannon,1916~2001年), 美国数学家,信息论的创始人。

创造性的采用概率论的方法来研究通信中的问题,并且对 信息给予了科学的定量描述,第一次提出了信息熵的概念。

1948年,《通信的数学理论》(A mathematical theory of communication ) 以及1949年,《噪声下的通信》标志了信息论的创立。

1949年,《保密通信的信息理论》,用信息论的观点对信息保密问题做了 全面的论述,奠定了密码学的基础。

1959年,《保真度准则下的离散信源编码定理》,它是数据压缩的数学基 础,为信源编码的研究奠定了基础。

1961年发表“双路通信信道”,开拓了多用户信息理论(网络信息论)的研 究;第 4 页 2011-2-21四、信息论发展历史1924年 奈奎斯特(Nyquist,H.)总结了信号带宽和信息速率之 间的关系。

3-1 设有一离散无记忆信源,其概率空间为12()0.60.4X x x P x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦,信源发出符号通过一干扰信道,接收符号为12{,}Y y y =,信道传递矩阵为51661344P ⎡⎤⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦,求: (1) 信源X 中事件1x 和2x 分别含有的自信息量;(2) 收到消息j y (j =1,2)后,获得的关于i x (i =1,2)的信息量; (3) 信源X 和信宿Y 的信息熵;(4) 信道疑义度(/)H X Y 和噪声熵(/)H Y X ; (5) 接收到消息Y 后获得的平均互信息量(;)I X Y 。

解:(1)12()0.737,() 1.322I x bit I x bit ==(2)11(;)0.474I x y bit =,12(;) 1.263I x y bit =-,21(;) 1.263I x y bit =-,22(;)0.907I x y bit =(3)()(0.6,0.4)0.971/H X H bit symbol ==()(0.6,0.4)0.971/H Y H bit symbol ==(4)()(0.5,0.1,0.1,0.3) 1.685/H XY H bit symbol ==(/) 1.6850.9710.714/H X Y bit symbol =-= (/)0.714/H Y X bit symbol =(5)(;)0.9710.7140.257/I X Y bit symbol =-=3-2 设有扰离散信道的输入端是以等概率出现的A 、B 、C 、D 四个字母。

该信道的正确传输概率为0.5,错误传输概率平均分布在其他三个字母上。

验证在该信道上每个字母传输的平均信息量为0.21比特。

证明:信道传输矩阵为:11112666111162661111662611116662P ⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦,信源信宿概率分布为:1111()(){,,,}4444P X P Y ==, H(Y/X)=1.79(bit/符号),I(X;Y)=H(Y)- H(Y/X)=2-1.79=0.21(bit/符号)3-3 已知信源X 包含两种消息:12,x x ,且12()() 1/2P x P x ==,信道是有扰的,信宿收到的消息集合Y 包含12,y y 。