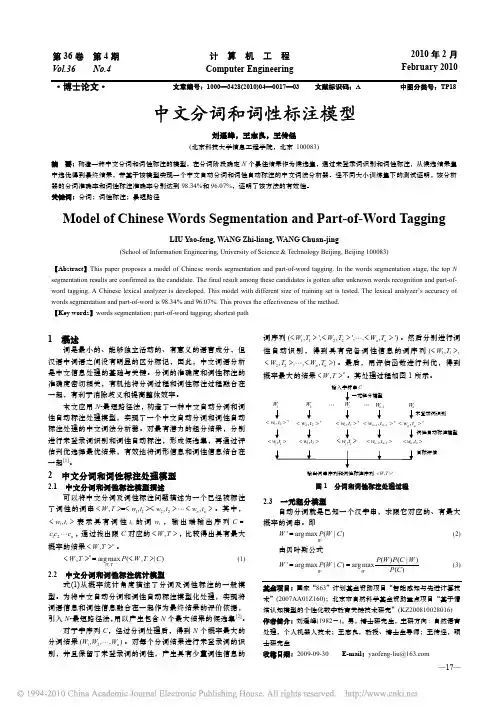

中文分词和词性标注模型

- 格式:pdf

- 大小:1.13 MB

- 文档页数:3

中文nlp模型

中文NLP模型是指专门用于处理中文自然语言的各类任务的模型。

中文NLP模型主要有以下几种:

1. 分词模型:用于将中文句子进行分词,将句子拆分成独立的词语单位。

2. 词性标注模型:用于为中文句子中的每个词语标注其词性,如动词、名词、形容词等。

3. 命名实体识别模型:用于识别中文句子中的命名实体,如人名、地名、机构名等。

4. 语义角色标注模型:用于对中文句子中的动词进行语义角色标注,将动词与其所表示的语义角色进行对应。

5. 情感分析模型:用于分析中文句子中的情感倾向,判断句子是否表达了积极、消极或中性的情感。

6. 机器翻译模型:用于将中文句子翻译为其他语言的句子,或将其他语言的句子翻译成中文。

7. 文本生成模型:用于生成中文文本,如填充式文本生成、生成式对话系统等。

以上只是中文NLP模型的一部分,随着研究的深入和技术的进步,还会出现更多新的模型和任务。

中文分词与词性标注技术研究与应用中文分词和词性标注是自然语言处理中常用的技术方法,它们对于理解和处理中文文本具有重要的作用。

本文将对中文分词和词性标注的技术原理、研究进展以及在实际应用中的应用场景进行综述。

一、中文分词技术研究与应用中文分词是将连续的中文文本切割成具有一定语义的词语序列的过程。

中文具有词汇没有明确的边界,因此分词是中文自然语言处理的基础工作。

中文分词技术主要有基于规则的方法、基于词典的方法和基于机器学习的方法。

1.基于规则的方法基于规则的中文分词方法是根据语法规则和语言学知识设计规则,进行分词操作。

例如,按照《现代汉语词典》等标准词典进行分词,但这种方法无法处理新词、歧义和未登录词的问题,因此应用受到一定的限制。

2.基于词典的方法基于词典的中文分词方法是利用已有的大规模词典进行切分,通过查找词典中的词语来确定分词的边界。

这种方法可以处理新词的问题,但对未登录词的处理能力有所限制。

3.基于机器学习的方法基于机器学习的中文分词方法是利用机器学习算法来自动学习分词模型,将分词任务转化为一个分类问题。

常用的机器学习算法有最大熵模型、条件随机场和神经网络等。

这种方法具有较好的泛化能力,能够处理未登录词和歧义问题。

中文分词技术在很多自然语言处理任务中都起到了重要的作用。

例如,在机器翻译中,分词可以提高对齐和翻译的质量;在文本挖掘中,分词可以提取关键词和构建文本特征;在信息检索中,分词可以改善检索效果。

二、词性标注技术研究与应用词性标注是给分好词的文本中的每个词语确定一个词性的过程。

中文的词性标注涉及到名词、动词、形容词、副词等多个词性类别。

词性标注的目标是为后续的自然语言处理任务提供更精确的上下文信息。

1.基于规则的方法基于规则的词性标注方法是根据语法规则和语境信息,确定每个词语的词性。

例如,根据词语周围的上下文信息和词语的词义来判断词性。

这种方法需要大量的人工制定规则,并且对于新词的处理能力较差。

基于深度学习方法的中文分词和词性标注研究中文分词和词性标注是自然语言处理中的重要任务,其目的是将输入的连续文字序列切分成若干个有意义的词语,并为每个词语赋予其对应的语法属性。

本文将基于深度学习方法对中文分词和词性标注进行研究。

一、深度学习方法介绍深度学习是一种基于神经网络的机器学习方法,在自然语言处理领域中应用广泛。

经典的深度学习模型包括卷积神经网络(Convolutional Neural Network,CNN)、循环神经网络(Recurrent Neural Network,RNN)、长短时记忆网络(LongShort-Term Memory, LSTM)和门控循环单元(Gated Recurrent Unit, GRU)等。

在对中文分词和词性标注任务的研究中,CNN、RNN以及LSTM均被采用。

CNN主要用于序列标注任务中的特征提取,RNN及LSTM则用于序列建模任务中。

GRU是LSTM的一种简化版本,在应对大规模文本序列的过程中更为高效。

二、中文分词中文分词是将一段连续的汉字序列切分成有意义的词语。

传统的中文分词方法主要包括基于词典匹配的分词和基于统计模型的分词。

基于词典匹配的分词方法基于预先构建的词典,将待切分文本与词典进行匹配。

该方法精度较高,但需要较为完整的词典。

基于统计模型的分词方法则通过学习汉字之间的概率关系来进行分词。

该方法不依赖于完整的词典,但存在歧义问题。

深度学习方法在中文分词任务中也有较好的表现,通常采用基于序列标注的方法。

具体步骤如下:1. 以汉字为单位对输入文本进行编码;2. 使用深度学习模型进行序列标注,即对每个汉字进行标注,标记为B(词的开头)、M(词的中间)或E(词的结尾),以及S(单字成词);3. 将标注后的序列按照词语切分。

其中,深度学习模型可以采用CNN、RNN、LSTM或GRU等模型。

三、中文词性标注中文词性标注是为每个词语赋予其对应的语法属性,通常使用含有标注数据的语料库进行训练。

基于LSTM模型的分词及词性标注一体化设计摘要中文分词及词性标注是NLP领域的一项基础技术,分词及词性标注是否准确将直接影响着自然语言理解的准确性。

目前普遍采用Dictionary、N-gram、Maximum Entropy、HMM、CRF等模型来完成。

虽然也有很多对LSTM的研究,但几乎缺乏详细的推理过程。

而本文将对模型的架构图做出详细的说明,以及对模型做出详细的正向和反向推理过程。

实验表明该模型在应用于分词及标注能取得很好的效果。

关键词LSTM;分词;标注;分词标注一体化Design of word segmentation and POS Tagging Based on LSTMFAN ZhenSouth China Agricultural University ,College of Mathematics and Informatics,510000,Guangzhou,Guangdong,PRCAbstract Chinese word segmentation and POS tagging is a basic technology in NLP field,the accuracy of word segmentation and POS tagging will directly affect the accuracy of natural language understanding. At present,there are usually done by Dictionary,N-gram,Maximum Entropy,HMM,CRF and other models. Although there are many studies on LSTM,there is almost no detailed reasoning process. In this paper,we will give a detailed description of the model’s architecture diagram,and make a detailed forward and backward reasoning process of the model. Experiments show that this model can achieve good results in segmentation and POS tagging.Key words LSTM;segmentation;POS;integration of segmentation and POS 前言由于中文不同于英文,需要进行分词和词性标注等基础性的工程[1],才能准确的理解语义[2]。

基于深度学习的中文自动分词与词性标注模型研究1. 引言中文自动分词与词性标注是中文文本处理和语义分析的重要基础任务。

传统方法在处理中文自动分词和词性标注时,通常采用基于规则或统计的方法,并且需要大量的特征工程。

然而,这些传统方法在处理复杂语境、歧义和未知词汇等问题时存在一定的局限性。

随着深度学习的发展,基于神经网络的自然语言处理方法在中文自动分词和词性标注任务上取得了显著的成果。

深度学习方法通过利用大规模的文本数据和端到端的学习方式,避免了传统方法中需要手动设计特征的问题,能够更好地解决复杂语境和未知词汇等挑战。

本文将重点研究基于深度学习的中文自动分词与词性标注模型,探讨这些模型在中文文本处理中的应用和效果,并对未来的研究方向进行展望。

2. 相关工作在深度学习方法应用于中文自动分词和词性标注之前,传统的方法主要基于规则或统计模型。

其中,基于规则的方法采用人工定义的规则来处理中文分词和词性标注任务,但这种方法需要大量人力投入且难以适应不同语境。

另一方面,基于统计模型的方法则依赖于大规模的语料库,通过统计和建模的方式进行分词和词性标注。

然而,这些方法在处理复杂语境和未知词汇时效果有限。

近年来,随着深度学习的兴起,基于神经网络的中文自动分词和词性标注模型逐渐成为研究热点。

其中,基于循环神经网络(RNN)的模型如BiLSTM-CRF(双向长短时记忆网络-条件随机场)模型被广泛使用并取得了令人瞩目的效果。

该模型利用LSTM单元来捕捉输入序列的上下文信息,并利用条件随机场模型来建模序列标注问题。

此外,基于注意力机制的模型如Transformer也在中文自动分词和词性标注任务中取得了优异的表现。

3. 深度学习方法在中文自动分词中的应用中文自动分词是将连续的汉字序列划分为具有独立语义的词组的任务。

传统的基于规则或统计的方法在处理未知词汇和复杂语境时存在一定的限制。

而基于深度学习的方法通过端到端的学习方式,可以更好地捕捉上下文信息,并通过大规模的语料库进行训练,从而提高分词的准确性和鲁棒性。

hanlp分词流程

HanLP是一款开源的自然语言处理工具包,可以实现中文分词、词性标注、命名实体识别等功能。

下面将详细介绍HanLP的分词流程。

一、HanLP分词流程概览

HanLP的分词流程可以分为以下几个步骤:文本预处理、分词、词性标注、命名实体识别等。

二、文本预处理

在进行分词之前,需要对待处理的文本进行预处理。

预处理的目的是将文本转化为HanLP可以处理的格式,包括去除空格、标点符号等。

三、分词

分词是HanLP的核心功能之一。

HanLP采用了基于条件随机场(CRF)模型的分词方法,该方法能够在不依赖词典的情况下进行分词,具有较好的鲁棒性和泛化能力。

四、词性标注

词性标注是为分词结果中的每个词语标注其词性。

HanLP提供了预训练好的词性标注模型,可以自动为分词结果进行词性标注。

五、命名实体识别

命名实体识别是指识别文本中的人名、地名、组织机构名等实体。

HanLP采用了基于条件随机场(CRF)模型的命名实体识别方法,

能够较准确地识别出文本中的命名实体。

六、其他功能

除了上述功能外,HanLP还提供了其他一些功能,如关键词提取、摘要生成、文本分类等。

这些功能可以根据具体需求进行选择和使用。

HanLP的分词流程包括文本预处理、分词、词性标注、命名实体识别等步骤。

通过这些步骤,可以对中文文本进行有效的处理和分析,为后续的自然语言处理任务提供基础支持。

HanLP的功能强大且易于使用,是中文文本处理的重要工具之一。

nlp部分基本术语简释自然语言处理(Natural Language Processing,NLP)是计算机科学领域的一个重要研究方向,旨在让计算机具备理解人类语言的能力。

在NLP领域中,有一些基本术语需要了解,下面我将对其中的一些术语进行简单的解释。

1. 语言模型(Language Model):语言模型是根据一段文本的统计特征,预测下一个单词或句子的概率分布模型。

它可以用来生成新的语言序列或者评估一个句子的合理程度。

2. 分词(Tokenization):分词是将一段连续的文本切割成单个的词或者字符的过程。

它是NLP的基础步骤,常用于对句子进行处理和处理中文文本。

3. 词性标注(Part-of-Speech Tagging):词性标注是指为一段文本中的每个词标注其所属的词性,如名词、动词、形容词等。

它可以帮助计算机理解文本的语法结构和语义信息。

4. 命名实体识别(Named Entity Recognition,NER):命名实体识别是指识别一段文本中特定类型的实体,如人名、地名、组织机构等。

它可以帮助计算机理解文本中的重要信息和实体关系。

5. 文本分类(Text Classification):文本分类是指将一段文本划分到预定义的类别中。

它可以用于情感分析、垃圾邮件过滤、新闻分类等任务。

6. 机器翻译(Machine Translation):机器翻译是将一种语言的文本自动翻译为另一种语言的技术。

它可以帮助人们解决跨语言交流的问题。

7. 问答系统(Question Answering System):问答系统是指能够根据用户提出的问题,在知识库或大规模文本中找到相应答案的系统。

它常用于智能助手、搜索引擎等应用中。

8. 情感分析(Sentiment Analysis):情感分析是指识别一段文本中包含的情感倾向,如积极、消极、中立等。

它可以帮助企业了解用户对产品或服务的评价和态度。

以上介绍了一些NLP领域的基本术语,它们涵盖了NLP技术在不同应用中的核心概念。

中文分词案例中文分词是自然语言处理中的一个重要任务,其目的是将连续的中文文本切分成单个的词语。

中文分词在很多应用中都起到了关键作用,例如机器翻译、信息检索、文本分类等。

本文将以中文分词案例为题,介绍一些常用的中文分词方法和工具。

一、基于规则的中文分词方法1. 正向最大匹配法(Maximum Matching, MM):该方法从左到右扫描文本,从词典中找出最长的词进行匹配,然后将该词从文本中删除。

重复这个过程,直到文本被切分完毕。

2. 逆向最大匹配法(Reverse Maximum Matching, RMM):与正向最大匹配法相反,该方法从右到左扫描文本,从词典中找出最长的词进行匹配,然后将该词从文本中删除。

重复这个过程,直到文本被切分完毕。

3. 双向最大匹配法(Bidirectional Maximum Matching, BMM):该方法同时使用正向最大匹配和逆向最大匹配两种方法,然后选择切分结果最少的作为最终结果。

二、基于统计的中文分词方法1. 隐马尔可夫模型(Hidden Markov Model, HMM):该方法将中文分词问题转化为一个序列标注问题,通过训练一个隐马尔可夫模型来预测每个字的标签,进而切分文本。

2. 条件随机场(Conditional Random Fields, CRF):与隐马尔可夫模型类似,该方法也是通过训练一个条件随机场模型来预测每个字的标签,进而切分文本。

三、基于深度学习的中文分词方法1. 卷积神经网络(Convolutional Neural Network, CNN):该方法通过使用卷积层和池化层来提取文本特征,然后使用全连接层进行分类,从而实现中文分词。

2. 循环神经网络(Recurrent Neural Network, RNN):该方法通过使用循环层来捕捉文本的时序信息,从而实现中文分词。

四、中文分词工具1. 结巴分词:结巴分词是一个基于Python的中文分词工具,它采用了一种综合了基于规则和基于统计的分词方法,具有较高的准确性和速度。

自然语言处理技术知识点归纳自然语言处理(Natural Language Processing,简称NLP)是研究计算机与人类自然语言之间交互的一门学科。

它融合了计算机科学、语言学和人工智能等领域的知识,旨在使计算机能够理解、分析和生成人类语言。

本文将对自然语言处理技术的一些重要知识点进行归纳和介绍。

一、语言模型语言模型是自然语言处理的基础,它描述了语言中单词或字符之间的关系。

语言模型可以用概率论的方法描述,常见的模型有n-gram模型和循环神经网络语言模型(RNNLM)。

n-gram模型是基于统计的方法,通过计算词语或字符出现的概率来预测下一个词语或字符。

而RNNLM利用循环神经网络结构,可以捕捉更长距离的语言依赖关系。

二、词法分析词法分析是将文本切分成基本的语言单元,主要包括词语和标点符号等。

常用的词法分析技术包括分词和词性标注。

分词是将连续的文本切分成独立的词语,中文分词是自然语言处理中的重要问题之一;词性标注是为每个词语标注一个词性,如名词、动词等,有助于后续的语义理解和文本分析。

三、句法分析句法分析是研究句子的结构和成分之间的关系。

它可以分析句子的语法结构,包括句子的组成成分和成分之间的关系,比如主谓关系、动宾关系等。

常见的句法分析方法有基于规则的方法、统计方法和基于神经网络的方法。

四、语义分析语义分析是理解文本的意思,包括词义消歧、情感分析、命名实体识别等任务。

词义消歧是确定词语在特定上下文中的具体含义;情感分析是判断文本所表达的情感倾向;命名实体识别是识别文本中的人名、地名、组织名等实体。

五、机器翻译机器翻译是将一种语言的文本转化为另一种语言的技术。

它可以基于规则或者统计方法进行翻译,还可以使用神经网络进行端到端的翻译。

机器翻译的目标是实现高质量、准确的翻译,并且尽可能保留原文的语义和风格。

六、问答系统问答系统是针对用户提出的问题,通过自动分析和推理,给出相应的答案。

问答系统可以基于检索的方法,也可以通过理解问题语义进行推理。

第 54 卷第 8 期2023 年 8 月中南大学学报(自然科学版)Journal of Central South University (Science and Technology)V ol.54 No.8Aug. 2023基于BiLSTM-CRF 的中文分词和词性标注联合方法袁里驰(江西财经大学 软件与物联网工程学院,江西 南昌,330013)摘要:针对中文分词、词性标注等序列标注任务,提出结合双向长短时记忆模型、条件随机场模型和马尔可夫族模型或树形概率构建的中文分词和词性标注联合方法。

隐马尔可夫词性标注方法忽略了词本身到词性的发射概率。

在基于马尔可夫族模型或树形概率的词性标注中,当前词的词性不但与前面词的词性有关,而且与当前词本身有关。

使用联合方法有助于使用词性标注信息实现分词,有机地将两者结合起来有利于消除歧义和提高分词、词性标注任务的准确率。

实验结果表明:本文使用的中文分词和词性标注联合方法相比于通常的双向长短时记忆模型−条件随机场分词模型能够大幅度提高分词的准确率,并且相比于传统的隐马尔可夫词性标注方法能够大幅度提高词性标注的准确率。

关键词:双向长短时记忆模型;中文分词;词性标注;马尔可夫族模型;树形概率中图分类号:TP391.1 文献标志码:A 文章编号:1672-7207(2023)08-3145-09A joint method for Chinese word segmentation and part-of-speech tagging based on BiLSTM-CRFYUAN Lichi(School of Software and Internet of Things Engineering, Jiangxi University of Finance and Economics,Nanchang 330013,China)Abstract: For sequence tagging tasks such as Chinese word segmentation and part-of-speech tagging, a joint method for Chinese word segmentation and part-of-speech tagging that combines BiLSTM(bi-directional long-short term memory model), CRF(conditional random field model), Markov family model(MFM) or tree-like probability(TLP) was proposed. Part-of-speech tagging method based on HMM(hidden markov model) ignores the emission probability of the word itself to the part-of-speech. In part-of-speech tagging based on MFM or TLP, the part-of-speech of the current word is not only related to the part-of-speech of the previous word, but also related to the current word itself. The use of the joint method helps to use part-of-speech tagging information to achieve word segmentation, and organically combining the two is beneficial to eliminate ambiguity and improve the收稿日期: 2023 −02 −20; 修回日期: 2023 −03 −24基金项目(Foundation item):国家自然科学基金资助项目(61962025,61562034) (Projects(61962025, 61562034) supported by theNational Natural Science Foundation of China)通信作者:袁里驰,博士,教授,从事自然语言处理研究;E-mail :*****************DOI: 10.11817/j.issn.1672-7207.2023.08.018引用格式: 袁里驰. 基于BiLSTM-CRF 的中文分词和词性标注联合方法[J]. 中南大学学报(自然科学版), 2023, 54(8): 3145−3153.Citation: YUAN Lichi. A joint method for Chinese word segmentation and part-of-speech tagging based on BiLSTM-CRF[J]. Journal of Central South University(Science and Technology), 2023, 54(8): 3145−3153.第 54 卷中南大学学报(自然科学版)accuracy of word segmentation and part-of-speech tagging tasks. The results show that the joint method of Chinese word segmentation and part-of-speech tagging used in this paper can greatly improve the accuracy of word segmentation compared with the usual word segmentation model based on BiLSTM-CRF, and it can also greatly improve the accuracy of part-of-speech tagging compared with the traditional part-of-speech tagging method based on HMM.Key words: bi-directional long-short term memory model; Chinese word segmentation; part-of-speech tagging; Markov family model; tree-like probability分词的目的是将一个完整的句子切分成词语级别。

Claws C7是一个用于自然语言处理的分词标注工具,它可以帮助实现中文语言文本的自动分词和标注。

在本文中,将介绍Claws C7的分词标注规则,帮助读者理解该工具的使用和应用。

一、Claws C7简介Claws C7是一个经过训练的分词标注器,它使用隐马尔可夫模型(Hidden Markov Model,HMM)来对中文文本进行分词和词性标注。

该工具基于大规模的中文语料库进行训练,可以对不同领域的中文文本进行准确的分词和标注。

二、分词标注规则1. 词性标注在Claws C7中,词性标注采用了国际通用的标注集,包括动词、名词、形容词、副词、介词、连词、代词等常见词性。

这些词性标注可以帮助用户理解文本中词语的语法功能和语义特征。

2. 分词规则Claws C7根据中文语言的特点,设计了一系列分词规则,包括基于词典的最大匹配法、基于规则的逆向最大匹配法等。

这些规则可以帮助工具对文本进行有效的分词,避免出现歧义和错误。

3. 模型训练Claws C7的分词标注规则还包括了模型训练的相关规定。

用户可以根据自己的需求,使用不同领域的语料库对模型进行重新训练,以提高对特定领域文本的分词和标注准确率。

三、应用实例Claws C7的分词标注规则在自然语言处理、信息检索、机器翻译等领域具有广泛的应用。

通过合理的分词和词性标注,可以帮助计算机系统理解和处理中文文本,提高文本处理的准确性和效率。

四、总结Claws C7的分词标注规则是该工具实现自动分词和标注的核心技术之一。

这些规则的合理设计和灵活应用,为中文文本处理提供了重要的支持和保障。

在今后的研究和应用中,可以进一步深入研究该工具的分词标注规则,推动中文自然语言处理技术的发展和应用。

五、分词标注的挑战与未来发展尽管Claws C7在分词标注方面取得了许多成就,但仍然面临一些挑战。

其中之一是歧义识别和处理。

中文语言中存在许多多音字和多义词,这给分词标注带来了一定的困难。

ictclas 标记法ICTCLAS标记法是一种中文分词和词性标注的方法,它可以将一段中文文本按照词汇的语义进行切分,并为每个词汇添加相应的词性标记。

本文将介绍ICTCLAS标记法的基本原理和应用。

ICTCLAS标记法是基于统计模型的一种分词和词性标注方法。

它的基本原理是通过训练大量的中文语料库,学习中文词汇的出现概率和词性的分布规律。

在这个过程中,ICTCLAS会根据词汇的上下文语境,对每个词进行分词,并为每个词汇添加相应的词性标记。

ICTCLAS标记法的应用非常广泛。

首先,在自然语言处理领域,ICTCLAS可以作为中文分词的基础工具。

通过将一段中文文本进行分词,可以为后续的文本处理任务提供准备。

其次,在信息检索和文本挖掘领域,ICTCLAS可以用来对大规模的中文文本进行分析和处理。

通过将文本进行分词和词性标注,可以为后续的信息检索和文本挖掘任务提供更加准确和精细的特征表示。

此外,在机器翻译和自动问答等任务中,ICTCLAS也可以用来提高系统的性能和效果。

ICTCLAS标记法的使用非常简单。

只需要将待处理的中文文本输入ICTCLAS系统,系统会自动对文本进行分词和词性标注,并输出分词结果和词性标记。

用户可以根据自己的需要,选择不同的参数设置和输出格式。

总结起来,ICTCLAS标记法是一种基于统计模型的中文分词和词性标注方法。

它可以将一段中文文本按照词汇的语义进行切分,并为每个词汇添加相应的词性标记。

ICTCLAS标记法在自然语言处理、信息检索、文本挖掘、机器翻译和自动问答等领域都有广泛的应用。

通过使用ICTCLAS标记法,可以提高系统的性能和效果,实现更加准确和精细的文本处理和分析。