模型轻量化技术方案-外发版V2.0

- 格式:pdf

- 大小:813.50 KB

- 文档页数:20

倾斜摄影模型轻量化技术流程

倾斜摄影模型轻量化技术是一种通过减少模型体积和保持模型细节的方法来增强模型性能的技术。

其流程大致为以下几步:

1.数据准备:选择适合的倾斜摄影模型数据集,将数据下载并做好预处理,包括数据格式转换和数据清洗等。

2.轻量化模型构建:通过特定的算法和技巧,设计和训练轻量化模型。

通常可以采用一些简化模型的方法,如剪枝、量化和低秩分解等,以减小模型大小和参数量。

3.模型融合:通过将多个轻量化模型融合成一个强模型,来提高模型的分类精度和性能。

可以采用一些模型融合的方法,如模型层级融合、模型参数平均融合和模型加权融合等。

4.性能评估:对轻量化模型进行性能评估,包括模型大小、准确率和速度等。

根据评估结果进行调整和优化。

5.部署和测试:将优化后的轻量化模型部署到特定平台上,并进行测试和验证,以确保模型能够在实际应用中发挥出最佳性能。

模型轻量化处理近年来,随着人工智能技术的不断发展,深度学习模型的应用越来越广泛,但是随之而来的问题是模型的大小和计算复杂度也在不断增加,这给模型的部署、运行和维护带来了很大的挑战,因此,模型轻量化处理成为了一个热门话题。

什么是模型轻量化处理?简单来说,就是通过减少模型的参数量和计算复杂度,来提高模型的效率和性能。

模型轻量化处理的方法有很多种,下面我们来介绍几种常见的方法。

1.剪枝剪枝是一种常见的模型轻量化处理方式,它通过删除一些不重要的连接和神经元,来减少模型的参数量和计算复杂度。

具体来说,剪枝分为结构剪枝和参数剪枝两种方式。

结构剪枝是指删除一些不重要的连接和神经元,可以使用一些启发式算法来实现;参数剪枝是指将一些较小的参数设为0,可以通过L1和L2正则化等方式来实现。

2.量化量化是指将模型中的浮点数参数转换为定点数参数,以减少模型的存储空间和计算量。

常见的量化方式有对称量化和非对称量化。

对称量化是指将参数映射到一个对称区间内,例如[-128,127],这样可以减少模型的存储空间,但会损失一定的精度;非对称量化是指将参数映射到一个非对称区间内,例如[0,255],这样可以保留更多的精度。

3.蒸馏蒸馏是指使用一个小模型来学习一个大模型的知识,并将其压缩到小模型中。

具体来说,蒸馏分为基于概率的蒸馏和基于特征的蒸馏两种方式。

基于概率的蒸馏是指将大模型的输出概率分布作为小模型的目标分布,通过最小化KL散度来训练小模型;基于特征的蒸馏是指将大模型的中间特征作为小模型的输入,通过最小化特征之间的距离来训练小模型。

模型轻量化处理是提高模型效率和性能的一种有效方式,具体的方法可以根据实际情况选择合适的方式进行处理。

上位机安装及使用说明执法记录仪上的时间和警员ID号等信息,以及录制的影音文件等需要通过电脑端的上位机软件来读写。

在使用上位机软件之前,请先至相关网站下载中心下载对应的上位机软件以及设备驱动。

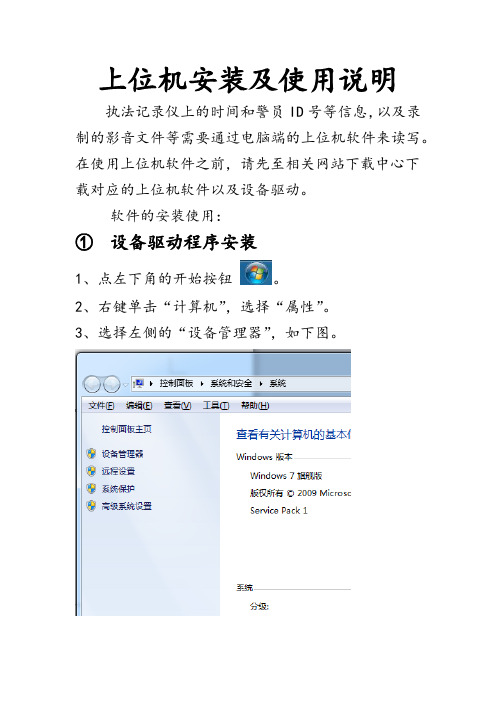

软件的安装使用:①设备驱动程序安装1、点左下角的开始按钮。

2、右键单击“计算机”,选择“属性”。

3、选择左侧的“设备管理器”,如下图。

4、弹出“设备管理器”界面,如下图:5、此时打开智能单兵指控终端,用USB线将其与电脑连接上。

会发现设备管理器中多了一个带问号的未知设备。

6、右键单击改设备,选择“更新驱动程序软件”,弹出如下图界面。

7、选择“浏览计算机以查找驱动程序软件”,弹出如下界面:8、点击“浏览”,选择“桌面”----“智能单兵指控终端软件”---“确定”,点击下一步。

9、等待驱动安装完成后,就可以使用上位机软件来管理操作设备了。

②智能单兵指控终端上位机软件安装1、双击setup进行安装。

2、点击“下一步”选择安装的路径,点击“下一步”,然后点击“安装”,直到“完成”。

3、在桌面上会生成一个“TRecord.exe”的快捷方式.③智能单兵指控终端上位机软件使用4、直接运行TRecord.exe。

弹出界面如下图所示。

5、点击“连接设备”,会提示“连接成功”。

6、输入密码“888888”(设备初始管理员密码,可通过上位机软件修改),点击“提交密码”。

会提示“登陆成功”。

7、接下来就可以对设备进行各种操作。

登录主界面之后就可以对设备进行如下操作:a、使用系统时间校时:点击将设备的时间修改同电脑时间b、使用自定义时间校时:点击将设备时间修改同界面前方设置的时间c、编号设置:进入可设置设备号和警员号d、进入U盘:点击可连接U盘,进入后到我的电脑中可以对本机存储文件进行操作e、文件管理:点击可直接根据警员号查看音视频文件,并可选择批量导出f、采集站IP设置:设置采集站外网IP用于在线上传数据内容等操作g、指控平台设置:进入可执行平台的参数设置。

模型轻量化方法综述随着深度学习的不断发展,大规模深度神经网络在各个领域的应用变得越来越普遍。

但是,由于深度神经网络的参数量庞大,导致计算成本高、存储成本高,甚至还会在嵌入式设备等资源受限的场景中限制其应用。

因此,轻量化模型的研究变得越来越重要。

本文将综述当前主流的模型轻量化方法,并按照以下列表进行分类:## 去冗余1. 参数量减少:参数量较少的模型在训练和推理时均具有更快的速度和更低的计算成本。

解决方法包括结构剪枝、低秩分解、知识蒸馏等。

2. 运算量减少:通过减少复杂度较高的运算过程,从而实现模型轻量化。

解决方法包括深度可分离卷积、深度可分离分组卷积、宽度可分离卷积等。

3. 数据冗余压缩:通过数据压缩算法来减小网络的体积,并且可以在保证网络精度的情况下,大幅度减轻计算量。

解决方法包括离线量化、在线量化、低比特位宽网络等。

## 蒸馏1. 蒸馏方法:通过将一个大模型的知识迁移到一个小模型上,来达到模型轻量化的效果。

解决方法包括基于模型的蒸馏、任务导向的蒸馏、特征蒸馏等。

2. 蒸馏框架:提供了一些框架和工具,以便开发者能够轻松实现模型蒸馏,并且使蒸馏过程更加高效便捷。

解决方法包括TensorRT、NNAPI、Paddle Lite等。

## 聚合1. 同质化聚合:通过在不同设备或不同环境下,训练不同的模型,然后将这些模型第一时间聚合起来,来得到一个在多种情况下都表现良好的轻量化模型。

解决方法包括FedAvg、FedProx、FedOpt等。

2. 非同质化聚合:利用异构计算设备的计算资源,将不同的模型划分到不同的设备上,然后在中央服务器上进行聚合以获得更好的性能。

解决方法包括EdgeCluster、DGL和cluster-GCN等。

综上所述,轻量化模型的研究对于实现计算机视觉、自然语言处理和其他深度学习任务等上的快速应用至关重要。

在未来,随着深度学习技术的不断成熟,轻量化模型将会越来越受到青睐。

面向Transformer 模型的轻量化方法研究作者:徐慧超徐海文刘丽娜

来源:《电脑知识与技术》2024年第04期

摘要:隨着Transformer模型的改进与发展,模型的参数数量显著增加,使得Transformer 模型及其衍生模型需要消耗大量的计算资源和存储资源。

文章提出一种基于知识蒸馏的新的Transformer模型轻量化方法:使用预训练好的BERT模型(Bidirectional Encoder Representation from Transformers)作为教师模型,设计学生模型卷积神经网络(Convolutional NeuralNetwork,CNN),加入注意力机制的循环神经网络(Recurrent Neural Network,

RNN)和全连接神经网络(Full Connect Neu⁃ral Network,DNN),并采用logits和matching logits两种蒸馏方法,实现模型的轻量化。

实验结果表明,当将BERT模型蒸馏给CNN时,参数数量减少93.46%,运行速度提升30余倍,在小规模数据集上准确率仅下降0.70%;当将BERT蒸馏给加入注意力机制的RNN时,参数数量减少了93.38%,速度提升100余倍,模型准确率轻微下降;当将DNN作为学生模型时,参数数量减少了93.77%,速度提升了200余倍,在大规模数据集上,准确率仅下降0.02%。

关键词:深度学习;Transformer模型;注意力机制;轻量化方法;知识蒸馏

中图分类号:TP301 文献标识码:A

文章编号:1009-3044(2024)04-0025-04。

模型轻量化及加速综述一、引言随着人工智能技术的快速发展,深度学习模型的应用越来越广泛。

然而,深度学习模型的计算量大、推理速度慢等问题,限制了其在移动设备、物联网等资源受限设备上的应用。

因此,模型轻量化和加速技术成为了深度学习领域研究的热点。

二、模型压缩模型压缩是降低模型复杂度、减少存储和计算资源消耗的一种有效方法。

常用的模型压缩方法包括权重剪枝、量化、知识蒸馏等。

这些方法可以从不同角度对模型进行简化,从而达到减小模型大小、加速推断速度的目的。

1.权重剪枝:通过去除模型中的冗余权重,降低模型复杂度。

2.量化:将模型的权重和激活值从浮点数转换为低精度的整数,减少存储和计算资源消耗。

3.知识蒸馏:将大模型的“软标签”知识迁移到小模型,从而提高小模型的性能。

三、模型优化模型优化是一种通过对模型结构、参数等进行调整,以提高模型性能的技术。

常用的模型优化方法包括模型剪枝、量化和混合精度训练等。

1.模型剪枝:通过去除部分模型结构,减小模型大小,加速推断速度。

2.混合精度训练:结合使用不同精度的权重和激活值,以加速训练和推断过程。

四、硬件加速硬件加速是通过利用专用硬件资源来加速深度学习模型的推理过程。

常用的硬件加速器包括GPU、FPGA和ASIC等。

这些硬件加速器可以显著提高深度学习模型的推断速度,从而在资源受限设备上实现实时推断。

五、实时推断实时推断是指在资源受限设备上快速完成深度学习模型的推断过程,以便在实际应用中实现实时响应。

为了实现实时推断,需要综合考虑模型压缩、优化和硬件加速等技术,以最小化推断时间并最大化模型性能。

六、应用场景与案例分析模型轻量化和加速技术的应用场景广泛,包括移动设备、物联网设备、自动驾驶系统等。

下面以移动设备上的实时语音识别为例,介绍模型轻量化和加速技术的应用案例。

首先,采用知识蒸馏技术将大模型的“软标签”知识迁移到小模型,从而在小模型上实现高效的语音识别。

然后,通过权重剪枝和量化技术对小模型进行压缩,减小模型大小并加速推断速度。

模型轻量化恢复权重法

模型轻量化是指在保持模型性能的前提下,通过减少模型的参数数量或者计算量来降低模型的大小和计算开销。

恢复权重法是一种常用的模型轻量化技术,它的核心思想是通过对模型的权重进行重新调整,使得模型在减少参数数量或者计算量的同时,尽可能地保持原有的性能。

恢复权重法的基本步骤如下:

1. 初始化轻量化模型:根据需要减少模型的参数数量或者计算量,得到轻量化模型。

2. 训练轻量化模型:使用原始模型的训练数据对轻量化模型进行训练,以优化其参数。

3. 恢复权重:根据轻量化模型的参数和原始模型的参数之间的关系,计算出原始模型的权重。

4. 微调原始模型:使用恢复后的权重对原始模型进行微调,以进一步提高其性能。

恢复权重法的关键在于如何建立轻量化模型的参数和原始模型的参数之间的关系。

常见的方法包括直接映射、线性映射、随机映射等。

不同的方法适用于不同的场景和模型结构。

需要注意的是,在使用恢复权重法进行模型轻量化时,需要在模

型性能和轻量化程度之间进行权衡。

过度追求轻量化可能会导致模型性能的下降,因此需要根据具体情况进行选择。

3D打印模型的轻量化设计方法3D打印技术的发展为制造业带来了革命性的变化,其应用范围也越来越广泛。

在制造3D打印模型时,轻量化设计方法是一个关键的考虑因素。

本文将探讨几种常见的3D打印模型的轻量化设计方法。

首先,我们来看看参数优化设计。

在3D打印模型中,通过调整参数来优化设计,可以实现轻量化效果。

例如,在设计一个机械零件时,可以通过增加薄壁结构、减少孔洞数量等方式来减轻模型的重量。

此外,还可以通过优化支撑结构的位置和形状,减少支撑材料的使用量。

通过参数优化设计,可以在保证模型强度的前提下,减少材料的使用,达到轻量化的目的。

其次,拓扑优化设计也是一种常见的轻量化设计方法。

拓扑优化设计是一种基于材料力学和结构力学原理的设计方法,通过优化结构的拓扑形状,使得模型在承受载荷时能够最大程度地减少应力集中,从而减轻模型的重量。

拓扑优化设计可以通过调整材料的分布和结构形状来实现轻量化效果。

例如,在设计一个桥梁结构时,可以通过拓扑优化设计,将材料集中在承受载荷的主要部位,减少材料在无载荷区域的使用,从而减轻模型的重量。

此外,材料选择也是一个重要的轻量化设计考虑因素。

不同的材料具有不同的密度和强度特性,选择合适的材料可以实现轻量化效果。

例如,在设计一个飞机模型时,可以选择轻质高强度的复合材料,而不是传统的金属材料,从而减轻模型的重量。

在选择材料时,还需要考虑到模型的使用环境和要求,确保材料的耐热性、耐腐蚀性等性能符合需求。

最后,结构优化设计也是一种常见的轻量化设计方法。

通过优化模型的结构形状和连接方式,可以减轻模型的重量。

例如,在设计一个建筑模型时,可以采用空心结构或者蜂窝状结构,减少材料的使用,从而达到轻量化的效果。

此外,还可以通过优化连接方式,减少连接件的使用量,减轻模型的重量。

综上所述,3D打印模型的轻量化设计方法有很多种。

参数优化设计、拓扑优化设计、材料选择和结构优化设计都是常见的方法。

在进行轻量化设计时,需要综合考虑模型的使用环境和要求,以及材料的特性和成本等因素。