基于FrameBuffer的简易图形库开发

- 格式:doc

- 大小:32.00 KB

- 文档页数:4

图形用户接口一、实验目的(1)了解嵌入式系统图形界面的基本编程方法(2)学习图形库的制作二、实验原理(一)Frame Buffer显示屏的整个显示区域,在系统内会有一段存储空间与之对应。

通过改变该存储空间的内容达到改变显示信息的目的。

该存储空间被称为Frame Buffer,或显存。

显示屏上的每一点都与Frame Buffer里的某一位置对应。

所以,解决显示屏的显示问题,首先要解决的是Frame Buffer的大小以及屏上的每一像素与Frame Buffer的映射关系。

影响空间大小的因素:由于Frame Buffer空间的计算大小是以屏幕的大小和显示模式决定的,所以显示模式(单色或彩色)、显示屏的性能、显示的需要均会影响Frame Buffer空间的大小。

另外显示屏还有单屏幕、双屏幕两种工作模式:单屏幕模式代表屏幕的显示范围是整个屏幕,只需一个Frame Buffer和一个通道;双屏幕模式则将整个屏幕划分为两个部分,这两个部分各自有Frame Buffer,且他们的地址无需连续,并同时具有两个各自独立的通道将Frame Buffer的数据传送到显示屏。

显示操作及映射连续性:由于Frame Buffer通常就是从内存空间分配所得,并且他是有连续的字节空间组成,屏幕的显示操作通常是从左到右逐点像素扫描,从上到下逐行扫描,直到扫描到右下角,然后再折返到左上角。

又由于Frame Buffer里的数据是按地址递增的顺序被提取,所以屏幕上相邻的两像素被映射到Frame Buffer里是连续的,并且屏幕最左上角的像素对应Frame Buffer的第一空间单元,屏幕最右下角则对应最后一个单元空间。

(二)Frame Buffer 与色彩计算机反映自然界的颜色是通过RGB(Red-Green-Blue)值来表示的。

如果要在屏幕某点显示某种颜色,则必须给出相应的RBG值。

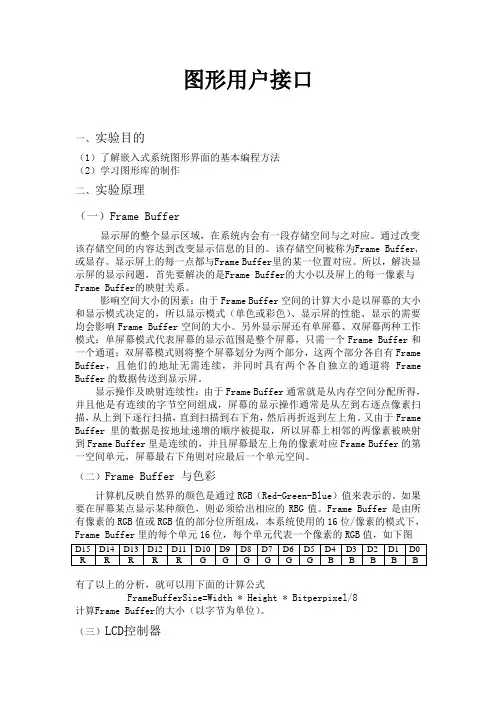

Frame Buffer是由所有像素的RGB值或RGB值的部分位所组成,本系统使用的16位/像素的模式下,Frame Buffer里的每个单元16位,每个单元代表一个像素的RGB值,如下图D15 D14 D13 D12 D11 D10 D9 D8 D7 D6 D5 D4 D3 D2 D1 D0 R R R R R G G G G G G B B B B B有了以上的分析,就可以用下面的计算公式FrameBufferSize=Width * Height * Bitperpixel/8计算Frame Buffer的大小(以字节为单位)。

一、概述Framebuffer(帧缓冲)是计算机图形学中的重要概念,它指的是将图形数据存储在内存中的一块缓冲区,用于在显示设备上显示图像。

而FPGA(Field Programmable Gate Array)则是一种灵活可编程的逻辑芯片,能够根据需求进行重构,可用于实现各种硬件系统。

本文将探讨如何利用FPGA实现framebuffer的原理。

二、framebuffer原理1. 存储结构在FPGA中实现framebuffer需要考虑如何存储图像数据。

通常情况下,可以使用双缓冲区来存储图像数据,这样可以在显示图像的同时对后台进行图像数据的更新。

每个像素点的颜色数据通常以RGB格式进行存储,而在FPGA中可以使用BRAM(Block RAM)来实现图像数据的存储。

2. 显示控制FPGA需要实现显示控制器来控制图像数据的输出。

显示控制器需要对时序进行精确的控制,将图像数据按照固定的频率输出到显示设备上。

需要考虑显示设备的分辨率和刷新率,确保输出的图像在显示设备上能够正确显示。

3. 数据传输当图像数据需要从主机系统传输到FPGA中时,需要考虑数据传输的速率和稳定性。

可以使用串行通信接口如MIPI或者并行接口如LVDS等方式来进行数据传输。

三、FPGA实现framebuffer的优势1. 灵活性FPGA是一种可编程的逻辑芯片,能够根据需求进行灵活的重构。

利用FPGA实现framebuffer可以根据具体的应用需求进行定制化设计,以满足不同的图像处理需求。

2. 高性能FPGA拥有并行处理能力强的优势,能够快速处理大规模的图像数据。

通过合理的设计,能够在FPGA上实现高性能的图像处理和显示。

3. 低功耗和传统的图像处理芯片相比,FPGA在处理同等任务时具有较低的功耗。

利用FPGA实现framebuffer可以在保证性能的同时降低能耗。

四、FPGA实现framebuffer的应用1. 嵌入式图像处理利用FPGA实现framebuffer可以用于嵌入式图像处理系统中,如医疗影像设备、工业检测设备等,能够实现实时的图像采集、处理和显示。

flutter linux framebuffer -回复Flutter是一个开源的UI框架,它可以帮助开发者快速构建漂亮且高性能的跨平台应用程序。

而Linux framebuffer是一种基于内存的显示设备,它可以直接访问和操作显存,将图形信息显示在屏幕上。

本文将详细介绍Flutter在Linux framebuffer上的应用,包括如何配置和启动以及遇到的一些常见问题和解决方案。

何为Linux framebuffer?首先,我们需要理解什么是Linux framebuffer。

Framebuffer是一种显示设备的编程接口,它提供了对显存的底层访问和操作。

以前,大多数操作系统都使用字符设备驱动或者X Window System来显示图形界面,而Linux framebuffer则是在这些方式之上的一层软件接口。

它允许开发者直接操作显存,快速地将图形信息显示在屏幕上。

Linux framebuffer不仅适用于嵌入式设备,也可以在普通的Linux系统上使用。

Flutter在Linux framebuffer上的使用Flutter最初是为移动设备开发的,但随着时间的推移和社区的发展,Flutter已经支持了更多的平台,包括桌面和嵌入式系统。

使用Flutter在Linux framebuffer上进行开发,可以让我们在Linux环境中快速构建漂亮且高性能的应用程序。

# 配置Linux framebuffer在开始使用Flutter在Linux framebuffer上进行开发之前,我们需要先配置Linux framebuffer。

首先,确保操作系统已经安装了Linux framebuffer的驱动程序。

然后,通过修改系统的启动参数来启用Linux framebuffer。

具体的步骤会因不同的Linux发行版而有所不同,可以参考相关的文档和教程来进行配置。

# 启动Flutter应用一旦Linux framebuffer配置完成,我们就可以开始启动Flutter应用了。

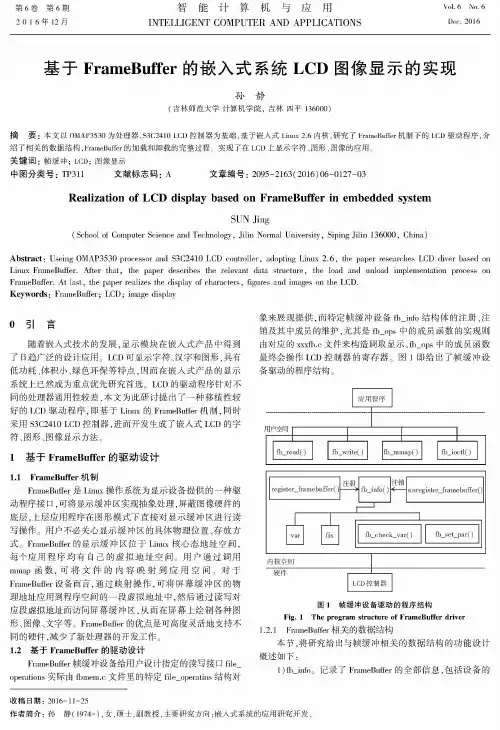

第6卷第6期 智能计算机与应用V 〇1.6 N “2 〇 1 6 年 12 月INTELLIGENT COMPUTER AND APPLICATIONS2016基于FrameBuffer 的嵌入式系统LCD 图像显示的实现孙静(吉林师范大学计算机学院,吉林四平136000)摘要:本文以OMAP3530为处理器,S3C2410LCD 控制器为基础,基于嵌入式L inux2.6内核,研究了 FmmaBuffer 机制下的LCD 驱动程序,介绍了相关的数据结构,l 々amaBuffer 的加载和卸载的完整过程。

实现了在LCD 上显示字符、图形、图像的应用。

关键词:帧缓冲;LCD ;图像显示中图分类号:T P 311文献标志码:A文章编号:2095-2163(2016)06-0127-03Realization of LCD display based on FrameBuffer in embedded systemSUN Jing(School of C om puter Science and T e ch n o lo g y , J ilin Nor^mal U n iv e rs ity , S iping J ilin 136000, C h in a )Abstract : U seing O M A P 3530 processor and S 3C 2410 L C D c o n tro lle r , adopting L in u x 2.6, the paper researches LC D d iv e r based onL in u x F ram e B u ffer . A fte r th a t , the paper describes the relevant data s tru c tu re , the load and unload im ple m en tation process on Fram e B u ffer . A t la s t , the paper realizes the displa y of cha racte rs , figures and images on the L C D .Keywords : F ra m e B u ffe r ; L C D ; image d ispla yo 引言随着嵌人式技术的发展,显示模块在嵌人式产品中得到 了日趋广泛的设计应用。

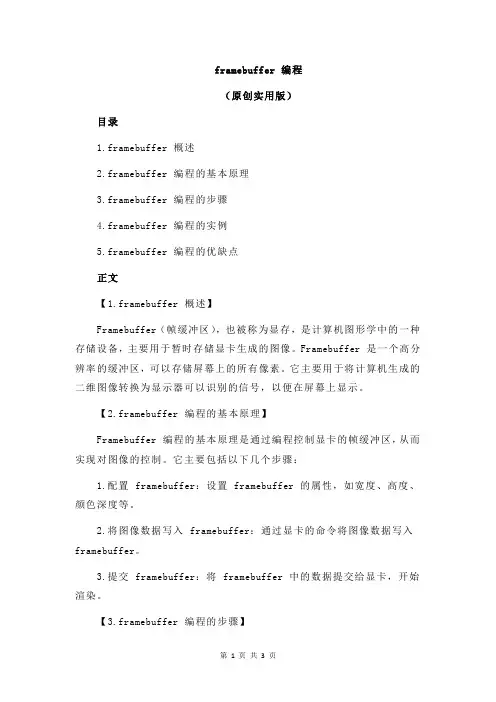

framebuffer 编程(原创实用版)目录1.framebuffer 概述2.framebuffer 编程的基本原理3.framebuffer 编程的步骤4.framebuffer 编程的实例5.framebuffer 编程的优缺点正文【1.framebuffer 概述】Framebuffer(帧缓冲区),也被称为显存,是计算机图形学中的一种存储设备,主要用于暂时存储显卡生成的图像。

Framebuffer 是一个高分辨率的缓冲区,可以存储屏幕上的所有像素。

它主要用于将计算机生成的二维图像转换为显示器可以识别的信号,以便在屏幕上显示。

【2.framebuffer 编程的基本原理】Framebuffer 编程的基本原理是通过编程控制显卡的帧缓冲区,从而实现对图像的控制。

它主要包括以下几个步骤:1.配置 framebuffer:设置 framebuffer 的属性,如宽度、高度、颜色深度等。

2.将图像数据写入 framebuffer:通过显卡的命令将图像数据写入framebuffer。

3.提交 framebuffer:将 framebuffer 中的数据提交给显卡,开始渲染。

【3.framebuffer 编程的步骤】Framebuffer 编程的基本步骤如下:1.初始化 framebuffer:首先,需要初始化 framebuffer,包括分配内存、设置属性等。

2.绑定 framebuffer:将 framebuffer 绑定到特定的渲染管线。

3.写入图像数据:通过显卡的命令将图像数据写入 framebuffer。

4.提交 framebuffer:将 framebuffer 中的数据提交给显卡,开始渲染。

5.释放 framebuffer:渲染完成后,需要释放 framebuffer。

【4.framebuffer 编程的实例】以下是一个简单的 framebuffer 编程实例:```c#include <GL/glut.h>void display() {glClear(GL_COLOR_BUFFER_BIT); // 清除颜色缓冲区glLoadIdentity(); // 重置变换矩阵glOrtho(0, glutGet(GL_WIDTH), glutGet(GL_HEIGHT), 0, -1, 1); // 设置透视投影矩阵glBegin(GL_QUADS); // 开始绘制四边形glColor3f(1.0, 0.0, 0.0); // 设置颜色为红色glVertex2f(-0.5, -0.5); // 绘制左下角glVertex2f(0.5, -0.5); // 绘制右上角glVertex2f(0.5, 0.5); // 绘制右上角glVertex2f(-0.5, 0.5); // 绘制左上角glEnd(); // 结束绘制glFlush(); // 提交绘制结果}int main(int argc, char** argv) {glutInit(&argc, argv);glutCreateWindow("Framebuffer Programming");glutDisplayFunc(display);glutMainLoop();return 0;}```【5.framebuffer 编程的优缺点】Framebuffer 编程的优点:1.灵活性:framebuffer 编程可以实现对图像的精确控制,包括颜色、亮度、对比度等。

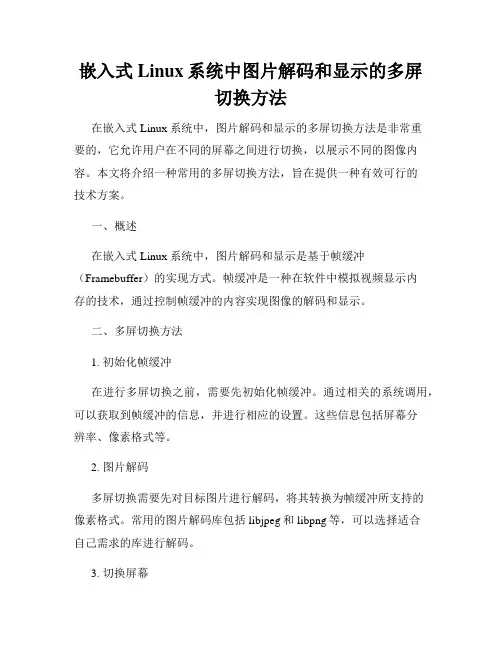

嵌入式Linux系统中图片解码和显示的多屏切换方法在嵌入式Linux系统中,图片解码和显示的多屏切换方法是非常重要的,它允许用户在不同的屏幕之间进行切换,以展示不同的图像内容。

本文将介绍一种常用的多屏切换方法,旨在提供一种有效可行的技术方案。

一、概述在嵌入式Linux系统中,图片解码和显示是基于帧缓冲(Framebuffer)的实现方式。

帧缓冲是一种在软件中模拟视频显示内存的技术,通过控制帧缓冲的内容实现图像的解码和显示。

二、多屏切换方法1. 初始化帧缓冲在进行多屏切换之前,需要先初始化帧缓冲。

通过相关的系统调用,可以获取到帧缓冲的信息,并进行相应的设置。

这些信息包括屏幕分辨率、像素格式等。

2. 图片解码多屏切换需要先对目标图片进行解码,将其转换为帧缓冲所支持的像素格式。

常用的图片解码库包括libjpeg和libpng等,可以选择适合自己需求的库进行解码。

3. 切换屏幕在进行屏幕切换时,需要通过系统调用将待显示的图像数据写入到帧缓冲中。

具体可以使用mmap将帧缓冲映射到用户空间,然后将解码后的图像数据写入帧缓冲的内存中。

这样就可以实现图像在不同屏幕之间的切换。

4. 刷新屏幕当图像数据写入帧缓冲后,需要通过刷新帧缓冲来显示图像。

可以使用相关的系统调用来触发刷新操作,从而将帧缓冲的内容实时显示在屏幕上。

5. 多屏协同在多屏切换时,如果需要多个屏幕同时显示不同的图像,可以通过多线程或多进程的方式进行实现。

每个线程/进程负责一个独立的帧缓冲和屏幕,实现多屏协同切换的效果。

三、技术实现嵌入式Linux系统中,可以使用各种工具和库来实现图片解码和显示的多屏切换。

比如,可以使用Qt等图形库来进行图像的解码和显示,并结合相关的系统调用来实现多屏切换。

1. 使用Qt库Qt是一种跨平台的应用程序开发框架,它提供了丰富的图形图像处理功能。

可以使用Qt库来解码和显示图片,并通过QImage对象将图像数据写入到帧缓冲中。

基于FrameBuffer的简易图形库开发基于FrameBuffer的简易图形库开发QT不是基于FrameBuffer的吗,现在被Nokia收购了,可惜对于很简单的应用,QT太宠大了,既然知道FrameBuffer的工作原理,自己写一个也行啊,找了找资料,写了以下的代码,当然功能极其简单,实现的基本原理是将FrameBuffer 的物理内容映射到进程空间内,然后直接对这段内存进行写操作,这样就会直接将数据显示在屏幕上。

//zsygui.h#ifndef __ZSYGUI_H__#define __ZSYGUI_H__#include#include#include#include#include#include#include#include#include#define ERR(fmt,args...) printf("Error:" fmt,##args)/*frame buffer device structure*/struct fb_dev{int fd; /*file descriptor*/struct fb_fix_screeninfo fixinfo;struct fb_var_screeninfo varinfo;char *addr; /*map address*/int fb_size; /*frame buffer size*/char *buffer; /*buffer,equals to framebufer's size*/};struct fb_dev* zsygui_open(const char *device,int mode);extern int zsygui_flush_buffer(struct fb_dev *pdev);extern int zsygui_fill_color(struct fb_dev*pdev,int color);extern int zsygui_draw_line(struct fb_dev *pdev,int whichline,int startpos,int endpos,int color);extern int zsygui_close(struct fb_dev *pdev);#endif //__ZSYGUI_H__//zsygui.c#include "zsygui.h"struct fb_dev* zsygui_open(const char *device,int mode){struct fb_dev *dev=(struct fb_dev*)malloc(sizeof(struct fb_dev));if(!dev){return NULL;}if(!device){free(dev);return NULL;}if((dev->fd=open(device,mode))<0){printf("open %s failed./n",device);free(dev);return NULL;}if(ioctl(dev->fd,FBIOGET_FSCREENINFO,&dev->fixinfo)==-1){printf("ioctl failed./n");free(dev);return NULL;}if(ioctl(dev->fd,FBIOGET_VSCREENINFO,&dev->varinfo)==-1){printf("ioctl failed./n");free(dev);return NULL;}//frame buffer sizedev->fb_size=(dev->varinfo.yres) * (dev->fixinfo.line_length);//map physical address to process virtual addressdev->addr=mmap(NULL,dev->fb_size,PROT_READ|PROT_W RITE,MAP_SHARED,dev ->fd,0);if(!dev->addr){printf("mmap failed./n");free(dev);return NULL;}//allocate the same size bufferdev->buffer=(char*)malloc(dev->fb_size);if(!dev->buffer){printf("malloc failed./n");free(dev);return NULL;}memset(dev->buffer,0,dev->fb_size);return dev;}int zsygui_fill_color(struct fb_dev*pdev,int color){if(!pdev){return -1;}memset(pdev->buffer,color,pdev->fb_size);zsygui_flush_buffer(pdev);return 0;}int zsygui_close(struct fb_dev*pdev){free(pdev->buffer);free(pdev);}int zsygui_flush_buffer(struct fb_dev *pdev){char *src,*dst;int size=0;int lines=0;int offset=0;if(!pdev){return -1;}src=pdev->buffer;dst=pdev->addr;size=pdev->varinfo.xres;printf("bits_per_pixel=%d/n",pdev->varinfo.bits_per_pixel);//这里实现一行一行的写,相当于逐行扫描//一个像素对应几个位,由bits_per_pixel获取,除以8,得到字节数//每次地址要偏移xres个单元lines=pdev->varinfo.yres*((pdev->varinfo.bits_per_pixel)/8);offset=pdev->varinfo.xres;while(lines-->=0){memcpy(dst,src,size);src+=offset;dst+=offset;}return 0;}int zsygui_draw_hline(struct fb_dev*pdev,int whichline,int startpos,int endpos,int color){int i;char *buf;if(!pdev){return -1;}if(startpos<0 || startpos>pdev->varinfo.xres)startpos=0;if(endpos<0 || endpos>pdev->varinfo.xres)endpos=pdev->varinfo.xres;if(whichline<0 || whichline>pdev->varinfo.yres)whichline=0;buf=pdev->buffer+whichline*pdev->varinfo.xres;for(i=startpos;i<endpos;i++)< p="">*buf++=color;zsygui_flush_buffer(pdev);return 0;}//测试程序#include "zsygui.h"int main(int argc,char **argv){struct fb_dev *dev;dev=zsygui_open("/dev/fb0",O_RDWR);printf("%p/n",dev);zsygui_fill_color(dev,0x0);zsygui_draw_hline(dev,300,0,500,0xb0);zsygui_draw_hline(dev,301,0,500,0xb0);zsygui_close(dev);return 0;}差不多,编译后,尽量在字符模式下编译,运行,实现了预期效果,后来我把它交叉编译后,放到ARM板上,运行也算良好。

openGL frame buffer object(FBO)fbo 扩展在openGL 3.0以后成为openGL核心特性,后缀EXT不再出现在扩展名中。

概览在openGL 渲染管线中,几何数据和纹理经过一系列测试最后以2d像素图渲染到屏幕上。

最后的渲染目的地叫做帧缓冲区。

帧缓冲区由一些openGL操作的2d数组和存储空间组成,如颜色缓冲区、深度缓冲区、模版缓冲区和累积缓冲区。

默认情况下,openGL用帧缓冲区作为最终渲染目的地,帧缓冲区完全由窗口系统创建了管理。

这个默认的帧缓冲区叫做“窗口系统提供的”缓冲区。

openGL扩展——GL_ARB_framebuffer_object提供了创建额外的不可显示的帧缓冲对象(fbo)。

这种帧缓冲对象叫做“应用程序创建的”帧缓冲区,以区别于“窗口系统创建”缓冲区。

通过使用帧缓冲对象,openGL应用程序可以重定向渲染输出到“应用程序创建的”缓冲区对象,“应用程序创建的”缓冲区完全由openGL控制。

类似“窗口系统创建的”缓冲区,fbo包含若干渲染目的地:颜色、深度、模版缓冲区(没有累积缓冲区)。

里面这些逻辑缓冲区叫做“可连接到帧缓冲对象的”图像,是一些2d数组或像素图。

有两种framebuffer-attachable图像:纹理图和渲染缓冲区图(renderbuffer image)。

若纹理对象被连接到帧缓冲对象,那么openGL执行“渲染到纹理”操作。

若renderbuffer对象连接到帧缓冲对象,那么openGL执行“离屏渲染”。

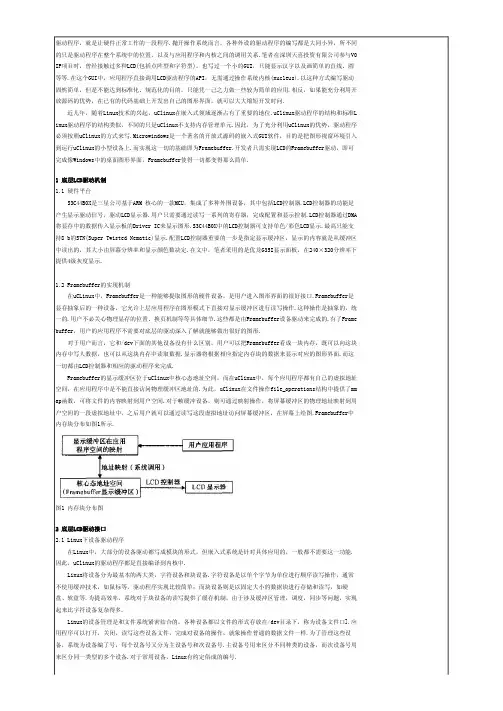

上图描述了帧缓冲对象、纹理对象、渲染缓冲对象之间的关系。

帧缓冲对象中可以连接多个纹理对象和渲染缓冲对象到连接点上。

图中显示有多个颜色连接点,一个深度连接点,一个模版连接点。

颜色连接点数量由具体实现决定,但一个fbo中至少要有一个。

通过GL_MAX_COLOR_ATTACHMENTS参数查阅当前显卡支持的最大值。

fbo中有多个颜色连接点是为了可以同时有多个渲染目的地。

基于Linux内核framebuffer的图像采集与显示系统设计李艳;吴浩;刘政科【期刊名称】《计算机测量与控制》【年(卷),期】2018(026)003【摘要】针对工业控制领域的自动化生产需要,设计了一种基于 Linux 内核驱动framebuffer 和 UVC 类型摄像头的图像采集与显示系统;以三星公司的S5PV210微控制器为控制单元,基于Linux 内核移植了framebuffer驱动,调用Linux 内核提供的 V4L2编程接口,基于Epoll架构进行多路图像采集;对采集到 YUVU 格式图像进行编码,转化成BMP和JPEG 保存,以便后续对图片做相应的应用开发;最后调用libjpeg 库函数对jpeg图片进行解码,并显示在 TFTLCD屏幕上;实验结果显示:能够采集到图片数据,并能成功在 LCD屏幕上显示,framebuffer驱动能正常工作,满足工业自动化生产图象处理的需求.%According to the need of automatic production in the field of industrial control,an image acquisition and display system based on embedded Linux kernel framebuffer and USB Video Class type camera is designed.The system uses Samsung S5Pv210 as core controller, and transplated framebuffer driver based on Linux kernel.Calling V4L2 programming interface provided by the Linux kernel,using the UVC types of USB camera multi -channel images acquisition based on Epoll architecture.The image data collected YUVU format is enco-ded,saved as BMP and JPEG file formats for subsequent development and application.Libjpeg library called by the system to decode JPEG images,and make image displayed in the TFT LCD screen.Theresult of experiments show that the images can be collected,saved and dis-played in the LCD screen,and framebuffer driver can work so that can meet the needs of image process in automatic production.【总页数】5页(P124-128)【作者】李艳;吴浩;刘政科【作者单位】东华大学机械工程学院,上海 201620;东华大学机械工程学院,上海201620;东华大学机械工程学院,上海 201620【正文语种】中文【中图分类】TP302.1【相关文献】1.基于ARM9的嵌入式图像采集与显示系统设计 [J], 胡庆;杜小丹;陈辉2.基于FPGA的实时图像采集与显示系统设计 [J], 王涌;肖顺文;郑瑞;陈韵文;罗春梅3.基于FPGA的实时图像采集与显示系统设计 [J], 阳斌;谢亮;金湘亮4.基于LabVIEW的高速图像实时采集显示系统设计 [J], 刘明;张保贵;张原野;袁远5.基于FPGA的图像采集与实时显示系统设计 [J], 李营;吕兆承因版权原因,仅展示原文概要,查看原文内容请购买。

framebuffer简单例子Framebuffer简单编程例子(转贴)http://shinco-/Blog/cns!94EC79D6B044343C!629.entry大家都知道Unix/Linux系统是由命令驱动的。

那么最基本的系统是命令行的(就是想DOS一样的界面)。

X-Window-System 是 Unix/Linux上的图形系统,它是通过X-Server来控制硬件的。

但有一些Linux的发行版在引导的时候就会在屏幕上出现图形,这时的图形是不可能由X来完成的,那是什么机制呢?答案是FrameBuffer。

FrameBuffer不是一个图形系统,更不是窗口系统。

它比X要低级,简单来说FrameBuffer就是一种机制的实现。

这种机制是把屏幕上的每个点映射成一段线性内存空间,程序可以简单的改变这段内存的值来改变屏幕上某一点的颜色。

X的高度可移植性就是来自于这种机制,不管是在那种图形环境下,只要有这种机制的实现就可以运行X。

所以在几乎所有的平台上都有相应的X版本的移植。

下面我们来看看可以利用FrameBuffer来干点什么。

首先看看是否有了相应的驱动:找一下在/dev/下是否有fb*这个设备文件,这是个字符类的特殊文件。

命令:ls -l /dev/fb0 (Enter)crw-rw---- 1 root video 29, 0 Jan 2715:32 /dev/fb0如果没有这个文件也可以找找其他的比如:/dev/fb1,/dev/fb2...如果找不到这些文件,那就得重新编译内核了。

下面假设存在这个文件/dev/fb0,这就是FrameBuffer的设备文件。

有了这个我们可以play with FrameBuffer了。

(一下的操作不一定要在X 下,可以在启动了FrameBuffer的虚拟控制台下)命令:cat /dev/fb0 > sreensnapls -l sreensnap-rw-r--r-- 1 wsw wsw 6291456 Jan 2721:30 sreensnap我们得到了一个恰好6M的文件,再做下面的操作:命令:clear /*清除屏幕的输出*/cat sreensnap > /dev/fb0是不是奇怪的事情发生了?好像是中了病毒一般?屏幕又恢复了以前的状态?不用着急,命令:clear这样屏幕就正常了。

framebuffer-con0-alldata 类型-回复以下是关于[framebuffercon0alldata 类型]的一步一步回答的文章,希望能给你带来帮助。

[framebuffercon0alldata 类型]是一种用于图形处理的数据类型。

在计算机图形学中,帧缓冲是一个用于存储图像像素值的内存区域。

而[framebuffercon0alldata 类型]则扩展了帧缓冲的功能,可以存储包含图像数据以及其他相关属性信息的结构。

下面我们将一步一步的介绍[framebuffercon0alldata 类型]的定义、用途以及实际应用中的一些问题和解决方案。

首先,让我们从[framebuffercon0alldata 类型]的定义开始。

[framebuffercon0alldata 类型]通常由一个结构体组成,该结构体包含了一系列用于描述图像的属性字段,如图像的宽度、高度、像素位深度、颜色模型等。

此外,它还可以包含用于存储图像数据的缓冲区指针。

通过这些属性字段,我们可以方便地获取和操作图像的信息。

[framebuffercon0alldata 类型]在图形处理中有着广泛的应用。

它可以用于图像处理算法的实现、图像的渲染和显示、图像的编解码等方面。

通过[framebuffercon0alldata 类型],我们可以对图像进行各种操作,例如调整亮度、对比度和色彩平衡,进行滤波和卷积操作,以及应用各种视觉效果等等。

同时,它还可以用于图形显示设备的控制,比如刷新率的设置、分辨率的调整以及字体和图像的渲染等。

然而,在实际应用中,使用[framebuffercon0alldata 类型]可能会遇到一些问题。

例如,当处理大尺寸的图像时,[framebuffercon0alldata 类型]需要分配大量的内存空间来存储图像数据,这可能导致内存不足的问题。

此外,由于图像数据的读写操作需要较大的带宽和处理能力,因此,当对多幅图像进行处理时,帧缓冲可能会成为性能瓶颈。

基于FrameBuffer的简易图形库开发QT不是基于FrameBuffer的吗,现在被Nokia收购了,可惜对于很简单的应用,QT太宠大了,既然知道FrameBuffer的工作原理,自己写一个也行啊,找了找资料,写了以下的代码,当然功能极其简单,实现的基本原理是将FrameBuffer 的物理内容映射到进程空间内,然后直接对这段内存进行写操作,这样就会直接将数据显示在屏幕上。

//zsygui.h#ifndef __ZSYGUI_H__#define __ZSYGUI_H__#include <stdio.h>#include <unistd.h>#include <sys/types.h>#include <sys/stat.h>#include <fcntl.h>#include <linux/fb.h>#include <sys/mman.h>#include <stdlib.h>#include <string.h>#define ERR(fmt,args...) printf("Error:" fmt,##args)/*frame buffer device structure*/struct fb_dev{int fd; /*file descriptor*/struct fb_fix_screeninfo fixinfo;struct fb_var_screeninfo varinfo;char *addr; /*map address*/int fb_size; /*frame buffer size*/char *buffer; /*buffer,equals to framebufer's size*/};struct fb_dev* zsygui_open(const char *device,int mode);extern int zsygui_flush_buffer(struct fb_dev *pdev);extern int zsygui_fill_color(struct fb_dev*pdev,int color);extern int zsygui_draw_line(struct fb_dev *pdev,int whichline,int startpos,int endpos,int color);extern int zsygui_close(struct fb_dev *pdev);#endif //__ZSYGUI_H__//zsygui.c#include "zsygui.h"struct fb_dev* zsygui_open(const char *device,int mode){struct fb_dev *dev=(struct fb_dev*)malloc(sizeof(struct fb_dev));if(!dev){return NULL;}if(!device){free(dev);return NULL;}if((dev->fd=open(device,mode))<0){printf("open %s failed./n",device);free(dev);return NULL;}if(ioctl(dev->fd,FBIOGET_FSCREENINFO,&dev->fixinfo)==-1){printf("ioctl failed./n");free(dev);return NULL;}if(ioctl(dev->fd,FBIOGET_VSCREENINFO,&dev->varinfo)==-1){printf("ioctl failed./n");free(dev);return NULL;}//frame buffer sizedev->fb_size=(dev->varinfo.yres) * (dev->fixinfo.line_length);//map physical address to process virtual addressdev->addr=mmap(NULL,dev->fb_size,PROT_READ|PROT_WRITE,MAP_SHARED,dev ->fd,0);if(!dev->addr){printf("mmap failed./n");free(dev);return NULL;}//allocate the same size bufferdev->buffer=(char*)malloc(dev->fb_size);if(!dev->buffer){printf("malloc failed./n");free(dev);return NULL;}memset(dev->buffer,0,dev->fb_size);return dev;}int zsygui_fill_color(struct fb_dev*pdev,int color){if(!pdev){return -1;}memset(pdev->buffer,color,pdev->fb_size);zsygui_flush_buffer(pdev);return 0;}int zsygui_close(struct fb_dev*pdev){free(pdev->buffer);free(pdev);}int zsygui_flush_buffer(struct fb_dev *pdev){char *src,*dst;int size=0;int lines=0;int offset=0;if(!pdev){return -1;}src=pdev->buffer;dst=pdev->addr;size=pdev->varinfo.xres;printf("bits_per_pixel=%d/n",pdev->varinfo.bits_per_pixel);//这里实现一行一行的写,相当于逐行扫描//一个像素对应几个位,由bits_per_pixel获取,除以8,得到字节数//每次地址要偏移xres个单元lines=pdev->varinfo.yres*((pdev->varinfo.bits_per_pixel)/8);offset=pdev->varinfo.xres;while(lines-->=0){memcpy(dst,src,size);src+=offset;dst+=offset;}return 0;}int zsygui_draw_hline(struct fb_dev*pdev,int whichline,int startpos,int endpos,int color){int i;char *buf;if(!pdev){return -1;}if(startpos<0 || startpos>pdev->varinfo.xres)startpos=0;if(endpos<0 || endpos>pdev->varinfo.xres)endpos=pdev->varinfo.xres;if(whichline<0 || whichline>pdev->varinfo.yres)whichline=0;buf=pdev->buffer+whichline*pdev->varinfo.xres;for(i=startpos;i<endpos;i++)*buf++=color;zsygui_flush_buffer(pdev);return 0;}//测试程序#include "zsygui.h"int main(int argc,char **argv){struct fb_dev *dev;dev=zsygui_open("/dev/fb0",O_RDWR);printf("%p/n",dev);zsygui_fill_color(dev,0x0);zsygui_draw_hline(dev,300,0,500,0xb0);zsygui_draw_hline(dev,301,0,500,0xb0);zsygui_close(dev);return 0;}差不多,编译后,尽量在字符模式下编译,运行,实现了预期效果,后来我把它交叉编译后,放到ARM板上,运行也算良好。

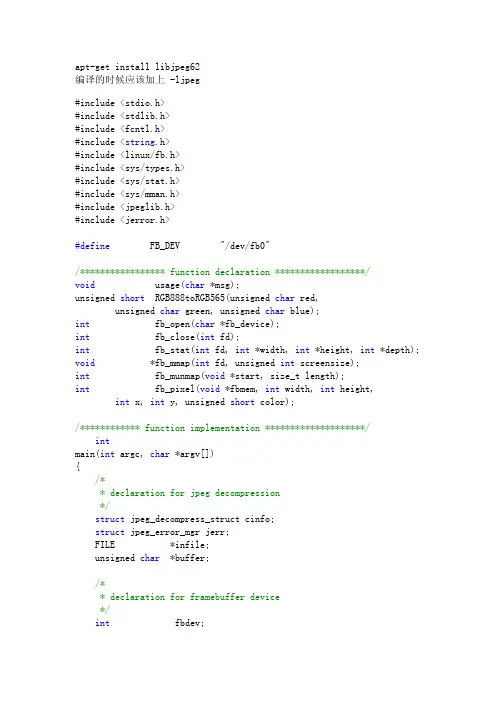

下一次的工作就是要将jpeg格式的图片,显示出来,涉及到jpeg解码问题,当然,自己写是不太可能的,不过,我找到了一个libjpeg的解码库,这个还不错,可以直接使用,等成功了,再发上来!编译libjpeg库1.download jpegsrc.v7.tar.gz2.tar zxvf jpegsrc.v7.tar.gz3.cd jpeg-74. mkdir ../libjpeg75../configure ---prefix=/home/creatory/ldd3/code/libjpeg7 && make && make install这样就在libjpeg7目录下生成了相当的文件#ls libjpeg7发生有如下目录bin include lib share看来头文件和库都生成了。