Hadoop集群的搭建方法与步骤

- 格式:docx

- 大小:37.70 KB

- 文档页数:3

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS本教程讲述如何配置Hadoop 集群,默认读者已经掌握了Hadoop 的单机伪分布式配置,否则请先查看Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置。

本教程由厦门大学数据库实验室出品,转载请注明。

本教程适合于原生Hadoop 2,包括Hadoop 2.6.0, Hadoop 2.7.1 等版本,主要参考了官方安装教程,步骤详细,辅以适当说明,保证按照步骤来,都能顺利安装并运行Hadoop。

另外有Hadoop安装配置简略版方便有基础的读者快速完成安装。

为了方便新手入门,我们准备了两篇不同系统的Hadoop 伪分布式配置教程。

但其他Hadoop 教程我们将不再区分,可同时适用于Ubuntu 和CentOS/RedHat 系统。

例如本教程以Ubuntu 系统为主要演示环境,但对Ubuntu/CentOS 的不同配置之处、CentOS 6.x 与CentOS 7 的操作区别等都会尽量给出注明。

环境本教程使用Ubuntu 14.04 64位作为系统环境,基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1,Hadoop 2.4.1 等。

本教程简单的使用两个节点作为集群环境: 一个作为Master 节点,局域网IP 为192.168.1.121;另一个作为Slave 节点,局域网IP 为192.168.1.122。

准备工作Hadoop 集群的安装配置大致为如下流程:1.选定一台机器作为Master2.在Master 节点上配置hadoop 用户、安装SSH server、安装Java 环境3.在Master 节点上安装Hadoop,并完成配置4.在其他Slave 节点上配置hadoop 用户、安装SSH server、安装Java 环境5.将Master 节点上的/usr/local/hadoop 目录复制到其他Slave 节点上6.在Master 节点上开启Hadoop配置hadoop 用户、安装SSH server、安装Java 环境、安装Hadoop 等过程已经在Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置中有详细介绍,请前往查看,不再重复叙述。

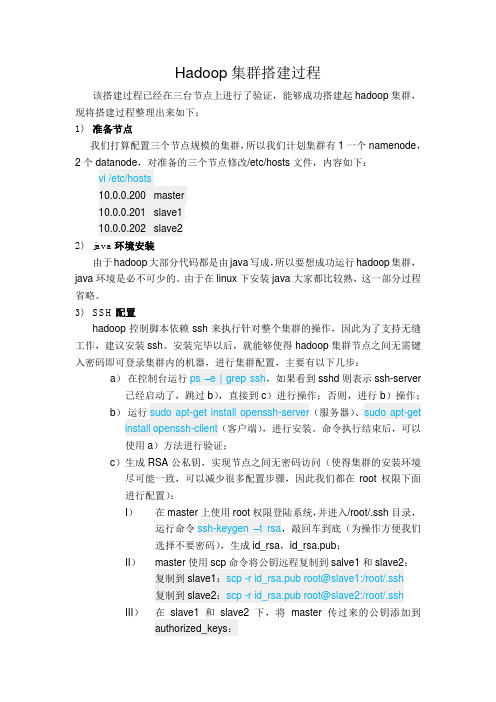

Hadoop集群搭建过程该搭建过程已经在三台节点上进行了验证,能够成功搭建起hadoop集群,现将搭建过程整理出来如下:1)准备节点我们打算配置三个节点规模的集群,所以我们计划集群有1一个namenode,2个datanode,对准备的三个节点修改/etc/hosts文件,内容如下:vi /etc/hosts10.0.0.200 master10.0.0.201 slave110.0.0.202 slave22)java环境安装由于hadoop大部分代码都是由java写成,所以要想成功运行hadoop集群,java环境是必不可少的。

由于在linux下安装java大家都比较熟,这一部分过程省略。

3)SSH配置hadoop控制脚本依赖ssh来执行针对整个集群的操作,因此为了支持无缝工作,建议安装ssh。

安装完毕以后,就能够使得hadoop集群节点之间无需键入密码即可登录集群内的机器,进行集群配置,主要有以下几步:a)在控制台运行ps –e | grep ssh,如果看到sshd则表示ssh-server 已经启动了,跳过b),直接到c)进行操作;否则,进行b)操作;b)运行sudo apt-get install openssh-server(服务器)、sudo apt-get install openssh-client(客户端),进行安装。

命令执行结束后,可以使用a)方法进行验证;c)生成RSA公私钥,实现节点之间无密码访问(使得集群的安装环境尽可能一致,可以减少很多配置步骤,因此我们都在root权限下面进行配置):I)在master上使用root权限登陆系统,并进入/root/.ssh目录,运行命令ssh-keygen –t rsa,敲回车到底(为操作方便我们选择不要密码),生成id_rsa,id_rsa.pub;II)master使用scp命令将公钥远程复制到salve1和slave2:复制到slave1:scp -r id_rsa.pub root@slave1:/root/.ssh复制到slave2:scp -r id_rsa.pub root@slave2:/root/.ssh III)在slave1和slave2下,将master传过来的公钥添加到authorized_keys:cat id_rsa.pub >> authorized_keysIV)至此,master到slave1和slave2即实现了无密码登陆4)hadoop配置下载hadoop最新的稳定版本,并复制到/usr/local,接下来开始进行集群的配置:a)解压hadoop:tar xzf hadoop.tar.gzb)修改相关配置文件,由于master和slave配置不一致(可以使用一致配置,但不推荐),所以将它们的配置分开陈述:对于master来说,需要修改四个文件:I)hadoop/conf/masters:vi /mastersmasterII)hadoop/conf/slaves:vi /slavesslave1slave2III)hadoop/conf/hadoop-env.sh:vi /hadoop-env.shexport JAVA_HOME=具体的java路径IV)core-site.xml:vi /core-site.xml<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name></name><value>hdfs://master:54310/</value></property><property><name>mapred.job.tracker</name>//<value>hdfs://master:54311/</value></property><property><name>dfs.replication</name><value>3</value> #指定HDFS 中每个Block 被复制的次数,起数据冗余备份的作用。

搭建hadoop集群的步骤Hadoop是一个开源的分布式计算平台,用于存储和处理大规模的数据集。

在大数据时代,Hadoop已经成为了处理海量数据的标准工具之一。

在本文中,我们将介绍如何搭建一个Hadoop集群。

步骤一:准备工作在开始搭建Hadoop集群之前,需要进行一些准备工作。

首先,需要选择适合的机器作为集群节点。

通常情况下,需要至少三台机器来搭建一个Hadoop集群。

其次,需要安装Java环境和SSH服务。

最后,需要下载Hadoop的二进制安装包。

步骤二:配置Hadoop环境在准备工作完成之后,需要对Hadoop环境进行配置。

首先,需要编辑Hadoop的配置文件,包括core-site.xml、hdfs-site.xml、mapred-site.xml和yarn-site.xml。

其中,core-site.xml用于配置Hadoop的核心参数,hdfs-site.xml用于配置Hadoop分布式文件系统的参数,mapred-site.xml用于配置Hadoop的MapReduce参数,yarn-site.xml用于配置Hadoop的资源管理器参数。

其次,需要在每个节点上创建一个hadoop用户,并设置其密码。

最后,需要在每个节点上配置SSH免密码登录,以便于节点之间的通信。

步骤三:启动Hadoop集群在完成Hadoop环境的配置之后,可以启动Hadoop集群。

首先,需要启动Hadoop的NameNode和DataNode服务。

NameNode是Hadoop分布式文件系统的管理节点,负责管理文件系统的元数据。

DataNode是Hadoop分布式文件系统的存储节点,负责实际存储数据。

其次,需要启动Hadoop的ResourceManager和NodeManager服务。

ResourceManager 是Hadoop的资源管理器,负责管理集群中的资源。

NodeManager是Hadoop的节点管理器,负责管理每个节点的资源。

包所在目有的话删除连接的java文件夹,没有直接创建一个连接文件夹java #java -version#ssh-keygen -t rsaauthorized_keys,将~/.ssh/id_rsa.pub里的内容复制到authorized_keys 桌面上的authorized_keys文件将~/.ssh/id_rsa.pub里的内容复制到authorized_keys文件里3.其他机器重复上述步骤4.将authorized_keys文件分别放到~/.ssh/下到此ssh免密码登录完成2.#ln -s hadoop-2.5.2 hadoop1.2.namenode节点,hdfs-site.xml配置需如下3.默认情况下是没有mapred-site.xml文件的,但是有mapred-site.xml.template文件,需要将mapred-site.xml.template复制一份并改名为mapred-site.xml#cp mapred-site.xml.template mapred-site.xml添加以下内容4.5.在其他机器上重复上述步骤,注意core-site.xml和yarn-site.xml都不变服务器上格式化datanode9.启动好后先运行start-dfs.sh,并测试10.启动start-yarn.sh第七步:配置zookeeper2.使用scp命令将改好的文件分发给其他的服务器文件:4.5.A_HOME和HBASE_MANAGES_ZK2.这两个文件分发到集群的其他服务器上3.修改datanode机器中/opt/software/hbase/conf/下的regionservers#cd /opt/software/hbase/conf/#vim regionserversSystem.out.println( "row Name:" + new String( CellUtil.cloneQualifier( cell ) ) + " " );System.out.println( "value:" + new String( CellUtil.cloneValue( cell ) ) + " " ); }}} finally {t.close();}System.out.println( "Done!" );注意,java测试程序所在机器的hosts文件,注意必须有全FDQN(fully qualified domain name, 参见上面linux中的hosts文件),否则有java访问时会提示找不到第九步:修该/etc/security/limits.conf#vim /etc/security/limits.conf添加:。

hadoop集群安装配置的主要操作步骤-概述说明以及解释1.引言1.1 概述Hadoop是一个开源的分布式计算框架,主要用于处理和存储大规模数据集。

它提供了高度可靠性、容错性和可扩展性的特性,因此被广泛应用于大数据处理领域。

本文旨在介绍Hadoop集群安装配置的主要操作步骤。

在开始具体的操作步骤之前,我们先对Hadoop集群的概念进行简要说明。

Hadoop集群由一组互联的计算机节点组成,其中包含了主节点和多个从节点。

主节点负责调度任务并管理整个集群的资源分配,而从节点则负责实际的数据存储和计算任务执行。

这种分布式的架构使得Hadoop可以高效地处理大规模数据,并实现数据的并行计算。

为了搭建一个Hadoop集群,我们需要进行一系列的安装和配置操作。

主要的操作步骤包括以下几个方面:1. 硬件准备:在开始之前,需要确保所有的计算机节点都满足Hadoop的硬件要求,并配置好网络连接。

2. 软件安装:首先,我们需要下载Hadoop的安装包,并解压到指定的目录。

然后,我们需要安装Java开发环境,因为Hadoop是基于Java 开发的。

3. 配置主节点:在主节点上,我们需要编辑Hadoop的配置文件,包括核心配置文件、HDFS配置文件和YARN配置文件等。

这些配置文件会影响到集群的整体运行方式和资源分配策略。

4. 配置从节点:与配置主节点类似,我们也需要在每个从节点上进行相应的配置。

从节点的配置主要包括核心配置和数据节点配置。

5. 启动集群:在所有节点的配置完成后,我们可以通过启动Hadoop 集群来进行测试和验证。

启动过程中,我们需要确保各个节点之间的通信正常,并且集群的各个组件都能够正常启动和工作。

通过完成以上这些操作步骤,我们就可以成功搭建一个Hadoop集群,并开始进行大数据的处理和分析工作了。

当然,在实际应用中,还会存在更多的细节和需要注意的地方,我们需要根据具体的场景和需求进行相应的调整和扩展。

1.Hadoop集群搭建(单机伪分布式)>>>加磁盘1)⾸先先将虚拟机关机2)选中需要加硬盘的虚拟机:右键-->设置-->选中硬盘,点击添加-->默认选中硬盘,点击下⼀步-->默认硬盘类型SCSI(S),下⼀步-->默认创建新虚拟磁盘(V),下⼀步-->根据实际需求,指定磁盘容量(单个或多个⽂件⽆所谓,选哪个都⾏),下⼀步。

-->指定磁盘⽂件,选择浏览,找到现有虚拟机的位置(第⼀次出现.vmdk⽂件的⽂件夹),放到⼀起,便于管理。

点击完成。

-->点击确定。

3) 可以看到现在选中的虚拟机有两块硬盘,点击开启虚拟机。

这个加硬盘只是在VMWare中,实际⼯作中直接买了硬盘加上就可以了。

4)对/dev/sdb进⾏分区df -h 查看当前已⽤磁盘分区fdisk -l 查看所有磁盘情况磁盘利⽤情况,依次对磁盘命名的规范为,第⼀块磁盘sda,第⼆块为sdb,第三块为sdc。

可以看到下图的Disk /dev/sda以第⼀块磁盘为例,磁盘分区的命名规范依次为sda1,sda2,sda3。

同理也会有sdb1,sdb2,sdb3。

可以参照下图的/dev/sda1。

下⾯的含义代表sda盘有53.7GB,共分为6527个磁柱,每个磁柱单元Units的⼤⼩为16065*512=8225280 bytes。

sda1分区为1-26号磁柱,sda2分区为26-287号磁柱,sda3为287-6528号磁柱下⾯的图⽚可以看到,还未对sdb磁盘进⾏分区fdisk /dev/sdb 分区命令可以选择m查看帮助,显⽰命令列表p 显⽰磁盘分区,同fdisk -ln 新增分区d 删除分区w 写⼊并退出选w直接将分区表写⼊保存,并退出。

mkfs -t ext4 /dev/sdb1 格式化分区,ext4是⼀种格式mkdir /newdisk 在根⽬录下创建⼀个⽤于挂载的⽂件mount /dev/sdb1 /newdisk 挂载sdb1到/newdisk⽂件(这只是临时挂载的解决⽅案,重启机器就会发现失去挂载)blkid /dev/sdb1 通过blkid命令⽣成UUIDvi /etc/fstab 编辑fstab挂载⽂件,新建⼀⾏挂载记录,将上⾯⽣成的UUID替换muount -a 执⾏后⽴即⽣效,不然的话是重启以后才⽣效。

hadoop集群建设方案如何构建一个Hadoop集群。

Hadoop集群的构建是一个复杂的过程,涉及到硬件设备的选择、网络连接的配置、软件环境的搭建等诸多方面。

本文将从集群规模、硬件设备、操作系统、网络连接、Hadoop软件的安装与配置等方面,一步一步地介绍如何构建一个Hadoop集群。

一、集群规模的确定在构建Hadoop集群之前,首先需要确定集群规模,即集群中节点的数量。

集群规模的确定需要考虑到数据量的大小、负载的情况以及可承受的成本等因素。

一般来说,至少需要3个节点才能构建一个功能完善的Hadoop 集群,其中一个作为主节点(NameNode),其余为从节点(DataNode)。

二、硬件设备的选择在选择硬件设备时,需要考虑到节点的计算性能、存储容量以及网络带宽等因素。

对于主节点,需要选择一台计算性能较高、内存较大的服务器,通常选择多核CPU和大容量内存。

对于从节点,可以选择较为经济实惠的服务器或者PC机,存储容量要满足数据存储的需求,同时要保证网络带宽的充足。

三、操作系统的配置在构建Hadoop集群之前,需要在每个节点上安装操作系统,并设置网络连接。

一般推荐选择Linux 操作系统,如CentOS、Ubuntu 等。

安装完成后,需要配置每个节点的域名解析、主机名以及网络连接,确保各个节点之间能够相互通信。

四、网络连接的配置在构建Hadoop集群过程中,节点之间需要进行网络连接的配置。

可以使用以太网、局域网或者云服务器等方式进行连接。

在网络连接的配置过程中,需要设置IP地址、子网掩码、网关等参数,确保各个节点之间的通信畅通。

五、Hadoop软件的安装与配置Hadoop软件的安装与配置是构建Hadoop集群的关键步骤。

在每个节点上,需要安装并配置Hadoop软件,包括Hadoop的核心组件和相关工具。

安装Hadoop软件可以通过源码编译安装或者使用预编译的二进制包安装。

安装完成后,还需要进行相应的配置,包括修改配置文件、设置环境变量等。

hadoop2.2.0集群搭建PS:apache提供的hadoop-2.2.0的安装包是在32位操作系统编译的,因为hadoop依赖一些C++的本地库,所以如果在64位的操作上安装hadoop-2.2.0就需要重新在64操作系统上重新编译1.准备工作:(参考伪分布式搭建)1.1修改Linux主机名1.2修改IP1.3修改主机名和IP的映射关系1.4关闭防火墙1.5ssh免登陆1.6.安装JDK,配置环境变量等2.集群规划:PS:在hadoop2.0中通常由两个NameNode组成,一个处于active 状态,另一个处于standby状态。

Active NameNode对外提供服务,而Standby NameNode则不对外提供服务,仅同步active namenode的状态,以便能够在它失败时快速进行切换。

hadoop2.0官方提供了两种HDFS HA的解决方案,一种是NFS,另一种是QJM。

这里我们使用简单的QJM。

在该方案中,主备NameNode之间通过一组JournalNode同步元数据信息,一条数据只要成功写入多数JournalNode即认为写入成功。

通常配置奇数个JournalNode这里还配置了一个zookeeper集群,用于ZKFC(DFSZKFailoverController)故障转移,当Active NameNode挂掉了,会自动切换Standby NameNode为standby状态3.安装步骤:3.1.安装配置zooekeeper集群3.1.1解压tar -zxvf zookeeper-3.4.5.tar.gz -C /cloud/3.1.2修改配置cd /cloud/zookeeper-3.4.5/conf/cp zoo_sample.cfg zoo.cfgvim zoo.cfg修改:dataDir=/cloud/zookeeper-3.4.5/tmp在最后添加:server.1=hadoop01:2888:3888server.2=hadoop02:2888:3888server.3=hadoop03:2888:3888保存退出然后创建一个tmp文件夹mkdir /cloud/zookeeper-3.4.5/tmp再创建一个空文件touch /cloud/zookeeper-3.4.5/tmp/myid最后向该文件写入IDecho 1 > /cloud/zookeeper-3.4.5/tmp/myid3.1.3将配置好的zookeeper拷贝到其他节点(首先分别在hadoop02、hadoop03根目录下创建一个cloud目录:mkdir /cloud)scp -r /cloud/zookeeper-3.4.5/ hadoop02:/cloud/scp -r /cloud/zookeeper-3.4.5/ hadoop03:/cloud/注意:修改hadoop02、hadoop03对应/cloud/zookeeper-3.4.5/tmp/myid内容hadoop02:echo 2 > /cloud/zookeeper-3.4.5/tmp/myidhadoop03:echo 3 > /cloud/zookeeper-3.4.5/tmp/myid3.2.安装配置hadoop集群3.2.1解压tar -zxvf hadoop-2.2.0.tar.gz -C /cloud/3.2.2配置HDFS(hadoop2.0所有的配置文件都在$HADOOP_HOME/etc/hadoop目录下)将hadoop添加到环境变量中vim /etc/profileexport JAVA_HOME=/usr/java/jdk1.6.0_45export HADOOP_HOME=/cloud/hadoop-2.2.0export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin cd /cloud/hadoop-2.2.0/etc/hadoop3.2.2.1修改hadoo-env.shexport JAVA_HOME=/usr/java/jdk1.6.0_453,2.2.2修改core-site.xml<configuration><!-- 指定hdfs的nameservice为ns1 --><property><name>fs.defaultFS</name><value>hdfs://ns1</value></property><!-- 指定hadoop临时目录--><property><name>hadoop.tmp.dir</name><value>/cloud/hadoop-2.2.0/tmp</value></property><!-- 指定zookeeper地址--><property><name>ha.zookeeper.quorum</name><value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value></property></configuration>3,2.2.3修改hdfs-site.xml<configuration><!--指定hdfs的nameservice为ns1,需要和core-site.xml中的保持一致--><property><name>services</name><value>ns1</value></property><!-- ns1下面有两个NameNode,分别是nn1,nn2 --> <property><name>nodes.ns1</name><value>nn1,nn2</value></property><!-- nn1的RPC通信地址--><property><name>node.rpc-address.ns1.nn1</name><value>hadoop01:9000</value></property><!-- nn1的http通信地址--><property><name>node.http-address.ns1.nn1</name><value>hadoop01:50070</value></property><!-- nn2的RPC通信地址--><property><name>node.rpc-address.ns1.nn2 </name><value>hadoop02:9000</value></property><!-- nn2的http通信地址--><property><name>node.http-address.ns1.nn2 </name><value>hadoop02:50070</value></property><!-- 指定NameNode的元数据在JournalNode上的存放位置--><property><name>node.shared.edits.dir<value>qjournal://hadoop01:8485;hadoop02:8485;hadoop03:8485 /ns1</value></property><!-- 指定JournalNode在本地磁盘存放数据的位置--><property><name>dfs.journalnode.edits.dir</name><value>/cloud/hadoop-2.2.0/journal</value></property><!-- 开启NameNode失败自动切换--><property><name>dfs.ha.automatic-failover.enabled</name><value>true</value></property><!-- 配置失败自动切换实现方式--><name>dfs.client.failover.proxy.provider.ns1</name><value>node.ha. ConfiguredFailoverProxyProvider</value></property><!-- 配置隔离机制--><property><name>dfs.ha.fencing.methods</name><value>sshfence</value></property><!-- 使用隔离机制时需要ssh免登陆--><property><name>dfs.ha.fencing.ssh.private-key-files</name><value>/root/.ssh/id_rsa</value> </property></configuration>3.2.2.4修改slaveshadoop01hadoop02hadoop033.2.3配置YARN3.2.3.1修改yarn-site.xml<configuration><!-- 指定resourcemanager地址--> <property><name>yarn.resourcemanager.hostname</name><value>hadoop01</value></property><!-- 指定nodemanager启动时加载server的方式为shuffle server --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property></configuration>3.2.3.2修改mapred-site.xml<configuration><!-- 指定mr框架为yarn方式--><property><name></name><value>yarn</value></property></configuration>3.2.4将配置好的hadoop拷贝到其他节点scp -r /cloud/hadoop-2.2.0/ hadoo02:/cloud/scp -r /cloud/hadoop-2.2.0/ hadoo03:/cloud/3.2.5启动zookeeper集群(分别在hadoop01、hadoop02、hadoop03上启动zk)cd /cloud/zookeeper-3.4.5/bin/./zkServer.sh start查看状态:./zkServer.sh status(一个leader,两个follower)3.2.6启动journalnode(在hadoop01上启动所有journalnode)cd /cloud/hadoop-2.2.0sbin/hadoop-daemons.sh start journalnode(运行jps命令检验,多了JournalNode进程)3.2.7格式化HDFS在hadoop01上执行命令:hadoop namenode -format格式化后会在根据core-site.xml中的hadoop.tmp.dir配置生成个文件,这里我配置的是/cloud/hadoop-2.2.0/tmp,然后将/cloud/hadoop-2.2.0/tmp拷贝到hadoop02的/cloud/hadoop-2.2.0/下。

⼤数据--Hadoop集群环境搭建⾸先我们来认识⼀下HDFS, HDFS(Hadoop Distributed File System )Hadoop分布式⽂件系统。

它其实是将⼀个⼤⽂件分成若⼲块保存在不同服务器的多个节点中。

通过联⽹让⽤户感觉像是在本地⼀样查看⽂件,为了降低⽂件丢失造成的错误,它会为每个⼩⽂件复制多个副本(默认为三个),以此来实现多机器上的多⽤户分享⽂件和存储空间。

Hadoop主要包含三个模块:HDFS模块:HDFS负责⼤数据的存储,通过将⼤⽂件分块后进⾏分布式存储⽅式,突破了服务器硬盘⼤⼩的限制,解决了单台机器⽆法存储⼤⽂件的问题,HDFS是个相对独⽴的模块,可以为YARN提供服务,也可以为HBase等其他模块提供服务。

YARN模块:YARN是⼀个通⽤的资源协同和任务调度框架,是为了解决Hadoop中MapReduce⾥NameNode负载太⼤和其他问题⽽创建的⼀个框架。

YARN是个通⽤框架,不⽌可以运⾏MapReduce,还可以运⾏Spark、Storm等其他计算框架。

MapReduce模块:MapReduce是⼀个计算框架,它给出了⼀种数据处理的⽅式,即通过Map阶段、Reduce阶段来分布式地流式处理数据。

它只适⽤于⼤数据的离线处理,对实时性要求很⾼的应⽤不适⽤。

多相关信息可以参考博客:。

本节将会介绍Hadoop集群的配置,⽬标主机我们可以选择虚拟机中的多台主机或者多台阿⾥云服务器。

注意:以下所有操作都是在root⽤户下执⾏的,因此基本不会出现权限错误问题。

⼀、Vmware安装VMware虚拟机有三种⽹络模式,分别是Bridged(桥接模式)、NAT(⽹络地址转换模式)、Host-only(主机模式):桥接:选择桥接模式的话虚拟机和宿主机在⽹络上就是平级的关系,相当于连接在同⼀交换机上;NAT:NAT模式就是虚拟机要联⽹得先通过宿主机才能和外⾯进⾏通信;仅主机:虚拟机与宿主机直接连起来。

Hadoop集群的搭建方法与步骤

随着大数据时代的到来,Hadoop作为一种分布式计算框架,被广泛应用于数

据处理和分析领域。

搭建一个高效稳定的Hadoop集群对于数据科学家和工程师来

说至关重要。

本文将介绍Hadoop集群的搭建方法与步骤。

一、硬件准备

在搭建Hadoop集群之前,首先要准备好适合的硬件设备。

Hadoop集群通常需

要至少三台服务器,一台用于NameNode,两台用于DataNode。

每台服务器的配

置应该具备足够的内存和存储空间,以及稳定的网络连接。

二、操作系统安装

在选择操作系统时,通常推荐使用Linux发行版,如Ubuntu、CentOS等。

这

些操作系统具有良好的稳定性和兼容性,并且有大量的Hadoop安装和配置文档可

供参考。

安装操作系统后,确保所有服务器上的软件包都是最新的。

三、Java环境配置

Hadoop是基于Java开发的,因此在搭建Hadoop集群之前,需要在所有服务器上配置Java环境。

下载最新版本的Java Development Kit(JDK),并按照官方文

档的指引进行安装和配置。

确保JAVA_HOME环境变量已正确设置,并且可以在

所有服务器上运行Java命令。

四、Hadoop安装与配置

1. 下载Hadoop

从Hadoop官方网站上下载最新的稳定版本,并将其解压到一个合适的目录下,例如/opt/hadoop。

2. 编辑配置文件

进入Hadoop的安装目录,编辑conf目录下的hadoop-env.sh文件,设置JAVA_HOME环境变量为Java的安装路径。

然后,编辑core-site.xml文件,配置Hadoop的核心参数,如文件系统的默认URI和临时目录。

接下来,编辑hdfs-site.xml文件,配置Hadoop分布式文件系统(HDFS)的相关参数,如副本数量和数据块大小。

最后,编辑mapred-site.xml文件,配置MapReduce框架的相关参数,如任务调度器和本地任务运行模式。

3. 配置主机文件

在Hadoop的安装目录下,编辑conf目录下的slaves文件,将所有DataNode 的主机名或IP地址逐行添加进去。

4. 格式化HDFS

在NameNode所在的服务器上运行命令:hadoop namenode -format,以格式化HDFS并生成初始的文件系统元数据。

五、启动Hadoop集群

1. 启动NameNode

在NameNode所在的服务器上运行命令:start-dfs.sh,以启动Hadoop分布式文件系统。

2. 启动DataNode

在所有DataNode所在的服务器上运行命令:start-dfs.sh,以启动Hadoop分布式文件系统。

3. 启动YARN

在所有服务器上运行命令:start-yarn.sh,以启动YARN资源管理器。

4. 验证集群状态

在浏览器中输入NameNode所在服务器的IP地址和端口号(默认为50070),可以访问Hadoop集群的Web界面,查看集群的状态和监控信息。

六、集群优化与扩展

搭建好Hadoop集群后,还可以进行一些优化和扩展操作,以提高集群的性能和可靠性。

例如,可以调整HDFS的副本数量和数据块大小,增加DataNode的数量,配置Hadoop的任务调度器等。

总结

通过以上步骤,我们可以成功搭建一个Hadoop集群,并开始进行大数据处理和分析工作。

当然,这只是Hadoop集群搭建的基本过程,实际情况可能因环境和需求的不同而有所差异。

因此,在搭建Hadoop集群之前,最好参考官方文档和其他可靠的资源,以确保正确理解和实施每一步骤。