Hadoop大数据平台构建与应用 第11章 HADOOP集群(完全分布式)环境搭建

- 格式:pptx

- 大小:516.44 KB

- 文档页数:11

《Hadoop大数据技术》课程教学大纲一、课程基本情况课程代码:1041139083课程名称(中/英文):Hadoop大数据技术/Hadoop Big Data Technology课程类别:专业必修课学分:3.5总学时:56理论学时:32实验/实践学时:24适用专业:数据科学与大数据技术适用对象:本科先修课程:JA V A程序设计、Linux基础教学环境:课堂、多媒体、实验机房二、课程简介《Hadoop大数据技术》课程是数据科学与大数据技术专业的专业必修课程。

《Hadoop大数据技术》主要学习当前广泛使用的大数据Hadoop平台及其主要组件的作用及使用。

通过学习Hadoop 平台框架,学会手动搭建Hadoop环境,掌握Hadoop平台上存储及计算的原理、结构、工作流程,掌握基础的MapReduce编程,掌握Hadoop生态圈常用组件的作用、结构、配置和工作流程,并具备大数据的动手及问题分析能力,使用掌握的知识应用到实际的项目实践中。

课程由理论及实践两部分组成,课程理论部分的内容以介绍Hadoop平台主要组件的作用、结构、工作流程为主,对Hadoop 平台组件的作用及其工作原理有比较深入的了解;课程同时为各组件设计有若干实验,使学生在学习理论知识的同时,提高实践动手能力,做到在Hadoop的大数据平台上进行大数据项目开发。

三、课程教学目标2.课程教学目标及其与毕业要求指标点、主要教学内容的对应关系四、教学内容(一)初识Hadoop大数据技术1.主要内容:掌握大数据的基本概念、大数据简史、大数据的类型和特征、大数据对于企业带来的挑战。

了解对于大数据问题,传统方法、Google的解决方案、Hadoop框架下的解决方案,重点了解Google的三篇论文。

掌握Hadoop核心构成、Hadoop生态系统的主要组件、Hadoop发行版本的差异及如何选择;了解Hadoop典型应用场景;了解本课程内容涉及到的Java语言基础;了解本课程实验涉及到的Linux基础。

Hadoop大数据开发基础教案Hadoop介绍教案第一章:Hadoop概述1.1 课程目标了解Hadoop的定义、发展历程及应用场景掌握Hadoop的核心组件及其作用理解Hadoop在大数据领域的优势1.2 教学内容Hadoop的定义与发展历程Hadoop的核心组件:HDFS、MapReduce、YARN Hadoop的应用场景与优势1.3 教学方法讲解与案例分析相结合互动提问,巩固知识点1.4 课后作业简述Hadoop的发展历程及其在大数据领域的优势。

第二章:HDFS(分布式文件系统)2.1 课程目标掌握HDFS的架构与工作原理了解HDFS的优势与局限性掌握HDFS的常用操作命令2.2 教学内容HDFS的架构与工作原理HDFS的优势与局限性HDFS的常用操作命令:hdfs dfs, hdfs dfsadmin2.3 教学方法讲解与实践操作相结合案例分析,理解HDFS的工作原理2.4 课后作业利用HDFS命令练习文件的与。

第三章:MapReduce编程模型3.1 课程目标掌握MapReduce的基本概念与编程模型理解MapReduce的运行原理与执行过程学会使用MapReduce解决大数据问题3.2 教学内容MapReduce的基本概念:Mapper、Reducer、Shuffle与Sort MapReduce的编程模型:Map阶段、Shuffle阶段、Reduce阶段MapReduce的运行原理与执行过程3.3 教学方法讲解与编程实践相结合剖析经典MapReduce案例,理解编程模型3.4 课后作业编写一个简单的MapReduce程序,实现单词计数功能。

第四章:YARN(资源管理器)4.1 课程目标掌握YARN的基本概念与架构了解YARN的工作原理与调度策略掌握YARN的资源管理与优化方法4.2 教学内容YARN的基本概念与架构YARN的工作原理与调度策略YARN的资源管理与优化方法4.3 教学方法讲解与案例分析相结合实操演练,掌握YARN的资源管理方法4.4 课后作业分析一个YARN集群的资源使用情况,提出优化方案。

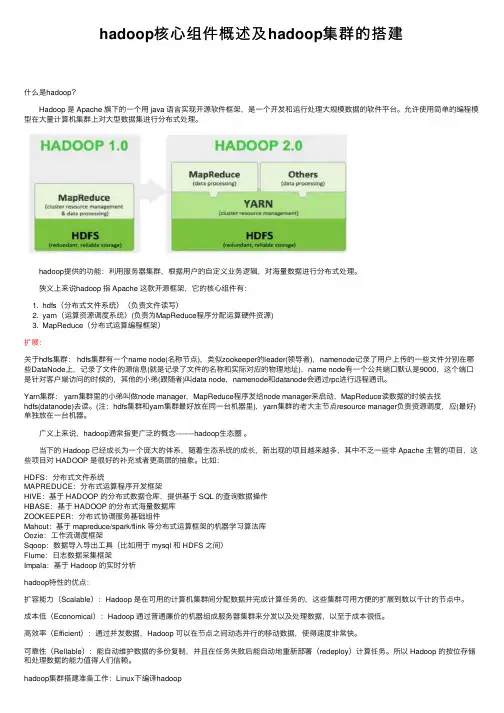

hadoop核⼼组件概述及hadoop集群的搭建什么是hadoop? Hadoop 是 Apache 旗下的⼀个⽤ java 语⾔实现开源软件框架,是⼀个开发和运⾏处理⼤规模数据的软件平台。

允许使⽤简单的编程模型在⼤量计算机集群上对⼤型数据集进⾏分布式处理。

hadoop提供的功能:利⽤服务器集群,根据⽤户的⾃定义业务逻辑,对海量数据进⾏分布式处理。

狭义上来说hadoop 指 Apache 这款开源框架,它的核⼼组件有:1. hdfs(分布式⽂件系统)(负责⽂件读写)2. yarn(运算资源调度系统)(负责为MapReduce程序分配运算硬件资源)3. MapReduce(分布式运算编程框架)扩展:关于hdfs集群: hdfs集群有⼀个name node(名称节点),类似zookeeper的leader(领导者),namenode记录了⽤户上传的⼀些⽂件分别在哪些DataNode上,记录了⽂件的源信息(就是记录了⽂件的名称和实际对应的物理地址),name node有⼀个公共端⼝默认是9000,这个端⼝是针对客户端访问的时候的,其他的⼩弟(跟随者)叫data node,namenode和datanode会通过rpc进⾏远程通讯。

Yarn集群: yarn集群⾥的⼩弟叫做node manager,MapReduce程序发给node manager来启动,MapReduce读数据的时候去找hdfs(datanode)去读。

(注:hdfs集群和yarn集群最好放在同⼀台机器⾥),yarn集群的⽼⼤主节点resource manager负责资源调度,应(最好)单独放在⼀台机器。

⼴义上来说,hadoop通常指更⼴泛的概念--------hadoop⽣态圈。

当下的 Hadoop 已经成长为⼀个庞⼤的体系,随着⽣态系统的成长,新出现的项⽬越来越多,其中不乏⼀些⾮ Apache 主管的项⽬,这些项⽬对 HADOOP 是很好的补充或者更⾼层的抽象。

搭建hadoop集群的步骤Hadoop是一个开源的分布式计算平台,用于存储和处理大规模的数据集。

在大数据时代,Hadoop已经成为了处理海量数据的标准工具之一。

在本文中,我们将介绍如何搭建一个Hadoop集群。

步骤一:准备工作在开始搭建Hadoop集群之前,需要进行一些准备工作。

首先,需要选择适合的机器作为集群节点。

通常情况下,需要至少三台机器来搭建一个Hadoop集群。

其次,需要安装Java环境和SSH服务。

最后,需要下载Hadoop的二进制安装包。

步骤二:配置Hadoop环境在准备工作完成之后,需要对Hadoop环境进行配置。

首先,需要编辑Hadoop的配置文件,包括core-site.xml、hdfs-site.xml、mapred-site.xml和yarn-site.xml。

其中,core-site.xml用于配置Hadoop的核心参数,hdfs-site.xml用于配置Hadoop分布式文件系统的参数,mapred-site.xml用于配置Hadoop的MapReduce参数,yarn-site.xml用于配置Hadoop的资源管理器参数。

其次,需要在每个节点上创建一个hadoop用户,并设置其密码。

最后,需要在每个节点上配置SSH免密码登录,以便于节点之间的通信。

步骤三:启动Hadoop集群在完成Hadoop环境的配置之后,可以启动Hadoop集群。

首先,需要启动Hadoop的NameNode和DataNode服务。

NameNode是Hadoop分布式文件系统的管理节点,负责管理文件系统的元数据。

DataNode是Hadoop分布式文件系统的存储节点,负责实际存储数据。

其次,需要启动Hadoop的ResourceManager和NodeManager服务。

ResourceManager 是Hadoop的资源管理器,负责管理集群中的资源。

NodeManager是Hadoop的节点管理器,负责管理每个节点的资源。

Hadoop集群的部署分为三种,分别独立模式(Standalonemode)、伪分布式模式(Pseudo-Distributedmode)、完全分布式模式(Clustermode),具体介绍如下。

(1)独立模式:又称为单机模式,在该模式下,无需运行任何守护进程,所有的

程序都在单个JVM上执行。

独立模式下调试Hadoop集群的MapReduce程序非常

方便,所以一般情况下,该模式在学习或者发阶段调试使用。

(2)伪分布式模式:Hadoop程序的守护进程运行在一台节上,通常使用伪分布

式模式用来调试Hadoop分布式程序的代码,以及程序执行否正确,伪分布式模式完全分布式模式的一个特例。

(3)完全分布式模式:Hadoop的守护进程分别运行在由多个主机搭建的集群上,不同节担任不同的角色,在实际工作应用发中,通常使用该模式构建级Hadoop系统。

在Hadoop环境中,所有器节仅划分为两种角色,分别master(主节,1个)和slave(从节,多个)。

因此,伪分布模式集群模式的特例,只将主节和从节合二

为一罢了。

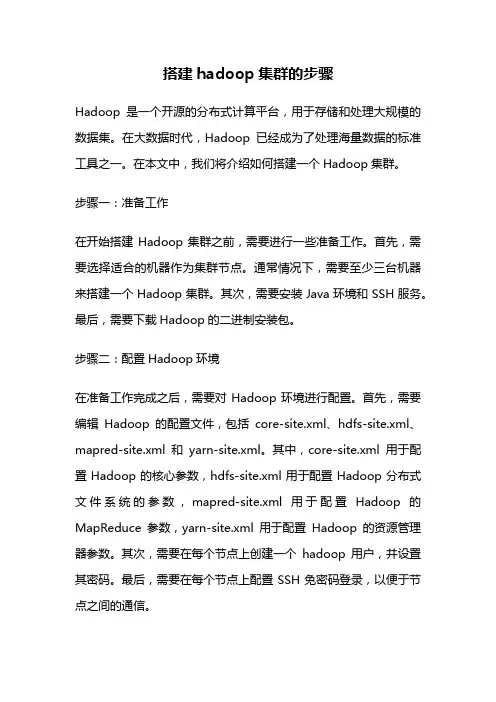

接下来,本书将以前面的三台虚拟机为例,阐述完全分布模式Hadoop集群的与配置方法,具体集群规划如图1所示。

图1Hadoop集群规划

从图1可以看出,当前规划的Hadoop集群包含一台master节和两台slave节。

这里,将前面的Hadoop01作为Master节,Hadoop02和Hadoop03作为Slave

节。

1。

Hadoop集群的搭建方法与步骤随着大数据时代的到来,Hadoop作为一种分布式计算框架,被广泛应用于数据处理和分析领域。

搭建一个高效稳定的Hadoop集群对于数据科学家和工程师来说至关重要。

本文将介绍Hadoop集群的搭建方法与步骤。

一、硬件准备在搭建Hadoop集群之前,首先要准备好适合的硬件设备。

Hadoop集群通常需要至少三台服务器,一台用于NameNode,两台用于DataNode。

每台服务器的配置应该具备足够的内存和存储空间,以及稳定的网络连接。

二、操作系统安装在选择操作系统时,通常推荐使用Linux发行版,如Ubuntu、CentOS等。

这些操作系统具有良好的稳定性和兼容性,并且有大量的Hadoop安装和配置文档可供参考。

安装操作系统后,确保所有服务器上的软件包都是最新的。

三、Java环境配置Hadoop是基于Java开发的,因此在搭建Hadoop集群之前,需要在所有服务器上配置Java环境。

下载最新版本的Java Development Kit(JDK),并按照官方文档的指引进行安装和配置。

确保JAVA_HOME环境变量已正确设置,并且可以在所有服务器上运行Java命令。

四、Hadoop安装与配置1. 下载Hadoop从Hadoop官方网站上下载最新的稳定版本,并将其解压到一个合适的目录下,例如/opt/hadoop。

2. 编辑配置文件进入Hadoop的安装目录,编辑conf目录下的hadoop-env.sh文件,设置JAVA_HOME环境变量为Java的安装路径。

然后,编辑core-site.xml文件,配置Hadoop的核心参数,如文件系统的默认URI和临时目录。

接下来,编辑hdfs-site.xml文件,配置Hadoop分布式文件系统(HDFS)的相关参数,如副本数量和数据块大小。

最后,编辑mapred-site.xml文件,配置MapReduce框架的相关参数,如任务调度器和本地任务运行模式。

hadoop集群工作原理Hadoop是目前主流的大数据处理框架之一,它具备强大的分布式计算能力和存储能力,在处理大规模数据集时表现优秀。

Hadoop集群由多个节点组成,每个节点都可以独立进行数据处理,通过节点间的协作和数据的分割,实现了高效的数据处理和分析。

本文将详细介绍Hadoop集群的工作原理。

一、Hadoop集群的架构Hadoop集群的基础架构由主节点(NameNode)和多个从节点(DataNode)组成。

主节点负责整个集群的管理和协调工作,而从节点则负责存储和处理数据。

主节点和从节点之间通过心跳机制进行通信,以实现数据的分片和任务的调度。

在Hadoop集群中,数据被分割成多个块,并分布在从节点上。

每个块都有多个副本,以保证数据的容错性和可靠性。

主节点维护着所有数据块和副本的信息,并根据需要将任务调度给从节点进行处理。

从节点完成任务后将结果返回给主节点。

二、数据的存储和处理Hadoop采用了分布式文件系统(HDFS)来存储数据。

HDFS将文件切分成多个块,并将这些块分布在不同的从节点上。

每个块都有多个副本,这些副本被存储在不同的从节点上,以提高数据的容错性。

当用户需要读取或写入文件时,主节点会将请求转发给最近的一个从节点。

从节点负责读取或写入其所拥有的块。

如果某个从节点失效,主节点会将任务重新分配给其他正常工作的从节点,以确保数据的可靠性和高可用性。

Hadoop采用了MapReduce编程模型来实现数据的处理和分析。

MapReduce将任务拆分成多个子任务,并将这些子任务分配给从节点并行执行。

每个从节点将通过Map阶段和Reduce阶段对数据进行处理。

Map阶段用于数据的筛选和转换,而Reduce阶段用于数据的归约和汇总。

三、任务的调度和监控Hadoop集群中的任务调度和监控由主节点负责。

主节点根据各个从节点的状态和负载情况,将任务分配给相应的从节点执行。

调度算法通常会考虑节点的性能和网络延迟等因素,以实现任务的均衡和高效执行。

习题一、选择题1.下列有关Hadoop的说法正确的是(ABCD )。

A.Hadoop最早起源于NutchB.Hadoop中HDFS的理念来源于谷歌发表的分布式文件系统(GFS)的论文C.Hadoop中MapReduce的思想来源于谷歌分布式计算框架MapReduce的论文D.Hadoop是在分布式服务器集群上存储海量数据并运行分布式分析应用的一个开源的软件框架2.使用Hadoop的原因是(ABCD )。

A.方便:Hadoop运行在由一般商用机器构成的大型集群上或者云计算服务上B.稳健:Hadoop致力于在一般商用硬件上运行,其架构假设硬件会频繁失效,Hadoop 可以从容地处理大多数此类故障C.可扩展:Hadoop通过增加集群节点,可以线性地扩展以处理更大的数据集D.简单:Hadoop允许用户快速编写高效的并行代码3.Hadoop的作者是(B )。

A.Martin Fowler B.Doug Cutting C.Kent Beck D.Grace Hopper 4.以下关于大数据特点的描述中,不正确的是(ABC )。

A.巨大的数据量B.多结构化数据C.增长速度快D.价值密度高二、简答题1.Hadoop是一个什么样的框架?答:Hadoop是一款由Apache基金会开发的可靠的、可伸缩的分布式计算的开源软件。

它允许使用简单的编程模型在跨计算机集群中对大规模数据集进行分布式处理。

2.Hadoop的核心组件有哪些?简单介绍每一个组件的作用。

答:核心组件有HDFS、MapReduce、YARN。

HDFS(Hadoop Distributed File System,Hadoop分布式文件系统)是Hadoop的核心组件之一,作为最底层的分布式存储服务而存在。

它是一个高度容错的系统,能检测和应对硬件故障,可在低成本的通用硬件上运行。

MapReduce是Hadoop的一个分布式计算框架,也是一种大规模数据集并行运算的编程模型,主要用于处理海量数据的运算。

Hadoop⽣态圈各个组件简介Hadoop是⼀个能够对⼤量数据进⾏分布式处理的软件框架。

具有可靠、⾼效、可伸缩的特点。

Hadoop的核⼼是HDFS和MapReduce,HDFS还包括YARN。

1.HDFS(hadoop分布式⽂件系统)是hadoop体系中数据存储管理的他是⼀个基础。

它是⼀个⾼度容错的的系统,能检测和应对硬件故障。

client:切分⽂件,访问HDFS,与之交互,获取⽂件位置信息,与DataNode交互,读取和写⼊数据。

namenode:master节点,在hadoop1.x中只有⼀个,管理HDFS的名称空间和数据块映射信息,配置副本策略,处理客户端请求。

DataNode:slave节点,存储实际的数据,汇报存储信息给namenode.secondary namenode:辅助namenode,分担其⼯作量:定期合并fsimage和fsedits,推送给namenode;紧急情况下和辅助恢复namenode,但其并⾮namenode的热备。

2.mapreduce(分布式计算框架)mapreduce是⼀种计算模型,⽤于处理⼤数据量的计算。

其中map对应数据集上的独⽴元素进⾏指定的操作,⽣成键-值对形式中间,reduce则对中间结果中相同的键的所有的值进⾏规约,以得到最终结果。

jobtracker:master节点,只有⼀个管理所有作业,任务/作业的监控,错误处理等,将任务分解成⼀系列任务,并分派给tasktracker. tacktracker:slave节点,运⾏map task和reducetask;并与jobtracker交互,汇报任务状态。

map task:解析每条数据记录,传递给⽤户编写的map()执⾏,将输出结果写⼊到本地磁盘(如果为map-only作业,则直接写⼊HDFS)。

reduce task:从map的执⾏结果中,远程读取输⼊数据,对数据进⾏排序,将数据分组传递给⽤户编写的reduce函数执⾏。

hadoop分布式环境搭建实验总结Hadoop分布式环境搭建实验总结一、引言Hadoop是目前最流行的分布式计算框架之一,它具有高可靠性、高扩展性和高效性的特点。

在本次实验中,我们成功搭建了Hadoop分布式环境,并进行了相关测试和验证。

本文将对实验过程进行总结和归纳,以供参考。

二、实验准备在开始实验之前,我们需要准备好以下几个方面的内容:1. 硬件环境:至少两台具备相同配置的服务器,用于搭建Hadoop 集群。

2. 软件环境:安装好操作系统和Java开发环境,并下载Hadoop 的安装包。

三、实验步骤1. 安装Hadoop:解压Hadoop安装包,并根据官方文档进行相应的配置,包括修改配置文件、设置环境变量等。

2. 配置SSH无密码登录:为了实现集群间的通信,需要配置各个节点之间的SSH无密码登录。

具体步骤包括生成密钥对、将公钥分发到各个节点等。

3. 配置Hadoop集群:修改Hadoop配置文件,包括core-site.xml、hdfs-site.xml和mapred-site.xml等,设置集群的基本参数,如文件系统地址、数据存储路径等。

4. 启动Hadoop集群:通过启动NameNode、DataNode和ResourceManager等守护进程,使得集群开始正常运行。

可以通过jps命令来验证各个进程是否成功启动。

5. 测试Hadoop集群:可以使用Hadoop自带的例子程序进行测试,如WordCount、Sort等。

通过执行这些程序,可以验证集群的正常运行和计算能力。

四、实验结果经过以上步骤的操作,我们成功搭建了Hadoop分布式环境,并进行了相关测试。

以下是我们得到的一些实验结果:1. Hadoop集群的各个节点正常运行,并且能够相互通信。

2. Hadoop集群能够正确地处理输入数据,并生成期望的输出结果。

3. 集群的负载均衡和容错能力较强,即使某个节点出现故障,也能够继续运行和处理任务。

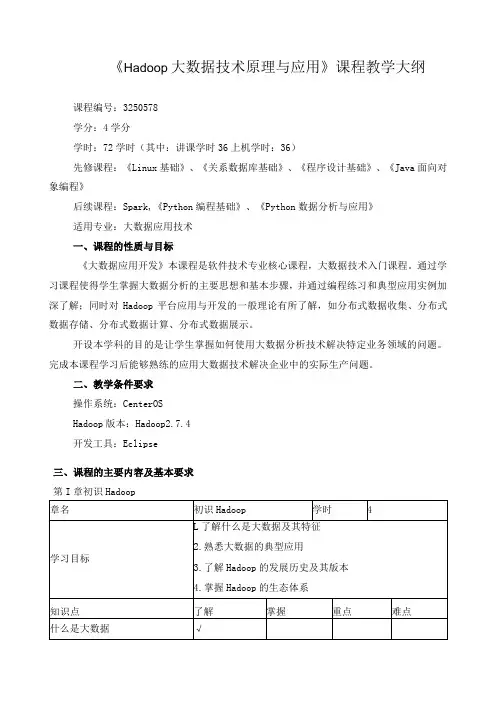

《Hadoop大数据技术原理与应用》课程教学大纲课程编号:3250578学分:4学分学时:72学时(其中:讲课学时36上机学时:36)先修课程:《Linux基础》、《关系数据库基础》、《程序设计基础》、《Java面向对象编程》后续课程:Spark,《Python编程基础》、《Python数据分析与应用》适用专业:大数据应用技术一、课程的性质与目标《大数据应用开发》本课程是软件技术专业核心课程,大数据技术入门课程。

通过学习课程使得学生掌握大数据分析的主要思想和基本步骤,并通过编程练习和典型应用实例加深了解;同时对Hadoop平台应用与开发的一般理论有所了解,如分布式数据收集、分布式数据存储、分布式数据计算、分布式数据展示。

开设本学科的目的是让学生掌握如何使用大数据分析技术解决特定业务领域的问题。

完成本课程学习后能够熟练的应用大数据技术解决企业中的实际生产问题。

二、教学条件要求操作系统:CenterOSHadoop版本:Hadoop2.7.4开发工具:Eclipse三、课程的主要内容及基本要求第I章初识Hadoop第3章HDFS分布式文件系统本课程为考试课程,期末考试采用百分制的闭卷考试模式。

学生的考试成绩由平时成绩(30%)和期末考试(70%)组成,其中,平时成绩包括出勤(5%)、作业(5%)、上机成绩(20%)o六、选用教材和主要参考书本大纲是参考教材《Hadoop大数据技术原理与应用》所设计的。

七、大纲说明本课程的授课模式为:课堂授课+上机,其中,课堂主要采用多媒体的方式进行授课,并且会通过测试题阶段测试学生的掌握程度;上机主要是编写程序,要求学生动手完成指定的程序设计或验证。

⼤数据--Hadoop集群环境搭建⾸先我们来认识⼀下HDFS, HDFS(Hadoop Distributed File System )Hadoop分布式⽂件系统。

它其实是将⼀个⼤⽂件分成若⼲块保存在不同服务器的多个节点中。

通过联⽹让⽤户感觉像是在本地⼀样查看⽂件,为了降低⽂件丢失造成的错误,它会为每个⼩⽂件复制多个副本(默认为三个),以此来实现多机器上的多⽤户分享⽂件和存储空间。

Hadoop主要包含三个模块:HDFS模块:HDFS负责⼤数据的存储,通过将⼤⽂件分块后进⾏分布式存储⽅式,突破了服务器硬盘⼤⼩的限制,解决了单台机器⽆法存储⼤⽂件的问题,HDFS是个相对独⽴的模块,可以为YARN提供服务,也可以为HBase等其他模块提供服务。

YARN模块:YARN是⼀个通⽤的资源协同和任务调度框架,是为了解决Hadoop中MapReduce⾥NameNode负载太⼤和其他问题⽽创建的⼀个框架。

YARN是个通⽤框架,不⽌可以运⾏MapReduce,还可以运⾏Spark、Storm等其他计算框架。

MapReduce模块:MapReduce是⼀个计算框架,它给出了⼀种数据处理的⽅式,即通过Map阶段、Reduce阶段来分布式地流式处理数据。

它只适⽤于⼤数据的离线处理,对实时性要求很⾼的应⽤不适⽤。

多相关信息可以参考博客:。

本节将会介绍Hadoop集群的配置,⽬标主机我们可以选择虚拟机中的多台主机或者多台阿⾥云服务器。

注意:以下所有操作都是在root⽤户下执⾏的,因此基本不会出现权限错误问题。

⼀、Vmware安装VMware虚拟机有三种⽹络模式,分别是Bridged(桥接模式)、NAT(⽹络地址转换模式)、Host-only(主机模式):桥接:选择桥接模式的话虚拟机和宿主机在⽹络上就是平级的关系,相当于连接在同⼀交换机上;NAT:NAT模式就是虚拟机要联⽹得先通过宿主机才能和外⾯进⾏通信;仅主机:虚拟机与宿主机直接连起来。

hadoop原理及组件Hadoop是一个开源的分布式计算框架,旨在处理大规模数据集。

它提供了一个可靠、高效和可扩展的基础设施,用于存储、处理和分析数据。

本篇文章将详细介绍Hadoop的原理以及其核心组件。

一、Hadoop原理Hadoop的核心原理包括数据分布式存储、数据切分、数据复制和数据计算等。

首先,Hadoop使用HDFS(分布式文件系统)进行数据存储,支持大规模数据的存储和读取。

其次,Hadoop采用了MapReduce 模型对数据进行分布式计算,通过将数据切分为小块进行处理,从而实现高效的计算。

此外,Hadoop还提供了Hive、HBase等组件,以支持数据查询和分析等功能。

二、Hadoop核心组件1.HDFS(Hadoop分布式文件系统)HDFS是Hadoop的核心组件之一,用于存储和读取大规模数据。

它支持多节点集群,能够提供高可用性和数据可靠性。

在HDFS中,数据被分成块并存储在多个节点上,提高了数据的可靠性和可用性。

2.MapReduceMapReduce是Hadoop的另一个核心组件,用于处理大规模数据集。

它采用分而治之的策略,将数据集切分为小块,并分配给集群中的多个节点进行处理。

Map阶段将数据集分解为键值对,Reduce阶段则对键值对进行聚合和处理。

通过MapReduce模型,Hadoop能够实现高效的分布式计算。

3.YARN(资源调度器)YARN是Hadoop的另一个核心组件,用于管理和调度集群资源。

它提供了一个统一的资源管理框架,能够支持多种应用类型(如MapReduce、Spark等)。

YARN通过将资源分配和管理与应用程序解耦,实现了资源的灵活性和可扩展性。

4.HBaseHBase是Hadoop中的一个列式存储系统,用于大规模结构化数据的存储和分析。

它采用分布式架构,支持高并发读写和低延迟查询。

HBase与HDFS紧密集成,能够快速检索和分析大规模数据集。

5.Pig和HivePig和Hive是Hadoop生态系统中的两个重要组件,分别用于数据管道化和数据仓库的构建和管理。

Hadoop环境搭建--Docker完全分布式部署Hadoop环境(菜鸟采坑吐⾎整理)系统:Centos 7,内核版本3.10本⽂介绍如何从0利⽤Docker搭建Hadoop环境,制作的镜像⽂件已经分享,也可以直接使⽤制作好的镜像⽂件。

⼀、宿主机准备⼯作0、宿主机(Centos7)安装Java(⾮必须,这⾥是为了⽅便搭建⽤于调试的伪分布式环境)1、宿主机安装Docker并启动Docker服务安装:yum install -y docker启动:service docker start⼆、制作Hadoop镜像(本⽂制作的镜像⽂件已经上传,如果直接使⽤制作好的镜像,可以忽略本步,直接跳转⾄步骤三)1、从官⽅下载Centos镜像docker pull centos下载后查看镜像 docker images 可以看到刚刚拉取的Centos镜像2、为镜像安装Hadoop1)启动centos容器docker run -it centos2)容器内安装java下载java,根据需要选择合适版本,如果下载历史版本拉到页⾯底端,这⾥我安装了java8/usr下创建java⽂件夹,并将java安装包在java⽂件下解压tar -zxvf jdk-8u192-linux-x64.tar.gz解压后⽂件夹改名(⾮必需)mv jdk1.8.0_192 jdk1.8配置java环境变量vi ~/.bashrc ,添加内容,保存后退出export JAVA_HOME=/usr/java/jdk1.8export JRE_HOME=${JAVA_HOME}/jreexport CLASSPATH=.:${JAVA_HOME}/libexport PATH=$PATH:${JAVA_HOME}/bin使环境变量⽣效 source ~/.bashrc验证安装结果 java -version这⾥注意,因为是在容器中安装,修改的是~/.bashrc⽽⾮我们使⽤更多的/etc/profile,否则再次启动容器的时候会环境变量会失效。

hadoop1hadoop2hadoop3HDFS NameNodeDataNodeDataNodeSecondaryNameNodeDataNodeYARN NodeManager ResourceManagerNodeManagerNodeManager Hadoop分布式集群搭建详细教程本教程是基于CentOS-7-x86_64的Hadoop完全分布式搭建1、搭建前的准备1)CentOS-7虚拟机3台(hadoop1、hadoop2、hadoop3)2)hadoop-3.3.0包3)jdk-8u144-linux-x64包2、整体部署3、基本步骤1)修改3台虚拟机的名称2)关闭、禁⽌开机⾃启防⽕墙3)配置静态ip4)修改/etc/hosts⽂件(hadoop1、hadoop2、hadoop3)5)配置免密登录(hadoop1、hadoop2、hadoop3)6)安装JDK及配置相应环境变量(hadoop1)7)安装Hadoop及配置相应环境变量(hadoop1)8)修改配置⽂件(hadoop1)9)拷贝(hadoop1-->hadoop2,hadoop1-->hadoop3)10)远程同步/etc/profile⽂件(hadoop1)11)格式化NameNode12)启动和关闭Hadoop集群13)通过浏览器访问Hadoop集群14)测试集群,上传⽂件4、详细步骤操作1)修改3台虚拟机的名称#hostname #查看主机名称hostnamectl set-hostname 主机名 #修改主机名称#reboot #重启虚拟机【注】:修改主机名称后需重启才能⽣效2)关闭、禁⽌开机⾃启防⽕墙#systemctl status firewalld #查看防⽕墙状态#systemctl stop firewalld #关闭防⽕墙#systemctl disable firewalld #关闭防⽕墙开机⾃启#vim /etc/selinux/config #修改selinux配置⽂件SELINUX=enforcing 修改为 SELINUX=disabled3)配置静态ip#cd /etc/sysconfig/network-scripts/#vim ifcfg-ens33BOOTPROTO=none 改为 BOOTPROTO=staticIPADDR也进⾏修改【注】:因为3台虚拟机都是克隆完成的,ip地址⼀致,故在此对ip进⾏修改4)修改/etc/hosts⽂件(hadoop1、hadoop2、hadoop3)192.168.150.14 hadoop1192.168.150.15 hadoop2192.168.150.16 hadoop3#reboot5)配置免密登录(hadoop1、hadoop2、hadoop3)#ssh-keygen -t rsa #⽣成ssh密钥,不提⽰输⼊密码三次回车键#ssh-copy-id hadoop1#ssh-copy-id hadoop2#ssh-copy-id hadoop3 #将密钥拷贝到各节点#ssh hadoop1#ssh hadoop2#ssh hadoop3 #测试免密登录6)安装JDK及配置相应环境变量(hadoop1)#cd /opt/#mkdir modules #创建modules⽂件夹#mkdir tar_packages #创建tar_packages⽂件夹#cd tar_packages/ #进⼊tar_packages⽂件夹将hadoop-3.3.0.tar.gz和jdk-8u144-linux-x64.tar.gz包导⼊tar_packages⽂件夹中导⼊⽅法较多,可⽤Xshell,可⽤命令wget xxxxx下载,亦可命令rz导⼊#tar -zxvf jdk-8u144-linux-x64.tar.gz -C /opt/modules/ #将压缩包解压到/opt/modules/⽂件夹下#cd /opt/modules/jdk1.8.0_144/#pwd/opt/modules/jdk1.8.0_144 #复制此路径#vim /etc/profile/ #修改配置⽂件,加⼊环境变量在⽂件末尾加⼊#JAVA_HOMEexport JAVA_HOME=/opt/modules/jdk1.8.0_144export PATH=$PATH:$JAVA_HOME/bin#source /etc/profile #⽴即⽣效#java#javac#javadoc #测试java环境7)安装Hadoop及配置相应环境变量(hadoop1)#cd /opt/tar_packages/#tar -zxvf hadoop-3.3.0.tar.gz -C /opt/modules #将压缩包解压到/opt/modules/⽂件夹下#cd /opt/modules/hadoop-3.3.0#pwd/opt/modules/hadoop-3.3.0 #复制此路径#vim /etc/profile #修改配置⽂件,加⼊环境变量在⽂件末尾加⼊#HADOOP_HOMEexport HADOOP_HOME=/opt/modules/hadoop-3.3.0export PATH=$PATH:$HADOOP_HOME/binexport PATH=$PATH:$HADOOP_HOME/sbin#source /etc/profile #⽴即⽣效#hadoop #测试hadoop8)修改配置⽂件(hadoop1)1、修改hadoop-env.sh⽂件#cd /opt/modules/hadoop-3.3.0/etc/hadoop#vim hadoop-env.sh在⽂件中加⼊export JAVA_HOME=/opt/modules/jdk1.8.0_1442、修改yarn-env.sh⽂件#vim yarn-env.sh在⽂件中加⼊export JAVA_HOME=/opt/modules/jdk1.8.0_1443、修改mapred-env.sh⽂件#vim mapred-env.sh在⽂件中加⼊export JAVA_HOME=/opt/modules/jdk1.8.0_1444、修改core-site.xml#vim core-site.xml在<configuration></configuration>间加⼊<!-- 指定HDFS中NameNode的地址 --><property><name>fs.defaultFS</name><value>hdfs://hadoop1:9000</value><!-- 指定Hadoop运⾏时产⽣⽂件的存储⽬录 --><property><name>hadoop.tmp.dir</name><value>/opt/modules/hadoop-3.3.0/data/tmp</value></property>5、修改hdfs-site.xml⽂件# vim hdfs-site.xml在<configuration></configuration>间加⼊<!-- 指定Hadoop副本个数 --><property><name>dfs.replication</name><value>2</value></property><!-- 指定Hadoop辅助名称节点主机配置 --><property><name>node.secondary.http-address</name><value>hadoop3:50090</value></property>6、修改yarn-site.xml⽂件#vim yarn-site.xml在<configuration></configuration>间加⼊<!-- Reducer获取数据的⽅式 --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!-- 指定YARN的ResourceManager的地址 --><property><name>yarn.resourcemanager.hostname</name><value>hadoop2</value></property>7、修改mapred-site.xml⽂件#vim mapred-site.xml在<configuration></configuration>间加⼊<!-- 指定MR运⾏在Yarn上 --><property><name></name><value>yarn</value></property>8、修改workers⽂件#vim workers修改为3个主机名称hadoop1hadoop2hadoop3【注】:我这⾥的hadoop-3.3.0版本⽂件名为workers,hadoop-2.x.x版本⽂件名为slaves9)拷贝(hadoop1-->hadoop2,hadoop1-->hadoop3)#scp -r /opt/modules/ root@hadoop2:/opt/#scp -r /opt/modules/ root@hadoop3:/opt/ #将hadoop1主节点下opt⽬录下的modules⽂件夹分别拷贝到hadoop2和hadoop3节点的opt⽬录下10)远程同步/etc/profile⽂件(hadoop1)#rsync -rvl /etc/profile root@hadoop2:/etc/profile#rsync -rvl /etc/profile root@hadoop3:/etc/profile #远程同步,将hadoop1主节点上的配置⽂件分别拷贝到hadoop2和hadoop3节点#tail /etc/profile #显⽰已修改的配置⽂件(/etc/profile)内容,查看是否同步成功#source /etc/profile #⽴即⽣效#javadoc #测试#hadoop #测试#cat /opt/modules/hadoop-3.3.0/etc/hadoop/workers #查看workers⽂件内容是否⼀致11)格式化NameNodecd /opt/modules/hdoop-3.3.0#hadoop namenode -format #格式化NameNode12)启动和关闭Hadoop集群#启动集群#cd /opt/modules/hadoop-3.3.0/sbin/#start-dfs.sh先在hadoop1节点下执⾏上述命令start-dfs.sh#cd /opt/modules/hadoop-3.3.0/sbin/等hadoop1主节点下start-dfs.sh命令执⾏结束后,在hadoop2节点下执⾏命令start-yarn.sh#jps #hadoop1、hadoop2、hadoop3⼀起查看启动的进程#关闭集群#stop-yarn.sh先在hadoop2节点下执⾏命令stop-yarn.sh#stop-dfs.sh等hadoop2节点下stop-yarn.sh命令执⾏结束后,在hadoop1主节点下执⾏命令stop-dfs.sh【注】:启动集群和关闭集群顺序是相反的,启动时先hadoop1,关闭时后hadoop1【注】:因hadoop版本不同,hadoop-2.x.x下启动正常,hadoop-3.x.x下可能出现如下错误:[root@hadoop1 sbin]# start-dfs.shStarting namenodes on [hadoop1]ERROR: Attempting to operate on hdfs namenode as rootERROR: but there is no HDFS_NAMENODE_USER defined. Aborting operation.Starting datanodesERROR: Attempting to operate on hdfs datanode as rootERROR: but there is no HDFS_DATANODE_USER defined. Aborting operation.Starting secondary namenodes [hadoop3]ERROR: Attempting to operate on hdfs secondarynamenode as rootERROR: but there is no HDFS_SECONDARYNAMENODE_USER defined. Aborting operation.[root@hadoop1 sbin]# start-dfs.shWARNING: HADOOP_SECURE_DN_USER has been replaced by HDFS_DATANODE_SECURE_USER. Using value of HADOOP_SECURE_DN_USER.解决办法为:在start-dfs.sh和stop-dfs.sh⽂件⾸部加⼊如下部分1 HDFS_DATANODE_USER=root2 HDFS_DATANODE_SECURE_USER=hdfs3 HDFS_NAMENODE_USER=root4 HDFS_SECONDARYNAMENODE_USER=root在start-yarn.sh和stop-yarn.sh⽂件⾸部加⼊如下部分1 YARN_RESOURCEMANAGER_USER=root2 HADOOP_SECURE_DN_USER=yarn3 YARN_NODEMANAGER_USER=root这样这个问题就解决了,记得看清楚⾃⼰hadoop的版本号13)通过浏览器访问Hadoop集群在浏览器输⼊:192.168.150.14(主节点ip):9870访问Hadoop⽂件系统【注】:hadoop-3.x.x,服务器端⼝改为了9870,并不是原来的50070,看清⾃⼰的Hadoop版本可在Windows下配置主机节点映射,配置完成后即可在浏览器输⼊:hadoop1(主节点名称):9870访问Hadoop⽂件系统具体映射配置:在C:\Windows\System32\drivers\etc\hosts⽂件后,加⼊与在虚拟机/etc/hosts配置⼀致的内容,即:#192.168.150.14 hadoop1#192.168.150.15 hadoop2#192.168.150.16 hadoop314)测试集群,上传⽂件#hadoop fs -mkdir -p /root/ #创建root⽬录#hadoop fs -put /opt/tar_packages/jdk-8u144-linux-x64.tar.gz /root/ #将/opt/tar_packages/⽬录下的jdk-8u144-linux-x64.tar.gz压缩包上传到刚才创建的root⽬录下⾄此,分布式集群搭建完成!PS:搭建过程中需要的⼯具我整理了⼀下,需要的请⾃取哦!(提取码:u240)如果搭建过程遇到了什么难以解决的问题,欢迎留⾔,毕竟多⼀个⼈⼀起百度可能会快⼀点!。

《Hadoop平台搭建与应用》课程标准1. 概述1.1课程的性质本课程是大数据技术与应用专业、云计算技术与应用专业、软件技术专业的专业基础课程,是校企融合系列化课程,该课程基于Hadoop生态系统进行大数据平台的构建。

1.2课程设计理念本课程遵循应用型本科和高等职业教育规律,以大数据技术与应用实际工作岗位需求为导向选取课程内容,课程目标是培养学生具备“大数据分析”应用项目所需系统环境的搭建与测试综合职业能力;坚持开放性设计原则,吸收企业专家参与,建立基于Hadoop的生态环境,以“工作任务”为载体的“项目化”课程结构;课程教学实施教、学、做一体,坚持理论为实践服务的教学原则,通过模拟企业“大数据分析”环境进行组织,锻炼学生的实践操作能力。

1.3课程开发思路通过岗位技能的项目化以及系统搭建与应用任务的序列化,对内容体系结构进行了适当调整与重构,以适应教学课程安排。

以项目案例及其任务实现为驱动,凭借翔实的操作步骤和准确的说明,帮助学生迅速掌握Hadoop生态系统环境构建与应用,并且充分考虑学习操作时可能发生的问题,并提供了详细的解决方案,突出岗位技能训练。

2.课程目标本课程的培养目标是使学生以大数据系统运维岗位需求为依托,以实际工作任务为导向,理清Hadoop生态系统中各个组件的作用及应用,培养学生大数据分析平台构建的实际动手能力。

2.1知识目标基于Hadoop2.X生态系统,要求学生全面掌握Hive环境搭建与基本操作、Zookeeper环境搭建与应用、HBase环境搭建与基本操作、 pig系统搭建与应用、Sqoop系统搭建与应用、Flume系统搭建与应用以及使用Apache Ambari实现Hadoop集群搭建及管理等的相关知识以及操作技能。

2.2素质目标(1)培养学生动手能力、自主学习新知识的能力(2)培养学生团队协作精神2.3能力目标通过该课程的学习,学生能利用所学的相关技术,能搭建适用于各种大数据分析应用业务需求的系统,能处理常见的系统运行问题。

Hadoop大数据开发基础教案-Hadoop集群的搭建及配置教案教案章节一:Hadoop简介1.1 课程目标:了解Hadoop的发展历程及其在大数据领域的应用理解Hadoop的核心组件及其工作原理1.2 教学内容:Hadoop的发展历程Hadoop的核心组件(HDFS、MapReduce、YARN)Hadoop的应用场景1.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节二:Hadoop环境搭建2.1 课程目标:学会使用VMware搭建Hadoop虚拟集群掌握Hadoop各节点的配置方法2.2 教学内容:VMware的安装与使用Hadoop节点的规划与创建Hadoop配置文件(hdfs-site.xml、core-site.xml、yarn-site.xml)的编写与配置2.3 教学方法:演示与实践相结合手把手教学,确保学生掌握每个步骤教案章节三:HDFS文件系统3.1 课程目标:理解HDFS的设计理念及其优势掌握HDFS的搭建与配置方法3.2 教学内容:HDFS的设计理念及其优势HDFS的架构与工作原理HDFS的搭建与配置方法3.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节四:MapReduce编程模型4.1 课程目标:理解MapReduce的设计理念及其优势学会使用MapReduce解决大数据问题4.2 教学内容:MapReduce的设计理念及其优势MapReduce的编程模型(Map、Shuffle、Reduce)MapReduce的实例分析4.3 教学方法:互动提问,巩固知识点教案章节五:YARN资源管理器5.1 课程目标:理解YARN的设计理念及其优势掌握YARN的搭建与配置方法5.2 教学内容:YARN的设计理念及其优势YARN的架构与工作原理YARN的搭建与配置方法5.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节六:Hadoop生态系统组件6.1 课程目标:理解Hadoop生态系统的概念及其重要性熟悉Hadoop生态系统中的常用组件6.2 教学内容:Hadoop生态系统的概念及其重要性Hadoop生态系统中的常用组件(如Hive, HBase, ZooKeeper等)各组件的作用及相互之间的关系6.3 教学方法:互动提问,巩固知识点教案章节七:Hadoop集群的调优与优化7.1 课程目标:学会对Hadoop集群进行调优与优化掌握Hadoop集群性能监控的方法7.2 教学内容:Hadoop集群调优与优化原则参数调整与优化方法(如内存、CPU、磁盘I/O等)Hadoop集群性能监控工具(如JMX、Nagios等)7.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节八:Hadoop安全与权限管理8.1 课程目标:理解Hadoop安全的重要性学会对Hadoop集群进行安全配置与权限管理8.2 教学内容:Hadoop安全概述Hadoop的认证与授权机制Hadoop安全配置与权限管理方法8.3 教学方法:互动提问,巩固知识点教案章节九:Hadoop实战项目案例分析9.1 课程目标:学会运用Hadoop解决实际问题掌握Hadoop项目开发流程与技巧9.2 教学内容:真实Hadoop项目案例介绍与分析Hadoop项目开发流程(需求分析、设计、开发、测试、部署等)Hadoop项目开发技巧与最佳实践9.3 教学方法:案例分析与讨论团队协作,完成项目任务教案章节十:Hadoop的未来与发展趋势10.1 课程目标:了解Hadoop的发展现状及其在行业中的应用掌握Hadoop的未来发展趋势10.2 教学内容:Hadoop的发展现状及其在行业中的应用Hadoop的未来发展趋势(如Big Data生态系统的演进、与大数据的结合等)10.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点重点和难点解析:一、Hadoop生态系统的概念及其重要性重点:理解Hadoop生态系统的概念,掌握生态系统的组成及相互之间的关系。